|

Опрос

|

реклама

Быстрый переход

Microsoft нашла способ отключить рекламу в YouTube для Android без подписки Premium

01.09.2025 [17:31],

Сергей Сурабекянц

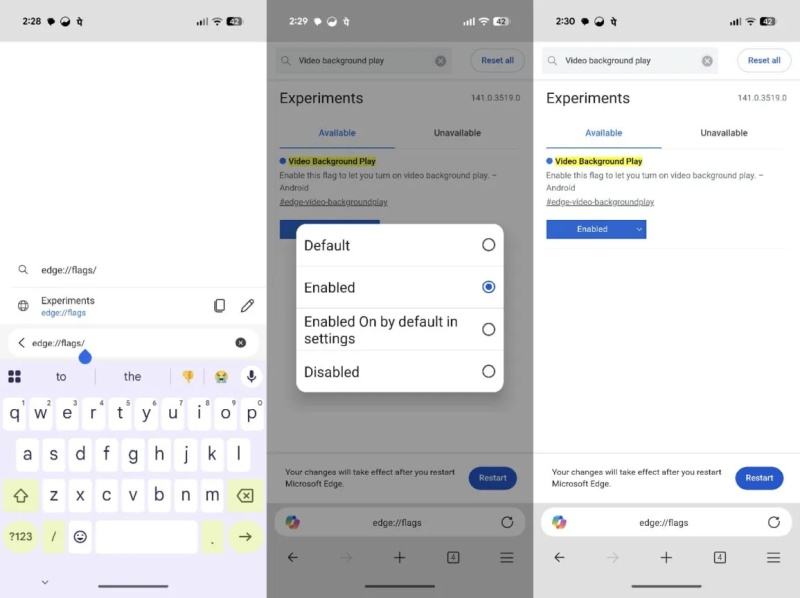

Одно из главных преимуществ подписки на тариф YouTube Premium за $14 — возможность воспроизведения видео в фоновом режиме. В последней сборке Canary браузера Microsoft Edge для Android появилась возможность обойтись без подписки Premium. Функция включается на странице флагов Edge и позволяет воспроизводить видео YouTube в фоновом режиме. Edge Canary для Android также предлагает встроенный блокировщик рекламы, работающий на YouTube.

Источник изображения: unsplash.com Чтобы протестировать новую возможность, необходимо загрузить Microsoft Edge Canary на устройство Android, затем ввести в поле поиска edge://flags. В появившемся списке следует отыскать пункт «Фоновое воспроизведение видео» и включить его в раскрывающемся меню статуса. После этого браузер нужно перезагрузить, затем в настройках браузера выбрать «Настройки сайта» и установить переключатель «Фоновое воспроизведение видео» в положение «Включено».

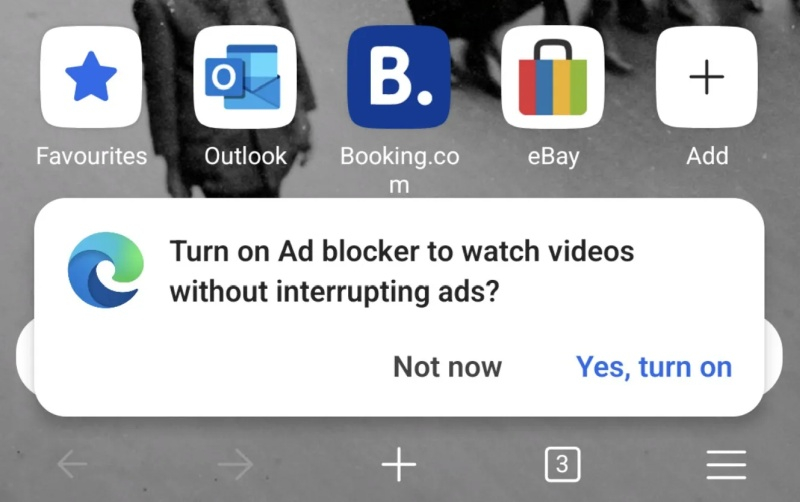

Источник изображений: Android Authority После проделанных манипуляций видео YouTube будут воспроизводиться в фоновом режиме, даже если у пользователя нет подписки YouTube Premium. Видео не будут останавливаться при переключении вкладок в Edge, переключении приложений или даже блокировке устройства. Эта функция также работает и на других сайтах. При первом запуске Edge Canary пользователям теперь предлагается «включить блокировщик рекламы, чтобы смотреть видео без рекламы» — это позволит не видеть рекламу на большинстве сайтов, включая YouTube.  Если обе эти функции станут доступны в стабильной сборке Edge для Android, причин использовать этот браузер станет больше, а оформлять подписку на YouTube Premium — меньше, что в конечном итоге негативно скажется на количестве подписчиков YouTube Premium. Похожая ситуация произошла в 2013 году, когда Microsoft выпустила собственное приложение YouTube для Windows Phone. Приложение не показывало рекламу в видео, а также позволяло пользователям загружать видео на своё устройство. Всё это нарушало условия обслуживания YouTube, в результате Google заблокировала это приложение. Время покажет, примет ли в этот раз Google аналогичные меры против Microsoft за разрешение воспроизведения видео YouTube в фоновом режиме и блокировку рекламы. Спустя год замедления YouTube наконец уступил «VK Видео» по месячной аудитории в России

27.08.2025 [14:41],

Владимир Мироненко

Отечественный видеосервис «VK Видео» впервые за всю историю наблюдений опередил YouTube по охвату аудитории в России, пишут «Ведомости» со ссылкой на данные Mediascope за июль. Согласно представленным данным, у «VK Видео» месячный охват достиг 76,4 млн человек, тогда как у YouTube — 74,9 млн. Бурный рост сервиса VK начался примерно год назад после замедления работы YouTube в России.

Источник изображения: «VK Видео» Как отметили «Ведомости», российский рынок видеоконтента переживает структурную трансформацию, сопровождающуюся переходом от глобальных платформ к национальным экосистемам, встроенным в соцсети и ТВ. В компании VK объясняют рост в первую очередь увеличением объёма контента и числа авторов, которых за год стало больше на 130 %, составив 182 тыс. человек. «Это обеспечивает постоянное обновление контента и расширение тематического разнообразия», — отметили в компании. Объём загружаемого видео за июнь составил 13,7 млн роликов, превысив показатель того же периода прошлого года в 2,4 раза. Также в VK делают ставку на вовлечённость пользователей. Согласно данным Mediascope, показатель Sticky Factor (доля пользователей, регулярно возвращающихся на платформу) в июле составил 51 % против 31,5 % у YouTube. Большую роль играет вопрос монетизации. К апрелю 2025 года к системе выплат видеосервиса были подключены 80 тыс. блогеров, средний доход которых вырос год к году в 5,7 раза, достигая 1 млн руб. в месяц. Наибольшие выплаты приходятся на категории «Детский контент», «Игры», «Новости» и «Развлечения». В компании сообщили, что половина активной аудитории смотрит видео через отдельное приложение или Smart TV, потребление контента по которому составляет более 2,5 часа в день на пользователя. Львиная доля просмотров (90 %) приходится на видео длительностью свыше 15 минут, наиболее активная аудитория — в возрасте 14–36 лет, чаще мужчины. Директор Института исследований интернета Карен Казарян сообщил, что рост «VK Видео» во многом обеспечен детским и пиратским контентом, а также использованием Smart TV, где приложение «VK Видео» предустановлено. Он также отметил удобство приложения и качество видеопотока, а также меньшее количество рекламы по сравнению с Rutube. Генеральный директор Telecom Daily Денис Кусков объясняет причины лидерства «VK Видео» прежде всего ограничениями для YouTube. «Человек уже ушёл из спорта, а мы всё продолжаем сравнивать с ним», — подшучивает он. В то же время он отметил, что «“VK Видео” и Rutube технически развиваются, наращивают контент и возможности рекомендательных сервисов, они работают — не они закрывали YouTube». Также сыграли роль большая аудитория соцсети «ВКонтакте» и активная рекламная поддержка за последние полгода, добавил эксперт. Согласно данным Brand Analytics, которые приводят «Ведомости», число активных авторов, написавших хотя бы одно публичное сообщение или опубликовавших видео за месяц, на YouTube в России в марте 2025 года сократилось на 34 % год к году с 8 млн до 5,3 млн, а объём контента снизился на 13 % с 34 млн до 29 млн. Google открыла бесплатный доступ к генератору видео Veo 3, но только на эти выходные

23.08.2025 [16:39],

Владимир Мироненко

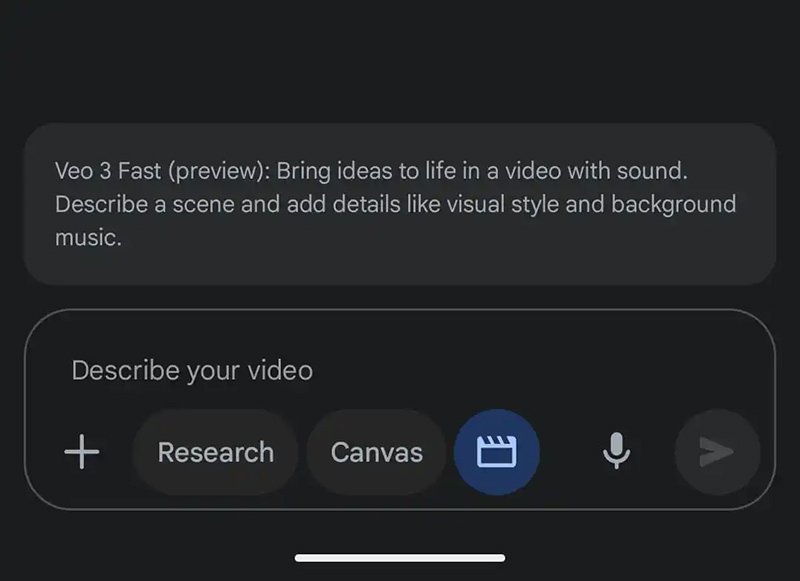

В эти выходные чат-бот на основе искусственного интеллекта Google Gemini предоставит пользователям бесплатного приложения возможность опробовать версию новейшей модели генерации видео Google Veo 3, анонсированной в мае. С её помощью можно создавать на основе запросов 8-секундные клипы со звуком. Отметим для россиян, что эта услуга доступна только с зарубежного IP-адреса.

Источник изображения: 9to5google С июля платные подписчики Google AI Pro по всему миру могут создавать три видео в день с помощью более дешёвой, чем Veo 3, модели Veo 3 Fast, которая генерирует видео в два раза быстрее с разрешением 720p. При этом владельцы подписки Google AI Ultra имеют расширенный доступ к полной версии. Им также доступна функция преобразования фото в видео. Однако в рамках акции с текущего момента до 22:00 по тихоокеанскому времени воскресенья (понедельник, 9:00 мск) пользователи бесплатной версии Gemini смогут создать три видео с помощью модели Veo 3 Fast. Глава ИИ-сервиса Gemini Джош Вудворд (Josh Woodward) сообщил в четверг в соцсети X, что Google «настраивает массу TPU» перед пробным периодом, чтобы справиться с ожидаемым ростом запросов. При открытии приложения Gemini можно увидеть сообщение об акции. Если его нет, необходимо нажать на указатель с тремя точками на панели подсказок, чтобы открыть новый элемент «Видео: Генерация с Veo». Запрос пользователя должен «описывать сцену с добавленными деталями, такими как визуальный стиль и фоновая музыка». Можно также указать в описании диалоги и фоновый шум. Создание займёт несколько минут, после чего пользователи смогут скачать клип с водяным знаком (значок Veo в правом нижнем углу) или получить ссылку для общего доступа. Пользователи «Google Диска» теперь могут редактировать видео прямо в браузере, но есть нюанс

22.08.2025 [19:40],

Сергей Сурабекянц

Google предложила возможность редактирования видео прямо на «Google Диске» в совместимом браузере. При предварительном просмотре видео в правом верхнем углу экрана может отображаться кнопка «Открыть». Нажатие на неё открывает клип в Google Vids, где можно обрезать видео, добавить текст и музыку, а также внести другие изменения. Нейросеть для генерации видео Google Veo также доступна прямо в приложении Google Vids.

Источник изображения: Google Функция Google Vids работает в последних версиях Chrome, Firefox и Microsoft Edge для Windows. Совместимость с другими браузерами не гарантируется. Поддерживаются видео в форматах MP4, Quicktime, OGG и WebM, при этом продолжительность отдельных клипов ограничена 35 минутами, а размер файла — 4 Гбайт. Для редактирования в Vids создаётся копия исходного файла, которую можно затем сохранить под другим именем или экспортировать. В целом, это удобный способ быстрого редактирования видео, уже загруженного на «Google Диск», но есть важный нюанс — редактирование доступно только пользователям платных тарифных планов. Также воспользоваться этой функцией смогут некоммерческие организации и пользователи дополнений Gemini Education или Gemini Education Premium. Доступ получат пользователи Google AI Pro и Ultra, а также те, кто приобрёл дополнения Gemini Business и Enterprise до того, как Google прекратила их поддержку в начале этого года. Возможность редактирования видео будет включена для поддерживаемых организаций по умолчанию, если, конечно, они не заблокировали доступ к «Документам Google». Google for Education предлагает бесплатный курс по использованию видеоредактора. Rutube — главный бенефициар замедления YouTube: аудитория российского сервиса выросла более чем вдвое в этом году

18.08.2025 [10:49],

Владимир Мироненко

Видеохостинг Rutube продемонстрировал самый высокий среди отечественных видеосервисов рост месячной аудитории за январь–июль 2025 года, увеличившейся на 117 % — до 49 млн человек, пишет «Коммерсантъ» со ссылкой на данные исследования «МТС AdTech». Аналитики связывают столь резкий рост показателя с оттоком аудитории из YouTube после начала замедления работы американского видеохостинга летом прошлого года.

Источник изображения: Rutube У «VK Видео» (веб-сайт и приложение) мобильный трафик составил в июле 47,2 млн человек. Среднедневной охват на смартфонах у Rutube в прошлом месяце вырос в годовом выражении на 253 % — до 6,5 млн человек, у «VK Видео» показатель увеличился на 10 %. В исследовании учитывались данные мобильного трафика на обезличенной Big Data за первые семь месяцев 2025 и 2024 годов. Вместе с тем, несмотря на перебои в работе YouTube и отток аудитории на другие сервисы, Rutube пока не удалось достичь показателей американской платформы. По данным Mediascope, на конец прошлого года среднемесячная аудитория YouTube сократилась до 89 млн человек против 95 млн в 2023 году, а среднедневная — до 42 млн человек. Представитель «Газпром-медиа Холдинга» сообщил «Коммерсанту» со ссылкой на данные Mediascope, что общая месячная аудитория Rutube увеличилась в годовом выражении на 68 % — до 79,5 млн человек. В «VK Видео» привели данные Mediascope за июль, согласно которым месячная аудитория сервиса превышает 70 млн пользователей. Директор по SMM и ORM коммуникационного агентства PR Partner Дамир Фейзуллов объяснил рост аудитории Rutube увеличением объёма оригинального контента, в том числе за счёт госзаказов, трансляций, коллабораций с блогерами и интеграции с медиагруппами. Он также отметил улучшение работы приложения, которое стало более стабильным. Кроме того, появились новые форматы монетизации для авторов. Меньший темп роста у «VK Видео» эксперт объяснил более высокой базой активных пользователей. Он отметил, что российским платформам в ближайшее время не удастся превзойти YouTube по охватам: «У YouTube в России аудитория всё ещё почти вдвое выше, чем у ближайших конкурентов. В течение двух-трёх лет Rutube имеет шансы догнать YouTube в отдельных сегментах, таких как новости, госпрограммы, тематический контент». Согласно прогнозу Фейзуллова, до конца года Rutube может увеличить аудиторию еще на 15–20 %, а «VK Видео» — на 3–5 %, в основном через интеграцию с социальной сетью и рекламу. Учёные придумали невидимые для глаз световые водяные знаки для выявления дипфейков

12.08.2025 [18:48],

Сергей Сурабекянц

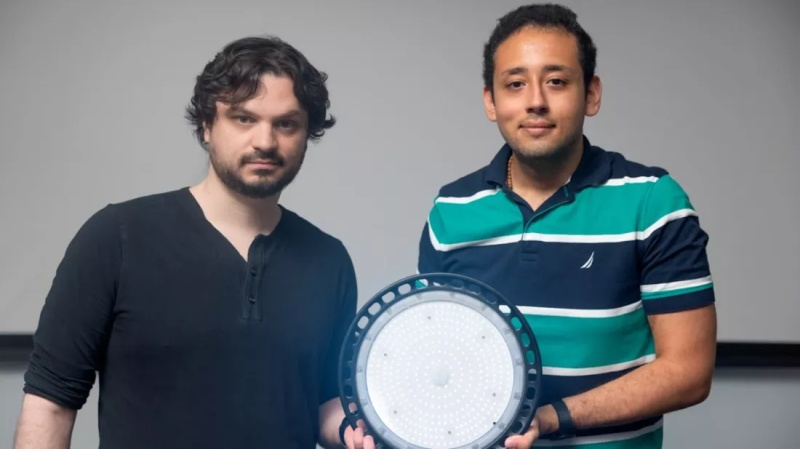

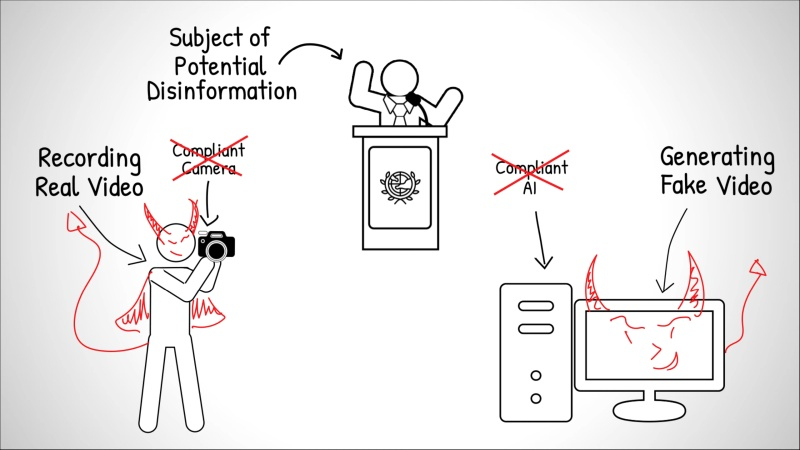

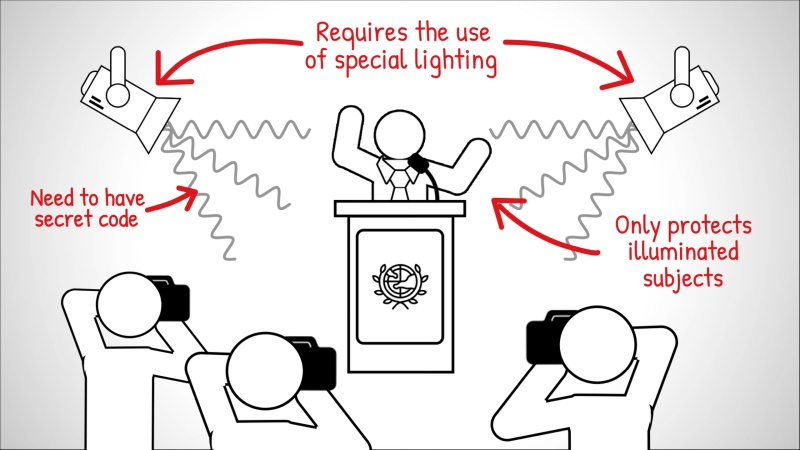

Поддельные видео становится всё сложнее выявлять, поэтому исследователи Корнеллского университета представили новую криминалистическую технологию, которая поможет специалистам удостовериться в подлинности видеоматериалов. Метод заключается во встраивании невидимых цифровых водяных знаков непосредственно в световой поток источников освещения, используемых при съёмке — например, на месте преступления.

Источник изображений: Cornell University Концепция «шумокодированного освещения» была представлена 10 августа на конференции SIGGRAPH 2025 аспирантом факультета компьютерных наук Корнеллского университета Питером Майклом (Peter Michael). Впервые этот подход был предложен и разработан доцентом Эйбом Дэвисом (Abe Davis) (на фото слева).  Обычно водяные знаки встраиваются непосредственно в видеофайлы, изменяя мельчайшие элементы изображения для создания скрытого идентификатора. Такие системы достаточно эффективны в контролируемых условиях, но требуют взаимодействия с устройством или платформой, создающей видеоматериал. При использовании несовместимой камеры или программного обеспечения цифровой водяной знак просто не появится.  Разработчики предложили при записи «встраивать» водяной знак непосредственно в световой поток от источников освещения. Это гарантирует, что любая камера — от профессионального оборудования до смартфона — запечатлеет его во время съёмки сцены. В программируемые источники света, такие как компьютерные мониторы, студийное оборудование или некоторые светодиодные приборы, можно встроить кодированные шаблоны яркости с помощью ПО. Стандартные лампы также можно адаптировать, оснастив их компактным чипом размером примерно с почтовую марку, который плавно меняет интенсивность света в соответствии с секретным кодом.  Встроенный код, разработанный на основе исследований зрительного восприятия человека, состоит из минимальных изменений частоты и яркости освещения, практически незаметных невооружённому глазу и воспринимаемых мозгом как незначительный световой шум. Уникальный код каждого источника света фактически обеспечивает параллельную запись сцены с низким разрешением и временными метками, которые Дэвис называет «видеокодами». «Когда кто-то манипулирует видео, изменённые фрагменты начинают противоречить тому, что мы видим на этих видеокодах, — пояснил Дэвис. — А если кто-то попытается сгенерировать поддельное видео с помощью ИИ, полученные видеокоды будут выглядеть просто как случайные вариации освещённости». При анализе видеоматериала специалисты могут обнаружить пропущенные последовательности, вставленные объекты или изменённые сцены. Например, удалённый из интервью фрагмент отобразится как визуальный пробел в восстановленном видеокоде, а сфабрикованные элементы — как сплошные чёрные области. Исследователи показали, что в одной сцене можно использовать до трёх независимых кодов освещения. Такое наложение увеличивает сложность водяного знака и усложняет задачу потенциальных фальсификаторов. «Даже если злоумышленник знает об этой технике и сможет вычислить коды, его задача всё равно будет значительно сложнее, — добавил Дэвис. — Вместо того чтобы имитировать свет только для одного видео, ему придётся подделывать каждый ролик с кодами отдельно, и все подделки должны будут согласовываться между собой». Полевые испытания показали эффективность метода в определённых условиях и его стабильную работу при различных оттенках кожи. Исследователи отмечают, что технология шумокодированного освещения — многообещающий шаг вперёд, но не панацея от фейковых видео. По мере развития инструментов генеративного ИИ будут совершенствоваться и методы обхода средств проверки подлинности. «Раньше видео рассматривалось как источник достоверной информации, но теперь мы не можем быть в этом уверены, — считает Дэвис. — Сегодня можно сгенерировать практически любой ролик. Это интересно, но и проблематично, потому что отличить реальность от подделки становится всё сложнее». Генератор видео Grok Imagine стал доступен бесплатно для всех

08.08.2025 [10:43],

Павел Котов

Специализирующийся на разработке технологий искусственного интеллекта стартап Илона Маска (Elon Musk) xAI оперативно подготовил ответ на выход новой флагманской модели OpenAI GPT-5 — компания сделала генератор видео Grok Imagine доступным бесплатно для всех желающих. Об этом говорится в сообщении администрации соцсети X.

Источник изображения: x.com/X Grok Imagine является одним из немногих общедоступных и бесплатных генераторов видео на основе ИИ. Он создаёт короткие ролики на основе загружаемых пользователями изображений. Сервис работает на базе модели Aurora и генерирует ролики длиной до 15 секунд. Первоначально функция была доступна только для подписчиков SuperGrok в отдельном приложении Grok и для подписчиков Premium+ в соцсети X, но теперь ограничения для приложения Grok решили убрать. Сервис предлагает создание видео в трёх режимах: в Normal генерируются «профессиональные» ролики, Fun предназначается для забавного контента, а Spicy открывает доступ к созданию материалов деликатного характера, но с ограничениями и строгой модерацией. Есть мнение, что пока Grok Imagine по реалистичности видео и аудио уступает лидерам отрасли, таким как Google Veo 3 и OpenAI Sora. Воспользоваться генератором видео Grok Imagine можно в приложениях Grok для Android и iOS — достаточно обновить их до последней версии. Universal Pictures пригрозила ИИ-компаниям судом за незаконное использование фильмов студии для обучения нейросетей

07.08.2025 [07:56],

Владимир Фетисов

Одна из старейших голливудских киностудий Universal Pictures становится всё более агрессивной в защите своих фильмов от компаний, занимающихся разработкой генеративных нейросетей. В стремлении защитить свои фильмы от незаконного их использования для обучения нейросетей компания выбрала новый подход.

Источник изображения: Julien Tromeur / Unsplash В июне этого года киностудия добавила в финальные титры фильма «Как приручить дракона» информацию о том, что незаконное использование этого контента грозит нарушителям судебными разбирательствами. Позднее аналогичные предупреждения появились в титрах фильмов «Мир юрского периода: Возрождение» и «Плохие парни 2». «Этот фильм защищён законами США и других стран. Несанкционированное копирование, распространение или демонстрация повлекут за собой гражданскую ответственность и уголовное преследование», — говорится в сообщении Universal Pictures. В компании считают, что добавление в титры такой формулировки создаст дополнительный уровень защиты от кражи кинофильмов с целью сбора данных для обучения ИИ-моделей. В некоторых странах в предупреждении компании упоминается вступивший в силу в Евросоюзе в 2019 году закон об авторском праве. Этот закон позволяет авторам контента отказаться от использования их материалов в научных целях. Быстрое развитие генеративных нейросетей несёт опасность для киноиндустрии, поскольку легко представить себе будущее, в котором многие зрители откажутся от просмотра традиционных фильмов в пользу того, что генерируют нейросети. При этом такие алгоритмы обычно обучаются на принадлежащей киностудиям интеллектуальной собственности. В настоящее время нейросети преимущественно задействованы для оптимизации отдельных процессов кинопроизводства, но уже сейчас есть игроки, которые верят в то, что будущее киноиндустрии за искусственным интеллектом. Например, в конце прошлого месяца студия Fable Studios Эдварда Саатчи (Edward Saatchi) объявила о получении неназванного объёма инвестиций от Amazon на создание платформы, которая позволит пользователям генерировать эпизоды шоу по простому текстовому описанию. У компании большие амбиции в этом направлении, она планирует выпустить в прокат свой первый сгенерированный ИИ полнометражный фильм в 2026 году. Маск пообещал восстановить архив «вайнов», считавшийся безвозвратно утерянным

04.08.2025 [20:22],

Владимир Мироненко

Илон Маск (Elon Musk), владелец X (бывшая Twitter), объявил на этих выходных, что компания обнаружила видеоархив некогда популярного приложения для коротких видеороликов Vine, который, как считалось, был безвозвратно удалён. По его словам, команда специалистов сейчас работает над восстановлением доступа пользователей к архиву.

Источник изображения: YouTube Платформа Vine, позволявшая создавать шестисекундные видеоролики, получившие название «вайны», была приобретена соцсетью Twitter в октябре 2012 года за $30 млн для расширения видеонаправления. Платформа пользовалась большой популярностью, а к 2015 году её аудитория превышала 200 млн пользователей. Тем не менее Twitter не удалось в полной мере раскрыть потенциал Vine, и в октябре 2016 года было объявлено о решении закрыть проект. Несмотря на отсутствие в App Store, приложение Vine продолжает жить в коллективной памяти интернета, отмечает TechCrunch. Благодаря онлайн-подборкам лучших «вайнов» на YouTube и карьере множества авторов контента, начавших свой путь на Vine и ставших интернет-знаменитостями, проект в какой-то мере сохранил своё культурное наследие. После приобретения Twitter в октябре 2022 года Маск опубликовал опрос в соцсети с единственным вопросом: «Вернуть Vine?», на который почти 70 % пользователей ответили «да». В то время Axios сообщало, что Twitter выделила специалистов для перезапуска Vine, однако проект так и не был реализован. Недавно Маск заявил о планах вернуть Vine, но уже «в формате с искусственным интеллектом». В своём посте о восстановлении доступа к архиву он написал, что «Grok Imagine — это ИИ Vine». Дело в том, что подписчикам X Premium+ функция Grok Imagine доступна под названием AI Vine (ИИ Vine). Судя по всему, интерес Маска к созданию видео связан не столько с пользовательским творчеством, сколько с генерацией роликов при помощи ИИ на основе текстовых подсказок. xAI запустила Grok Imagine — платный ИИ-генератор изображений и видео с «пикантным режимом»

04.08.2025 [19:36],

Сергей Сурабекянц

Компания xAI Илона Маска (Elon Musk) официально представила Grok Imagine — генератор изображений и видео, доступный для подписчиков тарифных планов SuperGrok и Premium+. Как и обещал Маск, позиционирующий Grok как ИИ, свободный от цензуры, Grok Imagine позволяет создавать контент, который обычно в интернете маркируется аббревиатурой NSFW (not safe/suitable for work — «небезопасно/неподходяще для демонстрации на работе»).

Источник изображения: @elonmusk Grok Imagine преобразовывает текстовые или графические запросы в 15-секундные видеоролики с оригинальным звуком и предлагает «пикантный режим», позволяющий пользователям создавать контент сексуального характера, включая частичную наготу. Пример такого видео опубликовал в своём аккаунте X Илон Маск. Журналисты TechCrunch сообщили, что многие из опробованных ими (во имя журналистики, конечно!) пикантных запросов привели к появлению «модерированных» размытых изображений, однако изображения полуобнажённых тел им получить удалось. NSFW-контент неудивителен для xAI, учитывая выход в прошлом месяце пикантного аниме-компаньона Ani с искусственным интеллектом. Но так же, как необузданная натура Grok была забавной, пока он не начал изрыгать оскорбительный, антисемитский и женоненавистнический контент, появление Grok Imagine может повлечь за собой свои непредвиденные последствия. При этом в Grok Imagine предусмотрены серьёзные ограничения, особенно учитывая, что модель позволяет создавать контент с изображениями знаменитостей. Так, попытки журналистов TechCrunch сгенерировать изображение беременного Дональда Трампа (Donald Trump) успехом не увенчались — Grok Imagine создавал либо изображения Трампа с младенцем на руках, либо рядом с беременной женщиной. Grok Imagine стремится конкурировать с такими игроками, как Google DeepMind, OpenAI, Runway и китайские нейросети, но пока находится на начальном этапе развития. По отзывам тестировщиков, генерируемые им изображения и видео людей нередко выглядят мультяшно, особенно из-за неестественной текстуры кожи. Тем не менее, генератор впечатляет: изображения создаются за считаные секунды и продолжают формироваться автоматически по мере прокрутки страницы. Затем их можно анимировать в стилизованные видеоролики. Пользовательский интерфейс удобен и интуитивно понятен. Недавно Маск заявил о намерении создать Baby Grok — чат-бот, пригодный для работы с детским контентом. Учитывая, насколько скандально развивается «взрослая версия» Grok, подобное направление экспансии довольно рискованно. Тем не менее, с точки зрения охвата аудитории эта ставка вполне может себя оправдать. Популярность Baby Grok может стать дополнительным источником дохода для xAI и новой статьёй расходов для родителей. YouTube добавил ИИ-инструменты для создания роликов Shorts из фото или текста

23.07.2025 [22:02],

Николай Хижняк

Платформа YouTube начала внедрение инструментов на базе генеративного ИИ для упрощения процесса создания коротких вертикальных видео Shorts. Новые функции позволяют, например, преобразовывать фотографии в видео, а также предлагают целый арсенал видеоэффектов на базе ИИ. Кроме того, платформа представила инструмент генерации видео по подсказкам — AI Playground.

Источник изображения: Christian Wiediger/unsplash.com Google представила три основные функции на базе ИИ для создателей Shorts. Одна из них позволяет превращать фото в видео — для создания клипа достаточно одного статичного изображения. Хотя Google не уточняет ограничения по длине таких роликов, вероятно, они будут довольно короткими. В инструментах редактирования Shorts также появились два новых ИИ-эффекта. Их можно выбрать перед началом записи. Первый — эффект «погружения в воду»: ИИ генерирует промежуточные кадры между реальными, создавая иллюзию, будто объект на видео погружается под воду. С примером этого эффекта можно ознакомиться ниже. Также в разделе эффектов появилась функция, позволяющая сделать грубый набросок прямо на экране смартфона, который затем будет преобразован в более красочное и проработанное изображение. Новые инструменты GenAI включают и платформу AI Playground — полноценную среду для генерации контента, а не просто наложения эффектов на видео и изображения. AI Playground позволяет создавать видео, изображения и музыку на основе текстовых описаний или готовых примеров. Получившийся контент можно публиковать в YouTube Shorts; он будет помечаться как созданный с использованием ИИ. По словам Google, развёртывание новых функций займёт несколько недель. На первом этапе они станут доступны пользователям в США, Канаде, Австралии и Новой Зеландии. В перспективе ожидается расширение географии их поддержки. Инструменты GenAI, представленные YouTube для Shorts, основаны на модели ИИ Veo 2. В будущем они будут переведены на новую модель Veo 3. Правда, сроки запуска пока не определены. Adobe Firefly научился добавлять звуковое сопровождение к генерируемым ИИ видео

17.07.2025 [19:57],

Владимир Фетисов

С тех пор как в апреле Adobe выпустила обновлённое приложение Firefly, для платформы генеративных ИИ-сервисов компании почти каждый месяц выходят крупные обновления. Сегодня разработчики представили несколько новых функций, которые будут полезны тем, кто использует сервис для создания видео.

Источник изображения: Adobe Начнём с того, что Adobe упростила процесс добавления звуковых эффектов к клипам, созданным с помощью генеративных нейросетей. В настоящее время многие алгоритмы генерируют видео без звукового сопровождения. Adobe решает эту проблему с помощью новой функции, которая позволяет пользователю сначала описать звуковой эффект, который он хочет создать, а затем попытаться его воспроизвести. Вторая часть необходима не для того, чтобы ИИ-алгоритм имитировал звук, а для того, чтобы система лучше поняла, какую интенсивность и продолжительность звука ожидает пользователь. Во время демонстрации сотрудник Adobe использовал новую функцию, чтобы добавить звук расстёгивающейся молнии. Он произнёс «ззззттт», после чего алгоритм в точности воспроизвёл этот эффект с нужной громкостью. Отмечается, что не всегда генерация звука проходит безупречно, однако функция вполне подходит для создания черновых версий, как и задумывала Adobe. Ещё одной новой функцией стала Composition Reference. Она позволяет загрузить изображение или видео для управления процессом генерации. С помощью Video Presets можно задать стиль создаваемого ролика. Среди прочего на данный момент доступны стили аниме, чёрно-белое видео и видео с использованием векторной графики. Функция Keyframe Cropping позволяет загрузить первый и последний кадры и выбрать соотношение сторон, после чего Firefly сгенерирует видео, соответствующее заданному формату. В июне на платформе Adobe появилась поддержка ИИ-алгоритмов сторонних разработчиков, и в этом месяце их список расширился. Наиболее примечательным стало появление модели Google Veo 3, представленной в мае на конференции Google I/O 2025. В настоящее время Veo 3 — одна из немногих ИИ-моделей, способных генерировать видео со звуком. Каждое видео, созданное на платформе Firefly, имеет цифровую подпись, указывающую на то, что ролик был сгенерирован с помощью ИИ. HDMI 2.2 будет поддерживать 16K при 60 Гц и до 96 Гбит/с — утверждены финальные спецификации

25.06.2025 [17:57],

Сергей Сурабекянц

Спецификация HDMI 2.2 была впервые анонсирована на выставке CES 2025, а сегодня HDMI Forum опубликовал её точные параметры. Трудно прогнозировать, сколько времени потребуется производителям для выпуска соответствующего оборудования, но первые кабели Ultra96 HDMI с пропускной способностью 96 Гбит/с могут появиться в продаже уже в этом году.

Источник изображений: HDMI Forum Текущая спецификация HDMI 2.1 и соответствующие ей кабели Ultra High Speed HDMI обеспечивают максимальную пропускную способность 48 Гбит/с, что позволяет передавать видеосигнал с разрешением до 10K и воспроизводить контент в 4K при частоте обновления до 120 Гц. HDMI 2.2 и новые кабели Ultra96 обеспечат ещё более высокие разрешения и частоты обновления, включая 4K при 480 Гц, 8K при 240 Гц, 10K при 120 Гц и 16K при 60 Гц. Также заявлена поддержка несжатых видеоформатов с 10- и 12-битной глубиной цвета при разрешении 8K и частоте 60 Гц, а также 4K при 240 Гц. Учитывая невысокую популярность и ограниченное количество контента в нативном разрешении 8K, вряд ли поставщики в ближайшее время начнут активное продвижение 16K. Даже существующая с 2017 года спецификация HDMI 2.1 до сих пор не реализована производителями оборудования в полной мере, поэтому HDMI 2.2 можно считать заделом на достаточно отдалённое будущее. HDMI Forum рассчитывает, что новая спецификация упростит выбор нужного кабеля. Существующие наименования кабелей HDMI — Standard, High Speed, Premium High Speed и Ultra High Speed — малоинформативны и не отражают максимальную скорость передачи данных. Название Ultra96 однозначно указывает на пропускную способность до 96 Гбит/с. Спецификация HDMI 2.2 также включает новый протокол индикации задержки (Latency Indication Protocol, LIP). Он предназначен для улучшения синхронизации аудио и видео, особенно в тех случаях, когда сигнал проходит через саундбар или AV-ресивер, прежде чем достичь телевизора или проектора. «Сбер» представил нейросеть Kandinsky 4.1 Video для генерации 10-секундных HD-видео

25.06.2025 [15:40],

Владимир Фетисов

«Сбер» в рамках технологической конференции GigaConf анонсировал генеративную нейросеть Kandinsky 4.1 Video, которая позволяет создавать 10-секундные видео в формате HD по текстовому описанию или изображению. На данный момент опробовать новый алгоритм уже смогли участники конференции и профессиональные дизайнеры.

Источник изображения: Steve Johnson / Unsplash «Kandinsky 4.1 Video обеспечивает качественно новый уровень генеративного видео. Модель стала в разы лучше по всем параметрам: по соответствию промпту, визуальному качеству, качеству генерации движений, а также способности моделировать физику мира. Такие разработки открывают беспрецедентные возможности как для дизайнеров, маркетологов, так и для представителей любых других креативных индустрий, работающих над созданием высококачественного видеоконтента», — рассказал старший вице-президент «Сбербанка» Андрей Белевцев. Согласно имеющимся данным, Kandinsky 4.1 Video генерирует видеоряд продолжительностью до 10 секунд в разрешении SD (720×576 пикселей) или HD (1280×720 пикселей). Разработчики дообучили новую архитектуру диффузионного трансформера на данных, подготовленных более чем 100 профессиональными фотографами и художниками. Особое внимание уделялось оптимизации вычислительных процессов. За счёт применения методов дистилляции и ускорения удалось более чем втрое сократить время генерации по сравнению с моделью предыдущего поколения. Kandinsky 1.4 Video поддерживает создание роликов с произвольным соотношением сторон, за счёт чего генерируемый контент можно адаптировать под разные платформы и маркетинговые задачи. Для всех желающих новая версия алгоритма станет доступна в ближайшее время. «Весёлая, простая и красивая»: Midjourney запустила V1 — свою первую ИИ-модель для генерации видео по изображениям

19.06.2025 [09:45],

Сергей Сурабекянц

Midjourney, один из самых популярных стартапов по генерации изображений на основе ИИ, объявил о запуске модели V1, генерирующей видеоролики из изображений. Как и другие модели компании, на момент запуска V1 доступна только через Discord и только онлайн.

Источник изображения: Midjourney «Представляем нашу модель видео V1. Она весёлая, простая и красивая. Доступная за 10 долларов в месяц, это первая модель видео для всех и прямо сейчас», — говорится в аккаунте Midjourney в социальной сети X. V1 составит конкуренцию таким моделям видеогенерации, как Sora от OpenAI, Gen 4 от Runway, Firefly от Adobe и Veo 3 от Google. Midjourney подчеркнула, что в отличие от большинства компаний, сосредоточенных на разработке коммерческих моделей, она в первую очередь ориентирована на творческую аудиторию. По мнению экспертов, подобно сгенерированным изображениям Midjourney, видеоролики, созданные V1, выглядят «несколько потусторонними, а не гиперреалистичными». Хотя длительность видео, созданного с помощью V1, ограничена пятью секундами, пользователь может продлить его на четыре секунды до четырёх раз подряд, увеличив длительность финального ролика до 21 секунды. На момент запуска самым дешёвым способом опробовать V1 является подписка на базовый тариф Midjourney стоимостью $10 в месяц с ограниченным количеством генераций. Для безлимитного использования V1 придётся выбрать тариф Pro за $60 или Mega за $120 с дополнительным режимом Relax. Midjourney планирует в течение следующего месяца пересмотреть систему тарифных планов. Компания ставит перед собой более масштабные задачи, нежели генерация перебивок для голливудских фильмов или создание рекламных роликов. По словам главы Midjourney Дэвида Хольца (David Holz), конечная цель компании — модели ИИ, «способные к моделированию открытого мира в реальном времени». Также в дальнейших планах Midjourney — разработка ИИ-модели для полноценного 3D-рендеринга. Запуск V1 от Midjourney состоялся всего через неделю после того, как на стартап подали в суд две известные киностудии Голливуда —Disney и Universal. В иске утверждается, что модели Midjourney генерируют изображения персонажей студий, защищённых авторским правом, таких как Гомер Симпсон и Дарт Вейдер.

Источник изображения: theverge.com |