|

Опрос

|

реклама

Быстрый переход

Объёмы поставок памяти типа HBM в следующем году удвоятся, как считают аналитики TrendForce

10.08.2023 [08:26],

Алексей Разин

Специалисты TrendForce поделились собственными представлениями о тенденциях развития рынка памяти типа HBM как в этом, так и в следующем году. В этом году будет наблюдаться дефицит микросхем памяти данного типа, но в следующем объёмы поставок смогут вырасти на 105 % за счёт расширения производственных мощностей. При этом два южнокорейских производителя смогут увеличить свою долю рынка в ущерб Micron Technology.

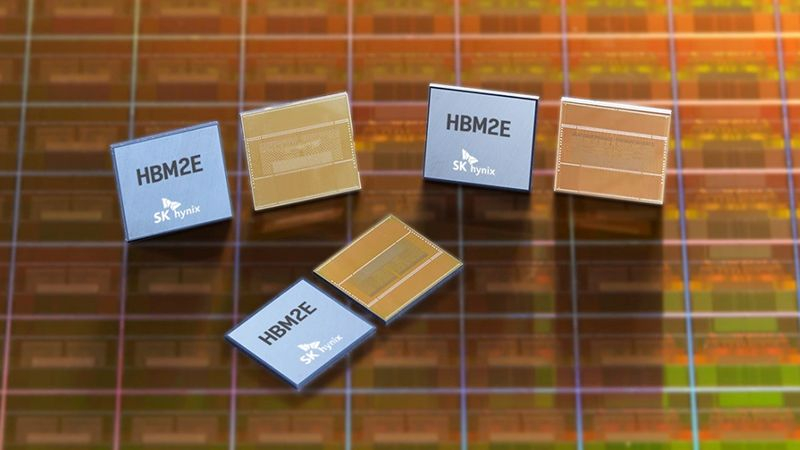

Источник изображения: SK hynix Сейчас производители памяти типа HBM наращивают объёмы выпуска соответствующих микросхем, но линии по их упаковке в вертикальные стеки требуют от 9 до 12 месяцев на монтаж и настройку, поэтому существенного увеличения объёмов поставок готовой продукции в этой сфере не приходится ожидать ранее второго квартала следующего года. Формально, на рынке присутствуют до трёх поколений памяти одновременно: HBM/HBM2, HBM2e и HBM3. Последняя считается четвёртым поколением, и на подходе уже пятое поколение микросхем, именуемое HBM3e. Шестым же станет HBM4, над разработкой которой уже трудятся корейские компании. Если в 2022 году на долю HBM3 приходились всего 8 % мирового рынка, а HBM2e занимала внушительные 70 %, то в текущем году спрос на HBM3 со стороны производителей ускорителей вычислений позволит поднять долю этого поколения памяти до 39 %. При этом доля HBM2e снизится до 50 %. Ну, а в следующем году доля HBM3 вырастет до 60 %, а HBM2e будет занимать не более 25 % рынка. В совокупности с ростом цен это приведёт к существенному увеличению выручки производителей данных типов памяти. По итогам 2022 года компания SK hynix контролировала 50 % рынка HBM3, причём отчасти она могла благодарить за это компанию NVIDIA, которую снабжает данной памятью. Samsung Electronics довольствовалась 40 % рынка, а Micron — умеренными 10 %. Тем не менее, если в этом году SK hynix и Samsung будут стремиться к паритету на уровне 46–49 % рынка, то Micron придётся ужаться до 4–6 %. В следующем году доля последней может сократиться до 3–5 %, как считают аналитики TrendForce. Впрочем, эта американская компания сосредоточена на разработке памяти типа HBM3e, а потому может отыграться в будущем. Такую память, в частности, будут использовать представленные недавно NVIDIA ускорители вычислений GH200, поставки которых начнутся во втором квартале. Как считают эксперты, цены на микросхемы HBM2 и HBM2e могут снизиться по итогам текущего года, поскольку они в меньшей степени востребованы рынком, чем HBM3. Высокий спрос на последний тип памяти в сочетании с высокими ценами будет способствовать росту выручки производителей HBM на 127 % до $8,9 млрд по итогам следующего года. В натуральном выражении объёмы поставок памяти вырастут на 105 %. NVIDIA поручит Samsung упаковку чипов для ИИ-ускорителей и будет покупать у неё память HBM3

02.08.2023 [12:29],

Павел Котов

Samsung Electronics обеспечит компании NVIDIA поставку высокопроизводительных полупроводниковых компонентов и услуги по упаковке чипов. Сотрудничество с таким партнёром поможет корейскому электронному гиганту обеспечить себя заказами и от других технологических компаний.

Источник изображений: semiconductor.samsung.com Samsung и NVIDIA сейчас проводят технологическую проверку стеков памяти HBM3 (High Bandwidth Memory) от Samsung, а также качества услуг по упаковке чипов для графических процессоров американской компании, сообщает Korea Economic Daily со ссылкой на собственный источник из Сеула. По завершении работ Samsung будет осуществлять упаковку чипов H100, составляющих основу ускорителей NVIDIA для систем искусственного интеллекта, а также станет поставщиком стеков памяти HBM3 для этих ускорителей. Соглашение будет заключено в конце года. Упаковка — один из последних этапов производства полупроводников. Она предполагает размещение микросхемы на подложке из текстолита со всеми контактами и интерфейсами, необходимыми для работы чипа и его подключения к другим компонентам системы. NVIDIA традиционно полагалась на TSMC, которая производит упаковку чипов с использованием собственной технологии; память HBM3 для ускорителей выпускала SK hynix. Но в связи с высоким спросом на компоненты для ИИ, а также загруженностью линий TSMC американский производитель был вынужден искать альтернативное предложение, которое ей обеспечила Samsung. В рамках нового партнёрства корейская компания может получить заказ и на производство самих графических процессоров NVIDIA, но пока речь только о поставках памяти и упаковке чипов. Все больше технологических компаний могут начать обращаться в Samsung в связи с загруженностью упаковочных линий TSMC, утверждает источник издания.  Крупнейшие мировые полупроводниковые подрядчики в лице Samsung, TSMC и Intel жёстко конкурируют на рынке передовых технологий упаковки, позволяющих объединять разнородные компоненты или вертикально соединять несколько микросхем. В 2021 году мировой рынок этого сегмента составлял $37,4 млрд, а к 2027 году он может вырасти на 74 % до $65 млрд. Сегодня отрасль сосредоточен на технологии 2.5D, предполагающей симбиоз графических процессоров и памяти HBM, которая в 10 раз быстрее DRAM. Мировым лидером является TSMC, которая вот уже шесть лет работает над технологией 2.5D — недавно компания сообщила, что планирует инвестировать 90 млрд тайваньских долларов ($2,9 млрд) в новый завод по производству упаковки на Тайване. В 2021 году компания представила технологию 2.5D I-Cube: во II квартале 2024 года стартует массовое производство компонентов I-Cube4 с графическим процессором и четырьмя чипами HBM, а в III квартале настанет черёд I-Cube8 с восемью чипами HBM. Samsung же стремится сделать своей сильной стороной предложение упаковки «под ключ», способное привлечь крупные технологические компании. Корейский производитель начал оказывать услугу, охватывающую весь процесс выпуска полупроводников: поставки чипов памяти, упаковку и тестирование — это поможет компании стать привлекательной альтернативой TSMC в условиях интенсивного роста отрасли ИИ. Спрос на услугу «под ключ» будет расти, помогая клиентам экономить время и деньги, а не привлекать подрядчиков для каждой услуги. Кроме того, Samsung и её местный конкурент SK hynix планируют значительно расширить линии производства памяти типа HBM — к концу 2024 года они планируют вложить в это направление более 2 трлн вон ($1,56 млрд), что поможет более чем вдвое увеличить производственную мощность линий HBM. Пока рынок DRAM пытается выйти из пике, спрос на HBM продолжает демонстрировать положительную динамику: в 2022 году он был 181 млн Гбайт; в 2023 году может подскочить на 60 % до 290 млн Гбайт, а в 2024 году может вырасти ещё на 30 % в годовом исчислении, подсчитали аналитики TrendForce. Доля HBM в выручке рынка оперативной памяти вырастет в четыре раза к 2026 году

07.07.2023 [12:53],

Алексей Разин

По мнению многих аналитиков, индустрия памяти может быстрее выйти из текущего кризиса перепроизводства за счёт активно растущего спроса на микросхемы типа HBM со стороны производителей компонентов для систем искусственного интеллекта. Сейчас память данного типа определяет не более 5 % всей выручки в отрасли, но уже к 2026 году эта доля может вырасти до 20 %.

Источник изображения: SK hynix Такими прогнозами делятся с The Wall Street Journal аналитики SemiAnalysis. По их данным, микросхемы типа HBM в среднем в пять раз дороже стандартных DRAM, поэтому в показателях выручки они достаточно быстро смогут нарастить свой удельный вес, даже если динамика натуральных показателей будет изменяться умеренными темпами. По данным TrendForce, в прошлом году примерно половину рынка памяти типа HBM контролировала южнокорейская компания SK hynix, она являлась основным поставщиком соответствующих микросхем для нужд NVIDIA, которая лидирует в сегменте ускорителей вычислений для систем искусственного интеллекта. На долю Samsung Electronics приходилось 40 % сегмента, а поздно вступившая на рынок Micron Technology довольствовалась 10 %. На апрельской отчётной конференции руководство SK hynix заявило, что в 2023 году выручка компании от реализации микросхем HBM вырастет более чем на 50 % по сравнению с прошлым годом. Samsung тоже рассчитывает заработать на буме ИИ с точки зрения поставок микросхем памяти. Аналитики Citi добавили, что доля используемой в системах ИИ оперативной памяти к 2025 году вырастет с текущих 16 до 41 %, поэтому данный сегмент рынка начнёт существенно влиять на выручку поставщиков памяти. Впрочем, в краткосрочной перспективе данный фактор не способен исправить ситуацию с перепроизводством микросхем памяти, поэтому многие производители сталкиваются с существенными убытками и сокращают объёмы выпуска продукции до рекордно низких величин. Японцы в четыре раза ускорили память HBM — они просто выбросили из чипов «лишние» контакты

06.07.2023 [14:00],

Геннадий Детинич

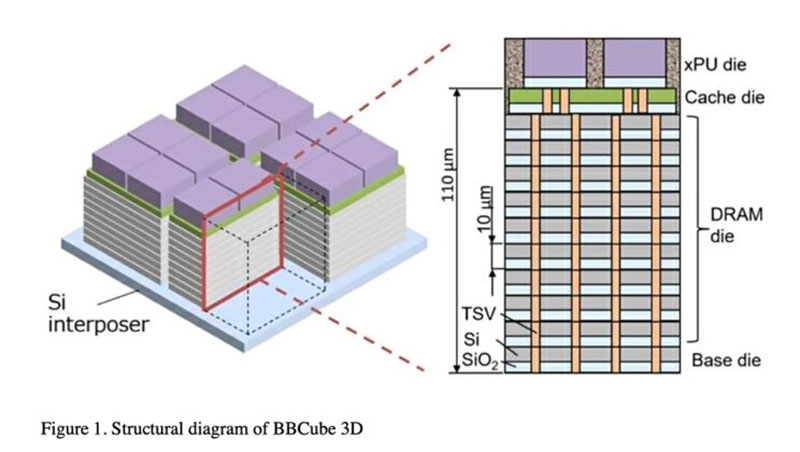

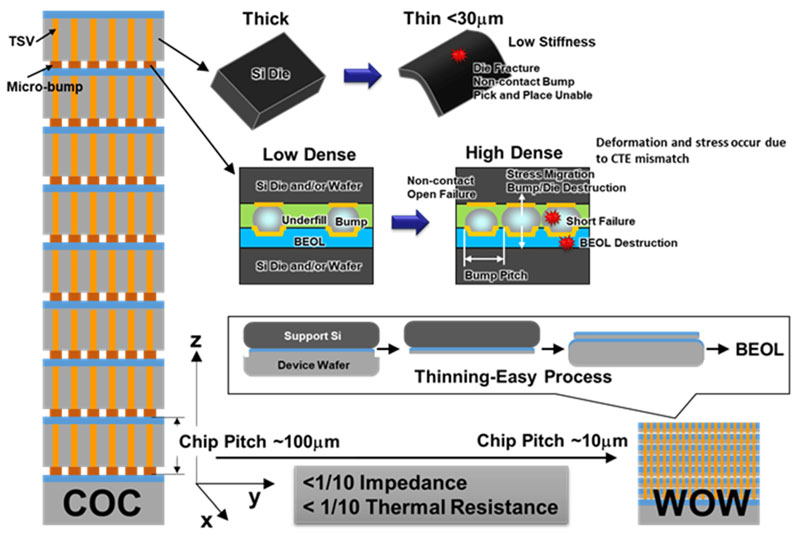

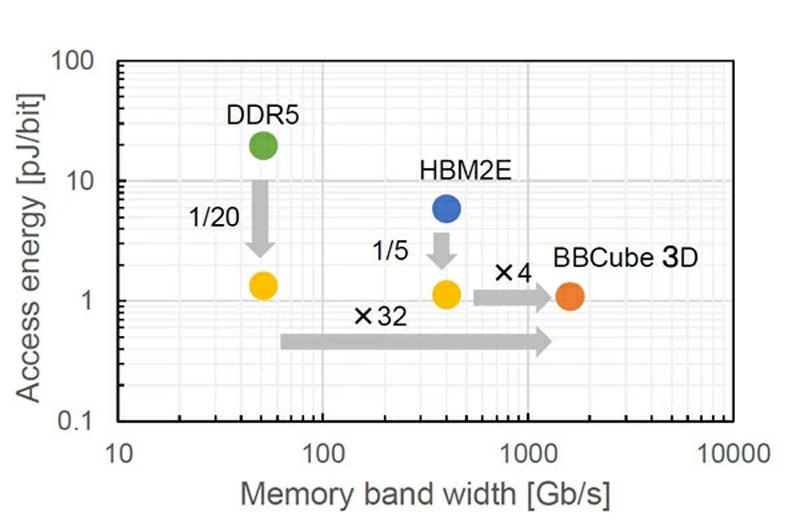

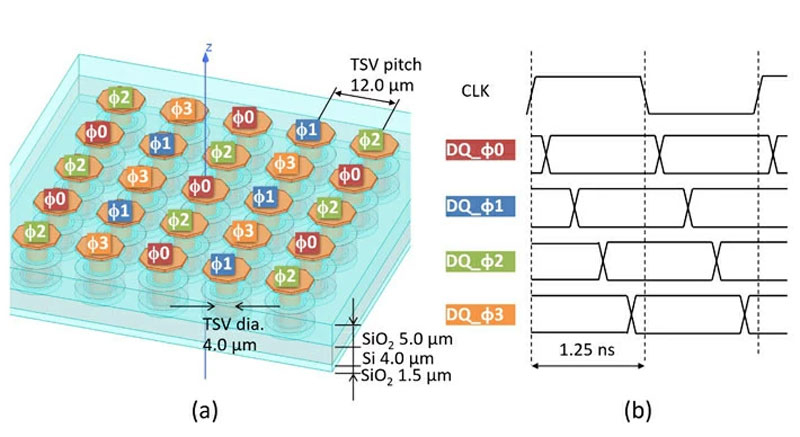

Ученые Токийского технологического института представили вариант стековой оперативной памяти, который в четыре раза быстрее памяти HBM2E и при этом потребляет в пять раз меньше энергии. Новый вариант памяти назвали Bumpless Build Cube 3D (BBCube) за отсутствие в его основе традиционных массивов шариковых контактов для послойной пайки кристаллов.

Источник изображений: Tokyo Institute of Technology Решение было представлено на симпозиуме VLSI IEEE 2023 в июне 2023 года. Японские исследователи не просто предложили концепцию, они представили детальное описание техпроцесса для изготовления такой памяти. Память HBM, как известно, помогает обойти ряд ограничений на работу с блоком ОЗУ специализированного, центрального и графического процессора. Это ограничения на доступный процессору объём оперативной памяти, что обходит стековая архитектура HBM, а также ограничения на пропускную способность, что тоже решается стеком и структурной организацией HBM. В то же время современный подход к сборке стеков HBM накладывает свои ограничения на возможности этой памяти. Каждый слой (кристалл DRAM) в стеке нельзя сделать тоньше определённой величины и нельзя увеличить количество межслойных контактов-шариков выше определённого значения. В противном случае это грозит механическими повреждениями и коротким замыканием. Проще говоря, увеличивает уровень брака, что никому не нужно.  Японцы предложили выбросить из техпроцесса сборки стека DRAM шарики-контакты. Это даст целый ряд преимуществ: кристаллы станут тоньше, поскольку уменьшатся механические напряжения в слоях, линии сквозных соединений TSVs станут короче (это позволит чипам лучше охлаждаться за счёт более высокой плотности TSVs на объём кристаллов — это будут своего рода тепловые трубки), стеки будут укрупняться, что позволит увеличить объём отдельных модулей до 64 Гбайт при использовании 16-Гбит кристаллов (в теории допустимо собирать до 40 кристаллов в стеке). Профессор Такаюки Охба (Takayuki Ohba), руководитель исследовательской группы, сказал: «BBCube 3D имеет потенциал для достижения пропускной способности в 1,6 терабайт в секунду, что в 30 раз выше, чем у DDR5 и в четыре раза выше, чем у HBM2E».  Проблему взаимных помех в сильно уплотнённых линиях TSVs-соединений предложено решить за счёт управления фазами сигналов в соседних линиях. Управляющий сигнал в определённой линии ввода-вывода никогда не возникнет, пока активны соседние линии.  Охба добавил: «Благодаря низкому тепловому сопротивлению и низкому импедансу BBCube, проблемы терморегулирования и питания, характерные для 3D-интеграции, могут быть сняты. В результате, предложенная технология может достичь потрясающей пропускной способности с энергией доступа к битам, которая составит 1/20 и 1/5 от DDR5 и HBM2E, соответственно». SK hynix захватит больше половины рынка памяти HBM в 2023 году благодаря ИИ-буму

18.04.2023 [13:13],

Владимир Фетисов

Высокий уровень спроса на ИИ-серверы стимулировал спрос на оперативную память с высокой пропускной способностью (HBM). По данным TrendForce, основными поставщиками памяти HBM в 2022 году стали SK hynix (50 % рынка), Samsung (40 % рынка) и Micron (10 % рынка). Аналитики считают, что по итогам нынешнего года южнокорейская SK hynix займёт больше половина глобального рынка HBM.

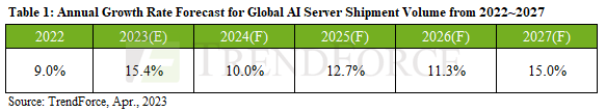

Источник изображения: SK hynix Во второй половине 2023 года начнётся производство серверных ускорителей NVIDIA H100 и AMD MI300 с памятью HBM3. В настоящее время только SK hynix запустила серийное производство памяти этого типа. Аналитики считают, что по итогам всего года это поможет южнокорейскому производителю увеличить долю рынка до 53 %. Ожидается, что Samsung и Micron начнут выпускать память HBM3 в конце этого или начале следующего года. По прогнозам аналитиков, доля этих компаний на рынке по итогам года составит 38 % и 9 % соответственно. Аналитики TrendForce прогнозируют, что объём поставок ИИ-серверов увеличится на 15,4 % в 2023 году. Более того, в период с 2023 по 2027 годы прогнозируется 12,2 % годовой рост поставок ИИ-серверов. Этому будет способствовать запуск сервисов и услуг на основе генеративных нейросетей. Ожидается, что спрос на ИИ-серверы будут поддерживать крупные поставщики облачных услуг, такие как Google, Amazon, Meta✴ и Microsoft, а также IT-гиганты, занимающиеся разработкой сервисов на основе ИИ, такие как Microsoft, Meta✴, Baidu, ByteDance и др.

Источник изображения: TrendForce В сообщении TrendForce отмечается, что рост спроса на ИИ-серверы стимулирует продажи серверной памяти DRAM, SSD и HBM. В то время как серверы общего назначения обычно имеют 500-600 Гбайт памяти DRAM, ИИ-серверы требуют значительно больших объёмов — в среднем 1,2-1,7 Тбайт памяти. Для твердотельных накопителей корпоративного уровня приоритет по-прежнему отдаётся памяти DRAM и HBM, но пока не наблюдается значительного толчка в плане увеличения ёмкости SSD. С точки зрения интерфейса, PCIe 5.0 является более предпочтительным, когда речь идёт об удовлетворении потребностей высокопроизводительных вычислений. Поскольку ИИ-серверы становятся более сложными, спрос на серверную память DRAM, SSD и HBM продолжит расти. Рекордное падение цен на память вынудило её производителей приостановить строительство новых мощностей

21.02.2023 [12:35],

Владимир Мироненко

Мировое производство чипов памяти переживает огромнейший спад спроса. Во втором полугодии 2022 года были зафиксированы самые значительные квартальные падения цен за всё время с момента начала наблюдений, пишет агентство Bloomberg.

Источник изображения: Pixabay По данным TrendForce, средняя цена на оперативную память DRAM упала в третьем квартале прошлого года на 31,4 % по сравнению с тем же периодом 2021 года, а в четвёртом квартале падение усилилось, составив 34,4 %. Ситуация с чипами флеш-памяти NAND ненамного лучше, сообщили аналитики, отметив, что за эти кварталы были зарегистрированы самые значительные снижения цен в отрасли с 2006 года. Из-сложившейся ситуации большинство ведущих вендоров сократили объёмы производства и приостановили строительство новых мощностей. Компании Micron Technology, SK hynix и Kioxia объявили о мерах по стабилизации рынка с помощью сдерживания избыточного предложения. Исключение составляет лишь Samsung Electronics, которая планирует направить в этом году более $30 млрд на наращивание производственных мощностей. Samsung делает ставку на долгосрочный рост потребления микросхем памяти, обусловленный растущим развёртыванием ресурсоёмких облачных сервисов, увеличением производства подключённых автомобилей и внедрением систем искусственного интеллекта. В своём последнем квартальном отчёте компания прогнозирует дальнейшее сокращение рынка смартфонов, вместе с тем ожидая, что ИИ-решения, такие как чат-бот ChatGPT, станут драйвером роста спроса на её продукцию. Ранее в этом месяце ресурс BusinessKorea сообщил о том, что у Samsung Electronics и SK hynix отмечен значительный рост заказов в этом году на память с высокой пропускной способностью (HBM), которая в сочетании с мощными процессорами и графическими ускорителями позволяет значительно повысить производительность серверов при обучении и вычислениях ИИ. ChatGPT и другие ИИ-боты взвинтили спрос на оперативную память HBM — это поменяет рынок

15.02.2023 [10:43],

Геннадий Детинич

Южнокорейские источники сообщают, что с начала года объём заказов на память HBM резко возрос как у SK hynix, так и у Samsung. Это взвинтило цены на чипы HBM — их закупочная стоимость сегодня в пять раз больше, чем самой передовой традиционной оперативной памяти. Рост спроса вызван взрывной популярностью чат-ботов с ИИ, которые как ничто другое требовательны к пропускной способности памяти. И это скоро изменит весь рынок компьютерной памяти, уверены эксперты.

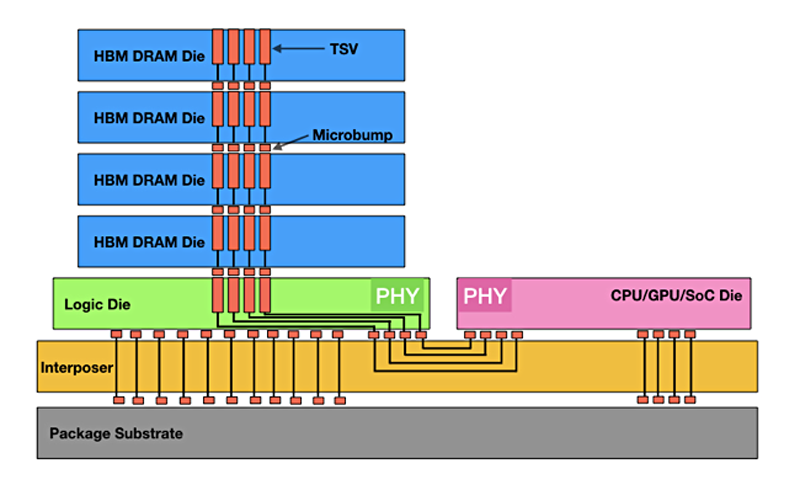

Компоновка памяти HBM Неназванный представитель отрасли заявил источнику, что разработка новых техпроцессов больше не в приоритете у производителей чипов памяти. Компании будут соревноваться в выпуске наиболее быстрых чипов памяти, включая решения с обработкой процессов непосредственно в памяти. К последним относится память HBM-PIM, представленная компанией Samsung в феврале 2021 года и компанией SK hynix в феврале 2022 года. Разработка платформ искусственного интеллекта для многих компаний становится приоритетной, и модули памяти типа HBM и HBM-PIM получают колоссальный толчок, что действительно способно изменить правила игры на рынке памяти. Разработчиков платформ не останавливает то, что память HBM как минимум в три раза дороже обычной памяти. Рост спроса и явная неспособность удовлетворить его в полном объёме уже привели к росту цен на этот тип памяти, что не смягчает динамику, а только её подогревает. Искусственный интеллект и расширение связанных с ним услуг очевидным образом ломает ситуацию. К компании SK hynix, как к лидирующему производителю чипов HBM3 в очередь выстроились NVIDIA, Intel и AMD. «Цена HBM3 выросла в пять раз по сравнению с самой высокопроизводительной DRAM», — поделился знаниями один из инсайдеров. Компания SK hynix начала выпускать память типа HBM самой первой, представив её ещё в 2013 году, а дебютировала она в видеокартах AMD Radeon R9 Fury на GPU Fiji в 2015 году. С тех пор этот южнокорейский чипмейкер выпустил HBM второго поколения (HBM2), третьего (HBM2E) и четвёртого (HBM3), обеспечив себе от 60 % до 70 % этого рынка. Высочайшую производительность памяти HBM обеспечивает стековая компоновка кристаллов, пронизанных сверху донизу сквозными контактами и фактически прямая связь с центральным или графическим процессором. Ни одна другая память не может работать с похожей пропускной способностью, а это самое узкое место в интенсивных вычислениях. Память HBM решает эту проблему намного лучше других типов памяти и это определило её будущее на ближайшие годы бурного развития ИИ. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |