Google представила облачный ИИ-суперкомпьютер A3 — до 26 000 ускорителей NVIDIA H100 для всех желающих

На конференции Google I/O компания Google анонсировала облачный ИИ-суперкомпьютер Compute Engine A3, который сможет предложить клиентам компании до 26 000 ускорителей вычислений NVIDIA H100. Это ещё одно доказательство того, насколько большое значение Google придаёт конкурентной битве с Microsoft за первенство в области ИИ. Что интересно, самый быстрый в мире на сегодняшний день общедоступный суперкомпьютер Frontier оснащён 37 000 ускорителями AMD Instinct 250X.

Источник изображения: NVIDIA

«Для наших клиентов мы можем предоставить суперкомпьютеры A3 до 26 000 GPU в одном кластере и работаем над созданием нескольких кластеров в крупнейших регионах», — заявила представитель Google, добавив, что «не все наши местоположения будут масштабироваться до такого большого размера». Таким образом любой облачный клиент Google может получить в своё распоряжение заточенный под ИИ суперкомпьютер с числом ускорителей вычислений до 26 000.

Клиенты Google Cloud смогут тренировать и запускать приложения ИИ через виртуальные машины A3 и использовать службы разработки и управления ИИ Google, доступные через Vertex AI, Google Kubernetes Engine и Google Compute Engine. Виртуальные машины A3 основаны на чипах Intel Xeon четвёртого поколения (Sapphire Rapids), которые работают в связке с ускорителями H100. Пока не ясно, будут ли виртуальные CPU поддерживать ускорители логических выводов, встроенные в чипы Sapphire Rapids.

Google утверждает, что A3 обеспечивает производительность для задач ИИ до 26 экзафлопс, что значительно сокращает время и затраты на обучение ИИ. Необходимо учитывать, что компания указывает производительность вычислений в специализированном формате для обучения ИИ TF32 Tensor Core с одинарной точностью, что демонстрирует производительность примерно в 30 раз выше, чем математика с плавающей запятой с двойной точностью FP64, которая используется в большинстве классических приложений.

Количество графических процессоров стало важной визитной карточкой облачных провайдеров для продвижения своих услуг в сфере ИИ. Суперкомпьютер Microsoft в Azure для ИИ, созданный в сотрудничестве с OpenAI, имеет 285 000 ядер CPU и 10 000 ускорителей на GPU. Microsoft также анонсировала свой суперкомпьютер для ИИ следующего поколения с ещё большим количеством графических процессоров. Облачный сервис Oracle предоставляет облачный доступ к кластерам, насчитывающим до 512 GPU и работает над новой технологией для повышения скорости обмена данными между ними.

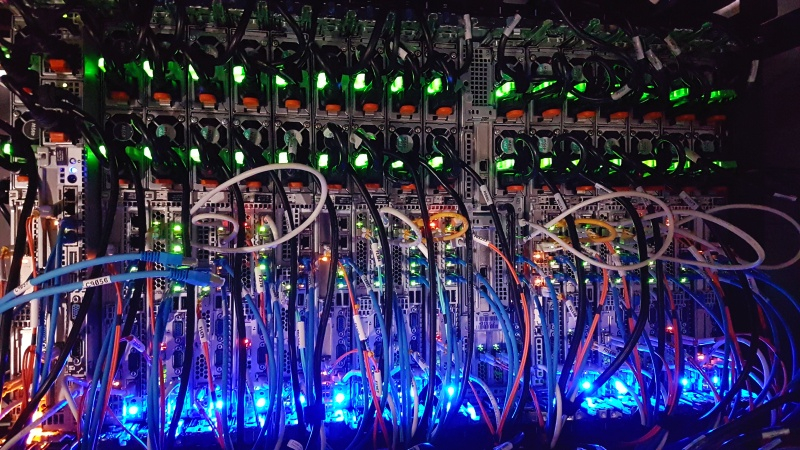

Источник изображения: unsplash.com

Хотя Google продолжает рекламировать собственные чипы для искусственного интеллекта TPU v4, используемые для запуска внутренних приложений ИИ, таких как Google Bard, ускорители на GPU от NVIDIA стали де-факто стандартом для построения инфраструктуры ИИ. Инструментарий параллельного программирования NVIDIA CUDA обеспечивает самые быстрые результаты благодаря специализированным ядрам ИИ и графическим ядрам H100.

Облачные провайдеры осознали, что универсального подхода недостаточно — требуется инфраструктура, специально созданная для обучения ИИ. Поэтому в настоящее время происходит массовое развёртывание систем на базе ускорителей H100, а NVIDIA в марте запустила собственный облачный сервис DGX, стоимость аренды которого значительно выше по сравнению с арендой систем на ускорителях A100 предыдущего поколения. Утверждается, что H100 на 30 % экономичнее и в 3 раза быстрее, чем NVIDIA A100, например, в обучении большой языковой модели MosaicGPT с семью миллиардами параметров.

A3 является первым облачным ИИ-суперкомпьютером, в котором GPU подключены через инфраструктурный процессор (IPU) Mount Evans, разработанный совместно Google и Intel. «В A3 используются IPU со скоростью 200 Гбит/с, передача данных от одного GPU к другому осуществляется в обход CPU через отдельные интерфейсы. Это позволяет увеличить пропускную способность сети до 10 раз по сравнению с нашими виртуальными машинами A2, с низкими задержками и высокой стабильностью пропускной способности», — утверждают представители Google.

Источник изображения: Pixabay

Суперкомпьютер A3 построен на основе сетевой структуры Jupiter, которая соединяет географически разнесённые кластеры CPU через оптоволоконные каналы связи. Одна виртуальная машина A3 включает восемь ускорителей H100, соединённых между собой с помощью запатентованной технологии NVIDIA. Ускорители будут подключены через коммутаторы NVSwitch и использовать NVLink со скоростью обмена данными до 3,6 Тбит/с.

Аналогичную скорость скоро готова будет предложить Microsoft на своём ИИ-суперкомпьютере, построенном на тех же технологиях NVIDIA. При этом суперкомпьютер от Microsoft может похвастаться сетевыми возможностями от производителя чипов Quantum-2 со скоростью до 400 Гбит/с. Количество ускорителей вычислений H100 в своём ИИ-суперкомпьютере следующего поколения Microsoft пока держит в секрете. Но вряд ли оно окажется меньше, чем у главного конкурента.