Украденные данные более 100 тыс. пользователей чат-бота ChatGPT оказались на торговых площадках даркнета

Данные более 100 тыс. пользователей чат-бота ChatGPT утекли в Сеть и оказались на торговых площадках даркнета, говорится в отчёте международной компании в сфере кибербезопасности Group-IB. Утечки зафиксированы в период с июня 2022-го по май текущего года.

Источник изображения: The Hacker News

Специалисты отмечают, что наиболее значительная выгрузка данных в даркнет была замечена в мае этого года.

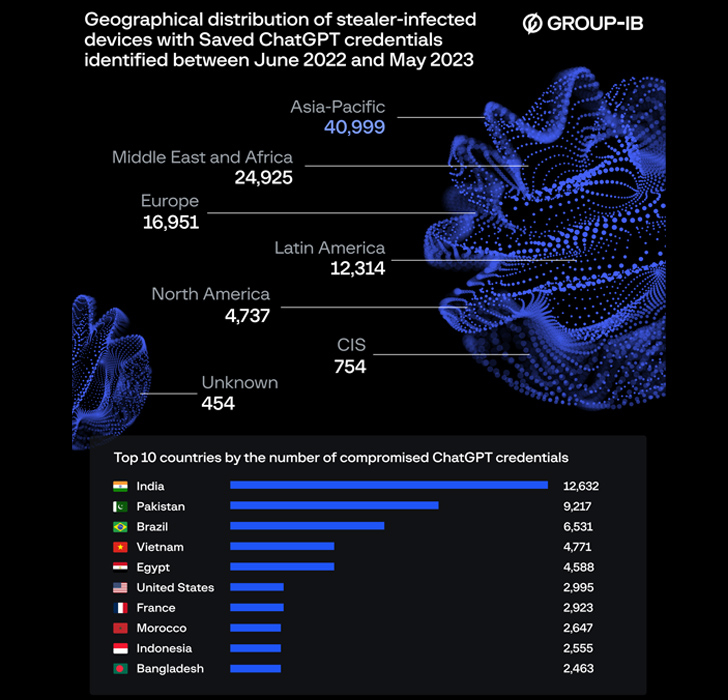

«Количество доступных логов, содержащих скомпрометированные учётные записи ChatGPT, достигло пика в 26 802 записей в мае 2023 года. За последний год самая высокая концентрация учётных данных ChatGPT, выставленных на продажу, наблюдалась в Азиатско-Тихоокеанском регионе», — говорится в отчёте компании.

Если говорить по странам, то больше всего за наблюдаемый период утекло данных пользователей ChatGPT из Индии (12 632 записи), Пакистана (9217 записей) и Бразилии (6531 запись). Также в даркнете оказались данные пользователей чат-бота из Вьетнама, Египта, США, Франции, Марокко, Индонезии и Бангладеш.

Источник изображения: Group-IB

Специалисты Group-IB отмечают, что логи, содержащие скомпрометированную информацию о пользователях, активно продаются на торговых площадках даркнета. Среди прочего в этих данных содержится информация о доменах и IP-адресах скомпрометированных пользователей.

Анализ также показал, что большинство записей (78 348 штук) были похищены с помощью вредоносной программы Raccon для кражи информации, доступной в виде услуги Malware as a Service. Следом за ней идёт шпионское ПО для Windows и средство кражи информации Vidar. С его помощью было похищены данные о 12 984 аккаунтах ChatGPT. На третьем месте (6773 похищенные записи) оказался троян RedLine, который крадет файлы cookie, имена пользователей и пароли, кредитные карты, хранящиеся в веб-браузерах, а также учётные данные FTP и файлы с заражённого устройства.

Следует понимать, что речь идёт не только о краже личной информации. В учётной записи ChatGPT можно найти как личный, так и профессиональный контент, от коммерческих секретов компании, которых там быть не должно, до личных дневников.

«Например, сотрудники компаний могут вносить в поисковый запрос чат-бота секретную информацию или использовать бота для оптимизации проприетарного программного кода. Учитывая, что стандартная конфигурация ChatGPT сохраняет все запросы, утечка этих данных может предоставить злоумышленнику доступ к ценной информации», — говорится в комментарии Group-IB.