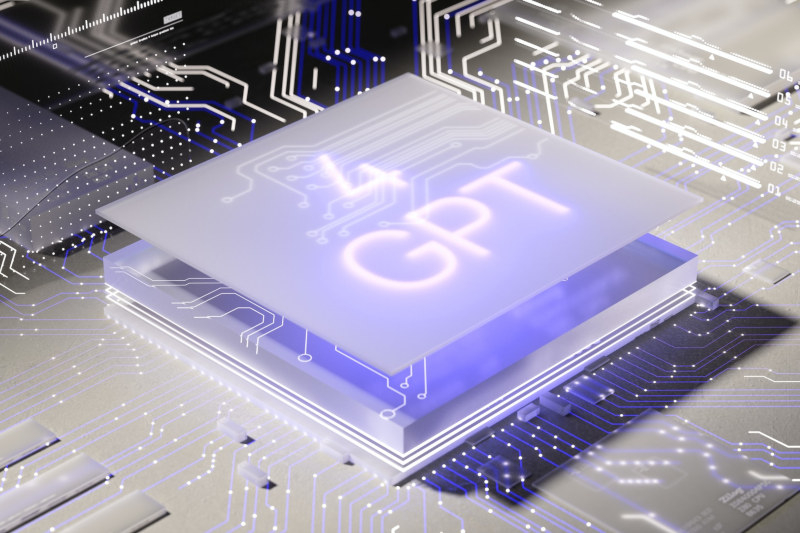

OpenAI предложила GPT-4 на роль беспристрастного модератора

OpenAI рассказала, что её разработки способны облегчить решение одной из самых сложных и неприятных технических задач — задачи модерации контента. Большая языковая модель GPT-4 способна заменить десятки тысяч модераторов-людей, демонстрируя столь же высокую точность и даже большую последовательность.

Источник изображения: ilgmyzin / unsplash.com

Компания OpenAI сообщила в корпоративном блоге, что уже использует GPT-4 для уточнения собственной политики в отношении контента, его маркировки и принятия отдельных решений. Разработчик даже привёл ряд преимуществ искусственного интеллекта перед традиционными подходами к модерации контента.

Во-первых, люди интерпретируют политику по-разному, тогда как машины последовательны в своих суждениях. Рекомендации по модерации могут быть объёмными и постоянно меняться — людям требуется много времени, чтобы научиться и адаптироваться к переменам, а большие языковые модели реализуют новые политики мгновенно. Во-вторых, GPT-4 способен помочь разработать новую политику в течение нескольких часов. Процесс составления маркировки, сбора отзывов и уточнений обычно занимает несколько недель или даже месяцев. В-третьих, нельзя забывать о психологическом благополучии работников, которые по долгу службы постоянно сталкиваются с вредоносным контентом.

Популярные соцсети существуют уже почти два десятилетия, не говоря о прочих онлайн-сообществах, но модерация контента по-прежнему остаётся одной из сложнейших задач для онлайн-платформ. Meta✴, Google и TikTok сформировали целые армии модераторов, которым приходится просматривать ужасный и часто травмирующий контент. Большинство из них проживает в развивающихся странах с низкой заработной платой, работает в аутсорсинговых компаниях и пытается самостоятельно справляться с психологическими травмами, получая минимальный объём помощи.

Источник изображения: D koi / unsplash.com

OpenAI и сама в значительной степени ещё полагается на человеческий ресурс — она нанимает работников из африканских стран для комментирования и разметки контента. Этот контент может быть проблемным, что делает работу таких сотрудников напряжённой при низкой зарплате. А вышеупомянутые Meta✴, Google и TikTok в дополнение к модераторам-людям пользуются услугами ИИ-моделей собственной разработки, поэтому предложенное OpenAI решение окажется полезным для небольших компаний, у которых нет ресурсов на разработку собственных систем.

Каждая платформа признаёт, что идеальных механизмов модерации в больших масштабах не существует: ошибки совершают и люди, и машины. Процент ошибок может быть низким, но в открытый доступ по-прежнему прорываются миллионы потенциально опасных публикаций — и, вероятно, такое же число безвредного контента скрывается или удаляется. Плюс остаётся «серая зона» недостоверного или агрессивного контента, который отвечает требованиям политики модерации, но озадачивает автоматизированные системы — такой контент сложно оценивать даже модераторам-людям, вот и машины часто совершают ошибки. То же относится к публикациям сатирического характера и материалам, документирующим преступления или превышения полномочий сотрудниками правоохранительных органов. Наконец, нельзя забывать и о внутренних проблемах, характерных для систем ИИ — «галлюцинациях» и «дрейфе», которые также способны затруднить работу ИИ-модераторов.