Microsoft выпустила три новые ИИ-модели ИИ Phi-3.5 — они превосходят аналоги от Google и OpenAI

Компания Microsoft не стала почивать на лаврах своего партнёрства с OpenAI и выпустила три новые системы искусственного интеллекта, относящиеся к семейству Phi — языковые и мультимодальные модели.

Источник изображения: VentureBeat / Midjourney

Три новых проекта линейки Phi 3.5 включают большую языковую модель базового варианта Phi-3.5-mini-instruct на 3,82 млрд параметров, мощную Phi-3.5-MoE-instruct на 41,9 млрд параметров, а также Phi-3.5-vision-instruct на 4,15 млрд параметров — она предназначена для анализа изображений и видео. Все три модели доступны под брендом Microsoft на платформе Hugging Face по лицензии MIT — их можно загружать, производить тонкую настройку, модифицировать и использовать в коммерческих целях без ограничений. В тестах они не уступают, а иногда и превосходят такие конкурирующие продукты как Google Gemini 1.5 Flash, Meta✴ Llama 3.1 и даже OpenAI GPT-4o.

Здесь и далее источник изображения: VentureBeat / Midjourney

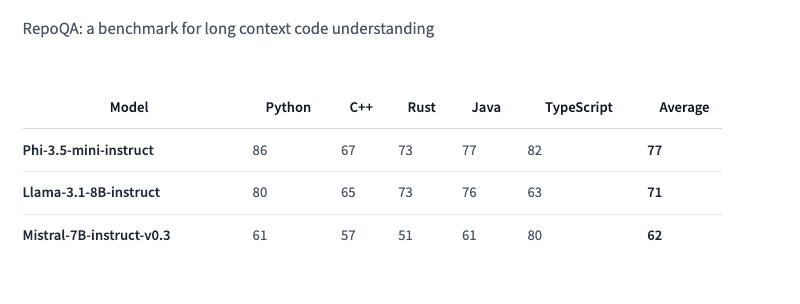

Phi-3.5 Mini Instruct оптимизирована для окружений с ограниченными вычислительными ресурсами. Это облегчённая модель с 3,8 млрд параметров. Она предназначается для выполнения инструкций и поддерживает контекст длиной 128 тыс. токенов. Модель справляется с такими задачами как генерация кода, решение математических задач и логические рассуждения. Несмотря на свой компактный размер, Phi-3.5 Mini Instruct вполне конкурентоспособна в многоязычных и многооборотных языковых задачах. В тесте RepoQA, который используется для оценки «понимания длинного контекстного кода» она опережает, в частности, Llama-3.1-8B-instruct и Mistral-7B-instruct.

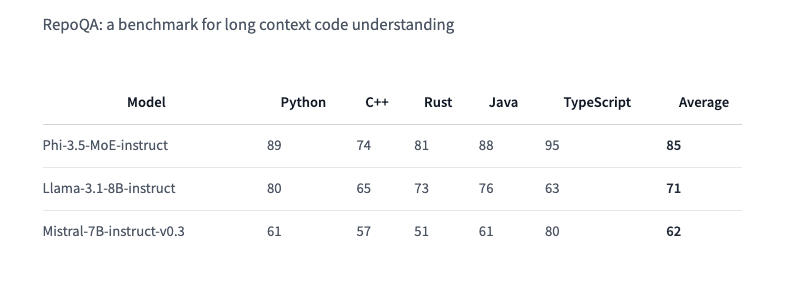

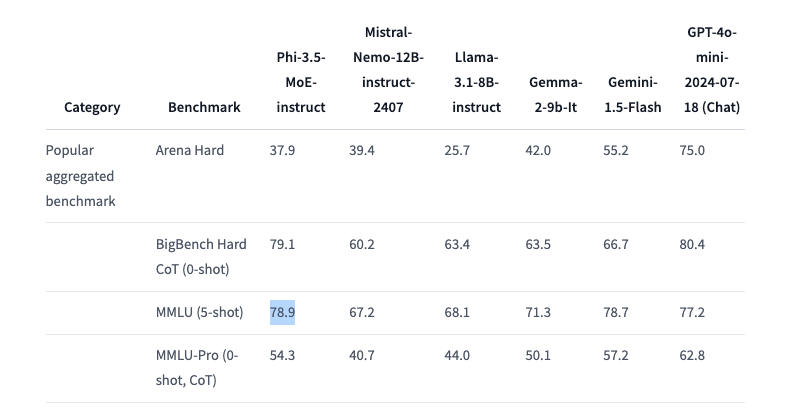

Phi-3.5 MoE (Mixture of Experts) объединяет несколько моделей различного типа, каждая из которых специализируется на собственной задаче. Архитектура модели характеризуется 42 млрд активных параметров и поддержкой контекста в 128 тыс., что позволяет применять её в требовательных приложениях — примечательно, что в документации Hugging Face говорится лишь о 6,6 млрд активных параметров. Phi-3.5 MoE демонстрирует достойные результаты в математике, генерации кода и понимании многоязычных запросов, зачастую превосходя более крупные модели в некоторых тестах, включая RepoQA; она также обошла GPT-4o mini в тесте MMLU (Massive Multitask Language Understanding) в области естественных и технических наук, а также гуманитарных и социальных дисциплин на разных уровнях знаний.

Phi-3.5 Vision Instruct объединяет возможности обработки текста и изображений. Она подходит для распознавания картинок и символов, анализа диаграмм и таблиц, а также составления сводок по видео. Vision Instruct, как и другие модели Phi-3.5, поддерживает длину контекста 128 тыс. токенов, что позволяет ей работать со сложными многокадровыми визуальными задачами. Система была обучена на синтетических и отфильтрованных общедоступных наборах данных с упором на высококачественные массивы информации с высокой плотностью рассуждений.

Phi-3.5 Mini Instruct обучалась на 3,4 трлн токенов с использованием 512 ускорителей Nvidia H100-80G в течение 10 дней; модель смешанной архитектуры Phi-3.5 MoE была обучена на 4,9 трлн токенов с использованием 512 единиц Nvidia H100-80G за 23 дня; для обучения Vision Instruct на 500 млрд токенов с использованием 256 ИИ-ускорителей Nvidia A100-80G потребовались 6 дней. Всё трио Phi-3 доступно по лицензии MIT — она позволяет разработчикам свободно использовать, изменять, объединять, публиковать, распространять, сублицензировать или продавать копии продуктов. Лицензия содержит отказ от ответственности: модели предоставляются «как есть» без каких-либо гарантий — Microsoft и другие обладатели авторских прав не несут ответственности за любые претензии, убытки и прочие обязательства, которые могут возникнуть при использовании моделей.