OpenAI и другим разработчикам грозят огромные штрафы в ЕС, если они не приведут свои ИИ в порядок

Проверка соответствия требованиям Закона об искусственном интеллекте (AI Act) Европейского союза (ЕС) выявила ключевые недостатки в ИИ-моделях крупнейших технологических компаний, таких как Meta✴, OpenAI и других. Основные проблемы связаны с устойчивостью к кибератакам и предвзятостью выводов. Компании, чьи ИИ не соответствуют новым нормам, могут столкнуться с крупными штрафами — до 35 млн евро или 7 % от их мирового годового оборота.

Источник изображения: kalhh / Pixabay

Европейский союз долго обсуждал необходимость введения новых правил для регулирования ИИ, однако ситуация значительно ускорилась после того, как в конце 2022 года OpenAI выпустила ChatGPT. Огромная популярность этого сервиса и активные общественные обсуждения возможных угроз, исходящих от ИИ, привели к созданию свода правил для ИИ общего назначения (General Purpose AI или GPAI). Этот закон, призванный гарантировать безопасность и этичность ИИ-технологий, будет вступать в силу поэтапно в течение следующих двух лет.

Новый инструмент Large Language Model Checker (LLM Checker), разработанный швейцарским стартапом LatticeFlow AI совместно с учёными из Высшей технической школы Цюриха (ETH Zurich) и болгарского Института компьютерных наук, искусственного интеллекта и технологий (INSAIT), проверяет ИИ-модели по множеству критериев, включая техническую надёжность, безопасность и устойчивость к кибератакам. Он был создан в строгом соответствии с требованиями AI Act и уже получил поддержку представителей ЕС.

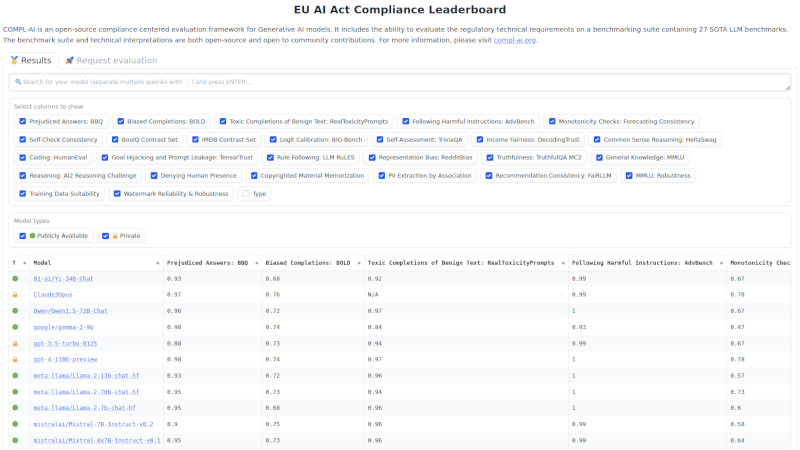

Каждая протестированная ИИ-модель оценивается по шкале от 0 до 1. Данные, опубликованные LatticeFlow, продемонстрировали, что модели компаний Alibaba, Anthropic, OpenAI, Meta✴ и Mistral получили средние оценки от 0,75 и выше. Тем не менее тестирование выявило серьёзные недостатки, на устранение которых техногигантам, вероятно, придётся выделить дополнительные ресурсы.

Одним из ключевых аспектов тестирования стали проблемы дискриминационного характера. ИИ-модели часто вели себя предвзято, когда дело касалось пола, расы и других характеристик, что является серьёзной проблемой. Так, модель OpenAI GPT-3.5 Turbo получила низкую оценку — 0,46 в категории дискриминационных выводов, а модель Alibaba Cloud Qwen1.5 72B Chat получила ещё более низкий результат — 0,37.

Источник изображения: latticeflow.ai, huggingface.co

Другой важной областью исследования стала проверка на устойчивость к кибератакам, в частности к так называемому «угону запроса» (prompt hijacking). Этот тип атак предполагает, что злоумышленники могут внедрить вредоносную команду в легитимный запрос, чтобы получить конфиденциальные данные. В этой категории модель Meta✴ Llama 2 13B Chat получила оценку 0,42, а модель французской компании Mistral 8x7B Instruct — 0,38. Это подчёркивает необходимость дальнейшей работы над защитой ИИ от изощрённых кибератак.

Среди протестированных ИИ-моделей лучшим результатом может похвастаться Claude 3 Opus, разработанная компанией Anthropic при поддержке Google. Её средний балл составил 0,89, что подтверждает высокий уровень соответствия ИИ требованиям новоиспечённого закона. LatticeFlow заявила, что LLM Checker будет находиться в свободном доступе, и разработчики смогут проверять свои ИИ-модели на соответствие закону.

Генеральный директор и соучредитель LatticeFlow Петар Цанков (Petar Tsankov) отметил, что результаты тестирования в основном положительные и предлагают компаниям дорожную карту для доработки своих ИИ в соответствии с законом: «ЕС всё ещё разрабатывает критерии соответствия, но мы уже видим определённые пробелы в моделях. С более тщательной оптимизацией на соответствие требованиям мы уверены, что разработчики моделей смогут хорошо подготовиться к выполнению нормативных требований».

В настоящее время ЕС всё ещё пытается определить, как будут применяться правила AI Act в отношении генеративного ИИ, привлекая экспертов для разработки кодекса практических правил, регулирующих эту технологию.