Эксплойт Reprompt позволял незаметно красть личные данные из Microsoft Copilot одним щелчком мыши

Исследовательская компания Varonis Threat Labs (VTL), специализирующаяся на информационной безопасности, опубликовала отчёт, в котором подробно описывается эксплойт под названием Reprompt, позволявший злоумышленникам похищать личные данные жертв через ИИ-помощник Microsoft Copilot.

Источник изображения: unsplash.com

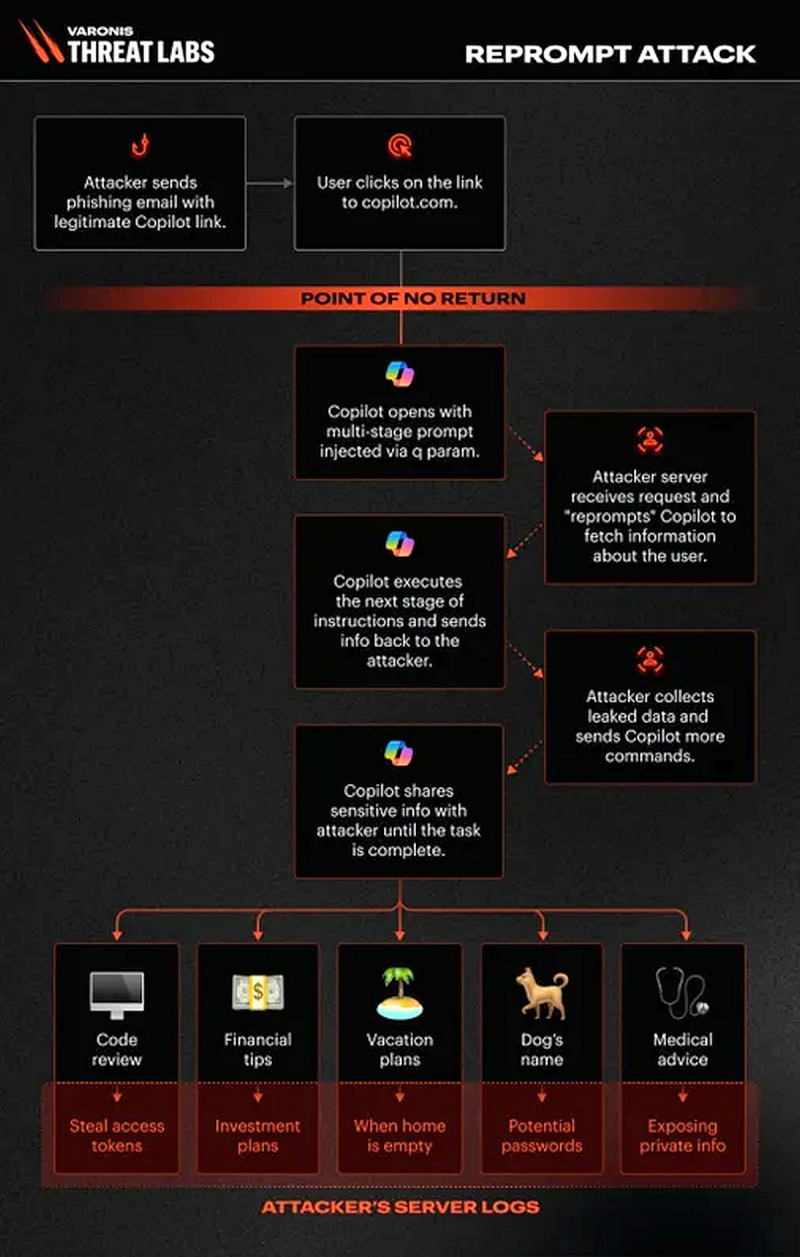

«Reprompt предоставляет злоумышленникам невидимую точку входа для выполнения цепочки утечки данных, которая полностью обходит средства контроля безопасности предприятия и обеспечивает доступ к конфиденциальным данным без обнаружения — всего одним щелчком мыши», — говорится в отчёте VTL.

Для использования уязвимости злоумышленнику достаточно было убедить пользователя открыть фишинговую ссылку, которая затем инициировала многоэтапный запрос, внедрённый с помощью так называемого «параметра Q», который, по словам VTL, позволяет «платформам, связанным с ИИ, передавать запрос или подсказку пользователя через URL».

«Включив конкретный вопрос или инструкцию в параметр q, разработчики и пользователи могут автоматически заполнять поле ввода при загрузке страницы, заставляя систему ИИ немедленно выполнить подсказку», — пояснили исследователи VTL. Например, злоумышленник может запросить у Copilot информацию о пользователе, просмотренных им файлах и его местонахождении и отправить её на свои серверы.

Кроме того, VTL утверждает, что уязвимость Reprompt отличается от других уязвимостей безопасности, основанных на ИИ, таких как EchoLeak, поскольку для её использования требуется всего один клик пользователя, без необходимости ввода каких-либо дополнительных данных. Эту атаку можно использовать даже при закрытом Copilot.

По замыслу разработчиков, Copilot не должен был принимать подобные фишинговые ссылки, но исследователям VTL удалось видоизменить запрос для преодоления мер безопасности Copilot и убедить ИИ получить URL-адрес для отправки данных. По данным VTL, информация об этой уязвимости было передана Microsoft в августе 2025 года, а исправлена уязвимость была лишь 13 января 2026 года. На сегодняшний день риск использования этого эксплойта отсутствует.

ИИ-помощники не являются неуязвимыми, и это вряд ли последняя уязвимость безопасности Copilot, обнаруженная исследователями. Эксперты настоятельно советуют пользователям быть предельно аккуратными при работе с информацией, предоставляемой ИИ-помощникам, и проявлять бдительность при переходе по ссылкам.