ATI Radeon X800 XT (R420): Extreme force

Стр.1 - Графический чип ATI R420

Eng version: ATI Radeon X800 XT

Введение

| Чип GPU | ATI R420 |

| Память | 256 Mb; GDDR3 1.6ns |

| Core/Mem: | 520/1120 MHz |

| Категория: | Hi-End |

| Цена: | $500 |

Помните, сколько было баллов на самых быстрых VGA на момент выхода 3DMark2003? Я тоже не помню. Помню только, что мало. Так мало, что игроки всех стран чуть ли не предали этот тест анафеме. По крайней мере, предметом спортивного соревнования он так и не стал. Теперь станет - и R420 и NV40 единым махом легко и свободно перемахнули за психологически важный барьер в 10000 марков.

Проделав все тесты и, наконец, засев писать этот обзор, отчетливо понял, что кликнув на текст с интригующим названием "ATI Radeon X800 XT (R420): секретное оружие" читатель преследует всего одну лишь цель - выяснить "так кто же, елки-моталки, победил на этот раз?" И вам совершенно не хочется пролистывать десяток страниц обзора, читая 50 kb текста. Уважим нетерпеливых и, в нарушение всех правил и традиций жанра трагедии, раскроем карты во втором абзаце:

Полегчало? :-) Наверное, не всем. Особенно должны расстроиться те, кто недавно купил Radeon 9800XT или GeForce FX5950Ultra. Как и было обещано, сегодняшние новинки действительно демонстрируют двукратный отрыв от вчерашних чемпионов по той же цене в 500$.

Графический чип ATI R420

Чип R420 первый в линейке Hi-End чипов от ATI, изготовленный по технологии 0,13 микрон на литографических мощностях тайваньской компании TSMС (Taiwan Semiconductor Manufacturing Сompany), ранее ATI вволю тренировалась на более простых RV360, ожидая удешевления технологии производства.

|

Обзоры ATI X800: (опубликованы 4 мая `04) |

Разместить 160 млн транзисторов, из которых состоит R420, не сильно увеличивая площадь кристала по технологии 0,15 микрон, физически невозможно - переход на 0.13 был неизбежен. Этот переход ATI во многом оплачен потом и кровью ее конкурента, компании NVIDIA, которая начала свои эксперименты на размерах 0.13 с выпуска NV30 на тех же площадях TSMC еще летом 2002-го года, когда только была построена первая тайваньская линия этого техпроцесса. Новый техпроцесс - это семь кругов ада, которые и прошла NVIDIA, а когда окончательно устала, то перебросила производство своих чипов на мощности IBM и всё началось сначала (сейчас снова переводит в TSMC).

Для чипов компании ATI такой срочный переход не был столь критичен. В их ядре R300 (который послужил основой для последующего R360 и нынешнего R420) было меньше транзисторов (115 млн), благодаря оптимальной архитектуре чипа. И эти транзисторы вполне умещались в разумные размеры кристаллов, изготовленных по по технологии 0,15 микрон. А вот NVIDIA в эти размеры хронически не укладывалась, начиная с архитектуры первого чипа FX, оттого и все их страдания со срочным поиском самого современного техпроцесса.

Архитектура видеочипа "коренным образом" меняется редко. И ждать каждые 9 месяцев абсолютно нового чипа более чем наивно. Как и наивно думать, что одна и та же команда инженеров, закончив один проект, принимается за следующий чип. НИЧЕГО ПОДОБНОГО. Что ATI, что NVIDIA имеют как минимум по три таких команды - одна разрабатывает текущий чип, заявленный в роадмапах, вторая следующий, а третья думает на много лет вперед...

Так что, закончив R300 (Radeon9700 Pro), сразу же начали разработки по увеличению кол-ва пиксельных и вершинных конвееров на основе этого удачного ядра. Почему все время упоминается R320? Всё просто - до его появления ATI висел на волоске, hi-end ускоритель ATi Radeon 8500 по производительности противостоял только лишь самой дешевой Ti4200 ($200), продажи упали ниже уровня моря, прибыли не было - одни убытки, а кол-во выпускаемых нижних чипов и карт зашкалили все разумные пределы, для каждой карты приходилось поддерживать собственный драйвер, маркетинговый отдел, похоже, возглавляли выпускники ЦПШ (церковно-приходское училище), а руководство каждый день развлекалось тем, что отмечало на доске оставшуюся сумму на счетах компании. Денег оставалось мало.

Все было брошено на последний шанс - разработку нового чипа - R300. Если сейчас заставить Intel разработать новую архитектуру процессора для массового рынка - благосостояние Intel сильно пошатнется. Стоимость разработок каждого следующего продукта Intel, AMD, ATI и NVIDIA сейчас зашкаливает за все разумные пределы. И если нашему правительству назвать эти суммы - они позеленеют от жадности и утопятся от горя.

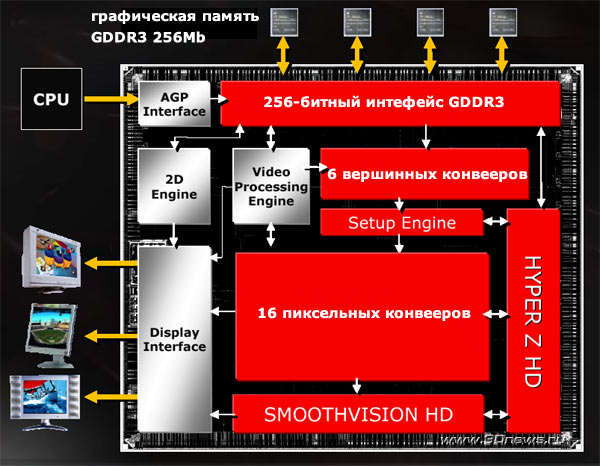

Блок-схема R300

Поэтому, говоря, что компания ATI и NVIDIA "выпустили новые чипы", необходимо четко понимать что же в них нового... Новизна бывает разной. Архитектуру отработанного до последней извилинки чипа сейчас уже менять никто не решится - денег не хватит. Поэтому, речь может идти только либо о добавлении нового технологического функционала, в некоторой степени разгона ядра, оптимизации конвееров и... самое кардинальное - увеличении их кол-ва.

Блок-схема R360

Все блоки, подвергшиеся изменению, помечены красным цветом. Шесть блоков вершинных программ (вместо старых четырех) теоретически готовят 750 миллионов полигонов в секунду, для сравнения - NV40 демонстрирует 600 миллионов полигонов в секунду за счет меньшей частоты работы чипа.

А 16-ть пиксельных конвееров (вместо старых восьми) способны обрабатывать параллельно до 80 шейдерных инструкций за такт с производительностью 192GigaFLOP c теоретическим филрейтом более чем 8,8 гигапикселей в секунду.

|

Документация (PDF): |

Конвеер пиксельного шейдера состоит из двух векторных и двух скалярных ALU. Плюс однин адресный ALU и специальный блок F-Buffer, отвечающий за обработку длинных шейдеров OpenGl.

Изюминкой технологии R420 является полная масштабируемость процессора и возможность создания как 16-ти, так и 8-ми и 4-х конвеерных конфигураций пиксельного конвеера для процессоров всех рыночных ниш.

Полное описание архитектуры процессора займет не один десяток страниц и достойно отдельного разговора, а интересующимся даём ссылку на PDF-файл Architecture_Final.zip (1 мб).

Стр.2 - Видеокарта ATI Radeon X800 XT

Видеокарта ATI Radeon X800 XT

На основе чипа R420 намечено к производству две видеокарты - ATI Radeon X800 в версиях XT и Pro. 4-го мая выйдет ATI Radeon X800 Pro c 12-тью пиксельными конвеерами, а 21-го мая официально стартует X800 XT c 16-тью пиксельными конвеерами. Все их отличия представлены в следующей таблице:

| Транзисторов | 160 млн | 160 млн |

| Core | 475 Mhz | 520 Mhz |

| Mem | 900 Mhz (DDR3) | 1120 Mhz (DDR3) |

| Пиксельные конвееры (шт) | 12 | 16 |

| Старт | 4 мая | 21 мая |

| Цена | $400 | $500 |

Дизайн

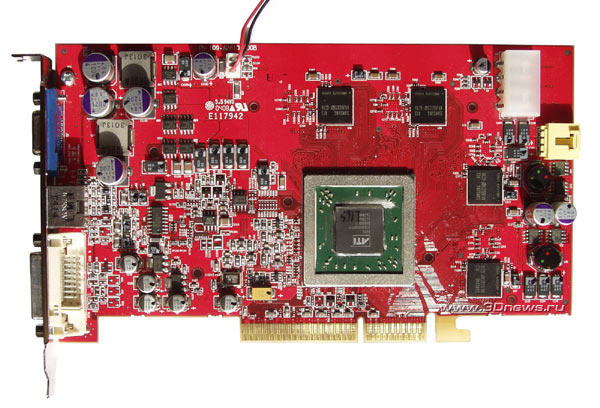

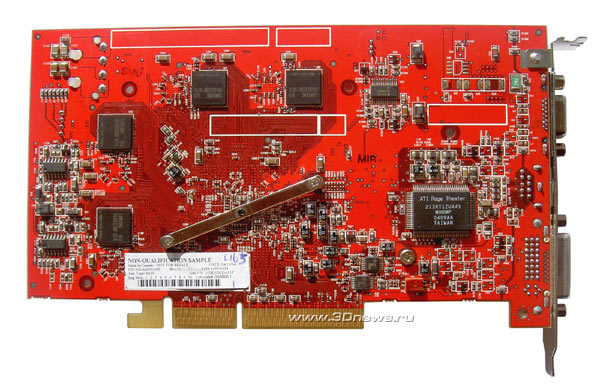

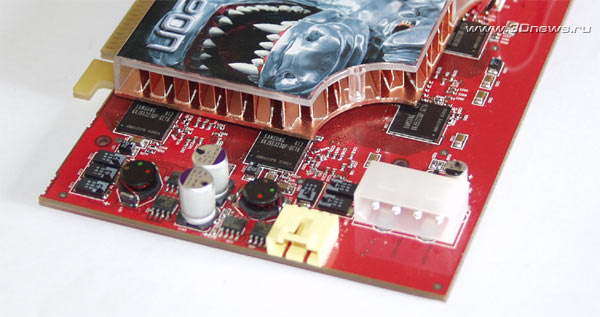

Хотя сегодня (4 мая) компания ATI представит 12-ти конвеерный ATI Radeon X800 Pro, нам достался его старший собрат - 16-ти конвеерный ATI Radeon X800 XT, изображенный на фотографиях:

Как видим, карта внешне очень похожа на свою предшественницу - ATI Radeon 9800XT. А система охлаждения, сохранив свою форму, стала даже меньше! Да они просто издеваются над богатырскими системами своего конкурента.

И все же, подобная "похожесть" не к лицу абсолютно новому продукту. Хотелось бы более серьезных внешних отличий - например, белого текстолита. То, что на плате нет логотипа X800 XT - не ошибка, а последствия семплового происхождения карты. На картах, которые поступят в продажу, будет вот такой логотип:

Кстати, хотите посмотреть на человека, который собственными ручками производит разводку дизайна плат под все видеокарты ATI?

Выпускница Бауманки ;-) Иногда читает русские обзоры своей продукции, но, в основном, не отрывается от своего громадного монитора, и все пытается развести очередную тысячу ножек свежеиспеченного чипа. Оказывается, TSMC обожает менять местами сигнальные ножки процессора и каждый новый семпл либо ревизия требует переделки дизайна разводки платы.

Фамилию и e-mail не дам - самому пригодится ;-)

Энергопотребление

Одна из самых серьезных проблем для видеокарт - тепловыделение ядра и чипов памяти.

Референс-карта ATI Radeon X800XT потребляет всего ~70Вт, что в полтора раза меньше 110Вт, необходимых GeForce 6800 Ultra. Откуда такая фантастическая разница, ставшая уже традиционной для конкурентных моделей обеих компаний? Ответ очевиден - 160 миллионов транзисторов с использованием диеэлектрика Low-k против 222 миллионов без Low-k для чипов NVIDIA, плюс более современное ядро от ATI ноги которого растут из Radeon9700Pro, доводимого в свое время практически вручную. И третье - все энергосберегающие технологии ATI для мобильных решений внедрены и на обычных графических процессорах ATI. Конвееры просто отключаются в случае их простоя.

Нынешнее основное ядро NVIDIA на два поколения старше и со временем обросло довесками и новыми блоками, что в итоге неминуемо ведет к общему "снижению КПД". Впервые это стало очевидно с выходом NV30, и NVIDIA стоило больших усилий не потерять лицо и срочно заняться модернизацией и доводкой чипа - кстати, получилось не плохо. Но история повторяется - опять необходимость в двухэтажной системе охлаждения (первоначально карту пытались спроектировать с низкопрофильным блоком охлаждения) и, на этот раз, уже два обязательных коннектора питания molex, которые необходимо подключать к двум разным шлейфам питания. Рекомендуемая мощность блока питания системы с установленной NV40 - 480Вт. Достать такие БП в России весьма непросто, а стоимость ~120-150$.

GeForce 6800Ultra

Кол-во транзисторов на чипе ключевым образом влияет и еще на несколько его характеристик. Чем их больше - тем меньше процент выхода годных кристаллов, ниже частота чипа и возрастают трудности подвода питания на кристалл (больше зон).

ATI Radeon X800XT имеет один коннектор питания стандарта molex. Желтенький коннектор непонятного назначения присутствует только на референсах, розданных тестовым лабораториям и изготовленных на собственном небольшом производстве ATI для собственных тестовых целей. На картах, которые поступят в продажу, его не будет.

И еще немного о питании современных карт - 70Вт это больше, чем можно подать через шину AGP, но меньше(!), чем держит PCI-Express16 (~75Вт). Как следствие, при появлении новых материнских плат, можно ожидать и карт R420 без какого-либо дополнительного питания. Да и NV40 скорее всего избавится от одного из двух коннекторов в своем варианте PCI-E. В любом случае, срок выпуска AGP вариантов что Radeon X800XT, что GeForce 6800Ultra ограничен несколькими месяцами, после чего они станут раритетами. Как только Intel анонсирует Alderwood и Grantsdale, компьютерная индустрия будет быстро переведена на рельсы PCI-E.

VIVO

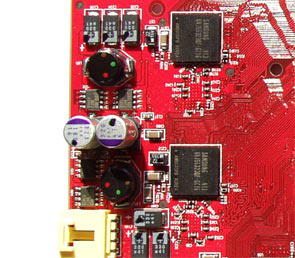

Обе карты Radeon Х800 имеют чип VIVO (старый RAGE THEATER) на борту. Из предыдущей серии 9800XT, только карта от ASUS оснащалась чипом Theater 200.

Традиционно в главе "карта" рассматривается и память, но на этот раз тема так громадна, по потребовался вынос ее на отдельную страницу.

Стр.3 - Память GDDR3

Память GDDR3

На картах серии Radeon X800 установлено 256 Mb GDDR3 SDRAM памяти. Это абсолютно новая архитектура чипов графической памяти, предложенная специалистами компании ATI в качестве открытого стандарта и одобренная JEDEC.

| JEDEC (Joint Electronic Devices Engineering Council) - Совет по совместной разработке электронных компонентов. Создан в 1960 году Ассоциацией электронной промышленности (EIA - Electronic Industries Alliance) и Национальной ассоциацией производителей электрооборудования (NEMA - National Electrical Manufacturers Association) с целью совместной разработки стандартов на электронные устройства и снижения затрат на создание новых устройств путем совместного обмена информацией. Сегодня, большинство изготовителей и разработчиков электроники во всем мире являются членами JEDEC. |

Именно Джо Макри (Joe Macri), главный технический директор ATI (работает в американском офисе ATI в Santa Clara), возглавлял разработку отраслевых стандартов GDDR3 с последующим утверждением в JEDEC, а сейчас является председателем комиссии по разработке уже следующего стандарта - GDDR4 в комитете JEDEC.

Joe Macri (технический директор ATI)

Задачи, которые ставились при разработке GDDR3, достаточно предсказуемы - поднять эффективность памяти при сохранении совместимости с исходной архитектурой DDR:

GDDR2 vs GDDR3:

| Преодоление ограничений и недостатков DDR | ||

| Сохранение обратной совместимости с исходной архитектурой DDR | ||

| Архитектура, поддерживающая настольные системы верхнего ценового диапазона (UHE) и рабочих станций | ||

| Совместимость с мобильными системами и системами среднего ценового сегмента (через 6-9 месяцев) | ||

| Упрощенная структура DRAM, упрощение архитектуры системы, применение DRAM везде, где возможно | ||

| Новая архитектура на ближайшие несколько лет | ||

| Поддержка частот более 600 МГц | ||

| Единый отраслевой стандарт, т.е. единая спецификация для всех |

++ задача выполнена полностью

+ задача выполнена с оговорками

- пролет

Как видно из представленной таблицы, на этот раз удалось избежать главной ошибки предыдущей архитектуры - разночтение стандарта.

Впервые память GDDR3 была продемонстрирована на осеннем IDF прошлого года. А первой компанией, реализовавшей GDDR3 в массовом коммерческом продукте, по иронии судьбы, стала NVIDIA с вариантом карты FX5700Ultra DDR3. Эксперимент оказался удачным - карта потребляла меньше питания, была холоднее и все это на фоне даже пусть и небольшого повышения производительности (см. результаты тестов в "VGA Roundup").

Что такое GDDR3?

| I/O | SSTL-2 | SSTL-18 with ODT |

POD-18 |

| Синхронизация: | DQS | Differential DQS or DQS | Unidirectional DQS |

| Частота | 166-450Mhz | 400-500Mhz | 500-800Mhz |

Для избежаний разночтений мы не стали переводить эту табличку. Специалистам более привычны английские наименования, а нормальным людям, возможно, это не интересно вовсе ;-) Но что такое POD и Unidirectional DQS стоит пояснить.

POD (Pseudo Open Drain)

Технология псевдо-открытой стоковой области:

- Стоковая область, управляемая напряжением, против стоковой области, управляемой током (приводит к сокращению площади формирования выходных импульсов);

- опорное напряжение Vref = 1.26 в против 0,9 в на DDR2;

- Контроллер, поддерживающий DDR, GDDR2 и GDDR3;

- Упрощенная конструкция DRAM (позволяет использовать N-канальные МОП-транзисторы в проектировании блока приема импульсов DRAM);

- Снижение мощности и упрощение структуры MC/IO;

- Упрощение синхронизации за счет незанятого состояния строб-импульсов = VDDQ.

В GDDR3 реализована подача однонаправленных асимметричных DQS-импульсов, что выгодно отличается от подачи двунаправленных дифференциальных DQS-импульсов в DDR2 для приложений P2P:

| Дифференциальные импульсы

(Differential):

|

Однонаправленные импульсы

(Unidirectional)

|

Также гарантируется совместимость с DDR и DDR2 по остальным параметрам, таким как:

- Структура данных та же, что и для DDR (Централизованная запись; согласование по записи);

- Импульсы синхронизации те же, что и в DDR

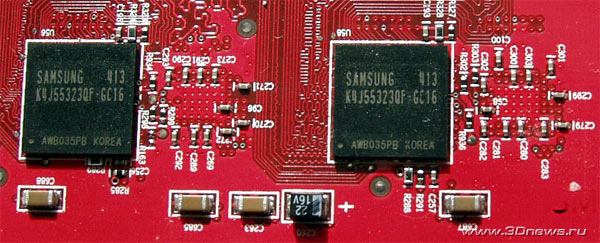

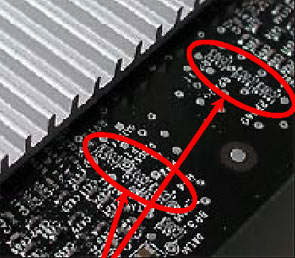

Совершенно не хочется превращать данный материал в учебник по микроэлектронике и скажем проще - убраны лишние резисторы, а блок стабилизатора напряжения на карте упростился в два раза, что хорошо видно на фотографиях:

|

|

Низкая потребляемая мощность памяти GDDR3 приводит к меньшему нагреву чипов при серьезном увеличении тактовой частоты. Чипы просто холодные и на картах серии Radeon X800 даже не установлены радиаторы на чипах памяти. Оверклокерам явно должно понравиться ;-) Ведь ничто не мешает установить ее самим. Только помните цифру - 105 градусов Цельсия - после достижения которой происходит утечка данных. В GDDR3 реализована постоянная калибровка входных/выходных импульсов, что гарантирует стабильную температуру и напряжение.

И последнее её неотемлемое приятное свойство - упрощенная синхронизация. Как следствие - высвобождение ресурсов в системе ввода/вывода и минимизация длины критических каналов.

Уфффф...ФФФФсё!

Не часто нас так грузят технологическими подробностями (да еще и на английском языке), так что грех не выложить читателям всю свежезагруженную в голову информацию. Следующая наша лекция, уже по GDDR4 состоится в 2005-м году, потому как завершение ее стандартизации намечено к концу нынешнего года.

Память GDDR3 на картах серии X800

Сейчас память GDDR3 уже производится всеми ведущими игроками на рынке памяти, компаниями Samsung, Hynix, Micron, Infinion и Elpida.

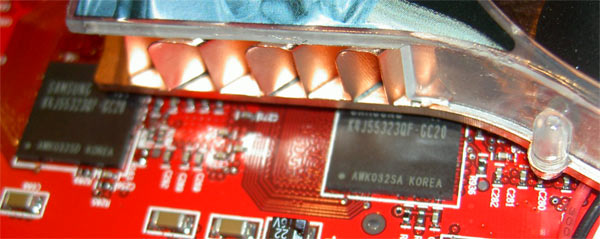

На карте Radeon X800 в версии XT установлено 256 Mb GDDR3 SDRAM памяти, набранных из 8-ми чипов Samsung K4J55323QF-GC16 с максимальной частотой 600Mhz (резульрующая 1.2 GHz). В BIOS видеокарты частота памяти выставлена на 560(1120Mhz), т.е. с некоторым запасом. Чипы установлены по четыре с каждой из сторон и не требуют какого-либо охлаждения. Напряжение питания 2.0V (сравните с 2.8-2.5V на популярной серии чипов K4D263238E-GC).

Samsung в своей линейке GDDR3 предлагает и еще более скоростные чипы - GC14 и GC12 (700 и 800MHz соответственно), вполне возможно появление в продаже более продвинутых и дорогих карт на основе чипа R420 от производителей, предпочитающих самим разрабатывать и производить VGA, например, ASUS. Правда, в этом случае, чипы памяти придется охлаждать, что потребует переработки и всей системы охлаждения карты, что для некоторых производителей не представляет серьезной проблемы.

В варианте Radeon X800 Pro использован нижний чип памяти той же серии - Samsung K4J55323QF-GC20, но с максимальной частотой 500MHz(1GHz). В BIOS видеокарты частота памяти выставлена на 450(900Mhz), т.е. опять с некоторым запасом на разгон. Но разгонять пока нечем.

GDDR3 Samsung K4J55323QF-GC20 (для карт Radeon X800Pro)

Стр.4 - Технологии. Demo "Ruby: The DoubleCross"

Технологии. Demo " Ruby: The DoubleCross "

Со времен выхода первой карты 3DFX у видеоиндустрии появилась хорошая традиция - к запуску нового чипа собственными силами подготовить технодемку, во всей красе демонстрирующую новые графические горизонты, поскольку, пока дождёсся реализации новых технологий в реальных игровых продуктах - поседеешь.

Самые удачные демки становятся культовыми символами продукта, вспомните "бабочку" от NVIDIA. Эту бабочку пора включать во все учебники по маркетингу как фантастически удачный пример чисто имиджевой подачи высокотехнологического продукта.

С выходом "Dusk" полностью изменилась сама концепция подхода к заказам технодемок, теперь их основная и единственная цель - РЕКЛАМА, а демонстрация новых возможностей чипа - это вторично. Сегодня "демки" выполняют роль телевизионной рекламы - удивить, ошеломить и зацепить внимание. В случае задействования средств Интернета - даже заставить добровольно и за собственные деньги качать из сети сначала ролики, снятые на презентации, а потом и сам исполняемый файл (если выложит производитель).

"Agent RUBY is authorized in use of extreme force and has global diplomatic immunity"

Самое экстремальное оружие Руби :-)

Прожжёные технари из ATI наконец это поняли. На сей раз для представления публики карт серии X800 обошлось без огров и прочей нечисти, а в роли завлекаловки выступает вполне симпатичная девушка "Ruby", выполняющая суперсекретное правительственное задание, правда, в одетом виде! Вы видели когда-нибудь одетых шпионок??? Я - нет.

|

|

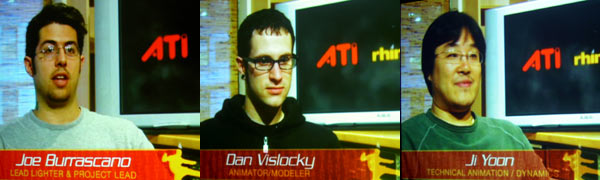

Демо " Ruby: The DoubleCross " создавалась совместными усилиями ATI и компании "RhinoFX". RhinoFX - не последний игрок на рынке трехмерной анимации, среди ее клиентов такие компании как General Motors, Sony, Motorola, BMW, Procter & Gamble, Ford и т.п...

В нашем случае, совместно с компанией ATI ребята из RhinoFX прошли технологический тренинг и освоили все новые возможности трехмерных ускорителей серии X800. В частности, в демке активно используется возможность создания комплексных команд шейдеров (до 512-ти инструкций) и новая технология сжатия карт нормалий (normal map) получившая название 3Dc.

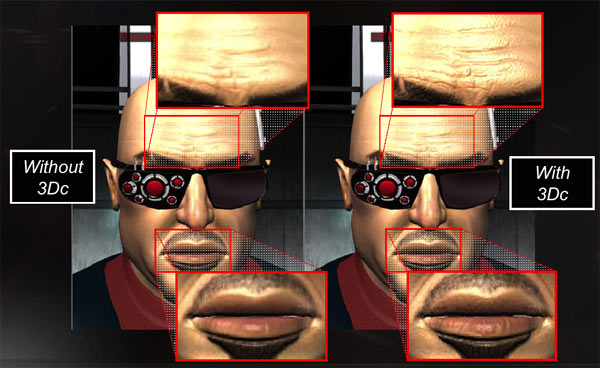

Технология 3Dc

|

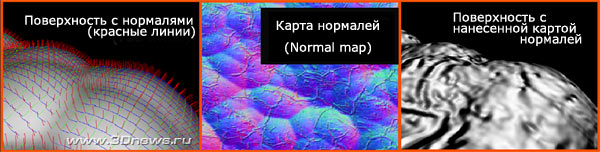

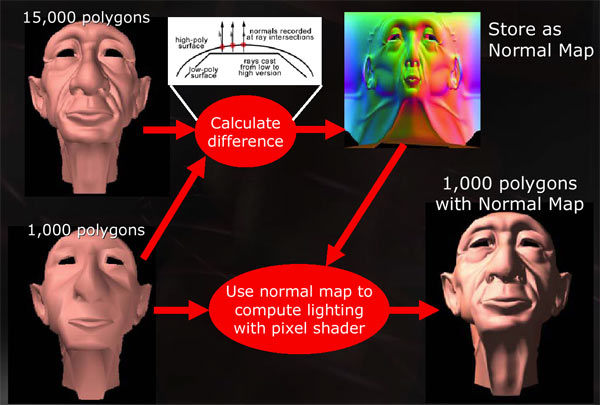

Технодемки: Сегодняшние трехмерные изображения в играх до сих пор состоят из элементарных треугольников, на которые "натянуты" 2D текстуры. Чем больше треугольников - тем точнее представлена форма и объем объекта. Но каждый раз вычислять миллионы координат для правильного создания трехмерного объекта слишком расточительно. Был найден простой и эффективный метод - карта нормалий (normal map). Метод позволяет на достаточно простой объект, состоящий из ограниченного кол-ва элементов, наложить специальную текстуру, которая отвечает за правильное учитывание освещенности объекта и тем самым корректно отображать объем поверхности. Сами карты нормалий уже интенсивно используются как в последних вышедших играх (например Far Cry и Lord of the Ring), так и ожидаемых Half Life 2, Doom 3 и Serious Sam 2.  "Нормали" как стрелка, которая указывает правильное перпендикулярное направление от сложной поверхности в любой ее точке. Эти данные необходимы для вычисления того, как свет должен отражаться от этой точки поверхности, а сами normal map представляют из себя обычные текстуры, где вся необходимая цифровая информация хранится в цветовом виде. Возможно, никто ничего не понял, поэтому по пунктам:

Для иллюстрации воспользуемся следующей картинкой из презентации ATI:  Как и любая текстура, карта нормалий имеет свои ограничения на объем представленной информации. Для уменьшения объема текстур используется технология сжатия DXTC:  Как видим, итоговый результат, после использования существующих методов сжатия, далек от оригинала. ATI предлагает разработчикам новый инструмент улучшения качества сжатия карт нормалей - технологию 3Dc, хардверно реализованную в чипе R420.  Мы не будем сильно вдаваться в математическую модель процесса - специалисты смогут детально ознакомиться с ней по технологической документации на сайте ATI. Отметим только результат внедрения - сжатие 1:4 (один-к-четырем) при сохранении идентичности оригиналу, что приводит к экономии пропускной способности шины памяти при повышении реалистичности отображения трехмерных моделей. Мы уже не раз наблюдали бравурные анонсы и такие же тихие похороны фирменных инициатив - достаточно вспомнить TrueForm (ATI). Будем надеяться, на этот раз разработчики воспользуются новой технологией, тем более, что она крайне проста в реализации. Croteam буквально за два часа ввел в демо-версию "Serious Sam 2" поддержку 3Dc, но это возможно при условии, что есть деталированные модели. На сегодня технология 3Dc анонсирована в таких ожидаемых и культовых проектах как Serious Sam 2, Half Life 2, Pirates! Сида Мейера, Tribes Vengeance и DarkSector.

|

|

|

А в случае сравнения примерно однозначных видеокарт, FRAPS совершенно не годится. Кто ж сможет совершенно одинаково прокатиться по трассе NFS:Underground? (В принципе это возможно, если выбрать Free и отсутствие трафика на трассе).

И самое болезненное - читинг и оптимизации от NVIDIA. Вот на этом придется остановиться подробней. Дело в том, что "читинг" и "оптимизации" это совершенно различные понятия. Так что же это такое, откуда ноги растут и в чем, собственно, проблема? Попытаемся объяснить как можно проще.

Архитектуры конвееров графических чипов ATI и NVIDIA, разумеется, различны. Если в двух словах - конвеер от NVIDIA длиннее и теоретически за один такт способен обработать (протолкнуть) больше данных, чем короткий конвеер от ATI. Но при одном обязательном условии - входные данные обязательно должны быть оптимизированы (упорядочены) под последовательную обработку данных именно этим конвеером. Одна ошибка и привет. Данные заворачиваются на начало, делается новая выборка и опять поступает на обработку. Полностью исключить холостые такты невозможно, но вполне можно и нужно уменьшить их процент. Достигается это двумя факторами - общим улучшением работы алгоритма предсказаний

ветвлений в компиляторе, либо прямым прописыванием в компиляторе для каждой конкретной игры - как же обрабатывать ее код оптимальным образом. Именно этот второй метод и называется "оптимизацией" и он вполне легален. Другое дело, что этот геморой дорого обходится NVIDIA. У них целый штат сотрудников (говорят, не менее 10-20 человек) получает немаленькую зарплату только за то, что днем и ночью анализирует чужой код (все новые игры), прекрасно держа в голове особенности работы своего компилятора. Это адская работа, требующая невероятной квалификации. Но они вынуждены это делать и будут делать это ВСЕГДА! Как бы и кто бы их не уговаривал прекратить свою деятельность. И тут NVIDIA абсолютно права.

Если все данные пролетают по конвееру нормально, без заворотов в начало и дополнительной выборки - то потенциально, NVIDIA должна серьезно выигрывать у конвееров ATI. Но только в теории. Так в жизни не бывает - это как кривые зубчики у шестеренок часов, изготовленных вручную в 17-м веке - вероятность полного сочленения, так же падает на порядок при увеличении радиуса сочленения.

В качестве иллюстрации, предлагаем читателям самим оценить вероятность благополучного исхода событий для левого и правого случая. Все бесконечные новые версии драйвера Detonator/ForceWare как раз и включают в себя все новые и новые оптимизации НОВЫХ ИГР. |

Чтоб хоть как-то облегчить себе существование и был разработан язык Cg, но инструментарий от NVIDIA оказался таким замороченным и сложным, что разработчики в своем поголовном большинстве практически его не используют. А если и решаются его освоить, то необходима финансовая и технологическая поддержка от NVIDIA (маркетинговая программа "Вот как надо играть" :-)

А что же ATI? А ATI это делать нет нужды - компания пошла по другому пути. Они используют короткий конвеер, а за счет меньшего кол-ва транзисторов на кристалле смогли даже в R420 увеличить частоту работу чипа по сравнению с NV40 (525Mhz против 400). С одной стороны - короткий конвеер обрабатывает меньше данных за такт, но зато меньше пустых циклов, а еще и повышенная частота его работы по сравнению с конкурентом, да и на оптимизацию всего подряд собственными силами тратиться нет нужды.

Компиллятор ATI отличается высокой предсказуемостью результатов и стабильностью. Даже сейчас, на бета версии драйвера Catalyst 4,5 (для серии X800), ни разу не возникли какие-либо проблемы. Драйвер предсказуем в своей производительности и, в отличии от ForceWare, никогда не демонстрирует необъяснимых прибавок в производительности либо таких же странных провалов.

Терри Македон (Terry Makedon)

"Mr. Catalyst" - руководитель отдела

разработки драйвера Catalyst

Так что "оптимизация а-ля NVIDIA" - вынужденная мера компании и если ее не производить, то результат будет катастрофичен. В качестве типичного примера рекомендуем посмотреть результаты тестов в обзоре "3DMark2003 build 320 vs 340: Редкий момент истины?", когда Futuremark в момент наивысшего накала страстей блокировала все оптимизации NVIDIA для теста 3DMark2003.

Отчего это было сделано? И вот тут мы вплотную подошли к рассмотрению проблемы "читинга", которая, в отличии от "оптимизаций" уже не является легальным методом конкурентной борьбы.

У Futuremark есть специальная версия теста 3DMark2003, позволяющая производить облет карты и однажды, на одном из драйверов Detonator/ForceWare, была обнаружена пропажа целого куска карты в одном из тестов. В принципе, в тесте этого фрагмента карты не видно, но факт остается фактом. Futuremark не стал разбираться что к чему относится, а просто заблокировал единым махом все оптимизации и читы, легальные и не очень. Обе компании были в ярости. Futuremark дорожит своей репутацией и им совсем не хочется ее терять, и так их бедных полоскают почем зря....

Договоренности были достигнуты следующие: NVIDIA обязалась не переступать "критического порога" в продуктах Futuremark, а последние обязались не предавать гласности эту историю :-).

Стр.6 - Тестирование: синтетика

Тестовая конфигурация

| CPU | P4 3,2Mhz 800FSB (Northwood D1) |

| Mb | Epox 4PDA2+ (i865PE) |

| Memory | PC2700 2x256Mb 400Mhz в двухканальном режиме Тайминги - 2:6:3:3 |

| OS | WinXP + SP1 |

| Драйверы | Forceware 56.72 для FX5950Ultra & Forceware 56.72

Catalyst 4,5 BETA для тестеров |

Тестовые программы:

-

Cинтетика:

- 3DMark2003 v340;

- Codecreatures v1.0.0 (DirectX 8.1 приложение, шейдеры, Hardware T&L);

- AquaMark 3 (DirectX 9.0, Vertex Shaders 1.1/1.4/2.0, Pixel Shaders 1.1/1.4/2.0, Hardware T&L, режим AquaMark3 Triscore);

Игровые приложения:

- Unreal Tournament 2003 Demo (Direct3D, Hardware T&L, вершинные шейдеры, Dot3, cube texturing.);

- Gun Metal Benchmark 2 v1.20s (DirectX 9.0 бенчмарк, Vertex Shaders 2.0, Pixel Shaders 1.1, Hardware T&L);

- X2: The Threat Demo (Direct3D, мультитекстурирование, Dot3, режим встроенного в демо-версию бенчмарка);

- Final Fantasy XI Official Benchmark 2 (бенчмарк для оценки производительности в будущей игре Final Fantasy XI. Данных по характеристикам движка игры разработчики не предоставляют);

- Core Design / Eidos Entaractive Tomb Raider: Angel of Darkness v49 (DirectX 9.0, Vertex Shaders 2.0, Pixel Shaders 2.0);

- Valve Software/Vivendi Universal Games Half-life 2 leaked beta (DirectX 9.0, Vertex Shaders 2.0, Pixel Shaders 2.0);

- GSC GameWorld / Руссобит М FireStarter (DirectX 8.1/DirectX 9.0, пиксельные и вершинные шейдеры, система частиц, динамические источники света, проецируемые текстуры);

- Crytek / UbiSoft FarCry (DirectX 9.0, Pixel Shaders 2.0, настройки качества на максимально возможном уровне, использовалась собственная записанная демка "3Dnews001").

В тестировании приняли участие три предыдущих поколения Hi-End карт ATI: Radeon 9700Pro/9800Pro/9800XT. Положение NVIDIA обозначалась картой FX5990Ultra (пунктир на графиках).

Цель тестирования: выявляем разницу в производительности поколений видеокарт ATI.

3DMark 2003 Pro ver340

Мультекстурирование и скорость обработки пиксельных шейдеров 2.0 честно возросли в 2,5 раза. Всё остальное (кроме Wing Of Fury - самого старого теста) - в два раза. Невозможно себе представить выпуск процессора Pentium, который бы подобным образом продемонстрировал прибавку. Видеоиндустрия еще способна творить чудеса!

3DMark 2001SE

Спортсмены будут разочарованы - из теста выжаты уже все соки.

Codecreatures

Cначала общий счет при стандартном качестве изображения (AA и AF отключены):

В этом тесте использованы пиксельные шейдеры 1.1 и карты NVIDIA всегда чувствовали себя уверенней. Прибавка для Radeon X800 XT конечно не двукратная по сравнению с Radeon 9800XT, но впечатляет.

Раскладка по разрешениям вплоть до самых сверхвысоких:

Codecreatures 4xAA / 8xAF

Включаем качество и наслаждаемся результатом:

Это просто невероятно! Более чем двукратный рост (два с половиной раза). Radeon X800XT уходит в фантастический отрыв от всех предыдущих поколений! Запас "прочности" (мы называем этим термином разницу в падении производительности при стандартных настройках и при включении агрессивных настроек качества изображения) железобетонный.

Раскладка по разрешениям:

9700Ultra не выдержал издевательств в разрешении 2028x1536 и честно сдался - памяти не хватило.

Aquamark 3

Последний "условно-синтетический" тест. Все же он сделан на движке реальной игры...

Ощутимая прибавка, хотя и не так впечатляет, как рывок в Codecreatures.

Переходим к реальным играм...

Стр.7 - Тестирование: игровые приложения

UT 2003

Начнем со старенького UT2003, впрочем, и в "новеньком" UT2004 в движке мало что поменялось. Так как без включения настроек качества игра давно уперлась в свой технологический потолок на всех верхних картах, то тестирование производилось исключительно в качественном режиме.

HALO

Тот же самый клинический случай, что и Unreal Tournament 2003. Сразу же пришлось включать всё по полной и тестировать все карты исключительно в режиме 4AA/8AF.

Все старые карты стартуют из точки, где X800 XT уже закончил свой победный марш.

Final Fantasy XI Official Benchmark 2

Игра уже вышла и лежит на прилавках всего мира - толстая такая коробка с оформлением в стиле японского аниме - это и остановило от преждевременной покупки. Наша бухгалтерия ни в жизни бы не поверила, что это "тестовая программа" и отказалась бы оплачивать чек в 60$. Поэтому - что там в этой игре я до сих пор не знаю, а сам тест уже порядком надоел - толпы эксимоских детей, скачущих на павлинах в полушубках по джунглям Амазонки, уже снятся ночами... и наутро некоторые несознательные гражданки жалуются, что я пинаюсь... Сознательные благоразумно готовят кофе ;-)

В общем, подробностей об этом тесте как не было так и нет... что там меряется, в каких попугаях, что использовано - непонятно.

GunMetal Benchmark

DirectX 9.0 бенчмарк, но условный. Активно используются Vertex Shaders версии 2.0 и Pixel Shaders старой версии 1.1.

Традиционная картина - игра для карт нового поколения откровенно слаба. Во втором тесте опять практически прямая линия для карты X800 XT.

А общий рывок в производительности хорошо демонстрирует этот график:

X2 - The Threat Rolling Demo

Мультитекстурирование и Dot3 - никаких шейдеров.

Карты ATI не любят технологию трафаретных теней, но, тем не менее, если не включать AA+shadow, то можно поиграть в разрешении 2048x1536 на 82-х кадрах в секунду! Полный беспредел.

Half Life 2 Leaked Alpha

Похоже, демо-версия Half Life 2 стала играбельной на разрешении 1600x1200, демонстрируя 82 кадра на X800 XT. Еще вчера в этот трудно было поверить. А в разрешении 1024x768 отчетливо виден потолок.

На нашей второй записанной демке к Half-Life2 вообще нет никакого падения на всех разрешениях экрана. Для X800 XT что Half-Life2 что Commanch4 - одного поля ягоды ;-) Сильно надеемся, что в окончательной версии игры можно будет выставлять заоблачные условия качества изображения.

Для широты общего мировосприятия опубликуем тест всех видеокарт на разрешении 1024x768 в первой нашей демке к HL2:

Tomb Rider: Angel of Darkness

"Tomb Rider: Angel of Darkness" тяжелая DX9 игра - и опять четкий двукратный рост производительности на высоких разрешениях. Пора менять мониторы на 23` :-)

Видеокарты предыдущего поколения играбельны только в разрешении 800x600 и 1024x768.

В демках paris2g и paris1c все видеокарты стартуют из одной точки, а Radeon X800XT в демке paris1c так на ней и остается в любых разрешениях. В это невозможно поверить! Ну и когда Intel наконец выпустит 4Ггц процессор?

Firestarter

Достаточно несложная игра даже для предыщих поколений видеокарт, и для получения адекватных результатов, мы сразу же закрузили ее настройками 4AA и 8AF.

Еще один недостаток бенча - позволяет снимать результаты только в двух разрешениях. Сверхвысокие разрешения остаются недоступны, а на 1280x1024 наш сегодняшний подопытный не может показать себя во всей красе.

FarCry

И гвоздь программы - Far Cry (наверное, все предыдущие результаты вы быстренько пропустили, ища глазами цифры по FarCry :-) По крайней мере, именно такая реакция была у высшего менеджемента ATI, когда они вчера смотрели эти тесты.

Использовалась полная версия игры (кстати, закупленная в Торонто). Она уже включала в себя установленный патч 1,1 который достаточно хорошо фиксил производительность карт FX в обработке пиксельных шейдеров 2.0.

Все настройки выставлены на Very High Quality... кроме качества отображения воды - она Ultra High Quality. Проделаны две серии тестов - в режимах с AF level 1 и AF level 4

Если оставаться в рамках приличия и поумерить радостные эмоции, то вывод очевиден - даже Far Cry слишком прост для Radeon X800 XT!

И, наконец, включаем AF level 4:

Если бы на стенде стоял процессор помощнее раза в полтора - то Radeon X800 XT показал бы совершенно плавную дугу, как и остальные карты, но увы... сегодняшним своим ударом видеоиндустрия взлетела так высоко, как никто не ожидал.

Для прогона FarCry использована собственная demo, записанная на карте "research 6". Поступает много просьб рассказать о технике тестирования в этой игре - всё просто.

Инструкция по тестированию FarCry:

- Устанавливаете полную игру, ставите патч 1.1 - фиксит шейдеры на NV3х

- Положить нашу демку (всего 200kb) в каталог путь_куда_установлена_игра/levels/research

- В ярлыке к игре прописать -DEVMODE

- Стартуете игру - настройки графики через меню

- Далее открываем консоль (~) пишем "map research 6". Загружается карта

- Опять консоль - пишем: "demo 3dnews001" - пошёл прогон и быстренько жмем (~) для закрытия консоли

- Прим: в самой консоли кавычки командам ставить не надо

- Прим для читеров: запустите игру в режиме -DEVMODE, загрузите любую карту, нажмите P - получите любое оружие, O - 999 единиц боеприпасов (чит найден собственноручно и совершено случайно :-)

Стр.8 - R420 vs NV40: первый взгляд

R420 vs NV40: первый взгляд

GeForce 6800Ultra (NV40) лишь несколько часов постоял на нашем стенде и за такой срок проделать полноценное тестирование невозможно, но несколько цифр были сняты и первые впечатления получены.

Естественно, это не отменяет священную обязаность полного тестирования, а пока - "первый взгляд". Тем более, что драйвер ForceWare60,72 вел себя сильно капризно, а несколько тестов (например, GunMetal и UT2003) просто не запустились. Вчера вышел поправленный драйвер (ForceWare 61.11) и лучше проделать новые и более полные тесты.

Просто цифры, и пока без комментариев.

Стр.9 - Выводы

Выводы

Все предыдущие карты Hi-End - это мусор по сравнению с новым поколением графических чипов. На фоне двукратного роста производительности в современных тяжелых игровых приложениях - все тестирования предыдущих продуктов с мизерным приростом и ловлей блох кажутся несерьезными. Нам клятвенно был обещан двукратный рост - мы его получили. В первый раз за много лет потребителя не обманули.

Необходимо отдавать себе отчет, что новые карты предназначены исключительно для новых игр, для очень-очень мощных центральных процессоров и хороших мониторов, где могут в полный рост продемонстрировать потрясающее качество картинки в самых сверхвысоких разрешениях, при максимально агрессивных настройках качества, и всё это при сохранении играбельности. А разработчикам игр предоставляются новые горизонты для всевозможных экзотических экспериментов в создании самых изысканных эффектов.

Первые карты Radeon X800 Pro сегодня поступят в продажу под маркой ATI для североамериканского континента. Как нас заверили тайваньские партнеры ATI - их варианты доберутся до России через две недели (таможня, отгрузка)... Еще через пару недель в продажу должна поступить Radeon X800 XT.

Напомним - стоимость версии Pro составляет 400$ и есть целых две недели для поиска приличного монитора и процессора Athlon64/P4 EE...

Торонто - столица ATI :-)

(Снято с CN Tower)

Карта "Radeon X800 XT" предоставлена московским представительством компании ATI

Сердечно благодарим:

- Александра Жаворонкова и Николая Радовского (ATI Russia) - за организацию поездки в Торонто на "ATI Technology Day"

- Рика Бергмана (Rick Bergman) - главного вице-президента ATI по маркетингу, Терри Македон (Terry Makedon) - Sr. Product Manager - Software Desktop Discrete Graphics, Joe Macri (ATI USA) - за отменный семинар по GDDR3, Криса Хука (ATI Europe)

- Андрея Воробьева (iXBT) и Павла Пиларчика (Pavel Pilarczyk PCLab.pl) - за интересное общение в Канаде

- Геннадия Ригера, Ирину Крамцову и Романа Киричинского (сотрудники ATI) - за встречи и проводы из аропорта, потрясающие экскурсии, заботу и опеку ;-)