GeForce2 MX vs Radeon SDR

Стр.1 - Описание

Автор: Миргородский МаксимМы уже привыкли к ожесточенной конкуренции между Intel и AMD, но если оглянуться назад и посмотреть на состояние компаний до середины 1999 года... Тогда безусловным лидером был Intel, и это было аксиомой. AMD выпускал свои, казалось бы, очень конкурентоспособные продукты немного позже, чем Intel. Вся линейка K6... Ведь если бы где-нибудь на полгода раньше... Времена поменялись. Athlon перевернул все представления о лидерах процессорного рынка. Признайтесь, это очень напоминает то, что происходит сейчас на рынке графических карт. Для полноты картины нам не хватает лишь одного - своеобразного Athlon`а для ATI. Вот только представьте, что бы было, если бы линейка "Radeon" вышла на полгода раньше?! А так... После анонса "GeForce 2 GTS" это было уже не то... Ведь имелись многие бенчмарки, по которым детище ATI обгоняло конкурента, но тут опять помешал неcколько своеобразный "стиль" ATI. Мало того, что продукты появились слишком поздно, так у них еще и были понижены частоты (для всех тестов давали Retail версию с частотами 183/366, а предназначенные для продажи OEM`ы имели 166/333)!

Высокоскоростное решение провалилось. Но кроме Hi-End рынка существует еще и Middle-End, и Low-End. Уровень продаж последних в несколько раз выше уровня "> 200$" карт! И здесь ATI имеет все шансы. Супер-скорости не нужно, а необходима очень низкая цена и конкурентоспособная производительность. Об откровенном Low-End мы пока говорить не будем ("GeForce 2 MX 200" and "Radeon VE"). Это тема для отдельной статьи. Для сектора Middle-End решений ATI представила "Radeon SDR", который от обычного "Radeon" отличался только типом памяти и частотой (по непонятным причинам пониженной на 6 Mhz). nVidia же, помимо установки SDR памяти, кастрировала 2 конвейера рендеринга и серьезно понизила частоту чипа для обрезанной версии. По-моему, это правильный шаг. Не думаю, что скорость 4-х конвейерного 200Mhz монстра хоть как-то отличается от 2-х конвейерного 175Мгц чипа при использовании очень медленной SDRAM памяти. Беглые тесты, проводимые в то время, показали примерно равную скорость.

Ценовой марафон стартовал. Поначалу с огромным отрывом побеждал GeForce2 MX, брэндовые платы которого стоили на 30, а то и 40 долларов дешевле Radeon SDR. Видимо, нашлось не много покупателей, способных отдать 160$ за Middle-End карточку, и стоимость поползла вниз... Сейчас мы видим, что платы от ATI не просто догнали, а даже перегнали по ценам брендовые GF2MX! Естественно, изменилось и представление о SDR`е. Покупатель столкнулся с дилемой, что лучше? В нашем обзоре мы наивнимательнейшим образом рассмотрим 2 карты от двух конкурирующих фирм. Среди производителей GF2MX был выбран MicroStar (aka MSI) по двум причинам: одинаковые с Radeon SDR цены (OEM версий) и повсеместная распространенность на российском рынке. Итак, платы перед нами, приступим.

StarForce817

Плата представляет собой копию референс-дизайна от nVidia. Справа от графического процессора расположены 32Mb 6ns памяти, размещенной с лицевой стороны PCB в 4х чипах. Память произведена компанией WinBond (несмотря на то, что на коробке изображена память от Samsung). Чип функционирует на 175Mhz, память на 166, - стандартные значения. Видео процессор накрыт игольчатым радиатором большого размера. Также присутствуют отверстия для возможности установки других теплоотводных решений. Между радиатором и чипом нанесена термопаста. Разъем один - D-SUB. Никаких там TV-OUT, DVI, TwinView и пр. В принципе, для очень дешевых вариантов на GF2MX это норма.

Видео карта поступила в Ratail комплекте. В коробке стандартного размера находилась сама плата, 3-х страничная книжка-раскладка, 2 диска с драйвером и утилитами, огромные куски паралона, между которыми все это находилось. В книжке (если это так можно назвать), кроме подробной инструкции по установке карты в слот и установке драйвера, ничего нет, полноценная инструкция находится на диске. На первом диске записаны драйверы. Причем, не только для StarForce817, но и для других карт производства MSI (включая Trident Bade 3D, Savage3D и т.д.). Для GeForce2 MX имеются референс-драйверы Detonator 5,32 и Detonator 6,18. Из утилит присутствуют Adobe Acrobat Reader 3.01, MS DirectX 7, MSI 3DTurbo 2000 (утилита, предназначенная для настройки и разгона карт от MicroStar). На втором диске лежат программы MSIDVD, MS Internet Explorer 5.0 и... та же 3DTurbo 2000. Плюс, записано несколько коротеньких DVD демок. Короче, софт беден, ничего по-настоящему полезного там нет (кроме драйвера и инструкции).

Radeon SDR

По размерам RSDR больше предшественника. На лицевой стороне PCB расположены 32Mb 6ns памяти в 4х чипах. Память производства Micron. Частоты синхронны и равны 160Mhz. На видео процессоре прилеплен радиатор с вентилятором. Именно прилеплен, отверстий для установки других систем отвода тепла нет. Не скрою, вентилятор не самый тихий... Его шум отчетливо слышен на фоне Chrome Orb на 7В, винчестера c частотой оборотов 7200rpm на антивибрационной подставке, вентилятора на блоке питания и дополнительного вентилятора. Кулер можно демонтировать от радиатора и использовать другой, менее шумный (а можно попробовать понизить напряжение на этом). Чип греется очень незначительно (гораздо меньше, чем чип GeForce2 MX с пассивным охлаждением). Разъем, опять же, только D-SUB.

Карта досталась нам в OEM упаковке. В пакетике присутствовала плата, диск с драйвером и утилитами и маленький буклет с описанием процесса установки карты в слот установки драйверов на английском и японском (или китайском) языках. На диске записаны драйвер, инструкция, набор технологических демок и несколько мелких бесплатных утилит вроде Acrobat Reader и DirectX (7.0, если кому интересно). Обычная OEM поставка.

Разгон StarForce817

Наш образец разгоняется до 215/172Mhz (дефалт 175/166). Стоит уточнить - на 220Мгц по чипу все игры шли нормально, но тест DOT3 Bump Mapping из 3DMark2001 сильно глючил. Весьма скромный показатель для GF2MX. В принципе, видео процессор разогнался нормально, но вот память... И нет большой надежды, что на других экземплярах разгон будет значительно более удачным (Winbond он и в Африке Winbond).Разгон Radeon SDR

Radeon разогнался до 187/187Mhz (дефалт 160/160Mhz).Установка драйвера StarForce817

Установка драйвера прошла без проблем. Сразу в дополнительных настройках экрана появились 3 новые закладки:-

- GeForce2 MX

- Устройство вывода

- TwinView.

Установка драйвера Radeon SDR

Здесь я не могу сказать, что все было безоблачно... Карта встала в слот нормально, драйвера установились, и, казалось бы, все путем, но... Неожиданно при запуске Quake 3 пошли глюки. Причем везде: от главного меню до текстур. Перепробовал несколько версий драйверов, не помогло. Тогда что-то с чем-то несовместимо, подумал я, и полез в БИОС менять режим AGP. И действительно, когда я поставил AGP 2x, проблемы исчезли. А теперь самое интересное: карта тестилась на материнке EPOX 8KTA3 (чипсет VIA KT-133A)! Чтобы на мат. плате, собранной таким зарекомендовавшим себя производителем и на таком популярном чипсете, да проблемы? Пришлось перепробовать несколько версий "VIA 4 in 1" (до этого использовался AGP 4.03). Думаю, никого не удивит тот факт, что комп стал виснуть во время загрузки и ничего при этом не помогало (даже физическое удаление драйверов). Попытка переустановки Windows поверху существующего не увенчалась успехом - процесс установки так же успешно вис. Пришлось на корню сносить старые окна и переустанавливать OS с чистого листа.Опытным путем, с гораздо большей осторожностью, было установлено, что две последние версии AGP минипорта не дают нужного эффекта (4,03 и 4,04). Вернее, дают, но только при установке в режиме Standart, при этом скорость была даже меньше, чем в режиме AGP 2x Turbo. С этим я смирился, решив тестировать Radeon в AGP 2x. Но в один прекрасный день разогнал систему до 133Mhz FSB (понизив коэффициент умножения до 6) и неизвестно по какой причине попробовал включить AGP 4x... Каково же было мое удивление, когда все заработало! Было 2 варианта: либо переводить всё тестирование на нештатный режим, либо тестить Radeon при AGP 2x. Пришлось решиться на последний, так как, даже не смотря на то, что это 80% "заслуга" чипсета, StarForce прекрасно работал. Таким образом, GF2MX тестировался в режиме AGP 4x, а Radeon SDR в 2x. Это будет немного сдерживать показатели RSDR в высоких разрешениях. Вернемся к драйверам и ПО. Если забыть о данном инцеденте на KT-133A + AGP 4x + 100Mhz FSB (тем более, что как решить проблему вы уже знаете), модернизация видео карты прошла абсолютно гладко. С помощью программы Radeon Tweaker можно довольно тонко настроить карту. Сразу укажу ссылку на мой профиль с настройками, с которым происходило тестирование. С ним видео плата настроена на максимальную производительность без потери качества (честно сказать, на твикинг у меня ушло немало времени, поэтому рекомендую вам не тратить свое и воспользоваться данным профилем).

Сравнительная таблица

| GeForce2 MX | Radeon SDR | |

| Техпроцесс: | 0,18 мкм | 0,18мкм |

| Число конвейеров рендеринга: | 2 | 2 |

| Число TMU в каждом конвейере: | 2 | 3 |

| Частота чипа: | 175Mhz | 160Mhz |

| Fillrate (млн. пикс. в секунду): | 350 | 320* |

| Fillrate (млн. текс. в секунду) при монотекстурировании: | 350 | 320* |

| Fillrate (млн. текс. в секунду) при битекстурировании: | 700 | 640* |

| Fillrate (млн. текс. в секунду) при тритекстурировании: | 960* | |

| Частота памяти: | 166Mhz | 160Mhz |

| Ширина канала памяти: | 128Бит | 128Бит |

| Пропускная способность памяти: | 2,7Гб/с | 2,6Гб/с |

| RAMDAC: | 350Mhz | 350Mhz |

Главное архитектурное отличие двух карт - число текстурных модулей. У Radeon их по 3 в конвейере, а у GeForce2 MX по 2. Но игр, использующих тритекстурирование, при котором можно было бы задействовать все TMU Radeon`а, до сих пор нет (сдается мне, и не будет, пока nVidia не начнет поддерживать наложение до 3-х текстур на полигон). Частота памяти у Radeon SDR немного ниже, но если учесть, что HyperZ существенно разгружает шину памяти при большом overdraw, в минусе должен оказаться GeForce2 MX.

Замечания по качеству драйверов

StarForce817

Карта тестировалась на Detonator`ах 5.32, 5.33, 6.18, 6.26, 6.72, 7.52. На всех, кроме двух последних, присутствовали артефакты в 2D в виде квадратиков разных цветов на рабочем столе:

Aртефакты

Эти проблемы появляются только при первоначальной загрузке Windows. Если нажать F5 (Refresh) или заместить глючные места каким-нибудь окном, артефакты исчезнут. Новые версии это как метлой сметают. 3D тестировался на огромном количестве игр (более 20). Нареканий, как и предполагалось, нет. Я остановил свой выбор на версии драйверов 6.72. Однако, и здесь не все гладко. 3DS MAX зависал практически сразу после начала работы (OpenGL). Что интересно, глюк только этой версии. А что 7.52? Там еще больше недостатков. После загрузки Windows98 необходимо сразу поменять разрешение (можно 2 раза, во второй раз вернувшись к прежнему). Если этого не сделать, то после выхода из любой игры экран гаснет и вернуть его в нормальное состояние очень не просто. Что примечательно, после смены разрешения драйвер автоматически выставляет частоту чипа 66Mhz (!!!). Приходится запускать утилиты твикинга и ставить нормальную частоту. Как итог - версия 7.52 была отброшена сразу. Еще довод в пользу 2х последних версий - более качественный S3TC, но об этом позже... Повторюсь, в тестировании принимала участие 6.72. Итого: из 6 версий драйвера нет ни одного полностью универсального, пригодного и для игр, и для работы.

Radeon SDR

В тестировании принимали участие 3 версии драйвера: 4.12.3044, 4.13.7075, 4.13.7097. Версия 3044 была записана на диске, 7075 - последняя официальная на момент написания статьи и 7097 - последняя бета. Артефактов в играх я не нашел (7075 и 7097). 3044 идущий с картой - самый сырой. На нем глючили некоторые игры. 7075 отличается от 7097 неработоспособностью теста "Point Sprites" из 3DM2001. Кроме того, 97 работает пошустрее в Quake3, но имеет некоторые редкие баги в "Game3 Lobby" (3DMark2001). По неизвестной мне причине "Star Wars: Racer" не работал при включенном FSAA на всех версиях (без сглаживания работал). В "Need For Speed: Porsche Unleashed" отсутствует туман. Твикером его включить не удалось... В итоге использовался драйвер 4.13.7097 как самый лучший из протестированных.

Стр.2 - Общая производительность

Тестовый стенд

Прежде чем оценивать производительность value карт от nVidia и ATi, познакомимся с конфигурацией тестового стенда:- Процессор: Duron 750 (100Mhz FSB);

- Материнская плата: EPOX 8KTA3 (чипсет VIA KT-133A);

- Память: 192Mb PC133 SDRAM CAS3;

- Видео карты: MSI StarForce817, ATI Radeon SDR;

- Жесткий диск: 20,4Gb Seagate Barracuda ATA2;

- Звуковая карта: Creative SBlaster Live!;

- Операционная система: Windows ME.

Блок TCL

Блок трансформации и освещения - неотъемлемая часть современных видео карт. Уже с уверенностью можно сказать, что большинство выходящих сегодня игр его поддерживают. Посмотрим, что нам покажет тест TreeMark. Устанавливалось 4 источника освещения, разрешение 640x480 и 16 битный цвет (для того, чтобы снизить нагрузку на память и fillrate).

Мы видим тотальное превосходство TCL GF2MX перед TCL RSDR. Попробуем прогнать High Poligon Count из 3DMark2001:

Результаты TreeMark подтвердились. Действительно в идеальных условиях T&L быстрее у GeForce.

И, все же, необходимо напомнить, что от скорости TCL не напрямую зависит скорость всего приложения, пусть даже с очень приличной геометрической детализацией. В большинстве случаев производительность упирается в скорость прорисовки сцены текстурными модулями или в низкую пропускную способность памяти. Насколько сбалансированы решения с таким TCL, таким fillrate и такой памятью, сложно сказать. В принципе, все зависит от используемого разрешения, цветовой палитры и качества текстур. Дальнейшие тесты в 3DMark2001 должны пролить на это свет.

Общая производительность

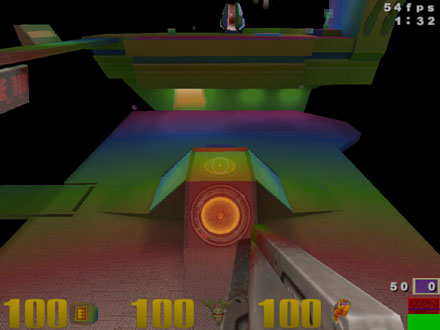

Вот мы и подошли к самому интересному - чистой производительности. Начнем с самого популярного сегодня OpenGL бенчмарка - "Quake3". Тестировалась последняя версия - 1.27h. Использовалась демка demo127.dm3 (она входит в состав патча). Звук отключался.

В 16 битном цвете лидерство одержал GeForce2 MX. По мере роста разрешения разница оказывается все меньше и меньше, это заслуга HyperZ. Но 16 битный цвет - не удел для карт такого класса. Посмотрим на результаты в 32 битном.

Здесь картина прямо противоположная. GeForce отстает, но, надо заметить, не сильно. Возможно, Radeon немного поджимает AGP 2x, но тут ничего не поделаешь. Неплохой разгон обусловил RSDR полную победу в нештатных режимах.

Недавно появившийся 3DMark2001 уже завоевал себе звание самого популярного Direct3D теста. Чистая производительность оценивается по четырем псевдоигровым бенчмаркам, один из которых использует пиксельные шейдеры и, соответственно, работает только на GeForce3. Три остальных игровых теста работают на всех современных видео картах. Каждый из них имеет 2 режима: High Deatil и Low Detail. Первый отображает производительность в играх будущего (зубодробительная детализация), а второй эмитирует игры сегодняшнего дня. Всего получается 6 тестов. Тестировались карты только в 32 битном цвете, т.к. разница в скорости между 16bbp и 32bbp очень мала (даже на GF), а разница в качестве огромна. Frame Buffer - Tripe, Texture Format - Compressed, Z-Buffer Depth - 24Bit (т.к. GeForce 32 битного не поддерживает (Radeon поддерживает)). Тестирование не проводилось в 1600x1200, потому что GeForce с такими настройками не заработал (Radeon заработал). Итак, игра 1:

Как вы уже заметили, правая часть столбиков - результат при выставлении высокой детализации. На уровне Low карты сравнялись и пришли к примерно одинаковому результату. На High тоже сравнялись... Все... Включая разогнанные... Странная картина получается. Если бы скорость лимитировал TCL, разгон GeForce дал бы не слабый прирост в производительности, если бы лимитировал fillrate или низкая пропускная способность памяти, то разгон Radeon дал бы свои плоды. Кроме того, во всех разрешениях получились одинаковые результаты... Из этого делаем вывод, что скорость _во всех_ разрешениях лимитирует процессор! Это при оптимизации под 3Dnow и HW TCL! Вот уж не думал, что найдется игровой тест, скорость в котором при 1280x1024x32 с использованием видео карт GeForce 256 класса, полностью будет лимитировать Duron 750! Не уверен, что такие видео платы будут покупать обладатели Pentium 4 1,5Ghz или Athlon 1,33Ghz DDR...

Игра 2 представляет собой помесь Fantasy RPG и стратегии. OverDraw достаточно высок, что обеспечивает безоговорочную победу Radeon`а. При высокой детализации разница гигантская! Такое ощущение, что карты из совершенно разного ценового диапазона.

Lobby - сцена перестрелки в небольшом помещении. Сложная геометрия создается за счет сотен высокодетализированных гильз и осколков от стен. Персонажи сделаны ужасно. Более-менее проработаны лишь лица, и те не анимированы! Одно и то же выражение лица у главного героя на протяжении всего теста... раздражает. Но, несмотря на это, графика на достаточно высоком уровне, очень четкие текстуры, красивый пол и освещение достойны игры будущего. Мы видим победу Radeon практически везде. Опять же, в низких разрешениях и High Detail скорость лимитирует процессор, но по мере роста разрешения эффект узкого горлышка от бутылки нивелируется. И в заключение посмотрим на Overall Score - итоговую оценку видео карте 3DMark`ом.

Детище ATI лидирует во всех разрешениях с немалым отрывом. Еще мы можем заметить неплохой прирост в производительности от разгона GeForce. Т.к. разгон по памяти равен всего 3,6%, напрашивается вывод, что прирост дал более быстрый TCL... Представляете, что бы показал Radeon, если бы он имел такой же блок трансформации и освещения, как у GeForce!

Подытожим. В OpenGL (Quake3) и 16 битном цвете быстрее оказался GeForce2 MX, в 32 битном карты сравнялись. В Direct3D (3DM2001) во всех разрешениях победил Radeon.

Стр.3 - Анизотропная фильтрация

Анизотропная фильтрация

Поддержка анизотропной фильтрации - требование к современной видео карте. Мало кто не будет включать эту функцию, т.к. она серьезно улучшает качество. Попробуем сравнить трилинейную и анизотропную фильтрации обоих чипов на примере Quake3 (для цветного отображения мип уровней использовалась команда "/r_colormiplevels 1").Trilinear

Anisotropic GeForce2 MX

Anisotropic Radeon SDR

Как видно, новый тип фильтрации значительно лучше старого. И тут же мы видим гораздо лучшее качество у GeForce. Твикер RaidOn позволяет задать от 2 до 128 у.е. уровень фильтрации для Radeon`а (доступны значения 2,4,8,16,32,64,128). Все, что до 16 не достойно нашего внимания по причине ужасного качества. Сравним анизотропию GeForce2 MX и Radeon SDR без цветного отображения MIP уровней:

GeForce2 MX |

Radeon SDR 16 |

Radeon SDR 128 |

|

|

|

|

|

|

В близких расстояниях качество фильтрации лучше у GF, а в дальних четче текстуры при 128 у.е. фильтрации Radeon`а. Нельзя не отметить резкого перехода между MIP уровнями у RSDR. НО. Все скрины снимались с 1024x768. А вот если поставить 1280, то уровни фильтрации на порядок отдалятся и их практически не будет видно. В 1600x1200 наступает полнейшее блаженство. Никаких MIP`ов не заметно. Никаких переходов между ними! Кажется, что текстуры одинаково четкие на каком угодно расстоянии от камеры. В таком разрешении увидеть разницу между Radeon и GeForce фактически не возможно. Посмотрите на скрин, взятый с Radeon при 1600x1200:

Теперь проследим за падением скорости, которое происходит при активизации anisotropic mipmap.

За удовольствие надо платить. Но это относится только к GeForce2 MX! Посмотрите, разницы в скорости между фильтрациями на RDSR практически нет. А 128 у.е. фильтрация так вообще практически бесплатно дается (менее 1 процента потеря в скорости по сравнению с 16 анизотропией). Да. Здесь получилось 2 точки. GeForce позволяет добиться качественной, но медленной анизотропии, а Radeon - некачественной, но быстрой. Идеальный вариант - это, конечно же, настраиваемое качество (скорость). К сожалению, драйвера ни той, ни другой карты подобного ключа в реестре не имеют (Radeon имеет, но только выбирать приходится из очень плохого или просто плохого качества). Этот раунд завершился ничьей. Качество традиционно противопоставляется скорости.

Стр.4 - FSAA, S3TC

FSAA Теперь поговорим о такой важной вещи, как полносценное сглаживание. Не секрет, что эта функция позволяет убрать "лесенки" между разными 3D объектами. Теперь посмотрим на качество, получаемое при включении FSAA на рассматриваемых нами картах. No AA No AA No AA No AA GeForce2 MX FSAA 2x2 FSAA 2x2 GeForce2 MX FSAA 2x2 GeForce2 MX FSAA 2x2 GeForce2 MX Radeon SDR FSAA 4x FSAA 4x Radeon SDR FSAA 4x Radeon SDR FSAA 4x Radeon SDR Качество сглаживания 2x2 у GF2MX и RSDR отличается. И не в пользу Radeon. Полностью избавиться от "лесенок" в низких разрешениях получается только у GeForce. Хочу обратить ваше внимание на FSAA 1x2. Посмотрите на часть скриншота, снятого с GeForce2 MX: FSAA 1x2 GeForce2 MX Мы видим, что сглаживание в горизонтальном направлении присутствует, но отсутствует в вертикальном. Поэтому не будем даже замерять скорость на этих видах FSAA. Посмотрим теперь на производительность, которую показывают платы в Quake3 при AA 2x2: Quake3 FSAA 16bpp Quake3 FSAA 32bpp На обеих картах скорость страдает катастрофично. В 640x480 и 800x600 мы можем увидеть практически одинаковую производительность обеих плат (в 16 битном цвете выигрывает даже GeForce), но вот в 1024x768... Объяснение этому найти трудно. Качество в 1024 сильно не отличалась от оного в остальных разрешениях... В общем, практически 2х кратная разница в скорости при FSAA 4x в 1024x768x32 между протестированными видео платами. Существует мнение, что это бесполезная функция, раз на выходе имеем более чем трехкратную потерю производительности. Действительно, если посмотреть на графики, играбельно лишь разрешение 640x480x16 на StarForce. Но нужно помнить, что это Quake3 и максимальная детализация. А ведь есть еще множество старых игр, в подавляющем большинстве которых поставить разрешение выше 640x480 или 800x600 просто не получается. Тут на помощь и приходит полносценное сглаживание. Такие игры как Need For Speed 3, Carmageddon 2, Monster Truck Madness 2, Star Wars: EP1 PM/Racer с включенным антиалиасингом выглядят прямо-таки по-новому. И скорость вполне играбельна на обеих картах. S3TC Компрессия текстур - важная функция, позволяющая путем их сжатия получить некоторый прирост производительности. Если приложение уже содержит предварительно сжатые текстуры, то их качество не зависит от видео чипа, а если карте необходимо проводить автокомпрессию, ситуация меняется на противоположную. В Quake3, как и в большинстве игр, изначально сжатых текстур нет. Посмотрим, как справляются с автокомпрессией рассматриваемые видео платы: S3TC off S3TC GeForce S3TC отключен S3TC - GeForce 2 MX* S3TC Radeon S3TC - Radeon SDR * Ключ S3TCQuality был равен 1. Итак, мы видим, что обе карты справились с задачей на 4 и качество ухудшилось не сильно. Но ухудшилось. Должен сказать, что кроме как на небосводе разницы практически нигде не заметно. Если взглянуть на качество исполнения S3TC исследуемых карт, мне кажется, что у nVidia оно немного выше (ключевое слово _немного_)... Хотя, опять же, кроме как на небе разницы заметить нигде невозможно. Теперь о том, что мы получаем, принося в жертву качество прорисовки многоцветных текстур: Quake3 S3TC Quake3 S3TC (percent) А получаем мы многое... Особенно на Radeon SDR. 42% прирост от какой-то компрессии текстур - это что-то! Наверное, здесь еще внес вклад AGP 2x, пропускной способности которого не хватало, чтобы пропускать некомпрессированные 32 битные текстуры. В любом случае, раунд выигран ATI.Стр.5 - DOT3/EMBM, Выводы

DOT3/EMBM

Технологии рельефного текстурирования начала продвигать Matrox 2 года назад. После поддержки лидером рынка (GeForce 256) они были обречены на блестящее будущее. К сожалению, линейка GeForce 256 и GeForce 2 имела поддержку лишь DOT Product 3, а более продвинутая технология - EMBM так и оставалась только на Matrox картах. Здесь эстафету подхватила ATI, внеся этот вид рельефного текстурирования в свою линейку Radeon. Позже спохватилась и nVidia, чей GeForce3 тоже присоединился к EMBM картам. Таким образом, GeForce2 MX поддерживает только DOT3, а Radeon SDR имеет поддержку и DOT3, и EMBM. Это большой плюс для Radeon, потому что Environment Bump Mapping используется уже не в единичных играх.Уникальные технологии

В этой графе мы рассмотрим уникальные технологии, т.е. те, что есть только у GF2 или Radeon. Общие функции, такие как "Cubic Envoerment Mapping" или "Vertex Shader" сюда не вошли.GeForce2 MX

По сути GF2MX отличается поддержкой NSR (программируемого блока для мультитекстурных эффектов). NSR до сих пор не поддерживается играми и сказать что-либо о его полезности сейчас невозможно.

Radeon SDR

Radeon противопоставляет этому геометрический блок "Charisma Engine" (Vertex Skinning, Keyframe Interpolation), HSR и Hyper Z. VS - метод трансформации вершин с помощью специальных матриц. Говоря простым языком, он позволяет убрать ни с того, ни с сего возникающие острые углы анимированных объектов. KI позволяет путем указания нескольких ключевых кадров при анимации автоматически создать промежуточные и получить более плавное движение. HSR и Hyper Z позволяют разгрузить шину памяти благодаря отсечению невидимых поверхностей и оптимизации работы Z-буфера (это направлено на повышение производительности, поэтому как отдельный "плюс" технологии рассматривать не будем, все показали тесты).

Выводы

К чему пришли:Доводы за выбор Radeon SDR |

Доводы за выбор StarForce817 |

Производительность в 3DMark2001 (Direct3D) |

Производительность в Quake3 и 16 битном цвете (OpenGL 16bpp) |

| Гораздо большая производительность при высоком OverDraw | |

| Качество 2D (в сравнении со StarForce) | |

Более-менее отлаженные драйверы (для SF очень сложно подобрать один универсальный драйвер) |

|

| Более быстрый TCL | |

| По 3 текстурных модуля в конвейере | |

| Скорость анизотропной фильтрации | Качество анизотропной фильтрации |

| Качество FSAA | |

| EMBM, Charisma Engine | NSR |

| Скорость при активизации S3TC | |

| Поддержка 32bit Z-Buffer | |

| Хорошая разгоняемость попавшего на тестирование экземпляра |

Исходя из этой таблицы каждый может выбрать то, что ему по душе. Я не буду давать единой рекомендации. Может, кто-то мечтает о скорости в 16 битном цвете, быстром TCL, тумане в NFS5, качественной анизотропии и FSAA, а все остальное ему просто не нужно. Может, кому-то главное, чтобы запускался тест Crytec X-Isle или ему подобный, заточенный под GeForce`ы. Но как бы там ни было, плюсов у Radeon получилось гораздо больше. И они значительно весомее. nVidia уже подготовила ответ. Это GeForce2 MX 400. Мы уже знаем, что единственным отличием от обычного GF2MX будет частота чипа/памяти. Вместо 175/166 будет 200/183 (частоту памяти nVidia переложила на совесть производителей, некоторые будут комплектовать платы 166Mhz памятью, некоторые 183, а некоторые 200 Мегагерцовой).

Частота чипа еще больше поднимет скорость TCL, но на общую производительность это практически не повлияет. Частота памяти увеличится на 10%. Даже если предположить, что скорость при этом увеличится на те же 10%, то мы получим следующую картину: GeForce немного обгонит Radeon в Q3 32bpp, сильно обгонит в Q3 16bpp, но все так же значительно отстанет в 3DMark2001. Все остальные характеристики чипа не изменятся, поэтому Radeon все равно останется более предпочтительной покупкой. Прибавим к этому и высокую цену, которую на первых порах будет иметь MX 400. Пока обычный MX абсолютный лидер по продажам. Но ведь стоимость Radeon сравнялась со стоимостью GeForce совсем недавно... Сейчас очень интересно будет следить за ценовыми войнами (по последним данным GeForce2 MX вышел вперед и стоит уже дешевле Radeon (другой вопрос - на долго ли?)).

Эта ситуация, опять же, напоминает процессорный рынок, где гораздо более быстрый и дешевый Duron продается значительно хуже, чем медленный и дорогой Celeron. Пользователей когда-то зомбировали, и они до сих пор думают, что Intel это круто, а AMD выпускает второсортные продукты. Интересно будет наблюдать и за финансовыми отчетами ATI. Мы помним, какие прибыли ждали AMD после выпуска Athlon, даже несмотря на сравнительно низкую продаваемость. Как бы там ни было, все решат цены. А их предопределяет спрос. Ждем развития событий...