СКИФ Аврора ЮУрГУ: суровый Челябинский суперкомпьютер

Введение. Южно-Уральский государственный университет.

Человеку офисному может показаться, что лето – совершенно гиблое время года в смысле работы. Продажи вялые, коллег и партнеров то и дело приходится вылавливать на заморских пляжах («я в роуминге, говори быстрее»). Даже пробки – самый наглядный индикатор деловой жизни города – летом становятся как будто меньше. Злее, но все-таки меньше. Ленивая пора, одним словом. И как иначе, если колеса автомобиля норовят погрузиться в расплавленный асфальт, а жизнь без кондиционера любой готов променять на путешествие из первой части «Божественной комедии»?

Впрочем, так дела обстоят далеко не во всех сферах деятельности. В туристическом бизнесе закономерный аврал – принтеры еле справляются с печатью путевок. Строители стараются успеть построить как можно больше – им в этом помогают огнеупорные таджики и узбеки. В сельском хозяйстве вовсю готовятся к уборочной компании. А коммунальщики с утроенной силой начинают бить баклуши на бесконечных ремонтах и профилактиках.

Как ни странно, это лето стало чрезвычайно напряженным периодом еще для одной отрасли, никак особенно со сменой сезонов не связанной – для области высокопроизводительных вычислений, или, для краткости, HPC. В начале июня в Гамбурге состоялась традиционная International Supercomputing Conference. Во второй половине июня в Новосибирске прошел HPC Day, организованный Intel, РАН и руководством Новосибирской области. А на конец месяца пришлись еще два достаточно важных события: официальное обновление знаменитого TOP500 и официальный запуск весьма небезынтересного суперкомпьютера в… Челябинске?

Челябинск – столица СССР

Челябинск – столица СССР

Что знает о Челябинске среднестатистический россиянин? Разумеется, первое, что приходит в голову любому при упоминании названия города – это самый успешный мем «Нашей Раши» – про суровых мужиков. Второе, что вспомнит обычный человек, это многочисленные предприятия тяжелой промышленности. Металлургия, химия, машиностроение. Мечел, ЧТЗ и так далее.

Более внимательный исследователь обнаружит, что помимо «тяжелых» отраслей в Челябинской области на удивление неплохо развита пищевая промышленность – как ни странно, именно отсюда родом самый популярный российский бренд макарон, «Макфа».

А если как следует покопаться, окажется, что в Челябинске расположен один из крупнейших в нашей стране университетов: по количеству студентов Южно-Уральский государственный университет обгоняет и МГУ, и СПбГУ. А среди многочисленных подразделений ЮУрГУ имеется один из ведущих суперкомпьютерных центров России. И это подводит нас к основной теме беседы.

Высокопроизводительными вычислениями в Челябинске заинтересовались достаточно давно. В 2000 году в университете был запущен кластер Physics на 1 GFLOPS – достаточно скромно даже по тогдашним меркам, так что его можно считать пробным шаром. В 2004 году заработала более мощная система Infinity с пиковой производительностью 333 GFLOPS.

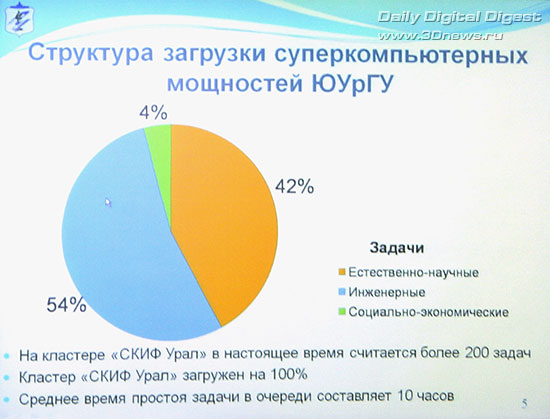

Более серьезная заявка на победу последовала через четыре года: построенный в 2008 кластер СКИФ Урал с пиковыми 16 TFLOPS забрался на 282 место TOP500, а в российском рейтинге занял весьма почетное 4 место. Как показала практика, в Южно-Уральском университете умеют не только закупать железо, но и ставить перед ним задачи. По утверждению ректора загруженность вычислительных мощностей в Челябинском СКЦ составила 100%. Что и обусловило новый виток эволюции – приобретение еще более мощного суперкомпьютера, который получил зубодробительное название «СКИФ Аврора ЮУрГУ».

Отрасль высокопроизводительных вычислений развивается чрезвычайно быстро. Поэтому, несмотря на увеличение пиковой производительности в полтора раза по сравнению со старой системой, в июньскую редакцию престижного TOP500 новый компьютер уже не попал. Зато занял 8 место российского рейтинга. Что, в принципе, неплохо – из российских ВУЗов впереди только МГУ.

Впрочем, примечателен данный суперкомпьютер не только и даже не столько местами в рейтинге. Он интересен в первую очередь тем, что на нем обкатываются весьма интересные технологии, которые в будущем могут быть использованы для построения куда более мощных систем. Самое время разобраться, что же такое это за зверь такой – СКИФ Аврора.

Этот суперкомпьютер является совместной разработкой Института программных систем РАН, российской компании РСК СКИФ и итальянской компании Eurotech. Прямого ответа на вопрос, в каких долях упомянутые организации принимали участие в разработке, все заинтересованные лица старательно избегают. Удалось выяснить лишь, что «Eurotech – соразработчик и поставщик части компонентов, но не участвовал в создании решения целиком», а также, что отечественные участники проекта «имеют право и способны изготавливать в России все печатные платы, всю «механику», систему «СКИФ-Аврора» в целом, а закупать останется только микросхемы».

СКИФ Аврора ЮУрГУ: суровый Челябинский суперкомпьютер

Как и большинство современных суперкомпьютеров, СКИФ Аврора представляет собой кластерное решение: огромное количество небольших компьютеров, объединенных в единое целое высокопроизводительной сетью. Боевой единицей в системе СКИФ Аврора является крайне компактный blade-модуль со следующими характеристиками:

- 2 x Intel Xeon X5570: по четыре вычислительных ядра (8 потоков HyperThreading) на процессор, частота 2,93 ГГц (до 3,33 ГГц в режиме Turbo Boost), кэш L3 8 Мб, TDP 95 Вт;

- чипсет Intel 5500;

- FPGA Altera Stratix IV;

- 6, 12 или 24 Гб оперативной памяти DDR3-1333 (объем памяти варьируется 0,5 до 2-3 Гб, что «позволяет покрывать практически все основные конфигурации HPC-приложений для двухпроцессорных кластерных модулей»);

- SSD объемом 80 Гб, форм-фактор 1,8’’ – используются твердотельные накопители Intel X-18M (SSDSA1MH080G201).

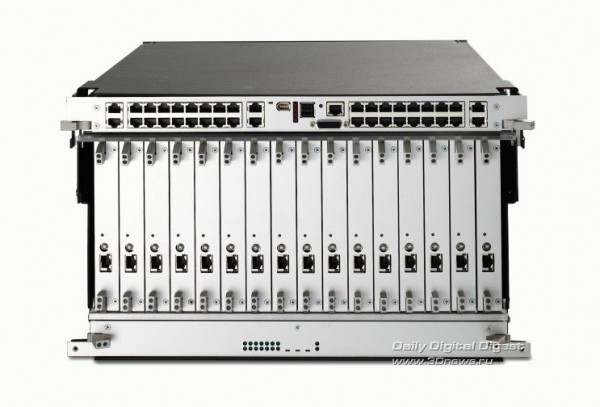

Полностью укомплектованный blade-модуль суперкомпьютера СКИФ Аврора

Полностью укомплектованный blade-модуль суперкомпьютера СКИФ Аврора

Модули пакуются в шасси по 16 штук, каждое шасси имеет высоту 6U. Помимо собственно blade-модулей оно включает плату питания и корневую плату – эти платы находятся снизу и сверху от blade-модулей, которые расположены в шасси вертикально. Модули действительно очень компактные: их толщина составляет около дюйма, ширина – порядка семи. Несмотря на скромные размеры, они обладают отнюдь не скромной производительностью: каждый модуль обеспечивает 95 GFLOPS. На шасси, таким образом, приходится около 1,5 TFLOPS.

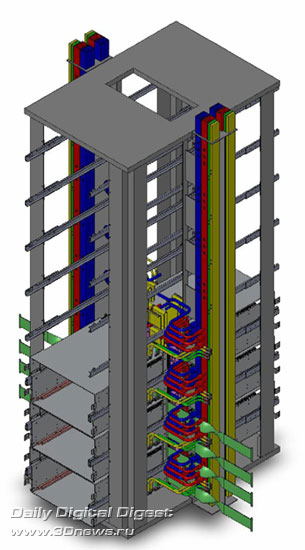

Далее шасси собираются в стойку – по восемь штук вертикально, что дает в совокупности 48U. Монтажный шкаф двусторонний: восемь шасси устанавливается с одной стороны шкафа, столько же с другой (из-за такой компоновки разработчики величают их «полушасси»). Blade-модули поддерживают горячую замену – в любой момент любой из модулей может быть извлечен из шасси, это не повлияет на работу остальных.

Что до упомянутой выше высокопроизводительной сети, то их тут даже две. Во-первых, используется шина Infiniband QDR, работающая на скорости 40 Гбит/с с пропускной способностью. Каждое шасси оснащено 36-портовым коммутатором Infiniband – 16 внутренних соединений и 20 внешних. Во-вторых – и этим особенно гордятся разработчики – в СКИФ Аврора использована сеть с топологией трехмерный тор отечественной разработки, обеспечивающая соединение на скорости 60 Гбит/с. Именно для работы этой сети в blade-модули устанавливают FPGA-микросхемы.

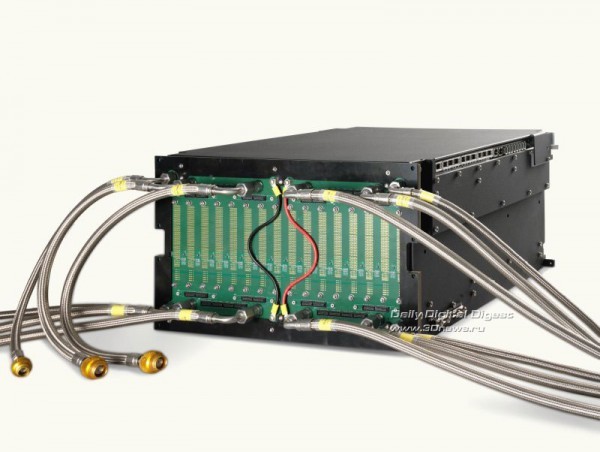

Как можно заметить, blade-модули собираются в шасси чрезвычайно плотно, расстояния между ними практически не остается. И каждый из них потребляет и выделяет весьма впечатляющие 270 Вт. Как же удается охлаждать суперкомпьютер? Это еще одна примечательная особенность проекта: в СКИФ Аврора используется водяное охлаждение.

Вкупе с заменой традиционных винчестеров на SSD, это решение позволило полностью избавиться от движущихся частей. По заверениям разработчиков, сей факт должен положительно сказаться на отказоустойчивости и энергопотреблении. Как было замечено во время презентации суперкомпьютера, порядка половины всей потребляемой современным суперкомпьютером энергии тратится именно на охлаждение. Жидкостная система позволяет сократить эти затраты на 60% – то есть сэкономить до трети общего потребления.

Помимо всего прочего, отсутствие движущихся частей обусловило и побочный плюс системы: оно позволило сделать ее практически бесшумной. Поскольку в ЮрГУ теперь есть два суперкомпьютера сравнимой вычислительной мощности, возможность «почувствовать разницу» была предоставлена. Что сказать, разница колоссальная: старый СКИФ Урал, обладающий производительностью 16 TFLOPS, занимает достаточно большое помещение – примерно с классную комнату, – уровень шума в котором примерно соответствует вагону московской подземки. СКИФ Аврора с его 24 TFLOPS спокойно помещается в небольшой комнатке размером с хорошую спальню и… вообще не шумит.

Стойка СКИФ Аврора. Зеленым выделена сеть, желтым питание. Красный и синий – охлаждение, горячие исходящие и холодные входящие трубки соответственно

Производительность в 24 TFLOPS на шкаф – показатель очень даже неплохой. Тут правда, не стоит забывать о том, что монтажные стойки унифицированы по ширине внутреннего пространства, но могут сильно отличаться по глубине и внешним габаритам. К примеру, Cray XT5 – на этих системах построен TOP1 суперкомпьютер Jaguar – обеспечивают до 12 TFLOPS на стойку, вдвое меньше, чем СКИФ Аврора. Но габариты шкафов почти вдвое же меньше: 572x1411 (Cray XT5) против 1095х1500 мм (Аврора) при близкой высоте – 2,04 и 2,26 метра соответственно.

Производители «Авроры» обещают поднять производительность до 40 TFLOPS на шкаф путем замены процессоров на 6-ядерные Xeon серии 5600. Но и враги не дремлют: в следующем поколении систем Cray, XT6, будут задействованы 12-ядерные AMD Opteron. Таким образом, производительность на стойку составит до 20 TFLOPS – при этом габариты увеличатся только по высоте, до 2,36 метра.

Впрочем, паритет по плотности вычислительной мощности с такой компанией, как Cray – это уже очень и очень неплохо. Тем более, что он подкреплен еще и паритетом по пропускной способности сети: именно топологию 3D-тор используют самые быстрые системы Cray и IBM.

Как уже было упомянуто в начале статьи, достигнутые результаты системы не являются конечной целью проекта. Предстоящее повышение производительности до 40 TFLOPS – тоже не предел. Замыслы гораздо масштабнее: система спроектирована с замахом на совсем другие результаты.

Примерно так может выглядеть сегодня российский суперкомпьютер производительностью порядка 1 PFLOPS

Примерно так может выглядеть сегодня российский суперкомпьютер производительностью порядка 1 PFLOPS

Разработчики уже готовые покорить заветный петафлопс – системе СКИФ Аврора с использованием 6-ядерных Xeon для этого понадобится всего лишь 25 шкафов. А также 2,84 МВт и много-много денег. На постройку пилотного СКИФ ЮУрГУ Аврора ушло, к примеру, 80 миллионов рублей. Поэтому главное – чтобы нашлись достойные такого масштаба вложений задачи. Будем надеяться, что они в нашей стране найдутся.