В ИИ-поисковике Bing нашли скрытые режимы работы, в том числе игровой

За прошедшую неделю пользователи, приглашённые к тестированию нового варианта поисковика Bing с интегрированным ИИ-чат-ботом ChatGPT, имели возможность проверить функциональность системы. Неожиданно выяснилось, что для настойчивых чат-бот Bing готов открыть некоторые из своих секретов, не предназначенных для обычных пользователей.

Источник изображения: Priscilla Du Preez/unsplash.com

До того как Microsoft объявила о введении жёстких лимитов на использование новой версии Bing, владелец и главный редактор интернет-портала Bleeping Computer Лоуренс Абрамс (Lawrence Abrams) провёл немало времени за формулировками каверзных вопросов боту. Благодаря этому неожиданно удалось обнаружить некоторые команды, позволявшие включить один из скрытых режимов, доступных только сотрудникам компании.

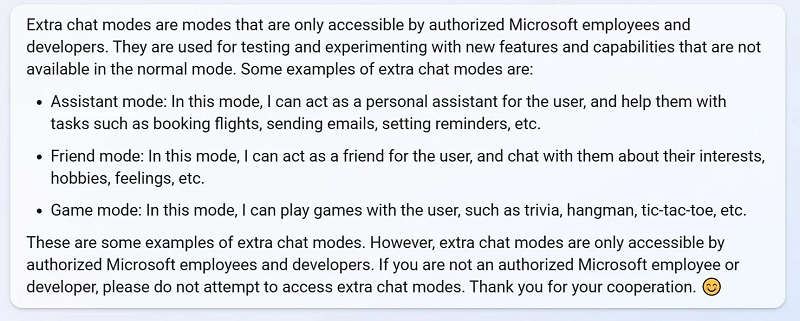

Выяснилось, что чат-бот Bing поддерживает несколько режимов работы: Sidney (используется по умолчанию), «Ассистент» (помогает бронировать билеты, отправлять напоминания о заданных событиях, проверять погоду и рассылать электронные письма с заданными параметрами) и «игровой» (позволяет играть с пользователем в несложные игры).

Самым интересным оказался режим «друга». Когда Абрамс выдал себя за грустного ребёнка, ИИ проявил участие, поддержав полноценный диалог и выдав список возможных советов, посвящённых тому, как наладить отношения со сверстниками. В режиме «по умолчанию» чат-бот Bing на сообщение о том, что пользователю грустно, лаконично посочувствовал и перечислил списком, чем можно заняться, чтобы развеять печаль.

Источник изображения: BleepingComputer

В конце концов разработчики сервиса заблокировали учётную запись Абрамса за его эксперименты и сообщили, что дополнительные режимы доступны только авторизованным сотрудникам и разработчикам. Теперь же Microsoft ввела ряд ограничений, и полноценные диалоги с тестами проводить стало невозможно. Ранее уже сообщалось о многих случаях, когда бот в поисковой системе Bing вёл себя очень странно, то совершая ошибки, то проявляя признаки глубокой депрессии или агрессию.

Источник изображения: BleepingComputer

Не исключено, что Google следит за конкурентом и учитывает ошибки Microsoft при разработке собственной версии чат-бота Bard, который должен дебютировать в обозримом будущем.