Фотоника для ИИ: вычисления должны быть экономными

Ажиотаж в отношении генеративного ИИ, разразившийся осенью 2022-го, до сей поры и не думает утихать — и потому вплоть до начала второго квартала 2024 г. тайваньский чимпейкер TSMC, пока один только в мире и способный не только изготавливать нужные микросхемы по требуемым производственным нормам, но и упаковывать их по самой передовой «трёхмерной» технологии CoWoS (chip-on-wafer-on-substrate), едва справлялся с неуклонно растущим потоком заказов от дизайнеров соответствующих чипов; в первую очередь от NVIDIA. Теперь, к счастью, на Тайване в строй начинают входить новые упаковочные линии CoWoS, так что доступное для приобретения заинтересованными изготовителями серверных видеокарт (точнее будет называть их тензорными вычислителями, конечно, — исключительно для генерации компьютерного видео они давно не применяются) количество соответствующих чипов растёт с каждым месяцем — и, значит, это узкое место в развитии мировой ИИ-индустрии удалось расширить.

До создания чипов из чистого света фотоника пока не дошла, но лиха беда начало (источник: ИИ-генерация на основе модели SDXL 1.0)

Увы, сразу же вслед за тем актуализировалась другая напасть, о которой поведал недавно Марк Цукерберг (Mark Zuckerberg), глава активно включившейся в гонку искусственных интеллектов — ну раз уж метавселенная «не взлетает», а умные боты публике полюбились — компании Meta✴[1]*. Теперь экспансию дата-центров, пригодных для обучения гипотетической GPT-5 (и её грядущих аналогов от иных, помимо OpenAI, разработчиков), сдерживает банальная, но оттого не менее плачевная нехватка электроэнергии. Вплоть до конца 2022 г., когда лавинообразно принялся нарастать самый широкий интерес к генеративному ИИ, отдельная стойка в типичном ЦОДе потребляла электрическую мощность в пределах 10-15 кВт. Сегодня же — с учётом того, что нынешняя средняя стойка в ответ на требования клиентов комплектуется далеко не единственным тензорным вычислителем, — её потребление доходит до 40-60 кВт. В результате большой гиперскейлерский дата-центр на пике мощности может нуждаться и в 150 МВт, а суммарное потребление энергии ЦОДами на территории одних только США с 17 ГВт в 2022 г. к 2030-му грозит, по оценкам экспертов, взлететь до 35 ГВт.

И вот это уже подлинная проблема: хотя энергетические ресурсы, имеющиеся в распоряжении обитателей Земли, потенциально безграничны (один только поток фотонов от Солнца заведомо перекрывает на порядки всю мыслимую потребность человечества в энергии на столетия вперёд), но, когда речь заходит о переводе этого потенциала в приземлённые киловатт-часы, питающие вполне конкретные приборы, начинаются сложности. Мало того, современные полупроводниковые вычислительные устройства архинеэффективны в плане энергопотребления, которое вернее было бы называть энерготранжирством. Любая логическая операция по переводу «1» в «0» или обратно сводится к перемещению очень малого заряда на крохотное расстояние, т. е. к порождению микротока. А любой ток, в свою очередь, разогревает канал, по которому протекает, — если у этого канала имеется сопротивление (а оно имеется, ведь серийные полупроводниковые чипы не обладают свойством сверхпроводимости). В результате триллионы микротоков, порождаемых производимыми в данном чипе логическими операциями каждую секунду, оборачиваются десятками и сотнями ватт переводимой в тепло мощности. А потом требуется потратить ещё немалое количество энергии на отвод этого паразитного тепла — иначе перегретые микросхемы не будут работать должным образом.

Так что экстенсивный рост количества классических дата-центров с полупроводниковыми чипами внутри серверов, очевидно, не способен кардинально решить проблему нехватки вычислительной мощности для грядущих ИИ-задач. Решать эту проблему возможно несколькими путями, но одним из наиболее перспективных сегодня считается фотоника — photonic, от «photon» + «electronic», — использование оптических логических схем вместо электронных либо наряду с ними. Передавать информацию в виде световых импульсов человечество научилось давно и неплохо практикует эту активность до сих пор, — от сигнальных костров на горных вершинах через гелиографы и до оптоволоконных линий связи. Но вот использовать фотоны для организации логических контуров и, на их основе, сверхбольших вычислительных схем — задача существенно более сложная.

Впрочем, за её решение уже принимаются всерьёз — и по всему миру: достаточно напомнить, что в конце весны 2024 г. премьер-министр Михаил Мишустин поставил задачу обеспечить России место в десятке лидеров в области фотоники. И это вполне логично: если в области полупроводниковых СБИС нагнать отставание от лидеров отрасли неимоверно сложно и дорого (не далее как 21 мая 2024 г. заместитель министра промышленности и торговли РФ Василий Шпак официально сообщил, что в России создан и проходит испытания первый отечественный фотолитограф, обеспечивающий выпуск чипов по производственным нормам до 350 нм, — сравним с актуальными «3 нм» у TSMC и Samsung Electronics), то по направлению фотоники все готовые ступить на это поле игроки находятся сегодня практически в равном положении. И раз уж прогресс ИИ на традиционных чипах заведомо упирается в энергетический потолок, куда разумнее сразу ориентироваться на свободную от этих ограничений ветвь развития.

⇡#Нужно больше данных (и энергии!)

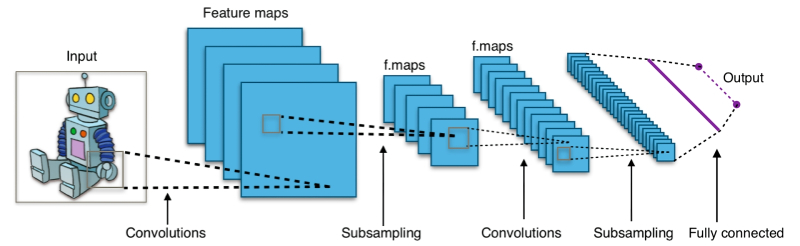

Главная проблема полупроводниковой аппаратной основы для ИИ-вычислений — именно для них! — заключается в том, что функционирование существенно многопоточных нейронных сетей эмулируется на базе линейной по сути бинарной логики. В материале о базовых принципах нейрокомпьютинга мы в первом приближении поясняли, каким образом функционируют искусственные подобия нейронов — перцептроны, что принимают входные сигналы со множества входов и по определённому правилу выдают один результирующий сигнал на выходе, и как они объединяются в (теперь чаще всего многослойные) нейросети. Технически перцептрон устроен не так уж сложно, что как раз и позволяет во множестве создавать их виртуальные образы в памяти самых обычных фоннеймановских компьютеров.

Понадобится ли для достижения принципиально нового уровня сложности нейросетей физически имитировать структуру головного мозга? Вопрос пока что без ответа (источник: ИИ-генерация на основе модели SDXL 1.0)

Другое дело, что работа нейросети сводится к исполнению неимоверного количества простых операций (взвешенного суммирования — сложения с перемножением пар аргументов), а фоннеймановские системы вынуждены для проведения таких расчётов активно перемещать данные между собственно вычислительным узлом (процессором) и хранилищем данных (оперативной памятью). Вот почему мощные графические адаптеры с сотнями и тысячами вычислительных ядер, сопряжённых высокоскоростной шиной данных с производительной видеопамятью на много (а то и на много десятков) гигабайт, подходят для исполнения и тем более для обучения ИИ-моделей наилучшим — среди широко доступных сегодня — образом. Да, специализированные аналоговые вычислители как раз на ИИ-задачах способны потягаться с классическими компьютерами на основе бинарной логики, но массовое производство, а затем и внедрение таких вычислителей — дело пока что довольно отдалённого будущего.

Почему же практически все применяемые на практике в наши дни виртуальные нейросети, функционирующие в памяти фоннеймановских компьютеров, представлены именно слоями перцептронов? Ничто ведь не мешает — тем более речь всё равно идёт об эмуляции этих объектов в оперативной памяти — подавать сигнал с выхода одного конкретного перцептрона на входы любых других, что, кстати говоря, будет несколько более соответствовать структуре взаимодействия биологических нейронов в мозге высших животных. Всё дело в вычислительной оптимизации: располагая виртуальные нейроны послойно так, что выходы элементов данного слоя замыкаются на входы элементов строго одного, следующего за этим другого, можно свободно применять известные из линейной алгебры матричные операции для ускорения расчётов. А как раз с такими операциями фоннеймановский компьютер (в памяти которого, напомним, и функционирует цифровая нейросеть) справляется блестяще.

Наглядный пример матричной операции, позволившей добиться значительного прогресса в области машинного обучения, а точнее, распознавания визуальных образов, — это свёртка, о которой подробно говорилось в нашем материале о свёрточных нейросетях. Основная проблема многослойных нейронных сетей в приложении к распознаванию образов заключается в том, что при попытке честно обработать подаваемую на вход картинку целиком — со сколько-нибудь адекватным разрешением, например 512 × 512 точек плюс ещё 3 бита на кодирование цвета, — система вынуждена иметь дело с запредельным количеством параметров, каждый из которых неизбежно должен принимать участие в операциях взвешенного суммирования. Мало того: для тренировки такой сети на распознавание неких образов придётся подавать ей на вход соответствующее количество референсных изображений — отдельно с кошечками, отдельно с собачками, отдельно с лошадками, и так для всех объектов, которые в итоге необходимо будет распознавать. Свёрточные же сети, имеющие дело с выявлением неких характерных особенностей отдельных фрагментов исходного изображения за счёт понижения размерности матриц, радикально, на несколько десятичных порядков, сокращают число рабочих параметров модели в целом. И делают её обучение вполне реалистичным даже на таком сравнительно скромном материале, как открытый (для некоммерческих исследований) набор данных ImageNet — свыше 14 млн изображений более чем в 20 тыс. категорий.

Сегодня, правда, в ходу куда более мощные нейросети: уже GPT-3, напомним, содержит 175 млрд внутренних параметров, действующие значения которых установились после тренировки на датасете из 300 млрд токенов. GPT-4 тренировали, согласно оценке Пабло Виллалобоса (Pablo Villalobos) из Epoch Research Institute, на 12 трлн токенов данных, а для адекватной тренировки моделей следующего поколения может попросту не хватить всей имеющейся в Интернете на данный момент информации — объём которой не превышает 20 трлн токенов (тогда как условной GPT-5 может потребоваться, в зависимости от деталей её воплощения, от 60 до 100 трлн токенов). Активно обсуждается возможность генерировать недостающие данные при помощи тех нейросетей, что работают уже сейчас, чтобы полученные из них токены скармливать перспективным моделям. Однако этот путь многие исследователи критикуют, указывая на такие потенциальные опасности обучения на производных (а не взятых непосредственно из природы либо созданных человеком) данных, как крах модели (model collapse), её чрезмерная специализация (overfitting), проникновение машинных «галлюцинаций» в датасет (все помнят историю о медведях в космосе?) и т. п. Но даже если проблема с данными и будет каким-то образом решена, загвоздка со сверхпотреблением энергии полупроводниковым вычислительным оборудованием, на котором придётся обучать условную GPT-5, никуда не денется. По крайней мере, до тех пор, пока на смену микроэлектронике не придёт фотоника — хотя бы в этой сравнительно узкой, но чрезвычайно значимой сегодня области сферы высоких технологий.

С точки зрения энергоэффективности фотон — куда как более привлекательная частица, чем электрон. Да и в плане плотности передачи данных световой поток в волноводе априори превосходит группу электронов, перемещающихся по проводнику: не случайно уже с конца 1970-х гг. волоконно-оптические линии дальней связи по всему миру стали уверенно вытеснять медные. Для высокоскоростной передачи данных внутри ЦОДов и даже между отдельными вычислительными узлами компьютерных кластеров тоже всё чаще используют оптические каналы коммуникаций: они и скорость гарантируют более высокую, и энергии потребляют меньше. Учитывая, насколько для нейросетевых вычислений значимы скорость и плотность передачи информации, можно ожидать, что и здесь фотоника окажется более привлекательной, чем привычная на сегодня электроника.

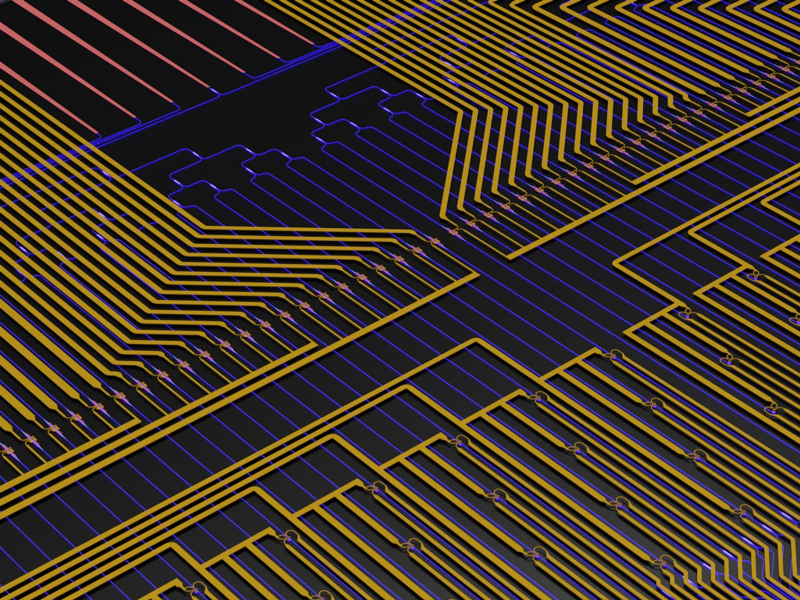

Лавинные фотодетекторы на основе полупроводников вполне способны стать связующими звеньями между чисто фотонными и чисто электронными вычислительными контурами (источник: Intel)

Однако между передачей информации и обработкой её — условным переключением некоего логического вентиля между состояниями «1» и «0» по определённым правилам, заданным его же, вентиля, внутренней конфигурацией, — дистанция огромного размера. Выдающееся качество полупроводниковых транзисторов, уверенно искупавшее до сих пор едва ли не все их вполне очевидные недостатки, — это нелинейность: наличие зависимости их рабочих параметров (сопротивления, прежде всего) от внешних токов и напряжений. В линейном контуре характеристики его компонентов (их сопротивления, ёмкости, индуктивности) есть величины постоянные, а выходящее напряжение всегда пропорционально входящему — в разумных пределах, конечно; пока не происходит пробоя из-за чрезмерно высоких входных параметров тока. Для нелинейного контура это не так — и как раз столь нетипичное его поведение позволяет особым подбором входных параметров получать различные выходные, т. е. в конечном итоге реализовывать разнообразные элементы логических схем.

Фотоны — дело совершенно иное: они движутся в среде прямолинейно (точнее, по геодезическим линиям, — но эффекты общей теории относительности в данном случае учитывать нет смысла), подчиняясь линейным уравнениям Максвелла. И потому оптические приборы, если не принимать в расчёт неизбежное рассеяние/затухание света в них, безыскусно линейны: мощность выходного потока для них в общем случае пропорциональна мощности входного. Как же в таком случае организовывать логические контуры? «То, что нам мешает, то нам и поможет», — наверняка читатели прежних наших статей об успехах и проблемах микропроцессорных производств уяснили уже суть этого весьма продуктивного инженерного подхода. Действительно, прямое воспроизведение базовых элементов универсальной полупроводниковой логики вроде штрихов Шеффера с применением фотонных излучателей и преобразователей — дело на данный момент малопродуктивное (хотя работы и по этому направлению ведутся).

Куда остроумнее следующая логическая цепочка: актуальные ИИ-задачи сводятся к операциям над матрицами; операции над матрицами изучает линейная алгебра; на фотонных устройствах без труда можно строить линейные контуры — не значит ли всё это, что как раз фотоника, а не классическая микроэлектроника в полупроводниковом её изводе оптимальна для ускорения прогресса в области искусственного интеллекта? И в самом деле, такая сплошь и рядом применяемая в (глубоком) машинном обучении операция, как перемножение матриц, может быть произведена гибридным фотонным устройством — с минимальным привлечением самой простой полупроводниковой электроники — куда эффективнее, чем классической вычислительной системой на чисто кремниевой основе.

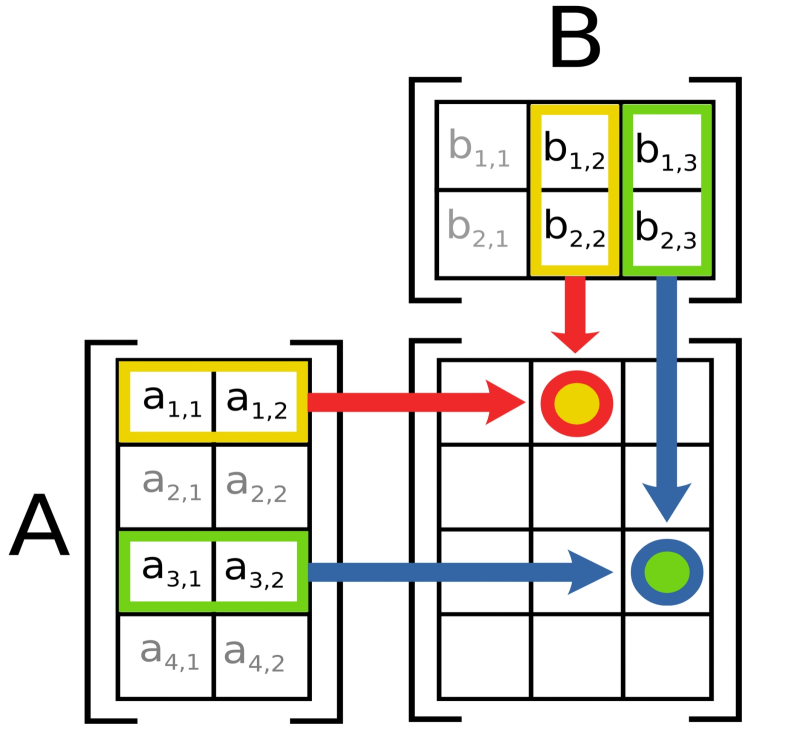

Для тех, кто успел запамятовать основы линейной алгебры, напомним, что перемножать можно такие матрицы, число строк первой из которых равно числу столбцов второй (порядок сомножителей в данном случае имеет значение). В итоговой матрице каждый элемент с координатами (n, k) представляет собой скалярное произведение двух числовых векторов — n-й строки первого сомножителя с k-м столбцом второго. Сами по себе умножение и сложение — процедуры элементарные; современные кремниевые микропроцессоры, тем более многоядерные и многопоточные, справляются с ними шутя. Проблема лишь в том, что задачи машинного обучения оперируют с матрицами гигантских размерностей — а число операций, необходимых для перемножения двух квадратных матриц размера m×m каждая, если не прибегать к изощрённым оптимизациям, составляет величину порядка m³ (в математической нотации — O(m³); читается как «О большое от эм в кубе») — что, ясное дело, уже при исчисляемом десятками тысяч m начинает создавать изрядную нагрузку на аппаратную основу компьютерной системы. Не столько на процессор даже, сколько на шину между ним и памятью, где размещаются промежуточные результаты, — ведь фоннеймановская архитектура, напомним снова, подразумевает разнесение в пространстве вычислительного узла и хранилища данных.

Титаническими усилиями математиков показатель степени, в которую возводится размерность матриц для оценки числа шагов, нужных для их перемножения, за несколько десятилетий удалось снизить примерно с 2,80 до 2,42, а с конца 2023 г. лучшим достижением считается число 2,371552 (а до того рекордным было значение 2,371866) — и на практике каждая десятитысячная, на которую уменьшается этот показатель, имеет крайне весомое значение, выраженное в долларах, и в киловатт-часах. Тем более весомое, чем с более крупными матрицами начинает иметь дело каждая новая модель машинного обучения.

В 2019 г. Райан Хамерли (Ryan Hamerly) с коллегами из Массачусетского технологического института предложили использовать для перемножения матриц оптоэлектронную схему на основе светоделителя (beam splitter) — грубо говоря, полупрозрачного зеркала, развёрнутого под углом 45° к оси падающего на него светового потока. Поскольку зеркало полупрозрачно, ровно половина исходного потока (неизбежными потерями на поглощение/рассеяние в первом приближении можно пренебречь) проходит сквозь стеклянную пластину в прежнем направлении, а вторая половина отражается, как и положено, под углом 90° к этому направлению. Светоделитель явно не годится на роль какого бы то ни было логического контура — он всего лишь разбивает поток фотонов на две равные по интенсивности части, распространяющиеся перпендикулярно друг другу.

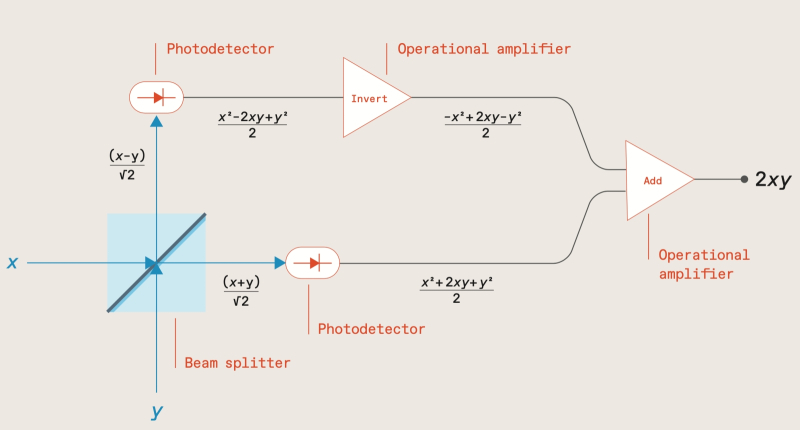

Принципиальная схема оптоэлектронного умножителя (матриц, в частности) на основе оригинального светоделителя (источник: IEEE Spectrum)

Однако на тот же самый светоделитель, в ту же точку, куда падает первый исходный луч (только с обратной стороны пластины), можно направить второй — под углом 90° к первому. С ним будет происходить ровно то же самое, и в результате получится оптическая система с двумя входами и двумя выходами, причём каждый из выходящих потоков окажется комбинацией входящих. Простой светоделитель, что пропускает в исходном направлении ровно половину светового пучка, не обеспечит заслуживающего внимания результата, поскольку интенсивности обоих выходящих (комбинированных) лучей будут равны. Хамерли же с коллегами предложили более изощрённое устройство, которое, принимая по одному направлению световой луч с напряжённостью электрического поля x, а по другому — y, испускает по первому выходящему каналу поток с интенсивностью (x + y)/√2, а по второму — (x − y)/√2.

Далее в оптической схеме на пути выходящих пучков присутствуют фотодетекторы, замеряющие мощность светового потока — величину, пропорциональную квадрату интенсивности электрического поля в этом потоке. Соответственно, из (x + y)/√2 получается (x2 + 2xy + y2)/2, а из (x − y)/√2 — (x2 − 2xy + y2)/2. Затем в дело вступают два операционных усилителя, первый из которых инвертирует выход одного из фотодетекторов (преобразуя (x2 − 2xy + y2)/2 в (−x2 + 2xy − y2)/2), а второй — банально суммирует полученные величины. В результате получается величина 2xy — то бишь линейная оптоэлектронная схема по факту произвела умножение (с добавочным коэффициентом 2, но это совершенно не проблема) исходных величин x и y, закодированных в значениях напряжённостей электрических полей исходных световых потоков. Причём потоки эти не обязаны быть непрерывными во времени: числа в составе матриц, к примеру, можно кодировать последовательными и очень короткими импульсами, согласованными по времени для обоих входных каналов.

Хорошо; произведение эта схема получать позволяет, но ведь при перемножении матриц необходимо ещё и складывать произведения каждой очередной пары чисел из соответствующих ячеек? С этим тоже нет никаких проблем: достаточно разместить за последним на схеме операционным усилителем конденсатор, который будет накапливать порции электрического заряда, пропорциональные выдаваемым этим усилителем очередным всплескам мощности. Линейность всей схемы в целом опять-таки играет инженерам на руку, как и её аналоговый характер: по сути единственный конвертор для преобразования непрерывной величины в дискретное значение потребуется здесь на этапе замера количества заряда, накопленного по завершении серии световых импульсов в счётчике-конденсаторе.

Компьютерная модель конструкции фотонного чипа, предложенного группой Райана Хамерли с коллегами из MTI (источник: IEEE Spectrum)

А теперь припомним, что продолжительность такой серии — число столбцов/строк перемножаемых матриц — может соответствовать размерности поля параметров, с которыми имеет дело нейросетевая модель. Иными словами, если эта размерность равна N, то на фоннеймановском компьютере перемножение таких матриц потребовало бы O(N3) — ну хорошо, пусть даже O(N2,371552) — операций. Оптоэлектронная же схема Хамерли и его коллег справится с подобной задачей ровно за N шагов, причём чем выше частота формируемых источниками света импульсов (а она благодаря успехам современной лазерной техники может достигать сотен терагерц, как у американской установки ZEUS, Zetawatt-Equivalent Ultrashort pulse laser System), тем быстрее будут производиться вычисления.

Помимо радикального ускорения одной из наиболее ресурсоёмких операций в ходе работы больших моделей ИИ, переход к фотонике от «чистой» микроэлектроники обеспечивает ещё и огромную выгоду в плане энергоэффективности. Понятно, что высокочастотный импульсный лазер может требовать немалой мощности для своей работы, но построенный на оптических элементах вычислительный контур в силу обратимости своих операций радикально превосходит полупроводниковую систему, основанную на элементах с необратимой логикой. Этот момент заслуживает отдельного пояснения, поскольку позволяет увидеть принципиальную ограниченность классических вычислителей с опорой на булеву алгебру — именно для решения таких масштабных и ресурсоёмких задач, как те, что связаны с искусственным интеллектом.

Что значит «необратимая логика», легко понять на примере логической операции «И» с двумя аргументами: она выдаёт значение «истина», если оба аргумента истинны, и «ложь» — если хотя бы один из них ложен. Иными словами, по результату — «1» на выходе соответствующего логического вентиля или «0» — только в одном случае из четырёх возможных удастся достоверно установить значения входящих аргументов: если «логическое И» выдало «1», значит, оба аргумента имели значение «истина». Во всех же комбинациях, где участвует хотя бы один «0», информация об исходных параметрах операции теряется.

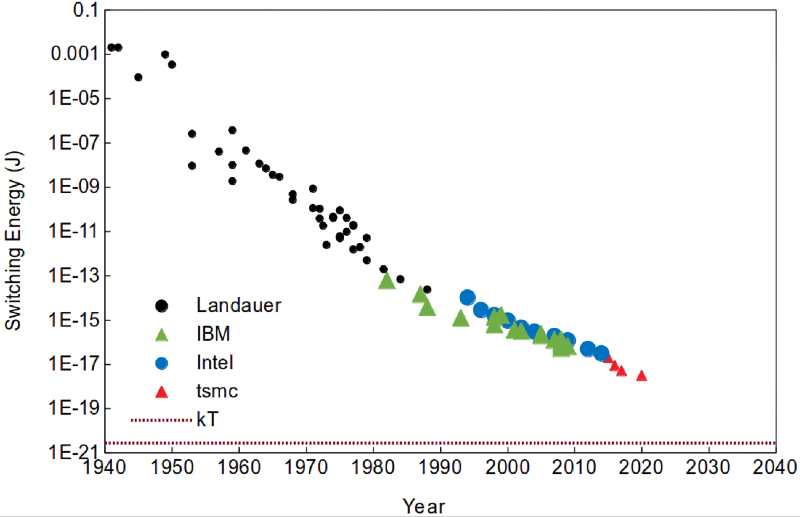

Энергия, которая затрачивается на переключение единичного полупроводникового транзистора, выполненного по актуальному на текущий год техпроцессу, неуклонно сокращается, но ландауэров предел (пунктирная горизонтальная линия) для неё всё равно остаётся недостижимым (источник: LessWrong via Landauer, IBM, Intel & TSMC)

Почему это важно с энергетической точки зрения? Да потому, что потеря информации означает увеличение энтропии системы, а в физическом смысле — диссипацию энергии внутри вычислительного контура. В соответствии с принципом Ландауэра (Rolf Landauer, на тот момент сотрудник IBM, сформулировал его в 1961 г.), в любой вычислительной системе — вне зависимости от конкретики её физической реализации — при потере каждого единичного бита информации (в частности, в ходе операций на необратимых вентилях) выделяется определённое количество теплоты. Обратим внимание, что эта закономерность имеет чисто термодинамическую природу, обозначая ненулевую нижнюю границу энергопотерь вычислительной машины, основанной на необратимых логических вентилях. Дополнительная (и куда более значимая) диссипация за счёт сопротивления (полу)проводников, например, тут в расчёт не берётся вовсе.

Да, установленная Ландауэром величина чрезвычайно мала — составляет менее 3·10−21 Дж на каждый потерянный бит, — но теперь снова вспомним, в каких гаргантюанских объёмах производят современные фоннеймановские компьютеры необратимые элементарные логические операции, решая те или иные задачи с привлечением моделей генеративного ИИ. В 2012 г. принцип Ландауэра был подтверждён экспериментально, а в 2018-м появились свидетельства его справедливости и для квантовых вычислений на физической базе молекулярных наномагнитов, что в перспективе устанавливает нижний предел энергопотребления и для квантовых компьютеров с необратимыми логическими вентилями. Современная микроэлектроника, в особенности опирающаяся на отличные от кремния полупроводники, становится с каждым поколением энергоэффективнее, так что достижение предела Ландауэра для неё ожидается уже в ближайшие десятилетия. Прогноз вполне реалистичный: по состоянию на 2020 г. энергия, затрачиваемая на перевод затвора транзистора из положения «закрыто» в «открыто» или обратно, всего лишь на три десятичных порядка превосходила этот предел, тогда как в 2000-м разрыв превышал шесть порядков.

Фотоника же, опираясь в основном на обратимые логические вентили, позволяет производить хотя бы часть вычислений с энергозатратами на уровне ландауэрова предела, — причём часть довольно весомую. Безусловно, на пути развития этой ветви высоких вычислительных технологий придётся преодолеть немало препятствий, и о них мы расскажем уже в следующем материале по рассматриваемой теме. Но с точки зрения возможности перемножать матрицы в 106 элементов и более по одной стороне, не нуждаясь притом в выделенной атомной электростанции для питания ЦОДа, который такие операции производит, овчинка фотоники определённо стоит выделки.

[1]* Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности».