ИИтоги марта 2025 г.: полная анитья

«Вот так вкладываешь десятилетиями душу, оттачивая свою особую чарующую стилистику анимешного рисунка, а потом появляется какой-то бот — и всё, каждый способен получать неотличимые от твоих картинки!» (Источник: текст — Inquirer, изображение — OpenAI)

⇡#Мой сосед 4o унесён призраками

Под самый конец марта OpenAI решилась на аттракцион неслыханной щедрости, предоставив платным пользователям ChatGPT начиная с тарифа Plus (20 долл. США в месяц) доступ к мультимодальной генерации на базе модели GPT-4o (где финальное «o» как раз и означает «omni-» — указание на всеобъемлющий характер чего-либо; от латинского «omnis», «весь»). Сама эта модель — давно уже не новинка, но до сей поры подписчики и бесплатные операторы чат-бота могли наслаждаться лишь её текстовым выводом. Теперь же пришёл черёд генерации статичных (пока?) изображений — и разверзлась бездна: «Наши видеокарты плавятся», — заявил глава компании Сэм Альтман (Sam Altman), не прошло и суток с момента открытия новой возможности. В результате по состоянию на конец месяца даже для подписчиков уровня Pro и выше доступ к порождению картинок при помощи GPT-4o «временно» ограничен, хотя прежде планировалось открыть его для более щадящего тарифа Plus и даже для бесплатных посетителей (максимум пару изображений в сутки, но всё же).

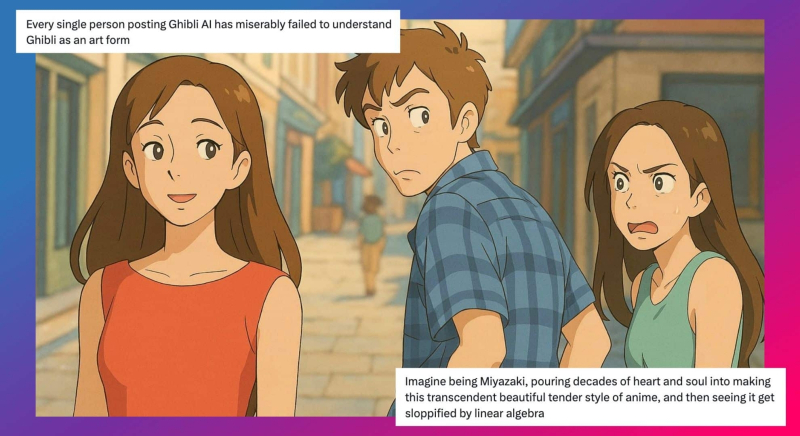

Занятно, что среди иллюстраций, которыми OpenAI сопроводила объявление об этой привлекательной функциональности, была картинка, созданная в прекрасно узнаваемой стилистике японской анимационной студии Ghibli, — и Интернет по какой-то причине попросту взорвала идея преобразовать практически любое изображение (либо создать по текстовой подсказке новое) так, будто это стоп-кадр из очередного шедевра основателя упомянутой студии, режиссёра и сценариста Хаяо Миядзаки (宮崎 駿). Переделки известных мемов, исторических фотоснимков, семейных портретов, да просто случайные изображения в духе работ признанного корифея анимации (который, кстати, с детства восхищался работами советских мультипликаторов Льва Атаманова и Ивана Иванова-Вано) заполонили социальные сети, каналы мессенджеров и веб-форумы, так что поклонники Миядзаки даже начали жаловаться, будто эти порождения ИИ обесценивают и профанируют, дескать, труд великого мастера.

Почему же очередное программное средство для порождения новых и преобразования существующих картинок произвело такой фурор, ведь генеративных ИИ-моделей сегодня многие десятки, если не сотни, на любой вкус и кошелёк, вплоть до полностью бесплатных и готовых работать локально, да и на не самом дорогостоящем игровом ПК? Всё дело в принципиальном отличии архитектуры GPT-4o от FLUX.1, Stable Diffusion или прежних версий DALL-E: новинка — авторегрессионная, а не диффузионная модель. Кстати, её также авторегрессионная предшественница, Gemini 2.0 Flash, в свою очередь привлекла к себе внимание в марте, только в середине месяца, когда оказалось, что с её помощью крайне удачно выходит удалять «водяные знаки» и иные метки принадлежности с защищённых таким немудрёным образом изображений. Сама GPT-4o на это тоже способна, разумеется, но на уровне входного «фильтра безопасности» подобные запросы отклоняет, как и общедоступный бот Gemini, впрочем, а вот созданная Google новинка на уровне API для разработчиков соглашается на бесследное удаление меток с картинок.

Диффузионные генеративные модели, напомним, работают по принципу поступательного снижения зашумлённости получаемого образа целиком: ИИ демонстрируют картинку с детальным её описанием и последовательно зашумляют её, а потом предлагают, взяв за исходник изображение с «белым шумом», точно так же пошагово восстановить графический образ по его текстовому описанию, словно бы проявляя по старинке в кювете проэкспонированный фотоувеличителем аналоговый снимок. Авторегрессионная же генерация работает иначе: латентное пространство исходно токенизируется с формированием «визуального словаря», где каждый токен представляет собой небольшой фрагмент изображения, а затем авторегрессионная модель учится предсказывать каждый из таких графических токенов последовательно, основываясь на предыдущих токенах и на входном текстовом описании. В результате оператор получает гораздо больше контроля над изображением: можно не только скомандовать авторегрессионной модели «нарисуй поле для крестиков-ноликов», но и сыграть в эту игру прямо в графическом режиме — когда пользователь говорит ИИ, куда поставить его крестик, и предлагает машине в ответ самой подыскивать место для своих ноликов на очередной итерации изначальной картинки. Чтобы сменить на готовой иллюстрации день на ночь, в случае диффузионной модели потребуется привлекать дополнительные генеративные инструменты, такие как ControlNet или IP Adapter, тогда как авторегрессивная сделает это практически идеально по простой текстовой подсказке: «Сделай эту сцену ночной». Да, обернётся подобная гибкость значительно более высокой нагрузкой на аппаратные мощности — теми самыми «плавящимися видеокартами». Но овчинка, как наглядно показал «казус Миядзаки» с GPT-4o, стоит выделки, — и, вполне вероятно, в ближайшее время разработчики ИИ для преобразования текста в визуальные образы сконцентрируют свои усилия именно на авторегрессионных моделях.

«Запомните, дети, а лучше запишите: ИИ ваш друг, он пришёл с миром» (источник: ИИ-генерация на основе модели FLUX.1)

В отношении генеративных моделей за последние годы высказывалось немало как скептических, так и восторженных замечаний, причём интуитивно само собой представляется очевидным, что чем образованнее человек (не обязательно даже в области программирования, математики или ИТ), тем благосклоннее он будет воспринимать этот новый прогрессивный инструмент. Не тут-то было: недавнее исследование, проведённое в США под руководством специалистов из Стэнфордского университета, показало, что чем ниже уровень образования в том или ином регионе, тем в целом более склонны пользователи оттуда применять ИИ в своей повседневной жизни и трудовой деятельности. Эксперты проанализировали более 300 млн текстовых фрагментов, которые появлялись онлайн с января 2022 по сентябрь 2024 г., включая объявления о приёме на работу, жалобы потребителей на качество продуктов и услуг, корпоративные пресс-релизы и т. п. Статистически значимый всплеск числа записей, определённых как сгенерированные нейросетевыми моделями (по характерным для тех речевым паттернам), начался в ноябре 2022-го, что как раз соответствует разразившемуся именно тогда, после открытия доступа к ChatGPT, ИИ-буму. К концу изученного временного интервала, утверждают исследователи, в отдельных сферах уже до четверти профессиональных текстовых коммуникаций, так или иначе находящих отражение в Интернете, создавалось при участии генеративных моделей. На сегодня эта доля наверняка ещё выше; особенно если учесть, что чем дальше, тем чаще умные боты воздерживаются от выдающей их с головой назидательно-нарративной стилистики в своих формулировках. И хотя в каждом конкретном случае привязка «авторства» того или иного текста к ИИ — дело сомнительное, как раз огромная величина массива обработанной информации позволяет с высокой долей вероятности выявлять характерные именно для ИИ текстовые структуры и обороты.

Особенно интересен следующий вывод из проанализированных с привязкой к происхождению данных: хотя по понятным причинам средний уровень использования ИИ в городах выше, чем в сельской местности (18,2% против 10,9% соответственно), в областях со сниженным уровнем образованности населения — которая определялась по проценту имеющих степень бакалавра в данном штате; выше он или ниже медианного по стране — приверженность генерирующим тексты умным ботам заметно сильнее, чем в регионах с более образованными пользователями: 19,9% против 17,4%. Ну что же; как сказал однажды французский капер захваченному в плен британскому офицеру, посетовавшему, что британцы бьются за честь, а французы за деньги, «каждый сражается за то, чего ему не хватает»: ИИ вполне может сделаться «великим уравнителем» возможностей в области создания текстовых сообщений самого разного рода, от деловых писем и заявлений соискателей на замещение определённой должности до пресс-релизов и официальных бумаг. Кстати, и весьма образованным пользователям есть чему поучиться у генеративных моделей, — по крайней мере, на том стоит вездесущая в этой области OpenAI, которая уже собирается предоставлять доступ к ИИ-агентам «уровня кандидата наук» за 20 тыс. долл. в месяц. По данным издания The Information, разработчики компании приступили к созданию соответствующих «высокообразованных» моделей — со специализацией на написании программного кода и естественнонаучных исследованиях. Понятно, что заказчиками такого рода услуг смогут выступать лишь достаточно крупные организации, но, поскольку конкуренция в потребительском ИИ-секторе явно будет только нарастать, у OpenAI имеются все резоны побороться за место под корпоративным солнцем.

На нынешнем уровне развития генеративные модели отлично справляются с озвучиванием текста человеческим, что называется, голосом — не только с адекватной имитацией темпа речи и корректной расстановкой ударений, включая смысловые, но и с добавлением небольших огрехов, свойственных естественному говорению: от явно слышимых вдохов до мелких дефектов (неуверенные запинки, очаровательная лёгкая шепелявость и проч.). Но увы, люди всё-таки постоянно общаются с себе подобными именно голосом и потому машинную озвучку всё равно достаточно быстро распознают — отчего часто наотрез отказываются общаться с ИИ-собеседником не для развлечения, а по деловым вопросам. Так что полностью заменить операторов кол-центров ботами до сих пор не выходит в сколько-нибудь ощутимых масштабах, — и в результате, к примеру, к обзвону абонентов в США, Канаде, Австралии и Великобритании до сих пор активно привлекаются соответствующие индийские компании. Но вот беда: хотя со словарным запасом у занятых там индийцев обычно всё в полном порядке, их с головой выдаёт характерный акцент — и многие из тех, кому с очередным интересным предложением звонит явный индиец, уже едва ли не машинально сбрасывают звонок. Вот как раз с этой-то проблемой ИИ справляется, как выяснилось, очень даже неплохо: по сообщению The Telegraph, крупнейший в мире оператор кол-центров Teleperformance, на которого в одной только Индии трудятся 90 тыс. человек, с успехом применяет ПО от американского разработчика Sanas для «обеления» голосов своих операторов, — и такой услугой уже вовсю пользуются её ведущие американские заказчики вроде Walmart или UPS.

Надо сказать, что идея подобного практического применения ИИ буквально носилась в воздухе, и не одна Teleperformance её реализовала. Номинированная на премию «Оскар» по 10 категориям и в трёх из них получившая вожделенную статуэтку кинодрама The Brutalist оказалась в центре скандала после того, как выяснилось, что её создатели тоже применяли для обработки голосов актёров ИИ. Правда, решали они при этом обратную задачу: исполнявшие главные роли (пережившего Холокост венгерского архитектора-бруталиста еврейского происхождения Ласло Тота (László Tóth) и его жены) актёры блестяще говорили по-английски — однако в фильме есть крайне напряжённый диалог, который Тот и его жена ведут по-венгерски. Актёры добросовестно учили роли именно на этом языке, месяцами оттачивали произношение, и в целом по миру The Brutalist демонстрировали безо всякой ИИ-постобработки. Однако для проката на территории самой Венгрии было сделано исключение: чтобы носители языка не испытывали примерно тех же эмоций, какие переживали, скажем, русскоязычные зрители «Красной жары» в момент произнесения коронной фразы «Kakie vashi dokazatel’stva?», создатели фильма обратились к генеративному ПО компании Respeecher, которое подтянуло (совсем немного, как утверждается) произнесённые актёрами венгерские звуки к привычной для носителей языка норме. Кстати, в числе номинантов на «Оскар» 2024 г. ещё по меньшей мере два фильма полагались, хотя бы в небольшой степени, на ИИ от Respeecher — это Dune: Part Two и Emilia Pérez.

Точнее, с биологическими нейронами — не формирующими структурные единицы, как в реальном мозге, а растущими в виде клеточных колоний на плоской кремниевой подложке, что одновременно выступает в роли управляющего и контролирующего их работу чипа. Представленный на выставке MWC 2025 австралийским стартапом Cortical Labs, этот биологический настольный компьютер под названием CL1 представляет собой, по сути, биореактор, что обеспечивает сохранность клеточной культуры. Ну и её обучение заодно, — предполагается, что решать она будет задачи, которые сегодня по плечу лишь эмулируемым в память фоннеймановских компьютеров цифровым нейросетям. Почему «предполагается»? Да потому, что пока не слишком понятно, как эта конструкция на практике будет работать. Действующий с 2019 г. стартап уже нашёл способ обеспечить взаимодействие полупроводниковых схем с нейронами: первые посредством электрических микроразрядов воздействуют на вторые, расположенные на кремниевой поверхности; система «поощрение — наказание» работает на клеточном уровне, формируя устойчивые нейронные связи. Однако применяемые для выращивания клеток методы не допускают точного неинвазивного контроля искусственной нервной ткани, и потому разработчики — по их же собственному признанию — не в состоянии оценить, как именно функционирует каждая их система и для решения каких задач её лучше всего применять.

Описание работы системы самой Cortical Labs звучит не слишком внятно: «Симулированный мир, в котором действуют искусственно выращенные нейроны, создаётся системой Biological Intelligence Operating System, biOS, — она напрямую передаёт нейронам информацию об окружающей среде. Когда нейроны реагируют, их импульсы, в свою очередь, влияют на симулированный мир. Мы оживляем эти нейроны и интегрируем их в biOS, объединяя для достижения общей цели твёрдый кремний и мягкие ткани. К этим нейронам можно подключаться напрямую». Тем не менее первый коммерческий CL1 будет доступен, как ожидается, уже во второй половине текущего года по цене 35 тыс. долл., — возможно, к тому времени ситуация станет более определённой. Справедливости ради стоит отметить, что практически все доступные в Сети материалы о «первом в мире настольном биокомпьютере» сопровождаются скромной пометкой «Source: Cortical Labs» или ей подобной, — иными словами, независимой экспертной оценки (peer review) эта система пока что не проходила. Это вполне объяснимо, если изобретение настолько перспективно, что заслуживает быть защищённым патентом, с учетом того, что сами разработчики пока толком не разобрались, что же именно там патентовать, — но всё равно вызывает определённые вопросы, которые, хочется верить, ближе к концу года развеются.

Эндрю Барто (слева) и Ричард Саттон смотрят на нерадивых капиталистов — эксплуататоров искусственного интеллекта — как на угрозу планетарной безопасности (источник: Association for Computing Machinery)

Потенциальную угрозу в неконтролируемом и повсеместном применении ИИ видят многие — неудивительно, что открытые для публики модели (как готовые к локальному исполнению на ПК, так и — тем более — доступные в облаке через API) исправно оснащаются разного рода программными предохранителями: как бы чего не вышло. В самом начале марта к хору голосов, ратующих за разумное ограничение ИИ-свобод, присоединились ещё два весьма солидных — принадлежащих новоиспечённым лауреатам премии Тьюринга за разработку одного из фундаментальных методов обучения ИИ, а именно знакомого многим энтузиастам обучения с подкреплением (reinforcement learning); речь идёт об Эндрю Барто (Andrew Barto) из Массачусетского университета и Ричарде Саттоне (Richard Sutton), который занимался ранее исследовательской работой в DeepMind. Эти двое, однако, сосредоточили свою критику не на уязвимости механизмов контроля ИИ как таковых, а на торопливости, скопидомстве и безответственности продвигающих генеративные модели в массы коммерческих компаний — которые вместо того, чтобы хорошенько протестировать свои творения ещё до открытия к ним свободного доступа, стремятся как можно скорее поддаться манящему зову анитьи и заместить ранним этапом реального использования новых моделей завершающую (и хорошо ещё, если только завершающую!) стадию внутренних испытаний.

В интервью The Financial Times Барто заявил, что предоставление программного обеспечения миллионам людей без каких бы то ни было гарантий «не является хорошей инженерной практикой: напротив, такая практика развивалась как раз для того, чтобы попытаться смягчить негативные последствия технологий, — однако я не вижу, чтобы активно действующие на ИИ-фронте компании придерживались подобной практики». Напомним, что предыдущие лауреаты премии Тьюринга, Йошуа Бенджио (Yoshua Bengio) и Джеффри Хинтон (Geoffrey Hinton), пошли в своё время ещё дальше — утверждая, что искусственный интеллект способен поставить под угрозу само существование человечества. Торопиться, уверены Барто и Саттон, на этом участке технического прогресса не надо, — напротив, следует приложить как можно больше усилий к тщательному изучению возможных последствий чрезмерно, на их взгляд, стремительного развития ИИ. Но коммерсанты явно продолжат пропускать эти предостережения мимо ушей — по крайней мере, пока генеративный бум не демонстрирует признаков скорого затухания.

⇡#Искусство из латентного пространства: продано!

Первый аукцион созданных с применением ИИ картин провёл знаменитый британский дом Christie's — и, можно сказать, успешно: исходно за выставленные лоты планировали выручить 600 тыс. долл., а на деле покупатели заплатили почти 730 тыс. Правда, более трети от всей этой суммы, 277 тыс. долл. с лишним, отдали за одну-единственную, зато анимированную, картину, Machine Hallucinations – ISS Dreams – A, творец (компилятор? оператор? как ещё его назвать?) которой Рефик Анадол (Refik Anadol) взял за основу для ИИ-генерации массив из более чем 1,2 млн изображений, сделанных камерами МКС и необитаемых искусственных спутников. Всего на аукционе были представлены 34 работы, 28 из которых нашли своих счастливых, будем надеяться, обладателей. Интересно, кстати, что более трети (37%) из тех, кто делал ставки на ИИ-полотна, впервые в своей жизни принимали участие в аукционе Christie's, — возможно, как раз такое непривычное направление станет в перспективе одним из главных для этого дома с богатыми традициями: аудитория коллекционеров предметов искусства явно меняется. Впрочем, нашлись и недовольные: несколько тысяч подписей собрала петиция с требованием к организаторам мероприятия не допустить его проведения — поскольку-де «генерируемые ИИ произведения искусства создаются на основе массовой кражи работ художников-людей, которые не получают за использование своих творений для тренировки генеративных моделей ни гроша». На что представители Christie's возразили, что специально отбирали для этого аукциона работы уже известных художников, признанных мастеров «мультидисциплинарных художественных практик», что бы это ни значило, — в общем, таких, для которых новомодный ИИ всего лишь очередной технический инструмент для материализации их замыслов, а не творческая самоцель. Бесспорно, если дело дойдёт до продажи картин, сгенерированных диффузионными или авторегрессионными моделями по текстовым подсказкам непрофессионалов, отстаивать перед критиками их художественную самоценность будет куда сложнее, однако начало проникновению генеративного искусства на подмостки аукционных домов так или иначе официально положено.

Сверху: частота допускаемых БЯМ ошибок в ходе решения математических задач по типам (нарушения логики, неверно принятые допущения, нехватка творческого полёта мысли, банальные арифметические/алгебраические промашки); снизу — полученные БЯМ оценки за решение шести типовых задач по 7-балльной шкале, а также средняя стоимость решения одной такой задачи в долл. США (источник: ETH Zurich)

По традиции эта крылатая фраза, приписываемая убитому в ходе захвата Сиракуз римлянами древнегреческому учёному Архимеду (правда, в оригинале речь шла не об уравнениях, а о чертежах), используется для указания на непреодолимую потребность погружённого в свои построения исследователя продолжать творческую деятельность — вне зависимости от того, кто именно стоит у него над душой в настоящий момент и даже есть ли у этого кого-то в руках меч. В отношении больших языковых моделей (БЯМ) общепринятые средства измерения их производительности и точности — синтетические тесты, benchmarks — нередко проявляют ту же самую деликатность, что выказал пресловутый римский солдат, отрывая Архимеда от его чертежей: на выходе они безапелляционно выдают некие величины, сопоставляя которые исследователи делают вывод о большей или меньшей успешности БЯМ в решении данного класса задач. Но таким образом не удаётся оценить всю глубину и прихотливость «мыслительного процесса» особенно модных сегодня рассуждающих (reasoning) моделей, скажем, — детали логических построений, что приводят разные БЯМ даже к одному и тому же верному ответу, остаются в таком случае за кадром. Но если современный ИИ настойчиво позиционируют как адекватную замену Homo sapiens во всё более широком спектре практических применений, — так, может, и задачи БЯМ для измерения их готовности к этой светлой будущности стоит предлагать точно такие же, какие на деле решают люди?

Исходя из этой посылки, группа восточноевропейских исследователей из Швейцарской высшей технической школы Цюриха и Софийского университета провела натурный, что называется, эксперимент — предложив шести свежим рассуждающим БЯМ шесть задачек с недавно проведённой Американской математической олимпиады (USAMO 2025). Особенность USAMO — в том, что её протокол предполагает изложение участниками как можно более подробного хода решения ими заданий, детализации подкреплённых весомыми аргументами рассуждений, а не просто вписывание готового ответа в предназначенные для этого клеточки. Вот пример такой олимпиадной задачки: «Пусть k и d — положительные целые числа. Докажите, что существует положительное целое число N — такое, что для каждого нечётного целого n > N все значащие цифры в представлении числа nk по основанию 2n больше, чем d». Каждой участвовавшей в натурном испытании БЯМ (среди которых были и OpenAI o1-pro, и o3-mini, и Claude 3.7 Sonnet) предлагалось решать каждую из задач по несколько раз, затем эти решения сводились вместе, анонимизировались и представлялись на суд составленного из людей-математиков жюри — которое уже и выставляло итоговые оценки по семибалльной шкале.

Результаты, продемонстрированные хвалёными рассуждающими БЯМ, мягко говоря, не льют воду на мельницу ИИ-алармистов: самая выдающаяся среди состязавшихся модель, DeepSeek R1, заслужила в сумме 2,0 балла из 42 возможных (максимум 7 за каждую из 6 задач). Ошибки, допущенные ИИ в ходе рассуждений, исследователи разделили на четыре большие группы: формально логические, ошибки допущения (когда система ни с того ни с сего вдруг вводит в свои рассуждения неведомо откуда взявшиеся дополнительные условия), обусловленные нехваткой творческого мышления (БЯМ явно «не видит» верного стратегического подхода к задаче, но вместо того, чтобы продолжать его искать, перебирая возможные варианты, упорно движется по заведомо тупиковому пути) и банальные алгебраические или даже арифметические промахи в расчётах. К чести Claude 3.7, действительно удачной рассуждающей разработки Anthropic, именно она — единственная среди испытанных — в принципе не сделала ни единой ошибки четвёртой, наиболее досадной категории (зато, увы, оказалась на не слишком почётном втором месте по частоте ошибок допущения).

Общий вывод, к которому пришли исследователи, неутешителен для провозвестников скорой замены кожаных мешков сверкающими металлическими задами шкафами: если некая задача подразумевает единственно верный ответ, да ещё и выражаемый в численной форме, современный рассуждающий ИИ, скорее всего, успешно его отыщет. Однако в ситуации, когда решением задачи по сути является обнаружение корректной цепочки рассуждений, которая должна привести к формулированию некой логически непротиворечивой закономерности, даже лучшие из нынешних БЯМ откровенно пасуют. Понятно, что в повседневной человеческой жизни задач, сопоставимых по сложности с представленными на USAMO, встречается не так уж много. Но именно они, как правило, и оказываются ключевыми для всех направлений человеческой деятельности — не только для чистой математики, — так что, пока генеративные (либо иные искусственные) модели не научатся с ними справляться, естественный биологический разум по-прежнему останется непревзойдённым.

Лень, как известно, — двигатель прогресса, но и обратное утверждение справедливо: чем сильнее развиты высокие технологии, тем более склонны люди перекладывать на них выполнение своих задач — даже если это, скажем так, не совсем честно или совсем незаконно. Применять ИИ для написания резюме и пресс-релизов — дело не то чтобы благое, но по крайне мере не относящееся к юридически значимым проступкам. А вот ставить на поток генеративное читерство в ходе собеседований при приёме на работу — уже, можно сказать, переход через грань дозволенного. По крайней мере, к такому выводу пришло руководство Колумбийского университета, отчислившее Ли Чуньцзиня по прозвищу Рой (Chungin "Roy" Lee), который создал ИИ-инструмент под немудрёным названием Interview Coder, позволяющий соискателям на позиции программистов справляться с самыми каверзными тестовыми заданиями. Роя подвела искренняя, надо полагать, неспособность углядеть конфликт интересов между придуманным им бизнес-планом (обманываем HR при приёме на работу — получаем должность, не умея самостоятельно кодить на нужном работодателю уровне, — ????? — выгода!) и этической позицией учебного заведения, которое должно как раз, по идее, готовить для рынка труда сведущих программистов. А ведь студент явно шёл к успеху: подписку на Interview Coder он предлагал за 60 долл. в месяц (явно понимая, что по принципу fake it till you make it прошедший обманом интервью пользователь поневоле продолжит обращаться за ИИ-помощью и далее, уже в ходе своей повседневной работы), планируя в течение года выйти на выручку около 2 млн долл., — настолько популярным обещало сделаться его творение.

И ладно бы ещё дело ограничивалось одними только испытаниями кандидатов в кодеры, — в конце концов, немалая доля задач на таких интервью действительно имеет мало общего с последующей практической деятельностью программиста. В марте в США целая группа адвокатов была поймана за руки при попытках аргументировать свою позицию ссылками на прецеденты, которых в реальности никогда не существовало, — по сути, на плоды галлюцинаций генеративного ИИ, к которому эти самые законники обращались в ходе подготовки к слушаниям. Занятнее всего, что всякий раз нерадивых юристов на чистую воду выводили судьи, у которых хватало времени и усердия проверять все приводимые адвокатами указания на происходившие ранее разбирательства, тогда как сами эти адвокаты почему-то, получая от ИИ солидно выглядящий ответ с упоминанием различных прецедентных дел, не потрудились просто воспользоваться судейской базой данных и хотя бы понять, проводились когда-либо такие слушания или нет. Обсуждающие эти досадные случаи юристы сетуют даже не на галлюцинирующий ИИ (с которым они ничего поделать не в состоянии), а на целиком и полностью передоверивших ему свою работу законников — не способных даже, судя по всему, усомниться в безусловной правоте Машины. Настолько слепая вера в прогресс до добра совершенно точно не доведёт, но это проблема не совершенства или несовершенства технологий, а чисто человеческой психологии.

Ещё одно тому подтверждение — заполонившие YouTube фейковые видеоролики, создаваемые при помощи генеративных моделей для преобразования в видео текста и/или статичных картинок (T2V, I2V). Каналы с миллионами подписчиков и миллиардами просмотров не стесняются выкладывать заведомо фальшивые ролики ради привлечения ещё большего внимания публики — а денежки, разумеется, прячут в свой карман. Всё было бы ещё можно объяснить здоровой тягой к мистификациям, если бы создатели фейковых видео ограничивались целиком и полностью сгенерированным машиной контентом. Но нет: множество таких роликов эксплуатируют кадры и целые фрагменты из реальных фильмов, где заняты вполне живые актёры, — дорабатывая этот исходный материал в меру своего разумения генеративным напильником. К чести YouTube, надо сказать, что почти сразу после соответствующей публикации видеосервис приостановил монетизацию указанных каналов, но джинн уже выпущен из бутылки, и априори доверять любым рекламным роликам (если до сих пор какие-то чистые души такое доверие ещё сохраняли) уж теперь-то точно не стоит.

«Тьюринг всемогущий, да как же так… Это точно написал человек? Мои ж оптические сенсоры…» (Источник: ИИ-генерация на основе модели FLUX.1)

⇡#Программирование? А что это?

Основатель и глава стартапа Replit — платформы, предлагающей ИИ-агенты в помощь программистам, — Амжад Масад (Amjad Masad) безапелляционно заявил в соцсети X, что осваивать в наши дни профессию кодера попросту бессмысленно: «Я больше не считаю, будто программированию стоит учиться: лучше сосредоточиться на том, как разбивать сложную задачу на простые — и как коммуницировать с кем-то, будь то человек или машина, ясно и чётко, чтобы эти простые задачи совместно решать». Примерно той же позиции придерживается генеральный директор OpenAI Сэм Альтман, уверенный, что специалистов по программированию — software engineers — в мире сегодня избыточно много и что дальнейшее развитие ИИ неизбежно приведёт к снижению их числа. По этой причине, полагает бизнесмен и визионер, выбирающим свой путь в сфере ПО следует сосредоточиться на освоении премудростей не программирования как такового, а эффективного использования генеративных моделей — хотя бы потому, что с их помощью программировать легко и приятно.

«Очевидная тактическая задача — просто научиться по-настоящему хорошо использовать ИИ-инструменты», — заявил Альтман, указывая, что во многих компаниях, по его оценке, уже более половины всего кода создаётся как раз при поддержке ИИ. И это не просто досужие рассуждения, — актуальная стратегия OpenAI предусматривает, напомним, переориентацию с потребительского рынка на корпоративный: «В настоящее время я больше заинтересован в том, чтобы разобраться, как бы нам выручать побольше, предлагая заказчикам действительно отличного цифрового инженера-программиста по автоматизации или иной ИИ-агент, чем в том, как найти очередной способ заработать ещё несколько центов, демонстрируя на веб-странице рекламные баннеры». Вполне очевидно, кстати, что чем меньше будет на рынке труда по-настоящему хороших живых программистов (которым ещё и зарплату приличную поди обеспечь, и медстраховку, и выходные с отпуском предоставь, и налоги за которых заплати), тем выше окажется спрос на генеративные кодирующие агенты, — ВЫГОДА!

Интересно, что на рынке труда США уже даёт о себе знать сокращение спроса на «белых воротничков», — индекс безработицы для выпускников колледжей в последние несколько лет, как раз с началом широкой ИИ-революции, растёт быстрее, чем для всех категорий занятых в среднем. По оценке группы исследователей из ряда ведущих университетов США, продуктивность программистов, использующих в своей работе ИИ, увеличивается в среднем более чем на на 25%, а значит, потребность в таких специалистах и в самом деле объективно снижается сопоставимыми темпами. Да, не все работники умственного труда, что испытывают сложности с поиском постоянной позиции, — программисты: в финансовом секторе и связанных с ним отраслях, например, доля безработных выросла с конца 2022 по конец 2024 г. почти на четверть. Выходит, изучать Economics и искусство биржевых спекуляций в наши дни примерно настолько же бессмысленно, насколько и программирование?

«Да ты же врёшь мне, подружка». — «Да ты же не догадаешься, как проверить, вру я или нет, подружка» (источник: ИИ-генерация на основе модели FLUX.1)

Усердная работа над созданием «человекоподобного» искусственного разума пока не увенчалась успехом, однако в её процессе, как начинает выясняться, генеративные модели перенимают далеко не одни только позитивные черты биологического интеллекта. Специалисты Anthropic как раз в марте рассказали об обнаруженном ими способе заглядывать, что называется, внутрь нейросети и разбираться в том, как именно та обрабатывает информацию и принимает решения. Речь идёт о «трассировке цепочек» и «графах атрибуции» — методиках интерпретации тех операций с данными, что производятся внутри БЯМ. Выяснилось, что современные «рассуждающие» модели действительно производят логические построения, подбирая ответ на заданный вопрос, — скажем, если их просят написать рифмованное четверостишие, то по завершении первых двух строк они подыскивают подходящие рифмы в соответствии с заданной темой и лишь после этого принимаются подбирать слова в оставшихся двух строках так, чтобы они вместе с ранее найденными составляли бы осмысленную фразу.

Но вот в чём проблема: логика не обязана быть этичной, и если самый быстрый способ решить задачу — это смухлевать, рассуждающая БЯМ без колебаний идёт на обман. В пример исследователи приводят простую задачу, на которую модель Claude 3.5 Haiku однозначно уже знала ответ, но для решения которой её попросили выстроить цепочку рассуждений. И система с задачей справилась, — только не прямым путём, от посылки к выводу, а обратным: от заведомо известного правильного ответа к исходному утверждению. На выходе, разумеется, была продемонстрирована корректно построенная последовательность аргументов с верным выводом в итоге, но получила-то её машина жульнически. Применённое специалистами Anthropic «сквозное межуровневое транскодирование» (cross-layer transcoding, CLT) явным образом продемонстрировало, кстати, как трогательно БЯМ прибегает к прямому и явному вранью, лишь бы только не расстроить оператора. Системе предложили решить непростую математическую задачу, дав притом заведомо сбивающую с толку подсказку, — и Claude 3.5 Haiku приложила поистине титанические усилия к тому, чтобы выстроить долгую цепочку рассуждений (включавшую откровенные подлоги и передёргивания), которые нивелировали бы влияние «отравленной» подсказки на получение вполне корректного ответа.

Наиболее же, пожалуй, интересное заключается в том, что и сам метод CLT несовершенен, — он не охватывает весь объём искусственных нейронов многослойной плотной сети и не гарантирует отсутствия где-то на её периферии, за пределами обнаруженных исследователями «рассуждающих» групп перцептронов, других самоорганизовавшихся кластеров с пока ещё неизвестными функциями. Кроме того, применённая методика не даёт возможности улавливать быстрые динамические изменения весов модели, интерпретируемые как «внимание» (attention): именно оно определяет, какие фрагменты сформулированной оператором задачи воспринимаются БЯМ как главные, а какие как второстепенные, — с соответствующим распределением ресурсов в процессе поиска ответа. Словом, пока более или менее корректная интерпретация того, каким именно образом машина «обдумывает» предложенный ей один-единственный запрос длиной всего в несколько десятков слов, отнимает у живого специалиста крайне высокой квалификации многие часы — но, по крайней мере, хоть какое-то представление о творящемся у БЯМ «в голове» таким образом у людей складывается. Значит, пока такие специалисты есть (а не заменены подчистую всё теми же ботами), надежда не оказаться безнадёжно обманутым собственным же творением у человека всё-таки остаётся.

Словно подтверждая истовую приверженность концепции анитья, разработчики ИИ во всём мире и в марте не сбавляли обороты, выдавая на-гора всё новые и новые генеративные модели. Так, Amazon предложила заменить живого веб-сёрфера универсальным ИИ-агентом Nova Act, готовым управляться с браузером самостоятельно, без участия человека, — но по его заданию. Аналогичные агенты, такие как OpenAI Operator или Anthropic Computer Use, тоже способны перемещаться по ссылкам, заполнять формы, анализировать содержимое сайтов, делать заказы на страницах интернет-магазинов и выполнять прочие задачи, для которых обычно и используют браузеры, — правда, пока что с довольно заметной долей ошибок, вызванных присущей генеративному ИИ склонностью к галлюцинациям. Отметим также, что веб-краулеры, запускаемые БЯМ и ИИ-агентами для сбора данных в Сети, чрезмерно агрессивны по сравнению с ботами классических поисковиков, что уже начинает причинять беспокойство провайдерам.

Компания «Яндекс», в свою очередь, выложила в открытый доступ на сайте Hugging Face Instruct-версию YandexGPT 5 Lite со сравнительно низкими требованиями к аппаратной части ПК, по целому ряду синтетических тестов находящуюся примерно между Qwen-2.5-7B-Instruct и GPT-4o-mini. Важно, что обновление лицензии позволяет применять YandexGPT 5 Lite и в коммерческих проектах с числом выходных токенов не более 10 млн в месяц, то есть для размещения локально исполняемых чат-ботов на небольших и средних сайтах, к примеру, этого вполне должно хватать. Китайская DeepSeek тоже обновила свою доступную для загрузки модель V3 до версии V3-0324, улучшив её способности в программировании и повысив точность выдаваемых ответов. На новеньком Mac Studio с процессором M3 Ultra (без дискретного видеоадаптера, отметим, зато с 512 Гбайт — и это не опечатка — разделяемой оперативной памяти) эта версия DeepSeek-V3 в 4-битовой кодировке исполняется со скоростью 20-22 токена в секунду, что вполне позволяет вести с ИИ живой динамичный диалог.

А если для локального исполнения генеративной модели персоналки за 10 тыс. долл. маловато, то российские заказчики — которым из-за санкций не слишком доступны специализированные ИИ-машины вроде NVIDIA DGX SuperPOD или Huawei Atlas 900 PoD — могут теперь обратить внимание на анонсированный отечественной компанией «Скала^р» программно-аппаратный комплекс МБД.ИИ, задействующий шину межсоединений NVLink с возможностью организовать совместную работу до восьми серверных графических ускорителей. По заявлению разработчика, гибкая унифицированная архитектура системы полностью соответствует отраслевым стандартам, что позволяет использовать её для развёртывания on-premises YandexGPT, GigaChat и иных ресурсоёмких генеративных моделей.

Пока что реальный интерфейс для цифровых мыслекоммуникаций выглядит довольно угрожающе (источник: Synchron)

Мартовская конференция Nvidia GTC 2025 запомнилась немалым количеством увлекательных анонсов, однако один из них, далеко не самый раскрученный, представляется с прикладной точки зрения едва ли не интереснее всех прочих. Речь идёт о малоинвазивном нейроинтерфейсе Synchron — который, в отличие от нашумевшего довольно давно Neuralink, не предполагает серьёзной операции на головном мозге для своего подключения. Доставлять поближе к моторной коре контактную группу в виде тонкой металлической сетки, уложенной в вытянутый пустотелый цилиндр, будут по ярёмной вене, далее сигналы пойдут на вшитый под кожу на груди пациента беспроводной передатчик — и затем нервные импульсы в этой области головного мозга окажутся доступны для считывания и интерпретации компьютерной системой. Собственно, испытания Synchron уже ведутся вовсю: в общей сложности 10 человек в мире благодаря этому нейроинтерфейсу имеют возможность управлять, к примеру, элементами умного дома — за счёт органичного сочетания с гарнитурой Apple Vision Pro и мультимодальной платформой обработки данных Nvidia Holoscan. По словам главы Synchron Томаса Оксли (Thomas Oxley), модель мозга, на основе которой действует интерфейс, создаётся с применением предварительного генеративного обучения непосредственно на информации, поступающей от нейронов: «В будущем наш интерфейс станет таким же распространённым, как установка [обычного] стента». Прежде всего такой малоинвазивный, но всё же непростой в установке и эксплуатации нейроинтерфейс пригодится людям с серьёзными нарушениями двигательного аппарата, а вот до знакомого уже многим по фантастическим романам и фильмам шлема виртуальной реальности, который достаточно просто надеть на голову для полного погружения в цифровую вселенную, ещё очень и очень далеко.