Обзор GeForce GTX 780 Ti: нет приема от титанового лома

Характеристики. Комплектация. Внешний вид

Выход Radeon R9 290 и R9 290X оставил рынок видеоадаптеров класса High-End совсем другим, нежели он был еще две недели тому назад. За все время с того момента, когда AMD представила Radeon HD 7970, а NVIDIA — GeForce GTX 680, которые после определенного периода притирки драйверов стали эквивалентными по производительности, ситуация развивалась довольно скучно. Перспективы перехода с техпроцесса 28 нм к следующему узлу — 20 нм — на фабрике TSMC, услугами которой пользуется дуумвират производителей дискретных GPU, лишь только обозначились в 2014 году. Как следствие, недавно мы стали свидетелями парада ребрендинга, когда под личиной видеокарт нового поколения выпускаются уже знакомые модели — с более или менее заметными нововведениями. Это и GeForce GTX 770, и недавно представленная линейка Radeon R7 260X — R9 280X от AMD.

(c) 2013 Theodore Gray periodictable.com

В принципе, перемаркировка старых SKU — не зазорное дело, коль скоро цены неуклонно идут вниз. Скажем, пресловутые Radeon R9 280X и GeForce GTX 770 сейчас стоят на добрых $200-250 меньше, чем их предшественники. Проблема в том, что по-настоящему новые и более производительные графические чипы, которым предназначена освободившаяся ценовая ниша в сегменте High-End, пришлось также выпустить, не дожидаясь заветного дня, когда TSMC запустит процесс фотолитографии по норме 20 нм.

Как для AMD, так и для NVIDIA нелегкой задачей стало впихнуть GPU, которые, согласно закону Мура, должны включать вдвое больше транзисторов, чем чипы, выпущенные двумя годами ранее, в те же самые круглые цветные пластины, произведенные по норме 28 нм. GeForce GTX TITAN на долгожданном чипе GK110 дал почувствовать вкус будущего только тем, кто был готов отдать за него круглую сумму в $1 000, и даже GeForce GTX 780, будучи «облегченной» разновидностью GTX TITAN, изначально не вписался в цену $499–549, стандартную для топовых дискретных видеоадаптеров, и установил новую планку в $650 (впрочем, теперь уже $499).

Radeon R9 290 и R9 290X на ядре Hawaii, которое по количеству транзисторов и площади кристалла сопоставимо с GK110, удалось сделать то, что требуется от флагманских видеоадаптеров нового поколения, — дать заметно более высокую производительность, чем их предшественники, на которых пользователь потратил такую же сумму в прошлый раз. У AMD другая проблема: R9 290 и R9 290X — беспрецедентно прожорливые (реальный TDP — не менее 280 Вт), а значит — довольно-таки горячие и шумные видеокарты.

Казалось бы, на этом можно закрыть тему дискретных видеоадаптеров класса High-End вплоть до грядущего перехода на техпроцесс 20 нм, который по меньшей мере позволит существующим большим ядрам от NVIDIA и AMD нарастить тактовые частоты. Но остался еще один компонент истории, который мы должны увидеть перед тем, как перевернуть страницу, — видеокарта на полностью функциональной версии процессора GK110.

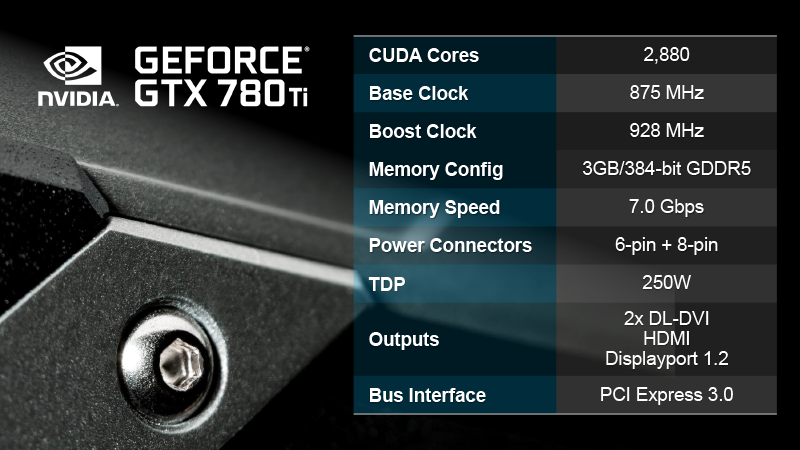

⇡#GeForce GTX 780 Ti: технические характеристики

Вот и он — GK110 во всей красе. Как таковой GPU нам уже знаком по GeForce GTX TITAN и GTX 780, которые получили версии этого кристалла с изрядно порезанным числом вычислительных блоков, а архитектуру Kepler в целом мы изучили на примере ядра GK104 в обзоре GeForce GTX 680. GeForce GTX 780 Ti, напротив, комплектуется полностью функциональным ядром. Что это возможно в принципе, уже показал пример профессиональной карты Quadro K6000.

В результате того, что в GeForce GTX 780 Ti вернулись три из пятнадцати крупных строительных блоков архитектуры Kepler — потоковых мультипроцессоров, новый флагман имеет на 20% большую производительность в части выполнения шейдерных инструкций и текстурирования.

Столь же важно и другое: NVIDIA перенесла на GTX 780 Ti эксклюзивное достижение GeForce GTX 770 — поддержку видеопамяти с частотой 7 ГГц, что способствует увеличению пропускной способности на 14 %.

Таким образом, GTX 780 Ti во всех отношениях превосходит не только GTX 780, но и GTX TITAN. Единственное достоинство TITAN по сравнению с новинкой (помимо 6 Гбайт памяти) — это разблокированные ядра CUDA двойной точности (FP64), количество которых с ядрами FP32 в GK110 соотносится как 1 к 3. Стало быть, TITAN может потенциально выполнять расчеты двойной точности в compute-приложениях на скорости 1/3 от FP32, а GeForce GTX 780 Ti ограничен унылой планкой 1/24.

| GTX 770 | GeForce GTX 780 | GeForce GTX TITAN | GeForce GTX 780 Ti | GeForce GTX 690 | |

|---|---|---|---|---|---|

| Основные компоненты | |||||

| GPU | GK104 | GK110 | GK110 | GK110 | GK104 |

| Число транзисторов | 3 540 млн | 7,1 млрд | 7,1 млрд | 7,1 млрд | 2x3540 млн |

| Техпроцесс, нм | 28 | 28 | 28 | 28 | 28 |

| Тактовая частота GPU, МГц: Base Clock / Boost Clock | 1046/1085 | 863/900 | 836/876 | 875/928 | 915/1019 |

| Потоковые процессоры | 1536 | 2304 | 2688 | 2880 | 2x1536 |

| Текстурные блоки | 128 | 192 | 224 | 240 | 2x128 |

| ROPs | 32 | 48 | 48 | 48 | 2x32 |

| Видеопамять: тип, объем, Мбайт | GDDR5, 2048 | GDDR5, 3072 | GDDR5, 6144 | GDDR5, 3072 | GDDR5, 2x2048 |

| Тактовая частота памяти: реальная (эффективная), МГц | 1753 (7010) | 1502 (6008) | 1502 (6008) | 1750 (7000) | 1502 (6008) |

| Разрядность шины памяти, бит | 256 | 384 | 384 | 384 | 2x256 |

| Интерфейс | PCI-Express 3.0 x16 | ||||

| Вывод изображения | |||||

| Интерфейсы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI 1.4a, 1 x DisplayPort 1.2 |

2 х DL DVI-I, 1 x DL DVI-D, 1 x Mini DisplayPort 1.2 |

|||

| Макс. разрешение | VGA: 2048x1536, DVI: 2560x1600, HDMI: 4096х2160, DP: 4096x2160 |

||||

| Макс. потребляемая мощность, Вт | 230 | 250 | 250 | 250 | 300 |

| Средняя розничная цена, руб. | Нет данных | Нет данных | Нет данных | Нет данных | Нет данных |

Ну а теперь сравним новинку с главным соперником — Radeon R9 290X. Примем в качестве исходных данных, что видеокарта AMD работает на частоте GPU 1000 МГц, а GTX 780 Ti — на своей средней Boost Clock (928 МГц). Это реалистичные условия, ведь для Radeon R9 290X при хорошем охлаждении вполне реально удержаться на частоте 1 ГГц без «троттлинга», да и Boost Clock графических процессоров NVIDIA вполне справедливо отражает среднюю частоту, на которой GPU работает под нагрузкой.

- В таком случаетеоретическая производительность шейдерного массива GTX 780 Ti ненамного, но все-таки ниже, чем у соперника: 5345 против 5632 FGLOPS (около 5%).

- Зато текстурных блоков в процессоре GTX 780 Ti куда больше — 240 против 176.Это означает, что фильтрация текстур — опять-таки с поправкой на разные частоты — на GK110 происходит на 21% быстрее, чем у AMD.

- Hawaii по-прежнему имеет на четверть больше ROP — 64 против 48, что наверняка скажется не в пользу видеокарты NVIDIA в тестах при высоком разрешении: мультимониторные конфигурации, 4К-дисплеи. Даже в 2560х1440 эффект в какой-то степени должен проявиться.

- NVIDIA и AMD разным способом увеличили пропускную способность видеопамяти: 512-битная шина и тактовая частота 5 ГГц у Radeon R9 290X либо 384 бита и 7 ГГц у GeForce GTX 780 Ti. По результирующей пропускной способности данные примерно одинаковые — с перевесом около 5% в пользу GTX 780 Ti (336 и 320 Гбайт/с соответственно).

- По части обработки геометрии на стороне GeForce GTX 780 Ti превосходит соперника с большим перевесом. Поскольку каждый из 15 потоковых мультипроцессоров (SMX) в составе чипа имеет свой блок Polymorph Engine, способный выдавать по одному полигону в течение двух тактов, совокупная производительность всего ядра GK110 составляет 7,5 геометрических примитивов за такт. У Radeon R9 290X — всего лишь четыре.

- AMD Radeon R9 290 и R9 290X умеют выполнять расчеты FP64 на скорости 1/8 от FP32. GeForce GTX 780 Ti, как отмечено выше, намеренно ограничен соотношением 1/24.

В сухом остатке преимущество полностью функционального GPU GK110 перед AMD Hawaii состоит в а) намного более высокой скорости выборки текстур (за счет 240 блоков фильтрации), которая, наряду с шейдерной производительностью, остается главным бутылочным горлышком GPU в современных играх; б) обработке геометрии, что, к примеру, важно в сценах, нагруженных тесселяцией. Сила Radeon R9 290X — в числе ROP (высокие разрешения и антиалиасинг методом SSAA, который нынче опять вошел в моду), а шейдерная производительность, по грубым оценкам, не хуже, чем у соперника. То есть, несмотря на то, что GK110 включает на миллиард больше транзисторов, чем Hawaii, избиения младенцев в бенчмарках все-таки не произойдет.

Остался только один вопрос, который мы обошли вниманием в обзорах Radeon R9 290 и R9 290X, — объем видеопамяти. AMD оснащает свои флагманы 4 Гбайт кадрового буфера, в то время как GeForce GTX 780 Ti довольствуется 3 Гбайт. Пока рано говорить о том, что такого объема недостаточно, но вот, к примеру, для Battlefield 4 3 Гбайт уже являются рекомендацией.

Как бы то ни было, цена, которую NVIDIA установила на GeForce GTX 780 Ti, говорит о том, что производитель полностью уверен в безоговорочном превосходстве своего детища над конкурентом от AMD. Выпустив базовую версию GeForce GTX 780 за $640, NVIDIA уже освоилась в пространстве выше привычной планки в $549 для топовых геймерских видеокарт, но GTX 780 Ti продвинулся еще дальше. Рекомендуемая розничная цена для рынка США составляет $699, что на $150 выше планки Radeon R9 290X. Для России рекомендована цена в 24 990 рублей. Впрочем, сколько-нибудь показательное сравнение цен по прайс-листам в российских интернет-магазинах будет возможным лишь после того, как на наш рынок потекут крупные поставки обеих новинок. К примеру, на момент написания статьи в Москве было только одно предложение Radeon R9 290X, да и то — почти за 25 тысяч. Так что пока для простоты и надежности продолжим мыслить в американских ценах.

Уделим немного внимания последней инициативе NVIDIA, которая не связана прямо с новым флагманским видеоадаптером, но интересна сама по себе. Известно, что зеленая компания с недавних пор ведет крестовый поход во имя плавного изображения. Именно NVIDIA представила методику FCAT, которая выявила нашумевшие проблемы AMD CrossFire с равномерностью времени подготовки кадров. Ранее для всех видеокарт на архитектуре Kepler было представлено любопытное решение – Adaptive V-Sync, которое просто-напросто включает вертикальную синхронизацию, если частота смены кадров в буфере видеокарты не меньше 60, и отключает, если фреймрейт падает ниже. G-SYNC является еще одним оригинальным подходом к вертикальной синхронизации, который на этот раз требует в определенных моментах переделать сам протокол коммуникации GPU и монитора.

Но для начала обозначим проблему, которую призвана решить вертикальная синхронизация как таковая, и почему большинство геймеров привыкли ее игнорировать либо считать каким-то неизбежным недостатком компьютерной графики – разрывы экрана.

Такое возникает, когда монитор считывает изображение из кадрового буфера, одновременно с чем GPU заканчивает рендеринг следующего кадра и буферы (которых на самом деле два) меняются местами. В результате та часть строк на экране, которую монитор начал «рисовать» после смены буферов, принадлежит уже другому кадру. Осюда и разрыв, который, по логике, может быть и множественным, если разница между частотой смены кадров и частотой обновления экрана достаточно велика.

Суть вертикальной синхронизации в том, что смена буферов запрещается до того момента, когда монитор завершит цикл обновления картинки. Как следствие, в то время, когда выводится на экран содержимое одного буфера (называемого Front Buffer), в другой буфер (Back Buffer) может быть записан только один следующий кадр. В то же время в системе без V-Sync, при условии, что GPU имеет большой запас производительности, буферы могли поменяться местами несколько раз, что привело бы к пресловутому разрыву, зато задержка ввода (input lag) была бы меньше. Но это меньшая из двух издержек вертикальной синхронизации, которую с лихвой перекрывает другой эффект.

Монитор запрашивает кадр из памяти графического адаптера с регулярной частотой (допустим, 60 Гц). Представим идеальную ситуацию, когда GPU также рендерит кадры с частотой 60 FPS. Тогда каждый из отрисованных кадров демонстрируется на мониторе один раз. Но стоит одному кадру хоть немного опоздать к очередному циклу обновления монитора, и вот уже предшествующий кадр пользователь увидел дважды, что воспринимается как микроторможение (и одновременно – задержка ввода). В реальных же играх, когда частота смены кадров колеблется, такое событие происходит гораздо чаще, а долговременная падение ниже 60 FPS приводит к тому, что фактическая частота смены кадров на экране составляет 30 FPS, иследующий шаг – 15 FPS. По этой причине большинство геймеров брезгует V-Sync, смирившись с мерзкими разрывами.

G-SYNC представляет собой абсолютно радикальное решение – заставить монитор обновлять экран с произвольным интервалом путем модификации протокола DisplayPort. Тогда, если следующий кадр еще не готов, но вот-вот рендеринг завершится, то монитор сможет в определенных пределах задержать цикл обновления вместо того, чтобы продублировать предшествующий кадр.

Для поддержки G-SYNC в монитор нужно установить специальный модуль, который несет на плате некий чип с логикой и три микросхемы DRAM общей емкостью 768 Мбайт. Пока что разъем под такой модуль есть лишь в одной модели – ASUS VG248QE, а саму плату NVIDIA начнет продавать до конца этого года. После рождества станут доступны варианты ASUS VG248QE с предустановленным модулем и некоторое количество мониторов от других производителей, поддерживающих G-SYNC нативно.

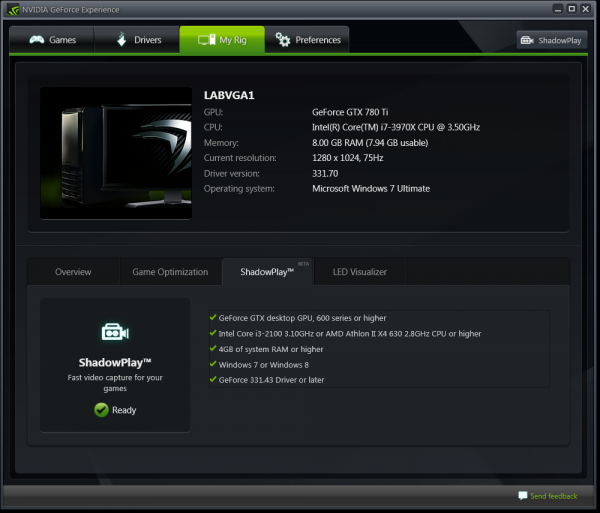

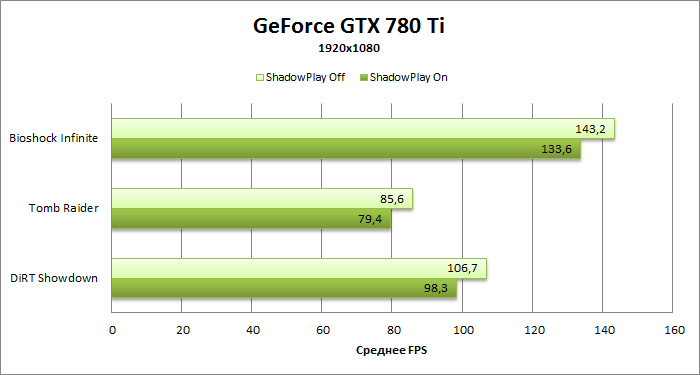

Незадолго до запуска GeForce GTX 780 Ti в статус работающей бета-версии вошла еще одна из эксклюзивных технологий NVIDIA, с помощью которых компания стремится дифференцировать свои продукты от конкурирующих предложений. ShadowPlay использует возможности встроенного в GPU семейства Kepler кодировщика H.264 (NVENC) для записи видеоряда из игр. У ShadowPlay есть две функции – во-первых, запись ролика по требованию, как это делается при помощи FRAPS или других чисто программных решений. А во вторых, ShadowPlay может просто непрерывно захватывать в фоновом режиме и удерживать в памяти последние 20 минут игрового процесса, которые по нажатию горячей клавиши сохраняются в файл-контейнер MP4.

Доступ к настройкам ShadowPlay открывается через утилиту GeForce Experience, которая уже является частью пакета драйверов для графических карт NVIDIA. Меню содержит настройку качества, которая задает битрейт будущего видеоролика. Доступны варианты 16, 23 или 52 Мбит/с. Видео пока что записывается только в одном разрешении – 1080p — и с частотой 60 кадров в секунду. Независимо от того, в каком разрешении на самом деле идет игра, итоговый продукт будет отмасштабирован до этих параметров. Надеемся, что в финальной версии ShadowPlay появится выбор разрешений, по меньшей мере, ниже, чем 1080p, а еще лучше – вплоть до 2560х1600 без масштабирования. Но пока что есть, то есть.

Вся соль идеи ShadowPlay в том, что работа утилиты одновременно с игрой мало влияет на игровую производительность. Отчасти это заслуга аппаратного кодировщика H.264, но есть и другая причина: «железо» Kepler предоставляет возможность напрямую считывать содержимое кадрового буфера, которая в первую очередь была нужна NVIDIA для потоковой трансляции игр в облачной платформе GeForce GRID, но в результате нашла и вот такое вполне локальное применение. Впрочем, нельзя сказать, что постоянная фоновая запись видео в буфер при включенной ShadowPlay дается полностью бесплатно.

В трех играх из нашей тестовой обоймы при захвате изображения с максимальным битрейтом частота смены кадров снижается на 7-8% от исходного уровня. И все же это сущие пустяки по сравнению с тем, что происходит при записи игрового процесса чисто программными методами, не говоря уже о молниеносном расходе места в ПЗУ, когда продукт сохраняется в «сыром» формате. В целом использование для этой цели кодировщика, которым сегодня обладают все дискретные GPU, выглядит настолькой очевидной и простой идеей, что возникает вопрос, почему какое-либо подобие ShadowPlay не возникло еще гораздо раньше.

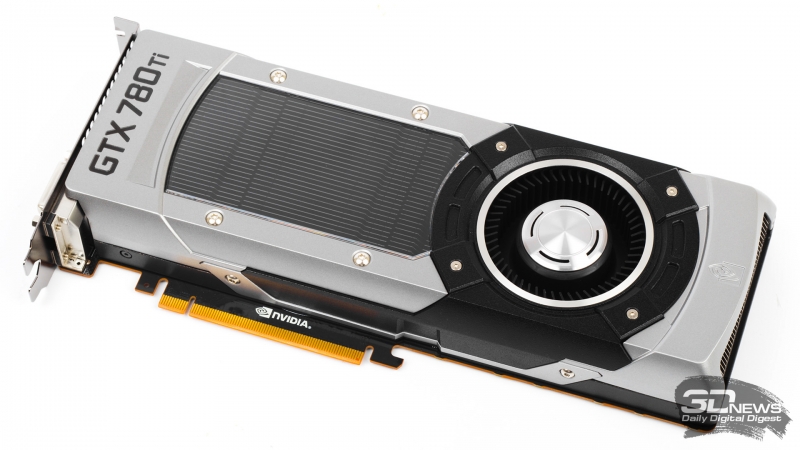

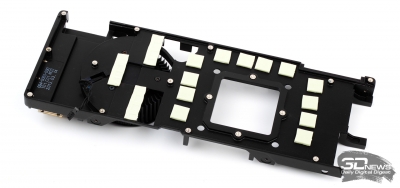

Система охлаждения GeForce GTX 780 Ti в общих чертах не отличается от тех конструкций, которые установлены на базовую версию GTX 780 и GTX TITAN. Отсутствие изменений в данном случае полностью оправданно, ведь этот кулера представляет собой практически эталонный образчик «турбинки» (или blower’а) – высокоэффективной и в то же время тихой. Ну и, помимо практических достоинств, увесистую видеокарту в цельнометаллическом кожухе просто приятно взять в руки.

На торце корпуса, где расположены разъемы SLI, вырезан логотип GeForce GTX, подсвеченный яркой зеленью.

Впрочем, по одному признаку кулер GeForce GTX 780 Ti отличается от предшествующих реализаций: радиатор GPU, видимый через пластиковое оконце, покрашен в вороной цвет, за счет чего устройство выглядит более строго.

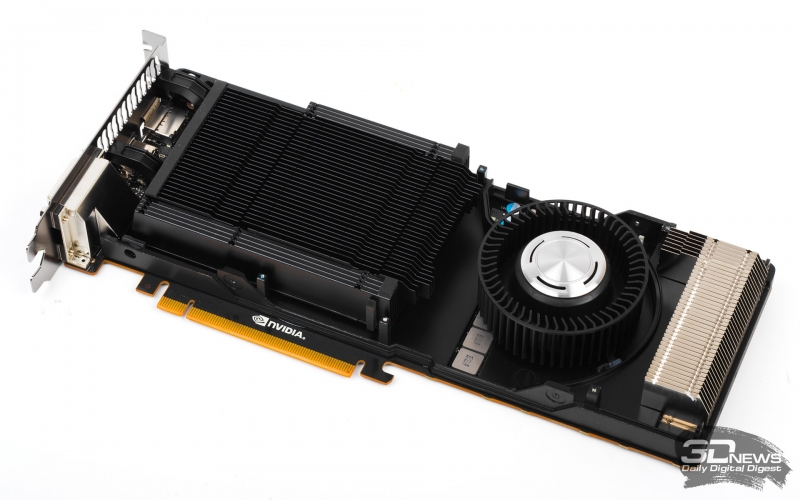

Кстати, этот радиатор более компактный по сравнению с тем, что мы недавно увидели в составе Radeon R9 290/290X, но так же имеет в основании испарительную камеру. Радиатором для микросхем памяти и MOSFET’ов системы питания служит массивная металлическая рама из литого алюминия.

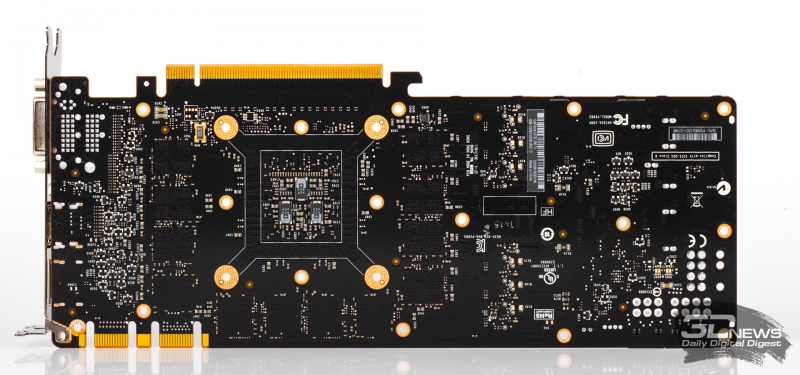

Дизайн планки с разъемами остался прежним. Решетка «выхлопа» системы охлаждения делит пространство одного слота с неуклюжим портом DVI-D. Помимо него, плата несет выходы DVI-I, полноразмерные версии HDMI и DisplayPort.

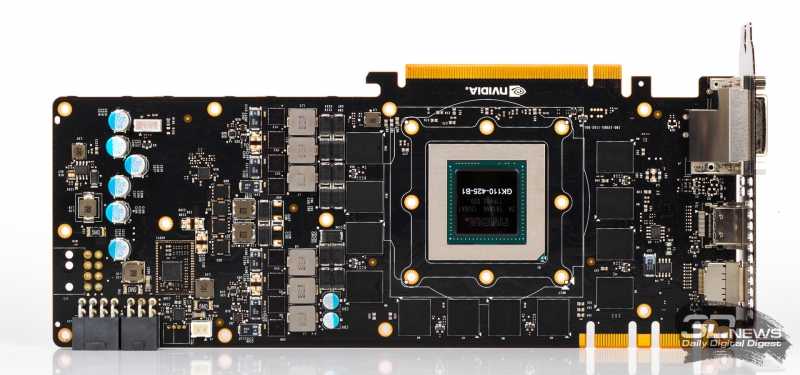

Графический процессор GK100, распаянный на плате GeForce GTX 780 Ti, не только является полностью разблокированным чипом, но и принадлежит к версии «кремния» B1, в которой производитель исправил некоторые мелкие ошибки и чуть-чуть уменьшил утечки тока.

Спецификациям карты соответствуют микросхемы памяти SK Hynix с маркировкой H5GQ2H24AFR-R2C, которые выдают штатную эффективную частоту 7 ГГц. Чипы сосредоточены только на лицевой поверхности PCB, но сзади платы в зеркальных позициях размечены площадки под второй массив микросхем.

Сама печатная плата на первый взгляд точно такая же, как и у GeForce GTX TITAN и GTX 780, но все же и здесь есть некоторые отличия. NVIDIA поменяла часть элементов в системе питания на другие аналоги – наверняка не спроста. В целом видеоадаптер по-прежнему обслуживается по схеме 6+2+1 (число фаз для GPU, чипов памяти и PLL). Напряжением на процессоре управляет все тот же ШИМ-контроллер ON Semiconductor NCP 4206.

NVIDIA также сообщила о новой функции системы питания GTX 780 Ti, незаметной при визуальном осмотре платы, – балансировке тока на трех источниках, коими являются шести- и восьмиконтактный разъемы дополнительного питания вместе со слотом PCI-Express. Задача дополнительной автоматики – следить, чтобы при разгоне не возникала такая ситуация, когда одна из шин питания нагружена по максимуму, а другие две «отдыхают».

Тестирование. Выводы

| Конфигурация тестовых стендов | ||

|---|---|---|

| CPU | Intel Core i7-3960X @ 4,6 ГГц (100x46) | Intel Core i7-3970X @ 4,6 ГГц (100x46) |

| Материнская плата | ASUS P9X79 Pro | |

| Оперативная память | DDR3 Kingston HyperX 4x2 Гбайт @ 1600 МГц, 9-9-9 | |

| ПЗУ | Intel SSD 520 240 Гбайт | |

| Блок питания | Corsair AX1200i, 1200 Вт | Seasonic Platinum-1000, 1000 Вт |

| Охлаждение CPU | Thermalright Archon | |

| Корпус | CoolerMaster Test Bench V1.0 | |

| Операционная система | Windows 7 Ultimate X64 Service Pack 1 | |

| ПО для карт AMD | AMD Catalyst 13.11 Beta v8 (для Radeon R9 290); v5 (для остальных) + Catalyst Application Profiles 13.5 CAP1 |

|

| ПО для карт NVIDIA | 331.70 (для GeForce GTX 780) 331.58 WHQL (для остальных) |

|

Для измерения мощности системы используется стенд с блоком питания Corsair AX1200i. Энергосберегающие технологии CPU во всех тестах отключены. Шина PCI-Express работает в режиме 3.0. Для активации PCI-E 3.0 на видеокартах серий GeForce 600 и 700 в системе на чипсете X79 применяется патч от NVIDIA.

В настройках драйвера NVIDIA всегда в качестве процессора для вычисления PhysX выбирается CPU. В настройках AMD всегда настройка Tesselation переводится из состояния AMD Optimized в Use application settings.

| Набор бенчмарков | ||||

|---|---|---|---|---|

| Программа | API | Настройки | Анизотропная фильтрация, полноэкранное сглаживание | Разрешение |

| 3DMark 2011 | DirectX 11 | Профиль Extreme | - | - |

| 3DMark | DirectX 11 | Тест Fire Strike (не Extreme) | - | - |

| Unigine Heaven 2 | DirectX 11 | DirectX 11, макс. качество, тесселяция в режиме Extreme | AF 16x, MSAA 4x | 1920х1080 / 2560х1440 |

| Crysis Warhead + Framebuffer Crysis Warhead Benchmarking Tool | DirectX 10 | DirectX 10, макс. качество. Демо Frost Flythrough | AF 16x, MSAA 4x | 1920х1080 / 2560х1440 |

| Battlefield 3 + FRAPS | DirectX 11 | Макс. качество. Начало миссии Going Hunting | AF 16x, MSAA 4x + FXAA | 1920х1080 / 2560х1440 |

| Batman: Arkham City. Встроенный бенчмарк | DirectX 11 | Макс. качество | AF, MSAA 4x | 1920х1080 / 2560х1440 |

| DiRT Showdown . Встроенный бенчмарк | DirectX 11 | Макс. качество, Global Illumination вкл. Трасса Shibuya, 8 машин | AF, AA 4х | 1920х1080 / 2560х1440 |

| Far Cry 3 + FRAPS | DirectX 11 | DirectX 11, макс. качество, HDAO. Начало миссии Secure the Outpost | AF, MSAA 4x | 1920х1080 / 2560х1440 |

| Tomb Raider. Встроенный бенчмарк | DirectX 11 | Макс. качество | AF 16x, SSAA 4x | 1920х1080 / 2560х1440 |

| Bioshock Infinite. Встроенный бенчмарк | DirectX 11 | Макс. качество. Postprocessing: normal | AF 16x, FXAA | 1920х1080 / 2560х1440 |

| Crysis 3 + FRAPS | DirectX 11 | Макс. качество. Начало миссии Post Human | AF 16x, MSAA 4x | 1920х1080 / 2560х1440 |

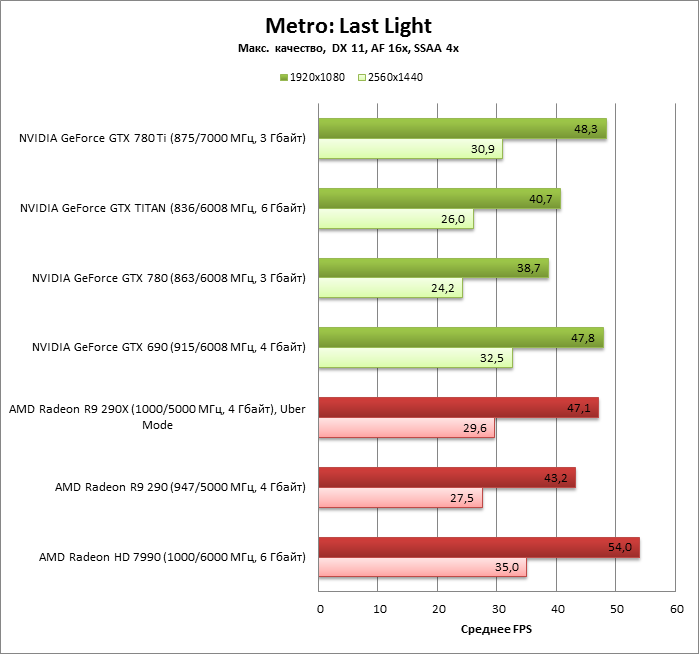

| Metro: Last Light. Встроенный бенчмарк | DirectX 11 | Макс. качество | AF 16x, SSAA 4x | 1920х1080 / 2560х1440 |

В тестировании производительности приняли участие следующие видеокарты:

- AMD Radeon R9 290 (947/5000 МГц, 4 Гбайт)

- AMD Radeon R9 290X (1000/5000 МГц, 4 Гбайт)

- AMD Radeon HD 7990 (1000/6000 МГц, 6 Гбайт)

- NVIDIA GeForce GTX 690 (915/6008 МГц, 4 Гбайт)

- NVIDIA GeForce GTX TITAN (836/6008 МГц, 6 Гбайт)

- NVIDIA GeForce GTX 780 (863/6008 МГц, 3 Гбайт)

⇡#Разгон, температура, энергопотребление

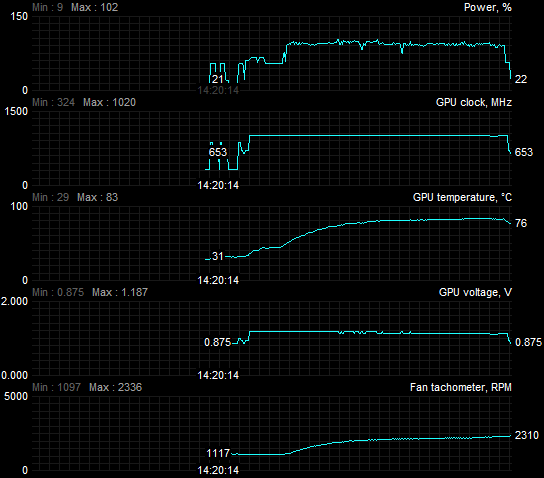

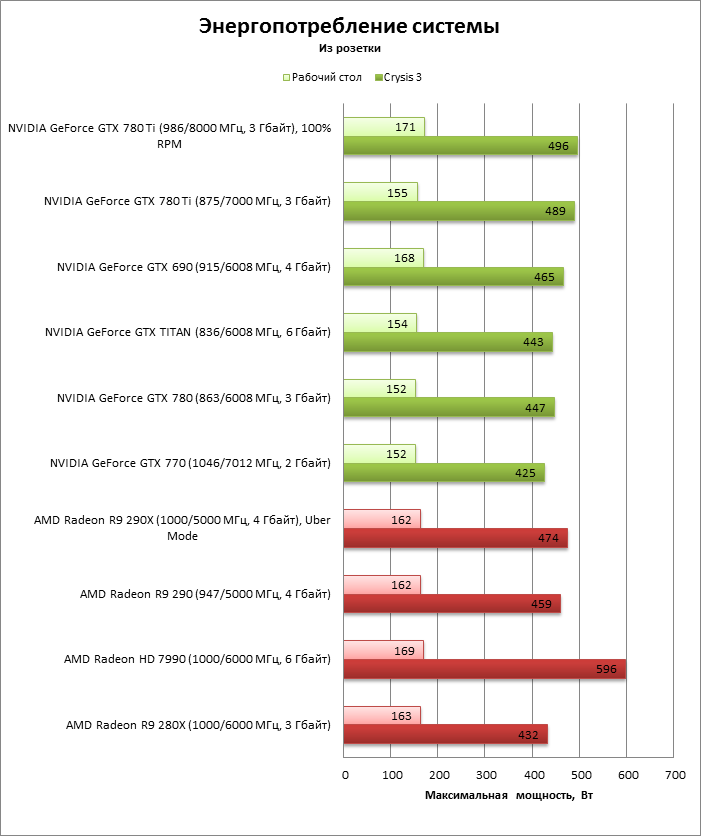

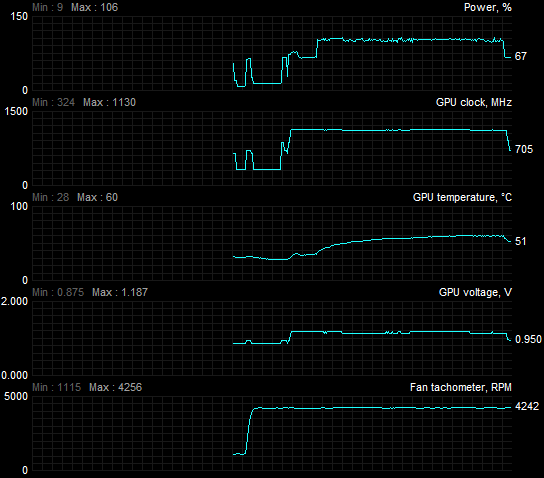

В штатном режиме GeForce GTX 780 Ti удерживает достаточно высокие тактовые частоты под нагрузкой. Во время тестового прогона Crysis 3 GPU работал на частоте 1006—1020 МГц (ненамного больше, чем у GTX 780 и GTX TITAN) с редкими проседаниями до 993 МГц. При этом максимальное напряжение на GPU составляло 1,187 В, в то время как GTX 780 и GTX TITAN довольствуются 1,162 В.

Если сравнивать GTX 780 Ti с Radeon R9 290X, то выходит, что обе видеокарты (при условии, что R9 290X работает в Uber Mode с более высокой скоростью вращения вентилятора) под нагрузкой стабильно держат частоту в районе 1 ГГц.

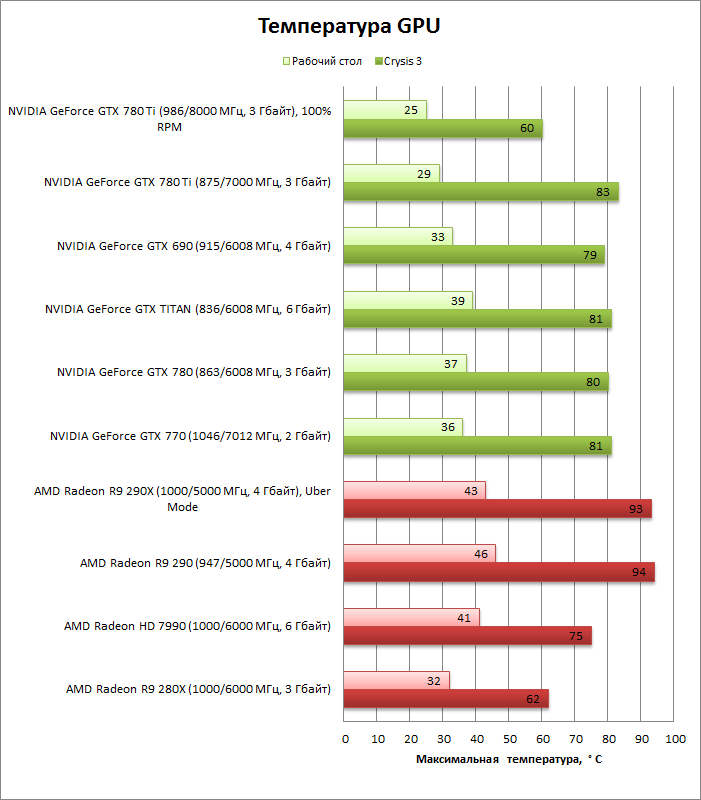

Вот только процессор GK110 при этом сохраняет температуру в пределах 83 °C и турбинка его системы охлаждения раскручивается до 2336 об/мин, а Hawaii разогревается до 93 °C, в то время как кулер вращается на скорости 2727 об/мин.

Штатный режим

Забавно, но, если судить по тесту в Crysis 3, GeForce GTX 780 Ti в пиковом энергопотреблении немного превосходит Radeon R9 290X, да и системы охлаждения у соперников на вид одинаковы по мощности, но R9 290X явно испытывает трудности с теплоотводом. Возможно, причина в разной площади кристаллов GK110 и Hawaii: у первого — 533 мм2, а у второго — 455 мм2, отсюда и разная плотность теплового потока.

Кроме того, нельзя не отметить, что система охлаждения GTX 780 Ti хороша не только изысканным дизайном и светящейся надписью, но и отличными акустическими характеристиками. Даже при скорости 4261 об/мин, что является максимумом для крыльчатки, шум нельзя сравнить с ревом штатного охладителя Radeon R9 290X на таких же оборотах. Кроме того, спектр шума у NVIDIA более мягкий и приятный слуху.

По оверклокерским возможностям GeForce GTX 780 Ti уступает «ванильной» разновидности GTX 780, что вполне ожидаемо, если учесть дополнительное тепловыделение от трех ранее дремавших SMX и повышенное напряжение на GPU. К тому же у нового флагмана мизерный запас по TDP — его можно увеличить лишь на 6%. На всякий случай включив вентилятор на полные обороты, чтобы температура не влияла на динамику частоты, и отдав приоритет температуре в EVGA Precision, мы смогли увеличить базовую частоту до 986 МГц, а максимальное зарегистрированное значение выросло до 1130 МГц. Частота под нагрузкой достаточно стабильна — в ходе теста в Crysis 3 она не опускалась ниже 1111 МГц.

Разгон

Если судить по состоянию индикаторов Power/Voltage/OV/Utilization Limit, которыми NVIDIA снабдила видеокарты с технологией GPU Boost 2.0, препятствием на пути разгона видеокарты становится лимит энергопотребления и одновременно — напряжение питания GPU. Попытки покрутить опцию Overvoltage попросту ни к чему не привели: заданного подъема напряжения на 75 мВ на графиках не зарегистрировано.

| Base Clock, МГц | Макс. Boost Clock, МГц | Base Clock, МГц (разгон) | Макс. зарегистрированная Boost Clock, МГц (разгон) | |

|---|---|---|---|---|

| GeForce GTX 780 Ti | 876 | 1020 (+144) | 986 | 1130 (+144) |

| GeForce GTX TITAN | 836 | 1006 (+145) | 966 | 1150 (+184) |

| GeForce GTX 780 | 863 | 1006 (+143) | 1053 | 1215 (+162) |

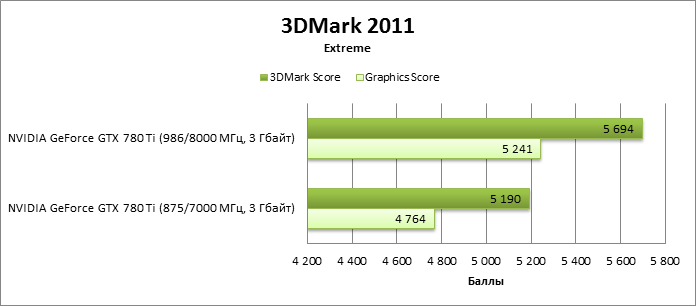

Производительность: синтетические тесты

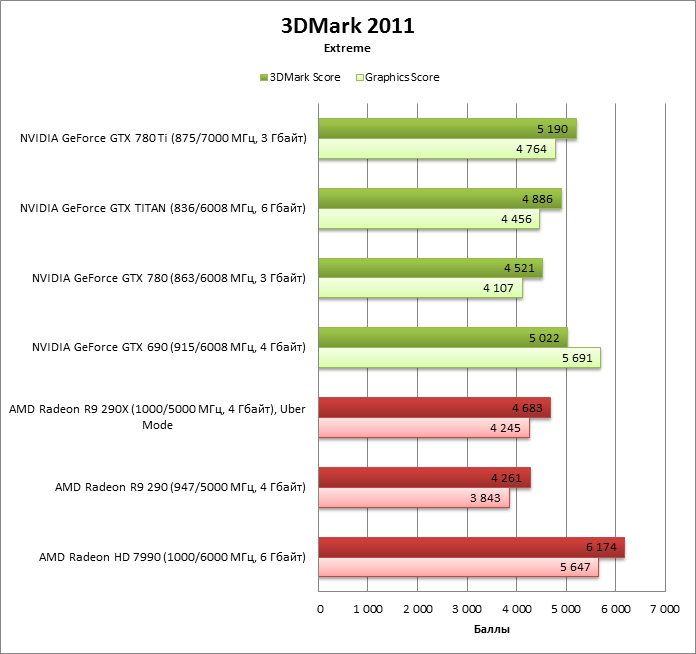

3DMark 2011

- В этом тесте GeForce GTX 780 Ti предсказуемо быстрее всех однопроцессорных видеокарт, а по параметру 3DMark Score даже превосходит GeForce GTX 690.

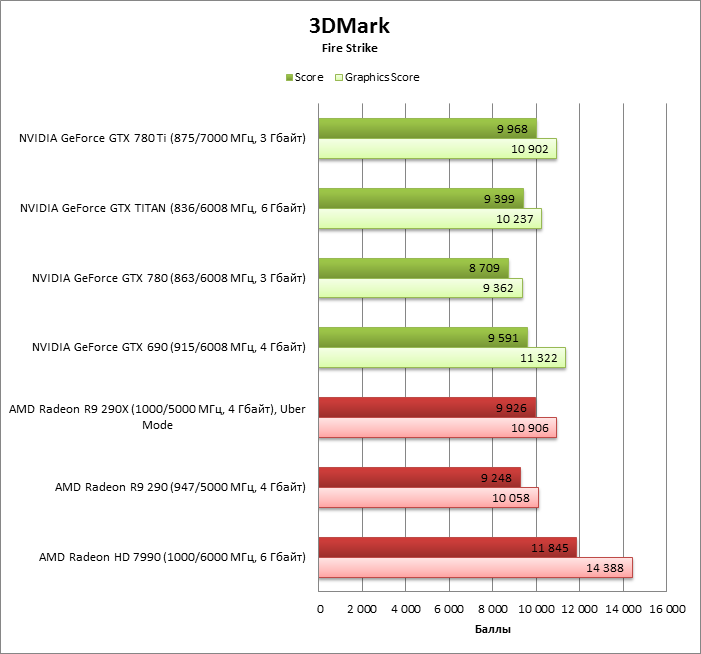

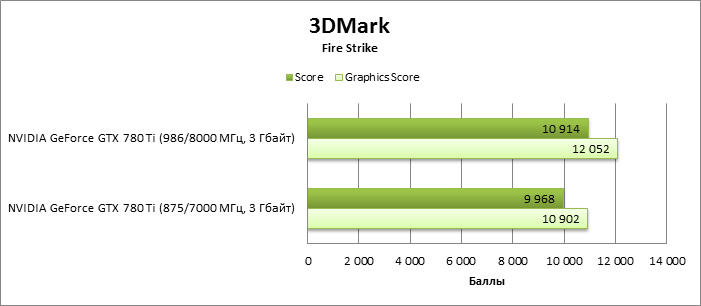

3DMark

- А вот в более свежей версии бенчмарка результаты GeForce GTX 780 Ti поразительно точно совпадают с тем, чего достиг Radeon R9 290X.

- И вновь GTX 780 Ti набрал больший итоговый балл, чем у GTX 690.

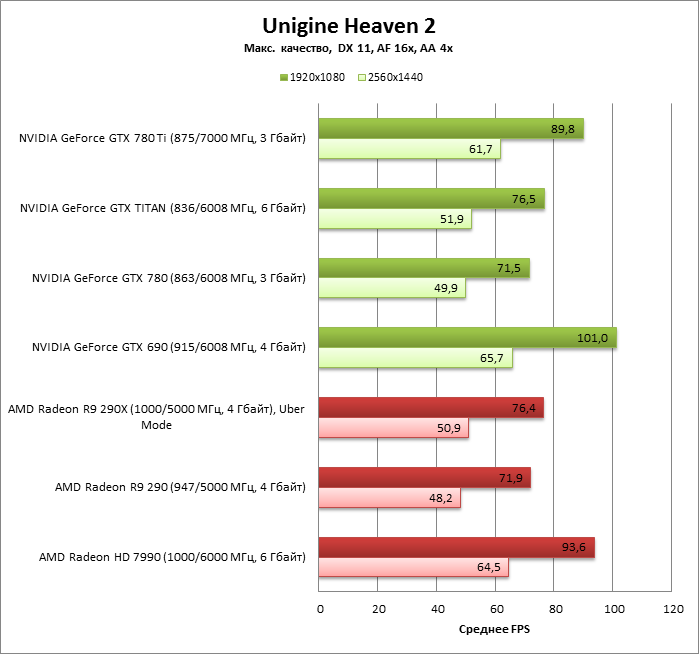

Unigine Heaven 2

- GTX 780 Ti наступает на пятки обеим видеокартам на базе двух GPU.

- Разница между GTX 780 Ti и Radeon R9 290X весьма велика. Спасибо быстрой обработке геометрии, которая, как ничто иное, важна в этом тесте, богатом аппаратной тессляцией.

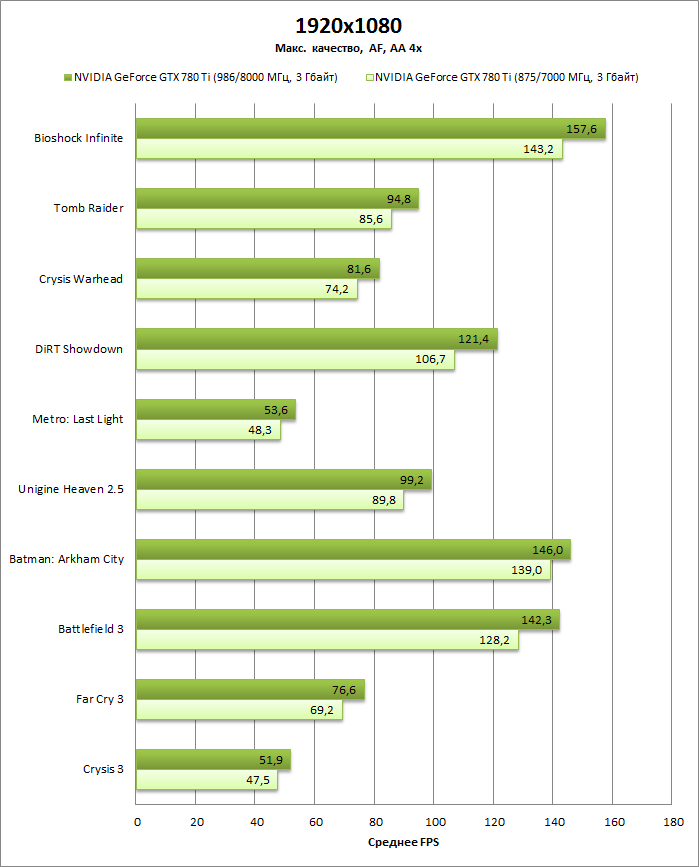

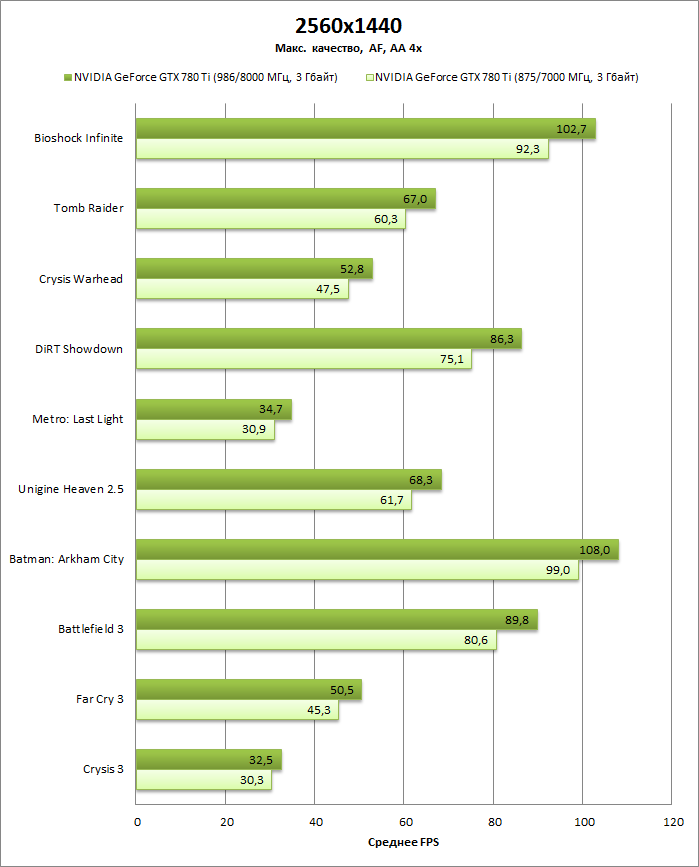

⇡#Производительность: игровые тесты

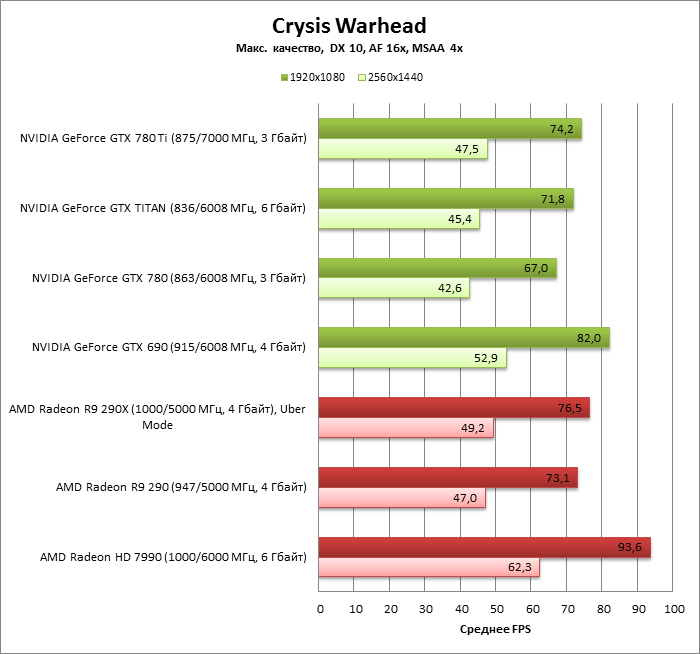

Crysis Warhead

- Превосходство GTX 780 Ti над предыдущими видеокартами с чипом GK110 не столь выражено, как в других тестах.

- GTX 780 Ti немного, но все же медленнее, чем Radeon R9 290X.

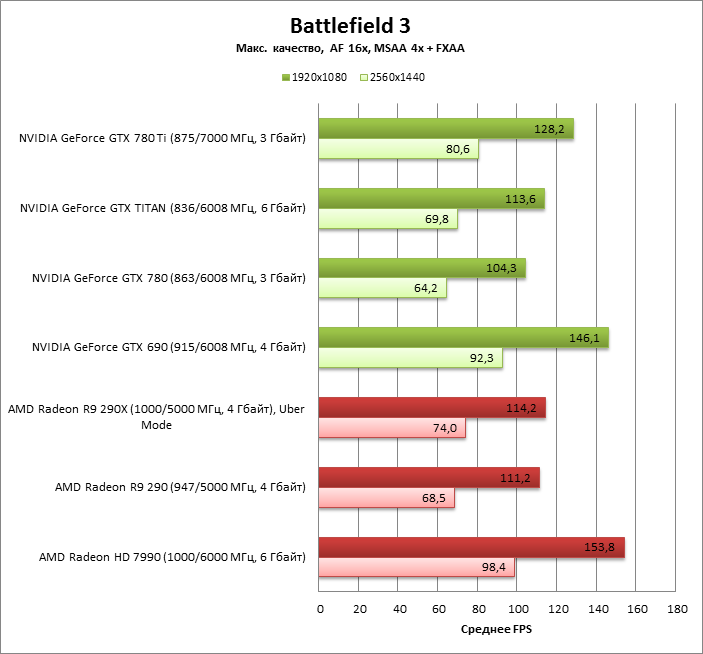

Battlefield 3

- Здесь GTX 780 Ti в очередной раз уверенно превосходит R9 290X.

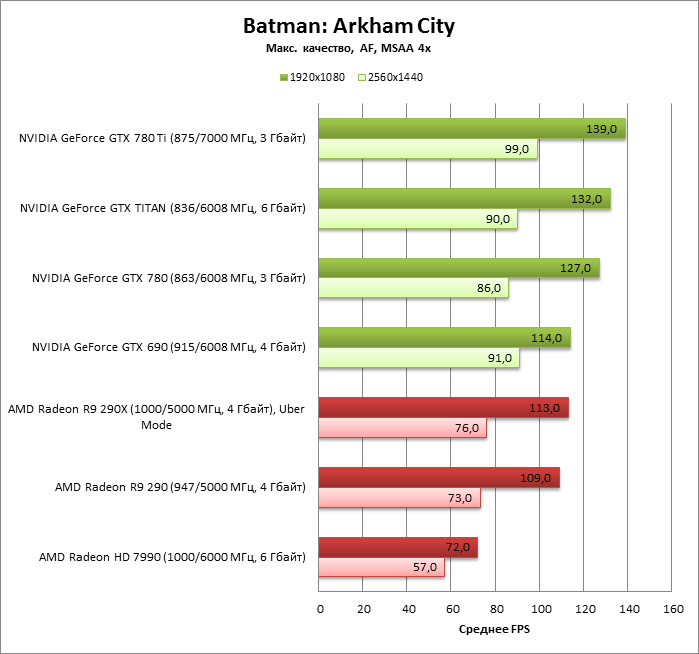

Batman: Arkham City

- GTX 780 Ti – король этого бенчмарка. Ему удалось заткнуть за пояс не только Radeon R9 290X, но и «двухголовый» GeForce GTX 690.

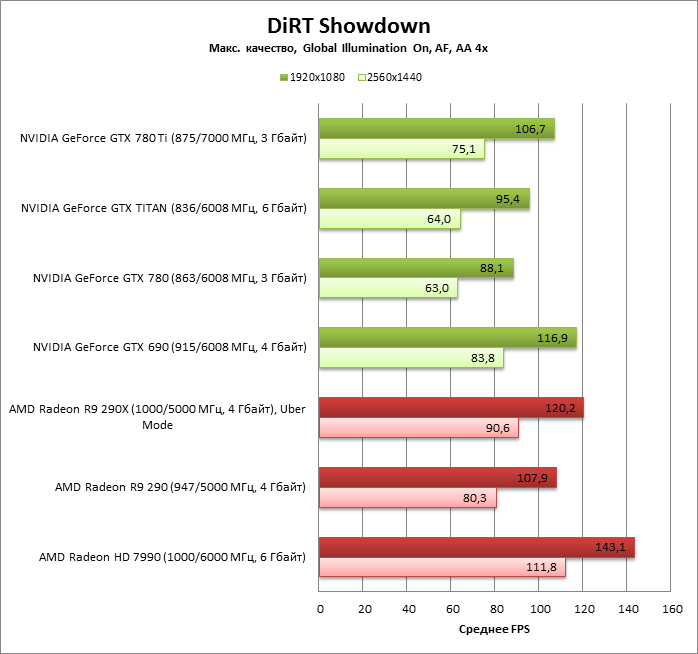

DiRT Showdown

- Преимущество опять перешло на сторону Radeon R9 290X.

- Впрочем, внутри команды NVIDIA на платформе GK110 новый флагман существенно превосходит «обычный» GeForce GTX 780.

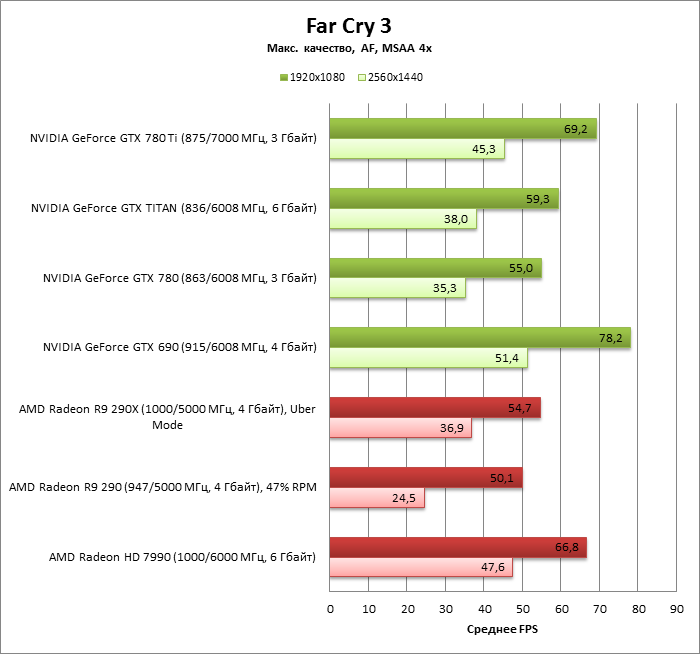

Far Cry 3

- Far Cry 3 – одна из тех игр, где разница между GeForce GTX 780 Ti и Radeon R9 290X наиболее велика (в пользу NVIDIA).

- Более того, GTX 780 Ti отработал практически не хуже, чем Radeon HD 7990.

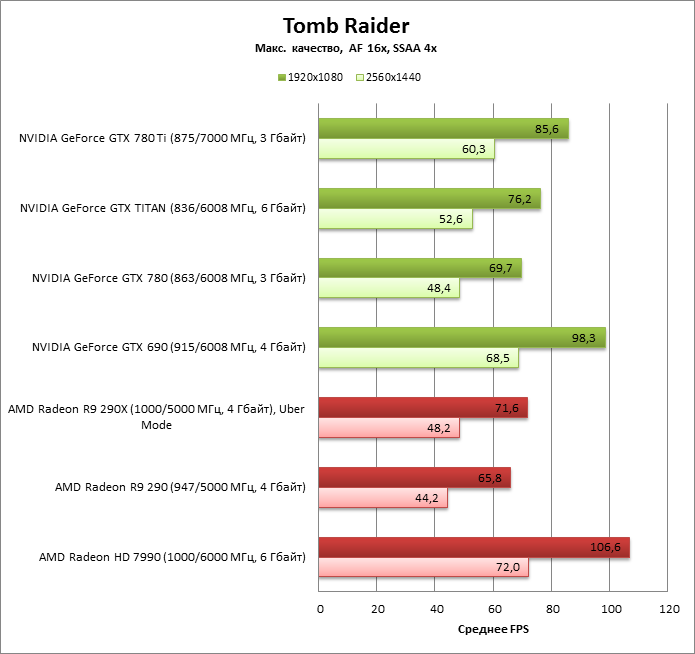

Tomb Raider

- Еще одно разгромное поражение для Radeon R9 290X.

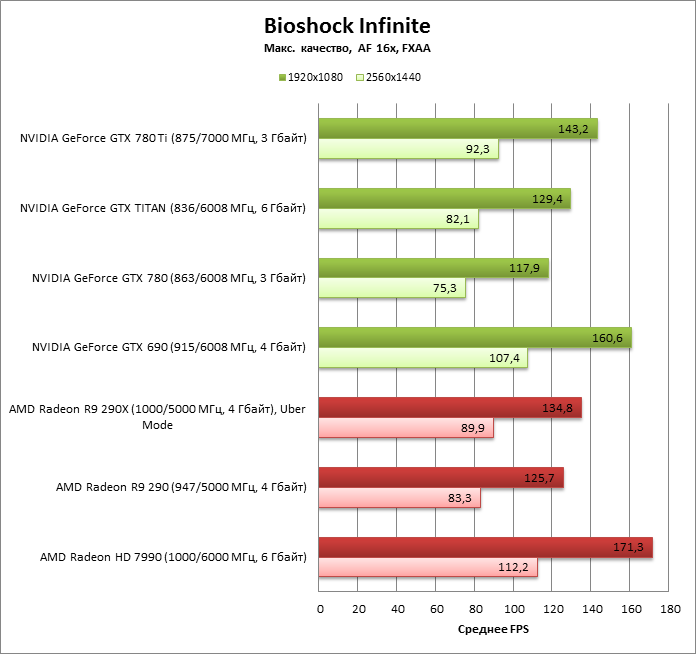

Bioshock Infinite

- Здесь GTX 780 Ti все еще впереди по отношению к R9 290X, хотя разница уже менее выражена.

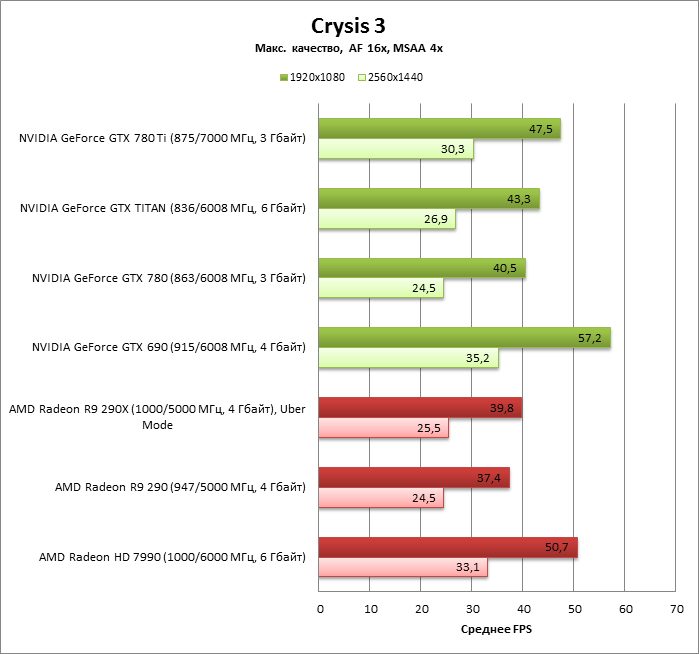

Crysis 3

- Из двух видеокарт – GeForce GTX 780 Ti и Radeon R9 290X — первый быстрее, и намного.

- Фактически GTX 780 Ti подбирается к позициям Radeon HD 7990.

Metro: Last Light

- Radeon R9 290X держится уверенно, уступая сопернику не более 1 FPS.

- Сам GeForce GTX 780 Ti практически равен GeForce GTX 690.

Оверклокинг GeForce GTX 780 Ti ощутимо влияет на очки в синтетических тестах 3DMark, но в играх повышение частоты большого значения не имеет. Как ни крути, а разгон GPU NVIDIA с технологией GPU Boost – не очень плодотворное занятие. Тем более что GTX 780 Ti сильно ограничен рамками TDP и не дает возможности повысить напряжение питания, как следствие – повышение частоты было не таким большим, как в случае с GeForce GTX 780 в базовой версии.

3DMark 2011

3DMark

⇡#Игровые тесты + Unigine Heaven 2

В диапазоне цен от $400 до $550, который обычно занимают игровые видеокарты для энтузиастов, AMD сегодня сильна как никогда. Фактически впервые в истории противостояния двух главных производителей дискретных GPU видеоадаптеры AMD не только не уступают конкурентам равной стоимости, которые предлагает NVIDIA, но даже заметно превосходят их по производительности. Но у NVIDIA в запасе было секретное оружие — полностью разблокированный графический процессор GK110. Пускай GeForce GTX 780 невозможно сделать настолько дешевым, чтобы он мог предоставить такую же производительность по цене $400 (сколько стоит Radeon R9 290), зато «зеленые» в состоянии создать видеокарту, гораздо более дорогую, чем Radeon R9 290X, но при этом она безоговорочно превосходит последнего по производительности.

Просто у GK110 изначально был запас масштабирования вплоть до тех высот, которые продемонстрировал сегодня GeForce GTX 780 Ti, а GPU Hawaii в составе Radeon R9 290X уже полностью проявил свой потенциал. Во-первых, конечно же, GK110 включает на миллиард больше транзисторов по сравнению с Hawaii. Но, что не менее важно, NVIDIA по-другому распорядилась этим бюджетом. AMD вложилась в большое количество ROP, что делает R9 290X более приспособленным к играм в 4K-разрешении, но NVIDIA сделала акцент на блоках фильтрации текстур. Преимущество в обработке геометрии также вновь на стороне топового GPU NVIDIA. Как показывают тесты, в разрешении вплоть до 2560х1440 последние параметры все еще более важны, чем скорость заполнения пикселов.

Любопытно, что GTX 780 Ti и Radeon R9 290X очень близки по тактовым частотам GPU и, судя по всему, обладают примерно одинаковым энергопотреблением (как минимум 280-290 Вт), что само по себе говорит в пользу NVIDIA, ибо GK110 — более сложный и высокопроизводительный чип, чем Hawaii. Но при всем этом видеокарта NVIDIA еще и нагревается меньше. Нельзя не похвалить референсный кулер, который GTX 780 Ti унаследовал от своих предшественников, но дело явно не только в системе охлаждения. Похоже, что GK110 сам по себе более эффективно отдает тепло.

Впрочем, если судить с чисто практических позиций, то GeForce GTX 780 Ti и Radeon R9 290X не являются прямыми конкурентами в силу разницы по ценам в $150. Новый флагман NVIDIA, как и базовая версия GTX 780 ранее, оказался единственным представителем собственной ценовой категории для энтузиастов, которые готовы отдать дополнительные деньги сверх привычных $500-550, составляющих цену видеокарты класса High-End. В таком качестве ему вряд ли появится альтернатива вплоть до того, как производство GPU освоит техпроцесс 20 нм.

Напоследок замолвим слово о GeForce GTX TITAN, которая до сего момента считалась самой производительной однопроцессорной видеокартой NVIDIA. После выхода GeForce GTX 780 Ti ее продолжат продавать, и даже о снижении цены не было никаких официальных заявлений. По всей видимости, TITAN по-прежнему будет стоит $1 000, но теперь его преподносят как «просьюмерский» видеоадаптер с возможностью выполнять неграфические вычисления двойной точности на скорости 1/3 от FP32. По сути, некий аналог Quadro K6000 для не-профи. Ценность TITAN как игровой видеокарты после выхода GeForce GTX 780 Ti уже окончательно уничтожена.