Ты помнишь, как все начиналось?

Мобильные телефоны

1997 год. 80 лет Октябрьской революции и всего 6 лет после распада Советского Союза. Закат эпохи малиновых пиджаков: мобильный телефон в России уже постепенно переходит от статусного элемента к настоящему средству связи, но до реального бума еще несколько лет. В мире активно развиваются КПК, и в продаже уже есть первый «настоящий» коммуникатор, впервые доступен телефон с цветным экраном, но камеры в нем еще нет. Мысль о том, что через 20 лет телефон, как швейцарский нож, заменит собой всю портативную технику разом, кажется еще дикой. И, оглядываясь назад, действительно понимаешь, что для предвидения этого надо было обладать серьезным даром предсказания.

Сама концепция говорить друг с другом, не будучи привязанным к месту (домашним аппаратам или телефонным будкам), уже не кажется утопической – очевидно, что в скором времени сотовая связь будет как минимум бурно развиваться. Но DECT-телефонам все равно, кажется, ничего не угрожает. Говорить по «мобиле» дорого: средняя стоимость минуты разговора составляет около пятидесяти центов. Да, дефолт, когда уровень доходов у большей части населения упадет ровно в два раза, случится только в следующем году, но все же средняя зарплата составляет примерно 175 долларов. То есть можно смело проговорить за месяц пять часов, если, конечно, ничего не есть. Поэтому общее число абонентов в России составляет 300 тысяч человек, а 3DNews пока не пишет про мобильные телефоны – все-таки не слишком актуально, да и тематика тогда не предполагала.

А написать есть о чем – технологии развиваются бурно. Уже массово распространяется стандарт GSM (почитайте нашу историческую статью десятилетней давности), который знакомит людей с таким понятием, как «SIM-карта». Но он пока еще не господствует – более актуальна цифровая версия стандарта AMPS. А вот имена операторов, действующих в России, не вызывают удивления: бал правит большая пара из еще желто-белого МТС и сине-желтого «Билайна». В спину им дышат почившие теперь «Сонет», «Московская сотовая связь» и «Дельта Телеком». А «Северо-Западный-GSM», который потом превратится в «МегаФон», пока еще не представляет реальной силы – он ее наберет как раз вместе с взрывным разрастанием популярности стандарта GSM, с которым компания и работала изначально.

Мобильный телефон 20 лет назад воспринимался исключительно как средство голосовой связи – даже SMS воспринимались как экзотика, доступная, во-первых, только в GSM-сетях, во-вторых, только между абонентами одного оператора. Забавно, что спустя 20 лет звуковая связь возвращается в какой-то мере – но уже в виде голосовых сообщений: люди за это время уже успели устать от того, что на телефоне постоянно приходится печатать.

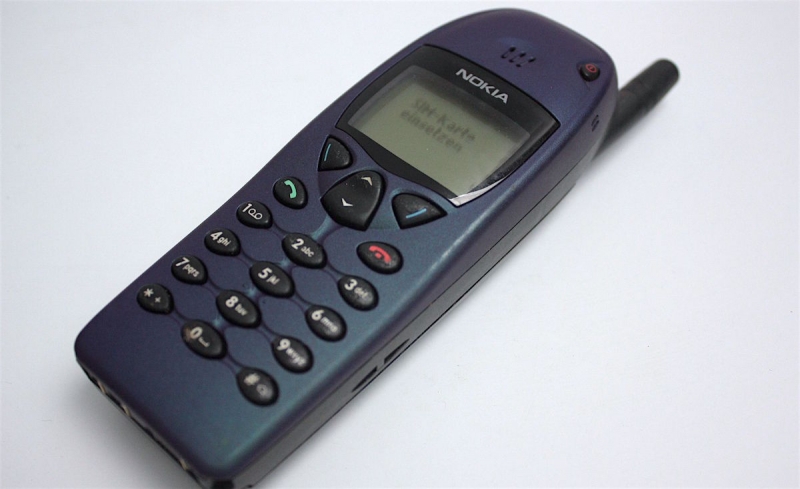

Поэтому и запросы к мобильному телефону были соответственные. «Кирпичи», впрочем, уже ушли в прошлое – вид обычной трубки 20-летней давности больше не вызывает священный трепет. В большинстве своем это обычные «моноблоки» средних размеров с обязательной торчащей антенной – первый массовый телефон с антенной, убранной в корпус, появится только в следующем году (это будет Nokia 8810). Никаких изысков в плане дизайна и «зоопарка» форм-факторов – буйство случится уже в 2000-е и продлится недолго – все убьет iPhone.

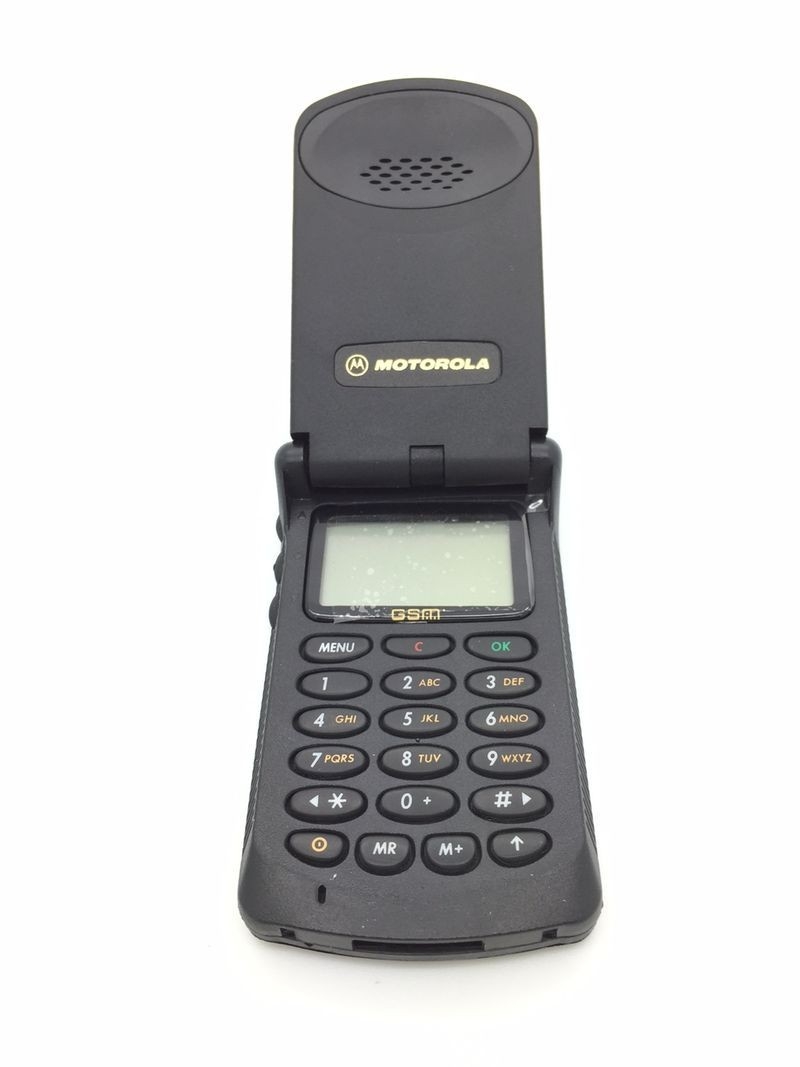

Пока же пользователь, желающий выделиться, выбирает Motorola StarTAC – первую в истории «раскладушку», выпущенную в 1996 году. Красотой аппарат не блещет, но его конструкция вскоре станет визитной карточкой пионеров сотовой связи, в то время как их главный конкурент будет напирать именно на моноблоки, иногда сваливаясь в безумные эксперименты (речь тут, конечно, о Nokia).

Для финнов 1997 год можно назвать во-многом переломным – именно 20 лет назад Nokia догнала американцев из Motorola и составила с ними дуэт правящих на этом рынке компаний. Nokia занимает первое место по продажам в Европе и второе – в США. Общее число проданных телефонов в 1997-м – 21,3 миллиона (согласно годовому отчету). Motorola царит в США и неплохо чувствует себя в Европе, общее число проданных телефонов – более 25 миллионов. На третьем месте – Ericsson (до покупки подразделения компанией Sony остается пять лет). Далее – Panasonic (лучшие из азиатов) и французский Alcatel.

На этом хватит цифр и статистики, пора поговорить про гаджеты – хотя это слово 20 лет назад не употреблялось в отношении мобильных телефонов. Они уже были весьма важны в обыденной жизни (пусть пока в основном для американцев, японцев и жителей Западной Европы), но нынешнего культа технологических примочек 20 лет назад не было и в помине. Это был уже постиндустриальный мир, но во многом аналоговый. Революция только готовится.

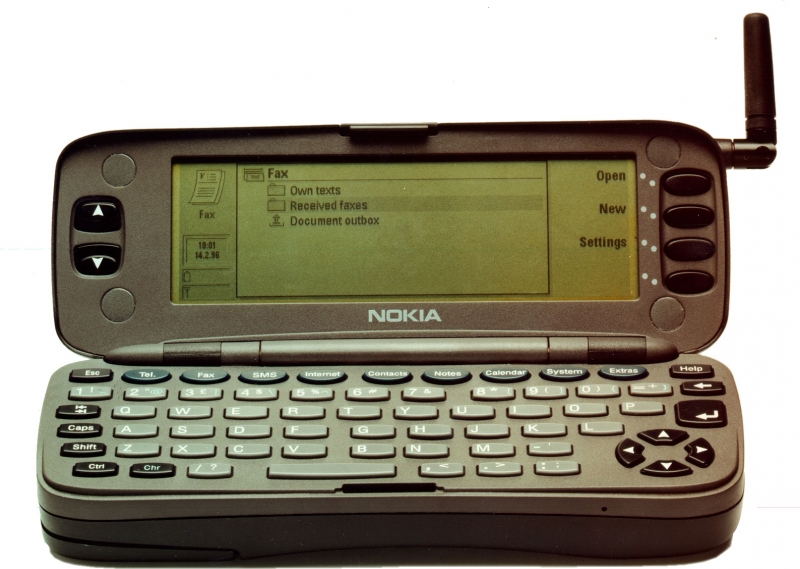

1997 год, если честно, – один из самых пустых в плане знаковых событий в развитии мобильных телефонов и КПК. Почти ежегодно выходили устройства, которые во всех исторических справках теперь характеризуются как «первые в мире», но ровно 20 лет назад случилось как раз небольшое белое пятно. Так что не удержусь и начну с аппарата, вышедшего годом ранее, но получившего серьезное распространение именно в 1997-м – Nokia 9000 Communicator.

Он анонсирован на важнейшей европейской выставке электроники CeBIT 1996 и вышел в продажу в августе того же года. И да, слово «коммуникатор», которое затем заменит собой нынешнее «смартфон», появилось именно благодаря Nokia и этому устройству. В сложенном виде 9000 Communicator представлял собой рядовой GSM-телефон – только очень толстый (38 мм, сейчас телевизоры тоньше) и тяжелый (397 грамм). Зато он раскрывался – и пользователь получал QWERTY-клавиатуру и дополнительный монохромный экран (разрешением 640 × 200); на первом коммуникаторе была установлена операционная система GEOS, позволявшая запускать приложения. Процессор – Intel Intel i386 тактовой частотой 24 МГц, восемь мегабайт памяти, из которой для приложений выделена половина. Ни о какой работе в Интернете речи тогда не шло – это не «портал» в Сеть, как нынешние смартфоны, а именно аппарат для голосовой связи с функцией карманного компьютера: в первую очередь это бизнес-приложения; например, на нем можно было открывать и редактировать файлы Microsoft Office.

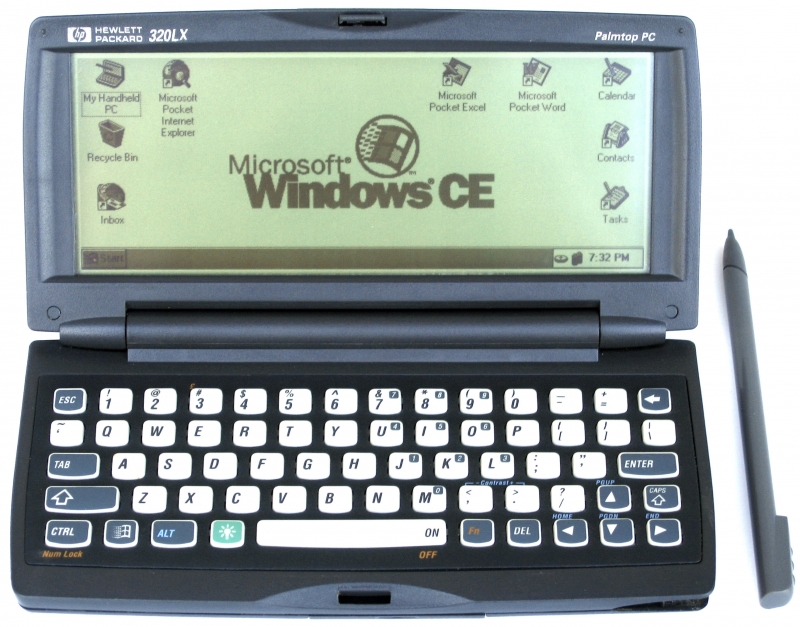

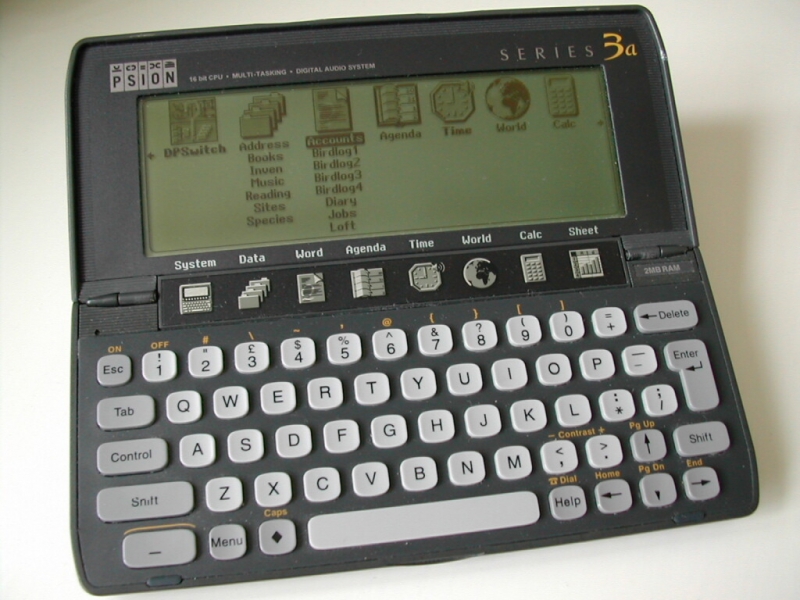

Подобной функцией тогда удивить было сложно – рынок карманных компьютеров (КПК) жил и развивался, но сочетание функций, безусловно, сносило крышу. И раз уж речь зашла о КПК, посвятим им несколько строк. Этот рынок 20 лет назад делили между собой в первую очередь компании Psion (прекрасная история компании от коллег из hpc) и Palm, использовавшие операционные системы собственного сочинения – SIBO (EPOC) и Palm OS соответственно. Windows слегка отставала и, хотя и представила в 1997-м вторую версию своей операционки CE, значимых продаж КПК на ее основе не имели. Главные КПК 20 лет назад – это Psion Series 3a/3c и Palm Pilot (Personal или Professional).

Psion Series 3c имел габариты 165 × 85 × 22 мм и вес 275 грамм – заметно тоньше и легче Nokia 9000 Communicator. Работал от двух пальчиковых батареек типа АА, обладал монохромным дисплеем разрешением 480 × 160, 7-мегагерцевым процессором NEC V30H, встроенным микрофоном и обилием любимых многими приложений, вроде ежедневника Agenda, который некоторые пользователи вспоминают и поныне.

Palm Pilot был еще более компактным — 119 × 81 × 18 мм, весил 160 грамм и не подразумевал физической клавиатуры. Только сенсорный экран со стилусом и несколько навигационных клавиш – именно этот формат вскоре станет единственно верным, а «клавиатурники» будут несколько задвинуты в сторону. Процессор – Motorola 68328 с тактовой частотой 16 МГц, питание – от двух батареек формата ААА.

Вернемся к мобильным телефонам. Про то, что с инновациями в этой области ровно двадцать лет назад было туго, я уже сказал, но что-то все-таки нашлось. Это Siemens S10 от немецкой компании, не имевшей большой доли на рынке, но постепенно набиравшей силу (мой первый телефон был как раз таки Siemens, а ваш?). Это первый в истории телефон с цветным дисплеем, поддерживавшим три цвета – и использовались они исключительно для выделения текста. О картинках речи не шло.

Про то, что первым массовым телефоном без выпирающей антенны станет Nokia 8810, я уже сказал выше, но официально первым телефоном на рынке без этой «части тела» стал Hagenuk GlobalHandy. Да, я тоже узнал о компании Hagenuk только что – при подготовке этой статьи. Немецкая компания испытывала серьезные финансовые трудности, несмотря на достаточно удачные и тепло принятые специалистами телефоны, уже в том же 1997 году и, после долгой череды банкротств и перепродаж, прекратила свое существование в 2001-м.

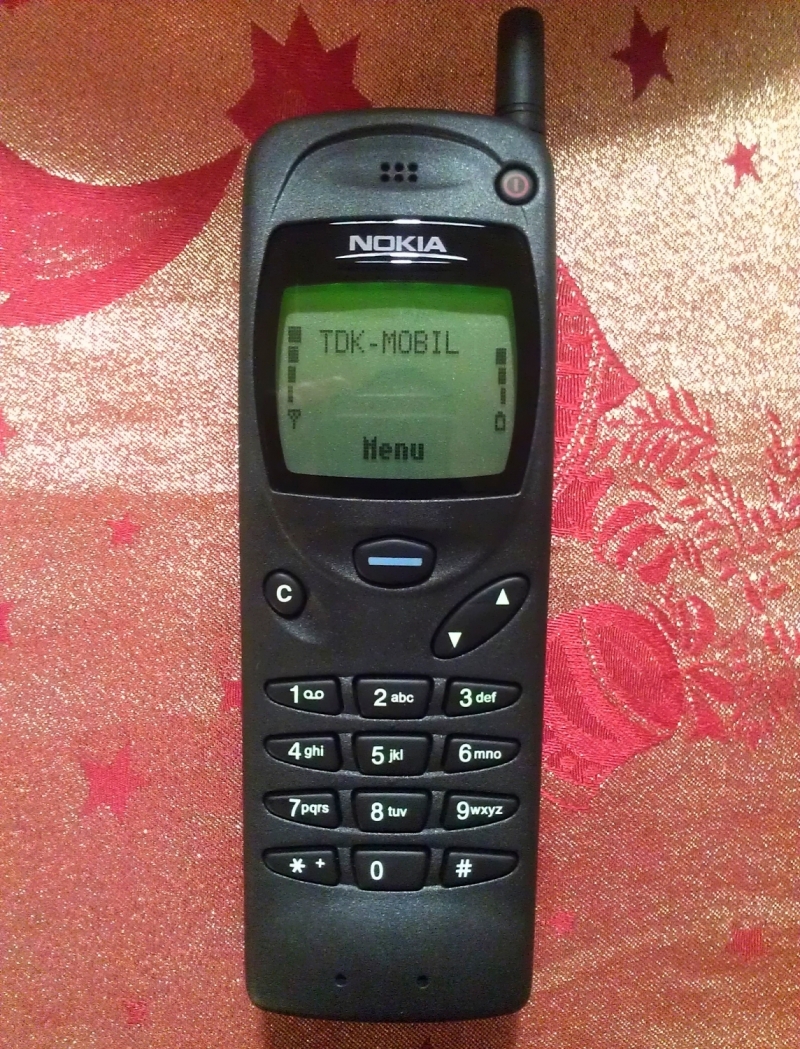

Куда более массовым аппаратом был Nokia 3110 – первый телефон финской компании с системой навигации при помощи «джойстика» Navi-Key. Монохромный дисплей, монофонические рингтоны («впервые на арене» – Jingle Bells и 40-я симфония Моцарта), темно-серый цвет и ориентация на бизнесменов средней руки.

Еще одна важнейшая модель финской компании – Nokia 6110, без Navi-Key, но с Моцартом и «Джингл Беллз» на рингтоне, зато более доступная – ее можно купить за $900. И это сделало ее настоящим бестселлером. С учетом инфляции ее цена бы сегодня составила, к слову, примерно $1 300 – дороже iPhone X.

Главный конкурент – Motorola StarTAC 70, более недорогая (тоже менее 1 000 долларов) версия ставшего впоследствии легендой первого StarTAC. Тоже бы стоила сегодня дороже «десятки», зато статус, который вы приобретали, пользуясь этой «раскладушкой», ни в какое сравнение не идет с тем, что вы получите сегодня от пользования даже 512-гигабайтным X.

Шведы из Ericsson тоже не сидели сложа руки – иначе продавать по 15 миллионов трубок в 1997-м было бы невозможно. Главным их аппаратом 20 лет назад можно считать Ericsson GA628 – первый в истории телефон с изменяемым внешним видом. Это сегодня купил чехол – и ходишь довольный. Тогда же для GA628 были выпущены сменные панели разных цветов: зеленого, желтого, синего и красного. Не сказал бы, что это очень красиво, но на общем фоне как минимум ярко.

Если же брать главных героев нашего времени, то похвастать хоть чем-то может только Samsung. Актуальной на тот момент моделью можно считать вышедший в 1996-м Samsung SGH-250 – с любопытной откидной панелью, прикрывавшей клавиатуру.

Apple 20 лет назад терпел чудовищные убытки и не помышлял о мобильном бизнесе, зато в компанию после 12-летнего отсутствия вернулся Стив Джобс – пройдет еще 10 лет, и все изменится.

А до первого в истории 3DNews обзора мобильных телефонов (причем сразу нескольких) оставалось всего три года. Мы изменили мир чуть раньше.

Программное обеспечение

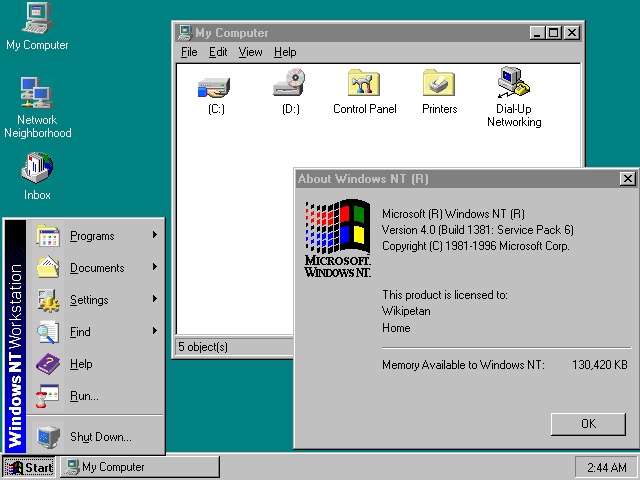

Для софтверной индустрии 1997-й стал годом не на шутку обострившейся конкуренции на рынке операционных систем, особенно в корпоративном сегменте, где лоб в лоб столкнулись и вступили в отчаянную схватку две программные платформы — Unix и Windows NT. На тот момент ассортимент Unix-систем был очень широк — от небольших рабочих станций и персональных компьютеров до мощных высокопроизводительных серверов, сравнимых с мейнфреймами. Очень популярен Unix был в академической среде. Однако благодаря агрессивной маркетинговой политике Microsoft, ОС Windows NT удалось отбить пальму первенства и потеснить в области настольных систем и серверов младшего класса позиции не только Unix, но и довольно востребованной в то время в сетях малых и средних организаций Novell NetWare.

О масштабах экспансии Microsoft на рынок ПО в 1997 году можно судить по количеству релизов программной продукции софтверного гиганта. Компания выпустила на российский рынок локализованную версию Windows NT 4.0 Workstation, представила третий комплект дополнений и исправлений для этой платформы, начала продажи пакета офисных приложений Office 97, презентовала Windows CE 2.0 для наладонных компьютеров и встраиваемых систем и продемонстрировала широкой аудитории первую публичную бета-версию ОС Windows 98, аккумулировавшей в себе все, что было наработано за два года развития Windows 95. Важной вехой в развитии семейства продуктов Microsoft, отражающей нацеленность компании на рынок сетевых ОС масштаба предприятия, стал выпуск Windows NT Server 4.0 Enterprise Edition для крупных корпоративных заказчиков и BackOffice Small Business Server для малого бизнеса.

Вспоминая события двадцатилетней давности, нельзя обойти стороной Linux, реализованный на тех же модульных принципах, стандартах и соглашениях, что были заложены в Unix в течение 1970- и 1980-х годов. Впервые появившись в 1991 году и пройдя путь от научной разработки до полноценной ОС, к 1997-му эта платформа достигла определенной зрелости и стала занимать все более заметные позиции в областях, связанных с исследовательской и инженерно-конструкторской деятельностью, а также в сегменте малого бизнеса. Большую роль в популяризации Linux сыграли открытость программного кода системы, поддержка различных архитектур, нетребовательность к ресурсам вычислительных машин и наличие многочисленной армии энтузиастов, вносивших свой посильный вклад в развитие системы. Огромное влияние на выход Linux на широкий рынок оказали компании Caldera и Red Hat, выпустившие коммерческие версии ОС и наглядно продемонстрировавшие потенциал Open Source-решений.

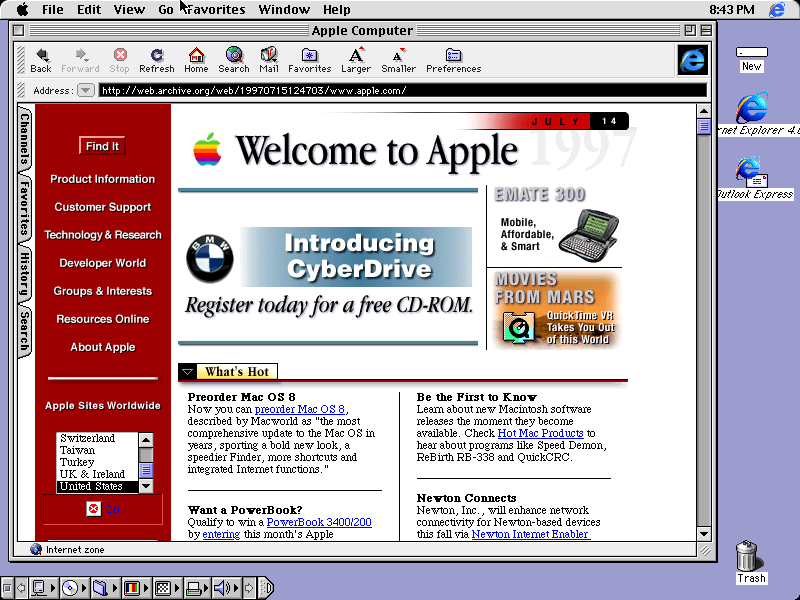

Был 1997-й богат и на новости, связанные с Apple Computer (так до 2007 года называлась знаменитая компания из Купертино). Именно в это время Apple Computer выпускает новую версию платформы Mac OS 8 с поддержкой файловой системы HFS+, улучшенной поддержкой мультизадачности, усовершенствованным графическим интерфейсом, встроенными средствами для работы в Интернете и прочими доработками, а в руководстве самой компании происходят значимые изменения, связанные с возвращением на пост генерального директора американской корпорации Стива Джобса, спасшего «яблочную» империю от банкротства и предопределившего развитие IT-индустрии на многие годы вперед.

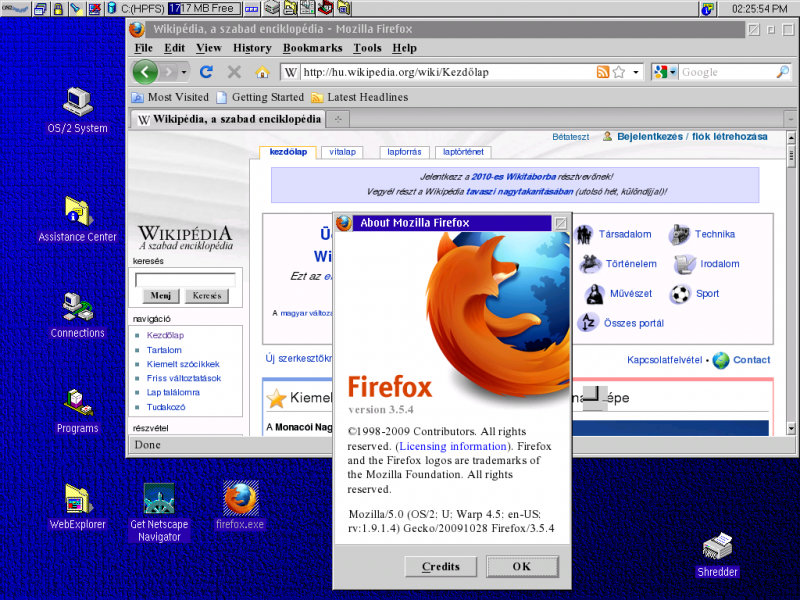

Раз уж речь зашла об операционных системах, не лишним будет помянуть добрым словом эпохальную платформу OS/2, отметившую в 1997 году десятилетний юбилей и до сих пор живущую в умах и сердцах ностальгирующей публики. Призванная вытеснить DOS с персональных компьютеров, «полуось» изначально разрабатывалась в партнерстве со специалистами Microsoft, однако спустя три года сотрудничеству между именитыми компаниями пришел конец, и IBM пришлось взять на себя ответственность за дальнейшее развитие продукта. Для своего времени OS/2 была прогрессивной и надежной операционной системой, нашедшей широкое применение в телекоммуникационных компаниях, банковских структурах и корпоративном секторе. Немало поклонников «полуоси» было и среди рядовых пользователей ПК, в числе которых наверняка присутствуют читатели 3DNews. Однако неправильная маркетинговая политика разработчиков, отсутствие должной поддержки и все возрастающее давление со стороны Windows предопределили будущее перспективной платформы, сделав ее сугубо нишевым продуктом. В настоящее время OS/2 живет и здравствует в вариантах под названиями eComStation и ArcaOS, поставляемых компаниями Serenity Systems и Arca Noae в рамках лицензионных соглашений с IBM на выпуск и продажу дистрибутива системы для современного аппаратного обеспечения.

В 1997 году начала свой путь к всемирной известности «Лаборатория Касперского», дебютировавшая на рынке информационной безопасности с продуктом AVP — Antiviral Toolkit Pro by Eugene Kaspersky (помните его знаменитый свинячий визг при обнаружении вредоносного файла?). Антивирус был представлен в версиях для DOS, Windows 95, Novell NetWare и умел не только выявлять различные типы зловредов, но и выискивать их внутри архивов и упакованных файлов, а также в загрузочном секторе жесткого диска. Уже тогда в активе AVP фигурировал эвристический модуль Code Analyzer для детектирования неизвестных вирусов и прочие востребованные на тот момент функции, разработкой которых занималась команда из десяти человек. Сейчас компания ведет свою деятельность в 200 странах мира и имеет 37 региональных офисов в 32 странах. Штат сотрудников «Лаборатории Касперского» насчитывает свыше 3600 высококвалифицированных специалистов, аудитория пользователей продуктов и технологий компании составляет 400 млн человек и 270 тысяч корпоративных клиентов. В портфолио разработчика насчитывается более 30 ключевых продуктов и сервисов.

Как Касперский звук свиньи придумал

Для софтверных разработчиков 1997-й стал годом бурного развития языка программирования Java и одноименной платформы компании Sun Microsystems (впоследствии поглощенной корпорацией Oracle). Свою популярность положенные в основу Java технологии получили благодаря возможности создавать приложения, функционирующие совершенно одинаково на разных аппаратных платформах вне зависимости от используемой в них машинной архитектуры. Идея кросс-платформенности довольно быстро нашла применение в IT-среде, и благодаря поддержке ведущих представителей компьютерной индустрии IBM, Apple Computer, Novell, Hewlett-Packard и Netscape Communications, включивших виртуальную машину Java Virtual Machine (JVM) в свои программные решения, язык Java приобрел широкую известность и до сих пор продолжает оставаться наиболее востребованным в профессиональной среде инструментом для создания приложений.

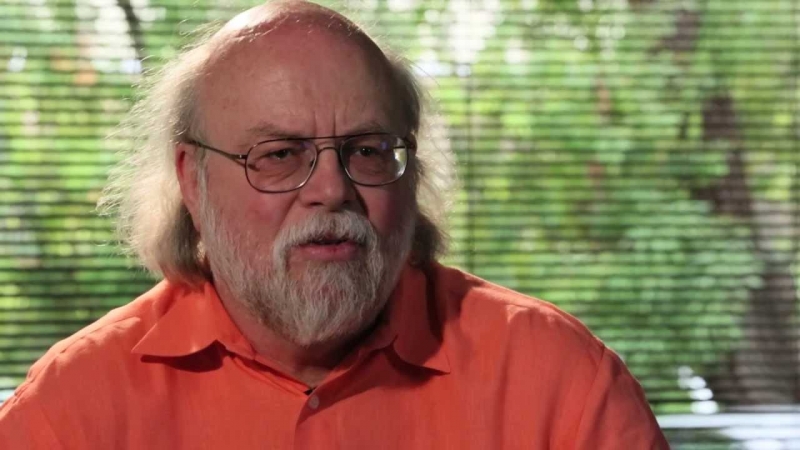

Автор объектно ориентированного и кроссплатформенного языка программирования Java Джеймс Гослинг (источник фото: liquid-robotics.com)

Немало в далеком 1997-м произошло других интересных событий — всех не упомнишь. Из заслуживающих внимания стоит отметить выпуск компанией «Арсенал» обновленного текстового редактора «Лексикон 97», судебную тяжбу между Symantec и McAffee по поводу незаконного использования программного кода, релизы объектно-реляционной системы управления базами данных Oracle 8 и программной платформы Solaris 2.6, переход Sun Microsystems, IBM, Hewlett-Packard на 64-разрядные версии ОС Unix и появление первой версии медиапроигрывателя Winamp, ставшего на долгие годы непременным атрибутом любого работающего под управлением Windows компьютера.

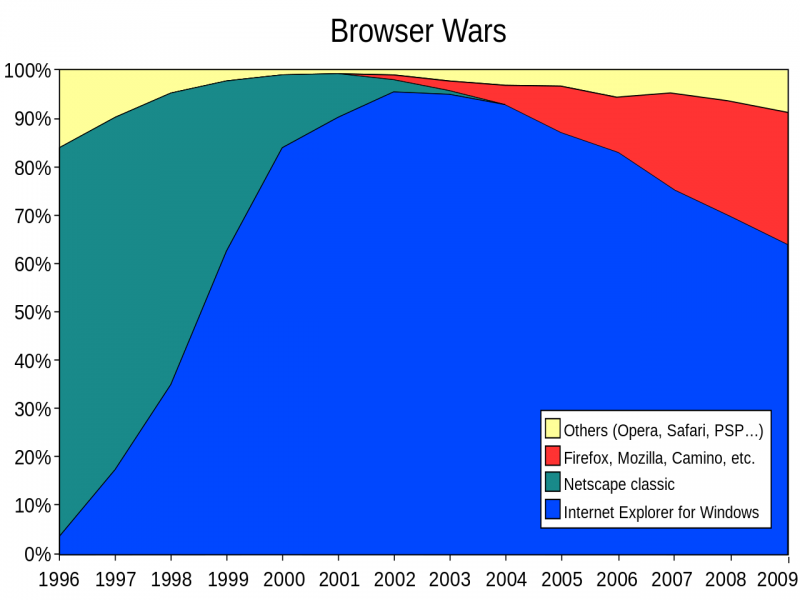

Не менее жаркой вторая половина 90-х годов выдалась и для интернет-индустрии, в которой уже вовсю бушевали браузерные войны, где на одной стороне ринга был представлен производившийся компанией Netscape Communications и контролировавший львиную долю рынка (почти 80%) веб-обозреватель Netscape Navigator, а на другой — Microsoft Internet Explorer.

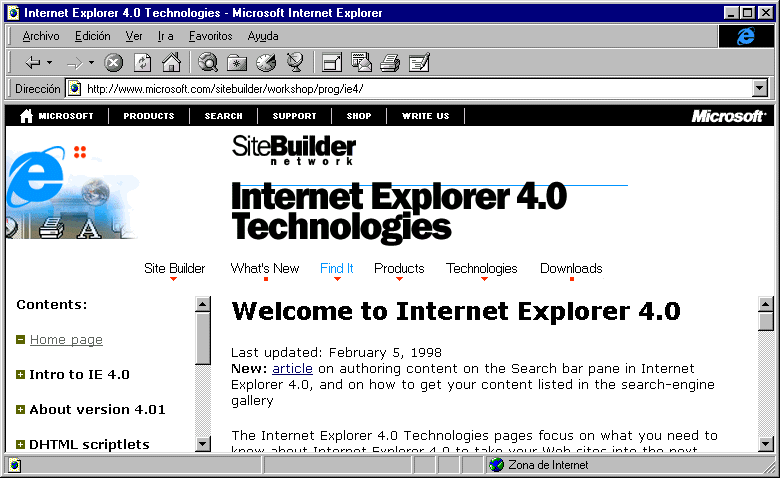

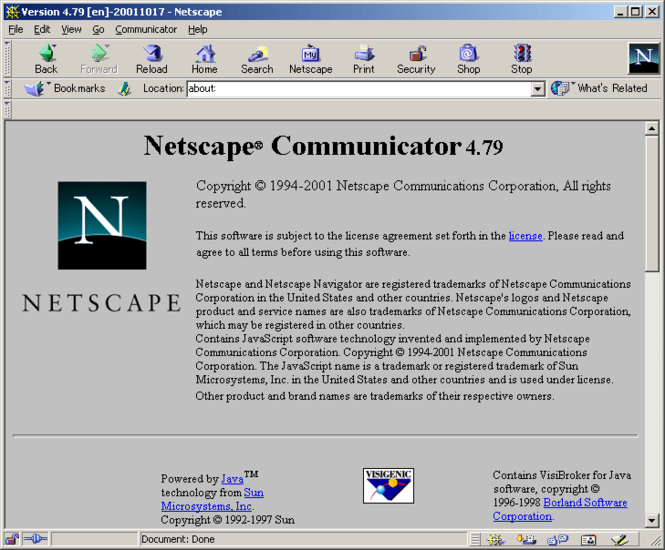

Ход войны за господство на рынке браузеров переломил выпущенный в 1997 году Internet Explorer 4.0, который в отличие от Netscape Navigator был полностью бесплатным и благодаря тесной интеграции с операционной системой Windows функционировал намного стабильнее и быстрее конкурента. Браузер получил новый движок Trident, поддержку Dynamic HTML (DHTML), ActiveX, собственных расширений JavaScript и технологии групповой политики, позволявшей организациям контролировать доступ своих сотрудников ко многим аспектам конфигурации обозревателя. Netscape Communications не оставила это без ответа и сфокусировалась на разработке веб-клиента следующего поколения под названием Communicator. В компании не стали размениваться на мелочи и включили в продукт сразу несколько компонентов: браузер Netscape Navigator, программу для работы с электронной почтой и новостными группами Netscape Mail and Newsgroups, адресную книгу Netscape Address Book и HTML-редактор Netscape Composer. Однако инициатива по созданию универсального решения для работы с веб-ресурсами не нашла поддержки у пользовательской аудитории, и детище Netscape Communications стало стремительно терять долю рынка. Немалую роль в этом сыграл маркетинговый ход Microsoft, предполагавший включение IE в каждую копию операционной системы Windows, на то время уже доминировавшей на рынке персональных компьютеров и рабочих станций.

Противостояние Netscape и Microsoft и стремление компаний привнести что-то свое оригинальное во Всемирную паутину не прошло незамеченным со стороны консорциума World Wide Web Consortium (W3C), в 1997 году представившего рабочий проект новой, четвертой версии языка гипертекстовой разметки HTML. Выпуск HTML 4.0 должен был стандартизировать элементы разметки и устранить создавшуюся на тот момент путаницу из различных веб-конструкций и тегов, используемых разными браузерами для отображения сетевого контента. Старожилы из числа веб-мастеров помнят, сколько сил тогда приходилось тратить на «заточку» сайтов под конкретный интернет-обозреватель. У кого-то зрительная память наверняка до сих пор еще хранит изображения информационных значков «лучше всего просматривать этот сайт в Netscape» или «этот сайт оптимизирован для просмотра в Internet Explorer». Впоследствии с монополизацией рынка Internet Explorer эта проблема перестала быть актуальной, и вновь о ней заговорили с последовавшей через несколько лет второй конфронтацией браузеров, начавшейся с открытия компанией Netscape Communications исходного кода своего веб-обозревателя, появления Mozilla Firefox и других альтернативных решений для работы в сетевой среде.

В российском сегменте глобальной сети события двадцатилетней давности запомнились запуском поисковой системы «Яндекс», название которой придумали Илья Сегалович и Аркадий Волож. «Яндекс» образца 1997 года учитывал морфологию русского языка, расстояние между словами и умел ранжировать документы в соответствии с их релевантностью заданному запросу. Робот поисковой системы (сетевой паук) обходил 5 тысяч серверов каждую неделю и при индексировании учитывал ряд параметров, включая проверку уникальности документов. Область поиска ограничивалась серверами доменов .SU и .RU, а также иностранными русскоязычными веб-площадками, в том числе — стран СНГ. Примечательно, что на тот момент индекс русскоязычного Интернета целиком умещался на одном SCSI-диске емкостью 4 Гбайт, а команда разработчиков сервиса составляла около десяти человек.

Современный «Яндекс» очень далеко ушел от своего прародителя и продолжает эволюционировать с каждым годом, собирая и структурируя самую разнообразную информацию, не ограничиваясь поиском только по веб-страницам. Практически все сервисы компании в настоящий момент используют технологии машинного обучения и системы искусственного интеллекта на базе нейронных сетей — для ранжирования в поиске, показа рекламы, машинного перевода. «Яндекс» поддерживает крупнейшую в России сеть центров обработки и хранения данных — десятки тысяч серверов. При этом вычислительные возможности и алгоритмы сервиса также используются партнерами компании — научными организациями для проведения исследований. Сейчас у «Яндекса» есть офисы и представительства в восьми странах, в которых работают более 6 тысяч специалистов во многих областях науки — в математике, анализе данных, программировании, лингвистике и других дисциплинах. Сервисами компании пользуются почти 60 млн россиян в месяц.

В настоящее время стало привычным вести повседневную активность в глобальной сети и исчислять пользовательскую аудиторию популярных онлайновых сервисов в миллионах, а тогда — 20 лет назад — для многих Интернет как средство коммуникации был в диковинку и только-только начинал свое развитие. Модемные соединения с вечно рвущейся связью и скоростью передачи данных 33,6 кбит/с, эйфория от общения в веб-форумах, гостевых книгах, чатах, IRC-сетях и по электронной почте, томительное ожидание загрузки страниц того или иного сайта и неописуемый восторг от предоставляемых вычислительной техникой и всемирной сетью новых возможностей.

Интернет середины 90-х годов был молод и хаотичен, по-своему уникален и притягателен. Именно в то время в нем стали появляться рассчитанные на широкую аудиторию веб-площадки и медиаресурсы, зарождаться новаторские идеи вроде сервиса мгновенного обмена сообщениями ICQ, электронная коммерция, реклама и интернет-бизнес. Именно в то время наблюдались резкое возрастание интереса аудитории к сетевым технологиям и головокружительный взлет ценных бумаг высокотехнологических компаний, закончившийся, как мы помним, крахом доткомов и банкротством многих работавших на интернет-рынке фирм. Впрочем, это уже совсем другая история.

Центральные процессоры

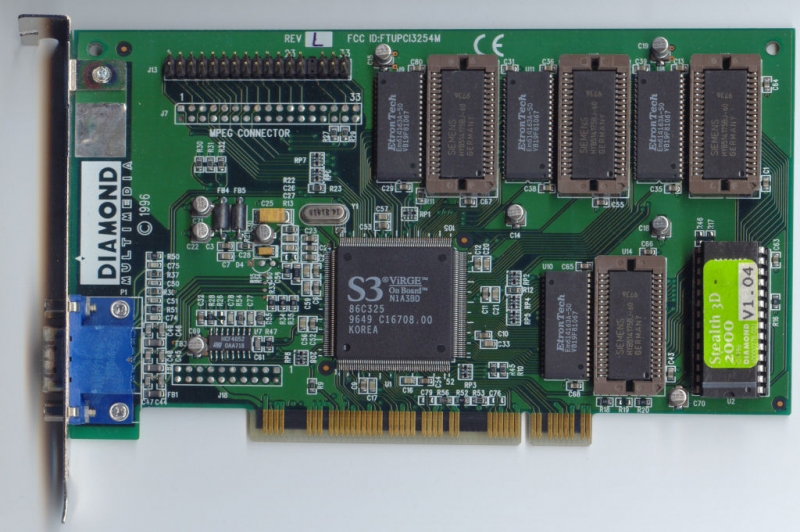

3DNews – сайт, который возник и вырос в первую очередь благодаря зарождению и бурному развитию отрасли массовых 3D-ускорителей. Первые потребительские акселераторы трехмерной графики серий 3dfx Voodoo, S3 ViRGE, ATi Rage и проч. стали получать широкое распространение как раз около двадцати лет назад, и совершенно неудивительно, что на этой волне появилось огромное число информационных ресурсов, выбравших своей главной темой освещение захватывающих событий, происходящих на этом молодом, но перспективном рынке. Однако сказать, что другие компьютерные отрасли на фоне 3D-графики отошли в тень, совершенно невозможно.

События бурлили и в смежных областях, достаточно, например, взглянуть на центральные процессоры. В 1997 году стало уже совершенно понятно, что стандартным выбором для массовых персональных компьютеров будут CPU с архитектурой x86. Однако окажется ли при этом рынок процессоров таким интелоцентрированным в последующие десятилетия, 20 лет назад понять было достаточно сложно. Хотя по состоянию на конец 1996 года рыночная доля Intel составляла примерно 88 процентов, положение компании незыблемым совсем не казалось. Конкурентов, разрабатывающих и поставляющих x86-процессоры, у Intel на тот момент было предостаточно, причем у многих имелись достаточно многообещающие независимые разработки. Помимо привычного интеловского антагониста, компании AMD, развитием альтернативных вариантов x86-процессоров занимались также компании Cyrix и IDT. Не казалась в то время чем-то сверхъестественным и возможность прихода новых амбициозных игроков.

При этом рынок находился на перепутье. Путем длительных судебных разбирательств Intel удалось добиться от конкурентов перехода на полностью самостоятельную разработку процессорных дизайнов, а не копирование и клонирование ее продуктов, которое повсеместно происходило в эпоху господства микроархитектур поколения 80486 и более ранних. Поэтому строить какие-то прогнозы относительно будущего рынка x86-процессоров в то время было очень проблематично.

***

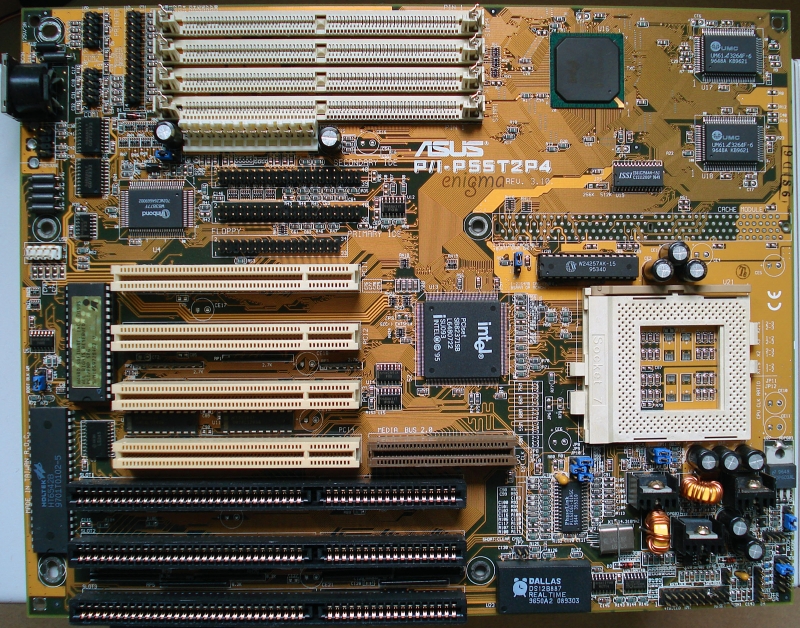

В 1997 год Intel входила с процессорами поколения Pentium (P54CS), которые впервые были представлены еще в 1993 году и за последующие четыре года переехали на платформу Socket 7, стали выпускаться по 0,35-мкм технологии и достигли тактовых частот до 200 МГц.

Прогресс, достигнутый этим семейством за время своего существования был огромен: если сравнивать Pentium 200 МГц с первыми 60-мегагерцевыми представителями серии, то прирост производительности достигал трехкратного уровня. Интенсивный рост тактовых частот избавлял Intel от необходимости регулярно проводить микроархитектурные усовершенствования и позволял сохранять отрыв от конкурирующих продуктов самыми элементарными мерами.

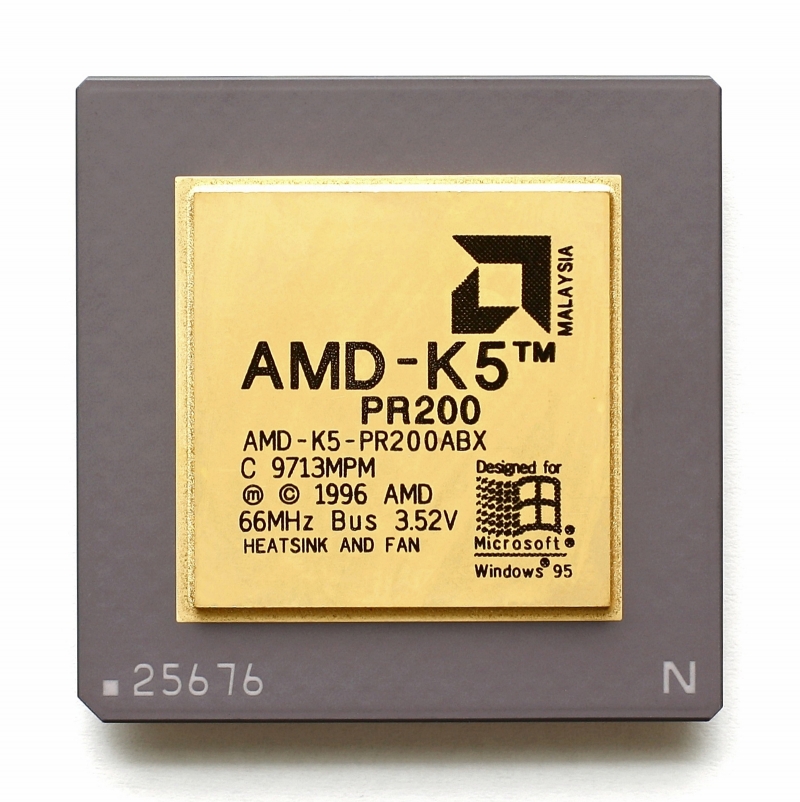

Одними из наиболее памятных соперников Pentium на начало 1997 года выступали процессоры AMD K5, но говорить о том, что они могли предложить сравнимый уровень быстродействия, к сожалению, было невозможно. С одной стороны AMD смогла сделать весьма продвинутый с инженерной точки зрения процессор, в котором нашла свое место масса прорывных для того времени микроархитектурных решений. Так, в K5 присутствовал декодер инструкций, переводящий сложные CISС-инструкции в RICS-микрооперации, и поддерживалось внеочередное исполнение команд. Однако с другой – технически сложный дизайн оказалось не очень-то просто воплотить в кремнии, поэтому в конечном итоге K5 смог стать лишь бюджетным предложением, несмотря на то, что его полупроводниковый кристалл был примерно на 30 процентов крупнее, чем у конкурирующих Pentium. Серьезная проблема заключалась в том, что процессорам K5 не удавалось развивать приемлемые тактовые частоты, и 133-мегагерцевый барьер был для них непреодолимым препятствием. Тепловыделение же при этом оказывалось значительно выше, чем было принято в то время. К тому же, как выяснялось в процессе эксплуатации, K5 были свойственны и некоторые проблемы совместимости: не все программное обеспечение, изначально ориентированное на интеловские процессоры, работало в системах на базе K5 безупречно.

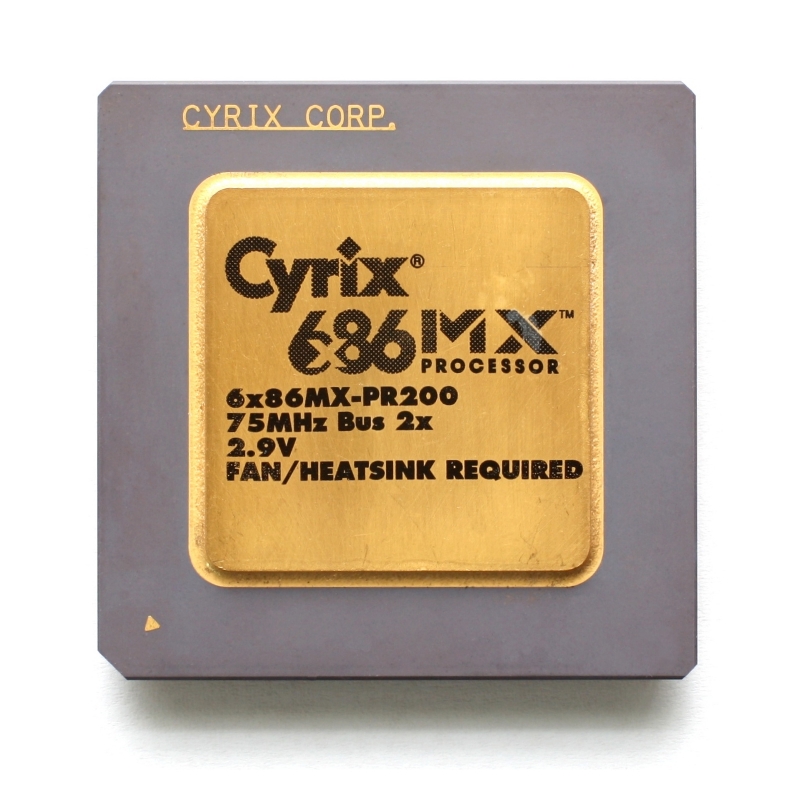

В конечном итоге это привело к тому, что AMD K5 продавались крайне плохо, и более популярным альтернативным Pentium вариантом в конце 1996 – начале 1997 года удалось стать чипу 6x86 (M1) компании Cyrix. Как и K5, процессоры 6x86 были совместимы с платформой Socket 7 и могли использоваться в тех же самых материнских платах, что и Pentium. Но микроархитектура у них была своя собственная. Подобно K5, они поддерживали переименование регистров, внеочередное и упреждающее исполнение команд, но при этом они оперировали x86-инструкциями напрямую, не прибегая к декодированию микроопераций. Такой подход давал в то время неплохие результаты. В большинстве случаев производительность Cyrix 6x86 была вполне достаточна, и на одинаковой тактовой частоте эти процессоры были способны даже превосходить Pentium. Но портила все ситуация с совместимостью. С программным обеспечением, разрабатываемым под интеловские CPU, у Cyrix 6x86 часто возникали проблемы, и во многих случаях разработчикам приходилось выпускать даже специальные патчи. Но еще большей неприятностью оказалась недостаточная производительность блока FPU. По этой причине многие популярные в то время компьютерные игры (тот же Quake) работали на Cyrix 6x86 заметно медленнее, чем на оригинальных Pentium.

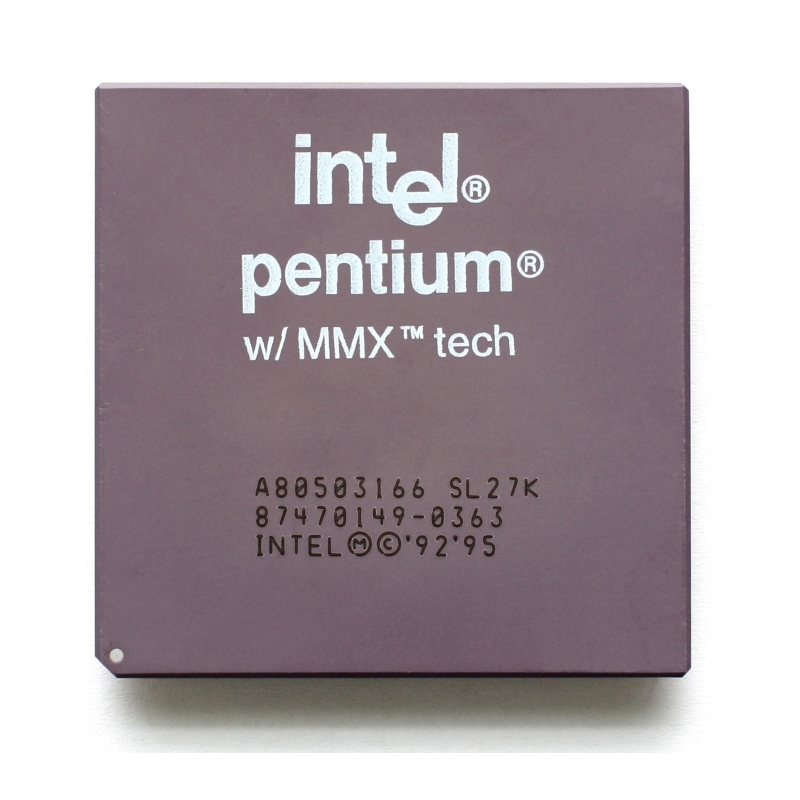

Таким образом, соперники Petnium были достаточно слабы. Тем не менее, несмотря на отсутствие острой конкуренции, в начале 1997 года компания Intel обновила модельный ряд своих процессоров, добавив в Pentium набор векторных инструкций MMX. Попутно в микроархитектуре был проведен ряд небольших улучшений, которые сегодня наверняка бы окрестили расхожим термином «плюс 5 процентов». В обновленной версии удвоился объем кеш-памяти первого уровня, был слегка переработан исполнительный конвейер и улучшена эффективность предсказания переходов. В остальном же новые Pentium MMX остались похожи на классические суперскалярные Pentium, так что совсем неудивительно, что их совместимость с единой платформой Socket 7 полностью сохранилась. Однако предельные тактовые частоты сделали один шаг вперед и дотянулись до отметки 233 МГц.

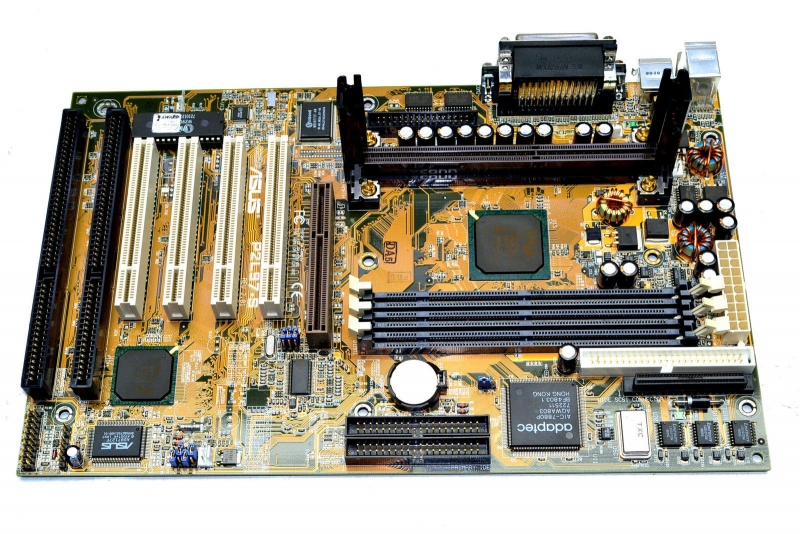

Анонс Pentium MMX был не слишком грандиозным событием, и он оказался лишь прелюдией к действительно кардинальным изменениям, которые произошли на рынке всего лишь несколькими месяцами позже. В середине 1997 года Intel выпустила принципиально новый продукт – семейство процессоров Pentium II, первые представители которого носили кодовое имя Klamath. Нового в Pentium II было предостаточно. Микроархитектура этих процессоров была построена на принципах, заложенных в Pentium Pro еще в 1995 году. Это значит, что Pentium II стал первым массовым интеловским процессором с трансляцией x86-команд во внутренние RISC-микроинструкции. Кроме того, в Pentium II появился длинный исполнительный конвейер, шесть параллельных исполнительных устройств, оптимизации под работу с 32-битным кодом, расширенная адресация памяти, внеочередное и спекулятивное исполнение команд, точное предсказание переходов и переименование регистров. Но самое главное – в процессорах Pentium II появился интегрированный кеш второго уровня объемом 512 Кбайт. До Pentium II кеш второго уровня размещался на материнских платах и работал на частоте процессорной шины. Теперь же скорость кеширования сильно возросла, так как кеш стал ближе к CPU и благодаря этому мог функционировать на уполовиненной частоте процессора. Все нововведения в сумме обеспечили впечатляющее 50-процентное преимущество Pentium II перед обычными Pentium на равных тактовых частотах.

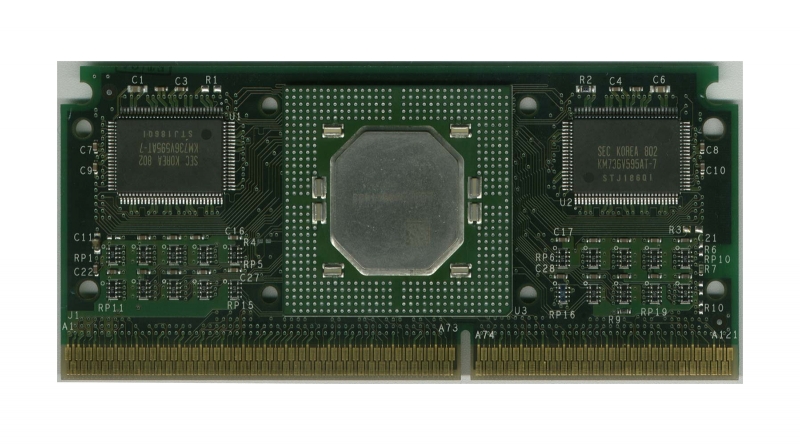

Но Pentium II поражали воображение не только своим прогрессом в производительности. Удивляли они и возросшими почти в полтора раза тактовыми частотами, сразу достигшими уровня в 300 МГц, несмотря на то, что производство Klamath все еще опиралось на 0,35-мкм нормы. Сильно впечатляло и внешнее исполнение Pentium II: они получили принципиально новый форм-фактор Slot 1. Сами процессоры стали упаковываться в достаточно габаритные SECC-картриджи, внутри которых располагалась дочерняя печатная плата с собственно CPU и микросхемами L2-кеша, а на материнских платах вместо привычного сокета появился специальный процессорный слот.

Но самое неизгладимое впечатление производили цены. Флагманский Pentium II 300 МГц на момент своего анонса получил рекомендованную стоимость $1 981, а младший процессор в модельном ряду, Pentium II 233 МГц, продавался за $636. Именно поэтому народными Klamath так и не стали, а обладатели систем на базе Slot 1-процессоров долгое время оставались в меньшинстве.

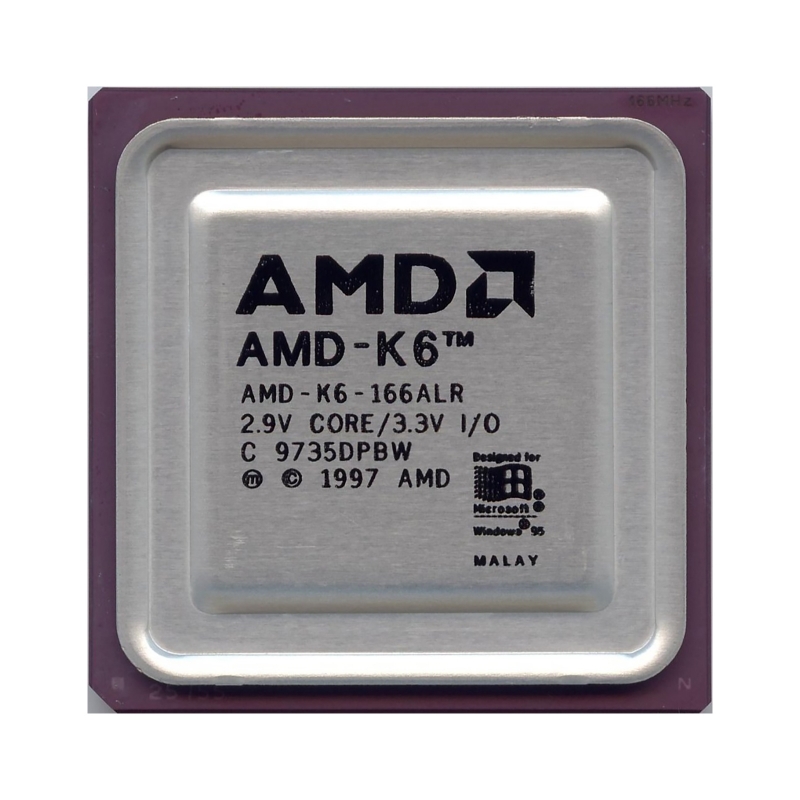

Настоящей же восходящей звездой в 1997 году стал AMD K6 – новый процессор извечного интеловского конкурента. В отличие от K5 он в конечном итоге сумел стать очень популярным решением благодаря отличному сочетанию цены и производительности, а также благодаря совместимости с широко распространенной и открытой платформой Socket 7.

История появления AMD K6 весьма примечательна. Дело в том, что результатом работы инженеров AMD этот продукт можно назвать лишь весьма условно. Микроархитектурный дизайн K6 компания AMD приобрела в конце 1995 года вместе с небольшой, но талантливой командой разработчиков NexGen, которые собирались выпустить собственный продукт под именем Nx686. Руководству AMD удалось разглядеть потенциал разработки до того, как она была выведена на рынок, и доделывали свой Nx686 инженеры NexGen уже будучи сотрудниками AMD. Под патронажем менеджеров AMD в процессоре была реализована совместимость с Socket 7 и шиной процессоров Pentium, а также добавлен блок MMX. И в таком виде новинка, обретшая новое имя AMD K6, была запущена в тираж.

Дизайн K6 оказался для AMD очень удачным приобретением. Разработка NexGen была для своего времени революционной. Микроархитектурно она не уступала Pentium II, а в чем-то даже превосходила его. Ядро K6 опиралась на RISC-архитектуру; оно имело вместительный L1-кеш объемом 64 Кбайт; обладала декодером, способным обрабатывать до четырех x86-инструкций за такт (против трех в Pentium II); с 95-процентной эффективностью предсказывала переходы благодаря огромной таблице истории ветвлений; и была снабжена семью (!) исполнительными устройствами. При этом, несмотря на то, что микроархитектура K6 сильно отличалась от интеловской, у нового процессора AMD практически не было никаких проблем совместимости.

Не подкачала и производительность. На одинаковой тактовой частоте K6 превосходил процессоры Pentium MMX и был сопоставим с Pentium Pro. Новым Pentium II он все же несколько уступал в чистом быстродействии, но с точки зрения сочетания цены и производительности перевес оказывался на стороне новинки AMD. За 1997 год было выпущено несколько моделей K6 с максимальной тактовой частотой 233 МГц, но стоимость старшей версии составляла достаточно демократичные для того времени $469, что было немного ниже цены флагманских моделей Pentium MMX. Цена же самого дешевого варианта K6 166 МГц была установлена в $244. И такая ценовая политика привлекала покупателей.

Стоит отметить, что K6 и его последователи в виде K6-2 и K6-III в течение четырех последующих лет оставались весьма востребованными предложениями. Именно они долгое время поддерживали популярность платформы Socket 7, которую, пожалуй, можно назвать одной из самых долгоживущих, несмотря на то, что Intel в 1997 году перестала выпускать для нее какие-либо новые CPU. Кроме того, с момента выхода K6 в жизни AMD начался период уверенного роста, и на протяжении нескольких следующих лет она стабильно наращивала свою рыночную долю примерно по 2 процента в год.

Появились в 1997 году новые Socket 7-решения и у других конкурентов Intel — Cyrix и IDT. Правда, на фоне K6 выступили они не слишком ярко. Новый Cyrix 6x86MX (M2) получил поддержку расширений MMX и расширенный L1-кеш, но главным усовершенствованием стал переход на 0,35-мкм производственную технологию и последовавшее за этим увеличение до 187 МГц тактовых частот. В целом 6x86MX показывал вполне приемлемое быстродействие и вполне бы мог стать неплохим недорогим вариантом в массовом сегменте. Однако смертельный удар по будущему процессоров Cyrix нанесла покупка этого разработчика гигантом National Semiconductor, который принял решение отказаться от прямой конкуренции с AMD и Intel. Новые хозяева скорректировали приоритеты Cyrix в сторону недорогих систем-на-чипе, в результате чего рынок производительных x86-процессоров понес невосполнимую утрату.

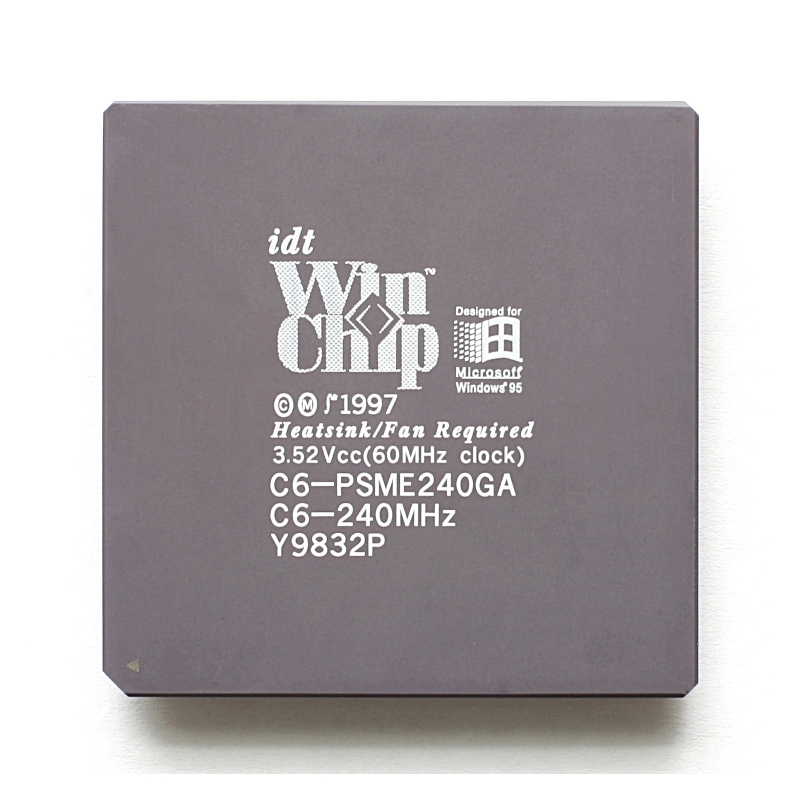

Не слишком много внимания привлек к себе и анонс разработанных компаний Centaur Technology процессоров IDT WinChip C6. Эти чипы не позиционировались в роли производительных решений изначально. Разработчики Centaur выбрали иную стратегию и создали максимально простой и энергоэффективный Socket 7-процессор с микроархитектурой, подобной 80486, то есть с единственным конвейером и с последовательным исполнением команд. В результате WinChip C6 мог конкурировать с Pentium MMX и K5/K6 лишь в сравнительно простых задачах, в первую очередь в офисных программах. Поэтому в конечном итоге он смог заинтересовать лишь отдельных корпоративных заказчиков, которых подкупили предложенные IDT низкие цены.

***

Ретроспективный взгляд на процессорный рынок 1997 года хорошо показывает, насколько живой и изменчивой была ситуация в то время. Сейчас, спустя 20 лет, подобного числа крупных процессорных анонсов, сконцентрированных в столь ограниченном периоде времени, уже не бывает. А ведь мы описали лишь самые важные события. За кадром остались процессоры Pentium OverDrive, позволявшие модернизировать системы прошлых поколений. Не упоминали мы и про мобильные Mobile Pentium, которые в этот период времени тоже начинали свой жизненный путь. Без внимания осталась и параллельно происходящая в недрах Intel активная подготовка 64-битной архитектуры IA-64, первые процессоры на базе которой увидели свет спустя два года.

Совершенно неудивительно, что под впечатлением от всей этой чехарды событий находились не только простые пользователи, но и признанные отраслевые эксперты. Например, двадцать лет тому назад тогдашний исполнительный директор компании Intel Эндрю Гроув (Andrew Grove) совершенно искренне обещал, что к 2011 году интеловские процессоры будут состоять из миллиарда транзисторов, смогут работать на частоте 10 ГГц и окажутся способны обеспечить производительность на уровне 100 тысяч MIPS. Впрочем, к чести Эндрю Гроува, не сбылось это предсказание лишь в части тактовых частот. В остальном же, получив 20 лет назад мощный импульс, прогресс в процессорной отрасли до начала 2000-х шел без каких-либо явных признаков застоя.

3D-ускорители

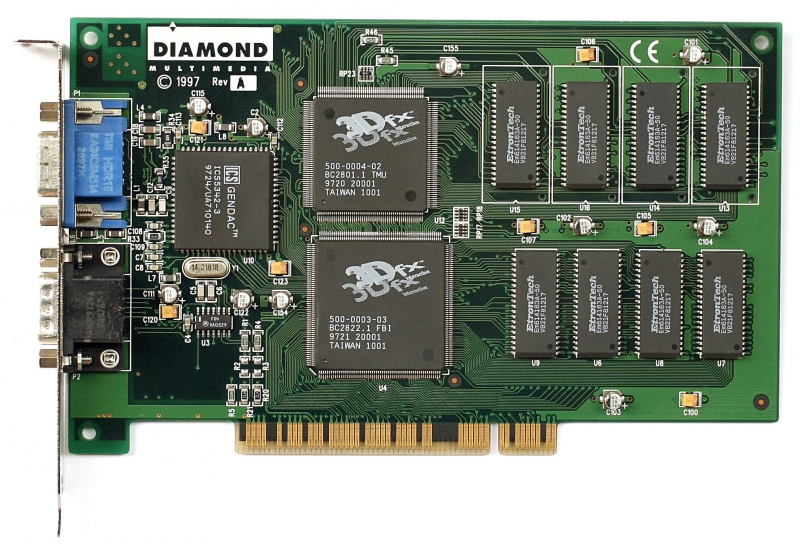

1997 год в летописи ПК неразрывно связан с именем компании 3dfx и ее революционного продукта — платы Voodoo Graphics, которая была пределом мечтаний каждого геймера той поры и дала старт триумфальному шествию 3D-графики в мире персональных компьютеров (на самом деле, Voodoo была представлена в декабре 1996-го, но именно в следующем году началось все самое интересное). Чтобы в полной мере оценить историческую значимость Voodoo в столь отдаленный от описываемых событий момент, стоит рассказать, в каком состоянии тогда находились технологии 3D-рендеринга. Для этого придется углубиться в историю немного дальше и вспомнить об иных, подчас экзотических на современный взгляд, устройствах, которые появились на свет еще до дебюта Voodoo Graphics.

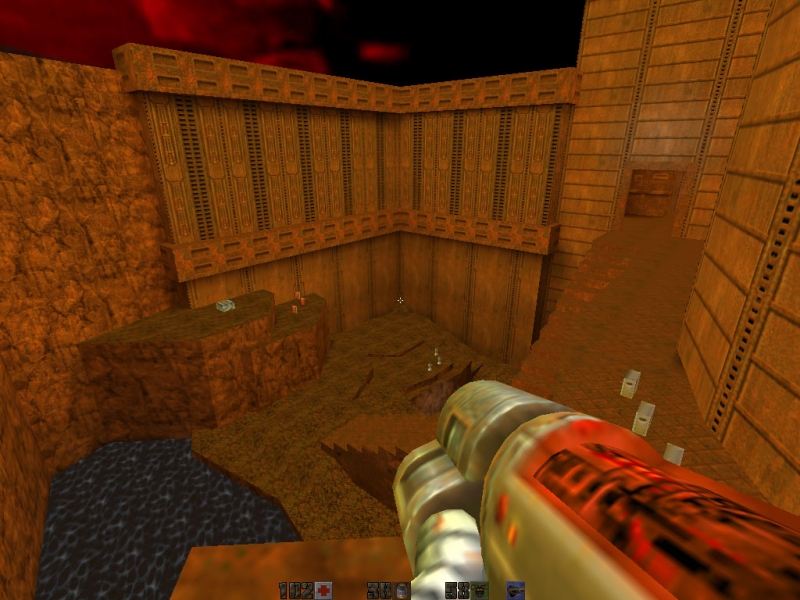

Создавать трехмерное изображение в реальном времени с помощью чипов специального назначения умели и до 3dfx, но довольно долго подобные технологии были привилегией рабочих станций, аркадных автоматов и домашних игровых приставок. Сегодня игроки на ПК нередко винят консоли, вечно отстающие в своем развитии от мощностей дискретных видеокарт, когда тот или иной проект прекрасно выглядит в виде бета-версии, но на пути к релизу теряет часть визуальной роскоши для того, чтобы уравнять возможности нескольких игровых платформ. В начале-середине 90-х годов все было наоборот. На персоналках преобладал программный метод рендеринга в реальном времени, а в прессе обязательно сообщали, поддерживает ли та или иная игра 3D-акселерацию — в большинстве случаев эта функция была необязательной. Даже Quake, вышедший в 1996 году, — первый шутер в «честном» 3D, и уже абсолютно современная по своим основным принципам игра — был опубликован без поддержки каких-либо методов ускорения и лишь потом получил совместимость с API OpenGL.

Аппаратная 3D-графика впервые стала доступна массам в игровых автоматах образца 1992 года. Владельцы домашних консолей пятого поколения (Sega Saturn, Sony PlayStation и Nintendo 64) тоже наслаждались пусть и чрезвычайно грубым по современным стандартам, но отрисованным в железе трехмерным изображением. Даже исполнение ранних стадий конвейера рендеринга — трансформация и освещение полигонов (T&L) — было реализовано в кремнии игровых автоматов и консолей (здесь отличилась Nintendo 64) за годы до того, как этой вехи достигли игровые видеокарты (NVIDIA GeForce 256 и ATI Radeon 7000 появились лишь в 1999–2000 годах).

После того как в консолях прогремела революция 3D-графики, производители компьютерного железа попытались вывести на рынок оборудование, которое могло бы предложить геймерам сопоставимый уровень быстродействия и функции, для которых требовалась вычислительная мощь, недоступная в рамках программного рендеринга на распространенных в тот момент CPU, — такие как 16-битное представление цвета, билинейная и трилинейная фильтрация. Вопреки репутации Voodoo Graphics как самого первого 3D-ускорителя для ПК, к моменту его появления на потребительском рынке уже существовали несколько устройств, сочетающих функции аппаратного рендеринга графического интерфейса Windows с конвейером трехмерной графики. Задача перечислить все ранние ускорители выходит за рамки данной статьи — их было выпущено немало, поэтому ограничимся наиболее известными устройствами.

Так, один из первых массовых 3D-ускорителей выпустила компания S3 — в то время это был признанный и респектабельный производитель видеокарт с ускорением растровой (2D) графики, а ныне — «дочка» тайваньской HTC. Впрочем, видеокарты семейства S3 ViRGE, увидевшие свет в 1995 году, ускорителями 3D-графики в буквальном смысле этого слова не были в силу посредственной производительности в реальных сценариях использования. Лучших результатов достигли продукты Matrox (видеокарта Matrox Mistique), а также небольшой на тот момент компании ATI (семейство 3D Rage).

Но самой перспективной платформой для игрового 3D-рендеринга в то время считался чип Vérité V1000 от Rendition. Именно на его проприетарный API поначалу ориентировались создатели Quake, пусть в итоге 3D-акселерация игры пришла в форме универсального OpenGL. Вплоть до пришествия Voodoo этот ускоритель обладал наивысшим уровнем быстродействия и функциональности. Так, устройство оперировало 16-битным цветом, поддерживало билинейную фильтрацию текстур, MIP-текстурирование и краевое сглаживание (Edge Anti-Aliasing). В отличие от распространенных сегодня методов полноэкранного сглаживания, Edge AA выполняется за счет рисования в плоскости экрана линий, наложенных на видимые границы полигонов. Любопытно, что сперва ранние реализации краевого сглаживания в игровых движках уступили место полноэкранным методам SSAA и MSAA, а сегодня сглаживание краев полигонов путем обработки конечного изображения является важной частью современных высокопроизводительных алгоритмов.

Vérité V1000 выделялся и с архитектурной точки зрения, т. к., в отличие от всех конкурирующих решений, устройство представляло собой программируемый RISC-процессор в сочетании с рядом блоков фиксированной функциональности, а не чистый ASIC (Application-Specific Integrated Circuit). Жаль только, что разработчики игр не оценили гибкость, которой обладает такая архитектура. Вы уже могли заметить тенденцию — многие из технологий, которые на сегодняшний день являются неотъемлемым атрибутом графических процессоров (такие как программируемый конвейер рендеринга в данном случае), в той или иной форме появились еще на заре аппаратно-ускоренного рендеринга, но cтали востребованы лишь много лет спустя.

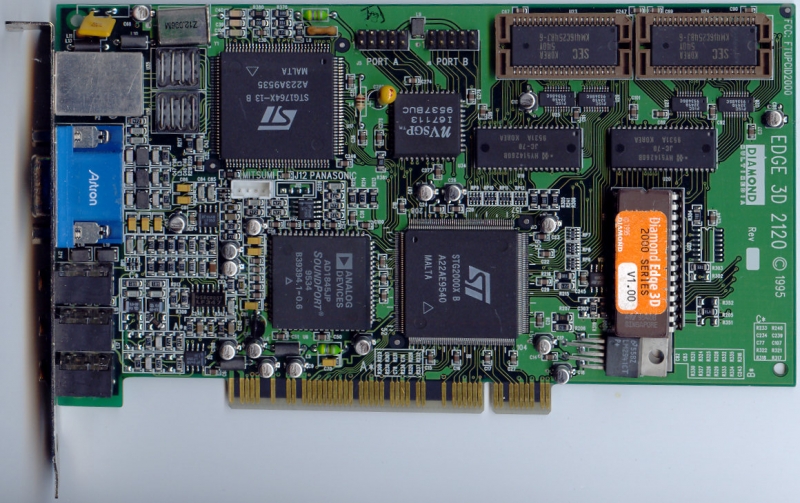

Отдельного упоминания заслуживает и дебютный продукт ныне всемогущей NVIDIA — ускоритель STG2000 на чипе NV1, выпущенный на рынок в 1995 году под маркой Diamond Edge 3D. Но прежде чем мы расскажем, чем была столь замечательна эта видеокарта, сделаем краткое отступление. Если 3dfx Voodoo не был первым потребительским 3D-ускорителем, то какому устройству принадлежит эта честь? Дать точный ответ на этот вопрос сложнее, чем кажется, ведь даже простейший конвейер рендеринга был реализован в железе не целиком и сразу. К примеру, 2D-видеокарты Impression Plus и Millenium от Matrox еще в 1994 году умели обрабатывать трехмерное изображение, только в них отсутствовала возможность наложения текстур на полигоны, без которой немыслима современная графика. Так вот, первым из коммерческих доступных устройств для домашних ПК с поддержкой аппаратного текстурирования стал именно ускоритель Diamond Edge 3D на базе процессора NV1. Но на этом особенности первенца NVIDIA не заканчиваются.

NV1 — единственное устройство среди игровых 3D-ускорителей, когда-либо представленных для ПК, выполняющее рендеринг на основе четырехугольных примитивов. Стандартом для современных API являются примитивы треугольные, но в ту эпоху магистральная линия развития рендеринга в реальном времени еще не была определена. Построение моделей из четырехугольников имеет то преимущество, что такой примитив не обязательно должен быть плоским: вынос одной вершины из плоскости порождает фигуру со сложной поверхностью. Кроме того, в дополнение к базовым четырем вершинам примитива NV1 позволял указывать пять дополнительных вершин для формирования более детализированной геометрии. Недостаток такого подхода в том, что неплоские поверхности плохо сочетаются со стандартным методом наложения текстур, т. к. с целью избежать искажений, каждая уникальная форма в игре зачастую должна иметь собственную текстуру. Это не проблема для CAD-приложений, где четырехугольные примитивы по-прежнему в ходу, но, как пришлось убедиться NVIDIA, чрезмерно усложняет разработку и портирование игр, написанных с расчетом на рендеринг треугольниками.

Перспективной возможностью NV1 казался перенос игр с платформы Sega Saturn, где использовался аналогичный метод рендеринга, а сам STG2000 был фактическим аналогом игровой консоли в форм-факторе платы расширения. Помимо ускорения 3D-графики, карта выполняла ускорение растрового изображения, вывод звука и даже имела разъемы для подключения контроллеров Sega. Увы, Saturn не снискала успеха на консольном рынке, а после того, как Microsoft сделала выбор в пользу треугольников в API Direct3D, NVIDIA пришлось принять правила игры и остановить разработку чипа NV2 в пользу NV3, на основе которого компания позже выпустила ускоритель Riva 128.

Одним из факторов, который задержал появление массово доступных — нет, не GPU, этот термин введет в обиход NVIDIA лишь в 1999 году — ускорителей трехмерной графики на ПК, была экономика. Но как только отпускные цены памяти EDO DRAM снизились настолько, что производство совсем недешевых карт расширения для игр стало рентабельным предприятием, рынок компьютерной графики взорвала 3dfx, а затем несколько компаний столкнулись в борьбе за открывшуюся рыночную нишу.

Кто в итоге вышел победителем в этой гонке, мы прекрасно знаем: NVIDIA и ATI здравствуют по сей день (последняя — в виде Radeon Technologies Group, подразделения AMD), а 3dfx в результате ряда критических ошибок со стороны руководства, обанкротилась, и большинство ее ресурсов перешло в распоряжение той самой NVIDIA. Но именно бренд Voodoo Graphics на долгое время стал практически синонимом понятия «3D-ускоритель» благодаря непревзойденной производительности и широкой поддержке со стороны разработчиков игр.

Карта Voodoo Graphics была дорогим удовольствием для геймеров того времени. Сегодня никто не удивляется ценам свыше $700 за топовую видеокарту, но тогда далеко не все геймеры могли себе позволить 3D-ускоритель за сумму в $299 (такова была оригинальная цена Voodoo Graphics с 4 Мбайт EDO DRAM), тем более в России 90-х годов. Помимо беспрецедентной производительности, 3dfx помогло оправдать эту цену смелое и правильно решение выпустить Voodoo в виде отдельной платы расширения, которая для вывода изображения работала в тандеме с, собственно, видеокартой. В категории 2D-ускорителей тогда правили бал продукты S3 и высоко ценимые за качество изображения Matrox. Обладатели дорогих видеокарт оценили возможность частичного апгрейда, которую давала 3dfx, — в отличие от комбинированных 2D/3D-ускорителей предыдущих лет, которые зачастую принуждали идти на компромисс в четкости и скорости растрового изображения.

Вариант, который объединял логику 3dfx с 2D-чипом на одной плате (Voodoo Rush) пал жертвой неудачной архитектуры, и в 1998 году, когда вышла Voodoo 2, производитель вновь сделал ставку на дискретный 3D-ускоритель, который впервые предложил возможность объединить две платы в режиме SLI (Scan-Line Interleave). Эта концепция, под той же аббревиатурой, но с другим смыслом (Scalable Link Interface) воскресла много лет спустя благодаря появлению шины PCI Express.

Другой из сильных сторон продуктов 3dfx был собственный API под названием Glide. Поскольку в Glide была реализована только та функциональность, которой располагали чипы 3dfx, а код, написанный для Glide, был ближе к железу, нежели в универсальных, но недостаточно развитых на тот момент API Direct3D и OpenGL, все лучшие игры 90-х (и Quake 2, и Half-Life, и Unreal) поддерживали Glide. Таким образом 3dfx предвосхитила еще одну тенденцию современности — внедрение низкоуровневых интерфейсов программирования Mantle, Vulkan и Metal.

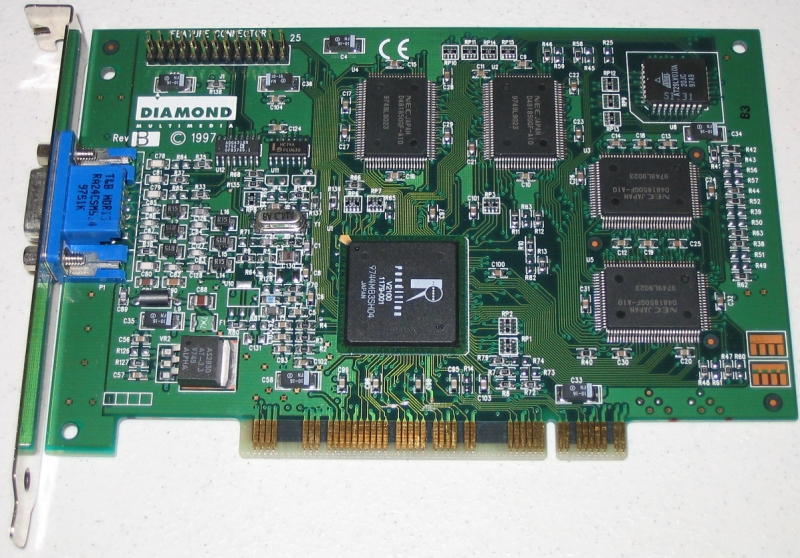

Современниками ускорителей Voodoo первого поколения и близкими соперниками по производительности были видеокарты NVIDIA RIVA 128 и 3D Rage Pro от ATI. RIVA 128 стала первым достижением NVIDIA после чрезвычайно интересного, но коммерчески неуспешного чипа NV1. Помимо впечатляющего быстродействия, устройство отличалось поддержкой повышенных разрешений экрана по сравнению с Voodoo, и качественным интегрированным 2D-ядром. Это была одна из первых видеокарт с поддержкой шины AGP, появившейся в системных платах для Pentium II. Что касается 3D Rage Pro, то в этой плате ATI также применила новый чип, совместимый с AGP, усовершенствованный со времен Rage первого поколения в отношении как производительности, так и функций рендеринга, что принесло ему поддержку интерфейса OpenGL, которой был лишен 3D Rage первого поколения. В то же время Rendition выпустила вторую и последнюю итерацию оригинальных ускорителей на базе программируемой RISC-архитектуры, Vérité V2000. По быстродействию Rendition вновь не смогла взяла высокую планку, заданную Voodoo Graphics, зато это был один из редких 3D-чипов того времени, способный выводить на экран 32-битный цвет..

Вопреки ауре легенды, окружающей названия 3dfx и Voodoo, признаем, что бум 3D-графики в сфере домашних ПК наверняка не миновал бы, даже в том случае, если бы такой компании никогда не существовало, а вместо нее прогремели другие (тоже хорошо известные нам) имена. И все же именно 3dfx сыграла ключевую роль в становлении компьютерных технологий и компьютерных игр как гигантской индустрии, которой они являются сегодня, да и в истории нашего сайта ей принадлежит особенное место. Читателям, которые присоединились к нам в не столь отдаленные годы, раскроем тайну — сайт 3DNews.ru изначально назывался не иначе, как 3dfx-ru.com.

Игры

Говоря языком путешественников, девяностые для игровой индустрии были эпохой Великих географических открытий. Массовый переход на трехмерную графику дал толчок к развитию нескольких жанров: шутеры от первого лица, стратегии в реальном времени, MMORPG — сейчас нельзя представить себе мир без них, а тогда они делали свои первые шаги. В начале девяностых SEGA была на острие прогресса — появились Virtua Racing (1992) и Virtua Fighter (1993), игры с фантастической по тем временам 3D-графикой. Видя такой успех, Sony повернула разработку PlayStation в соответствующую сторону — а ведь изначально консоль планировалось оснастить железом для 2D-игр. Для нас все это было чем-то далеким — на постсоветском пространстве безраздельно властвовали компьютеры.

И какое же это было замечательное время для ПК-игроков! 1997-й год выдался особенно сочным. id Software, годом ранее взорвавшая мир немыслимо технологичным, быстрым и красивым Quake, выкатила Quake II. В отличие от предшественника, на MS-DOS он уже не работал — всем, кто хотел приобщиться к хай-теку, пришлось ставить Windows 95 с пятнадцати «трешек» (или CD-диска, если такая роскошь была доступна). Как и с первой «квакой», мы снова не могли поверить в то, что видим на своих пузатых мониторах — такой фантастической графики просто не может быть, это какая-то черная магия! Первоначальный шок и наслаждение божественной картинкой сменились ожесточенными LAN-битвами в прокуренных интернет-кафе. Особым шиком считалось принести «конфиг» из дома на дискете и загрузить его через консоль — и все, создаем и рубимся, пока за окном не станет светло. Кто помнит лифт на Q2DM1, который можно заклинить удачно убитым соперником?

RTS не отставали. Во времена, когда зеленый логотип Westwood Studios отождествлялся с жанром и воспринимался как гарантия качества, а Command & Conquer гордо восседала на вершине, дерзкие выскочки из Cavedog Entertainment, никогда не делавшие стратегий, выстрелили со своей Total Annihilation — первой RTS с трехмерными юнитами и ландшафтом. На поле боя в невероятном 3D сражались танки, двуногие боты, корабли, артиллерия и самолеты. И снова мы не могли поверить своим глазам. Но больше всего почему-то впечатлял тот факт, что искореженные остовы уничтоженной техники никуда не исчезали и оставались на карте навсегда — если, конечно, одна из воюющих сторон не перерабатывала их на металл.

Total Annihilation поражала не только графикой, но и разнообразием боевых единиц. Как вам танки-амфибии?

Понятия MMORPG как такового тогда не существовало, но разработчики уже экспериментировали с идеей постоянного окружения, которое живет своей жизнью, а игрок в нем — не пуп земли, а всего лишь один из обитателей. Результатом таких экспериментов стала Ultima Online, пришедшая на смену текстовым MUD (Multi-User Dungeon). Ричард Гэрриот и Origin Systems создали первую MMORPG в ее современном понимании — с постоянным миром, развитием и индивидуализацией персонажа, социальным взаимодействием. Двадцать лет назад каждый мог стать героем — а если были герои, значит, должны быть и злодеи. Безопасные зоны появились много позже, в расширении Renaissance (2000 год), а до этого каждый игрок в любой момент мог пасть жертвой другого игрока.

1997 год. Тогда оскорбления в онлайне были далеко не такими затейливыми, как сейчас (скриншот mmorpg.com)

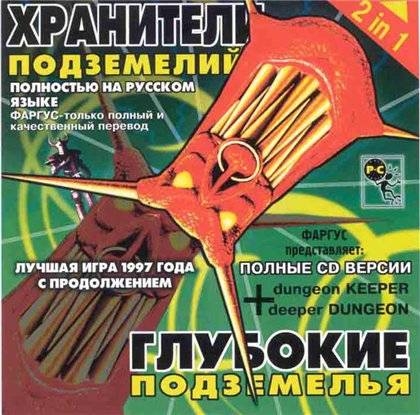

Вообще, если бы мы составляли хит-парад годов, 1997-й подобрался бы очень близко к вершине, ведь за эти двенадцать месяцев вышло огромное множество интересных, важных, знаковых и просто памятных игр. Ряды шутеров от первого лица пополнили Blood, Shadow Warrior и Hexen II; появились новые точки отсчета: Age of Empires, Carmageddon, Dungeon Keeper, Fallout, GTA, MDK (не то, что вы подумали, а увлекательный и причудливый шутер от третьего лица); свет увидели ожидаемые продолжения: Need for Speed II, Riven (сиквел Myst), Star Wars Jedi Knight: Dark Forces II, Tomb Raider II. До пришествия Half-Life, которая навсегда изменит мир интерактивных развлечений, еще год…

И все это — в лихие девяностые, при полном отсутствии лицензионного рынка в России и странах СНГ. Только в 99-м «Бука» совершит революцию и официально выпустит «Героев меча и магии III», положив начало легальной издательской деятельности на наших необузданных просторах. Но это еще впереди, а пока мы жадно скупаем и обмениваемся дисками от «Фаргуса», «Дядюшки Рисёча», «7-го волка» и других пиратских легенд, а логотип 3dfx на обложке вызывает волнительное предвкушение.

Пожалуй, пора закругляться с этим стариковским бормотанием, а то становится неудобно печатать текст сквозь пелену ностальгических слез.