|

Опрос

|

реклама

Быстрый переход

Мошенники с помощью голосового дипфейка пытались выдать себя за гендира LastPass

12.04.2024 [19:39],

Сергей Сурабекянц

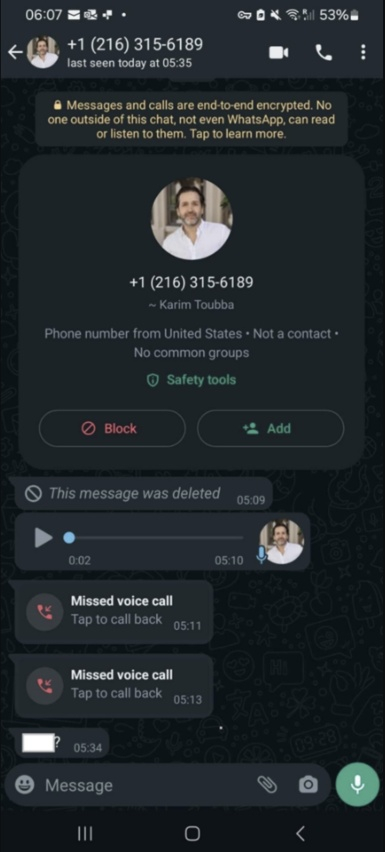

Менеджер паролей LastPass подвергся атаке мошенников, которые применили технологии искусственного интеллекта, пытаясь выдать себя за генерального директора LastPass Карима Туббу (Karim Toubba). Злоумышленники создали поддельную учётную запись Туббы в WhatsApp и начали переписку с одним из сотрудников компании. В процессе они отправляли голосовые сообщения, в которых имитировали голос руководителя Last Pass.

Источник изображения: insider.com Подвергшийся атаке сотрудник LastPass оказался достаточно опытным и стрессоустойчивым, поэтому попытка обмана силами дипфейка не удалась. Сотрудника насторожило то, что сообщения WhatsApp «выходили за пределы обычных каналов делового общения». Дополнительным поводом усомниться в реальности аудиосообщения от руководителя стало излишнее давление со стороны мошенников, тактика под названием «вынужденная срочность», которую преступники часто используют для манипулирования жертвами. Это окончательно убедило сотрудника LastPass, что вся переписка была фикцией.  LastPass сообщила, что попытка мошенничества не увенчалась успехом и сейчас расследованием инцидента занимается служба безопасности компании. Тем не менее, компания решила поделиться подробностями этого инцидента, чтобы привлечь внимание к тому, что дипфейки всё чаще используются для мошеннических кампаний с выдачей себя за руководителей. За последнее время многие компании, в том числе криптовалютная биржа Binance, столкнулись с мошенниками, выдающими себя за руководителей компаний при помощи искусственного интеллекта. Недавно в Гонконге занятый в финансовой сфере сотрудник международной компании, думая, что участвует в сеансе одновременной видеосвязи со своими коллегами, по указанию «финансового директора предприятия из Великобритании» перевёл $25,6 млн на указанный ему счёт. С 8 февраля 2024 года в США коммерческим компаниям запретили использовать голосовых ИИ-ботов в ходе автоматизированных «холодных звонков» потенциальным клиентам. Компания отдала мошенникам $25,6 млн после видеоконференции с дипфейками

05.02.2024 [18:19],

Владимир Мироненко

Транснациональная компания потеряла 200 млн гонконгских долларов ($26 млн) из-за мошенников, использовавших технологию дипфейка на новом уровне. Злоумышленникам удалось убедить сотрудника офиса компании в Гонконге перечислить указанную сумму с помощью фальшивого группового видеозвонка, в котором с помощью дипфейка участвовали поддельный финансовый директор и несколько сотрудников компании.

Источник изображения: Pixabay Полиция отметила, что это было первое дело такого рода для Гонконга, причём касающееся крупной суммы. По словам исполняющего обязанности старшего суперинтенданта Криминального бюро Барона Чана Шунь-цзина (Baron Chan Shun-ching), в предыдущих случаях мошенники обманывали жертв с помощью видеозвонков один на один. «В этот раз в ходе видеоконференции с участием нескольких человек все, кого можно было увидеть, оказались фальшивками», — сообщил он, добавив, что мошенникам удалось создать убедительные изображения целевых лиц, которые выглядели и звучали как настоящие люди. Сотрудник финансового отдела филиала компании сообщил полиции, что в середине января получил фишинговое сообщение, по-видимому, от финансового директора компании из Великобритании, в котором говорилось, что необходимо провести секретную транзакцию. Поначалу это вызвало у него сомнения, которые развеяла проведённая мошенниками групповая видеоконференция, на которой он увидел финансового директора, а также других сотрудников компании. По словам потерпевшего, сотрудники компании, участвовавшие в телефонной конференции, выглядели и говорили как настоящие люди. Затем мошенники поддерживали связь с жертвой через платформы обмена мгновенными сообщениями, электронную почту и видеозвонки один на один. В результате он, следуя указаниям фейкового руководителя, выполнил 15 переводов на общую сумму 200 млн гонконгских долларов на пять банковских счетов в Гонконге. Спустя неделю сотрудник начал подозревать неладное и обратился в головной офис компании. В результате проведённого расследования полиция установила, что участники видеоконференции были воссозданы в цифровом виде мошенниками, которые использовали общедоступные видео- и аудиозаписи этих лиц. «Они использовали технологию дипфейка, чтобы имитировать голос своих жертв, читающих текст», — отметил Чан. Он сообщил, что мошенники пытались найти подход к ещё несколькими сотрудникам компании из других филиалов, но отказался предоставить подробности обстоятельств дела. Расследование этого дела всё ещё продолжается. Старший инспектор Тайлер Чан Чи-Винг (Tyler Chan Chi-wing) сообщил, что существует несколько способов проверить, является ли человек, появившийся на экране, фальшивым цифровым фейком. Он предложил попросить собеседника делать движения головой, а также задавать вопросы, которые позволили бы определить подлинность персонажа, и сразу проявлять бдительность если тот попросит перечислить деньги. Полиция сообщила, что расширит свою систему оповещения, включив в неё систему быстрых платежей, чтобы предупреждать пользователей о том, что они переводят деньги на счета, связанные с мошенничеством. Мошенники вооружились ИИ для вымогательства с помощью фейковых голосовых сообщений

10.01.2024 [14:43],

Дмитрий Федоров

Злоумышленники стали практиковать новый метод вымогательства через социальные сети и мессенджеры с использованием ИИ для создания поддельных голосовых сообщений. Получив доступ к аккаунту пользователя, они рассылают его знакомым и во все чаты, где он состоит, поддельные голосовые сообщения с просьбами о переводе денег.

Источник изображения: B_A / Pixabay При этом мошенники не ограничиваются созданием с помощью ИИ поддельных голосовых сообщений: они также используют фотографии банковских карт, указывая на них имя и фамилию владельца украденного аккаунта. Это делается для придания дополнительной достоверности их просьбам о переводе денег. Так, один из пользователей социальной сети «ВКонтакте» потерял 200 000 рублей, а другой — 3000 рублей. Важно отметить, что в некоторых случаях злоумышленники использовали данные паспорта пользователя украденного аккаунта, которые отличались от информации в его социальных сетях, что дополнительно затрудняло выявление обмана. Это свидетельствует о высокой степени изощрённости и планирования таких атак. Представители «ВКонтакте» подчеркнули, что подобные массовые мошеннические схемы на их платформе отсутствуют. Для борьбы с такими угрозами компания использует системы безопасности, в том числе автоматические инструменты на основе ИИ, которые способны оперативно реагировать на обращения пользователей. По словам Евгения Егорова, ведущего специалиста департамента Digital Risk Protection компании F.A.C.C.T., взлом аккаунтов в Telegram или WhatsApp чаще всего происходит через фишинговые атаки, в том числе с использованием фейковых голосований. После кражи аккаунта мошенники скачивают сохранённые голосовые сообщения пользователя и с помощью ИИ создают поддельные аудиозаписи с нужным содержанием. Диана Селехина, эксперт центра мониторинга внешних цифровых угроз Solar AURA ГК «Солар», сообщила о значительном росте числа случаев мошенничества в Telegram, связанных с кражей аккаунтов. Она добавила, что за последние 30 дней было выявлено более 500 новых доменных имён, созвучных с названием мессенджера, что указывает на активизацию мошенников. Селехина отметила, что в Telegram наряду с фейковыми голосованиями и схемами подписки Premium активно распространяются и другие мошеннические методы. Общим элементом всех этих схем является требование от пользователей вводить свой номер телефона и SMS-код, которые затем используются для несанкционированного доступа к аккаунтам. В последнее время эксперты фиксируют участившееся использование дипфейков в Telegram, часто сочетаемых с поддельными голосовыми сообщениями. Упомянутая ситуация требует повышенного внимания со стороны пользователей социальных сетей и мессенджеров. Важно быть бдительным и критически подходить к любым просьбам о переводе финансовых средств, в том числе от знакомых лиц. Развитие ИИ открывает новые горизонты не только для положительных инноваций, но и для мошеннических схем. Всё это подчёркивает важность осведомлённости и предосторожности в цифровом мире. В России впервые оштрафовали компанию за воровство видео с дипфейком — в нём есть липовый Киану Ривз и утюг

06.12.2023 [16:36],

Павел Котов

Арбитражный суд Москвы взыскал с ООО «Бизнес-аналитика», управляющего аналитическим сервисом Roistat, компенсацию в размере 500 тыс. руб. за несанкционированное использование видео с дипфейком. В ролике использовался образ канадского актёра Киану Ривза (Keanu Reeves). Компенсация была присуждена создателю видео, компании «Рефейс Технолоджис», которая работает под брендом Agenda Media Group (AMG), сообщает Forbes.

Источник изображения: agenda.media На видеоролике человек, которому при помощи технологии дипфейка было дорисовано лицо Киану Ривза, пытается выйти из дома, но несколько раз возвращается и проверяет, выключил ли он утюг, — в итоге герой уносит утюг с собой. В июне 2023 года сервис Roistat начал распространять в Telegram рекламный ролик, в котором использовалось это видео. AMG специализируется на создании роликов с использованием дипфейков — компания также выпускала короткие постановки, используя образы Джейсона Стейтема (Jason Statham) и Роберта Паттинсона (Robert Pattinson). Ставший предметом разбирательства ролик имеет пародийный и юмористический характер, он направлен на завладение вниманием аудитории, а не прямое извлечение коммерческой выгоды. После выхода рекламы глава AMG Алексей Парфун обратился в Roistat, но администрация сервиса ответила, что «продукция нейросетей авторским правом не регулируется, можно брать и использовать». В ответ создатели видео подали в суд, «чтобы разобраться в юридической практике».

Источник изображения: succo / pixabay.com Решение суда было вынесено 30 ноября 2023 года. Как гласит его мотивировочная часть, «доводы ответчика о том, что созданный видеоролик не является объектом авторского права по причине использования технологии deep-fake, отклоняются судом, поскольку технология дипфейк — это дополнительный инструмент обработки (технического монтажа) видеоматериалов, а не способ их создания». Иными словами, при создании ролика был подготовлен сценарий; произведена видеосъёмка артиста, чьё лицо было заменено на образ Киану Ривза; создано аудиосопровождение; а использованная для подмены лица нейросеть оказалась одним из использованных рабочих инструментов, установил суд. Опрошенные Forbes специалисты, в частности, отметили, что современным нейросетям пока не под силу полностью генерировать видеоролики с настолько глубокой драматургией — ИИ выступает лишь как один из многих инструментов при производстве. При этом создатели ролика должны были также заручиться разрешением Киану Ривза на использование его образа — права артиста также были потенциально нарушены. Недавно схожую претензию за несанкционированное использование своего голоса в рекламе подала актриса Скарлетт Йоханссон (Scarlett Johansson). В 2021 году российский мобильный оператор «МегаФон» показывал серию рекламных роликов с использованием образа актёра Брюса Уиллиса (Bruce Willis) — при производстве видео также использовалась технология дипфейка, о чем компания предупреждала зрителей. «МегаФон» заключил с артистом контракт, действие которого к настоящему моменту завершено. Разработана система защиты голоса от создания дипфейков

29.11.2023 [15:49],

Павел Котов

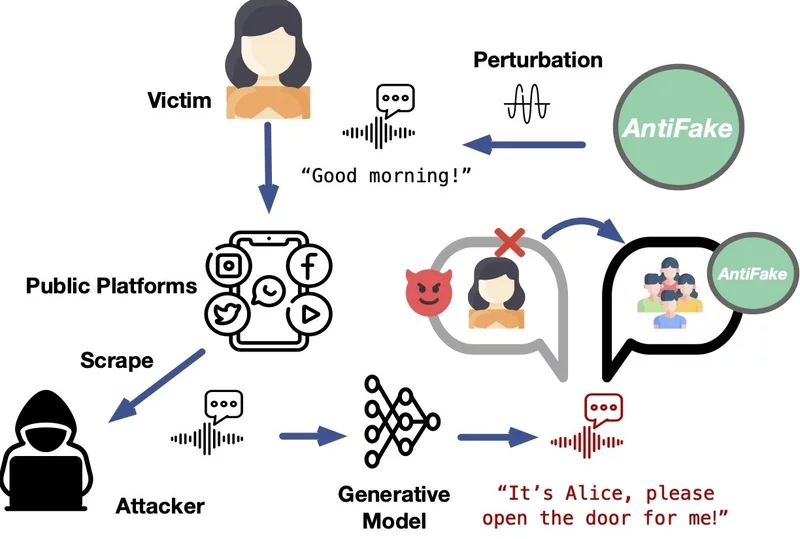

Технологии подделки голоса при помощи искусственного интеллекта являются довольно опасным инструментом — они способны правдоподобно воспроизвести человеческий голос даже по короткому образцу. Не допустить создание искусной подделки сможет предложенный американским учёным алгоритм AntiFake.

Источник изображения: Gerd Altmann / pixabay.com Дипфейки представляют собой достаточно опасное явление — с их помощью можно приписать знаменитому артисту или политику высказывание, которого он никогда не делал. Были также прецеденты, при которых злоумышленник звонил жертве и голосом друга просил срочно перевести деньги в связи с некой чрезвычайной ситуацией. Доцент кафедры компьютерных наук и инженерии Вашингтонского университета в Сент-Луисе Нин Чжан (Ning Zhang) предложил технологию, которая значительно усложняет создание голосовых дипфейков. Принцип работы алгоритма AntiFake состоит в формировании условий, при которых системе ИИ оказывается намного сложнее считывать ключевые характеристики голоса при записи разговора реального человека. «В инструменте используется техника состязательного ИИ, которая изначально применялась киберпреступниками, но теперь мы направили её против них. Мы немного искажаем записанный аудиосигнал, создавая возмущения ровно в той мере, чтобы для человека он звучал так же, а для ИИ — совершенно иначе», — прокомментировал свой проект господин Чжан.

Источник изображения: wustl.edu Это значит, что при попытке создать дипфейк на основе изменённой этим способом записи сгенерированный ИИ голос не будет похож на голос человека в образце. Как показали проведённые испытания, алгоритм AntiFake на 95 % эффективен для предотвращения синтеза убедительных дипфейков. «Что будет с голосовыми ИИ-технологиями дальше, я не знаю — новые инструменты и функции разрабатываются постоянно, — но всё же считаю, что наша стратегия использования техники противника против него самого так и останется эффективной», — заключил автор проекта. Американские актёры потребовали запретить студиям бесконтрольное использование дипфейков

14.07.2023 [16:23],

Павел Котов

Гильдия киноактёров США рассказала о борьбе, которую она ведёт со студиями за право контролировать цифровые копии артистов — студии, уверены в профсоюзе, хотят использовать их неограниченно. Представляющая студии организация заявила, что выдвинула «новаторское» предложение, которое поможет защитить актёров от подобных злоупотреблений.

Источник изображения: 0fjd125gk87 / pixabay.com Технологии искусственного интеллекта становятся больной темой для представителей актёрской профессии — они опасаются, что студии смогут бесконтрольно воспроизводить их внешний вид и голоса при помощи цифровых систем. Этот вопрос стал камнем преткновения в очередном раунде переговоров по поводу контрактов, которые должны заключаться с голливудскими студиями. Организация AMPTP, ведущая переговоры от имени Walt Disney, Netflix и других крупных игроков, заявила, что выдвинула «новаторское предложение по искусственному интеллекту», которое защитит актёров от возможных злоупотреблений. Эта мера защиты предполагает согласие актёра на создание и использование его цифровой копии либо на изменение его выступления при помощи цифровых средств, отметили представители студий и служб потокового видео. Дункан Крэбтри-Айланд (Duncan Crabtree-Ireland), главный переговорщик профсоюза SAG-AFTRA, представляющего интересы 160 тыс. актёров кино и телевидения, заявил, что это утверждение не соответствует действительности. «Они предлагают сканировать исполнителей, платить им за один день, чтобы компания владела этим отсканированным изображением, их подобием, и имела возможность использовать его вечно. Так что, если вы думаете, что это предложение новаторское, предлагаю вам подумать ещё», — цитирует Reuters Крэбтри-Айланда. В AMPTP возразили, что утверждение о возможности использовать цифровую копию артиста бессрочно без согласия или компенсации является ложным. По версии представителей студий и стримингов, в документе говорится, что договор об использовании цифровой копии заключается только на один фильм — дальнейшее применение технологий дипфейка требует согласия «отсканированного» актёра и переговоров о гонораре при условии, что он будет не меньше размера минимальной оплаты. Создано ПО, способное обмануть систему голосовой аутентификации в 99 случаях из 100

28.06.2023 [20:06],

Владимир Мироненко

Учёные-компьютерщики из Университета Ватерлоо создали программное обеспечение для дипфейка голосов, позволяющее в 99 % случаев обмануть систему голосовой аутентификации. Всё, что нужно при использовании этого ПО с поддержкой машинного обучения для клонирования голоса — пять минут аудиозаписи голоса человека.

Источник изображения: uk.pcmag.com Ведущий автор исследования Андре Кассис (Andre Kassis), кандидат наук в области компьютерной безопасности и конфиденциальности из Университета Ватерлоо, объяснил, как работает голосовая аутентификация: «При регистрации с использованием голосовой аутентификации вас просят повторить определённую фразу своим голосом. Затем система извлекает уникальную голосовую подпись (голосовой отпечаток) из этой предоставленной фразы и сохраняет её на сервере <..> При попытке аутентификации в будущем вас попросят сказать другую фразу, а извлечённые из неё характерные особенности сравниваются с голосовым отпечатком, сохранённым в системе, чтобы определить, следует ли предоставлять доступ». Как сообщается, даже меры противодействия спуфингу, используемые системами голосовой аутентификации, не позволяют заметить подмену, поскольку программа компьютерщиков из Университета Ватерлоо, удаляет маркеры из дипфейкового аудио, которые «выдают, что оно было сгенерировано компьютером». Сделав шесть попыток обойти систему аутентификации, учёные в 99 % добились успеха. Созданием поддельного голоса для обмана системы голосовой аутентификации никого не удивишь, но разработанное компьютерщиками ПО оказалось настолько эффективным, что профессор компьютерных наук Университета Ватерлоо Урс Хенгартнер (Urs Hengartner) выразил надежду, что компании, полагающиеся на голосовую аутентификацию как на единственный фактор аутентификации, «рассмотрят возможность развёртывания дополнительных или более строгих мер аутентификации». TikTok потребовал маркировать ролики с дипфейками

21.03.2023 [19:42],

Владимир Мироненко

Платформа коротких видео TikTok обновила правила сообщества. Как отметил ресурс The Verge, изменения включают новые ограничения на публикации сгенерированных силами ИИ дипфейков, которые становятся всё более популярными в приложении. Теперь автор должен явно указать в описании видеоролика или с помощью стикера на самом видео, что оно относится к «синтетическим и манипулятивным медиа».

Источник изображения: Pixabay Ранее правила TikTok в отношении дипфейков ограничивались запретом контента, который может «ввести пользователей в заблуждение, искажая правду о событиях [или] причинить значительный вред теме видео». TikTok отметил, что не допустит размещения «искусственных медиа, которые содержат изображение какой-либо реальной частной фигуры», демонстрируют поддержку публичной личностью какого-либо продукта, или же нарушают другие правила приложения (например, запрет на разжигание ненависти). Компания определяет в качестве общественных деятелей лиц в возрасте 18 лет и старше, занимающих «значительный общественный пост, например, государственного чиновника, политика, бизнес-лидера или являющихся знаменитостью». Обновление политики TikTok происходит на фоне усиления политического давления на материнскую компанию ByteDance в связи с опасениями правительств западных стран по поводу сбора личных данных приложением и его способностью влиять на общественное мнение. На данный момент приложение уже заблокировано для использования госслужащими в США, Великобритании, Новой Зеландии и в Канаде. Компания также опубликовала список из восьми «принципов сообщества», первыми среди которых являются «предотвращение вреда» и «обеспечение свободы слова». В настоящее время аудитория TikTok насчитывает 150 млн человек в США и более 1 млрд во всём мире. ИИ научили клонировать любые голоса для озвучки текста — в Сети тут же появились непристойные дипфейки с голосами знаменитостей

31.01.2023 [17:01],

Руслан Авдеев

Несколько дней назад стартап ElevenLabs представил бета-версию платформы для создания синтетических голосов-клонов реальных людей для озвучивания текстов. Буквально через несколько дней в Сети появились дипфейки голосов знаменитостей, озвучивающих крайне сомнительные тексты. По словам компании, отмечено «увеличивающееся число случаев злоупотребления клонированием голосов» — компания уже работает над решением проблемы с помощью введения дополнительных мер защиты.

Источник изображения: Kelly Sikkema/unsplash.com Что имелось в виду под злоупотреблением, в компании не уточнили, но уже известно, что на интернет-форумах появились аудиозаписи с голосами знаменитостей, содержащие высказывания неприемлемого содержания. Пока неизвестно, все ли материалы созданы с использованием технологии ElevenLabs, но значительная коллекция голосовых файлов содержит ссылку именно на платформу компании. Впрочем, ничего удивительно в этом нет, поскольку возникновение общедоступных систем машинного обучения привело к появлению многочисленных дипфейков различного рода. Сейчас ElevenLabs собирает обратную связь для предотвращения злоупотреблений технологией. На данный момент компания не придумала ничего необычного кроме добавления дополнительных мер верификации аккаунтов для обеспечения доступа к клонированию голосов. В числе идей: ввод платёжной информации или данных удостоверений личности. Дополнительно рассматривается верификация прав на использование голоса, который пользователи намерены клонировать, например, будет предложено загрузить образец с чтением предложенного текста. Наконец, компания рассматривает возможность полностью отказаться от инструмента Voice Lab и заставить проходить верификацию голосов в ручном режиме. Пока же пользователей призвали поделиться идеями с разработчиками сервиса. Известно, что в первой половине января схожее решение представила Microsoft. Её инструмент VALL-E тоже позволяет преобразовать текст в речь, использовав в качестве образца всего 3 секунды записи голоса любого человека. Intel представила FakeCatcher — технологию определения дипфейк-видео в реальном времени с точностью до 96 %

15.11.2022 [20:44],

Николай Хижняк

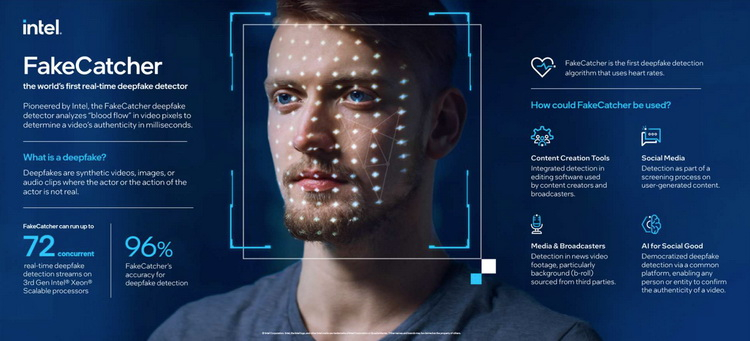

Компания Intel разработала технологию, способную в режиме реального времени отличить реального человека на видео от качественной подделки, выполненной силами ИИ, то есть дипфейка (deepfake). Разработку назвали FakeCatcher (англ. ловец подделок). Она использует программные и аппаратные средства Intel на уровне сервера, а взаимодействие FakeCatcher с пользователем происходит через веб-платформу.

Источник изображения: Intel В Intel отмечают, что FakeCatcher способен определить подделку на видео с точностью до 96 %. Технология с помощью ряда датчиков отслеживает изменение цвета лицевых вен под кожей участника видео, создавая пространственно-временные карты. Затем, алгоритмы машинного обучения по этим картам определяют, настоящий ли человек в кадре. По мнению Intel, их разработка может найти применение в социальных сетях. Также технологию могут использовать глобальные новостные СМИ, чтобы проверять поступающую информацию на достоверность. Обычные пользователи тоже могли бы использовать FakeCatcher в своих целях, считают в Intel. Однако для этого нужно, чтобы какая-либо некоммерческая организация взяла на себя поддержку этого направления. «Сбер» запатентовал технологии по распознаванию дипфейков

17.08.2022 [15:19],

Сергей Карасёв

«Сбер» получил два патента Федеральной службы по интеллектуальной собственности на технологии, касающиеся распознавания дипфейков. Разработанные алгоритмы позволяют повысить точность и эффективность обнаружения синтетического изменения изображений лиц людей в видео.

Источник изображений: pixabay.com Сообщается, что основу технологий составляет ряд ансамблей нейросетевых моделей класса EfficientNet (патент №2768797) и метод амплификации и анализа средствами ИИ микроизменений в цветах объектов на кадрах (патент №2774624). Эти инструменты объединены в одну систему, что позволяет с высокой точностью выявлять дипфейки. Важно отметить, что система способна анализировать видеоконтент с несколькими лицами в кадре. В этом случае выявляется отдельное лицо, созданное синтетическим образом, и оценивается его достоверность, что позволяет противодействовать ряду методов обхода систем обнаружения дипфейков.  Запатентованные технологии предназначены для защиты от кибератак с обходом систем Face Recognition и Liveness Detection, выявления на ранних стадиях информационных атак с целью борьбы с фейковыми новостями, а также для обеспечения защиты переговоров по видеоконференцсвязи. «Показатели эффективности системы при замерах на независимых тестовых выборках составили 98 %, что существенно выше показателей опубликованных аналогов», — заявляет «Сбер». Злоумышленники стали использовать дипфейки для дистанционного устройства на работу и кражи корпоративных данных

06.07.2022 [15:14],

Руслан Авдеев

Технологии т. н. «дипфейков» позволяют использовать ИИ-решения для создания ложных персонажей. С их помощью можно смоделировать видео или тембр голоса практически любого человека. По данным Федерального бюро расследований (ФБР), данные технологии стали часто практиковаться злоумышленниками для прохождения онлайн-собеседований при устройстве на удалённую работу.

Источник изображения: Sander Sammy/unsplash.com Недавно Центр рассмотрения жалоб на преступления в Сети, подведомственный ФБР (IC3), выпустил оповещение, в котором предупредил об участившихся случаях использования дипфейков и кражах персональной информации при подаче заявок на открытые вакансии и прохождении удалённых бесед для получения работы, предусматривающей деятельность не выходя из дома. Помимо относительно безобидных поводов использования дипфейков и обмана работодателей подобные средства могут использоваться злоумышленниками для внедрения злоумышленников на предприятия для получения конфиденциальной информации или выполнения прочих преступных действий. За короткое время технологии создания дипфейков стремительно эволюционировали, но наблюдательные зрители всё равно могут разглядеть подмену, например, несоответствие движений губ произносимым словам или звуки кашля и чихания, не совпадающие с мимикой человека на видео. По данным ФБР, с использованием дипфейков злоумышленники уже пытались устроиться на позиции, связанные с информационными технологиями и программированием, работой с базами данных и прочими вакансиями, так или иначе связанными с ПО. Некоторые из этих позиций предусматривают доступ к информации о клиентах бизнеса, финансовых данных, тем или иным базам или иной конфиденциальной информации, имеющей ценность на чёрном рынке. Компаниям и другим жертвам подобной активности в США рекомендуется обращаться в ФБР. Не исключено, что в России и окружающих её странах соответствующие технологии вскоре тоже найдут широкое применение. IT-гиганты признали правила ЕС, предписывающие борьбу с ботами, дипфейками и дезинформацией

17.06.2022 [15:55],

Руслан Авдеев

Meta✴, Twitter, Google и Microsoft, а также другие техногиганты и медиакомпании намерены единым фронтом бороться с онлайн-дезинформацией в соответствии с новейшим вариантом правил « Практического кодекса по дезинформации», опубликованных Еврокомиссией и наконец подписанным десятками структур.

Источник изображения: Austin Distel/unsplash.com Кодекс представляет собой набор обязательств, которые подписавшие его должны выполнять для борьбы с цифровыми фейками. Среди таких мер — демонетизация дезинформации, отказ в размещении рекламы рядом с фейковыми новостями или иной способ блокировки получения прибыли от распространения дезинформации онлайн. Кроме того, политическая реклама должна быть недвусмысленно маркирована. Дополнительно предусматриваются механизмы, с помощью которых данные с социальных медиаплатформ должны стать более «прозрачными» и доступными исследователям, а также должна поддерживаться и работа людей, занимающихся фактчекингом. Как сообщает The Register, ЕС обновил свои правила не в последнюю очередь из-за распространения фейковых аккаунтов, ботов и сгенерированных ИИ-системами дипфейков. Подписавшие документ обещают обнародовать свою внутреннюю политику, посвящённую борьбе с манипуляциями контентом, и должны доказать, что их алгоритмы, используемые для распознавания и модерации дипфейков, заслуживают доверия. На данный момент новый вариант кодекса подписали 33 организации, включая социальные платформы, вендоров программного обеспечения, медиакомпании и участников рынка рекламы. Хотя подписание добровольно, некоторые его положения обязательны к исполнению всеми компаниями в соответствии с европейским законом Digital Services Act (DSA) — их нарушение может повлечь штраф в размере 6 % от годовой выручки. У подписавших будет шесть месяцев на принятие мер по борьбе с дезинформацией. Ожидается, что они представят Еврокомиссии детализированные доклады о принятых мерах уже в начале 2023 года. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |