Google показала системы с собственными TPU, на которых обучаются ИИ-модели Gemini и Apple Intelligence

В большой лаборатории в штаб-квартире Google в калифорнийском Маунтин-Вью работают сотни серверных стоек, выполняя задачи, отличные от поисковой системы или рабочих нагрузок Google Cloud. Здесь тестируются тензорные процессоры (Tensor Processing Units —TPU), разработанные самой Google. Журналистам CNBC удалось заглянуть внутрь этой лаборатории.

Источник изображения: alban / unsplash.com

TPU от Google появились в 2015 и стали доступны облачным клиентам в 2018 году — они используются, в частности, для обучения моделей Apple Intelligence и Google Gemini. Google была первым поставщиком облачных услуг, который построил собственные чипы для ИИ — Amazon анонсировала свои Inferentia лишь три года спустя, а Microsoft представила Maia лишь в конце 2023 года. Но это первенство не помогло Google стать лидером в гонке генеративного ИИ: Gemini вышла более чем через год после OpenAI ChatGPT. При этом предложения в области ИИ помогли Google Cloud набрать обороты: этот сегмент в компании показал рост на 29 %, а квартальная выручка впервые превысила $10 млрд, гласит последний квартальный отчёт Alphabet.

В Google пришли к мысли о создании собственного чипа, когда в 2014 году задумались, какими должны быть ресурсы, чтобы все пользователи сервисов компании смогли пользоваться голосовым интерфейсом хотя бы 30 секунд в день. Как выяснилось, число компьютеров в центрах обработки данных было необходимо удвоить. Google TPU помог поднять эффективность при выполнении некоторых задач в 100 раз. В компании до сих пор используют и традиционные центральные процессоры, и графические процессоры Nvidia. Но Google TPU — это интегральная схема специального назначения (ASIC), предназначенная только для конкретного типа задач. В распоряжении компании есть ещё один такой чип — Video Coding Unit, и используется он для обработки видео.

Собственные чипы Google по примеру Apple стала использовать и в устройствах своей разработки: в смартфонах Pixel 9 это процессор четвёртого поколения Tensor G4, а в наушниках Pixel Buds Pro 2 — Tensor A1. Но важной отличительной чертой Google является серверный TPU — сейчас он занимает 58 % рынка среди облачных ускорителей ИИ собственной разработки. Графические процессоры Nvidia более гибкие, но и более дорогие и дефицитные в сегодняшних условиях, когда бум ИИ взвинтил акции компании до небес, и теперь она соперничает за звание самой дорогой публичной компании в мире с Apple и Microsoft. Настоящее испытание Google TPU ждёт, когда платформа Apple Intelligence в следующем году начнёт в полную силу работать на iPhone и Mac.

Разработка альтернативы ускорителям Nvidia — почти подвиг. Процесс настолько сложен и дорог, что даже Google не под силу сделать это в одиночку. С момента появления первого TPU компания заручилась поддержкой чипмейкера Broadcom, который помогает Meta✴ в решении той же задачи. Проект полностью разработанного чипа отправляется к полупроводниковому подрядчику — в его роли выступает TSMC, выпускающая 92 % передовой полупроводниковой продукции в мире.

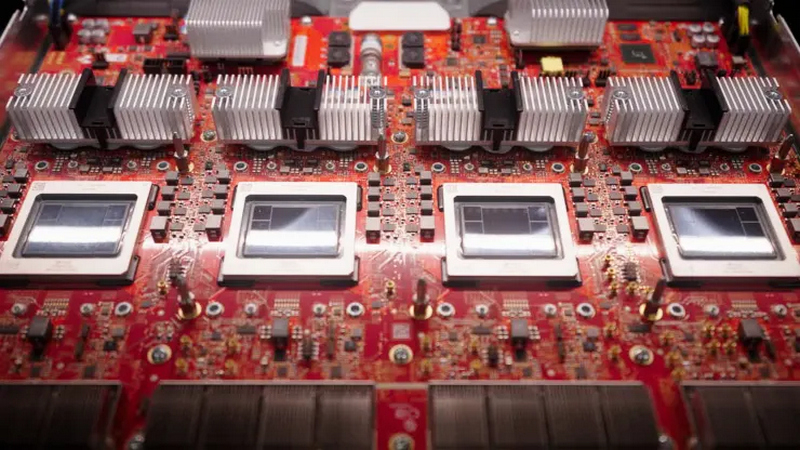

Trillium. Источник изображения: CNBC/Marc Ganley

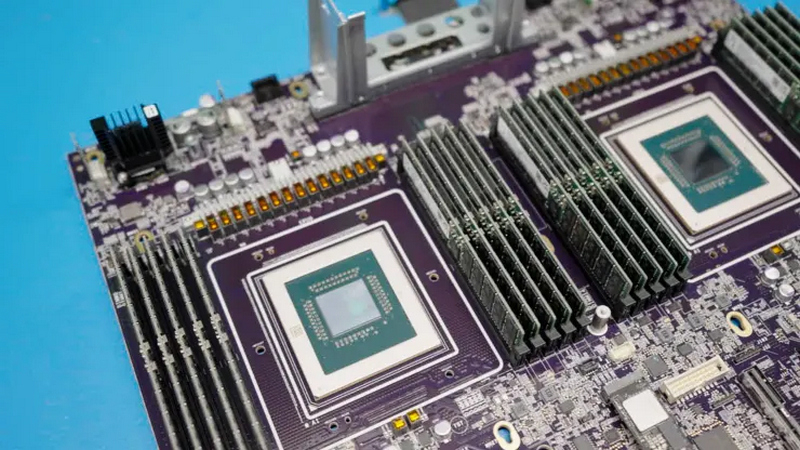

В этом году у Google выйдет шестое поколение TPU Trillium; кроме того, в минувшем апреле компания анонсировала и Axion — свой первый центральный процессор, который появится в конце года. И здесь Google уже не первая: Amazon выпустила свой Graviton в 2018 году, китайская Alibaba последовала её примеру в 2021 году, а Microsoft представила чип Cobalt 100 в ноябре прошлого года. Все они основаны на архитектуре Arm, более гибкой и энергоэффективной, чем x86, которой привержены Intel и AMD.

Axion CPU. Источник изображения: CNBC/Marc Ganley

Эффективность является важнейшим аспектом: если верить прогнозам, к 2027 году серверы ИИ будут потреблять столько же энергии в год, сколько Аргентина. Последний экологический отчёт Google показал, что выбросы компании с 2019 по 2023 гг. выросли на 50 % — отчасти из-за роста числа ЦОД для ИИ. Для охлаждения серверов для обучения и работы ИИ требуются огромные объёмы воды, поэтому с третьего поколения Google TPU охлаждение производится непосредственно на чипе — к такой же схеме прибегла и Nvidia с новейшими Blackwell. И, несмотря на сопутствующие трудности, оборудование Google для ИИ продолжает пользоваться большим спросом, и его ослабления в компании пока не отмечают.