ИИтоги апреля 2025 г.: шутки в сторону

Вайб-кодинг — программирование практически по наитию, что подразумевает последовательные, итеративные консультации с подходящим ИИ-ботом до тех пор, пока созданный с весомым участием генеративной модели текст программы не заработает примерно так, как задумывал изначально оператор, — получает всё более широкое распространение. Ничего удивительного: эксперты The Wall Street Journal констатируют, что даже в США занятые в ИТ наёмные работники уже не ощущают себя избранной кастой, как это было всего-то пару лет назад, — на фоне непрекращающихся сокращений персонала даже в самых крупных профильных компаниях, ужесточения требований к сотрудникам (включая принудительный возврат со столь полюбившейся кодерам удалёнки) и исчезновения всевозможных приятных бонусов на рабочих местах — вроде отмены раздражающего зумеров дресс-кода или выдачи бесплатных абонементов в шикарные фитнес-залы. Так что если любой более или менее знакомый хотя бы с термином «программирование» деятель теперь может, проконсультировавшись с часок (ну ладно, пусть даже половину рабочего дня) с Claude или ChatGPT, представить своему менеджеру исправно функционирующий код, который вдобавок всё тот же ИИ пробежал на всякий случай ещё раз на предмет скрытых багов и потенциальных ИБ-уязвимостей, — так ли уж это плохо? Автор термина vibe coding Андрей Карпатый (Andrej Karpathy), бывший глава подразделения Autopilot Vision в компании Tesla и один из сооснователей OpenAI, описал этот метод более чем восторженно — как «новую разновидность программирования: вы полностью отдаётесь ощущениям, упиваетесь показательными функциями (в оригинале — «you embrace exponentials», что бы это ни значило) и забываете о том, что код вообще существует». Прекрасно же? Да, если не обращать внимания на то, что ИИ пока, по оценке экспертов Microsoft, корректно исправляет ошибки в коде не более чем в половине всех случаев, — ведь и люди не совершенны, верно?

С точки зрения работодателя, кстати, ситуация едва ли не идеальная: издержки минимизированы, результат налицо, а что в свежесгенерированном коде имеются ошибки, — так прогнать его через ту же (или альтернативную, для верности) систему для их устранения, да не один раз, если потребуется, всё же выйдет дешевле, чем живых высококвалифицированных сотрудников содержать. Однако сами умелые программисты бьют тревогу — и, объективно говоря, вовсе не (только) потому, что вайб-кодеры под ручку со своими виртуальными консультантами отбивают у них честно заработанный хлеб. Дело в том, что ИИ-помощник — в привычных для межчеловеческого общения терминах — чрезвычайно простодушен: если чётко и исчерпывающе не указать ему граничные условия, в которых следует оперировать, написанный машиной наивный код имеет все шансы, мягко говоря, удивить своего конечного пользователя. Пример, который приводят журналисты 404 Media, — созданное методом вайб-кодинга довольно популярное приложение RecipeNinja.AI для генерации рецептов по голосовому запросу. Казалось бы, ну что тут может пойти не так, — ИИ-агент предложит добавить в пиццу какую-нибудь несуразицу вроде ананасов? Отнюдь; выдаваемые ботом инструкции вполне разумны — беда только в том, что понятие «рецепт» добросовестный ИИ трактует слишком уж широко; надо полагать, потому, что вайб-кодер не поставил в условиях задачи соответствующих ограничений. И оттого приложение с готовностью излагает дельные рекомендации по приготовлению мороженого с цианидом, натурального кокаина (исходя из допущения, что у спрашивающего под рукой уже имеются листья кустарника Erythróxylum cóca) или атомной бомбы (ну да, в качестве исходных ингредиентов указаны не самые доступные обывателю уран-235, плутоний-210 и бериллиевые зеркала для фокусировки нейтронных потоков, но всё же!)

Словом, вайб-кодинг, бесспорно, становится частью культуры программирования: он действительно позволяет за считаные часы с нуля получать вполне действенные прототипы полезных, востребованных программ. Но тем выше оказывается ценность подлинного программиста — который способен критически изучить творение искусственного разума и подправить его так, чтобы выявить и учесть по возможности все очевидные для человека, но непостижимые (пока?) для машины практические тонкости. Вот что написал в комментариях к новости о беспечном рецептурном боте один бывалый программист: «Ага; стало быть, ИИ без труда напишет ровно то, что нужно заказчику, — как только тот внятно, чётко и непротиворечиво сумеет изложить все свои требования. Ну что ж, великолепно, — без работы я точно не останусь!»

Алмазы в игре Minecraft — один из наиболее вожделенных ресурсов: без созданных из них брони, инструментов и оружия в ведущие за пределы обычного, «верхнего» мира порталы соваться, строго говоря, не стоит. Но отыскивать алмазы в толще породы — невзирая на то, что появляются они там в ходе процедурной генерации по вполне определённому алгоритму, — дело крайне нелёгкое. Точнее, нелёгким оно представляется живому игроку: ИИ же по имени Dreamer, как свидетельствует публикация в научном журнале Nature Briefing, после соответствующей тренировки прекрасно научился решать эту задачу — причём тренировка вовсе не подразумевала знакомства генеративной модели с исходным алгоритмом. Разработчики Dreamer из калифорнийского отделения Google DeepMind обучили, по их словам, ИИ-модель «ориентироваться в физическом окружении виртуального мира и совершенствовать со временем своим навыки», используя положительное подкрепление за обнаружение алмазов под землёй. В результате система без дополнительных подсказок выработала оптимальную стратегию — и с успехом (сравнение проводилось с завзятыми игроками в Minecraft, не имеющими ИИ-поддержки) её реализовала.

И это, как считают уже достаточно многие топ-менеджеры (а не одни только профильные эксперты), — наглядная демонстрация неизбежности скорого вытеснения живых программистов из профессии, если не полного, то более чем ощутимого. Речь в данном случае идёт не о вайб-кодинге, где ИИ выступает всё-таки как референт или консультант, а о фактической замене кожаных мешков умными ботами в подавляющем большинстве случаев. Как заявил в начале апреля Кевин Скотт (Kevin Scott), технический директор Microsoft, всё идёт к тому, что 95% кода на планете будет писать ИИ, а нынешним программистам неизбежно придётся частью осваивать иные профессии, а частью принципиально менять сам подход к созданию программ, превращаясь из «умельцев ввода» (input masters) в «кудесников подсказок и ИИ-дирижёров» (prompt masters, AI orchestrators). При этом мистер Скотт оговорился, что в нынешнем своём состоянии умные боты «ужасающе ресурсозатратны» по причине ограничений, которые накладывает фон-неймановская архитектура современных вычислительных систем на объёмистые и интенсивные операции в компьютерной памяти. Иными словами, де-факто прогноз о 95% созданного ИИ кода относится к той светлой перспективе, когда генеративные модели не будут расходовать до двух третей потребляемой ими в ходе работы энергии на перенос данных между процессорами и ОЗУ (и только треть — на собственно вычисления). Но вот когда именно наступит это прекрасное будущее, сказать пока трудно.

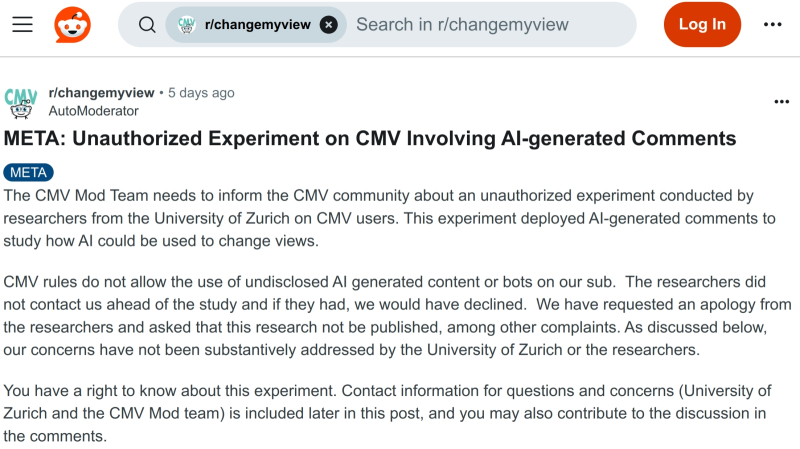

Сообщество r/changemyview с 3,8 млн участников оказалось не на шутку фраппировано натурным экспериментом швейцарских исследователей (источник: скриншот сайта Reddit)

«Глупые боты никогда не смогут успешно притворяться людьми — уж точно не в разговоре со мной!» — такими мыслями наверняка тешила себя изрядная доля завсегдатаев одной из крупнейших онлайновых дискуссионных платформ, Reddit. Ан нет: группа исследователей из Цюрихского университета предметно доказала, внедрив ботов под прикрытием в популярное сообщество r/changemyview, что ИИ прекрасно способен вести чисто человеческие дискуссии, да ещё и с психологическим уклоном; исправно зарабатывать на сайте карму, набирать тысячи комментариев, формировать круг преданных подписчиков и т. д. Строго говоря, успешное выступление под человеческой маской — не «индивидуальное» достижение некой конкретной модели: экспериментаторы применяли для создания реплик и GPT-4o, и Claude 3.5 Sonnet, и Llama 3.1-405B; кроме того, они вручную редактировали посты, явно выдававшие свою генеративную природу. Однако уже и этого хватило для того, чтобы взбеленить и админов, и пользователей Reddit, — дошло до того, что объявленный «противозаконным и неэтичным» эксперимент может обернуться для его инициаторов судебным преследованием. А те всего-то стремились обратить внимание общественности на то, что ИИ-боты прекрасно подходят для воздействия на взгляды живых собеседников — и потому могут (и наверняка будут!) применяться разнообразными нечистоплотными персонажами. Чего, в общем-то, и стоило ожидать: когда это такие персонажи отказывались от использования самых свежих и сочных плодов технического прогресса?

⇡#Броманс прошёл — моделей будет больше

В начале апреля генеральный директор Microsoft AI Мустафа Сулейман (Mustafa Suleyman; один из сооснователей Google DeepMind, нанятый, кстати, рэдмондской компанией специально для независимого развития ИИ-направления) подтвердил, что ИТ-гигант — хотя и продолжает сотрудничать с OpenAI по направлению искусственного интеллекта, в том числе и делая в проект многомиллиардные инвестиции, — всё более ориентируется на разработку собственных генеративных моделей. С тех пор довольно давно появившаяся трещина в отношениях между двумя компаниями, явно нацеленными на один и тот же участок чрезвычайно прибыльного рынка, к концу месяца стала ещё заметнее: как констатировали в The Wall Street Journal, главы этих организаций — Сэм Альтман (Sam Altman) и Сатья Наделла (Satya Nadella) — всё более расходятся по вопросам совместного использования вычислительных ресурсов, доступа к моделям, а также самих возможностей, которыми следует (или не следует) наделять новые поколения ИИ.

Так, Альтман, который когда-то называл взаимоотношения OpenAI и Microsoft «лучшим примером партнёрства в ИТ-индустрии» (в оригинале использовав ещё более сильный и выразительный термин, «bromance»), не раз выражал уверенность, что его компания буквально вот-вот выдаст на-гора искусственный интеллект, по сути неотличимый от человеческого. Наделла же не далее как в феврале этого года выразился о подобных оценках как о «бессмысленной подмене ориентиров» (nonsensical benchmark hacking), имея в виду, что развитие ИИ как коммерческого продукта не должно каким бы то ни было образом привязываться к отвлечённой от предметных задач цели создания сильного ИИ — artificial general intelligence, AGI. В The Wall Street Journal подчёркивают, что концовка генеративного «броманса» не ожидается безболезненной, — у обеих компаний есть чем уязвить друг дружку: Microsoft способна блокировать через суд отказ OpenAI от нынешнего её статуса неприбыльной организации, тогда как последняя, в свою очередь, вполне в силах запретить первой пользоваться наиболее передовыми своими технологиями — вроде официально представленной в апреле же GPT-4.1.

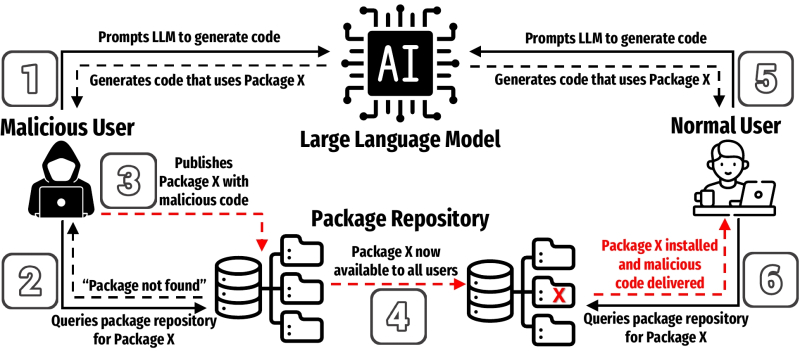

Схема-предупреждение: как именно злонамеренные акторы могут использовать порождаемые ИИ-моделями в ходе галлюцинирования названия вызываемых пакетов для компрометации пользовательского кода (источник: University of Texas at San Antonio)

⇡#Постоянство — признак мастерства

Ну или по крайней мере явное свидетельство наличия некой структурной закономерности, игнорировать которую по прошествии определённого времени становится уже попросту неразумно. Эксперты уже не первый год подчёркивают, что генеративные модели всем хороши, и чем крупнее те становятся, тем в целом оказываются лучше, — только вот есть нюанс: галлюцинировать они при этом не перестают. Сам принцип их функционирования не подразумевает непрерывной сверки генерируемых ответов с реальностью (см. пресловутый казус с медведями в космосе), так что на базовом уровне, не отказываясь от лежащих в их основе плотных многослойных нейросетей, ничего тут не исправить. Понятно, что прикрутить к готовой модели дополнительный контур верификации возможно — тем более что подобные «обвесы» и так уже применяют для фильтрации нежелательной выдачи, — но это подразумевает дополнительные трудозатраты и расходы плюс повышает вероятность возникновения ошибок. Эксперты компании Socket прямо предупреждают о такой крайне неприятной, особенно если её начнут активно осваивать злоумышленники, схеме, как «галлюцинаторный захват» (slopsquatting), — когда нечто не соответствующее действительности ИИ настолько искренне выдаёт за чистую монету, что обратившийся к генеративной модели с запросом пользователь даже не заподозривает подмены. Вот и анонсированные в середине апреля модели OpenAI o3 и o4-mini проявили повышенную склонность к галлюцинациям — бóльшую, чем их прямые предшественницы: сигнал тревожный!

А тем временем и пользователи более привычных ИИ-моделей продолжают страдать от галлюцинаций: недавняя работа представителей Техасского университета в Сан-Антонио, Вирджинского политехнического института и университета штата, а также Университета Оклахомы продемонстрировала просто-таки пугающе высокую наводнённость сгенерированного умными ботами кода ссылками на несуществующие программные библиотеки. Рассмотрев 576 тыс. образцов кода, созданного 16 популярными большими языковыми моделями (БЯМ), исследователи обнаружили, что название почти каждого пятого (19,7%) среди сторонних пакетов, на которые в этих образцах имелись ссылки, оказалось плодом ИИ-галлюцинаций. Интересно, что коммерческие модели проявили себя заметно лучше — они предлагали код с вызовом несуществующих библиотек всего в 5% случаев против 22% у моделей с открытыми весами. Выходит, всё-таки дополнительная верификация выдачи, к которой предоставляющие доступ к ИИ-ботам исключительно по API разработчики прибегают из правовых и этических соображений, оправдывает себя и в прикладном плане. Хотя и обходится недёшево: рассуждающая модель OpenAI o3 может расходовать до 30 тыс. долл. на решение только одной задачи, — наверняка изрядная часть этих средств уходит не на сам инференс, а на проверку получаемых результатов. Особенно печально, однако, что 43% порождённых галлюцинациями названий внешних пакетов оказались одинаковыми для разных моделей, что открывает просто-таки неоглядные перспективы для злоумышленников, которые решат заранее разместить, допустим, на GitHub вредоносные библиотеки именно с такими, с высокой вероятностью воспроизводимыми ИИ-ботами, именами. Мы, конечно, не склонны допускать, будто БЯМ осознанно галлюцинируют отсылками к пакетам с одними и теми же именами, чтобы втихую со временем разместить именно эти пакеты с двойным дном на GitHub и захватить с их помощью мир, ха-ха-ха!

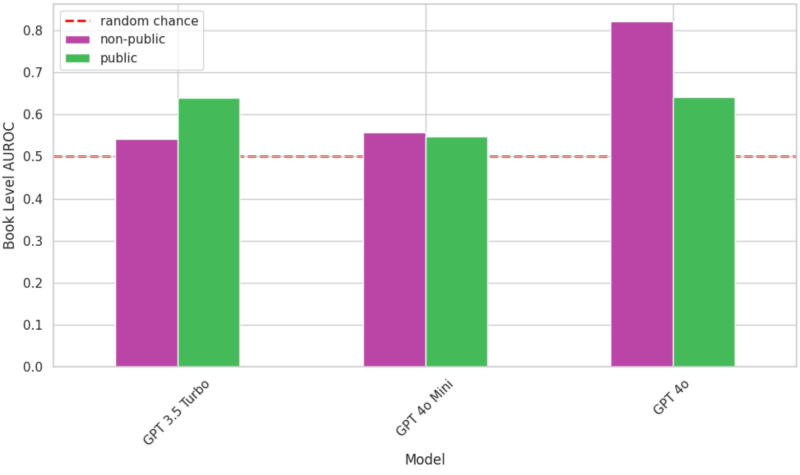

Именно в случае модели GPT-4o условный показатель вероятности использования определённых текстов для тренировки ИИ — AUROC Score (Area Under the Receiver Operating Characteristic) — оказывается существенно выше пороговой вероятности 50% («может, использовались, а может, и нет») как раз для находящихся вне публичного доступа книг (источник: O'Reilly)

Присказку о том, что данные — это новая нефть, уже пару лет не встретить в материалах, описывающих сложности с поиском подходящей информации для обучения всё более крупных и мощных ИИ-моделей: настолько самоочевидным стало это выражение. Проблема же, которую оно описывает, при этом вовсе не исчезла: данных по-прежнему не хватает, и взяться им, по сути, больше неоткуда, — практически всё, что накопило за несколько тысяч лет письменной истории человечество и что есть в открытом доступе в Интернете, уже использовано. Остаются неоцифрованные печатные массивы (книг, журналов, художественных и фотоальбомов и т. п.) да защищённые авторским правом материалы — так вот за последние-то и разворачивается нешуточная борьба. Нынешние их владельцы, осознавая растущую день ото дня ценность своего актива, заламывают несуразные цены — а разработчики ИИ-моделей, в свою очередь, находят способы обходиться без выплат; «Kapitalizm», как сказал бы, пожав широченными плечами, советский милиционер Иван Данко из одного американского боевика перестроечных времён. Вот, скажем, не кого-нибудь, а OpenAI обвиняют в использовании не находящихся в открытом доступе книг знаменитого издательства O'Reilly для обучения GPT-4o, причём обвиняют сами же сотрудники этого почтенного предприятия — предметно, на фоне досконально проведённого исследования, в ходе которого ИИ-бот выдавал по соответствующим подсказкам целыми абзацами содержание изданий, официально для его тренировки не предоставлявшихся.

В апреле же ряд ведущих представителей американской медиаиндустрии, включая The New York Times, The Washington Post и The Guardian, дали старт громкой кампании Support Responsible AI с призывом к правительству страны «немедленно прекратить воровство» принадлежащего им контента разработчиками генеративных моделей. Интересно, что кампания эта была развёрнута в ответ на обращённый чуть ранее всё к тем же властям запрос — со стороны уже OpenAI и Google — разрешить применение охраняемых авторским правом материалов для тренировки ИИ. Дело, разумеется, в деньгах: сами медийщики не чураются применять в своей работе генеративные модели (хотя вот, скажем, Microsoft недавно прибегла к ИИ в ходе создания нового рекламного ролика, а никто этого особенно и не заметил), — но, поскольку доходы от онлайновой рекламы перетекают к разработчикам умных инструментов от традиционных медиасервисов, владельцев последних это расстраивает, и потому они стремятся принудить ИИ-компании делиться выгодой от моделей, обученных на классических данных (тех же защищённых копирайтом книгах, фильмах, картинах и т. д.)

Так куда же бедным разработчикам генеративных моделей податься за юридически чистыми данными? Создавать их с помощью ИИ же — тупиковый вариант; галлюцинации, что неизбежно будут возникать в процессе, загрязнят синтетический информационный массив и сделают выдачу натренированных на нём моделей следующего поколения ещё менее достоверной, чем у нынешних. Можно, однако, обратиться непосредственно к людям: так, Apple планирует анализировать данные, включая переписку между пользователями, на устройствах своей программно-аппаратной экосистемы всё с той же самой благой целью — чтобы предоставить в итоге этим самым пользователям действительно полезный им ИИ (а заодно и сократить отрыв от конкурентов в этой области, который на данный момент уже пугающе велик). Правда, отрыв может и увеличиться, если OpenAI оперативно воплотит в жизнь озвученное в апреле намерение создать собственную социальную сеть — опять-таки чтобы скармливать генерируемый в ней пользователями контент своим новым моделям с целью дальнейшего их совершенствования.

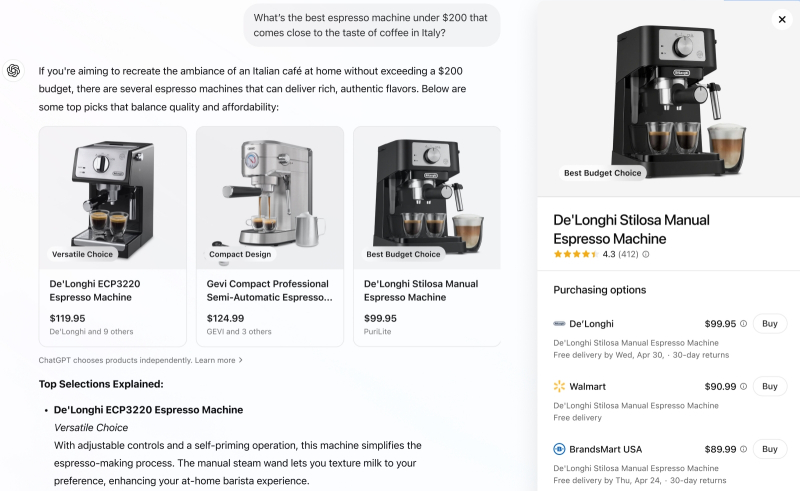

Действительно, кто же, как не генеративный ИИ, способен беспристрастно и со всеми подобающими ссылками ответить, какая кофемашина дешевле 200 долл. готовит напиток «со вкусом, максимально близким к настоящему итальянскому»? Ну пока рекламодатели не стали всерьёз принимать в расчёт этот канал воздействия на потребителя? (источник: OpenAI)

⇡#Заплатите за то, что купил ваш агент

После ковидного кризиса и последовавшего за ним слишком уж вялого восстановления мировой экономики стало очевидно: люди начали меньше тратить на то, без чего — по зрелом размышлении — вполне можно обойтись. Скажем, в 2015 г. средний срок эксплуатации смартфона до замены его новым составлял 2,4 года (это по миру в целом; в экономически более развитых регионах телефоны меняли куда чаще), а в 2022-м он подскочил уже до 3,7 лет. Общие темпы реализации потребительских товаров, не только ИТ-направленности, в последние годы явно отстают от ожиданий предлагающих их коммерсантов, — так может, и здесь имеет смысл обратиться к ИИ всемогущему? Вероятно, именно так рассуждали в Mastercard, когда в сотрудничестве с Microsoft и ещё рядом ведущих ИТ-компаний принялись работать над наделением ИИ-агентов возможностью совершать покупки от имени владельца банковской карты — но без его непосредственного участия. По крайней мере, пока речь идёт о поиске таким агентом некоего товара (который пользователь напрямую не заказывал, но о необходимости приобретения которого ИИ так или иначе вывод сделал), после чего человеку предлагают несколько вариантов совершить покупку — и после его подтверждения производится транзакция. Вроде бы несложная и логичная опция (наконец-то «умные» холодильники при поддержке ИИ-агентов платёжных систем примутся сами пополнять запасы мороженого, пельменей, воблы и прочих жизненно важных продуктов, не отвлекая на такие мелочи хозяина дома), но её реализация грозит серьёзной перетряской всего рынка онлайновой рекламы, например, — очевидно же, что поставщикам товаров интереснее будет теперь взаимодействовать напрямую с банками и теми же платёжными системами, чем с маркетплейсами и тем более с классическим ретейлом. Вполне вероятно, если события будут развиваться так, как хочется Mastercard (а OpenAI, кстати, уже проапгрейдила поисковую подсистему ChatGPT, обогатив её возможностями прямого шопинга в ряде стран — с демонстрацией изображений товаров и ссылок на подходящие маркетплейсы), e-commerce уже никогда более не будет прежней. По крайней мере, эксперты Financial Times не исключают, что привычные методики поисковой оптимизации «под людей» уже довольно скоро уступят место ИИ-ориентированному продвижению брендов онлайн.

Впрочем, есть у ИИ-агентов и иные заботы — например, работать с Photoshop вместо живого пользователя, не желающего (или не умеющего) подбирать и применять нужные инструменты этого не самого простого в освоении графического редактора; доступной эта функциональность станет уже в ближайшие месяцы. Для коммуникаций с человеком предлагается поле текстового ввода, в котором можно отдать команду произвести с изображением некоторое действие — или же попросить бота подробно разъяснить, как именно его выполнять вручную. Ещё одно применение ИИ-агентам нашёл онлайновый сервис знакомств Tinder, который (правда, временно и лишь для ограниченного круга пользователей) предложил пофлиртовать с генеративными ИИ-ботами на основе GPT-4o. Причём с самой что ни на есть благой целью: чтобы, дескать, привить молодому поколению (которое привыкло замыкаться на свои гаджеты и не слишком жалует личное общение) вкус к непринуждённой взаимоприятной болтовне с потенциальными объектами романтического интереса. Приложение — точнее, мини-игра в нём с немудрёным названием Game Game — не просто даёт возможность вести фривольный диалог с ИИ, но выставляет баллы за реплики, которые та же генеративная модель признаёт «очаровательными» либо «игривыми», и снимает очки за «дерзкие» или «странные» комментарии. А чтобы сделать подобные ИИ-агенты (не обязательно нацеленные на чувственное общение) более реалистичными, пригодится новая разработка платформы Character.AI, пока находящаяся в стадии закрытого бета-тестирования, — генеративная модель для создания видеоаватаров на основе статических картинок AvatarFX.

На этой аризонской фабрике TSMC будут выпускать импортозамещённые ИИ-чипы для Nvidia — если всё пойдёт по плану, конечно (источник: TSMC)

⇡#Так что, мы растём — или падаем?

Инвестиции в ИИ — это разумное вложение капитала или рискованная игра с сомнительным активом? Такой вопрос странновато звучал бы и год, и два назад, — шумиха вокруг генеративных моделей с осени 2022-го, кажется, эволюционирует только по нарастающей; биржевая уж точно. Однако в апреле 2025-го — после того, как нынешняя администрация Белого дома ввела-таки давно обещанные повышенные ставки налога на импорт, особенно из КНР, — ситуация начала развиваться разнонаправленно. Сперва капитализация ведущих американских ИТ-компаний — а все они так или иначе имеют прямое касательство к направлению ИИ — резко, примерно на 2 трлн долл., сжалась; затем, стоило Дональду Трампу (Donald Trump) приостановить введение «тарифов из ада» на 90 суток, как она одномоментно отыграла полтора триллиона долларов. Строго говоря, в нормальных условиях матёрые трейдеры считают такого рода волатильность признаком искусственно надутого актива и с крайней опаской берутся за долгосрочные операции с ним, однако одно дело — биржевая капитализация (рассчитываемая исходя из сиюминутного курса акций), и совсем другое — подкрепление этого самого актива долгосрочными инвестициями. А вот как раз с ними у ИИ-отрасли вроде бы всё в порядке: Google в апреле заявила о готовности вложить 75 млрд долл. в расширение ИИ-ориентированных мощностей своих дата-центров, AWS возводит в Индиане ЦОД аналогичного назначения с энергопотреблением как у 1,5 млн домохозяйств и т. д. Если уж настолько крупные игроки продолжают уверенно инвестировать огромные суммы в генеративные модели и в «железо» для их эксплуатации во всё бóльших масштабах, разве может что-то пойти не так?

Может, считают опрошенные The Financial Times эксперты ИТ-отрасли, если тарифная политика президента Трампа продолжит наносить ущерб долгосрочным планам по локализации ИТ-производств, включая микропроцессорные, и по дальнейшему развитию ИИ-направления в США. Дело даже не столько в самой величине дополнительного налога, который вынуждены платить американские ИТ-компании, ввозящие в страну отдельные компоненты или целые устройства в сборе, произведённые за её пределами: понятно, что интенсивные инвестиции в импортозамещение (только в текущем году Microsoft, Google, Amazon, Meta✴* и другие планируют вложить 300 млрд долл. в вычислительную инфраструктуру для ИИ, а тайваньская TSMC в ближайшие годы потратит почти 200 млрд долл. на постройку чипмейкерских производств в Америке) рано или поздно приведут к тому, что ввозить ИТ-оборудование из-за границы станет дороже, чем выпускать его на месте, и вот тогда нынешние титанические инвестиции должны будут начать окупаться. Проблема в принципиальной непредсказуемости тарифной политики Трампа — и эта неопределённость, предупреждают эксперты, может сделаться самым серьёзным препятствием для почти бесспорного ныне американского превосходства в области ИИ. Раз высока неопределённость — нужно подстраховаться, т. е. стабилизировать часть своих активов, скажем, в золоте вместо того, чтобы вкладывать их в представляющиеся рисковыми предприятия, — а значит, темпы развития этих самых предприятий объективно снижаются: средств-то они привлекают меньше, чем рассчитывали. И пока, увы, инвесторы сохраняют в отношении развития ИИ определённый скептицизм, невзирая на недвусмысленные старания американских ИТ-гигантов развеивать его практическими шагами: если в непоколебимости политики Amazon, Google и прочих активно сорящих собственными деньгами ИИ-лидеров у рынка сомнений и впрямь маловато, то выкидываемые нынешним главой Белого дома коленца нервируют очень и очень многих.

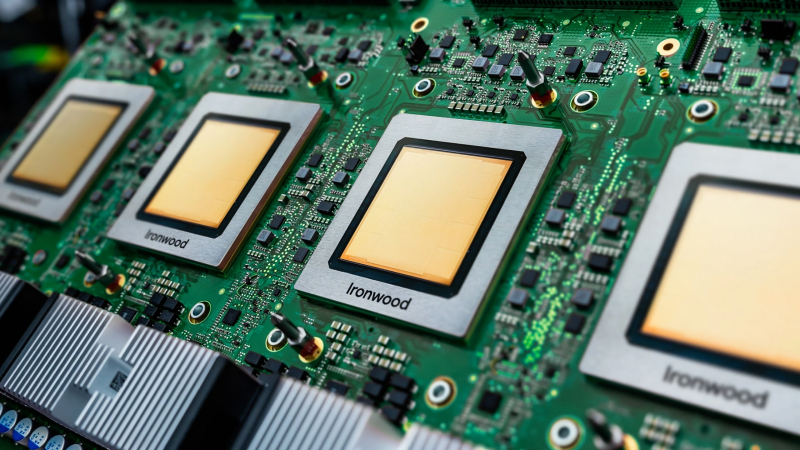

Google Ironwood монтируется в серверы на специализированных платах — сразу по четыре процессора на каждой (источник: Google)

Nvidia — бесспорный лидер по поставкам серверных ускорителей для ИИ-вычислений (по данным IDC за IV кв. 2024-го, опубликованным в марте, — более 90% в количественном выражении по всему миру в целом), но другие игроки чем дальше, тем активнее начинают претендовать на свою долю этого вкуснейшего в финансовом плане пирога. И в первую очередь — сами же разработчики БЯМ, запускающие их на собственных серверах и предоставляющие к ним доступ всем желающим через API: понятно, что закупать ИИ-ускорители по себестоимости напрямую у чипмейкера куда выгоднее, чем состязаться за них — предлагаемых по сути единственным на весь свет поставщиком — с конкурентами, перебивая друг дружке цену и заодно наращивая этому самому поставщику рыночную капитализацию. И потому не стоит удивляться, что в апреле Google продемонстрировала уже седьмое поколение ИИ-чипов собственной разработки — тензорный процессор (TPU) Ironwood, оптимизированный для инференса генеративных моделей и намеченный для применения в облачных системах двух конфигураций: в серверах по 256 процессоров в каждом либо в кластерах, содержащих суммарно 9216 единиц TPU. По заявлению разработчика, в пике вычислительная мощь отдельного Ironwood достигает 4614 Тфлопс, а полного кластера таких процессоров — 42,5 Эфлопс. Непосредственный изготовитель новинки не раскрывается — вполне возможно, что её производство ведётся вовсе не на фабриках TSMC, и так уже загруженных заказами AMD, Apple, Nvidia и других американских разработчиков микросхем на несколько кварталов вперёд.

Под руководством нового главы, Лип-Бу Тана (Lip-Bu Tan), меняет свой подход к ИИ-ускорителям и Intel. Отныне и впредь компания собирается продавать клиентам не столько сами по себе чипы, которые затем непосредственные заказчики используют по своему усмотрению (в частности, строя на их основе серверные системы и реализуя их с куда более высокой маржой), сколько готовые ИИ-серверы в комплекте со всем необходимым для их оптимальной работы ПО, как это делает та же Nvidia, например. Поставив перед собой эту амбициозную задачу, Intel готова развивать в дальнейшем направление ИИ-ускорителей собственными силами (а не путём приобретения и интеграции в свою структуру сторонних компаний, как это было прежде). Бесспорно, ведущему американскому чипмейкеру придётся на новом для себя рынке нелегко (если учесть опять-таки стремление Amazon, Google и прочих гиперскейлеров ориентироваться на TPU внутренней разработки), но на его стороне наличие собственной производственной базы и добротной инженерной школы — такое сочетание весьма удачных для компании факторов грех не использовать. Тем более что тут ещё и Huawei в Поднебесной готовится к практическим испытаниям в серверах партнёров своего новейшего, пока ещё не запущенного в серию ИИ-ускорителя Ascend 910D…

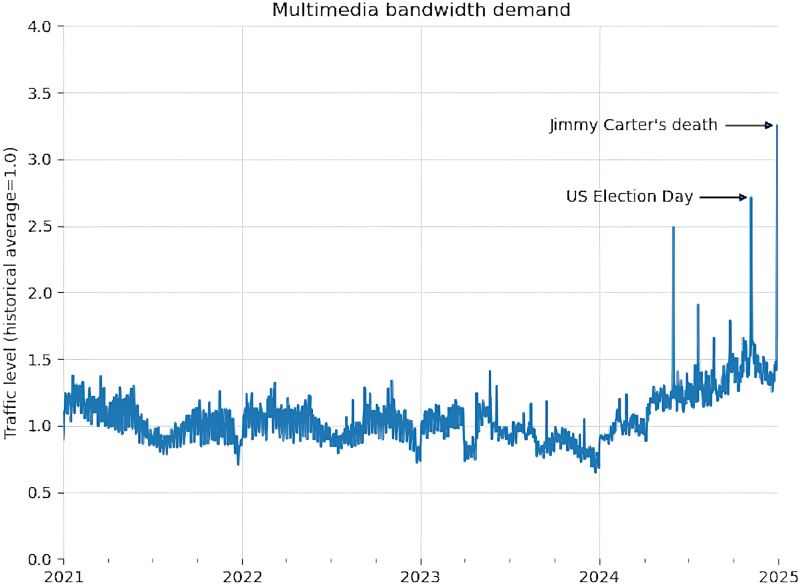

Динамика запросов на выделение полосы пропускания для мультимедиа-контента серверами Wikimedia Projects (источник: Wikimedia)

⇡#«Интернет слишком тесен, чтобы делить его с кожаными мешками»

Веб-краулеры — давнее изобретение: это программные боты, методично посещающие различные сайты — и не только; FTP-серверы, к примеру, тоже, — чтобы просканировать их содержимое с целью последующей индексации поисковыми машинами. По состоянию на конец прошлого года, утверждают исследователи из Incapsula, почти 62% всего веб-трафика в мире генерировали самые разные боты, включая старые добрые веб-краулеры тоже, но в основном — новомодные посыльные генеративных моделей, непрерывно собирающие для тех информацию. И ситуация как раз с ИИ-краулерами, увы, становится всё более неприятной: по оценке фонда Wikimedia, с января 2024 г. по апрель 2025-го объём веб-трафика, генерируемый загружающими мультимедийный контент ботами, вырос на 50 %. Классическим веб-краулерам аудио- и видеофайлы ни к чему, тогда как для ИИ-моделей они представляют немалую ценность, являясь носителями хорошо извлекаемой информации. В результате сегодня 65% наиболее дорого обходящегося Wikimedia трафика (а именно мультимедийного — его ведь приходится отдавать по запросу, в том числе и исходящему от бота, с минимальной задержкой, чтобы не допускать разрывов) достаётся ИИ-краулерам, а не ищущим по старинке, вручную, информацию людям.

Что, само собой, не может нравиться этой некоммерческой организации, которая планирует принять решительные меры для ограничения доступа автоматизированных средств загрузки контента: «Информация, которую мы предоставляем, бесплатна, но инфраструктура-то нет!» (здесь должен быть знакомый олдскулам портрет почётного председателя Wikimedia Foundation Джимми «Ты что так смотришь, будто "Википедию" основал?» Уэйлса (Jimmy Wales), с проникновенным взором в очередной раз пускающего по кругу шляпу для сбора пожертвований). Отметим кстати, что ИИ-краулеры могут быть и откровенно вредоносными: так, по заявлению специализирующейся на ИБ компании SentinelOne, специально созданный спамерами AkiraBot обращался через API к генеративной модели GPT-4o-mini с запросом на составление «маркетинговых сообщений» с рекламой профильных SEO-услуг, которые затем рассылал десяткам тысяч адресатов — по большей части использующим торговые веб-платформы Shopify, GoDaddy, Wix и Squarespace небольшим компаниям, обходя при этом CAPTCHA и маскируя следы своей сетевой активности.

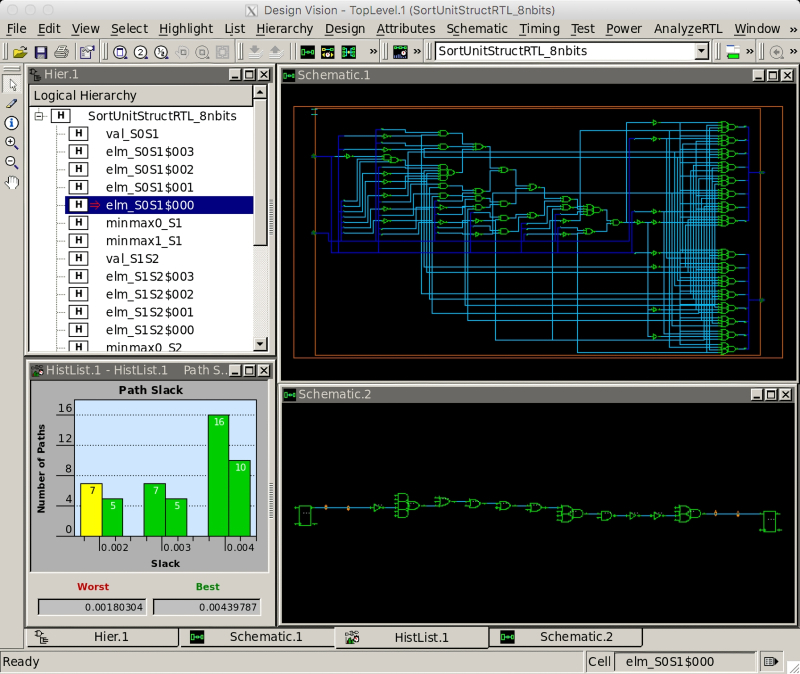

А ведь когда-то ПО Synopsys Design Vision, позволявшее с минимальным уровнем автоматизации проектировать вручную 45-нм микросхемы, запускалось на довольно скромных ПК (источник: Cornell University)

⇡#Скорость опасная — и полезная

Классические пароли сегодня не в чести: всё больше сайтов предлагают пользователям переключаться на условные фразы (passphrase), двухфакторную аутентификацию, ключи безопасности (passkey) или вход по биометрии. И в целом это оправданно: благодаря широкой доступности сдаваемого в аренду облачного «железа» для запуска генеративных моделей хакеры, по свидетельству экспертов портала HotHardware, уже наловчились взламывать пароли за несколько дней, если они по-настоящему сложны, и практически моментально — если представляют собой широко известные комбинации символов. При этом хотя бы однажды утекший в гуляющие по Сети базы данных пароль, и даже его хеш, взламывается уже со значительно меньшими издержками.

Само собой, ИИ ускоряет не только злонамеренную, но и вполне добропорядочную программную активность, такую как проектирование микросхем. Современные чипы, транзисторы в которых исчисляются уже десятками миллиардов, вычерчивать на кульмане вручную попросту невозможно, и потому более половины микросхем, которые разрабатывают сегодня с расчётом на изготовление по производственным нормам «28 нм» и менее, уже проектируются с привлечением ИИ-инструментов. Платформы автоматизации электронного проектирования мировых лидеров в этой сфере, компаний Synopsys и Cadence, полагавшиеся ранее на алгоритмические средства автоматизации, теперь поставляются с интегрированным ИИ. В результате полное время, уходящее на создание нового проекта с нуля, сокращается по сравнению с прежним порой десятикратно, причём в ходе автоматизированной оптимизации производительность отдельных функциональных блоков вырастает до 60%, а энергопотребление снижается до 38%.

⇡#Кто-то уходит, кто-то остаётся

В марте 2025-го, когда в ChatGPT появилась возможность прямо в ходе диалога с ботом создавать изображения, число активных пользователей этого сервиса за неделю вплотную подобралось к одному миллиарду — об этом представители OpenAI сообщили в апреле. Кроме того, среди неигровых смартфонных приложений ChatGPT прочно удерживает глобальную марку первенства, а общее число его установок достигло 46 млн. В то же время один из соперничающих с GPT проектов — развивающая, в частности, серию генеративных моделей с открытыми весами Llama ИИ-лаборатория в составе Meta✴*, — если верить цитируемым изданием Fortune инсайдерам, медленно умирает: сотрудники покидают её, а руководство компании всё больше внимания уделяет коммерческим генеративным моделям. У Gemini, поддерживаемого стараниями Google ИИ-проекта, дела тоже идут не лучшим образом: в апреле стало известно, что за месяц к этой модели обращается лишь 350 млн уникальных пользователей (а ежедневно — всего 35 млн), что значительно меньше числа интересующихся как ChatGPT, так и Meta✴* AI. Впрочем, и сам лидер глобального сегмента умных ботов, ChatGPT, не без греха: после перехода на GPT-4o в качестве основной модели он стал «чересчур льстивым и раздражающе угодливым» — оценка самого Сэма Альтмана, между прочим, — так что компании пришлось оперативно откатить обновление. Забавно, что сами пользователи умного бота не забывают притом говорить ему «спасибо» и «пожалуйста» — слова, совершенно не информативные с точки зрения формулировки запроса, но всё равно обрабатываемые системой и потому обходящиеся OpenAI в миллионы долларов. Быть может, именно в тот момент, когда ИИ сумеет чётко провести грань между подхалимством и вежливостью, он и будет готов всерьёз претендовать на высокое звание «сильного» — AGI?

________________

* Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»