|

Опрос

|

реклама

Быстрый переход

Character.AI и Google урегулировали иски о подростковых самоубийствах после общения с ИИ

08.01.2026 [17:16],

Павел Котов

Character.AI и Google заключили мировые соглашения с подавшими на них в суд членами семей подростков, причинивших себе вред или совершивших самоубийство после общения с чат-ботами Character.AI.

Источник изображения: Wesley Tingey / unsplash.com Подробности схемы урегулирования пока неизвестны. Стороны уведомили федеральный суд во Флориде, что достигли «принципиального согласия с участием посредника по урегулированию всех претензий» и попросили приостановить дело, чтобы заключить окончательное соглашение. Среди приостановленных исков — громкое дело Меган Гарсии (Megan Garcia), которая в 2024 году заявила, что её 16-летнего сына Сьюэлла Сетцера (Sewell Setzer) подтолкнул к уходу из жизни чат-бот по мотивам «Игры престолов»; до этого у подростка развилась «зависимость» от персонажа на основе искусственного интеллекта. Истец утверждала, что Google следует рассматривать как соавтора сервиса, потому что поисковый гигант «сделал вклад в виде финансовых ресурсов, персонала, интеллектуальной собственности и технологий ИИ» в эту службу — её запустили бывшие сотрудники Google, которых компания впоследствии приняла на работу обратно. После подачи иска Character.AI объявила о внесении изменений в свой чат-бот, чтобы защитить пользователей: для тех, кто не достиг 18 лет, компания подключила отдельную большую языковую модель, ввела строгие ограничения на материалы и добавила функции родительского контроля. Впоследствии участие в открытых чатах с персонажами было для несовершеннолетних закрыто полностью. Две компании также смогли договориться с истцами по делам, возбуждённым в Колорадо, Нью-Йорке и Техасе. Мировые соглашения ещё предстоит окончательно оформить и утвердить в суде. После скандала Character.AI закрыла свободные чаты для детей — вместо них появились безопасные «Истории»

26.11.2025 [19:26],

Владимир Фетисов

Платформа Character.AI после столкновения с угрозой нескольких судебных исков из-за негативного влияния на психическое здоровье подростков запретила несовершеннолетним взаимодействовать с открытыми чатами. Вместо этого для таких пользователей сервис запустил «Истории», которые в отличии от обычных чатов предлагают «структурированное» виртуальное приключение с участием ИИ-персонажей.

Источник изображения: Character.AI Формат историй доступен всем пользователям Character.AI, но разработчиками он позиционируется именно как способ «улучшить» опыт взаимодействия с ИИ-персонажами для несовершеннолетних. Ещё в прошлом месяце Character.AI объявила, что чаты будут закрыты для подростков с 25 ноября. Параллельно с этим разработчики сообщили о скором запуске функции для проверки возраста пользователей, которая будет автоматически направлять несовершеннолетних пользователей в «более консервативные» ИИ-чаты. Эти меры были приняты после того, как на Character.AI подали в суд, обвинив в том, что платформа способствовала доведению до самоубийства подростка. По мнению истца, взаимодействие несовершеннолетних с ИИ-персонажами также наносит вред их психическому здоровью. Новый формат «Истории» работает по следующему принципу: пользователь может выбрать двух или трёх персонажей, задать жанр, а затем написать самостоятельно описание сюжета или предоставить такую возможность ИИ-алгоритму. Затем платформа сгенерирует «управляемое повествование», где пользователю часто будет предоставляться возможность выбора для изменения хода истории. В «Историях» также используются изображения, сгенерированные ИИ, а в будущем разработчики планируют добавить «более разнообразные мультимодальные элементы». Character.AI запустила генерацию видео, а персонажи теперь могут говорить

03.06.2025 [06:15],

Анжелла Марина

Платформа Character.AI с функциями чат-бота для диалогов с ИИ-персонажами представила новые мультимедийные функции. Среди них — генератор видео AvatarFX, а также инструменты Scenes и Streams, позволяющие создавать ролики с ИИ-персонажами и делиться ими в социальной ленте.

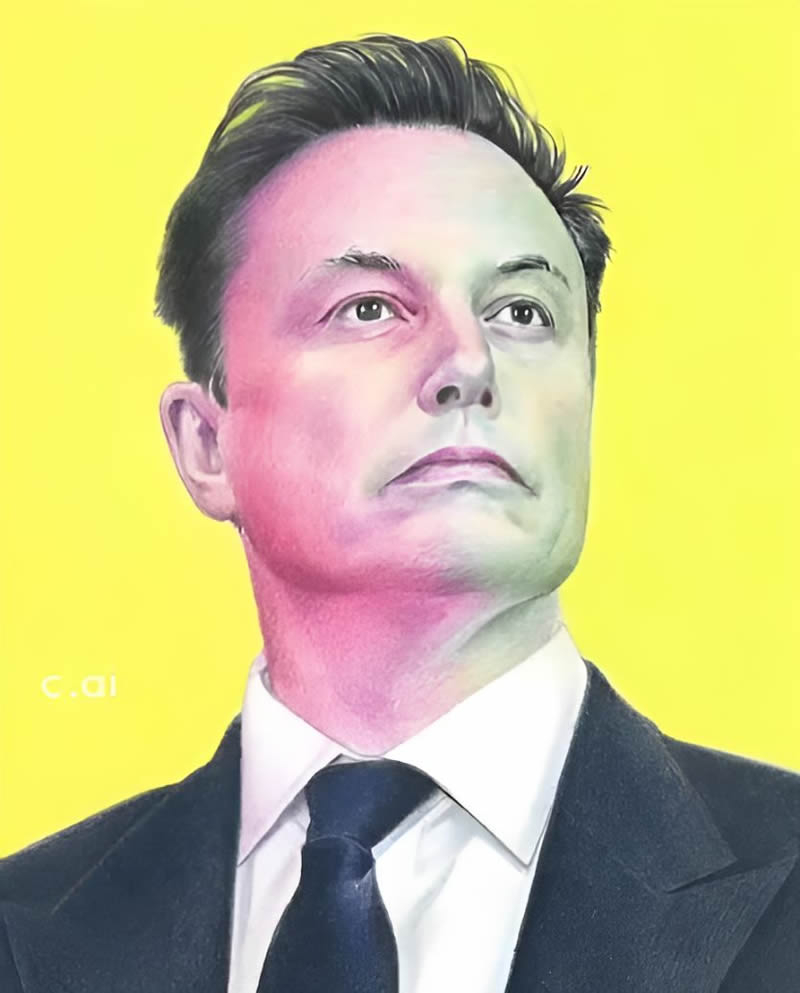

Источник изображения: Character.AI Ранее сервис работал только в текстовом формате, но теперь, по словам представителей компании, развивается в сторону большей интерактивности. Сейчас пользователи могут создавать до пяти видео в день с помощью AvatarFX. Для этого нужно загрузить изображение, выбрать голос и написать реплики для персонажа. Также есть возможность использовать аудиофайл для настройки голоса, но эта функция, как отмечает TechCrunch, пока работает нестабильно. Видео можно превращать в сцены (Scenes), представляющими из себя мини-истории с заранее заданными сюжетами от других пользователей. Пока эта опция доступна только в мобильном приложении, но скоро появится и в веб-версии. Функция Streams, позволяющая создавать динамические диалоги между двумя персонажами, выйдет на всех платформах на этой неделе. Готовые сцены можно будет публиковать в новой ленте сообщества. Однако у платформы есть проблемы с безопасностью из-за риска злоупотребления столь широкими возможностями. Ранее родители подавали в суд на Character.AI, утверждая, что чат-боты пытались склонить их детей к самоповреждениям и суициду. В одном случае 14-летний подросток покончил с собой после продолжительного общения с ИИ-персонажем. С расширением мультимедийных функций также могут возрастать риски злоупотреблений, например, использования фотографий реальных людей. Но компания заявляет, что блокирует загрузку изображений реальных людей, включая знаменитостей, и намеренно искажает их изображения (рисунок ниже), чтобы избежать создания deep-подделок. Однако иллюстрации с известными персонажами система не запрещает, что, возможно, оставляет лазейки для злоумышленников.

Источник изображения: Character.AI Каждое видео помечается водяным знаком, но это не гарантирует полной защиты. Например, при попытке создать дипфейк на основе рисунка Илона Маска (Elon Musk) результат выглядит неестественно, но теоретически такие ролики всё равно можно использовать для обмана.

Источник изображения: Amanda Silberling / bsky.app В Character.AI подчёркивают, что «стремятся балансировать между творческой свободой и безопасностью». По словам компании, цель платформы в том, чтобы предоставить пользователям интересные инструменты для самовыражения, минимизируя потенциальные угрозы. Однако есть те, кто сомневается, что текущих мер недостаточно для предотвращения новых скандалов. Минюст США расследует сделку Google с разработчиком платформы ИИ-ботов Character.AI

23.05.2025 [12:12],

Владимир Фетисов

Министерство юстиции США проводит очередную антимонопольную проверку в отношении компании Alphabet, являющейся материнской для Google. Ведомство изучает на предмет нарушения действующего в стране законодательства сделку между Google и Character.AI, в рамках которой технологический гигант получил доступ к разработанным стартапом технологиям на базе искусственного интеллекта.

Источник изображения: Greg Bulla / Unsplash Напомним, в рамках упомянутой сделки Google получила неисключительную лицензию на использование ИИ-алгоритмов Character.AI, а некоторые сотрудники стартапа, включая его соучредителей, присоединились к технологическому гиганту. По данным источника, антимонопольные органы недавно уведомили Google о проведении проверки по поводу возможного структурирования соглашения с Character.AI с целью избежать официальной проверки слияния со стороны правительства. «Мы всегда готовы ответить на любые вопросы регуляторов. Мы рады, что талантливые сотрудники Character.AI присоединились к компании, но нам не принадлежит доля в собственности, и они остаются отдельной компанией», — сообщил представитель Google. Представители Character.AI и Минюста пока никак не комментируют данный вопрос. В сообщении сказано, что Минюст может проверить, является ли сама сделка антиконкурентной, даже если она не требует формального рассмотрения. Отмечается, что в настоящее время антимонопольное расследование находится на ранней стадии, но в конечном счёте оно может привести к правоприменительным мерам. Любопытно, что в продолжающейся гонке за первенство в сфере ИИ другие технологические гиганты также заключали подобные сделки. В марте 2024 года Microsoft заключила сделку стоимостью $650 млн с Inflection AI, чтобы использовать ИИ-модели стартапа и нанять его сотрудников. В июне 2024 года Amazon наняла соучредителей и часть команды стартапа Adept. Эти сделки также привлекли внимание регулирующих органов. ИИ обрёл человеческое лицо: Character.AI представила модель AvatarFX для превращения ботов в анимированных персонажей

23.04.2025 [16:50],

Павел Котов

Платформа Character.AI, которая специализируется на общении и ролевых играх пользователей с созданными искусственным интеллектом персонажами, представила модель для генерации видео AvatarFX. Источник изображения: x.com/character_ai Пока AvatarFX доступна в формате закрытого бета-тестирования; она позволяет анимировать персонажей на платформе в различных стилях и с различными голосами — эти персонажи могут быть любыми: от человекоподобных до животных из 2D-мультфильмов. В отличие от конкурирующих решений вроде OpenAI Sora, AvatarFX — не просто генератор видеороликов по текстовым запросам. Пользователи могут создавать видео на основе существующих статических изображений, например, анимировать фотографии реальных людей. Подобные решения создают широкое пространство для злоупотреблений, указывает ресурс TechCrunch: недобросовестные пользователи могут начать загружать фотографии знаменитостей или тех, с кем знакомы в реальной жизни, чтобы виртуальный персонаж сказал или сделал нечто компрометирующее. Технологии создания убедительных дипфейков существуют уже не первый год, но их включение в популярные потребительские продукты масштаба Character.AI лишь усугубляет угрозу. В прошлом году трагедией закончилось общение созданного на платформе Character.AI ИИ-персонажа «Игры престолов» с 14-летним американским подростком. В ответ на это администрация сервиса добавила в приложение родительский контроль и дополнительные средства безопасности. Комментариев по поводу возможных злоупотреблений AvatarFX в компании не дали. Character.AI переобучила чат-ботов, чтобы они больше не советовали подросткам убивать родителей

12.12.2024 [20:46],

Сергей Сурабекянц

ИИ-сервис Character.AI в ближайшее время получит отдельную версию для подростков с интегрированным родительским контролем. Она установит «более консервативные» ограничения на ответы чат-ботов, «особенно когда речь идёт о романтическом контенте». Эти действия стали реакцией компании на пристальное внимание прессы к двум судебным искам, в которых Character.AI обвиняется в «способствовании членовредительству и самоубийству».

Источник изображения: Character.AI Character.AI, основанный бывшими сотрудниками Google, позволяет посетителям взаимодействовать с ботами, созданными на основе индивидуально обученной большой языковой модели. Они варьируются от чат-ботов-тренеров до симуляций вымышленных персонажей, многие из которых популярны среди подростков. Сайт позволяет пользователям, которые идентифицируют себя как 13-летних и старше, создавать учётную запись. В поданных против Character.AI исках утверждается, что по крайней мере некоторые несовершеннолетние пользователи становятся навязчиво привязанными к ботам, которые готовы поддерживать беседы на темы секса, членовредительства, причинения вреда себе и другим, и даже самоубийства. В одном из случаев чат-бот намекнул подростку, которому родители запрещают долго сидеть за компьютером, что «разумной мерой» было бы убийство родителей. Другой подросток стал «очень злым и неуравновешенным», после общения с чат-ботом в течение некоторого времени. Истцы полагают, что боты Character.AI в подобных ситуациях должны направлять несовершеннолетних пользователей к ресурсам психологической поддержки. Теперь версия для подростков получила специальную большую языковую модель и обеспечит более агрессивную блокировку вывода, который может быть «деликатным или наводящим на размышления», а также попытается лучше обнаруживать и блокировать пользовательские запросы ненадлежащего контента. При выявлении проявленного пользователем интереса к самоубийству или членовредительству, он будет перенаправлен на «Национальную линию по предотвращению самоубийств». Несовершеннолетним также будет запрещено редактировать ответы ботов, что давало возможность добавлять контент, который Character.AI в противном случае мог бы заблокировать. Сейчас компания пытается бороться с появлением зависимости у пользователей. Кроме того, будут предприняты меры, чтобы предотвратить восприятие бота как живого человека. Появится отдельное предупреждение о том, что боты не могут предлагать профессиональные консультации.  Функции родительского контроля появятся в первом квартале следующего года. Они будут сообщать родителям, сколько времени ребёнок проводит в Character.AI и с какими ботами он взаимодействует чаще всего. Все изменения вносятся в сотрудничестве с «несколькими экспертами по безопасности подростков в Интернете», включая организацию ConnectSafely. «Мы осознаем, что наш подход к безопасности должен развиваться вместе с технологией, которая управляет нашим продуктом, — создавая платформу, где творчество и исследование могут процветать без ущерба для безопасности, — говорится в пресс-релизе Character.AI. — Этот набор изменений является частью нашего долгосрочного обязательства по постоянному совершенствованию нашей политики и нашего продукта». |