|

Опрос

|

реклама

Быстрый переход

В Meta✴ починили уязвимость, позволявшую читать чужие ИИ-диалоги

16.07.2025 [08:19],

Анжелла Марина

Специалист по кибербезопасности выявил уязвимость в системе Meta✴✴ AI, позволявшую получать доступ к чужим запросам и ответам ИИ. Проблему обнаружил Сандип Ходкасиа (Sandeep Hodkasia), основатель компании AppSecure, который сообщил о ней Meta✴✴ и получил $10 000 в рамках программы поощрения за обнаружение багов.

Источник изображения: AI Как пишет TechCrunch, Ходкасиа выявил проблему ещё 26 декабря 2024 года, изучая механизм редактирования запросов в Meta✴✴ AI. Оказалось, что при изменении текста или изображения серверы Meta✴✴ присваивали каждому запросу и ответу уникальный номер (ID). Однако исследователь заметил, что, подменив этот номер в сетевом запросе, можно получить доступ к чужим диалогам с искусственным интеллектом (ИИ). Проблема заключалась в том, что система не проверяла, имеет ли пользователь право просматривать конкретный запрос. Ходкасиа отметил, что номера запросов были предсказуемыми, что теоретически позволяло злоумышленникам массово собирать данные, автоматически перебирая возможные комбинации. Meta✴✴ устранила уязвимость 24 января 2025 года. При этом представитель компании Райан Дэниелс (Ryan Daniels) заявил изданию TechCrunch, что не было обнаружено каких-либо свидетельств злонамеренного использования бага. Стоит сказать, что инцидент произошёл на фоне активного развития ИИ-продуктов крупными технологическими компаниями, которые нередко сталкиваются с проблемами безопасности. Ранее Meta✴✴ AI уже оказывался в центре скандала, когда пользователи по ошибке публиковали приватные диалоги с чат-ботом, ошибочно полагая, что они остаются конфиденциальными. Работники отрасли связи — главный источник сливов персональных данных россиян

14.07.2025 [13:12],

Владимир Мироненко

Чаще всего персональные данные россиян раскрывают третьим лицам сотрудники отрасли связи, сообщили «Ведомости» со ссылкой на исследование компании «Серчинформ». Аналитики изучили более сотни судебных актов за 2024–2025 годы по уголовным делам, связанным с инцидентами в сфере информационной безопасности, виновниками которых стали сотрудники организаций.

Источник изображения: Kevin Ku/unsplash.com Более половины судебных дел (63 %) были связаны с неправомерным доступом к компьютерной информации по статье 272 УК РФ. Из них значительная часть (68 %) приходится на отрасль связи. В 55 % случаев к уголовной ответственности за нарушения в сфере информационной безопасности привлекались сотрудники из отрасли связи, в 16 % — представители органов власти, в 15 % — сотрудники финансового сектора. В четверти случаев ограничивались наказанием в виде штрафа или лишения права занимать определённые должности, и лишь в 9 % — лишением свободы. Почти половина правонарушений (47 %) приходилась на так называемый пробив — продажу данных абонентов и детализации их звонков. Этот вид правонарушения может квалифицироваться по статьям 272 и 183 УК РФ (незаконное получение и разглашение сведений, составляющих коммерческую, налоговую или банковскую тайну). По последней статье предусмотрено наказание — от штрафа в размере от 500 тыс. до 5 млн рублей (или в размере дохода осуждённого за период до пяти лет) до лишения свободы сроком от двух до семи лет. Согласно данным «Серчинформа», в 33 % инцидентов правонарушение заключалось во внесении ложных данных в системы, в том числе для выпуска SIM-карт, а в 16 % — в выгрузке и передаче иных данных. В большинстве случаев (87 %) виновниками нарушений становились рядовые сотрудники, которым, как правило, выносился обвинительный приговор. В 45 % случаев применялся штраф, в 26 % — условное лишение свободы, в 23 % — лишение права занимать определённые должности, и в 6 % — лишение свободы. В этом году была законодательно повышена ответственность операторов, собирающих и обрабатывающих персональные данные, отметил руководитель направления «Разрешение IT & IP споров» юрфирмы «Рустам Курмаев и партнёры» Ярослав Шицле. В частности, были введены оборотные штрафы для компаний за повторные утечки — в размере от 1 до 3 % от годовой выручки, но не более 0,5 млрд рублей. Директор департамента методологии ИБ «Ростелекома» Михаил Савельев уточнил, что у бывших сотрудников нет возможности осуществлять пробив, поскольку в день увольнения они лишаются доступа ко всей инфраструктуре и данным компании. Мелкие инциденты, зачастую связанные с ошибками и невнимательностью пользователей, происходят регулярно, но, как правило, не приводят к разглашению персональных данных клиентов. «Ростелеком» придерживается концепции «минимальных полномочий», которая ограничивает доступ сотрудников как к отдельным системам, так и к конкретным данным клиентов, добавил Савельев. Отрасль связи действительно входит в число наиболее уязвимых с точки зрения вербовки сотрудников и выманивания персональных и коммерческих данных, подтвердили в ГК «Солар». Пробив уже давно перестал быть единичным криминальным эпизодом — это полукриминальный рынок, в котором взаимодействуют сотрудники операторов, посредники, сборщики информации и заказчики, сообщил представитель разработчика технологий для борьбы с киберпреступностью F6. По данным источника «Ведомостей» на рынке информационной безопасности, средняя цена пробива в тематических Telegram-каналах составляет от 5000 до 20 000 рублей за данные одного человека. По словам директора департамента расследований T.Hunter Игоря Бедерова, за эту сумму можно получить ФИО, дату рождения, паспортные данные, номер мобильного телефона, адрес регистрации и проживания, детализацию звонков и SMS (информация о входящих и исходящих вызовах, их времени, номерах собеседников), банковские реквизиты (номера счетов, остатки, сведения по картам, история операций), СНИЛС, ИНН и водительское удостоверение. В F6 назвали одной из причин устойчивой популярности услуги пробива её востребованность не только у мошенников, но и у служб безопасности российских компаний, часто выступающих основными заказчиками. Также к этому приводит недостаточный контроль за движением персональных данных у операторов сотовой связи. В большинстве AMD Ryzen и EPYC обнаружена уязвимость TSA, позволяющая красть пароли и другие секретные данные

10.07.2025 [11:52],

Дмитрий Федоров

AMD предупредила о новом классе атак по побочному каналу — Transient Scheduler Attack (TSA), основанном на особенностях микроархитектуры её процессоров. Подобно атакам Meltdown и Spectre, TSA использует аппаратные уязвимости, позволяющие обойти системные механизмы защиты. Уязвимости были выявлены специалистами AMD после изучения отчёта Microsoft.

Источник изображения: Rubaitul Azad / Unsplash Новый класс уязвимостей состоит из четырёх компонентов: две проблемы получили средний уровень критичности, две другие — низкий. Несмотря на такую формальную классификацию, эксперты из Trend Micro и CrowdStrike оценивают угрозу как критическую. Причина не в легкости эксплуатации, а в глубинной природе самих атак, которые затрагивают фундаментальные механизмы выполнения команд внутри процессора и при определённых условиях позволяют злоумышленнику получать доступ к защищённым данным, включая данные ядра операционной системы (ОС) и изолированных виртуальных машин. Атака TSA применима ко многим моделям процессоров AMD, включая мобильные, настольные и серверные решения. Особенно подвержены чипы EPYC третьего и четвёртого поколений, используемые в облачных средах и дата-центрах. Для реализации атаки требуется локальный доступ к машине — через вредоносное ПО, пользовательскую сессию или скомпрометированную виртуальную машину. При этом достаточно минимальных пользовательских прав. Уязвимость нельзя эксплуатировать через вредоносные сайты — в отличие от ранее известных атак типа Spectre. Чтобы извлечь данные, злоумышленнику необходимо многократное воспроизведение атаки на целевом оборудовании. Это обусловлено её природой: атака использует механизм ложного завершения инструкций загрузки, когда процессор предполагает, что данные успешно загружены, хотя на самом деле они ещё недоступны. Такие ошибки становятся основой таймингового побочного канала: инструкции, зависящие от загрузки, выполняются с иной задержкой, и это позволяет определить, какие данные были затронуты.

Источник изображения: Wesley Tingey / Unsplash В TSA выделены два типа атак: TSA-L1 и TSA-SQ. Первая использует ложные попадания в кеш первого уровня (L1), возникающие из-за ошибок в работе микротегов. Процессор ошибочно считает, что нужные данные находятся в кеше, и производит загрузку ложного значения, на основании которого можно восстановить содержимое памяти. Вторая атака — TSA-SQ — связана с тем, что инструкция загрузки преждевременно обращается к очереди хранения и извлекает данные, которые могли быть записаны ранее в другом потоке или контексте. Это позволяет обойти изоляцию между виртуальными машинами или процессами. По наихудшему сценарию, TSA позволяет получить доступ к данным ядра ОС, что открывает возможности для повышения привилегий, отключения защитных механизмов, внедрения бэкдоров и обеспечения долговременного присутствия в системе. Даже уязвимости с низкой формальной оценкой, которые позволяют определить поведение внутренних буферов или очередей, могут повысить точность более сложных атак. Поэтому специалисты по информационной безопасности (ИБ) рекомендуют отнестись к проблеме максимально серьёзно. AMD опубликовала подробный технический отчёт с описанием TSA и перечнем затронутых процессоров. В него входят серверные EPYC, пользовательские Ryzen, ускорители вычислений Instinct и чипы Athlon. Компания рекомендует системным администраторам как можно скорее установить последние версии Windows, содержащие обновления микрокода и патчи ядра. Альтернативно можно задействовать инструкцию VERW, которая очищает критические буферы процессора, но такая мера может снизить производительность. Выбор подхода требует отдельной оценки соотношения рисков и ресурсов в каждом конкретном случае.

Источник изображения: Tadas Sar / Unsplash Согласно заявлению Microsoft, по состоянию на 10 июля в открытом доступе отсутствует какой-либо эксплойт, способный использовать TSA. Более того, успешное проведение атаки требует значительных технических ресурсов и глубокого понимания архитектуры процессоров AMD. Это делает её доступной лишь для самых подготовленных злоумышленников — например, прогосударственных APT-групп (Advanced Persistent Threat). Тем не менее, само наличие таких уязвимостей требует оперативного реагирования и обновления ПО и аппаратного стеков защиты. Безинтернетный мессенджер Bitchat от основателя Twitter провалил первую проверку безопасности

10.07.2025 [11:07],

Анжелла Марина

Недавно запущенный мессенджер Bitchat, созданный генеральным директором Block и соучредителем Twitter Джеком Дорси (Jack Dorsey), позиционируется как средство безопасного общения без использования интернета. Но исследователи заявили, что приложение содержит критические уязвимости, которые ставят под угрозу конфиденциальность данных.

Источник изображения: GitHub Bitchat позиционируется как безопасный и приватный продукт без централизованной инфраструктуры, использующий только Bluetooth и сквозное шифрование вместо интернет-соединения. В техническом описании Дорси подчёркивал, что система мессенджера разработана с приоритетом на защиту данных. Однако уже в первые дни заявление о безопасности приложения подверглось сомнению, сообщает TechCrunch. Сам Дорси признал, что код Bitchat не проходил независимого аудита, и разместил на GitHub предупреждение о возможных уязвимостях. Разработчик прямо рекомендовал не использовать приложение для важной переписки, пока его безопасность не будет подтверждена экспертами. Однако изначально этого предупреждения не было — оно появилось позже, а затем Дорси добавил пометку «Work in progress», что говорит о незавершённости проекта. Поводом для корректировок стали выводы исследователя Алекса Радочи (Alex Radocea), который обнаружил критическую уязвимость в системе идентификации пользователей. Оказалось, что злоумышленник может перехватить цифровые ключи и выдать себя за доверенный контакт, отмеченный в Bitchat как «Избранный». Радочи сообщил об этом через тикет на GitHub, но Дорси сначала закрыл запрос без комментариев, а затем вновь открыл, предложив публиковать подобные отчёты напрямую в репозитории. Другие специалисты также нашли проблемы. Один из них усомнился в реализации функции Forward secrecy, которая должна защищать старые сообщения даже при компрометации ключа. Другой обратил внимание на потенциальную уязвимость переполнения буфера (buffer overflow), возникающую, когда программа пытается записать больше данных в буфер (область памяти), чем этот буфер может вместить. Это позволяет стороннему лицу получить доступ к памяти устройства. В итоге Радочи заявил, что текущая версия Bitchat не готова для использования теми, кто всерьёз полагается на защищённую связь. По его словам, базовые проверки криптографии идентификационных ключей не проводились, а громкие заявления о безопасности могут ввести пользователей в заблуждение. Исследователь иронично отметил, что приложение уже прошло внешний аудит силами энтузиастов, и результаты оказались неутешительными. Сам Дорси не ответил на запрос издания TechCrunch относительно выявленных проблем. Браузеры почти 1 млн пользователей превратились в скрытых ботов для скрапинга

10.07.2025 [06:16],

Анжелла Марина

Браузерные расширения, казалось бы, полезные и безобидные, оказались замешаны в масштабном проекте по превращению пользовательских устройств в ботов. 909 000 браузеров по всему миру стали невольными участниками нелегальной сети по сбору данных. Исследователь Джон Такнер (John Tuckner) из SecurityAnnex, обнаружил, что 245 популярных расширений для Chrome, Firefox и Edge отключали защиту, чтобы тайно скрапить сайты по заказу сервиса Olostep.

Источник изображения: Philipp Katzenberger/Unsplash Эти расширения выполняли функцию управления закладками, увеличением громкости звука, генерации случайных чисел и другими полезными задачами, но при этом использовали скрипт MellowTel-js, представляющий из себя JavaScript-библиотеку с открытым исходным кодом, которая позволяет разработчикам тайно монетизировать свои расширения. Как пишет издание Ars Technica, заработок был возможен за счёт скрапинга — автоматического сбора информации с веб-страниц (по заказу клиентов Olostep). По данным Такнера, библиотека MellowTel тесно связана с Olostep, позволяя обходить системы обнаружения ботов и параллельно обрабатывать до 100 000 запросов за считанные минуты. Клиенты указывают, какие страницы нужно открывать, и далее система использует устройства пользователей, установивших подходящие расширения, для выполнения задачи. Основатель MellowTel пояснил, что библиотека предназначена для распределённого использования интернет-канала пользователей без сбора их личных данных. По его словам, компании платят за доступ к публичной информации на сайтах, а разработчики расширений получают 55 % дохода. Однако Такнер считает, что MellowTel создаёт риски для пользователей, так как библиотека активирует скрытое соединение с сервером Amazon Web Services, передавая ему данные о местоположении, скорости интернета и активности пользователя. Кроме того, она внедряет невидимый iframe, который загружает сторонние сайты без ведома владельцев устройств. Обычно браузеры блокируют такие действия с помощью встроенных механизмов безопасности типа Content-Security-Policy и X-Frame-Options. Но MellowTel использует разрешение под названием declarativeNetRequest, чтобы временно отключать эти ограничения, одновременно делая устройства уязвимыми к межсайтовым атакам. Проблема усугубляется ещё и тем, что пользователи не знают, какие именно сайты открываются в фоновом режиме, и вынуждены полагаться на добросовестность MellowTel. Отмечается, что ситуация особенно опасна для корпоративных сетей с жёсткими политиками безопасности. Как сообщает Ars Technica, ссылаясь на слова Такнера, часть опасных расширений уже удалена. Из 45 выявленных дополнений для Chrome 12 уже перестали работать. Среди 129 расширений для Edge неактивны восемь, а в Firefox неактивны два из 71. При этом некоторые разработчики добровольно убрали библиотеку MellowTel из обновлённых версий своих расширений. Полный список расширений опубликован в отчёте исследователя в «Google Документах». Роскомнадзор заявил, что каждый день выявляет 1,2 млн звонков с подменой номера

09.07.2025 [10:07],

Владимир Фетисов

Роскомнадзор ежедневно выявляет среди 455 млн звонков 1,2 млн вызовов с подменой номера, используемых мошенниками. Об этом сообщил зампредседателя правительства, руководитель аппарата правительства Дмитрий Григоренко.

Источник изображения: NordWood Themes / Unsplash «Правительство ведёт системную работу по повышению уровня безопасности граждан в цифровой среде, и Роскомнадзор играет в ней ключевую роль. Ведомство оперативно выявляет и блокирует схемы злоумышленников», — добавил господин Григоренко во время выступления на рабочем совещании в ведомстве. Он также рассказал, что среди мер, направленных на борьбу с мошенниками, в Роскомнадзоре используют блокировку используемых злоумышленниками ресурсов. В прошлом году ведомство заблокировало около 44 тыс. веб-сайтов, которые использовались преступниками для кражи личных данных и денежных средств граждан. Григоренко напомнил, что в начале текущего года был принят и уже начал действовать пакет из 30 мер, направленных на защиту граждан от киберпреступников. В числе прочего в пакет вошел запрет на использование мессенджеров для сотрудников госорганов, банков и операторов связи при общении с клиентами. На этой неделе в МВД РФ напомнили, что преступники во время общения в мессенджерах или в телефонных разговорах с жертвами часто представляются сотрудниками операторов связи, банков или госорганов, правоохранителями, знакомыми и коллегами. Злоумышленники используют разные уловки в зависимости от выбранной роли, чтобы заставить жертву установить на свой смартфон вредоносное ПО или иным образом попытаться украсть личные данные или денежные средства. Исследователи обнаружили опасный метод взлома Android через невидимый интерфейс

09.07.2025 [05:11],

Анжелла Марина

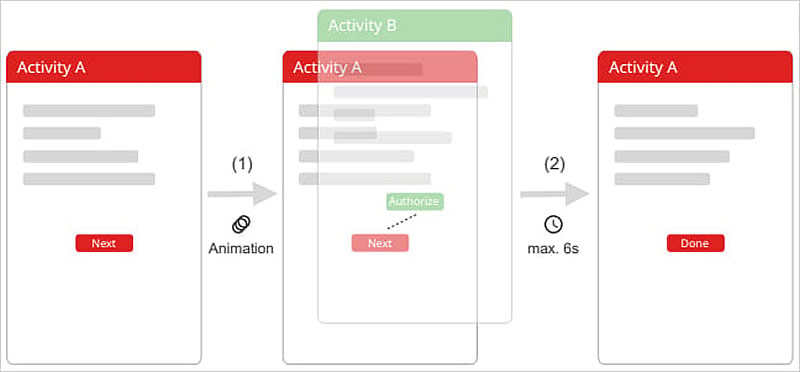

Исследователи в области кибербезопасности обнаружили новый метод взлома Android, который позволяет злоумышленникам получать доступ к конфиденциальным данным, обходя систему аутентификации. Атака, получившая название TapTrap, использует нестандартную анимацию интерфейса, создавая расхождение между тем, что видит пользователь, и тем, что на самом деле происходит на экране.

Источник изображения: IndiaBlue Photos/Unsplash В отличие от традиционных методов перехвата нажатий (tapjacking), TapTrap работает даже с приложениями, не имеющими никаких разрешений. Злоумышленники могут запускать прозрачные системные окна, маскируя их под обычные элементы интерфейса. Пользователь, думая, что взаимодействует с безобидным приложением, на самом деле нажимает на невидимые кнопки, которые могут, например, предоставить доступ к камере или сбросить устройство к заводским настройкам.

Источник изображения: bleepingcomputer.com Суть атаки заключается в манипуляции системными анимациями Android. Вредоносное приложение может запускать важные системные окна, такие как запросы разрешений или настройки, с почти нулевой прозрачностью. По словам исследователей, ключевая особенность TapTrap — использование анимации, которая делает целевое окно практически невидимым. Этого можно добиться, задав начальную и конечную прозрачность на уровне 0,01 (на Android прозрачность задаётся в числах от 0 до 255). Дополнительно злоумышленники могут масштабировать интерфейс, увеличивая, например, кнопку подтверждения на весь экран, чтобы повысить вероятность нажатия. Разработчиками смоделированной атаки являются исследователи из Венского технического университета и Университета Байройта Филипп Бир (Philipp Beer), Марко Скуарчина (Marco Squarcina) и другие. Они уже опубликовали техническое описание уязвимости и собираются представить свои выводы на симпозиуме по безопасности USENIX в следующем месяце. Проверив около 100 000 приложений из Google Play, исследователи выяснили, что 76 % из них уязвимы к TapTrap. Проблема сохраняется даже в Android 16, как подтвердил Скуарчина, протестировавший атаку на Google Pixel 8a. Разработчики мобильной операционной системы GrapheneOS, ориентированной на безопасность операционной системы, также подтвердили уязвимость и пообещали исправить её в следующем обновлении. Представитель Google по запросу издания Bleeping Computer заявил, что компания работает над устранением проблемы и готовит патч, закрывающий уязвимость. Однако сроки выхода обновления неизвестны. Microsoft устранила 137 уязвимостей, включая 14 критических и одну нулевого дня

08.07.2025 [22:24],

Анжелла Марина

В рамках июльского «вторника патчей» (Patch Tuesday) 2025 года компания Microsoft выпустила обновления своих продуктов, устранив 137 уязвимостей, включая одну уязвимость нулевого дня в Microsoft SQL Server. Эта проблема была связана с некорректной проверкой входных данных и позволяла злоумышленникам получать доступ к неинициализированной памяти сервера, предоставляя, таким образом, возможность удалённого раскрытия информации без аутентификации.

Источник изображения: bleepingcomputer.com Среди исправленных уязвимостей 14 имеют статус критических, причём десять из них позволяют удалённое выполнение кода. Остальные включают утечку информации (одна ошибка) и две уязвимости, связанные с атаками через побочные каналы (скрытые каналы утечки информации) процессоров AMD. Распределение по категориям выглядит следующим образом: 53 связаны с повышением привилегий, 8 — с обходом механизмов безопасности, 41 — с удалённым выполнением кода, 18 — с раскрытием информации, 6 — с отказами в обслуживании и 4 с подменой данных. Издание Bleeping Computer также отмечает, что здесь не включены семь исправлений для Microsoft Edge и Mariner, выпущенные ранее в этом месяце. Особое внимание Microsoft уделила уязвимости CVE-2025-49719 в SQL Server, обнаруженной Владимиром Алексичем (Vladimir Aleksic) из самой компании. Для её устранения администраторам рекомендуется установить последнюю версию SQL Server или обновить драйвер Microsoft OLE DB до версии 18 или 19. Помимо этого, в списке критических проблем оказались несколько уязвимостей в Microsoft Office, которые можно эксплуатировать через открытие специально подготовленного документа или даже через панель предпросмотра. Также была устранена уязвимость CVE-2025-49704 в Microsoft SharePoint, позволяющая удалённое выполнение кода при наличии учётной записи на платформе. При этом обновления для Microsoft Office LTSC для Mac 2021 и 2024 пока не готовы — их выпуск ожидается в ближайшее время. Магазин Chrome заполонили опасные расширения для браузера — их скачали уже 1,7 млн раз

08.07.2025 [18:39],

Алексей Селиванов

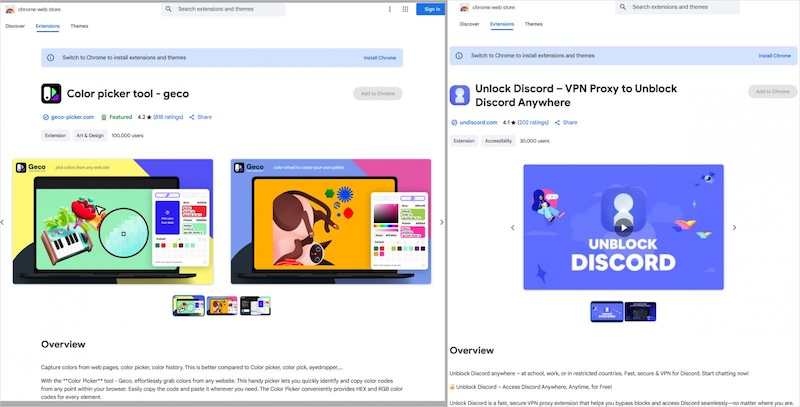

Одиннадцать вредоносных расширений для браузера, скачанных более 1,7 млн раз из магазина Chrome, могли следить за пользователями, перехватывать историю браузера и перенаправлять на небезопасные сайты, выяснили эксперты по кибербезопасности.

Источник изображения: BleepingComputer При этом большая часть дополнений выполняет заявленную функциональность — они маскируются под легитимные утилиты вроде прогноза погоды, инструментов для определения цветов или увеличения громкости, средств обхода блокировок сайтов или эмодзи-клавиатуры, пишет Bleeping Computer со ссылкой на исследователей из компании Koi Security. Часть расширений удалили вскоре после жалоб на них, но некоторые по-прежнему доступны. Некоторые дополнения имеют верификацию, сотни положительных отзывов и продвигаются на главной странице магазина, что вводит пользователей в заблуждение относительно их безопасности. Вот лишь некоторые из опасных расширений, которые стоит удалить из своего браузера: Color Picker, Eyedropper — Geco colorpick, Emoji keyboard online — copy&paste your emoji, Free Weather Forecast, Video Speed Controller — Video manager, Volume Max — Ultimate Sound Booster, а с полным списком можно ознакомиться на сайте Koi Security. По словам исследователей, вредоносный код скрывается в фоновых службах расширений через Chrome Extensions API. В них регистрируется обработчик, срабатывающий при каждой загрузке новой страницы. Он считывает URL и вместе с уникальным ID пользователя отправляет данные на удалённый сервер. В ответ сервер может отдавать команды на перенаправление. Таким образом злоумышленники получают возможность перехватить сессии и отправить жертву на фишинговые или заражённые сайты. Хотя в тестах Koi Security фактических редиректов не обнаружили, потенциал для атаки есть. Важно отметить, что изначальные версии этих расширений были «чистыми» — вредоносный код в них появился позже через автоматические обновления. Пока нет официальных комментариев от разработчиков, но не исключено, что их аккаунты были взломаны сторонними злоумышленниками, вставившими вредоносный код. Кроме того, Koi Security выявила аналогичную кампанию с теми же расширениями в официальном магазине Microsoft Edge: они суммарно набрали 600 тысяч установок. «В общей сложности эти расширения заразили более 2,3 млн пользователей браузеров, став одной из крупнейших известных операций по перехвату трафика», — отметили эксперты. Эксперты дают следующие рекомендации на случай обнаружения опасного расширения:

Минцифры РФ заплатит до миллиона рублей за обнаружение уязвимостей в государственных сервисах

08.07.2025 [16:35],

Павел Котов

Минцифры России инициировало третий этап программы, посвящённой проверке безопасности девяти государственных информационных систем. Обнаружившим в них уязвимости участникам обещаны выплаты в размере до 1 млн руб. за каждую выявленную ошибку — точный размер будет зависеть от её степени критичности.

Источник изображения: Arif Riyanto / unsplash.com В рамках программы эксперты проверят единый портал Госуслуг, Единую систему идентификации и аутентификации (ЕСИА), Единую биометрическую систему (ЕБС), Единую систему межведомственного электронного взаимодействия (СМЭВ), Национальную систему управления данными (НСУД), Единую систему нормативной справочной информации, Головной удостоверяющий центр, Федеральный реестр государственных и муниципальных услуг и Систему досудебного обжалования. Мера призвана повысить надёжность защиты государственных цифровых служб и их безопасность, пишет «Коммерсантъ» со ссылкой на заявление пресс-службы Минцифры. Специалисты будут проверять внешние компоненты систем в условиях отсутствия доступа к внутренним данным; их действия будут контролироваться. Участниками первого и второго этапов программы стали более 26 тыс. добровольцев. OpenAI усилила режим секретности, опасаясь утечки передовых ИИ-разработок

08.07.2025 [11:19],

Владимир Фетисов

По сообщениям сетевых источников, компания OpenAI ужесточила меры, направленные на защиту от корпоративного шпионажа. Это произошло после того, как в начале года китайский стартап DeepSeek выпустил гораздо более дешёвую, но конкурентоспособную ИИ-модель. OpenAI обвинила стартап в копировании своей языковой модели с применением методов «дистилляции», т.е. сжатия большой модели в меньшую.

Источник изображения: Oleksandr Chumak / Unsplash Усиление системы безопасности включает принятие политики «защиты информации», которая ограничивает доступ персонала к конфиденциальным данным и новым продуктам. Например, в процессе разработки алгоритма o1 только проверенные сотрудники, вовлечённые в проект, имели право обсуждать рабочие вопросы в офисах компании. Вместе с этим OpenAI стала изолировать проприетарные технологии внутри автономных компьютерных систем. Внедряется биометрический контроль доступа в офисные помещения, а также строгое ограничение на подключение к внутренним IT-системам компании из вне. Для повышения эффективности предпринимаемых мер OpenAI расширила штат сотрудников отдела кибербезопасности. По данным источника, изменения в политике безопасности OpenAI отражают опасения по поводу попыток иностранных конкурентов похитить принадлежащую компании интеллектуальную собственность. Если учитывать всё более обостряющуюся конкуренцию в сфере ИИ на рынке США, можно предположить, что усиление безопасности также является попыткой компании решить внутренние проблемы. Официальные представители OpenAI пока никак не комментируют данный вопрос. Китайская Envision устроила пожар в системе хранения энергии, чтобы доказать её устойчивость к распространению огня

04.07.2025 [13:10],

Геннадий Детинич

Жуткие истории о масштабных пожарах в системах хранения энергии на литиевых аккумуляторах уходят в прошлое. Индустрия учла этот печальный опыт и предприняла меры для повышения устойчивости систем накопления энергии к огню. Для наглядности китайская компания Envision Energy даже не пожалела 5-МВт·ч шкаф с аккумуляторами, подпалив его в тесном соседстве с такими же. 49 часов яростного огня ничуть не повлияли на соседние блоки и пожар остался локальным.

Источник изображения: Envision Energy Полномасштабный эксперимент по пожару в системе хранения энергии был проведён в присутствии наблюдателей из Канадской ассоциации стандартов (CSA) и инженеров противопожарной защиты из США (FPE). Демонстрация была организована в рамках канадского стандарта CSA C800. Опыт должен был наглядно показать безопасность использования батарейных систем накопления компании Envision. Для эксперимента была собрана полностью функциональная батарея из четырёх шкафов ёмкостью 5 МВт·ч, расположенных с интервалом 5 см друг от друга. Батареи были заряжены на 100 %. Системы пожаротушения не применялись. Осуществлялось контролируемое горение. С одного из шкафов сняли теплоизоляцию и разогрели его за 6 часов до температуры 1297 °C, что привело к его возгоранию. Пожар продолжался свыше 49 часов. Соседние три шкафа практически не пострадали от тепла. Температура их аккумуляторов оставалась на уровне 35–44 °C, что значительно ниже критических значений. Проверка после испытаний подтвердила отсутствие структурных деформаций или распространения тепла в системе, целостность уплотнений, а также то, что дым полностью улавливался и безопасно утилизировался. Компания Envision объяснила этот успех многоуровневой архитектурой безопасности: интеграцией ячеек в блоки, ячейками повышенной безопасности от Envision Power, системами раннего предупреждения о начале роста нагрева и системами контроля пожара на уровне блоков. Испытание не только подтвердило устойчивость оборудования в экстремальных условиях, но и позволило количественно оценить риски, что открывает путь к страхованию и широким продажам. Envision не одинока в «жестоком» обращении с аккумуляторными блоками и это радует — отрасль всерьёз озаботилась безопасностью систем хранения энергии коммунального масштаба. Несколько крупных игроков недавно опубликовали сравнительные данные испытаний на огнестойкость. Компания Sungrow провела испытания на огнестойкость батарейной системы с жидкостным охлаждением ёмкостью 20 МВт·ч. При этом четыре шкафа ёмкостью 5 МВт·ч были плотно расположены друг к другу, и распространения огня не наблюдалось. Другая компания — Prevalon Energy — сообщила о завершении крупномасштабных испытаний на огнестойкость CSA TS‑800 ёмкостью 6 МВт·ч (с расположением панелей вплотную друг к другу), которые также показали высокую огнестойкость. Hithium, Canadian Solar и Fluence провели крупномасштабные испытания на огнестойкость, в ходе которых шкафы выдерживали температуру более 1000 °C в течение 48 часов без распространения огня. Проведённые испытания на огнестойкость отражают растущую тенденцию к усилению контроля за безопасностью в секторе систем накопления энергии. Строгие протоколы, такие как CSA TS‑800/C800 и UL 9540A, всё чаще становятся обязательными условиями для выхода на рынок, оформления страховки и масштабного внедрения. Производители вкладывают миллионы не только в повышение технической надежности, но и в восстановление доверия к отрасли, ранее подмочившей свою репутацию на фоне резонансных пожаров. 39 млн записей с персональными данными россиян утекло за первое полугодие

03.07.2025 [17:22],

Алексей Селиванов

Объём утечек персональных данных россиян приблизился к 40 млн записей с начала текущего года, сообщил Роскомнадзор. Причём для этого понадобилось всего лишь 35 инцидентов, то есть за один раз допускалась утечка в среднем более 1 млн записей.

Источник изображения: Arif Riyanto/unsplash.com «За первые шесть месяцев 2025 года Роскомнадзор зафиксировал 35 фактов утечек персональных данных, в результате которых оказались скомпрометированы более 39 млн записей», — передает ТАСС со ссылкой на пресс-службу Роскомнадзора. В ведомстве добавили, что за последние два месяца в Роскомнадзор поступила информация об инцидентах от пяти операторов. В этом году по факту утечек персональных данных было составлено шесть протоколов об административных правонарушениях по статье 13.11 КоАП РФ. Некоторые дела еще находятся в суде, а по некоторым уже вынесены решения о предупреждениях и взыскании штрафов. Напомним, 30 мая вступил в силу Федеральный закон № 420-ФЗ, которым предусмотрено ужесточение административной ответственности за нарушения обработки персональных данных. Штраф за утечку пользовательских данных теперь составляет от 3 до 20 млн рублей. Китайские инженеры создали лучшую постквантовую защиту для блокчейна

03.07.2025 [15:41],

Геннадий Детинич

На днях в китайском журнале Journal of Software вышла статья с рассказом о новом методе защиты блокчейна от взлома квантовыми компьютерами. Настанет время, и традиционные методы шифрования на основе классической математики окажутся уязвимы к атакам со стороны квантовых систем. «Сани» для путешествия по новому постквантовому миру обмена данными нужно готовить заранее, в частности, разрабатывая новые устойчивые методы шифрования.

Источник изображения: ИИ-генерация Grok 3 Сегодня блокчейн — это не только и не столько криптовалюта, а распределённые высокозащищённые базы данных. В этом качестве технология блокчейна продолжит развиваться дальше. Проблема в том, что современные технологии защиты блокчейна опираются на обычную математику, включающую, например, факторизацию больших чисел. Современные суперкомпьютеры за разумное время не смогут её взломать, но квантовые системы, когда они появятся через десять или больше лет — обещают с лёгкостью одолеть подобное шифрование. «В частности, существующая защита на основе цифровой подписи становится уязвимой при квантовых атаках, — предупреждают разработчики. — Злоумышленники могут незаметно подделывать данные или вставлять вредоносные записи, ставя под угрозу целостность и согласованность блокчейна». Чтобы в будущем не возникло проблем с подделкой записей в распределённых базах, китайские учёные предложили защитить блокчейн технологией EQAS на базе постквантового алгоритма шифрования SPHINCS, впервые представленного в 2015 году. Вместо сложной математики в основе шифрования SPHINCS используются квантово-устойчивые хэш–функции или более простые математические проверки, что, в частности, ускоряет работу с блокчейном как на стороне пользователя, так и на стороне сервера, а это тоже дорогого стоит. В системе EQAS хранение данных также отделено от верификации. Система EQAS генерирует доказательства с использованием структуры «динамического дерева», а затем проверяет их с помощью эффективной структуры «супердерева». Предложенное решение за счёт своей древовидной архитектуры повышает и масштабируемость, и производительность, одновременно снижая нагрузку на серверы. В ходе исследования команда также проверила безопасность и эффективность EQAS. Оптимизировав параметры, удалось получить цифровые подписи меньшего размера и ускорить проверку без ущерба для безопасности. Так, в ходе моделирования EQAS потребовалось около 40 секунд для выполнения задач аутентификации и хранения – намного быстрее, чем текущее время подтверждения в блокчейне Ethereum, составляющее около 180 секунд (по 15 секунд на каждый из 12 блоков — принятый в Ethereum стандарт подтверждения). Европейцы получат урезанную iOS 26 из-за неутихающего противостояния Apple и ЕС

30.06.2025 [19:12],

Сергей Сурабекянц

Сегодня на семинаре с должностными лицами и разработчиками ЕС в Брюсселе вице-президент Apple по юридическим вопросам Кайл Андер (Kyle Andeer) сообщил, что компании «пришлось принять решение об отсрочке выпуска продуктов и функций, о которых мы объявили в этом месяце для наших клиентов в ЕС». Он объяснил это решение стремлением обезопасить пользователей, если экосистема Apple будет открыта для конкурентов.  Евросоюз требует от Apple соблюдения «Закона о цифровых рынках» (Digital Markets Act, DMA), который призван ограничить рыночные преимущества так называемых технологических компаний — «привратников» (gatekeepers) путём открытия их платформ для сторонних разработчиков. По мнению чиновников Евросоюза, этот закон призван обеспечить конкуренцию и справедливость на цифровых рынках Европы. Apple категорически не согласна с реализацией DMA и утверждает, что это ухудшает качество её продуктов, подвергает пользователей рискам безопасности и конфиденциальности и усложняет развёртывание обновлений в ЕС. Андер утверждает, что изменения, которые пришлось внести Apple, чтобы привести свои продукты в соответствие с правилами, «создают реальные риски конфиденциальности, безопасности и сохранности для наших пользователей». Apple заявила, что все ещё решает, какие функции пока окажутся недоступными в Евросоюзе, и работает над поиском решений для их скорейшего предоставления. Известно, что такие инструменты, как «Посещённые места» в приложении «Карты», не будут доступны жителям ЕС в момент выхода iOS 26 в конце этого года. Чиновник Евросоюза, присутствовавший на встрече с Кайлос Андером, подтвердил, что регулятор и Apple расходятся во мнениях относительно сферы действия DMA и потенциальных рисков безопасности. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |