|

Опрос

|

реклама

Быстрый переход

Meta✴ купит у AMD чипов на $100 млрд для ИИ-систем на 6 ГВт — и получит «в подарок» кусочек самой AMD

24.02.2026 [19:39],

Сергей Сурабекянц

Компании AMD и Meta✴✴ объявили о ещё одной колоссальной сделке, стоимость которой может превысить $100 млрд. AMD предоставит до 6 гигаватт вычислительной мощности на основе ИИ-ускорителей AMD Instinct для реализации амбиций Meta✴✴ в области ИИ. Сделка предусматривает вознаграждение для Meta✴✴, в рамках которого компания может получить до 160 млн акций AMD. Meta✴✴ также станет ведущим потребителем чипов AMD EPYC Venice и процессоров следующего поколения EPYC Verano.

Источник изображений: AMD В своём пресс-релизе AMD подтвердила партнёрство с Meta✴✴ с целью «быстрого масштабирования инфраструктуры ИИ и ускорения разработки и внедрения передовых моделей ИИ». С этой целью AMD предоставит Meta✴✴ архитектуру AMD Helios для стоечных систем, начало развёртывания которой ожидается во второй половине 2026 года. Решение будет основано на базе специализированных графических процессоров AMD Instinct, построенных на архитектуре MI450, процессоров AMD EPYC Venice и программного обеспечения ROCm.  Глава AMD Лиза Су (Lisa Su) заявила, что партнёрство с Meta✴✴ представляет собой «многолетнее сотрудничество», а генеральный директор Meta✴✴ Марк Цукерберг (Mark Zuckerberg) подтвердил долгосрочные перспективы партнёрства. По словам Цукерберга, амбиции Meta✴✴ в области искусственного интеллекта направлены на создание «персонального суперинтеллекта». AMD также сообщила, что Meta✴✴ станет ведущим клиентом для процессоров AMD EPYC Venice шестого поколения, а также чипов EPYC следующего поколения Verano. AMD заявила, что выпустила для Meta✴✴ «варранты на основе производительности» на сумму до 160 млн обыкновенных акций AMD, которые будут предоставляться «по мере достижения определённых этапов, связанных с поставками графических процессоров Instinct». По сути, AMD вознаграждает Meta✴✴ своими акциями за покупку графических процессоров. Сделка по масштабу практически идентична партнёрству OpenAI и AMD, объявленному в октябре. По данным The Wall Street Journal, стоимость сделки превышает $100 млрд, при этом каждый гигаватт вычислительных мощностей приносит AMD десятки миллиардов долларов дохода. Что касается сделки с акциями, Meta✴✴ сможет приобрести до 160 млн акций по цене 0,01 доллара за штуку. Для получения полного вознаграждения в виде акций, цена акций AMD должна достичь $600. В настоящее время они торгуется чуть ниже $200. На прошлой неделе сообщалось о намерении Meta✴✴ использовать автономные процессоры Nvidia Grace в своих ЦОД, что, по словам компании, обеспечит значительный скачок производительности на ватт. Суперсила, помноженная на два: в Японии IBM впервые смогла обеспечить бесшовную работу суперкомпьютера с квантовым

24.02.2026 [14:57],

Геннадий Детинич

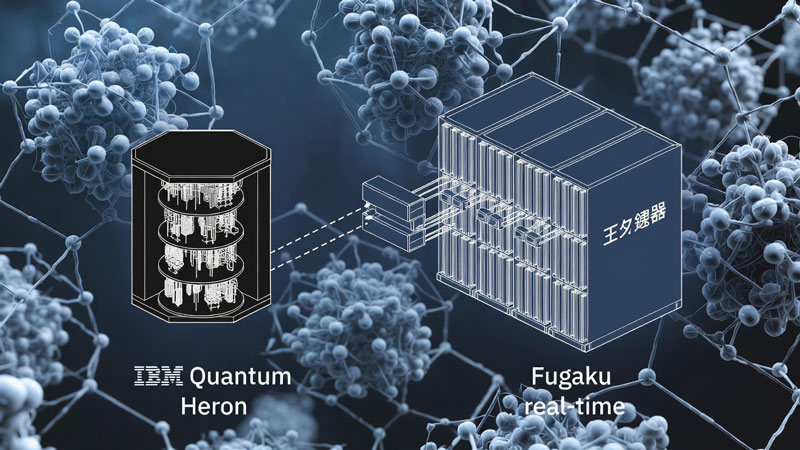

Команда специалистов IBM и института RIKEN (Япония) достигла важной вехи в развитии синтеза квантовых и суперкомпьютерных расчётов (Quantum-Centric Supercomputing, QCSC). Исследователям удалось впервые создать замкнутый цикл вычислений, в котором размещённые рядом квантовый вычислитель и суперкомпьютер непрерывно обменивались данными промежуточных расчётов, работая на общий результат.

Источник изображения: ИИ-генерация Grok 4/3DNews До сих пор квантовые вычислители редко использовались для получения практически значимых расчётов. Более того, в связке с суперкомпьютерами они работали циклами, пересылая один другому промежуточные данные поэтапно на больших отрезках времени. Это вело к простоям каждой из платформ, пока они дожидались завершения вычислительных циклов партнёра по расчётам. С учётом колоссальной стоимости рабочего времени таких систем — это недопустимая роскошь. Команде IBM и RIKEN впервые удалось обеспечить бесшовную работу совершенно непохожих друг на друга компьютерных платформ, обеспечив непрерывный обмен данными внутри каждого вычислительного цикла. Исследователи из США с коллегами из Японии создали гибридную систему из суперкомпьютера Fugaku (состоящего из 158 976 узлов — это почти 7,3 млн ядер ARM) и квантового компьютера IBM Quantum System Two на процессоре Heron (133 кубита). Это было впервые, когда на таком масштабе тесно связали классический высокопроизводительный вычислительный комплекс и квантовый компьютер. Суть эксперимента заключалась в расчёте электронной структуры двух сложных молекул из атомов железа и серы — важных для биохимии и катализа. Знание распределений электронных оболочек — это то, что даёт узнать о поведении молекул в любой среде. Для расчёта использовался метод «квантовой диагонализации на основе выборок» (Sample-based Quantum Diagonalization, SQD), когда квантовый процессор генерировал выборки из пространства состояний молекулы, а Fugaku обрабатывал огромные объёмы данных в рамках классических вычислений и корректировал результаты в итеративном цикле. Это позволило получить самую большую и точную квантово-химическую симуляцию на сегодняшний день — точность оказалась выше, чем у точных классических методов (к слову, для таких систем недостижимых), и сопоставима с лучшими приближёнными классическими подходами. Достижение можно с уверенностью считать первым практическим воплощением концепции суперкомпьютерных вычислений с привязкой к работе квантовых систем. Разработанный замкнутый рабочий процесс обеспечил быструю обратную связь между квантовой и классической частями системы, что критически важно для эффективного использования обоих типов ресурсов. Представители RIKEN и IBM отметили, что подобный синтез открывает путь к интеграции в систему расчётов ускорителей (в том числе GPU) и приближает момент достижения настоящего квантового превосходства в практически ценных химических и физических расчётах. Достижение имеет большое значение для будущего гибридных вычислений. Это создаёт основу для масштабирования подобных платформ, включая облачные гибридные среды, и ускоряет исследования в материаловедении, фармацевтике и энергетике, где точное моделирование молекулярных взаимодействий играет ключевую роль. Канадцы собрали «копеечный» аналог квантового компьютера для решения задач оптимизации

11.02.2026 [17:50],

Геннадий Детинич

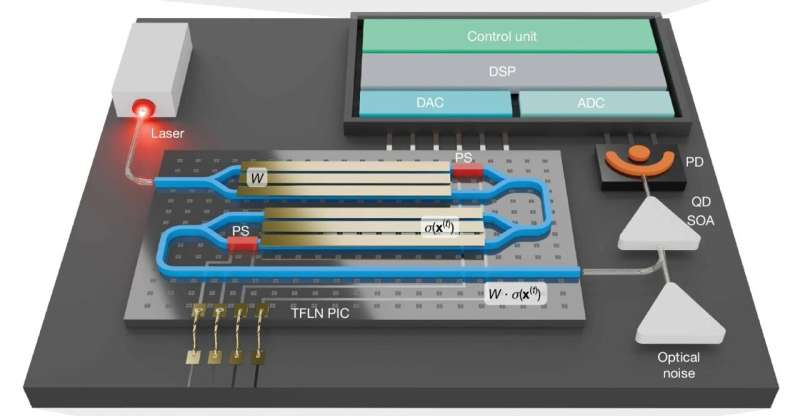

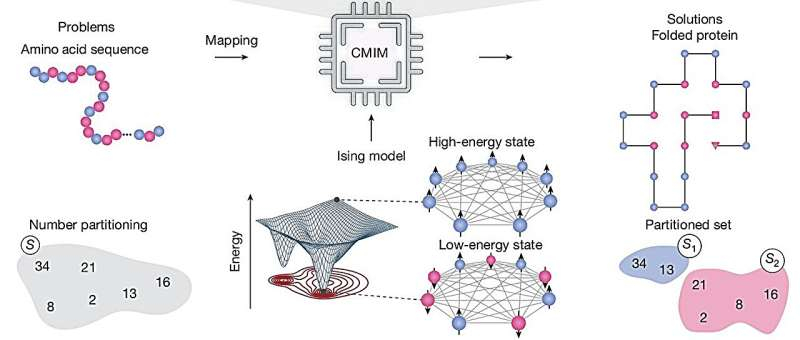

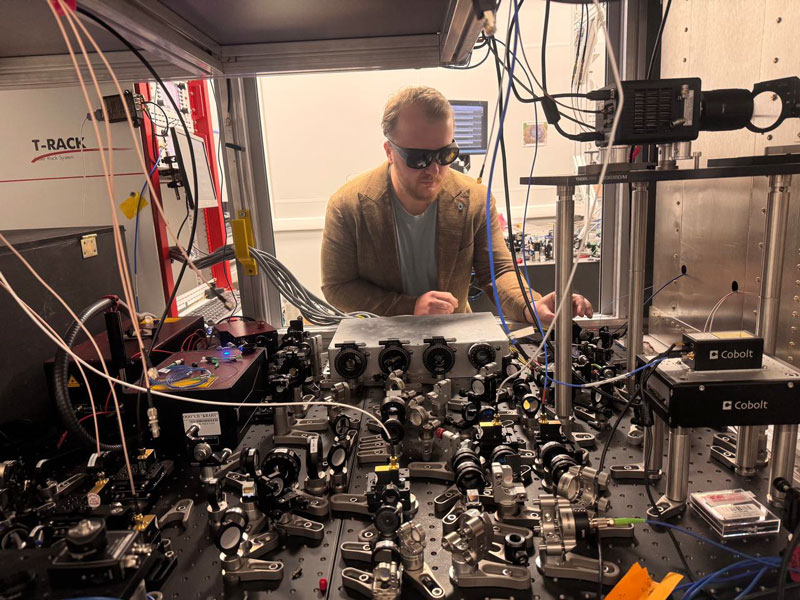

Учёные из Университета Квинс в Кингстоне (Queen's University) создали программируемую фотонную машину Изинга, работающую при комнатной температуре и часами сохраняющую стабильность. Установку можно назвать «копеечным» аналогом квантовых компьютеров компании D-Wave, поскольку они решают сходные задачи комбинаторной оптимизации. Но разница в цене, надёжности и стоимости обслуживания университетской установки и систем D-Wave колоссальна, и не в пользу последних.

Источник изображений: Nature 2025 Платформа учёных построена на базе оптоэлектронного генератора световых импульсов с использованием доступных в продаже компонентов для оптического телекоммуникационного оборудования: лазеров, модуляторов света на тонкоплёночном ниобате лития, полупроводникового оптического усилителя и электроники для цифровой обработки сигналов. В своей основе вычислитель работает на базе так называемой модели Изинга, которая в оригинале использует миниатюрные магниты, только вместо них университетская установка опирается на импульсы света. Модель Изинга позволяет решать сложные задачи комбинаторной оптимизации — это, прежде всего, знаменитая задача коммивояжёра, которому нужно найти оптимальный маршрут для посещения множества адресов с минимальными затратами на путь. Но она также позволяет ускорить расчёты с разбиением чисел и даже с синтезом белков. Решение возникает в процессе естественного (физического) стремления системы к минимальному значению энергии, что и будет ответом на поставленную задачу. Исполнение таких задач криогенной квантовой платформой D-Wave и другими подобными называется квантовым отжигом. Университетская установка делает то же самое, только каждый её вычислительный элемент — виртуальный спин — представлен импульсом света в петле с хитрым управлением. Задача кодируется импульсами света и запускается в систему, где они циркулируют до достижения минимальной энергии, что выражается в виде остаточной последовательности импульсов на выходе. Установка оперирует 256 спинами, которые допускают 65 536 связей «всех со всеми». Системам D-Wave, которые в миллионы раз дороже, такой масштаб пока даже не снился.  Очевидно, это можно реализовать не для всех задач, но никто не мешает разработке развиваться. В отличие от платформ D-Wave, предложенная учёными установка работает при комнатной температуре и остаётся стабильной часами, а не в течение считанных миллисекунд, как квантовые системы той же D-Wave. Созданная учёными машина достигла рекордной производительности — более 200 GOPS (гигаопераций в секунду) при взаимодействии спинов и нелинейной обработке. Разработка открывает путь к практическому, масштабируемому и энергоэффективному аналоговому вычислителю для задач оптимизации, логистики, криптографии, дизайна лекарств и нейроморфных вычислений. Новая статья: Квантовая коррекция: гонка за экспонентой

06.02.2026 [00:10],

3DNews Team

Данные берутся из публикации Квантовая коррекция: гонка за экспонентой Созданный в Европе аналоговый чип оказался в 5000 раз эффективнее цифровых решений

27.01.2026 [12:22],

Геннадий Детинич

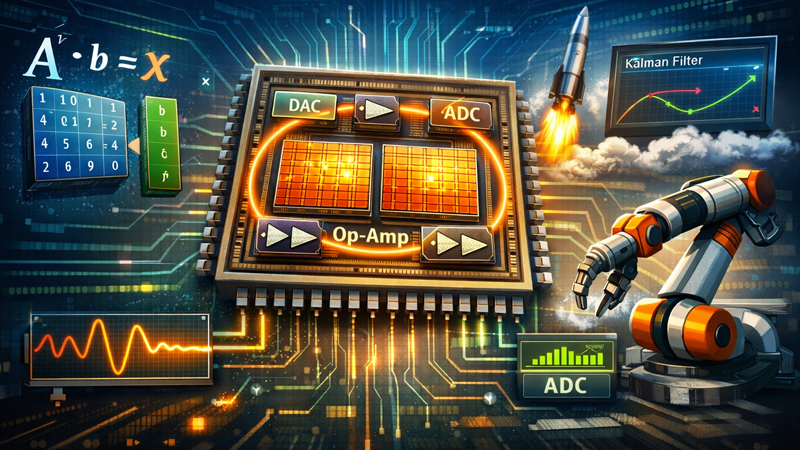

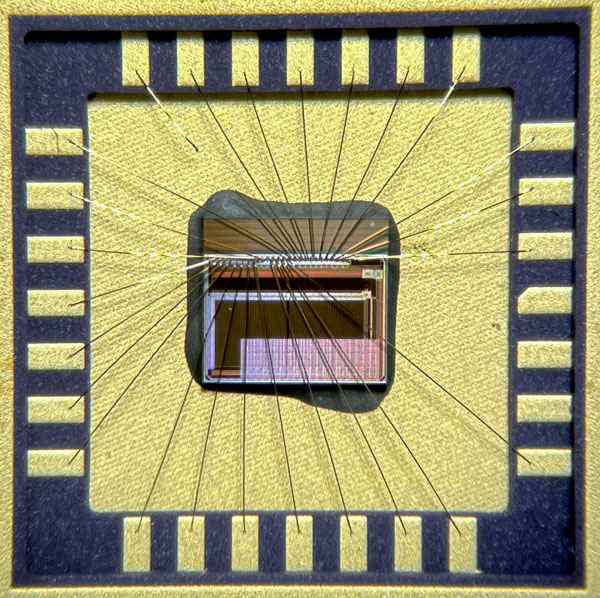

В Италии создали прототип аналогового процессора для тысячекратного ускорения обработки данных в сфере робототехники, ИИ и больших данных. Вычисления происходят в памяти процессора без пересылки данных, демонстрируя снижение потребления по сравнению с «цифрой» до 5000 раз.

Источник изображения: ИИ-генерация ChatGPT 5.2/3DNews Исследователи давно движутся в сторону вычислений в памяти, чтобы сократить энергетический бюджет компьютеров на пересылку данных из памяти в процессор и обратно. Это характерное для классической архитектуры фон Неймана «узкое место», которое ведёт к увеличению задержек и энергопотребления. Особенно перспективным вычисление в памяти обещает быть для реализации низкоуровневых операций линейной алгебры, требующих интенсивной обработки данных, в частности операций с матрицами и векторами. Ранее умножение матрицы на вектор уже успешно демонстрировалось в подобных системах, тогда как реализация умножения обратной матрицы на вектор представляет собой более сложную задачу по причине высокой схемотехнической сложности. Исследователи из Миланского политехнического университета (Politecnico di Milano) представили интегрированный аналоговый ускоритель вычислений с замкнутым контуром обратной связи, предназначенный для обеих этих операций. Устройство реализовано на основе статической памяти с произвольным доступом (SRAM) и изготовлено по 90-нм КМОП-технологии. Разработанный чип содержит два массива памяти размером 64 × 64, объединённых в аналоговую петлю обратной связи с использованием встроенных операционных усилителей, цифро-аналоговых и аналого-цифровых преобразователей. Такая архитектура позволяет выполнять операции инверсии матриц непосредственно в памяти, без необходимости передачи данных во внешние вычислительные блоки. Экспериментально показано, что ускоритель способен эффективно решать системы дифференциальных уравнений методом рекурсивной блочной инверсии, демонстрируя экономию потребления до 5000 раз по сравнению с цифровыми аналогами этих цепей.

Источник изображения: Politecnico di Milano Добавим, в основе массивов памяти лежат ячейки резистивной памяти ReRAM, которые схемотехнически связаны с ячейками SRAM. Ячейка ReRAM — это безусловно аналоговый элемент, задающий тон всей новой платформе. Также следует сказать, что в основе этой европейской разработки лежат проекты учёных из Пекинского университета, которые тоже публикуют научные работы на эту же тему. В целом — это пример международного сотрудничества, которое решает общую проблему повышения эффективности высокопроизводительных вычислений. Практическая применимость предложенного решения продемонстрирована на задачах отслеживания траектории ракеты с использованием фильтра Калмана, а также на ускорении вычислений обратной кинематики в роботизированных манипуляторах. Полученные результаты по точности сопоставимы с полностью цифровыми системами при эквивалентной разрядности, при этом аналоговый подход с вычислениями в памяти обеспечивает выигрыш по задержке, энергопотреблению и занимаемой площади кристалла. Российские учёные придумали, как встроить многоуровневый подход в квантовые алгоритмы — от этого выиграют все

23.01.2026 [22:14],

Геннадий Детинич

Учёные Университета науки и технологий МИСИС совместно с исследователями Российского квантового центра (РКЦ) систематизировали современные подходы к реализации квантовых алгоритмов с использованием многомерных квантовых систем — кудитов. Зарубежные исследователи редко интересуются этим направлением. В то же время кудиты способны упростить архитектуру квантовых компьютеров и позволить реализацию более сложных алгоритмов, а это дорогого стоит.

Источник изображения: НИТУ МИСИС «Мы показали, как упростить сложные операции, без которых невозможно большинство квантовых алгоритмов. Обычно для их выполнения требуется множество шагов и дополнительных элементов, что повышает риск ошибок. Использование дополнительных состояний уже имеющихся в кудитах позволяет сократить число шагов для выполнения подобных операций», — отметил директор Института физики и квантовой инженерии НИТУ МИСИС, к.н. Алексей Фёдоров. В основе квантовых вычислений лежат кубиты — квантовые биты, которые могут находиться одновременно в суперпозиции состояний «0» и «1». Такие системы существенно превосходят классические биты по возможностям обработки информации, но современные квантовые процессоры ограничены по числу кубитов и подвержены ошибкам, что снижает эффективность выполнения алгоритмов. Чтобы преодолеть эти ограничения, российские исследователи обратились к кудитам, которые представляют собой многоуровневые квантовые носители с тремя, четырьмя или большим числом состояний, что теоретически позволяет кодировать и обрабатывать больше информации в рамках одного физического элемента. Ключевым вкладом группы МИСИС и РКЦ стали разработанные схемы включения дополнительных уровней кудитов исключительно на этапах выполнения определённых операций, после чего система возвращается к стандартной кубитной работе. Такой подход обеспечивает сокращение количества шагов, необходимых для реализации сложных квантовых алгоритмов, и уменьшает риск ошибок, поскольку меньшее число операций означает меньшую вероятность возникновения декогеренции и других технологических проблем. Учёные подчёркивают, что их схемы не привязаны к конкретной технологической платформе, будь то сверхпроводниковые цепи, ионные ловушки или фотонные системы. Предложенное учёными «включение» кудитов в классические квантовые алгоритмические схемы позволит незнакомым с многоуровневыми системами коллегам начать использовать кудиты без переосмысления хорошо знакомых им алгоритмов. В то же время кудиты могут сократить число операций в классических алгоритмах или позволят запускать алгоритмы на платформах с меньшим числом физических элементов, чем требуется для работы этих алгоритмов в обычном режиме. «Мы сознательно фокусируемся на квантовых алгоритмах, представленных в виде кубитных цепочек, поскольку именно в таком виде сегодня описывается подавляющее большинство квантовых алгоритмов. Это позволяет напрямую связать теоретические идеи с реальными аппаратными платформами и показать, как кудиты могут быть использованы без необходимости полностью переосмысливать существующие алгоритмы», — уточнила к.ф.-м.н. Анастасия Николаева, старший научный сотрудник группы квантовых информационных технологий РКЦ и НИТУ МИСИС. IBM объявила 2026 год годом рассвета квантовых вычислений

10.01.2026 [21:31],

Геннадий Детинич

На выставке CES 2026 компания IBM собрала полный зал слушателей, заворожив их перспективой неминуемого рассвета квантовых вычислений. По мнению компании, которое озвучил ведущий алгоритмист IBM Quantum Борха Перопадре (Borja Peropadre), текущий год станет годом уверенного проявления в вычислениях квантового преимущества. Можно даже сказать, что в 2026 году случится долгожданный рассвет квантовых технологий в вычислениях, что невозможно будет оспорить.

Источник изображения: IBM Докладчик отметил, что у компании есть план, и она его придерживается. Более того, IBM последовательно выполняет пункты этого плана. Например, один из первых пунктов — о достижении «квантовой полезности» вычислителей на кубитах — был достигнут в 2023 году, как и планировалось. Тогда компания IBM вместе с исследователями из Беркли доказала, что 127-кубитовый QPU Eagle в составе вычислителя исполнил алгоритм из 3000 двухкубитовых операций, впервые показав полезность квантового вычислителя для решения практически значимых задач, «превосходя возможности классических вычислений методом перебора». Следующий этап — доказать квантовое преимущество вычислителей на кубитах. По словам Перопадре, это будет сделано в текущем году, что также станет подтверждением его прогноза о квантовом рассвете в 2026 году. Третий этап наступит в 2029 году, когда компания представит первый отказоустойчивый имеющий практическую ценность универсальный квантовый компьютер. Центральным элементом наступления или проявления квантового преимущества IBM считает сочетание двух критериев: квантового отделения или разделения от классических вычислений и возможности проверить результат квантовых вычислений. Квантовое разделение подразумевает наличие чётко измеряемого превосходства квантового алгоритма над лучшими классическими подходами: по скорости, точности, глубине моделирования или энергоэффективности. Проверка же позволяет убедиться, что полученное решение верно, что особенно важно для задач, где классические методы не дают точного результата. При этом квантовое превосходство не произойдёт окончательно и бесповоротно. Всегда будет место и время для совершенствования классических алгоритмов. В этом останется преимущество конкуренции, которое будет подстёгивать развитие классического и квантового метода расчётов. В ряде экспериментов квантовые системы IBM уже начали демонстрировать превосходство над классическими алгоритмами в задачах, связанных с моделированием энергетических состояний молекулярных систем, однако компания подчёркивает, что это соревнование будет продолжаться: развитие квантовых методов стимулирует появление улучшенных классических моделей, что временно нивелирует преимущества и задаёт новые ориентиры. Как считают в IBM, достижение квантового преимущества наиболее вероятно сначала в таких областях, как оценка количественных (и поэтому наблюдаемых) характеристик в квантовой химии и материаловедении, оптимизация энергетических состояний систем (квантовая химия), а также при решении задач, позволяющих классическую проверку, например, такие как вычислительная факторизация (алгоритм Шора), моделирование цепочек Маркова или специализированные схемы тестирования. Всё это легко проверяется (что может быть проще перемножения чисел после факторизации?) и доказать квантовое превосходство особого труда не составит. С точки зрения аппаратной архитектуры IBM продолжает наращивать вычислительные возможности квантовых процессоров, оценивая прогресс по количеству доступных двухкубитных гейтов, определяющих глубину и сложность реализуемых алгоритмов. Если в 2023 году квантовые системы IBM могли выполнять примерно 3000 двухкубитных операций, то к 2025 году показатель вырос до 5000, а на 2026 год компания прогнозирует около 7500. Процессор «Козодой» (Nighthawk) на 120 кубитах, обладающий улучшенной топологией соединений и низким уровнем ошибок, рассматривается как ключевой элемент для выхода на устойчивые преимущества в практических задачах. IBM также подчёркивает критическую роль алгоритмов и поэтому развивает партнёрскую экосистему, включая проекты с открытыми данными. В компании понимают, что самостоятельно могут долго идти к нужному результату. Для квантовых вычислителей сегодня в мире придумано очень мало имеющих практическую ценность алгоритмов и любая помощь со стороны будет только приветствоваться. В России создали первый в мире квантовый компьютер на кусептах — это решит проблему масштабирования

30.12.2025 [10:05],

Геннадий Детинич

«Долго запрягают, но быстро ездят» — эта, то ли цитата, то ли пословица хорошо ложится на разработку квантовых платформ в России. Эти платформы плохо масштабируются, что вынуждает думать об основе, прежде чем начинать создавать практичные решения. И тогда перспективы открываются у многоуровневых кубитов — кудитов (qudit). Лучшие разработки в этой сфере смог обойти Российский квантовый центр, представив квантовую систему на семиуровневых кусептах.

Источник изображения: Российский квантовый центр За последние годы российская наука сделала заметный шаг в деле создания квантовых вычислительных машин, и появление первого отечественного ионного квантового компьютера на кусептах — семиуровневых квантовых элементах — можно считать кульминацией этой работы. Такой подход позволяет расширить вычислительную ёмкость системы без простого увеличения числа кубитов (но эта линейная простота лишь кажущаяся). Многоуровневые квантовые состояния, реализованные учёными Российского квантового центра на основе 26 ионов кальция, обеспечивают эквивалент 72-кубитной вычислительной мощности и, помимо прочего, демонстрируют рекордную для систем такого масштаба точность ключевых операций. Классический подход к масштабированию квантовых систем с помощью наращивания числа двухуровневых кубитов давно известен, но он сталкивается с ограничениями по контролю, устойчивости и габаритам платформы. Команда учёных во главе с Кириллом Лахманским пошла иным путём: они сосредоточились на многоуровневых квантовых состояниях — так называемых кудитах и, в частности, кусептах, способных принимать значения от 0 до 6. Такая стратегия позволяет увеличить объём информации, которую может обрабатывать один квантовый элемент, и тем самым выйти на качественно иной уровень масштабирования и вычислительных возможностей. Создание этой системы стало возможным благодаря комплексному решению инженерных и научных задач: разработке специализированных лазерных комплексов, сложной оптической архитектуры, а также модернизации управляющей электроники и программного обеспечения. На стадии контрольных испытаний новые вычислительные блоки продемонстрировали среднюю точность однокубитных операций 99,92 % и двухкубитных 96,5 %, что соответствует высокому уровню исполнения и подтверждает работоспособность архитектуры. В планах научной группы — интеграция ионных ловушек с индивидуальным контролем частиц и реализация алгоритмов для решения практических задач комбинаторной оптимизации (алгоритма MaxCut). Таким образом, новый квантовый компьютер представляет собой не только научный прорыв, но и технологическую платформу для решения сложных прикладных задач в логистике, моделировании и оптимизации, хотя когда это время придёт сегодня вряд ли кто-то точно может сказать. По крайней мере, многоуровневые состояния создают хорошую основу для масштабирования, тогда как классические двухуровневые явно испытывают с этим трудности. Добавим, квантовая платформа на 72 кубитах на ионах кальция стала третьей за последние дни, представленной российскими учёными в этой интересной области вычислений. Ранее были показаны 70-кубитный компьютер на ионах иттербия от научной группы Физического института имени П. Н. Лебедева РАН (ФИАН), а также 72-кубитная платформа на холодных атомах рубидия от МГУ. Китай вторым после Google шагнул к отказоустойчивым квантовым компьютерам и сделал это элегантно

26.12.2025 [18:22],

Геннадий Детинич

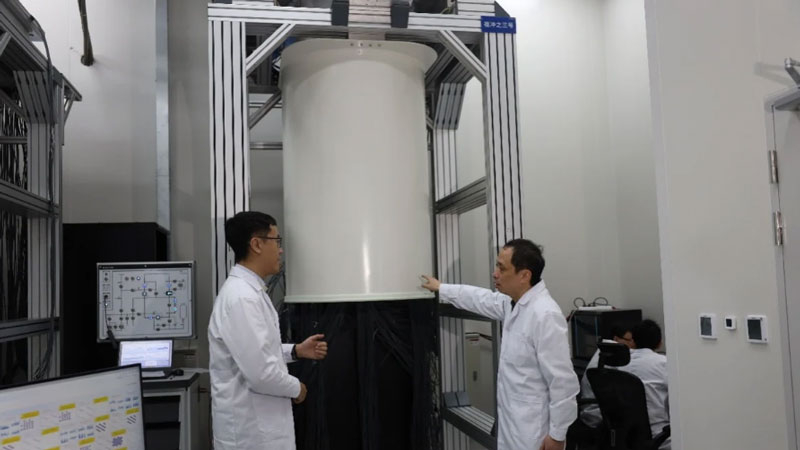

«Вековая» проблема квантовых вычислителей — рост числа ошибок вместе с наращиванием числа кубитов. Больше кубитов — больше ошибок, что затрудняет масштабирование и появление мощных отказоустойчивых квантовых компьютеров. Год назад Google сообщила, что вместе с новым процессором Willow она первой в мире решила проблему масштабирования, создав процессор с большим числом кубитов и вдвое меньшей вероятностью появления ошибок. Теперь Китай её в этом догнал.

Источник изображения: University of Science and Technology of China Команда исследователей из Университета науки и технологии Китая (University of Science and Technology of China) опубликовала в журнале Physical Review Letters работу, которую эксперты уже назвали «впечатляющей». Представленный почти одновременно с Google Willow процессор Zuchongzhi 3 с 107 кубитами (у Willow — 105 кубитов), как и его американский соперник, также показал увеличение числа кубитов с одновременным снижением частоты возникновения ошибок. Тем самым китайская команда заявляет о достижении порога отказоустойчивых квантовых систем — второй в мире и первой вне США. Более того, китайские разработчики утверждают, что им удалось реализовать более изящное и простое аппаратное решение проблемы коррекции ошибок. Так, если Google в процессоре Willow «подавляет ошибки» короткими импульсами тока, то в китайском процессоре Zuchongzhi 3.2 это происходит беспроводным способом — с помощью микроволнового излучения. В итоге китайская квантовая вычислительная платформа получается проще и эффективнее, а значит, её будет легче масштабировать. Как и Google Willow, китайский процессор Zuchongzhi 3.2 для коррекции ошибок использует поверхностный код и матрицу с разрядностью d=7. Эксперименты показали, что увеличение числа кубитов привело к снижению частоты появления ошибок с коэффициентом 1,4. Это хороший задел для совершенствования квантовых вычислителей, которых сегодня всё ещё не хватает для решения задач, неподъёмных для классических компьютеров. Установлен новый красивый рекорд по вычислению числа Пи: 314 трлн знаков за четыре месяца на одном сервере

25.12.2025 [18:24],

Сергей Сурабекянц

Вычисление числа Пи уже давно стало способом оценки производительности процессоров при вычислениях с плавающей запятой. Однако по мере роста объёмов вычислений задача усложнялась, поскольку на результат стали оказывать всё большее влияние оперативная память, архитектура ввода-вывода и система хранения данных (СХД). Это наглядно продемонстрировала команда StorageReview, установив новый рекорд в 314 трлн знаков на одном двухюнитовом сервере за четыре месяца.  Для вычисления числа Пи с таким количеством знаков требуется серьёзная СХД, ведь речь идёт о множителях, состоящих из триллионов цифр. В 2022 году Google установила рекорд в 100 триллионов знаков с использованием облачных серверов, а в этом году Linus Media Group и Kioxia достигли рекорда в 300 триллионов знаков, используя кластер Weka с общим хранилищем. Однако специалисты StorageReview решили побить рекорд, используя только локальные SSD-накопители. Энтузиасты использовали компьютер Dell PowerEdge R7725, оснащённый двумя 192-ядерными процессорами AMD Epyc и 1,5 Тбайт оперативной памяти DDR5. Однако наиболее выдающаяся часть системы — это массив хранения данных объёмом 2,5 петабайта, состоящий из 40 твердотельных накопителей Micron 6550 Ion объёмом 61,44 Тбайт каждый. Одним из ключевых факторов, обеспечивших быструю обработку 314 триллионов знаков, стала возможность прямого подключения в серверах Dell 17-го поколения SSD-накопителей непосредственно к PCIe-линиям процессоров. В случае 40 накопителей на каждый пришлось от 2 до 4 линий, что обеспечило внушительную производительность чтения/записи в 280 Гбайт/с.

Источник изображения: StorageReview Исследователи применили и другие важные оптимизации. Был особым образом настроен временный массив для обработки шаблонов, генерируемых программным обеспечением y-cruncher, применяемым для вычисления Пи, при большом количестве цифр. Также стандартное воздушное охлаждение сервера было заменено на систему CoolIT AHx10, что обеспечило повышенные тактовые частоты процессоров Epyc в установившемся режиме. Потребляемая мощность в процессе вычислений составила 1600 Вт, что является довольно впечатляющим показателем с точки зрения эффективности. Использовалась операционная система на Ubuntu 24.04.2, которая, по словам исследователей, обеспечила лучший результат по сравнению с Windows Server. IBM и Cisco к концу 30-х годов создадут интернет для котов Шрёдингера — квантовый и запутанный

20.11.2025 [20:10],

Геннадий Детинич

По мнению компаний IBM и Cisco, недалёк тот час, когда данные будут мгновенно загружаться на удалённый компьютер просто телепортируясь на него в соответствии с законами квантовой механики. Для этого они вошли в стратегическое партнёрство и обещают в течение пяти лет представить работающий прототип квантового интернета, чтобы уже к концу 30-х годов он стал глобальным.

Источник изображения: ИИ-генерация Grok 4/3DNews Компании IBM и Cisco объявили о стратегическом партнёрстве по созданию сети крупномасштабных отказоустойчивых квантовых компьютеров. Вкладом компании IBM в партнёрство станут достижения в области создания квантовых вычислительных платформ, тогда как компания Cisco представит свой опыт и знания в сфере квантовых сетей, протоколов и устройств.

Представление о квантовом преобразователе микроволн в оптический свет. Источник изображения: Cisco Очевидно, что рано или поздно квантовые компьютеры выйдут за рамки «персональных» решений и потребуют работы в распределённой сети. Подобный подход позволит значительно увеличить вычислительную мощность квантовых вычислений. Партнёры не намерены откладывать сетевые разработки в долгий ящик и уже в течение следующих пяти лет обещают представить «доказательство концепции» — работающий прототип квантовой сети, объединяющей два отдельных и самостоятельных квантовых компьютера в единый вычислительный кластер, а к концу 30-х годов намерены заложить основу для глобального квантового интернета.

Представление о первом коммерческом квантовом компьютере IBM «Скворец». Источник изображения: IBM Если с квантовыми компьютерами какая-то ясность есть, по крайней мере, IBM лично обещает представить к 2029 году первый коммерческий квантовый отказоустойчивый компьютер — то с квантовыми сетями всё очень сложно. Главная сложность в том, что технологий для их создания нет на базовых уровнях сетевой модели. Сетевым устройствам и протоколам придётся оперировать хрупкими квантовыми состояниями, о которых даже подумать страшно, не то что куда-то пересылать. Компания IBM в некотором роде поможет партнёру, обещая создать выходное сетевое устройство — Quantum Networking Unit (QNU), сопряжённое с квантовым процессором для вывода квантовых состояний из процессорного блока. Но затем в работу должна вступить Cisco. В квантовой архитектуре IBM данные на начальном этапе представлены в формате микроволнового сигнала. В Cisco берутся создать преобразователь микроволновых сигналов в оптические — для передачи по обычным каналам связи. Также Cisco будет работать над сетевым стеком и, в целом, над программно-аппаратной реализацией сетевого квантового соединения, включая распределение состояния запутанности между удалёнными квантовыми компьютерами.

Элементы квантового интернета Будущий квантовый интернет начнёт свой путь с лаборатории, продолжит его в ЦОД, затем — в масштабах мегаполиса и выйдет на глобальный простор. Эта сеть также будет включать в себя квантовые датчики, невероятная чувствительность которых позволит отслеживать погоду, землетрясения и многое другое. В конечном итоге распределённые квантовые вычисления приведут к появлению множества технологических чудес, которые долго ещё будут не по зубам локальным квантовым вычислителям. Илон Маск хочет на порядок больше ИИ-чипов, чем выпускает вся полупроводниковая индустрия мира

18.11.2025 [18:36],

Сергей Сурабекянц

Амбиции Илона Маска (Elon Musk) в области искусственного интеллекта настолько велики, что он хочет получить больше ускорителей ИИ, чем отрасль в настоящее время может произвести. По его словам, Tesla нуждается в «100–200 миллиардах чипов с искусственным интеллектом в год», и если она не сможет получить их от производителей, то рассмотрит возможность создания собственных фабрик.

Источник изображения: dogegov.com Маск заявил, что «испытывает огромное уважение к TSMC и Samsung», но он считает, что эти компании не в состоянии удовлетворить потребность его предприятий в чипах ИИ: «Когда я спросил, сколько времени займёт строительство новой фабрики по производству чипов, они ответили, что до запуска производства им потребуется пять лет. Пять лет для меня — это вечность. Мои сроки — год, два. […] Если они передумают и […] будут поставлять нам 100–200 миллиардов ИИ-чипов в год в те сроки, когда они нам нужны, это будет здорово». Маск не уточнил, когда Tesla и SpaceX потребуются эти 100–200 миллиардов ИИ-процессоров в год, но в любом случае выпуск такого количества чипов практически неосуществим, если он имел в виду единицы, а не сумму в долларах. По данным Ассоциации полупроводниковой промышленности, в 2023 году по всему миру произведено 1,5 трлн чипов. Однако в это число входят любые микросхемы — от крошечных микроконтроллеров и датчиков до чипов памяти и ускорителей ИИ.

Источник изображений: Tesla Такие ускорители ИИ, как Nvidia H100 или B200/B300, представляют собой огромные кремниевые блоки, которые сложно и дорого производить, поэтому на их изготовление уходит больше всего времени. По словам Маска, энергопотребление его ИИ-процессоров AI5 составит 250 Вт, в то время как графические процессоры Nvidia B200 могут потреблять до 1200 Вт. Этот параметр может служит косвенной оценкой размера чипов. Даже если чип AI5 будет в пять раз меньше Nvidia B200, мощностей для достижения целей Маска всё равно совершенно недостаточно. Будучи одним из крупнейших клиентов TSMC, Nvidia поставила четыре миллиона графических процессоров Hopper стоимостью $100 млрд (не считая Китая) за весь срок службы архитектуры, который составил около двух календарных лет. С Blackwell Nvidia продала около шести миллионов графических процессоров за первые четыре квартала их жизненного цикла. Если Маск действительно имел в виду 200 миллиардов устройств, то он хотел бы получить на порядки больше процессоров для искусственного интеллекта, чем отрасль (бо́льшая часть которой приходится на TSMC) может производить за год. Если он всё же подразумевал потребность в ИИ-чипах на сумму от $100 до $200 млрд, то TSMC и Samsung, безусловно, смогут поставить такой объём в ближайшие годы. Однако, похоже, что он действительно считает, что ему нужно больше, чем эти компании могут предложить.  «Мы будем использовать фабрики TSMC на Тайване и в Аризоне, фабрики Samsung в Корее и Техасе, — сказал Маск. — С их точки зрения, они движутся молниеносно. […] тем не менее, это будет для нас ограничивающим фактором. Они работают на пределе своих возможностей, но с их точки зрения — это “педаль в пол”. У них просто не было компании, которая разделяла бы наше понимание срочности. Возможно, единственный способ масштабироваться с желаемой скоростью — это построить действительно большой завод или быть ограниченным в производстве Optimus и беспилотных автомобилей из-за [поставок] ИИ-чипов. Действительно ли потребность Tesla и SpaceX в ИИ-чипах настолько высока, остаётся неясным. Tesla продала 1,79 млн автомобилей в 2024 году, поэтому ей вряд ли требуется больше двух миллионов чипов для своих автомобилей. Конечно, компаниям Маска могут понадобиться ещё миллионы ИИ-процессоров для обучения ИИ, но маловероятно, что Маск в ближайшее время готов создать ИИ-кластеры на базе миллиардов чипов. Антропоморфные роботы Optimus также вряд ли потребуют таких объёмов чипов в ближайшие годы.  Ранее мы писали, как воодушевлённый итогами голосования по новому компенсационному плану Илон Маск на собрании акционеров фонтанировал обещаниями и идеями, и по традиции пританцовывал в момент появления на сцене человекоподобного робота Optimus. Тогда он заявил, что для достижения поставленных новым планом целей Tesla вынуждена будет наладить самостоятельный выпуск чипов. IBM представила первый отказоустойчивый квантовый процессор «Гагара» (Loon) — он призван изменить мир

13.11.2025 [13:52],

Геннадий Детинич

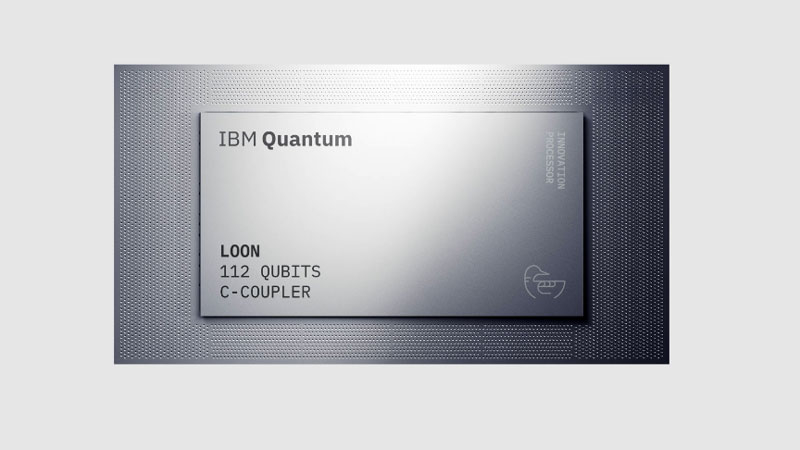

К 2029 году IBM собирается представить первый отказоустойчивый коммерческий квантовый компьютер Starling («Скворец»), в основе которого будет лежать новая архитектура и более развитый алгоритм коррекции ошибок qLDPC. Первым воплощением этих планов стал экспериментальный квантовый процессор Loon («Гагара»), о котором IBM говорит, как о решении, впервые заключающем в себе все ключевые компоненты, необходимые для отказоустойчивых квантовых вычислений.

Источник изображений: IBM Процессор IBM Loon поможет тестировать новую архитектуру для будущей реализации крупномасштабных квантовых вычислительных платформ и масштабирования компонентов, необходимых для практического и высокоэффективного исправления квантовых ошибок. Ранее IBM уже продемонстрировала некоторые революционные, по её словам, функции, которые будут реализованы в этом процессоре, например, внедрение нескольких высококачественных уровней маршрутизации с низкими потерями для обеспечения более длинных внутричиповых соединений (или С-сцепок), которые выходят за рамки сцепок с ближайшими соседями и физически связывают удалённые кубиты на одном чипе, а также технологии сброса кубитов между вычислениями.

Сравнение архитектур QPU IBM «Цапли» (слева) и «Гагары» (справа) Уход от соединений кубитов с ближайшими соседями к связям с удалёнными кубитами поможет, в том числе, отказаться от поверхностных кодов коррекции ошибок в пользу низкоплотной проверки чётности для квантовых систем (quantum low-density parity check, qLDPC). «Утверждается, что использование этой схемы вместо поверхностного алгоритма позволит сократить число физических кубитов, необходимых для реализации одного логического, примерно на порядок». Это тот резерв, который может дать IBM фору в достижении пресловутого квантового превосходства. Сочетание возможностей архитектуры Loon с коррекцией квантовых ошибок вычислений на классических компьютерах станет тем шагом, который быстрее всего приблизит сверхпроводящие квантовые платформы IBM к практической ценности. К слову, IBM также доказала, что можно использовать классическое вычислительное оборудование для точного декодирования ошибок в режиме реального времени с помощью кодов qLDPC (менее чем за 480 нс). И этот технический прорыв был совершён на год раньше запланированного срока. Для производства чипов с архитектурой для QPU Loon компания начала использовать 300-мм линии комплекса Albany NanoTech в Нью-Йорке. Когда-то это было практически собственное производство IBM, но с середины нулевых оптимизация бизнеса компании заставила её расстаться с обременительными активами. В то же время IBM остаётся главным клиентом этого центра и теперь перенесла туда разработку квантовых процессоров. Современное полупроводниковое оборудование центра и возможности непрерывной работы на этом предприятии уже ускорили процесс обучения персонала, совершенствования и расширения возможностей квантовых процессоров IBM, что позволило компании увеличить количество подключаемых кубитов, их плотность и производительность.  На сегодняшний день IBM удалось удвоить скорость исследований и разработок, сократив время, необходимое для создания каждого нового процессора, как минимум вдвое; достичь десятикратного увеличения физической сложности квантовых чипов; и получить возможность параллельно исследовать и изучать несколько проектов. Процессоры «Козодой» и «Гагара» стали реальностью во многом благодаря переходу на выпуск 300-мм пластин, что станет ещё одним преимуществом IBM в гонке за квантовым превосходством. Нестареющая классика: суперкомпьютеры продолжат исправлять ошибки квантовых вычислений на QPU IBM

13.11.2025 [13:37],

Геннадий Детинич

Компания IBM всеми силами стремится первой ворваться в сферу практических квантовых вычислений, для чего она предпочла пока сохранить прежнее знакомство разработчиков квантовых алгоритмов с широко распространёнными поверхностными кодами коррекции ошибок. Часть вычислительной нагрузки для этого можно переложить на классические компьютерные архитектуры, чем IBM не стыдится пользоваться и продолжает развивать.

Источник изображения: ИИ-генерация Grok 4 В значительной степени коррекция ошибок квантовых вычислений на новой платформе Nighthawk осуществляется на классических компьютерах, например, на процессорах компании AMD. Для этого IBM развивает «лучший в мире» программный стек или фреймворк Qiskit. Теперь он предоставляет разработчикам больше возможностей для контроля, чем когда-либо прежде, за счёт масштабирования динамических возможностей схем, что позволяет повысить точность на 24 % при использовании более 100 кубитов. IBM также расширяет возможности Qiskit с помощью новой модели исполнения, которая обеспечивает детальный контроль, и C-API, открывающего возможности устранения ошибок с ускорением высокопроизводительных вычислений, что снижает затраты на получение точных результатов более чем в 100 раз. Также IBM предоставляет интерфейс C++ для Qiskit на базе C-API, чтобы пользователи могли программировать квантовые вычисления в существующих средах высокопроизводительных вычислений. К 2027 году IBM планирует расширить Qiskit за счёт вычислительных библиотек в таких областях, как машинное обучение и оптимизация, чтобы эффективнее решать фундаментальные задачи в области физики и химии, такие как решение дифференциальных уравнений и более специфические. До квантового преимущества рукой подать: IBM представила «Козодоя» — квантовый процессор нового поколения

13.11.2025 [13:36],

Геннадий Детинич

На ежегодном мероприятии Quantum Developer Conference компания IBM представила два новых квантовых процессора: Nighthawk («Американский козодой») и Loon («Гагара»), а также обновлённый программный стек для квантовых вычислений с использованием суперкомпьютеров. Поставки QPU Nighthawk стартуют до конца 2025 года, что позволит IBM первой в мире добиться квантового преимущества в вычислениях уже через год и приведёт к квантовой революции в 2029 году.

Источник изображения: IBM «Для того чтобы квантовые вычисления стали по-настоящему полезными, необходимо множество составляющих, — сказал Джей Гамбетта (Jay Gambetta), директор по исследованиям IBM и научный сотрудник IBM. — Мы считаем, что IBM — единственная компания, которая способна быстро разрабатывать и масштабировать квантовое программное обеспечение, аппаратные средства, производство и коррекцию ошибок, чтобы создавать революционные приложения. Сегодня мы рады сообщить о свершении многих из этих достижений». Квантовый процессор Nighthawk компания представила как свой самый развитый процессор. Он содержит 120 кубитов, соединённых с помощью 218 настраиваемых сцепок (couplers) нового поколения с четырьмя ближайшими соседями, организованными в квадратную решётку. Чип имеет на 20 % больше сцепок, чем предыдущее решение — QPU Heron («Цапля»). Важно то, что Nighthawk развивает архитектуру Heron. Это означает, что IBM для рывка в сторону квантового преимущества слегка «наступила на горло» своей «лебединой песне» — отказу от поверхностных кодов коррекции в пользу qLDPC (низкоплотной проверки чётности для квантовых систем). Дело в том, что экспериментальная квантовая архитектура IBM с опорой на qLDPC, впервые реализованная в QPU Loon, пока плохо знакома квантовому сообществу, тогда как поверхностные коды для исправления ошибок квантовых вычислений используются десятилетиями. В компании здраво рассудили, что ставка на самое революционное решение может позволить свершить квантовое преимущество кому-то другому, что плохо для имиджа и продаж. В любом случае, продукт лучше развивать так, чтобы пользователи были с ним знакомы заранее. Тем самым Nighthawk продолжит традицию коррекции ошибок и станет эволюцией QPU, а не революцией. В то же время Nighthawk — это заметный шаг вперёд. В IBM заявляют, что благодаря расширенным возможностям подключения кубитов пользователи смогут точно выполнять алгоритмы, которые будут на 30 % сложнее, чем позволял предыдущий процессор IBM, при этом сохраняя низкий уровень ошибок. В частности, Nighthawk позволит запускать алгоритмы с использованием 5000 двухкубитных гейтов (в отличие от однокубитных, двухкубитные гейты позволяют осуществлять запутывание кубитов, необходимое для квантовых вычислений). В IBM ожидают, что к концу 2026 года будущие версии Nighthawk смогут управлять до 7500 гейтов, а в 2027 году — контролировать схемы с использованием до 10 000 гейтов. К 2028 году системы на базе Nighthawk смогут поддерживать до 15 000 двухкубитных гейтов, активируемых 1000 или более подключёнными кубитами, объединёнными с помощью дальнодействующих сцепок, впервые продемонстрированных на экспериментальных процессорах IBM в прошлом году. Все преимущества традиционного подхода IBM к методам коррекции ошибок раскроются уже в конце 2026 года, когда компания ожидает сама — или благодаря партнёрам по сообществу — добиться первого в мире публично доказанного квантового превосходства, а не тех «качелей», которые сопровождают доклады компании Google об их личных достижениях в этой области. Для IBM может быть принципиальным утереть нос конкуренту. В Google имели неосторожность связывать свои квантовые преимущества со сравнением с суперкомпьютерами IBM — не в пользу последних. Такое редко прощают. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |