|

Опрос

|

реклама

Быстрый переход

Учёные придумали термодинамический компьютер, который генерирует изображения в 10 млрд раз энергоэффективнее ИИ

28.01.2026 [15:43],

Павел Котов

Американские учёные предложили использовать в генераторах изображений на основе искусственного интеллекта технологию термодинамических вычислений — она позволяет сократить энергетические затраты на некоторые операции на величину до 10 млрд раз.

Источник изображения: Steve Johnson / unsplash.com Модели генеративного ИИ, в том числе DALL-E, Midjourney и Stable Diffusion, создают фотореалистичные изображения, но потребляют при этом огромное количество энергии. Это диффузионные модели. При обучении им подают большие наборы изображений, к которым постепенно добавляют шум, пока картинка не станет похожей на помехи в старом телевизоре. Далее нейросеть овладевает обратным процессом и генерирует новые изображения по запросу. Проблема в том, что вычисления для алгоритмов ИИ с добавлением и последующим удалением шума потребляют слишком много энергии — термодинамические вычисления позволяют сократить их несоразмерно возможностям современного цифрового оборудования, рассказали в Национальной лаборатории имени Лоуренса в Беркли (Калифорния). При термодинамических вычислениях используются физические схемы, которые меняют параметры в ответ на шум, например вызванный случайными тепловыми перепадами в окружающей среде. Стартап Normal Computing построил чип на основе восьми соединённых друг с другом резонаторов — соединители подключаются сообразно типу решаемой чипом задачи. Далее резонаторы подвергаются воздействию внешней среды, вносят шум в цепь и таким образом выполняют вычисления. После того как система достигает состояния равновесия, решение считывается из новой конфигурации резонаторов. Учёные Национальной лаборатории имени Лоуренса в Беркли показали, что можно построить термодинамическую версию нейросети. Эта методика закладывает основу для генерации изображений с помощью термодинамических вычислений. В термодинамический компьютер вводится набор изображений, далее компоненты компьютера подвергаются естественным воздействиям среды до тех пор, пока связи, соединяющие эти компоненты, не достигают состояния равновесия. Далее вычисляется вероятность того, что термодинамический компьютер с заданным состоянием связей сможет обратить этот процесс, и значения этих связей корректируются, чтобы повысить эту вероятность до максимальной. Симуляции подтвердили, что можно построить термодинамический компьютер, настройки которого помогут генерировать изображения рукописных цифр. Это достигается без энергоёмких цифровых нейросетей или создающего шум генератора псевдослучайных чисел. По сравнению с цифровыми нейросетями термодинамические компьютеры пока примитивны, признают учёные, и как проектировать их для работы на уровне DALL-E, они пока не знают. Но в аспекте энергоэффективности они обещают значительное преимущество. Apple создала ИИ, который генерирует тексты в 128 раз быстрее аналогов

14.10.2025 [12:49],

Владимир Мироненко

Разработчики Apple и Университета штата Огайо создали новую диффузионную модель Few-Step Discrete Flow-Matching (FS-DFM), которая может писать тексты в 128 раз быстрее аналогов, сообщил ресурс 9to5mac.com со ссылкой на исследование «FS-DFM: быстрая и точная генерация длинных текстов с помощью моделей языка диффузии с малым количеством шагов».

Источник изображения: Jackson Sophat/unsplash.com Согласно исследованию, FS-DFM способна записывать полные текстовые фрагменты всего за восемь быстрых шагов уточнения. Для получения аналогичного результата по записи текстового фрагмента другим моделям диффузии требуется более тысячи шагов. Для этого исследователи используют трёхэтапный подход: сначала модель обучается обрабатывать различные виды итераций уточнения. Затем они используют направляющую модель «учителя», которая помогает ей делать более крупные и точные обновления на каждой итерации, не выходя за рамки заданного текста. И наконец, они выполняют корректировку работы каждой итерации с тем, чтобы конечный результат был достигнут за меньшее количество шагов при более стабильной работе модели. По сравнению с более крупными моделями диффузии, FS-DFM показала хорошие результаты по двум важным метрикам: перплексии и энтропии. Показатель перплексии отражает качество текста в языковых моделях. Чем он ниже, тем точнее и естественнее звучит текст. Энтропия отражает, насколько уверенно модель выбирает каждое слово. Если энтропия слишком низкая, текст может стать повторяющимся или предсказуемым, но если она слишком высокая, он может выглядеть бессвязным со случайным набором слов. По сравнению с моделями диффузии Dream с 7 млрд параметров и LLaDA с 8 млрд параметров варианты FS-DFM с 1,7 и 1,3, а также 0,17 млрд параметров стабильно обеспечивали меньшую перплексию и более стабильную энтропию на протяжении всего количества итераций. Разработчики сообщили, что «планируют опубликовать код и контрольные точки модели для облегчения воспроизводимости и дальнейших исследований». Topaz Labs представила диффузную ИИ-модель, которая автоматически улучшает старые видео

07.02.2025 [18:32],

Владимир Мироненко

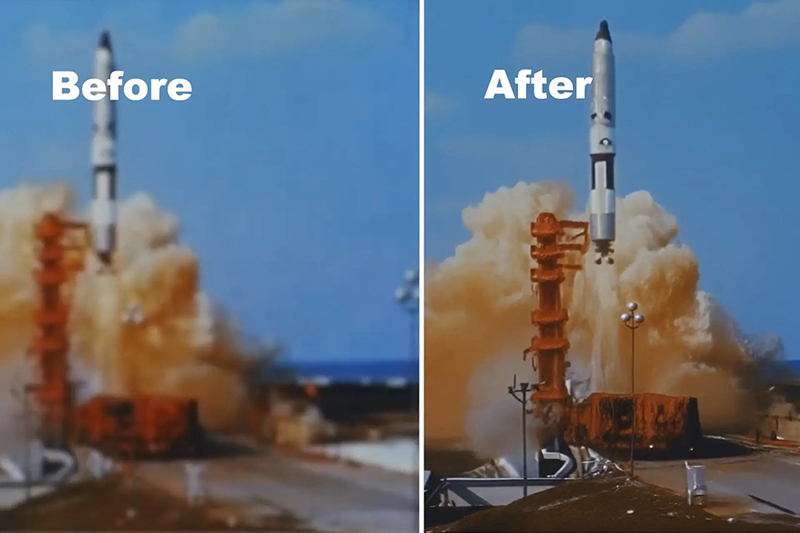

Компания Topaz Labs, специализирующая на разработке программного обеспечения для редактирования фотографий и видео, представила модель ИИ Project Starlight для повышения качества старых кадров из домашней видеоколлекции или архивного контента, качество которого могло со временем ухудшиться в ходе хранения на традиционных носителях.

Источник изображения: Topaz Labs По словам разработчика, это первая в истории диффузионная модель, созданная для этих целей, и ей не требуется ручной ввод данных для исправления видео. Сообщается, что Project Starlight была создана с нуля с использованием новой архитектуры модели с более чем 6 млрд параметров, и её работа поддерживается передовыми ускорителями NVIDIA. Для сравнения, вышедшая в мае 2024 года большая языковая модель GPT-4o от OpenAI с возможностью обработки текста, аудио, изображений и видео в качестве входных данных, изначально имела 8 млрд параметров. Topaz Labs утверждает, что модель «точно восстанавливает детали» и обеспечивает «непревзойдённое восстановление деталей в сочетании с непревзойдённой временной согласованностью». По словам компании, именно в этом и заключается суть её новой модели: улучшение нескольких кадров для достижения высококачественных результатов восстановления без артефактов движения или несоответствий между кадрами и объектами. Project Starlight также автоматически удаляет шумы, устраняет размытость, масштабирует и сглаживает кадры по запросу. Для работы с этой ИИ-моделью вовсе не требуется наличие специальных знаний в области обработки видео. Возвращение старого видео к жизни включает в себя несколько процессов, в том числе масштабирование, цветокоррекцию и сортировку, интерполяцию кадров, устранение повреждений и восстановление звука. Для каждого из этих вариантов восстановления уже созданы инструменты на базе ИИ, но для достижения наилучших результатов всем процессом в настоящее время должны управлять люди. Topaz Labs сообщила, что пользователи могут с помощью её ИИ-модели бесплатно восстанавливать видео длительностью до 10 с, в то время как клипы продолжительностью до 5 минут будут иметь максимальное разрешение 1080p и для этого потребуются кредиты. Версия для корпоративных пользователей поддерживает восстановление более продолжительных видео и с более высоким разрешением. Пока неизвестно, будет ли Project Starlight работать локально или будет интегрирована в другие приложения компании. |