|

Опрос

|

реклама

Быстрый переход

OpenAI выпустила GPT-5.3-Codex-Spark — свою первую ИИ-модель, работающую без чипов Nvidia

12.02.2026 [23:26],

Николай Хижняк

Компания OpenAI выпустила свою первую модель искусственного интеллекта, работающую на гигантских чипах-ускорителях Wafer Scale Engine 3 от стартапа Cerebras Systems. Данный шаг является частью усилий создателя ChatGPT по диверсификации поставщиков аппаратного обеспечения для обучения своих моделей.

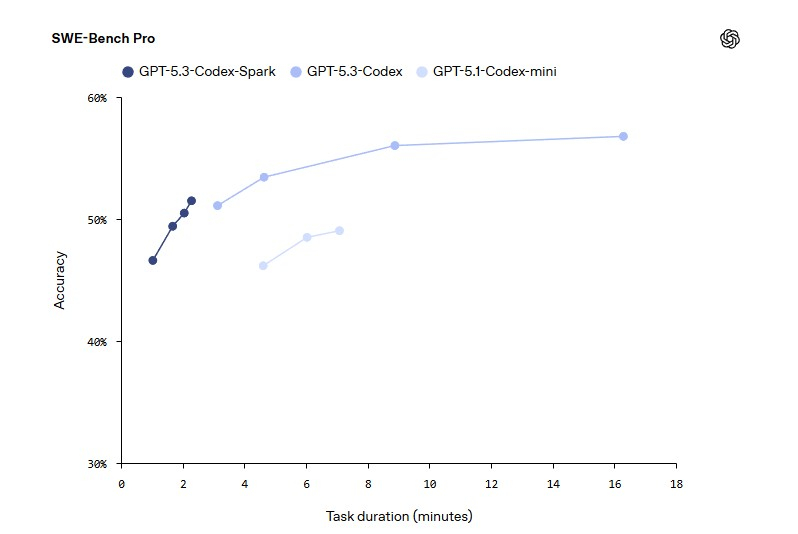

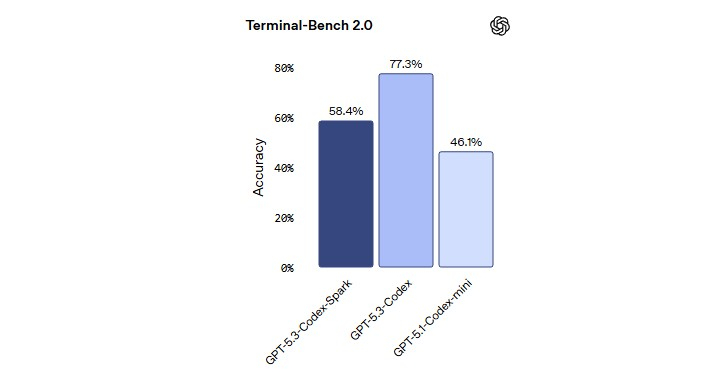

Источник изображения: OpenAI Модель GPT-5.3-Codex-Spark является менее мощной, но более быстрой версией продвинутой модели GPT-5.3-Codex, ориентированной на помощь в написании программного кода. Версия Spark позволит инженерам-программистам быстро выполнять такие задачи, как редактирование отдельных фрагментов кода и запуск тестов. Пользователи также могут легко прервать работу модели или дать ей указание выполнить что-то другое, связанное с вайб-кодингом, не дожидаясь завершения длительного вычислительного процесса.

Источник изображения: OpenAI В прошлом месяце OpenAI заключила сделку на сумму более $10 млрд на использование оборудования Cerebras для ускорения обучения своих моделей ИИ. Для Cerebras это партнёрство представляет собой значительный шаг в её стремлении конкурировать на рынке аппаратных средств для ИИ, где долгое время доминирует компания Nvidia. Для OpenAI — это способ расширить сотрудничество с разными поставщиками оборудования для удовлетворения растущих вычислительных потребностей.

Источник изображения: OpenAI В октябре OpenAI заявила о заключении многолетнего соглашения о стратегическом партнёрстве, в рамках которого будет построена ИИ-инфраструктура на базе сотен тысяч ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт. Позже в том же месяце OpenAI согласилась приобрести специализированные чипы и сетевые компоненты у Broadcom. Как пишет Bloomberg, в последнее время отношения OpenAI с Nvidia оказались под пристальным вниманием на фоне сообщений о напряженности между двумя компаниями. Однако руководители обеих компаний публично заявили, что по-прежнему привержены сотрудничеству. В заявлении, опубликованном в четверг, представитель OpenAI заявил, что партнёрство компании с Nvidia является «основополагающим» и что самые мощные модели ИИ OpenAI являются результатом «многолетней совместной работы над аппаратным и программным обеспечением» двух компаний. «Именно поэтому мы делаем упор на Nvidia как на основу нашей системы обучения и вывода, целенаправленно расширяя экосистему вокруг неё за счёт партнёрств с Cerebras, AMD и Broadcom», — заявил представитель компании. Первоначально GPT-5.3-Codex-Spark будет доступна подписчикам ChatGPT Pro в качестве предварительной версии для исследований. OpenAI собирается предоставить доступ к новой ИИ-модели для более широкого числа пользователей в ближайшие недели. Компания также отмечает, что Codex имеет более 1 млн активных еженедельных пользователей. OpenAI усомнилась в эффективности ускорителей Nvidia для инференса и всё активнее ищет им альтернативу

03.02.2026 [08:40],

Алексей Разин

Принято считать, что OpenAI и Nvidia являются главными выгодоприобретателями бума искусственного интеллекта, и они поддерживают прочные партнёрские отношения, которые должны быть подкреплены сделкой на сумму $100 млрд. Источники при этом отмечают, что эффективность ускорителей Nvidia в инференсе может не устраивать OpenAI, поэтому она стремится найти им подходящую альтернативу.

Источник изображения: Nvidia Об этом по своим каналам удалось выяснить Reuters, хотя публично OpenAI и Nvidia продолжают выражать крайнюю степень взаимной лояльности. Если верить данным источника, OpenAI хотела бы до 10 % ускорителей в своей вычислительной инфраструктуре заменить на решения сторонних поставщиков, которые лучше проявляли бы себя в задачах инференса — то есть, эффективнее бы работали с уже обученными большими языковыми моделями. OpenAI даже хотела договориться с Cerebras и Groq о поставках разрабатываемых этими стартапами чипов, но Nvidia решила сработать на опережение, купив в прошлом году последний за $20 млрд. До этого Groq вела переговоры с другими инвесторами о вложении в свой капитал до $14 млрд, но Nvidia предложила больше, обеспечив при этом весьма специфическую структуру сделки. По её условиям, Groq сохранила возможность лицензирования своих разработок другим компаниям, но фактически Nvidia перевела в свой штат основных разработчиков ускорителей из Groq. Фактически, остальным компаниям Groq теперь может предложить только программное обеспечение для облачных систем. Одновременно возникают вопросы по целесообразности сделки, в рамках которой Nvidia предложила направить в капитал OpenAI до $100 млрд. Пока стороны отрицают наличие проблем в этой сфере, хотя Nvidia и подчёркивает, что её обязательства не носят строгого характера. Сделку с Cerebras компании OpenAI заключить удалось, теперь вторая будет покупать у первой так называемые «царь-ускорители», которые неплохо проявляют себя в задачах инференса. Проблема OpenAI до сих пор заключалась в том, что она сильно зависит от ускорителей Nvidia и AMD, которые используют внешнюю, пусть и очень быструю память HBM, а в инференсе себя лучше проявляют чипы с большим объёмом интегрированной памяти. Таковые как раз предлагают Groq и Cerebras, а также конкурирующая Google. С последней, кстати, смогла договориться Anthropic, поэтому OpenAI пришлось искать альтернативы. По некоторым данным, OpenAI столкнулась с неэффективностью ускорителей Nvidia при создании ИИ-агента Codex, который помогает разработчикам создавать программный код. Обычные пользователи того же ChatGPT подобных проблем не испытывают, но для программистов OpenAI постарается предложить другие аппаратные решения типа изделий Cerebras, чтобы повысить производительность соответствующих программных инструментов. OpenAI договорилась о покупке царь-ускорителей Cerebras на $10 млрд — чтобы снизить зависимость от Nvidia

15.01.2026 [07:54],

Владимир Фетисов

Компания OpenAI подписала соглашение с разработчиком царь-ускорителей Cerebras. В рамках достигнутых договорённостей Cerebras поставит OpenAI 750 МВт вычислительных мощностей до 2028 года для достижения цели по удержанию лидирующих позиций в сфере ИИ и удовлетворения растущего спроса со стороны потребителей. По данным источника, сумма сделки составит $10 млрд.

Источник изображения: OpenAI Гендиректор Cerebras Эндрю Фельдман (Andrew Feldman) сообщил, что переговоры между двумя компаниями начались в августе прошлого года. Поводом стала демонстрация Cerebras того, что ИИ-модели OpenAI способны работать на ускорителях компании более эффективно, чем на традиционных GPU. После нескольких месяцев переговоров стороны достигли соглашения, в рамках которого Cerebras будет продавать OpenAI сервисы инференса на базе собственных ускорителей. В рамках сделки Cerebras построит или арендует центры обработки данных, полностью оснащённые своими ускорителями, а OpenAI будет оплачивать использование облачных сервисов и задействует их для собственных нужд. Вычислительные мощности будут вводиться в эксплуатацию в несколько этапов вплоть до 2028 года. «Вычислительная стратегия OpenAI заключается в создании отказоустойчивого портфеля, в рамках которого для разных рабочих нагрузок используются подходящие системы. Cerebras добавит нашей платформе выделенное решение для инференса с низкой задержкой. Это означает более быстрые ответы, более естественное взаимодействие и более прочную основу для масштабирования использования ИИ в реальном времени для гораздо большего числа людей», — говорится в заявлении OpenAI. «Мы в восторге от партнёрства с OpenAI, которое объединяет ведущие мировые ИИ-модели с самым быстрым в мире процессором для ИИ. Подобно тому, как широкополосный доступ преобразил интернет, инференс в реальном времени преобразит ИИ, открыв совершенно новые способы создания и взаимодействия с ИИ-моделями», — уверен Эндрю Фельдман. Производитель гигантских ИИ-чипов Cerebras оказался втянут в скандал с криптомошенничеством

19.06.2025 [18:31],

Сергей Сурабекянц

Cerebras, занимающаяся разработкой чипов для систем машинного обучения и других ресурсоёмких задач, сообщила, что её аккаунт в соцсети X был взломан и использован для продвижения выпущенной киберпреступниками фальшивой криптовалюты. Монета Cerebras, стартовавшая 15 июня с токеном $CEREBRAS, сразу же вызвала подозрения у отраслевых аналитиков. Руководители компании опровергли выпуск каких-бы то ни было криптотокенов, подтвердив взлом аккаунта Cerebras.

Источник изображения: unsplash.com «Официальный аккаунт Cerebras Systems в соцсети X был захвачен злоумышленниками для продвижения мошеннической криптовалютной схемы, — сообщила компания. — Обратите внимание: Cerebras не запускает и никогда не будет запускать или поддерживать какую-либо криптовалюту или токен. Мы работаем над тем, чтобы вернуть себе контроль над аккаунтом. Будьте бдительны и защитите себя от мошенничества». На данный момент Cerebras, похоже, восстановила контроль над своим аккаунтом X, не зафиксировав никаких подозрительных действий за последние 24 часа.

Источник изображения: Cerebras Cerebras является ведущим производителем крупнейших чипов ИИ и утверждает, что является единственной компанией в мире, создающей аппаратное обеспечение ИИ в масштабе полупроводниковых пластин. Она удерживает мировой рекорд по скорости инференса большой языковой модели Llama 4 Maverick с 400 млрд параметров — более 2500 транзакций/с, что в два с лишним раза превышает производительность флагманского решения Nvidia. Cerebras также может похвастаться такими поразительными аппаратными средствами, как процессор ИИ с 900 тыс. ядер, эквивалентный 62 графическим процессорам Nvidia H100. Разработчик ИИ-ускорителей Cerebras Systems готовится к выходу на IPO

01.10.2024 [07:56],

Алексей Разин

Основанная в 2016 году в Калифорнии компания Cerebras Systems разрабатывает непривычно крупные чипы для ускорения работы систем искусственного интеллекта, а их выпуском на квадратных подложках занимается TSMC. Американский стартап остаётся убыточным, но уже начал готовиться к выходу на IPO, опубликовав проспект для инвесторов.

Источник изображения: Cerebras Прежде всего, из опубликованных данных становится понятно, что по итогам первого полугодия компания получила чистые убытки составили $66,6 млн при выручке $136,4 млн. За год до этого выручка не превышала $8,7 млн при чистых убытках в размере $77,8 млн. По итогам всего прошлого года выручка Cerebras достигла $78,7 млн при убытках в размере $127,2 млн. Во втором квартале прошлого года компания выручила $69,8 млн и получила убытки в размере $50,9 млн. За год до этого выручка не превышала $5,7 млн, а чистые убытки составили $26,2 млн. В текущем году операционные расходы Cerebras выросли из-за необходимости найма дополнительного персонала в связи с расширением бизнеса. В прошлом году компания G42 из ОАЭ формировала 83 % выручки Cerebras. Помимо продажи собственно чипов ускорителей, компания занимается предоставлением доступа к собственным облачным мощностям на их основе. Получив в 2021 году $250 млн финансирования, Cerebras оценивала свою капитализацию в $4 млрд. На какую сумму она претендует по итогам IPO, пока не уточняется. Арабская G42 сейчас владеет примерно 5 % акций Cerebras, примерно столько же сосредоточено в руках основателя Эндрю Фельдмана (Andrew Feldman). Компания G42 обязуется до марта 2025 года потратить около $1,43 млрд на покупку ускорителей Cerebras. По мере увеличения объёмов закупок G42 получит право купить большее количество акций американской компании. Пакетами акций Cerebras не менее 5 % владеют около шести институциональных инвесторов. Основатель и глава OpenAI Сэм Альтман (Sam Altman) также является акционером Cerebras, как и сооснователь Sun Microsystems Энди Бехтольсхайм (Andy Bechtolsheim). Молодые компании серьёзно настроены потягаться с Nvidia на рынке систем для запуска ИИ-моделей

28.08.2024 [16:52],

Павел Котов

В попытке ослабить мёртвую хватку Nvidia на рынке чипов для систем искусственного интеллекта сейчас мобилизуется множество конкурентов компании — они привлекают сотни миллионов долларов инвестиций, стремясь воспользоваться волной бума ИИ. Среди наиболее перспективных конкурентов значатся такие компании, как Cerebras, d-Matrix и Groq.

Источник изображения: Mariia Shalabaieva / unsplash.com Мелкие компании решили воспользоваться тем, что спрос на оборудование для инференса ИИ будет расти экспоненциальными темпами. Эти системы необходимы для запуска уже обученных систем вроде OpenAI ChatGPT и Google Gemini — популярность подобных приложений продолжает расти. Сейчас самыми популярными в этом сегменте являются графические процессоры Nvidia, принадлежащие к семейству Hopper. Компании Cerebras, d-Matrix и Groq заняты разработкой более дешёвых, но и более узконаправленных чипов, которые предназначаются для запуска моделей ИИ. Cerebras накануне представила платформу Cerebras Inference, которая работает на чипе CS-3, который занимает целую 300-мм кремниевую пластину. Этот чип, утверждает производитель, в 20 раз быстрее в задачах вывода ИИ, чем ускорители Nvidia Hopper, но стоит дешевле — это подтверждают тесты Artificial Analysis. Чип Cerebras CS-3 отличает другая архитектура, предусматривающая интеграцию компонентов памяти непосредственно в кремниевую пластину процессора. Ограничения, которые налагает пропускная способность памяти, значительно снижают производительность ИИ-ускорителей, утверждают в Cerebras — объединение логики и памяти на одном большом чипе даёт результаты «на порядки быстрее». В конце этого года ещё одна компания, d-Matrix, намеревается выпустить собственную аппаратную платформу Corsair, предназначенную для работы с Triton — открытой программной средой, которая выступает альтернативой Nvidia Cuda. В прошлом году компания привлекла $110 млн вложений, и в этом также проводит раунд финансирования, на котором намеревается привлечь от инвесторов ещё $200 млн или более. Бывший основатель команды, выступающей разработчиком тензорных процессоров Google, теперь возглавляет ещё одну компанию — Groq, которая в этом месяце привлекла $640 млн при оценке $2,8 млрд. Стартапам в области полупроводников, даже несмотря на шумиху в сегменте ИИ-оборудования, непросто выйти на рынок, предупреждают аналитики. Японский финансовый конгломерат SoftBank в июле поглотил чипмейкера Graphcore, заплатив $600 млн — при том, что с момента своего основания в 2016 году компания привлекла у около $700 млн. Но инвесторы не отчаиваются найти и поддержать «новую Nvidia», и этот процесс способствует развитию многих стартапов. Cerebras представила гигантский процессор WSE-3 c 900 тысячами ядер

13.03.2024 [19:58],

Николай Хижняк

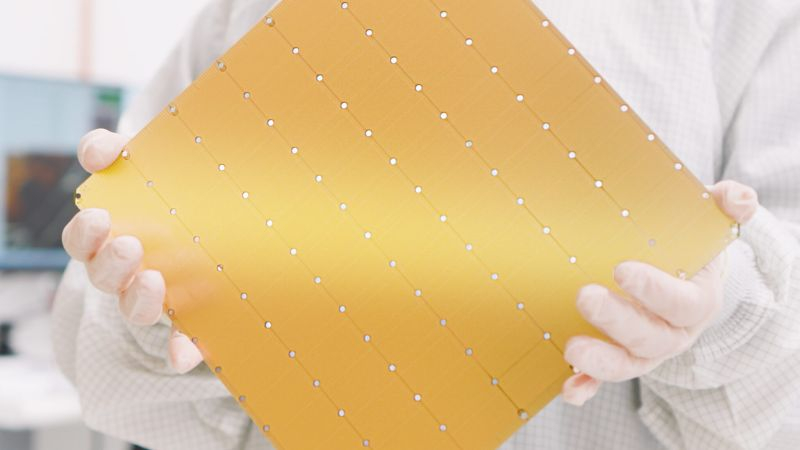

Американский стартап Cerebras Systems представил гигантский процессор WSE-3 для машинного обучения и других ресурсоёмких задач, для которого заявляется двукратный прирост производительности на ватт потребляемой энергии по сравнению с предшественником.

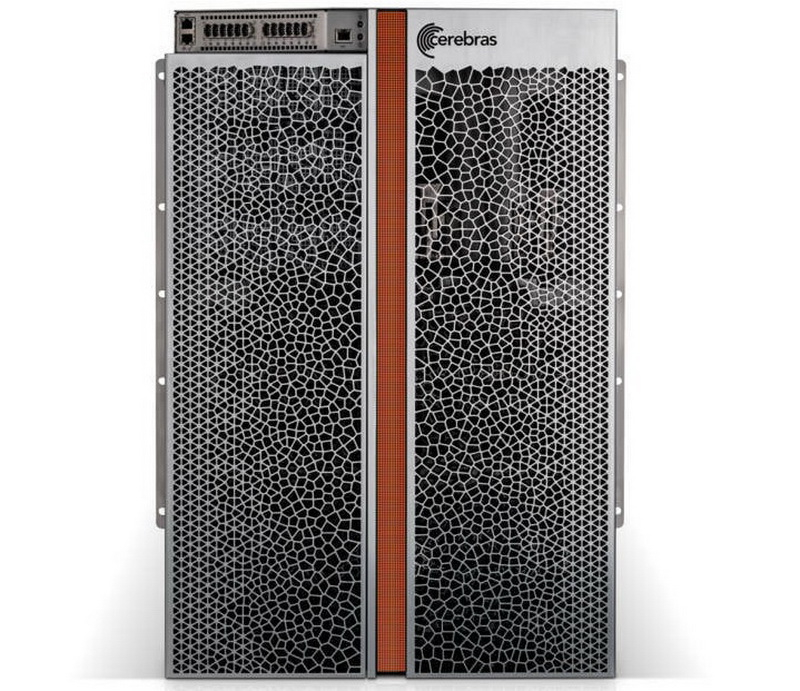

Cerebras WSE-3. Источник изображений: Cerebras Площадь нового процессора составляет 46 225 мм2. Он выпускается с использованием 5-нм техпроцесса компании TSMC, содержит 4 трлн транзисторов, 900 000 ядер и объединён с 44 Гбайт набортной памяти SRAM. Его производительность в операциях FP16 заявлена на уровне 125 Пфлопс. Один WSE-3 составляет основу для новой вычислительной платформы Cerebras CS-3, которая, по утверждению компании, обеспечивает вдвое более высокую производительность, чем предыдущая платформа CS-2 при том же энергопотреблении в 23 кВт. По сравнению с ускорителем Nvidia H100 платформа Cerebras CS-3 на базе WSE-3 физически в 57 раз больше и примерно в 62 раза производительнее в операциях FP16. Но учитывая размеры и энергопотребление Cerebras CS-3, справедливее будет сравнить её с платформой Nvidia DGX с 16 ускорителями H100. Правда, даже в этом случае CS-3 примерно в 4 раза быстрее конкурента, если речь идёт именно об операциях FP16.

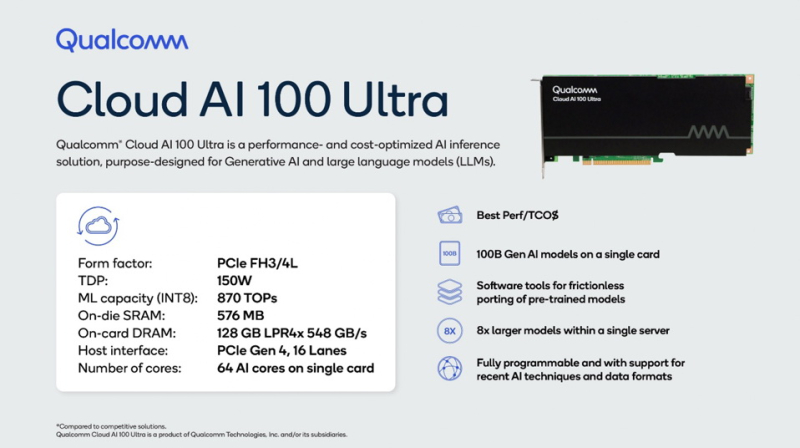

Cerebras CS-3 Одним из ключевых преимуществ систем Cerebras является их пропускная способность. Благодаря наличию 44 Гбайт набортной памяти SRAM в каждом WSE-3, пропускная способность новейшей системы Cerebras CS-3 составляет 21 Пбайт/с. Для сравнения, Nvidia H100 с памятью HBM3 обладает пропускной способностью в 3,9 Тбайт/с. Однако это не означает, что системы Cerebras быстрее во всех сценариях использования, чем конкурирующие решения. Их производительность зависит от коэффициента «разрежённости» операций. Та же Nvidia добилась от своих решений удвоения количества операций с плавающей запятой, используя «разреженность». В свою очередь Cerebras утверждает, что добилась улучшения примерно до 8 раз. Это значит, что новая система Cerebras CS-3 будет немного медленнее при более плотных операциях FP16, чем пара серверов Nvidia DGX H100 при одинаковом энергопотреблении и площади установки, и обеспечит производительность около 15 Пфлопс против 15,8 Пфлопс у Nvidia (16 ускорителей H100 выдают 986 Тфлопс производительности). Cerebras уже работает над внедрением CS-3 в состав своего суперкластера Condor Galaxy AI, предназначенного для решения ресурсоёмких задач с применением ИИ. Этот проект был инициирован в прошлом году при поддержке компании G42. В его рамках планируется создать девять суперкомпьютеров в разных частях мира. Две первые системы, CG-1 и CG-2, были собраны в прошлом году. В каждой из них сдержится по 64 платформы Cerebras CS-2 с совокупной ИИ-производительностью 4 экзафлопса. В эту среду Cerebras сообщила, что построит систему CG-3 в Далласе, штат Техас. В ней будут использоваться несколько CS-3 с общей ИИ-производительностью 8 экзафлопсов. Если предположить, что на остальных шести площадках также будут использоваться по 64 системы CS-3, то общая производительность суперкластера Condor Galaxy AI составит 64 экзафлопса. В Cerebras отмечают, что платформа CS-3 может масштабироваться до 2048 ускорителей с общей производительностью до 256 экзафлопсов. По оценкам экспертов, такой суперкомпьютер сможет обучить модель Llama 70B компании Meta✴✴ всего за сутки. Помимо анонса новых ИИ-ускорителей Cerebras также сообщила о сотрудничестве с компанией Qualcomm в вопросе создания оптимизированных моделей для ИИ-ускорителей Qualcomm с Arm-архитектурой. На потенциальное сотрудничество обе компании намекали с ноября прошлого года. Тогда же Qualcomm представила свой собственный ИИ-ускорители Cloud AI100 Ultra формата PCIe. Он содержит 64 ИИ-ядра, 128 Гбайт памяти LPDDR4X с пропускной способностью 548 Гбайт/с, обеспечивает производительность в операциях INT8 на уровне 870 TOPS и обладает TDP 150 Вт.

Источник изображения: Qualcomm В Cerebras отмечают, что вместе с Qualcomm они будут работать над оптимизацией моделей для Cloud AI100 Ultra, в которых будут использоваться преимущества таких методов, как разреженность, спекулятивное декодирование, MX6 и поиск сетевой архитектуры. «Как мы уже показали, разрежённость при правильной реализации способна значительно повысить производительность ускорителей. Спекулятивное декодирование предназначено для повышения эффективности модели при развёртывании за счёт использования небольшой и облегченной модели для генерации первоначального ответа, а затем использования более крупной модели для проверки точности этого ответа», — отметил гендиректор Cerebras Эндрю Фельдман (Andrew Feldman). Обе компании также рассматривают возможность использования метода MX6, представляющего собой форму сжатия размера модели путём снижения её точности. В свою очередь, поиск сетевой архитектуры представляет собой процесс автоматизации проектирования нейронных сетей для конкретных задач с целью повышения их производительности. По словам Cerebras, сочетание этих методов способствует десятикратному повышению производительности на доллар. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |