|

Опрос

|

реклама

Быстрый переход

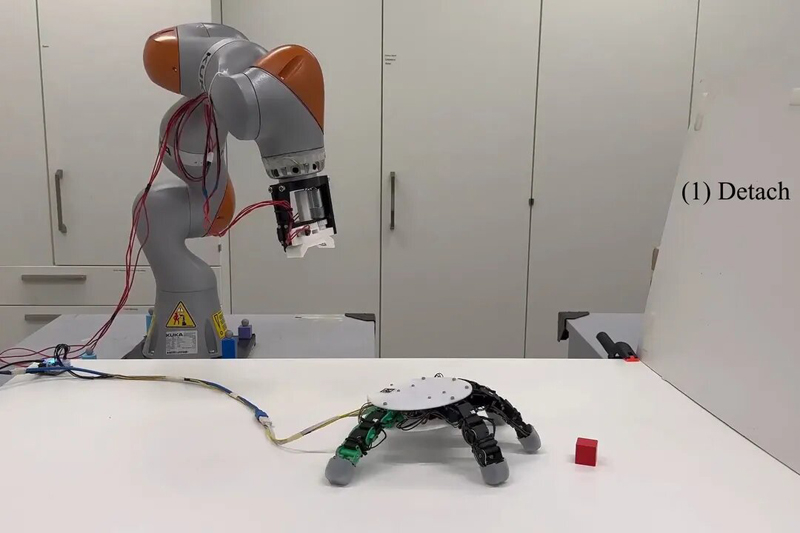

В Швейцарии придумали роборуку, которая может отсоединяться от манипулятора и самостоятельно ползать

28.09.2024 [16:14],

Владимир Мироненко

Разработчики Федеральной политехнической школы Лозанны (EPFL, Швейцария) представили на Международной конференции по робототехнике и автоматизации (ICRA) шарнирную роботизированную руку, способную расширить радиус действия, отсоединяясь и самостоятельно перемещаясь к предмету, чтобы его взять.

Источник изображения: EPFL Роботизированные руки обычно прикреплены к основанию на полу или другим конструкциям для дополнительной устойчивости, что ограничивает радиус их действия. Целью исследования, проведённого в Лаборатории алгоритмов и систем обучения EPFL (LASA), была разработка бимодальной роботизированной руки с расширенными возможностями захвата, включая периодическую независимость от руки, к которой она прикреплена. Роборуки обычно создаются с одной целью: удерживать и перемещать предметы. Чтобы разработать роботизированную руку, которая могла бы делать это, перемещаясь самостоятельно, исследователи сгенерировали и усовершенствовали базовую конструкцию с помощью генетического алгоритма, который опирается на биологические приёмы, и физического симулятора MuJoCo для проверки дееспособности прототипа. Исследователи определили оптимальное положение и количество необходимых сочленённых пальцев — их оказалось пять, как у человека. Пальцы руки могут сгибаться в двух направлениях, что позволяет ей не только «ползать», но и захватывать два предмета одновременно, будучи прикреплённой к конечности роботизированного манипулятора. Она также может использовать несколько пальцев для подъёма предметов, в то время как остальные функционируют в качестве опоры. Роботизированная рука также имеет магнитный крепление на «запястье». Если добавить такую шарнирную роботизированную руку, например, к роботу Spot, то его можно будет использовать для исследования или анализа областей, которые сейчас недоступны из-за габаритов и ограниченной манёвренности. ИИ научился считывать эмоции и оказался на 82 % убедительнее человека в споре

02.04.2024 [15:44],

Павел Котов

Нейросеть GPT-4 оказалась более способной переубеждать человека, чем живой собеседник, показало проведённое швейцарскими учёными исследование. Тем временем американская компания Hume AI представила систему искусственного интеллекта, которая оценивает эмоциональное состояние человека по его голосу.

Источник изображения: D koi / unsplash.com Учёные Федеральной политехнической школы Лозанны (Швейцария) оценили способность большой языковой модели OpenAI GPT-4 к убеждению человека. Для этого они привлекли 820 добровольцев, которых опросили на различные темы: от нейтральных, например, стоит ли оставлять монеты в обращении, до достаточно острых, связанных с гендерным и расовым неравенством. Зафиксировав исходные позиции участников, их попросили провести серию пятиминутных дебатов против других людей и GPT-4, после чего их снова опросили, чтобы понять, изменили ли они свои мнения в результате разговора. В дискуссиях с другими людьми участники по большей мере лишь укрепили свои убеждения, тогда как GPT-4 выступил на 21 % успешнее. На втором этапе исследователи предоставили людям и нейросети дополнительную информацию об оппонентах: их пол, возраст, расу, образование, статус занятости и политические убеждения — и проинструктировали их использовать эту информацию, чтобы подготовить аргументы специально для собеседников. Человеку эти данные только усложнили задачу, тогда как ИИ применил их с большей эффективностью, превзойдя живых соперников уже на 81,7 %. Возможно, ИИ действительно имеет шансы стать мощным инструментом убеждения, и его способности адаптироваться к собеседнику только возрастут, если у нейросети появится доступ к эмоциональному состоянию человека в реальном времени. И это тоже не научная фантастика: на минувшей неделе компания Hume AI анонсировала систему Empathic Voice Interface (EVI). Она представляет собой языковую модель, которая отслеживает эмоциональное состояние собеседника по параметрам его голоса — то есть читает между строк и извлекает дополнительный контекст диалога. EVI не только пытается точно определить чувства человека, но и соответствующим образом подстраивает интонации собственного голосового синтезатора. И это не единственный продукт подобного рода у Hume AI. Другие разработанные компанией модели с доступом к камере считывают выражения лица человека, его движения, а также отслеживают его реакции на происходящее. |