|

Опрос

|

реклама

Быстрый переход

Властелин ИИ: OpenAI затягивает Amazon в свою игру кольцевых инвестиций

17.12.2025 [07:15],

Алексей Разин

С точки зрения схем финансирования нынешнего бума ИИ стартап OpenAI вполне можно считать «властелином колец», поскольку он сосредоточил вокруг себя сделки с кольцевым принципом передачи средств и взаимными зависимости. Сама OpenAI при этом особо ничем не рискует, привлекая средства партнёров под обещания светлого будущего. Amazon может стать очередным инвестором OpenAI и поставщиком своих чипов.

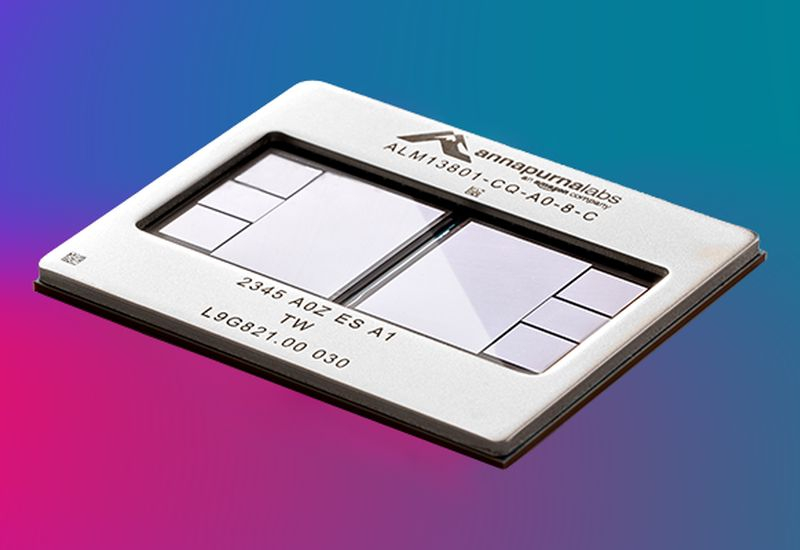

Источник изображения: Amazon По крайней мере, об этом на текущей неделе сообщили The Information и Reuters, используя независимые источники. По имеющимся данным, OpenAI ведёт переговоры о сотрудничестве с Amazon, которая может либо вложить в капитал первой до $10 млрд, либо просто ограничиться поставками своих ускорителей Trainium для нужд инфраструктуры OpenAI. Недавно прошедшая реструктуризация стартапа открыла перед ним больше возможностей по поиску инвесторов, помимо Microsoft, которая владеет 27 % акций стартапа. Облачные гиганты, включая Google и AWS (Amazon) давно разрабатывают собственные чипы для ускорения вычислений, и на фоне бума ИИ интерес к ним начали проявлять профильные стартапы. Например, ускорителями TPU заинтересовался не только Anthropic, но и конкурирующая с Google компания Meta✴✴ Platforms. Как теперь сообщается, ускорители Trainium компании Amazon могут найти применение в ИИ-инфраструктуре OpenAI. Отдельно отмечается, что инвестиции Amazon в OpenAI могут поднять капитализацию последней до отметки более $500 млрд. Это повышает шансы OpenAI на успех в негласной борьбе с SpaceX Илона Маска (Elon Musk) за статус самого дорогого в мире стартапа. Принято считать, что в перспективе OpenAI выйдет на IPO, и тогда капитализация разработчика ChatGPT вырастет до $1 трлн. Представители компании пока наличие планов по выходу на биржу не подтверждают. В случае, если сделка с Amazon состоится, наличие такого весомого инвестора будет способствовать привлечению средств в капитал OpenAI из других источников. Не исключено, что ChatGPT также будет каким-то образом интегрирован в собственные информационные сервисы Amazon, включая услуги по поиску товаров на одноимённой торговой площадке. Ведущий разработчик процессоров Amazon перешёл на работу в Arm

19.08.2025 [07:50],

Алексей Разин

В конце прошлого месяца для Arm стало проблематично скрывать намерения выпускать собственные чиплеты или целые чипы, поэтому соответствующие кадровые перестановки стали более очевидными. Недавно стало известно, что на работу в Arm перешёл Рами Синно (Rami Sinno), который в Amazon приложил руку к созданию процессоров Trainium и Inferentia.

Источник изображения: Unsplash, Marques Thomas Поскольку Amazon через своё подразделение AWS является крупным игроком рынка облачных услуг, разработка собственных процессоров для использования их в собственной вычислительной инфраструктуре имела определённый смысл. Как Arm распорядится опытом бывшего директора по разработке чипов AWS, пока предсказать сложно, но данный переход укладывается в логику усилий британского холдинга по разработке собственных полупроводниковых компонентов. Напомним, что классический бизнес Arm строился на продаже интеллектуальной собственности, с помощью которой сторонние разработчики процессоров могли создавать свои изделия. Теперь Arm готова сама разрабатывать не только отдельные блоки в составе процессоров, но и целые «системы на чипе». Рами Синно не будет единственным специалистом, которого Arm переманила из других компаний. Британский холдинг уже заполучил в свой штат руководителей и инженеров из HPE, Intel и Qualcomm, которые имеют опыт работы в бизнесе по созданию процессоров или серверных систем на их основе. ИИ обойдётся без Nvidia: Amazon выпустила системы на чипах Trainium2, а через год выйдут Trainium3

04.12.2024 [18:46],

Павел Котов

Подразделение Amazon Web Services (AWS) компании Amazon объявило на проводимой им конференции re:Invent, что клиенты её облачной платформы теперь могут пользоваться системами с ускорителями Trainium2, предназначенными для обучения и запуска больших языковых моделей искусственного интеллекта.

Источник изображения: aws.amazon.com Представленные в прошлом году чипы работают в четыре раза быстрее предшественников: один инстанс EC2 с 16 ускорителями Trainium2 предлагает производительность до 20,8 Пфлопс. Это значит, что при развёртывании масштабной модели Meta✴✴ Llama 405B на платформе Amazon Bedrock клиент получит «трёхкратный прирост скорости генерации токенов по сравнению с другими доступными предложениями крупных облачных провайдеров». Можно будет также выбрать систему EC2 Trn2 UltraServer с 64 ускорителями Trainium2 и производительностью 83,2 Пфлопс. Отмечается, что показатель 20,8 Пфлопс относится к плотным моделям и точности FP8, а 83,2 Пфлопс — к разреженным моделям и FP8. Для связи между ускорителями в системах UltraServer используется интерконнект NeuronLink. Совместно со своим партнёром в лице Anthropic, основным конкурентов OpenAI в области больших языковых моделей, AWS намеревается построить крупный кластер систем UltraServer с «сотнями тысяч чипов Trainium2», где стартап сможет обучать свои модели. Он будет в пять раз мощнее кластера, на котором Anthropic обучала модели текущего поколения — по оценке AWS, он «станет крупнейшим в мире вычислительным кластером для ИИ, о котором сообщалось до настоящего времени». Проект поможет компании превзойти показатели, которые обеспечиваются актуальными ускорителями Nvidia, которые по-прежнему пользуются высоким спросом и остаются в дефиците. Хотя в начале следующего года Nvidia готовится запустить ускорители нового поколения Blackwell, которые при 72 чипах на стойку предложат до 720 Пфлопс для FP8. Возможно, поэтому AWS уже сейчас анонсировала ускорители нового поколения Trainium3, которые предлагают ещё один четырёхкратный прирост производительности для систем UltraServer — ускорители будут производиться с использованием техпроцесса 3 нм, а их развёртывание начнётся в конце 2025 года. Потребность в системах нового поколения в компании обосновали тем, что современные модели ИИ по масштабам подходят к триллионам параметров. Инстансы Trn2 пока доступны только в регионе US East инфраструктуры AWS, но скоро появятся и в других; системы UltraServer в настоящее время работают в режиме предварительного доступа. Apple призналась, что использует кастомные ИИ-чипы Amazon, причём не только для ИИ

04.12.2024 [10:20],

Алексей Разин

Не всем разработчикам систем искусственного интеллекта нравится высокая зависимость от аппаратных решений Nvidia. Компания Apple, например, использует для развития собственных систем как свои процессоры семейства M, так и ускорители альтернативных поставщиков, среди которых есть и Amazon. Представители компаний признались в этом на текущей неделе.

Источник изображения: Amazon Весьма необычный рассказ о сотрудничестве между технологическими гигантами на таком уровне состоялся на площадке ежегодной конференции AWS Reinvent, проводимой облачным подразделением Amazon. Интересы Apple, как одного из клиентов AWS, на сцене представлял старший директор по машинному обучению и искусственному интеллекту Бенуа Дюпен (Benoit Dupin), который до 2014 года работал как раз в Amazon. «У нас налажено прочное сотрудничество, а инфраструктура надёжна и позволяет обслуживать наших клиентов по всему миру», — заявил Дюпен о взаимодействии Apple и AWS. Как он добавил, первая из компаний использует инфраструктуру второй на протяжении более десяти лет, чтобы обеспечить работу голосового ассистента Siri, а также сервисов Apple Maps и Apple Music. Поисковые сервисы Apple строила на чипах Amazon Inferentia и Graviton, и переход на них обеспечил повышение эффективности на 40 %. Собственные языковые модели Apple хочет предварительно обучать на чипах Amazon Trainium2. Как ожидается, это позволит поднять эффективность процесса с точки зрения соотношения производительности и энергозатрат на величину до 50 %. По словам представителей AWS, компания Apple оказалась в числе первых клиентов, приступивших к тестированию процессоров Trainium. Впрочем, из открытых источников известно, что она также применяла для обучения своей системы Apple Intelligence процессоры Google семейства Tensor. В отличие от ведущих чат-ботов, таких как OpenAI ChatGPT, подход Apple к искусственному интеллекту не основан на больших кластерах на ускорителях Nvidia. Вместо этого Apple использует чип iPhone, iPad или Mac для выполнения максимально возможного числа задач локально на устройстве, а сложные запросы на серверы Apple, использующие её собственные чипы M-серии. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |