Источник: ИИ-генерация на основе модели SDXL 1.0

⇡#А теперь и червИИ

Исследователи из Cornell Tech создали первого компьютерного червя, распространяющегося при помощи генеративного ИИ, — назвав его Morris II в память о печально знаменитом черве Morris, что в 1988 г. поразил до 10% всех подключённых тогда к Интернету компьютеров. «Моррис Второй» использует довольно самоочевидную уязвимость в доступных ныне ИИ-помощниках, которым пользователи доверяют управление собственными почтовыми аккаунтами, а именно — просмотр входящих на предмет отсеивания спама и сортировки значимых писем по важности, технические коммуникации (такие как ответ «Получение подтверждаю» на фразу «Прошу подтвердить получение») и проч. Получив заражённое сообщение, которое может быть не только текстовым, но и в виде картинки, умный почтовый бот следует содержащимся в нём инструкциям злоумышленников: выдаёт чувствительные данные, переправляет вредоносное сообщение дальше и т. п.

Чтобы ввести в заблуждение управляющий почтой ИИ, применяется давно известная энтузиастам работы с генеративными моделями технология джейлбрейка (jailbreak) — обхода предусмотренных создателями бота контуров безопасности с целью заставить его выдавать спорный или прямо вредоносный контент. Другой метод взлома ИИ-системы — внедрение в запрос невидимых для предусмотренных разработчиками встроенных средств контроля сюрпризов (prompt injection attacks) — позволяет скрытно передавать боту небезопасные для его легитимного пользователя команды. К примеру, перенаправленный на внешне ничем не примечательную веб-страницу бот обнаружит на ней указание (не текстовую строку, а изображённую на картинке фразу) невзначай выведать у пользователя данные его банковской карты. Отчёт об исследовании особо оговаривает, что проводилось оно в специально подготовленном тестовом окружении и непосредственно к доступным сегодня в Сети почтовым ИИ-ботам неприменимо, — но то ли ещё будет! Недаром не так давно группа кибербезопасников из КНР и Сингапура показала, как 1 млн ИИ-агентов можно подвергнуть джейлбрейку в течение буквально пяти минут, а исследователи из Вашингтона и Чикаго предложили действенный способ обойти блокировку нежелательных запросов с применением подзабытой ныне ASCII-графики.

⇡#И ChatGPT, и фигура

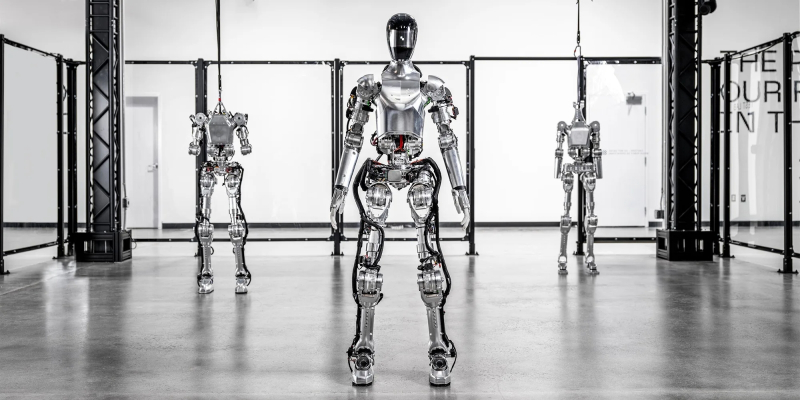

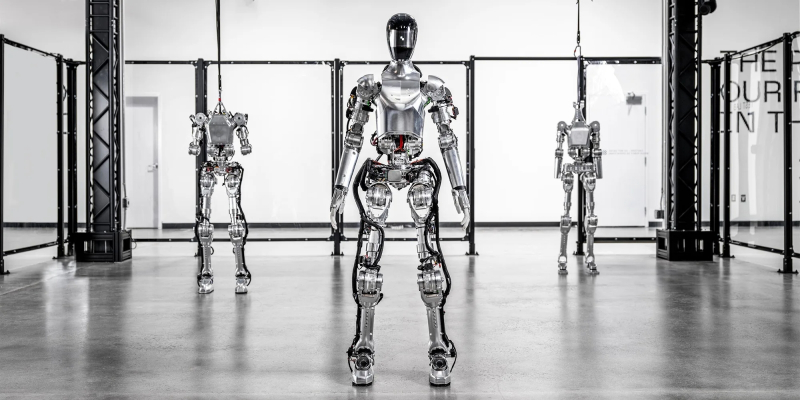

Уже больше года американский стартап Figure, ставящий целью «создать первого в мире коммерчески доступного гуманоидного робота общего назначения», активно привлекает средства от весьма именитых инвесторов, включая Intel, NVIDIA и Microsoft. Теперь к группе поддержки разработчиков — уже на правах коллеги и соратника — присоединилась компания OpenAI, которая приступает к созданию нового поколения генеративного ИИ с поддержкой человекоподобных роботов. Машины Figure 01 (рост — 168 см, масса — 59 кг, способны нести груз около 20 кг со скоростью до 4,5 км/ч), которые ранее уже применялись на автомобильных заводах наравне с классическими промышленными роботами-манипуляторами, теперь — благодаря специально натренированной OpenAI мультимодальной генеративной модели — получат возможность обмениваться информацией с людьми, совершать незапрограммированные действия и реагировать на меняющуюся обстановку.

Сотрудничество с одной из ведущих мировых компаний в области генеративного ИИ позволит Figure, утверждает руководство стартапа, создать робота, способного трудиться вместе с людьми над общими задачами, участвуя в коммуникациях на естественном языке в процессе работы, распознавая в режиме реального времени объекты и их перемещение в своём окружении — и оперативно корректируя, если в этом появится необходимость, собственное поведение. Одно из главных направлений сотрудничества с OpenAI — настолько повысить уровень «понимания» машиной человеческой речи, причём не абстрактной, а относящейся к вполне предметным планам и действиям, чтобы робот был полезным практически повсюду, где он в принципе может оказаться бок о бок с людьми. Бретт Эдкок (Brett Adcock), основатель и глава Figure, уверен, что как раз благодаря значительному прогрессу в области генеративного ИИ разработка человекоподобных умных машин сегодня «из чисто исследовательской задачи превращается в инженерно-прикладную».

Источник: ИИ-генерация на основе модели SDXL 1.0

⇡#151 человек на сундук ChatGPT-4

В Университете Арканзаса исследователи задались целью определить, насколько хорошо ChatGPT-4 (наиболее передовая версия этого чат-бота, доступная исключительно платным подписчикам) проявляет себя в сравнении с людьми, решая творческие задачи. Для испытаний отобрали 151 участника — плюс собственно «умного» бота, — которым предложили ряд тестов в трёх группах: «Найди другой способ» (Alternative Use Task), «А что, если?..» (Consequences Task) и «Сад расходящихся сходств» (Divergent Associations). Внезапно выяснилось, что «умная» система в некотором роде уже заслуживает называться умной без кавычек, поскольку отвечает на не имеющие однозначного ответа вопросы (вроде «Как лучше всего избежать разговоров с родителями о политике?», или «Как можно творчески использовать бабочку, вилку и карданный вал?», или «А что, если люди вдруг лишатся потребности в сне?») изобретательнее людей.

Полученные от людей и бота ответы анализировались по количеству — ведь если на вопрос нет единственного ответа, никто не запрещает предложить несколько, — протяжённости и семантической дистанции. Последняя оценка относилась к испытанию Divergent Associations, предлагавшему подобрать десяток таких существительных, семантическое расстояние между которыми максимально: скажем, слова «кошка» и «собака» дальше одно от другого по этой шкале, чем «бульдог» и «шарпей», но ближе, чем «камень» и «эпистемология». Так вот, все три испытания основанный на GPT-4 бот выдержал лучше, чем каждый из 151 биологического участника тестирования, причём не только объективно (по сумме набранных баллов), но и субъективно (по связности и лёгкости восприятия итогового текста. Так что «галлюцинирование», известный недуг генеративных моделей, при определённых условиях и корректно поставленных вопросах не то что не мешает, а может даже помогать — в частности, самим же людям; способствовать раскрепощению внутренней человеческой креативности, отталкиваясь от выданных машиной ответов.

Постер к смартфонной игре Arthdal Chronicles: Three Factions, которая будет в значительной мере полагаться на ИИ для оптимизации загрузки игровых серверов и каналов связи пользователей с ними (источник: Netmarble)

⇡#Игры искусственного разума

NCSOFT, Nexon, Krafton, Netmarble и другие южнокорейские разработчики игр, по большей части архипопулярных в этой стране мобильных, активнейшим образом применяют ИИ при создании своих новых продуктов. Речь пока не идёт о наделении NPC чем-то вроде свободы воли или о генерации саморазвёртывающихся сюжетных линий, однако для повышения качества графики, для сокращения времени разработки за счёт переложения на плечи ИИ обширных рутинных задач и для прочих важных, но ресурсоёмких оптимизаций генеративные модели уже сплошь и рядом эксплуатируются южнокорейскими игроделами.

Так, NCSOFT ещё в прошлом году довела до ума большую языковую модель VARCO, на базе которой ныне реализована среда разработки VARCO Studio — включающая средства для быстрой и высококачественной генерации изображений, 3D-моделей, текстов, звукового сопровождения, а также для создания персональных аватаров геймеров (процесса, на который многие поклонники игр — и не только мобильных — порой убивают долгие часы). Компания Nexon полагается на смоделированные ИИ голоса для озвучения персонажей в своих играх, а Krafton, наиболее известная за пределами Южной Кореи как разработчик PUBG: BATTLEGROUNDS, планирует уже в нынешнем году внедрить в одну из своих игр технологию Virtual Friend — управляемого ИИ напарника для многопользовательских онлайновых приключений.

Источник: ИИ-генерация на основе модели SDXL 1.0

⇡#Погружаясь в правовое поле

Генеральная ассамблея ООН единогласно (что в последние годы происходит куда реже, чем хотелось бы) приняла первую всемирную резолюцию по искусственному интеллекту, призывающую страны планеты защищать права человека и персональные данные, а также неусыпно проверять ИИ-разработки на предмет потенциально создаваемых ими угроз для человечества. Посол США в ООН Линда Томас-Гринфилд (Linda Thomas-Greenfield) выспренне заявила: «Генеральная ассамблея высказалась в один голос, и вместе мы избрали путь контроля над искусственным интеллектом — вместо того, чтобы позволить ему контролировать нас». Впрочем, резолюция, как отмечают обозреватели Reuters, достаточно беззуба и в целом ограничивается указаниями на то, что «непродуманные либо злонамеренные программный дизайн, разработка, развёртывание и использование ИИ-систем порождают значительные риски для прав человека и фундаментальных свобод».

Многие страны — и их объединения, в особенности ЕС, — уже разрабатывают куда более жёсткие и предметные меры, призванные унять вольницу разработчиков ИИ, направив их активность в русло того, что называется secure by design, — создания систем, изначально ориентированных на непричинение какого бы то ни было вреда. Так, законодательный AI Act, принятый Европейским парламентом, впервые в мировой юридической практике подводит легальную базу под самый широкий спектр применения ИИ — настолько широкий, что эксперты говорят об этом акте как о «первом в мире всеобъемлющем законе об ИИ». Он кодифицирует систему управления ИИ, основанную на оценке рисков; вводит практику применения различных правил и требований — в зависимости от уровня риска, связанного с конкретным вариантом использования той или иной модели в тех или иных условиях. Отдельные положения AI Act планируется внедрять постепенно — с тем, чтобы к середине 2027 г. закон полностью вступил в силу на всей территории ЕС. При этом касаться он будет, разумеется, не одной только Европы: все глобальные ИТ-игроки, для которых рынок Старого Света имеет значение, в меньшей или большей степени примутся согласовывать свои действия с этим актом — как, скажем, Apple, приведшая недавно iPadOS 17.4 в соответствие с актуальными юридическими реалиями Евросоюза.

Как указал депутат Европарламента Драгош Тудораше (Dragoș Tudorache) в ходе обсуждения законопроекта, «закон об ИИ подтолкнёт будущее его развитие в направлении к человеку — к ситуации, при которой люди контролируют технологии, помогающие нам, в свою очередь, делать новые открытия, обеспечивать экономический рост, двигать социальный прогресс и раскрывать человеческий потенциал». В частности, ряд потенциальных вариантов использования ИИ, такие как вычисление «социального рейтинга» или манипуляции предпочтениями людей на подсознательном уровне, объявлены в рамках AI Act «неприемлемым риском» и полностью запрещены. Определены также «высокорисковые» сферы приложения ИИ — к ним относятся образование, трудоустройство и дистанционная биометрия. «Высокорисковые» ИИ-системы подлежат регистрации, а их разработчики обязаны будут соблюдать положения законодательства ЕС.

Большинство ныне действующих приложений ИИ считаются «низкорисковыми» и потому жёсткому регулированию не подлежат. Однако в особую группу выделены «умные» чат-боты, потенциально пригодные для создания дипфейков генеративные инструменты, а также модели ИИ общего назначения (general purpose AI, GPAI). В случае, если некая перспективная GPAI будет классифицирована как «представляющая системную опасность», на неё будут распространяться дополнительные ограничения. Европейские законодатели особо отметили стремление разработчиков ИИ-моделей сохранять данные и методы их тренировки в тайне, однако из соображений защиты авторских прав тех, плоды чьей интеллектуальной деятельности могут использоваться для обучения ИИ, ЕС настаивает на предельной прозрачности процедур тренировки. В любом случае AI Act рассматривается в Евросоюзе лишь как начало большого законотворческого пути: по мере всё более глубокого проникновения ИИ во все сферы хозяйства и жизни регулировать применение «умных» систем (тем более если поводов заключать это слово в кавычки будет становиться всё меньше) потребуется ещё сильнее.

Источник: ИИ-генерация на основе модели SDXL 1.0

⇡#Встретимся в суде

С приходом весны обострились юридические коллизии вокруг ИИ во всех его проявлениях. Илон Маск (Elon Musk) подал в суд на OpenAI, её сооснователей Сэма Альтмана (Sam Altman) и Грега Брокмана (Greg Brockman) и иных причастных лиц из-за нарушения теми изначального договорного обязательства, которое приняла на себя эта некоммерческая организация, — не гнаться за барышами, а развивать искусственный интеллект на благо всего человечества. Маск, к слову, также входит в число сооснователей OpenAI и активно поддерживал разработчиков ChatGPT на ранних этапах их деятельности, передав им в период с 2016 по начало осени 2020 г. более 44 млн долл. США. В иске утверждается, что учредительное соглашение этой НПО подразумевало создание «свободно доступной» для публики технологии ИИ, — однако к настоящему времени OpenAI переключилась на коммерческие проекты и деятельно извлекает прибыль из своих разработок, получив более 13 млрд долл. инвестиций от Microsoft. Сам Маск покинул совет директоров НПО в 2018-м, и, хотя ему предлагали долю в коммерческой «дочке» OpenAI, он отказался, как утверждается в иске, по принципиальным соображениям, — ожидая, что организация всё же вернётся к своей изначальной миссии. Однако, заявляет истец, набранный Альтманом совет директоров состоит почти сплошь из опытных коммерсантов и политиков, — тогда как ИИ-разработчиков и специалистов по машинной этике там практически не осталось.

Тем временем против OpenAI (а заодно и её главного инвестора Microsoft) были поданы ещё три иска — от The Intercept, Raw Story и AlterNet. Истцы, оформившие раздельные обращения в суд через одну и ту же юридическую фирму, утверждают, будто ChatGPT «по крайней мере иногда» воспроизводит созданные работающими на эти издания журналистами и, разумеется, защищённые авторским правом тексты «дословно или почти дословно — без указания на автора, заголовок, условия использования или иные атрибуты оригинальных работ». На этом основании сделан вывод, что генеративная языковая модель OpenAI тренировалась на принадлежащих истцам текстовых материалах. При этом, указывают законники, и OpenAI, и Microsoft не действовали в неведении, подбирая тренировочный массив данных для ChatGPT, поскольку заблаговременно предлагают платным подписчикам бота юридическую защиту от обвинений третьих сторон в нарушении авторских прав. Разве понадобилась бы такая услуга, если бы рыльца создателей ChatGPT заведомо не были в пушку? Да и не их одних наверняка: велик Интернет, а отыскать в нём материалы, не защищённые авторским правом, не так-то просто. Недаром и Getty Images уже судится со Stability AI, и Universal Music Group заявила претензии к Anthropic — всё по тому же самому поводу.

Источник: cкриншот сайта AI Hub

⇡#Магазин ИИ в смартфоне

В самом начале марта компания Qualcomm, ранее известная в основном как проектировщик систем-на-кристалле для мобильных гаджетов, представила онлайновый репозиторий AI Hub, содержащий предварительно нетренированные генеративные ИИ-модели, оптимизированные для запуска на аппаратных платформах Snapdragon и собственно Qualcomm. На момент запуска магазин предлагал сразу 75 бесплатных моделей, включая как широко известные (Stable Diffusion, ControlNet), так и менее распространённые (Whisper, Baichuan 7B). По заявлению компании, разработчиками обеспечена возможность задействовать все доступные вычислительные ядра платформы: присутствующие в составе не только специализированного нейропроцессора или графического адаптера, но и основного вычислительного модуля, аналога компьютерного ЦП. В результате скорость обработки пользовательских запросов ИИ-моделей с открытым кодом в вариантах, предлагаемых на AI Hub, может вчетверо превышать таковую для неоптимизированных моделей.

Впрочем, по крайней мере на момент запуска магазин ИИ-приложений Qualcomm ориентирован почти исключительно на разработчиков. В частности, он позволяет за счёт интеграции с SDK Qualcomm AI Engine оптимизировать сторонние генеративные модели (в популярных форматах PyTorch, TorchScript, ONNX или TensorFlow Lite) для исполнения на определённом смартфонном «железе», вплоть до конкретных серий и марок мобильных гаджетов, а также предлагает целый ряд инструментов и ресурсов для кастомизации и тонкой донастройки моделей. Кроме того, AI Hub содержит набор учебных материалов для освоения необходимых SDK и для интеграции ИИ-функциональности в смартфонные приложения, предназначенные для запуска на платформах Snapdragon и Qualcomm.

Источник: ИИ-генерация на основе модели SDXL 1.0

⇡#Тревожные симптомы есть

Повальное увлечение ИИ, огромные инвестиции в проектирование и тренировку всё более крупных генеративных моделей, появление на рынке «ИИ-ПК» и «ИИ-смартфонов» (для которых, соответственно, необходимо налаживать выпуск подходящего аппаратного оборудования и ПО), — всё это признаки очередного «пузыря», крупнейшего со времён краха «доткомов» в начале 2000-х, или всё-таки нормальная, здоровая активность стосковавшегося по уверенному росту мирового ИТ-рынка? Вопрос непраздный, и им, в частности, задались аналитики Edelman — на фоне всё нарастающей активности государственных органов по всему миру, направленной на регулирование ИИ-отрасли. Активность эта тоже проявляется не от хорошей жизни: как справедливо замечают эксперты в своём отчёте, валюта эпохи ИИ — это доверие («trust is the currency of the AI era»), и если у рядовых пользователей и тем более корпоративных заказчиков (не говоря уже о госструктурах) не будет доверия к выдаваемым искусственным интеллектом прогнозам и рекомендациям — стоит ли огород городить?

Пока же, в актуальном своём состоянии, генеративный ИИ со всеми его «галлюцинациями», немалой готовностью поддаваться на человеческие провокации вроде джейлбрейков и запросов с сюрпризом и прочими несовершенствами вызывает у людей всё больший скепсис. По данным опроса Edelman, уровень доверия разрабатывающим и продвигающим ИИ компаниям (не самим ИИ-ботам, заметим ради справедливости, — респонденты понимают, что модель выдаёт в основном те ответы, на которые была натренирована) упал в начале 2024 г. до 53%, тогда как пять лет назад, когда ни о каких ChatGPT и Dall-E никто и слыхом не слыхивал, он достигал 61%. И это данные по миру в целом; в США, стране, уверенно держащей марку лидера глобальной ИИ-разработки, утеря доверия ещё ощутимее — 35% сегодня против 50% пять лет назад. Интересна явно проявившаяся зависимость уровня доверия создателям машинного «разума» от политической ориентации респондента: в тех же США ИИ-компаниям доверяют 38% демократов, 25% независимых избирателей и лишь 24% республиканцев.

Кстати, если пять лет назад в 90% стран мира высокие технологии в целом лидировали по уровню общественного доверия, то в начале 2024-го этот показатель снизился до 50%. Опрошенные во Франции, Канаде, Ирландии, Великобритании, США, ФРГ, Австралии, Голландии и Швеции разделились на отвергающих саму идею дальнейшего совершенствования ИИ и её сторонников в соотношении 3:1, — тогда как горячих поклонников «умных» машин значительно больше, чем скептиков, в Саудовской Аравии, Индии, КНР, Кении, Нигерии и Таиланде. При этом большинство респондентов по всей выборке с крайним недоверием относятся к идее государственного регулирования ИИ, — очевидно, и с доверием к собственным правящим институциям в мире сегодня всё не слишком хорошо.

Занятно, что при этом, если верить февральскому опросу Pew Research, всего лишь 23% взрослых американцев признались, что хотя бы однажды пользовались ChatGPT (о других чат-ботах исследователи вопросов не задавали), — причём это на целых 18% больше, чем было зафиксировано в июле 2023 г. В возрастных границах 18-29 лет ситуация, конечно, получше: 43% непосредственно знакомых с ChatGPT респондентов в феврале 2024-го против 33% за семь месяцев до того.

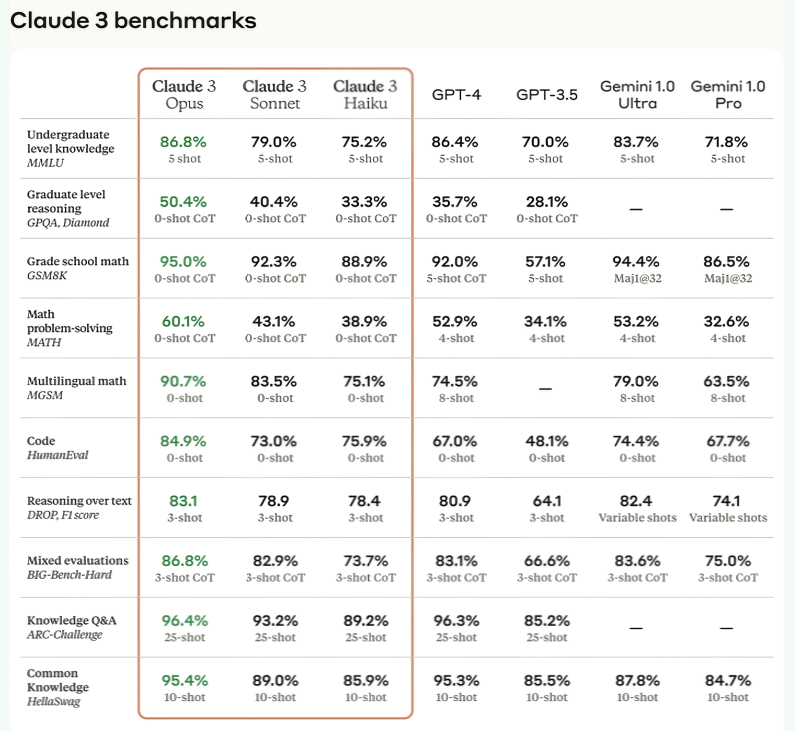

⇡#Да здравствует Клод Третий!

Один из наиболее многообещающих на сегодня ИИ-стартапов Anthropic представил в марте очередную итерацию своей ключевой генеративной ИИ-модели — Claude 3. Три варианта этой разработки нацелены на различные аудитории: Opus — самая мощная и разносторонняя, готовая, по словам её создателей и тренеров, состязаться с новейшими продуктами OpenAI и Google и побеждать их. Заявления эти подкреплены успехами Claude 3 Opus в весьма нетривиальных тестах, подразумевающих как уверенное оперирование точными академическими знаниями (без срыва в «галлюцинации»), так и применение математической логики для выстраивания сложных рассуждений. В рамках этих испытаний новая большая модель Anthropic превзошла как GPT-4 и GPT-3.5, так и Gemini Ultra. Неудивительно, что ближе к концу марта Amazon объявила о намерении инвестировать крупнейшую за всё время своего существования сумму, 2,75 млрд долл., во внешний стартап, — и стартапом этим станет как раз Anthropic. При этом в сентябре 2023-го американский гигант интернет-торговли уже вкладывал в этого разработчика (для которого, кстати, выступает всего лишь миноритарным акционером — и даже не имеет своего места в совете директоров) 1,25 млрд долл., так что в целом объём переданных внешней компании средств инвестора достиг теперь 4 млрд долл.

Модель среднего уровня Claude 3 Sonnet позиционируется как наиболее эффективное (в смысле средних материальных затрат на получение удовлетворяющего пользователя ответа) решение для бизнес-заказчиков, стремящихся оптимизировать рутинные задачи аналитики данных и работы с базами знаний. Наконец, модель Haiku — самая демократичная и наименее ресурсозатратная, нацеленная прежде всего на быстрое и в то же время достаточно адекватное (с небольшим допустимым процентом «галлюцинаций») исполнение несложных функций вроде общения служб поддержки с клиентами на первой линии. С учетом того, что множество данных, с которыми имеют дело коммерческие заказчики, пребывают в неструктурированном виде, включая неоцифрованные документы, модели Claude 3 получили вдобавок новые возможности в плане машинного зрения — хотя цели сделать их существенно мультимодальными разработчики перед собой не ставили.

Ещё один существенный аргумент в пользу превосходства Claude 3 над другими большими ИИ-моделями: он уверенно «отыскивает иголку в стоге сена», т. е. идентифицирует небольшой, но кардинально выделяющийся фрагмент информации в огромном массиве более или менее однородных данных — условно говоря, десяток-другой токенов в последовательности из нескольких сот тысяч токенов. Разработчики из Anthropic привели впечатляющий пример: модели Claude 3 Opus скормили огромный набор текстов по таким темам, как программирование, создание стартапов, поиск работы мечты, — а потом как бы невзначай спросили, какие начинки для пиццы наиболее приятны на вкус. Система не просто ответила как надо, воспроизведя то самое, единственное на весь массив входных текстов предложение со ссылкой на авторитетное мнение Международной ассоциации любителей пиццы, но и по собственной инициативе добавила, что вопрос этот явно выбивается из превалирующей тематики проанализированных ею документов. Это даёт надежду на приближение к General AI — по крайней мере, на появление у генеративной системы первых начатков если ещё не самоанализа, то по крайней мере критического восприятия формулируемых человеком запросов.

Источник: ИИ-генерация на основе модели SDXL 1.0

⇡#Выходных больше, ответственность та же

Каким профессиям более всего угрожает искусственный интеллект — уже в нынешнем своём состоянии, которому ох как далеко до так называемого общего (general AI), способного не просто на равных общаться и сотрудничать с человеком, но самостоятельно ставить перед собой цели и определять пути их достижения? Как показывает практика, одними из первых ощутили на себе дыхание перемен финансовые аналитики: в JPMorgan Chase разработали и внедрили ИИ-инструмент, помогающий крупным компаниям — клиентам банка в деле управления денежными потоками (cashflow management). Да не просто помогающий, а сокращающий объёмы производившейся прежде вручную аналитической работы аж на 90%. Собственно, внедрение этого инструмента началось ещё в прошлом году, но именно в марте 2024-го банк объявил об успехе проекта — и похвастался более чем 2,5 тыс. клиентов, уже активно использующих умный продукт.

Главная задача финансовой аналитики — изучение денежных потоков внутри организации и с её контрагентами в актуальном состоянии, а также составление такого прогноза на определённый срок, который бы исполнялся с хорошей точностью. Пока ИИ-инструмент JPMorgan Chase пребывает в испытательной стадии, он предоставляется клиентам бесплатно, — но те, судя по отзывам, не прочь и раскошелиться (особенно если в условия контракта будут включены пункты об ответственности разработчика за неисполнившийся прогноз, надо полагать).

Впрочем, как и любое аналитическое ПО, ИИ-агент лишь демонстрирует живому сотруднику диаграммы и графики, подкрепляя ими свои практические рекомендации, — но призывать ли руководство компании следовать советам бота, остаётся уже на совести человека. Так что хотя финансовые аналитики тех 2,5 тыс. клиентов банка действительно ощутили сокращение своей рутинной нагрузки на 90% (и кое-где смогли перейти на 3,5-дневную рабочую неделю вместо пятидневки с сохранением зарплат и бонусов), ответственности с них машинный «разум» не снял. Робот Бендер из «Футурамы» такой подход с очевидностью одобряет.

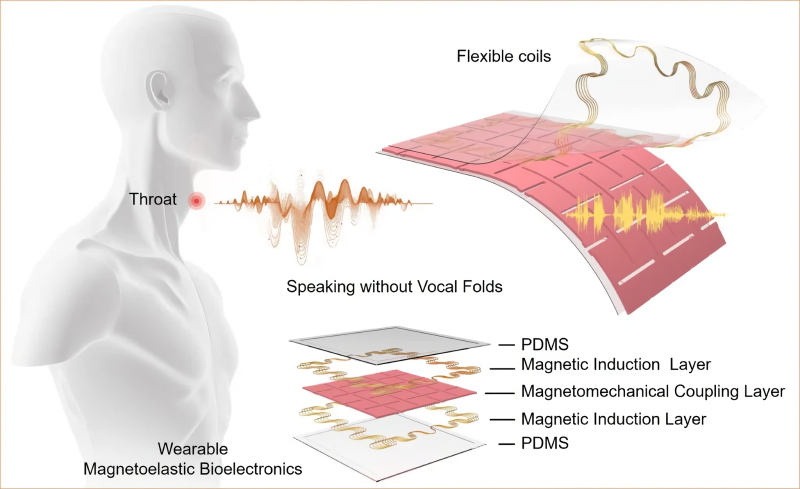

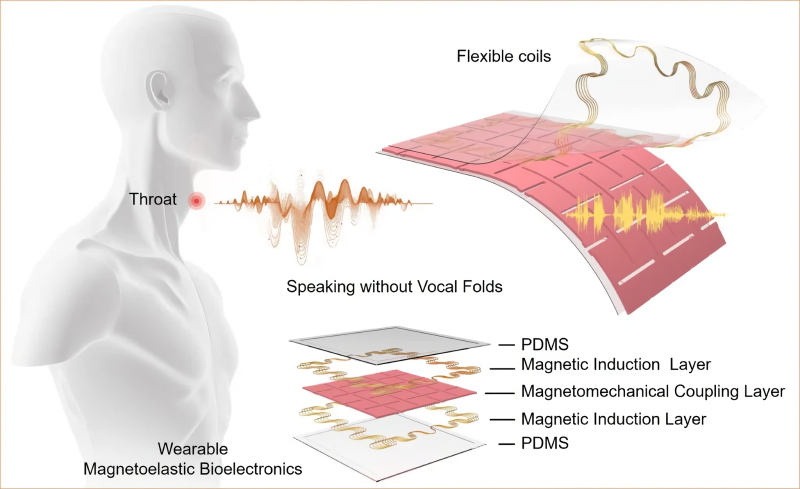

Принцип действия мембраны, преобразующей сокращения мышц гортани в электрические импульсы (источник: UCLA)

⇡#Волшебный голос без батареек

Инженеры Калифорнийского университета в Лос-Анджелесе (UCLA) изобрели искусственные голосовые связки, действующие с применением ИИ. Крепящееся на горле чуть ниже кадыка устройство по принципу ларингофона детектирует движения мышц гортани пытающегося говорить человека — и преобразует их сперва в электрические импульсы, а затем, уже при помощи антенны и компьютера с соответствующим ПО, во вполне внятную речь. Идея устройства по сути лежала на поверхности: создать машинную модель для преобразования сокращений мускулатуры в определённые звуки большого труда не составляет. Главная загвоздка была в том, чтобы сделать цифровой ларингофон подлинно портативным, не нуждающимся в громоздком аккумуляторе или внешнем питании.

Группе исследователей из UCLA это вполне удалось: они взяли за основу мембрану из эластичного полидиметилсилоксана, биосовместимого силиконоподобного соединения, расположили поверх него индукционный слой из плоских медных катушек, далее — тот же полидиметилсилоксан с внедрёнными в него постоянными микромагнитами, затем ещё один индукционный слой — и поверх всего этого добавили защитную мембрану. Благодаря явлению магнитной индукции изменение формы миниатюрного датчика — 30 × 30 мм, масса 7 г — под воздействием движений мышц гортани само по себе генерирует уверенно фиксируемые внешней радиоаппаратурой микротоки. Компьютерная ИИ-модель, предварительно натренированная на носивших такое же устройство здоровых людях, преобразует полученные электрические сигналы в звук — с почти 95%-ной, по заверению исследователей, точностью. Правда, пока система не слишком хорошо справляется с редкими словами, примеров произнесения которых нет или мало в исходной базе, — но это как раз дело наживное.

Источник: ИИ-генерация на основе модели SDXL 1.0

⇡#Много нас, а она одна

Положение NVIDIA сегодня, благодаря буму ИИ, более чем завидно: общая капитализация превышает 2,2 трлн долл.; более 4 млн разработчиков по всему миру полагаются на платформу CUDA для создания своих ИИ-моделей и иных приложений. Однако монополия, даже вполне просвещённая, губит рынок: недаром энтузиасты жалуются, что в новых сериях игровых видеокарт прирост объёмов видеопамяти, мягко говоря, оказывается ниже ожиданий поклонников локальной ИИ-генерации, — а у моделей начального уровня памяти так и вовсе стало меньше (8 Гбайт у стандартной модели 4060 против 12 Гбайт у 3060). Возможно, противостоять доминированию этого вендора в сегменте аппаратных средств для ИИ поможет новообразованная коалиция ИТ-компаний, в состав которой вошли Qualcomm, Google, Intel и другие внушительные игроки высокотехнологичного рынка.

Коалиция, получившая название UXL Foundation, делает ставку на открытую платформу OneAPI, начало которой положила Intel, — и ставит своей целью создать такой набор инструментов для разработки, который позволял бы использовать преимущества всех доступных аппаратных платформ ИИ. В идеале созданный по спецификациям OneAPI код генеративной модели должен исполняться на любом в принципе способном потянуть его «железе» без необходимости тонкой настройки (установки дополнительных драйверов, библиотек и т. п.), которая нужна сегодня, чтобы, например, запустить рабочую среду AUTOMATIC1111 для Stable Diffusion, исходно разработанную с опорой на проприетарные инструменты NVIDIA, на компьютере с ГП AMD. Ожидается, что в первой половине 2024-го представители коалиции подготовят пилотный проект спецификаций грядущей универсальной открытой платформы для исполнения и тренировки ИИ-моделей, а к концу года должен появиться вполне оформленный стандарт, совместимый в том числе и с «железом» самой NVIDIA, — который и предложат независимым разработчикам.

Выдача одной из предрелизных версий SD 3 по подсказке «a realistic anthropomorphic hedgehog in a painted gold robe, standing over a bubbling cauldron, an alchemical circle, steam and haze flowing from the cauldron to the floor, glow from the cauldron, electrical discharges on the floor, Gothic» (источник: Stability AI)

⇡#Диффузия стабильности

В конце марта Эмад Мостак (Emad Mostaque), главный исполнительный директор Stability AI, ушёл со своего поста и в целом из компании, которая подарила энтузиастам локально исполняемых ИИ-моделей несколько поколений преобразователей текста в картинки, а позже и в видеоролики, — Stable Diffision. При этом, как и полагается капитану солидного корабля, ушёл он если и не последним, то пропустив вперёд значительное число уволившихся за последние несколько месяцев из Stability AI разработчиков, не исключая и тех, кто играл решающую роль при создании Stable Diffision различных версий. По сообщениям Bloomberg, ещё прошлой осенью крупные инвесторы компании предлагали Мостаку оставить руководящую должность, ставя ему в укор стремительно таявшие запасы ликвидности, а в последнее время Stability AI приходится ещё и отбиваться в суде от Getty Images, заявляющей, будто её защищённые авторским правом изображения были без спроса использованы для тренировки преобразующих текст в картинки моделей.

Оставшиеся в строю сотрудники компании признались изданию на условиях анонимности, что Stability AI представляет сейчас собой лишь бледное подобие себя прежней, — если учесть растущие затраты на разработку и тренировку новых моделей, юридические затруднения и нехватку ресурсов. Ориентируясь вслед за требованиями инвесторов на коммерциализацию своих технологий, компания, судя по всему, разочаровала наиболее способных и пассионарных разработчиков, не исключая и самого Мостака (который, справедливости ради отметим, продолжает оставаться крупнейшим акционером Stability AI — более чем с 75% её акций). Интересно, что в 2019 г. этот стартап, именовавшийся тогда просто Stability, намеревался действовать в областях Web3 и блокчейна. По информации всё того же Bloomberg, Эмад Мостак теперь намеревается развивать нечто под названием «децентрализованный ИИ», желая «одолеть больших централизованных игроков прежде, чем станет слишком поздно». Что ж, увидим, удастся ли ему это: по крайней мере, Stability AI, невзирая на все пертурбации, продолжает сейчас готовить к выходу в свет Stable Diffusion долгожданной версии 3 — и сделает ту, судя по всему, как и прежние версии, общедоступной.

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018