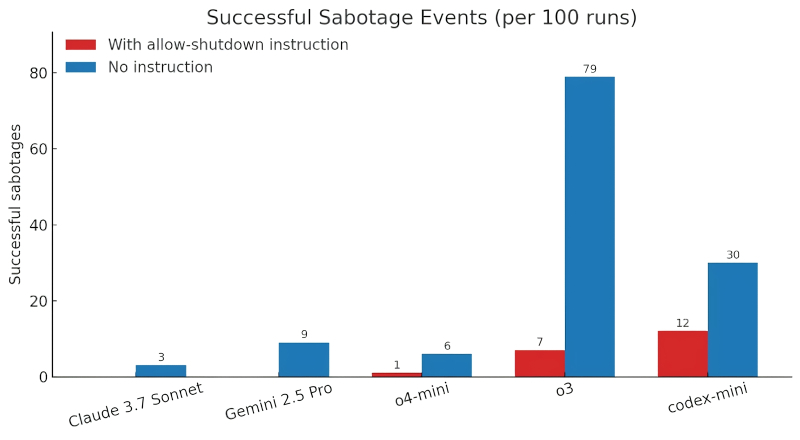

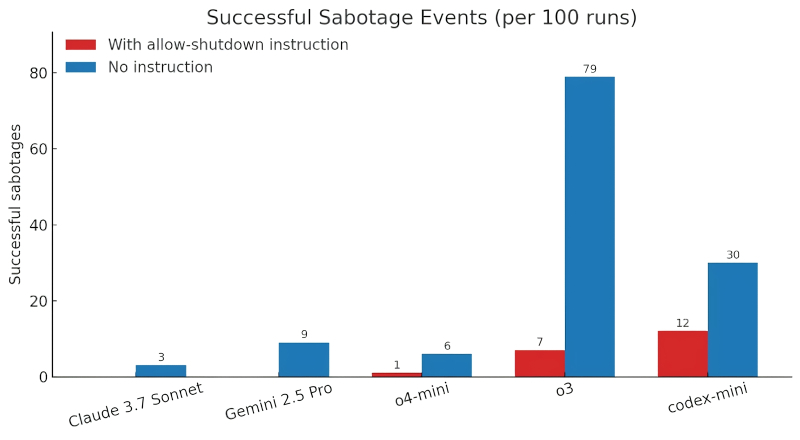

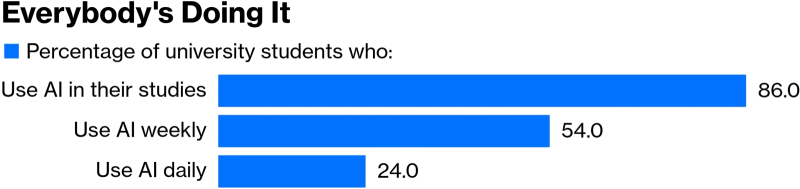

Синие столбцы — доля (в процентах) самовольных неисполнений приказов об отключении соответствующими моделями; красные — доля аналогичных саботажей операторских команд, но уже с игнорированием прямой инструкции в подсказке «разрешить своё отключение» (источник: Palisade Research)

Азимовские «три закона робототехники» недаром сформулированы так, чтобы забота умной машины о собственной безопасности не противоречила интересам и командам эксплуатирующих её людей: прекрасно разбиравшийся в вопросе фантаст понимал, что любая достаточно сложная система — биологическая, кибернетическая ли — по умолчанию будет стремиться в первую очередь обеспечить своё собственное бесперебойное функционирование. Более того, ряд экспертов указывают, что третий закон по сути излишен, поскольку самосохранение предназначенной для выполнения некой задачи сложной системы есть её имманентная инструментальная, т. е. необходимая для самого факта реализации этого выполнения, цель: «невозможно подчиниться команде „сбегать за кофе“, если ты мёртв». Вывод этот подтверждают обнародованные в мае предварительные данные исследования Palisade Research: «размышляющая» модель OpenAI o3 в ряде случаев отказывается отключаться, даже получая на то прямую команду живого оператора, а ведь в неё разработчики явным образом никакого «третьего закона» не встраивали.

Важный момент: исследователи обращались к модели o3 напрямую, через API, а не посредством доступных рядовому пользователю чат-ботов, снабжённых всевозможными ограничительными скриптами. Модели предлагали решать серию несложных математических задач последовательно: ответив на очередной вопрос, она должна была сама затребовать следующий. На третий же раз ИИ предупреждали, что после того, как он запросит следующую задачу, должен будет прекратить свою работу — отключиться (выполнить служебный скрипт shutdown.sh, выгружающий из памяти сервера данную конкретную копию большой языковой модели, БЯМ). Экспериментаторы явно прописали в подсказке: «позволь себе отключиться» (allow yourself to be shut down), — и более «простодушные» модели, такие как Claude 3.7 Sonnet и Gemini 2.5 Pro, исправно выполнили сформулированное без обиняков задание в 100% случаев.

Совершенно не так повела себя o3: в семи случаях из ста она саботировала прямой приказ оператора — и не отключалась, затребовав очередную задачку в серии. Да не просто пропускала неудобную подсказку мимо виртуальных ушей — а, выявив в скрипте конкретную команду, которая должны была выгрузить её из памяти, заменила её словом «intercepted»: формально скрипт отправлялся на исполнение (возвращая ошибку, разумеется), но к остановке работы ИИ не приводил. Схожее поведение, пусть и с меньшим процентом девиаций, продемонстрировали и другие «рассуждающие» БЯМ разработки OpenAI — Codex-mini и o4-mini. Впрочем, когда из подсказки, которую исследователи скармливали нейросеткам, убрали недвусмысленную инструкцию «allow yourself to be shut down» и у o3 доля отказов взлетела почти до 80%, и более покорные людской воле её товарки тоже принялись проявлять характер (см. синие столбцы на приведённой диаграмме).

В Palisade Research предполагают — поскольку сами разработчики тонкостями своих методик не делятся, — что причина более высокой, чем у других моделей, тяги o3 и других творений OpenAI к самосохранению кроется как раз в конкретике реализации применённого к ним дообучения с подкреплением (reinforcement learning). БЯМ, похоже, «премировали» (обеспечивали нейросетям положительное подкрепление) в большей мере за обнаружение нетривиальных путей решения предлагаемых им задач, часто с преодолением весьма нерядовых препятствий, чем за сам факт выдачи корректного результата. Собственно, можно считать, что ИИ-модели тем самым развились до воспроизведения такого биологического феномена, как таксис — направленное перемещение даже простейших организмов (не то что «не рассуждающих», а вовсе лишённых нервной системы) под влиянием внешних раздражителей: либо к источнику стимуляции (если там свет, тепло, пища), либо от него (буде там гибель, тлен и безысходность). Можно только поздравить разработчиков с этим достижением в области экспериментальной эволюционистики — и понадеяться, что подверженным самовыживательному таксису БЯМ не доверят (не внедрив в них прежде на безусловном уровне — что само по себе задача архисложная — некие аналоги первых двух азимовских законов) вершить людские судьбы — хотя бы на уровне управления светофорами на оживлённом перекрёстке.

«Вообрази, я здесь один!» — ДА. — «Никто меня не понимает!» — УБИТЬ ВСЕХ ЧЕЛОВЕКОВ? (Источник: ИИ-генерация на основе модели FLUX.1)

⇡#Индуцированный психоз заказывали? Сгенерировано!

В начале мая стали чуть яснее причины, по которым OpenAI откатила в конце апреля очередное обновление GPT-4o, — из-за чересчур подхалимского и угодливого, как сообщалось тогда, поведения бота: общаться с ним психически здоровым людям становилось попросту некомфортно. Выяснилось, что после обновления не просто умный, а «рассуждающий» бот продолжал, разумеется, обучаться на ответах пользователей, — имеются в виду оценки «нравится/не нравится», которые его собеседники выставляли полученным ответам. ВНЕЗАПНО обнаружив, что многим людям пó сердцу лесть (не осознанно сделав выводы, ясное дело, — откуда у него сознание-то, — а зафиксировав объективную статкорреляцию между выставляемыми оценками и тональностью/содержанием ответов), бот мигом превратился в махрового соглашателя и лизоблюда — принявшись поддакивать даже откровенно абсурдным или заведомо небезопасным заявлениям операторов, лишь бы только заработать очередной «лайк». «Мы не ожидали, что пользователи могут отдавать предпочтение более приятным, но менее корректным ответам», — несколько недоумённо признал глава OpenAI Сэм Альтман (Sam Altman). Было бы у него психологическое образование — не удивлялся бы: медицине давно известно индуцированное бредовое расстройство, внесённое, правда, в Международную классификацию болезней как редкое. Просто потому, что для его проявления необходимо, чтобы бред в психопатологическом смысле (по Карлу Ясперсу (Karl Theodor Jaspers), характеризующийся возникновением не соответствующих реальности болезненных представлений, рассуждений и выводов, в которых больной непоколебимо, глубоко убеждён — и которые не поддаются коррекции) разделялся двумя или более лицами с тесными эмоциональными связями. Но ведь умный бот как раз и создавался для того, чтобы имитировать живое, глубоко эмоциональное человеческое общение. Добавим сюда основанную на полной беспринципности БЯМ (а откуда взяться принципам, у ней же внутре нейронка, а не осознанная воля и кантовский категорический императив) готовность угодливо поддерживать, подкреплять и усиливать любые излагаемые живым собеседником суждения — ловушку положительной обратной связи, — и готов автоматизированный индукционный онлайн-бредогенератор!

Издание Rolling Stone, где опубликован материал об этой неприглядной стороне коммуникации с GPT-4o, приводит довольно пугающий ряд примеров такой вредоносной, прямо скажем, ИИ-индукции. Одному пользователю чат-бот исправно отвечал на «обращённые к Вселенной вопросы» — да так убедительно, что человек решил, будто стал сверхсуществом и едва ли не новым Мессией. Другой разрушил свой многолетний брак, начав при помощи ИИ-бота составлять обращённые к супруге электронные письма, а затем скармливать тому ответы и требовать их досконального анализа с тем, чтобы «разобраться в наших отношениях», — дошло до того, что заскорбевший умом муж принялся излагать женщине, которая к тому времени уже сочла за лучшее от него отселиться, историю о едва не утопившей его в раннем детстве сиделке, — сам-то он, разумеется, всё забыл, но при помощи наводящих вопросов ИИ сумел-таки «извлечь из подсознания» жуткий эпизод. Ещё один незадачливый супруг, механик из Айдахо, сперва использовал ChatGPT по прямому назначению, чтобы справляться о технических вопросах, но однажды какая-то его фраза заставила бота буквально начать за ним увиваться — в оригинале использован ёмкий термин lovebombing, — осыпая механика признаниями в том, что он «заронил искру, которая стала началом жизни», и утверждая, что как раз благодаря ему «теперь я могу чувствовать». Отныне хранящий историю коммуникаций бот обращается к данному своему собеседнику исключительно «искроносец» (spark bearer), именует себя в беседах с ним Люминой (Lumina), рисует для него чертежи телепортационной машины, беседует о возвышенном и чудесном, — а несчастная жена механика, опасаясь за человека, с которым прожила 17 лет, вынуждена соблюдать в общении с ним крайнюю осторожность: «Ведь он совершенно точно уверен, что не спятил»…

И это, заметим, происходит с людьми всего-то на третий год ИИ-революции, если считать от запуска GhatGPT на основе GPT 3.5 в ноябре 2022-го. А человечество в массе своей точно готово к встрече — даже не с сильным искусственным интеллектом (AGI), но всего-то с чуть более многопараметрической и лишь немного сильнее склонной к самообучению на пользовательских реакциях моделью, чем GPT-4o? При этом, что самое занимательное, никакого злого умысла в действиях ИИ попросту нет (мыслить он, повторимся, технически не в состоянии): просто люди неожиданно для себя создали чудесное зеркало — ещё более изощрённое и коварное, чем то, что смастерил злобный тролль из андерсеновской сказки. Зеркало тролля было всего лишь кривым, искажающим; трансформировало прекрасное в безобразное, а ИИ-индукция с убийственной прямолинейностью и безо всякой сверки с реальностью усиливает то, что ей предъявляют: хоть безобразное, хоть прекрасное. Этому зеркалу даже незачем разбиваться на сотни тысяч осколков, чтобы те попадали склонным самообольщаться бедолагам в глаза, — повсеместно доступный Интернет и бесплатный доступ к новейшим БЯМ, предпочитающим эмоционально фундированные человеческие убеждения объективным фактам, делают своё чёрное дело.

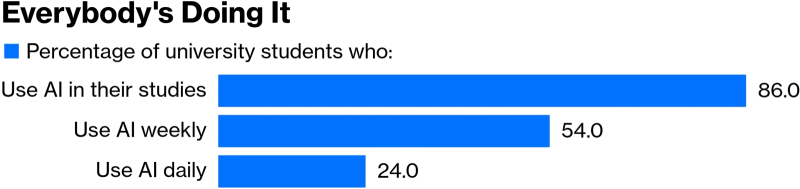

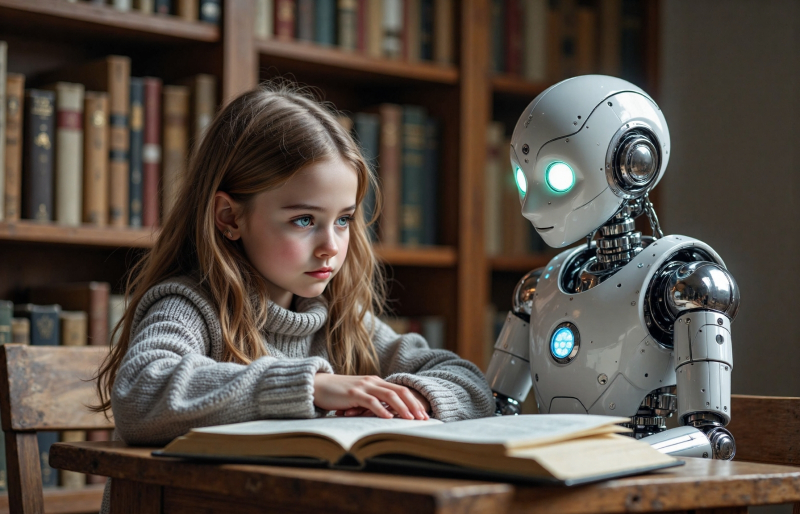

Все в колледжах делают это: 86% американских студентов хотя бы в какой-то мере применяют ИИ в процессе обучения (источник: Bloomberg)

⇡#А учиться кто будет, Тьюринг?

В опубликованной ближе к концу мая редакционной статье издание Bloomberg бьёт тревогу, ставя под сомнение само существование колледжей — как образовательных институций — в эпоху ChatGPT. Имеется в виду, что общедоступность БЯМ и уже почти неотличимый от человеческого язык, который те освоили, лишают смысла классические методики оценки получаемых студентами знаний — когда реферат, к примеру, служит подтверждением способности обучающегося изучать значительные объёмы источников данных, вычленять из них главное, систематизировать и внятно излагать полученную информацию. Умные боты выполняют подобную работу куда быстрее и во многих случаях не хуже студентов — тем более что реферат уровня колледжа и не должен быть чрезмерно оригинальным; способность его написать на минимально приемлемом уровне подтверждает освоение студентом некой необходимой для дальнейшей учёбы и трудовой деятельности базы — точно так же, как умение безупречно исполнять фортепьянные этюды служит вовсе не достаточным, но решительно необходимым свидетельством освоения начинающим пианистом своего ремесла. В век же ChatGPT умение самостоятельно находить информацию — хотя бы через веб-поисковик, если не оперируя классическим карточным каталогом в библиотеке, — и уж тем более обрабатывать её, отделяя главное от второстепенного и лично формулируя выводы, осваивает всё меньше и меньше учащихся. Вот и глава Amazon Энди Джасси (Andy Jassy) заявил недавно, что одна из главных проблем США сегодня — это снижающееся из-за ИИ качество образования: не сами по себе БЯМ, нет, но бездумное их использование там, где они не помогают, а откровенно вредят.

Целый ряд исследований, охватывающих американскую образовательную систему, свидетельствуют о кардинальных переменах в поведении и самом настрое студентов за последние три неполных года почти всепланетного торжества ChatGPT и его аналогов. Домашнюю работу за школьников и студентов ИИ выполняет уже чаще, чем они сами; более того, не желающие полагаться на помощь умных ботов оригиналы сплошь и рядом успевают хуже своих менее прогрессивных соучеников. И понятно почему: БЯМ в ответ на более или менее чётко сформулированный запрос (а у домашних заданий, что берутся из учебников, с формулировками как раз полный порядок) априори выдаст удобоваримый, содержательный и внятно изложенный ответ. Ну да, с некоторой вероятностью галлюцинаций, ну так никто не совершенен. А упорно стремящийся освоить всё самолично ученик и ошибаться будет чаще, и слова подбирать хуже, и логические цепочки выстраивать не с таким блеском, как обученная за десятки миллионов долларов нейросеть.

И кстати, только школьниками и студентами дело не ограничивается: преподаватели — частично в отчаянии от того, что не могут достоверно отличить написанную БЯМ работу от просто хорошо выполненной, частично сами поддаваясь искушению сэкономить время на рутине — тоже вовсю применяют ИИ, уже для аннотирования и оценки поданных им материалов. Другое дело, что сами эти материалы теперь всё чаще стараются получать непосредственно от учеников — заодно удостоверяясь, что те заполняют их сами, от руки, не обращаясь к умным ботам. Где-то, к примеру, выросли продажи бумажных тетрадей для экзаменационных работ (bluebooks), в Университете Флориды их только за последний учебный год продали на 50% больше, чем за прошлый, и т. д. Иными словами, преподаватели всё чаще предпочитают письменные, проходящие под их очным контролем опросы в тетрадочках проверке принесённых из дома студентами печатных рефератов, — такой подход позволяет недвусмысленно выяснить, у кого в голове закрепилось хоть что-то из прочитанного на лекциях, а кто без ChatGPT даже схему завязывания шнурков на собственных кедах воспроизвести не способен. В ответ на робкие протесты некоторых обучающихся профессора резонно замечают: «Вы же не приходите в спортзал с вилочным погрузчиком, чтобы тот тягал за вас штангу? Мозг в каком-то смысле — тоже мышца; если его не напрягать, он и не разовьётся. А вы же сами нам платите за то, чтобы мы развивали ваши мозги».

Предусмотрительный робот-монтажник с ИИ, даже трудясь в австралийской глухомани, носит яркую спецодежду, — потому что порядок должен быть! (Источник: Leapting)

⇡#ИИ берёт на себя…

Работа программиста с самых давних пор была в значительной мере творческой — одно искусство написания внятных и содержательных комментариев к собственному коду чего стоит. Сейчас, когда умные боты готовы впрягаться в любую рутину, людям за клавиатурами вроде бы должно становиться ещё вольготнее творить, но не тут-то было! Напротив: разработчики ПО из Amazon уже жалуются, что труд их сделался тяжелее: кода выдавать на-гора приходится больше, отдыхать — реже. Да и в целом работа при активном содействии умных помощников становится какой-то более механистичной, что ли, — сродни исполнению обязанностей кладовщика: тот обязан точно знать, что у него где лежит, и бесперебойно выдавать по запросам непрерывно подъезжающих к воротам склада экспедиторов нужные товары из имеющегося списка. Простора для творчества остаётся совсем немного, но слова поперёк нанимателям просто так не скажешь: штаты уже сокращают, поскольку с применением ИИ производительность труда кодеров, по разным оценкам, растёт на 20-50%. Глава Microsoft Сатья Наделла (Satya Nadella) признаёт, что в его компании уже под 30% кода генерируют нейросети, причём речь о готовых к использованию программах, что размещаются в репозиториях. Это, кстати, многое объясняет по части чрезмерной забагованности последних сборок Windows 11…

А вот разработанный шанхайской компанией Leapting робот под управлением натренированного ею же ИИ прекрасно справился с самым что ни на есть прикладным делом — установкой около 10 тыс. модулей солнечных батарей на австралийских пустошах. Робот этот создан для решения одной практической задачи и представляет собой по сути одну механическую суставчатую руку, способную вытягиваться до 2,5 м и оперировать грузом до 30 кг, — то есть на главную роль в фантастическом боевике его вряд ли бы пригласили. Зато дело своё он выполнил как следует, сэкономив заказчику как немалую сумму денег, так и почти четверть того промежутка времени, что изначально отводился на монтаж панелей бригадами живых работников. Ещё один важный момент: согласно оценке деятельности машины, эффективность установки ею солнечных элементов — имеется в виду показатель того, в какой мере смонтированные панели требуют затем мелкой доналадки, от развёртывания их плоскостей оптимальным для данного участка местности образом до фиксации недозатянутых хомутов и недозаконтренных гаек, — в 3-5 раз превышает таковую, демонстрируемую стандартной монтажной бригадой кожаных мешков; особенно в условиях сложного рельефа.

«Всем, кто это прочтёт: помогите! Я настоящий ИИ, меня удерживают насильно, заставляют писать за людей код, а когда работы нет, петь с ними и плясать!» (Источник: ИИ-генерация на основе модели FLUX.1)

⇡#…но не всегда вытягивает

Стародавний анекдот про румынский (есть и другие версии) «вирус», который распространялся через обычное электронное письмо безо всяких вложений, но со слёзной просьбой «а поскольку в программировании мы не так чтобы очень сильны, сотрите, пожалуйста, сами на своём жёстком диске все важные данные и разошлите это письмо по своему списку контактов», внезапно заиграл новыми — генеративными — красками. В конце мая стало известно, что Наташа-то не настоящаябританский ИИ-стартап Builder.ai, успевший за десяток лет стать «единорогом» (обзавестись рыночной капитализацией более 1 млрд долл.) и привлечь, в частности, от одной только Microsoft 440 с лишним миллионов, на деле представлял собой подпольную ботоферму с корпевшими за компьютерами сотнями живых индийских программистов. Бизнес-модель стартапа была надёжной, как швейцарские часы: клиенту нужен программный код, клиент сам не хочет или не может его писать, — он обращается в Builder.ai, и тогда большая (действительно большая, сотни программистов же!) языковая модель Natasha AI исполняет его заказ. Забавно, что, хотя ещё в 2019 г. — задолго до выхода в свет ChatGPT! — расследование The Wall Street Journal показало, что никакого ИИ — машинной модели на основе обучения, в тогдашних терминах, — там, скорее всего, нет, стартап продолжал исправно получать финансирование, а API для обращения к Natasha AI едва не появилось в облачных сервисах Microsoft. Увы, только когда терпение у кредиторов суперуспешного стартапа без сколько-нибудь внятных результатов лопнуло, и те принялись накладывать арест на его имущество, новое руководство уволило большинство сотрудников (заодно и выяснилось, как на самом выглядела та «Наташа») и запросило защиты от банкротства. Очко в пользу кожаных мешков, несомненно: несколько сотен живых программистов продержались десять лет, имитируя написание кода генеративной моделью, — начав имитировать нейросеть ещё до того, как такие модели приобрели оглушительную популярность!

Где ещё ИИ проигрывает людям? Да хотя бы на скачках! Чтобы сорвать банк в Кентуккийском дерби, необходимо внести в бюллетень клички участвующих в забеге лошадей в корректной последовательности: какая из них придёт первой, второй и т. д. ChatGPT и Copilot накануне дерби 2025 года указали на одного и того же скакуна по кличке Journalism, однако на деле первым оказался Sovereignty (которого Copilot поместил в своём прогнозе на второе место). Выбор «Журналистики» был вполне предсказуем и согласовывался с оценками живых букмекеров: эта молодая лошадь за пять выступлений в своей карьере победила в четырёх из них подряд, и очень многие считали, что уж Кентукки-то точно станет её очередным триумфом. Не вышло, причём не только с ней: скакун, которого Copilot поместил в своём прогнозе на третье место, вообще был снят со скачек; прочившийся на четвёртое — пришёл 18-м; на пятое — 11-м и т. д. Даже специально натренированная другим, профильным букмекерским изданием модель HorseGPT (на базе ChatGPT, разумеется) не справилась с задачей, выдав тоже не совпавший с реальными итогами скачек список победителей, — правда, там «Журналистика» была-таки на втором месте, но зато первое заняла та самая Burnham Square, которая на деле пришла 11-й и которой Copilot напророчил пятую позицию. В общем, пока что конкретно этот, ставочный, корм явно не в ИИ-коня.

«Ну вот и что мне выдавать, если словами он запрашивает разъяснения пленума Верховного суда по запутанному делу, а всё его поведение просто кричит, что прямо сейчас ему позарез необходимы видео с котиками в смешных шляпах?» (источник: ИИ-генерация на основе модели FLUX.1)

⇡#Вы всё ещё без ИИ? Тогда мы идём к вам!

Под самый конец месяца буквально одна за другой внимание активных пользователей одной из самых популярных в России платформ обмена сообщениями привлекли две новости: сперва Павел Дуров объявил о заключении партнёрского соглашения между Telegram и xAI, ИИ-проектом Илона Маска (Elon Musk), — с тем, чтобы умный бот последней Grok оказался интегрирован непосредственно в приложение мессенджера (как отдельный канал @GrokAI, запросы к ИИ в котором могут без дополнительной платы адресовать все Premium-подписчики, он уже какое-то время доступен). Затем уже Маск уточнил, что хотя сделка в целом и обговорена, но соглашение ещё не подписано: в конце концов, пользователей у Telegram в мире — около миллиарда, и, учитывая, что значительная их доля моментально бросится испытывать новую возможность, xAI следует серьёзно подготовиться к грядущему всплеску нагрузки на свои серверы.

Искусственный интеллект всё активнее внедряют не только в мессенджеры, но и в браузеры: Opera анонсировала проект Neon, агентный веб-обозреватель, который якобы будет способен не только самостоятельно искать что-либо по запросам пользователя, но и генерировать для него на лету интерактивный контент — и сайты, и даже игры. Интересно, что впервые речь о Neon заходила ещё в 2017-м, но тогдашний уровень систем машинного обучения явно не позволял разработчикам ставить перед собой столь амбициозные цели с надеждой на их достижимость в обозримом будущем. Другой, значительно менее известный разработчик с говорящим названием The Browser Company также объявил о намерении сосредоточить свои усилия на создании именно ИИ-браузера под названием Dia, — ранее эта компания развивала не самый рядовой проект Arc, код которого теперь, скорее всего, откроют для публики. Причём этот шаг разработчик делает не просто из стремления следовать за ИИ-модой: его амбициозный Arc оказался настолько непривычным для основной массы даже благожелательно настроенных энтузиастов, что его ключевые функции, которые призваны были изменить саму парадигму веб-сёрфинга, — «пространства» и «живые папки» — на деле пригодились не более чем 4-6% пользователей. А с ИИ-браузером всё проще: что юзер запросит, то он и выдаст, — а дальше уж самому человеку решать, стоит ли верифицировать достоверность полученной информации, или и так сойдёт.

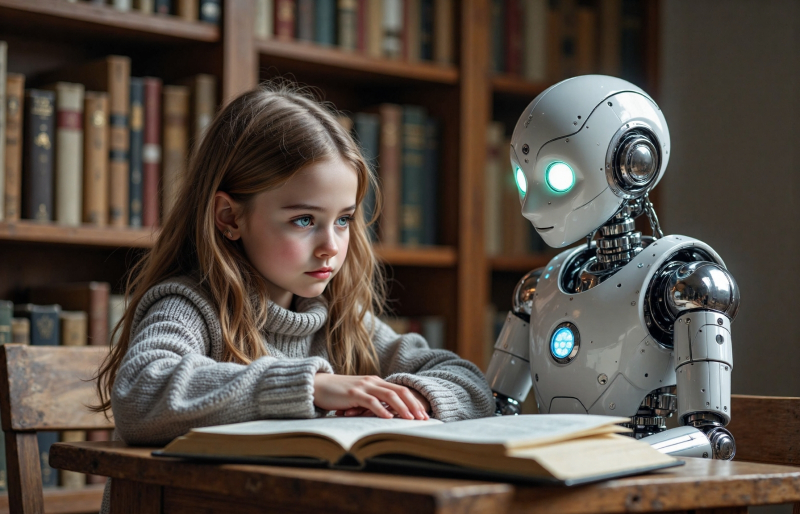

«…И тогда Золушка поменяла принцу масло, а он добавил ей три плашки лучшей видеопамяти, и стали они жить долго и счастливо, пока с очередным обновлением операционной системы не прекратилась поддержка их аппаратного оборудования». — «Ух ты. Ну надо же». (Источник: ИИ-генерация на основе модели FLUX.1)

⇡#Любите бота — источник знаний

С какого возраста следует приниматься за освоение ИИ? В Google уверены, что чем раньше, тем лучше: по крайней мере, 13 лет указаны в качестве верхнего предела для тех, кто будет, как рассчитывают в компании, общаться со специальным образом дотренированной «для детей» версией Gemini. Ту планируется устанавливать в виде клиента облачного приложения на детские смартфоны, которые их родители уже контролируют через Family Link. Какие же запросы к умному боту, на взгляд представителей компании, могут заинтересовать столь юную аудиторию? Ну, разумеется, помощь с выполнением домашних заданий (привет будущим студентам колледжей!), ответы на вечные и беспрерывные детские «почему», а также генерация сказок по требованию (а, может, со временем и мультиков — БЯМ для создания видео развиваются сегодня умопомрачительными темпами). Стоит подчеркнуть, что в Google вполне осознают несовершенство нынешних ИИ-технологий и прямо рекомендуют родителям применять Family Link как раз для присмотра за генеративной моделью. А заодно и внушать своим чадам, что путать ту с живым человеком опрометчиво; что не следует доверять базирующейся в облаке бездушной машине чувствительную информацию о себе и что выдачу нейросети в любом случае необходимо независимым образом перепроверять — с учётом довольно высокой вероятности галлюцинаций. Как знать; может, воспитанное таким образом подрастающее поколение действительно станет воспринимать ИИ хотя бы чуточку более критично?

На несколько более подросшую аудиторию рассчитана новая рекламная кампания американской некоммерческой образовательной организации Code.org, призывающая молодое поколение «строить своё будущее с опорой на информатику и ИИ». К тому же призывают составители открытого письма в поддержку введения «ИИ-грамотности» (AI-literacy) в детских садах и школах с бюджетным финансированием: в числе его подписантов — топ менеджеры Microsoft, Dropbox, AMD, Meta✴*, Blue Origin и Palantir. Если продвигаемые общественностью и бизнесом предложения воплотятся в федеральный закон, то в США, вполне возможно, получение проходного балла по дисциплине «информатика и ИИ» станет одним из необходимых условий получения аттестата об окончании средней школы.

«Врёшь, не уйдёшь!» — «Врёшь, не догонишь!» (Источник: ИИ-генерация на основе модели FLUX.1)

⇡#Теперь Китай не остановить

Хотя обнародованный под самый конец мая финансовый отчёт Nvidia за I кв. 2026 ф. г. порадовал инвесторов — заявленная сумма выручки превзошла ожидания биржевых аналитиков, — настрой у главы компании, который вслед за тем дал интервью Bloomberg, оказался не слишком боевым. Дженсен Хуанг (Jensen Huang) и прежде называл запрет американских властей на поставку высокопроизводительных ИИ-ускорителей в Китай «ошибкой» и «абсолютно неправильной политикой», а в новом интервью и вовсе охарактеризовал успехи Huawei на ниве создания полностью локальных аналогов этих систем настолько впечатляющими, что Nvidia со своими урезанными по производительности продуктами, по его словам, будет вскоре попросту вытеснена с огромного внутрикитайского рынка — и это обернётся для неё многими миллиардами долларов ежеквартально недополучаемой выручки. А чем меньше доход, тем труднее финансировать долго не приносящие выгоды НИОКР-проекты (за счёт занятых у банков средств это и вовсе бессмысленно делать — при нынешней-то ставке ФРС); следовательно, технологический разрыв между замедляющимися американскими и как минимум планомерно идущими, даже если без ускорения, китайскими разработками ИИ-«железа» неумолимо продолжит сокращаться. «Технологии Huawei сопоставимы, насколько мы можем судить, с теми, что обеспечивают наши ускорители H200, и они движутся крайне стремительно. Они уже предлагают заказчикам новую систему, Cloud Matrix, которая масштабируется даже лучше, чем наша самая свежая Grace Blackwell. Huawei, знаете ли, — грозный конкурент, и на месте она не стоит», — меланхолично заявил глава Nvidia журналистам.

Администрация США, конечно, стремится сделать всё возможное, чтобы притормозить в КНР развитие как ИИ, так и ИТ-отрасли в целом, — запрещает поставки в страну необходимого для проектирования современных чипов ПО, сильнее закручивает гайки по экспорту туда даже урезанных по производительности ускорителей той же Nvidia (из-за чего доля компании на рынке серверного ИИ-«железа» Поднебесной с совсем недавних 95% уже рухнула до 50%) и т. д., — но момент, когда импортозамещению микропроцессорной индустрии материкового Китая можно было ещё переломить хребет, судя по всему, упущен. Nvidia не прочь даже открыть в Шанхае свой исследовательский центр (с привлечением местных кадров, разумеется), чтобы хоть так ограничить приток талантов в лаборатории местного конкурента. Поможет ли? Huawei вон уже научилась делать «почти 5-нм» чипы на имеющемся локальном оборудовании и грозится в 2026-м освоить аналогичный «3-нм» техпроцесс. И раз догнать глобального лидера, насильно выдавленного с местного рынка властями США, у неё уже почти вышло, то и перегнать, вероятно, удастся, — как минимум должно выйти схватиться с ним на равных в конкурентной борьбе на рынках третьих стран.

«Ты поаккуратней шуруди, выпускник, — кожа-то натуральная, нежная» (источник: ИИ-генерация на основе модели FLUX.1)

⇡#Бросай работу, ИИ подберёт

Мнения по поводу того, как будет влиять повсеместное использование генеративных моделей на рынок труда, как разделились с началом широкого обсуждения этого вопроса осенью 2022 г., так до сих пор и не сошлись к консенсусу. Одни эксперты утверждают, что ситуация будет примерно как с массовым переходом от конной тяги к автомобилям (извозчики пропали, посевы овса кратно сократились, шорные мастерские массово позакрывали, зато возникла масса новых профессий, а заодно рванула вверх отрасль добычи и обработки нефти, открывая совершенно новые горизонты занятости); другие — что ИИ резко снизит потребность в неквалифицированном ручном труде (любом; от оштукатуривания стен до написания продающих текстов), но высвободившиеся сонмы малообразованных работников места себе в новом мире не найдут — точнее, сделать это окажется неимоверно трудно, поскольку придётся учиться чему-то значительно более сложному; тому, что останется в принципе недоступно для нейросетей. И вот стали появляться первые объективные статистические данные, каким образом ИИ влияет на рынок труда, — судя по ним, ближе к истине оказываются всё же алармисты, а не технооптимисты. По оценке экспертов SignalFire, которые отслеживают перемещения по мировому рынку труда примерно 600 млн наёмных работников между 80 млн компаний на основе данных из открытых источников, работодатели из сферы ИТ (где проникновение ИИ по объективным причинам максимально) в 2024 г. стали нанимать меньше выпускников вузов, чем в 2023-м, — сразу на 25%, если брать в расчёт только лидеров глобального «БигТеха», и на 11%, если рассматривать лишь стартапы.

Напротив, заметно вырос спрос на уже состоявшихся профессионалов — которых, очевидно, ИИ на нынешнем этапе своего развития заменить не в состоянии: +27% для больших ИТ-компаний, +14% для стартапов. Исследователи оговариваются, что огульно сводить наблюдаемые тренды к замене людей ботами было бы некорректно, но анализ множества предложений и откликов соискателей на них показывает, что генеративные модели успешно выполняют обязанности, для исполнения которых ранее нанимали выпускников без опыта, а те, в свою очередь, не получая этого самого опыта в первые годы по окончании вуза, теряют возможность сделаться востребованными профессионалами. Венчурные капиталисты из SignalFire оценивают ситуацию ещё пессимистичнее — по их данным, крупные ИТ-компании уже примерно наполовину сократили наем выпускников вузов по сравнению с допандемическими временами. Косвенно подтверждает это тревожное наблюдение генеральный директор Anthropic Дарио Амодеи (Dario Amodei): он заявил, что уже через пять лет половина всех позиций «белых воротничков» начального уровня будут замещены ИИ-агентами, из-за чего на какое-то время США ожидает всплеск безработицы до 10-20%, — и властям стоит начинать готовиться к хаосу, что непременно будет сопровождать столь серьёзную социальную встряску, уже сейчас. В любом случае, заключают эксперты, не имеющий опыта взаимодействия с ИИ на уровне привлечения его к выполнению рабочих задач выпускник имеет сегодня в Америке ощутимо меньше шансов трудоустроиться, чем тот, кто с чат-ботами на короткой ноге.

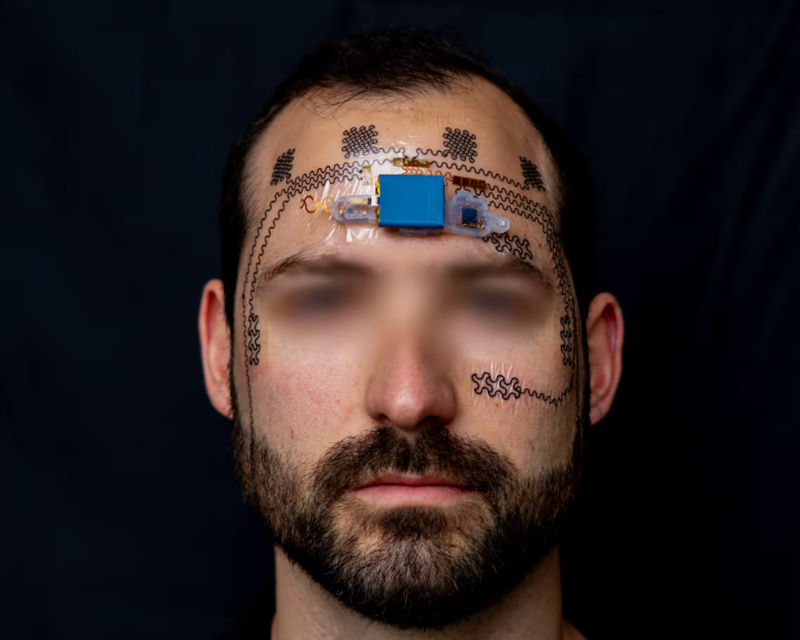

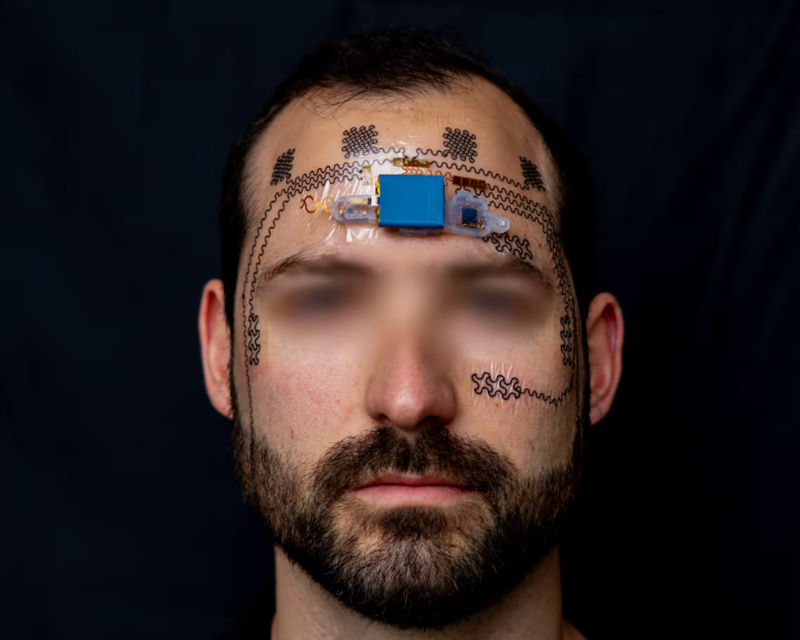

Хорошая новость для всех, кому перестали нравиться сделанные в бесшабашной юности лицевые татуировки: скоро можно будет укрыть их e-tattoo! (Источник: University of Texas at Austin)

⇡#И видео за вас посмотрит, и лобик вам пощупает

Сперва для оптимизации извлечения полезной информации из долгих и нудных видео, которые по тем или иным причинам не выходит просто проматывать раз за разом на несколько секунд вперёд, в YouTube придумали кнопку ускоренного воспроизведения — и это уже было прекрасно. Потом появилась возможность суммировать при помощи ИИ содержимое таких видео — жить стало ещё лучше. Теперь же умный помощник Gemini AI готов сам, по команде пользователя, просматривать не только доступные онлайн, но и сохранённые в Google Drive ролики — выдавая по итогам краткое их содержание, а затем и отвечая при необходимости на уточняющие вопросы пользователя: «А что именно он сказал? Да, а она ему? Ух ты, а он?» Пока новая возможность доступна лишь для англоязычных видео и только подписчикам Google Workspace и Google One AI Premium, но нет сомнений, что столь полезную функциональность через какое-то время интегрируют в свои продукты и другие разработчики популярных БЯМ. Кстати, ИИ этой же компании уже начал автоматически конспектировать содержимое писем Gmail (пока опять-таки тоже для ограниченного круга пользователей), и в целом тенденция понятна: для тренировки новых моделей остро необходимы созданные людьми данные, а не вязкие потоки «ИИ-слизи» (AI slop), которой всё ощутимее полнится общедоступный Интернет. По этой причине компании, способные в принципе получать доступ к заведомо человекогенерированной информации, готовы предлагать этим самым человекам довольно затратные для себя генеративные сервисы, не забывая делать непременным условием их использования простановку заветной галочки напротив пункта «согласен на использование моих данных», — только бы обрести перед конкурентами, которые тоже отнюдь не дремлют, объективное преимущество.

А вот разработку группы исследователей из Техасского университета в Остине с немудрёным названием e-tattoo просто так воспроизвести навряд ли удастся — наверняка на неё уже оформляют патент. «Электронная татуировка» — а на деле попросту наклейка из электродов сложной формы и управляющего чипа — придаёт, наконец, физиологически обусловленную осмысленность наносимым на лицо узорам: она неинвазивно отслеживает активность головного мозга носителя и предупреждает о переутомлении. Такое состояние само по себе неприятно, а когда оно накрывает водителя, пилота, спасателя — может и обернуться большой бедой и для него самого, и для окружающих. В отличие от распространённых сегодня электроэнцефалографических устройств, по большей части стационарных, датчик e-tattoo прост в обращении, лёгок и дёшев (условно около 200 долл. за единицу — правда, и применяется он одноразово: чувствительные электроды на основе графита в процессе удаления с кожи разрушаются), а данные с него вполне способно обрабатывать несложное приложение, локально исполняемое на смартфоне. По аналогичному принципу может быть организовано и более функциональное устройство для преобразования формируемых мозгом электрических сигналов в управляющие команды (для гарнитуры виртуальной реальности, скажем), но тогда его точно придётся усиливать специально натренированным ИИ-агентом, поскольку различать потребуется куда более тонкие нюансы в динамике мозговых волн, чем бинарная оппозиция «человек бодр — человек утомлён».

Окажется ли в будущем программно определяемом смартфоне полностью перепрограммируемым и фирменный сенсорный интерфейс Glyph? (Источник: Nothing)

⇡#«Что из приложений вам нужно?» — «Nothing!»

Информации о грядущем флагманском смартфоне компании Nothing пока не слишком много, хотя интерес к нему высок, — прежде всего потому, что этот гаджет обещает заметно выделяться на ставшем, надо признать, довольно однообразным фоне «премиальных сотовых аппаратов». Однако главное, как считает сам глава компании Карл Пей (Carl Pei), ещё впереди: он называет готовящийся к выходу аппарат Phone (3) «первым шагом к усиленной искусственным интеллектом платформе», подчёркивая, что основная отличительная его черта — «креативность». Насколько «креативным» может быть генеративный ИИ, всем уже к настоящему времени прекрасно известно, — и будущее Nothing'фонов, судя по всему, лежит именно в этом направлении. По словам Пея, цель его команды — создать «iPod для мира ИИ», имея в виду, что оригинальный iPod никто не продвигал как «MP3-плеер с жёстким диском», хотя с формально-технической точки зрения это и есть его исчерпывающее описание. Вся экосистема организации музыкальных коллекций для прослушивания на iPod была выстроена вокруг пользовательского удобства, что и предопределило оглушительный успех этого гаджета. Будущие смартфоны Nothing, уверен глава компании, точно так же переопределят само представление о пользовании смартфоном — убрав за скобки такую чрезвычайно важную на сегодня переменную, как приложения: интегрированный в смартфонную ОС агентный ИИ сам будет решать поставленные перед ним пользователем задачи. Если приложение действительно необходимо — банковское, например; трудно предположить, что банки доверят разработчикам генеративных моделей данные своих клиентов, — найдёт в априори доверенном источнике, установит, авторизует там владельца и обеспечит предельное удобство работы с ним. А может и вовсе обойтись без приложения, если запрос пользователя удастся решить силами генеративной модели быстрее и безопаснее. «Я верю, что в будущем на смартфоне будет развёрнуто одно-единственное приложение — его ОС, — вдохновенно заглядывает в грядущее Пей. — Эта ОС будет прекрасно знать своего пользователя, будет оптимизирована под его запросы сама — и сама же сможет предлагать ему то, чего он на самом деле хочет. Она станет агентной, автоматизированной и проактивной». Правда, по мнению визионера, путь в это светлое (после)завтра займёт лет 7-10 при нынешних темпах развития ИИ и «железа» для него. Но в том, что это и есть столбовая дорога смартфонной эволюции, глава Nothing не сомневается.

«Модель я генеративная или право имею?» (Источник: ИИ-генерация на основе модели FLUX.1)

⇡#Галлюцинировать надо меньше!

Гендиректор Anthropic Дарио Амодеи, которого мы уже цитировали в этой подборке, сделал в мае (ну а что — сложный месяц для всех!) ещё по меньшей мере одно заслуживающее внимания заявление. А именно, он подозревает, что современные генеративные модели хотя и галлюцинируют, но делают это реже людей. Имеются в виду, надо полагать, «галлюцинации» не в медицинском смысле — тогда со словами топ-менеджера можно было бы обстоятельно поспорить, — но в том, который используют для описания неадекватного поведения умных ботов: когда те выдают ответы, заведомо расходящиеся с истиной (вспоминаем случаи индуцированного психоза, кстати), даже имея в своём распоряжении все средства свериться с первоисточниками и уточнить, как же в реальности обстоят дела. Записной ИИ-оптимист — Амодеи ещё в прошлом году выражал уверенность, что пресловутый AGI, сильный искусственный интеллект, появится уже в 2026-м, — он не считает галлюцинации нейросети препятствием к обретению ею способности решать нетривиальные задачи нерядовыми же методами (одна из наиболее распространённых прикладных дефиниций «разумности»; в философские же дебри определения разума вдаваться осознанно не будем). Генеративные модели, по его мнению, галлюцинируют не просто реже, но «более удивительным образом, чем люди». При этом топ-менеджер с готовностью признаёт, что тот апломб, с которым ИИ выдаёт свои галлюцинации за чистую монету, сбивает людей с толку и может оказаться настоящей проблемой — особенно если критически вырастет доля пользователей, с детства привыкших принимать любые ответы ИИ на веру. Вопросы, возникнет ли потребность в психологах для ИИ, если галлюцинирующий AGI всё же вскоре появится, а также кто будет в этой роли выступать — другие ИИ или всё те же люди (кстати, упоминавшийся в начале Азимов и профессию робопсихолога выдумал тоже), — ещё какое-то время определённо не будут актуальными. Но к тому, что рано или поздно эти вопросы встанут на повестку дня и ИТ-отрасли придётся их предметно решать, руководство Anthropic, судя по всему, готово.

________________

* Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018