|

Опрос

|

реклама

Быстрый переход

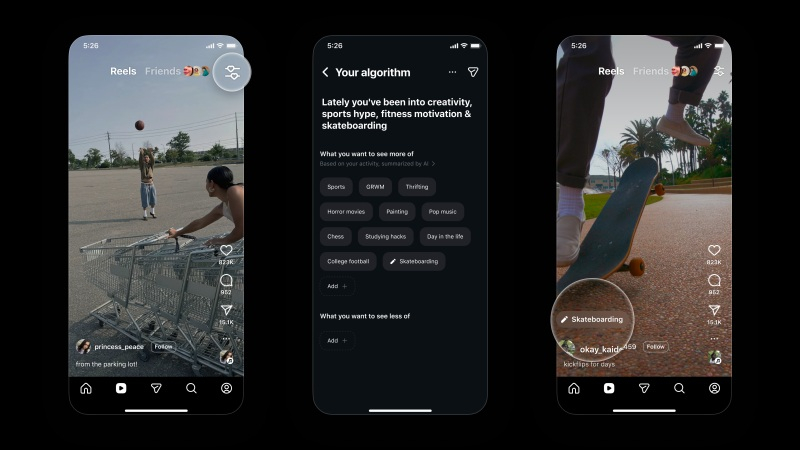

В Instagram✴ теперь можно настраивать алгоритмы Reels под свои предпочтения

11.12.2025 [13:25],

Владимир Мироненко

Instagram✴✴ добавила в Reels новый инструмент «Ваш алгоритм» на базе ИИ, позволяющий пользователям контролировать темы, которые рекомендует к просмотру алгоритм и настраивать рекомендации в соответствии с их интересами.

Источник изображения: TechCrunch «По мере того, как ваши интересы меняются со временем, мы хотим предоставить вам более эффективные способы контролировать то, что вы видите, — сообщается в блоге Instagram✴✴. — Используя ИИ, вы теперь можете проще просматривать и персонализировать темы, которые формируют ваши Reels, делая рекомендации ещё более индивидуальными для вас». Соцсеть пообещала вскоре добавить эту возможность в раздел «Исследовать» и другие разделы приложения. Для настройки алгоритма Reels необходимо коснуться значка в правом верхнем углу (две линии с сердечками). После этого откроется раздел «Ваш алгоритм», где отображаются темы, которые, по мнению Instagram✴✴, интересуют пользователя. Здесь можно указать, какие из них хотелось бы видеть чаще или реже, и в дальнейшем алгоритм будет следовать этим рекомендациям. При желании пользователь может поделиться своими интересами в своей «Истории», чтобы друзья и подписчики могли видеть, чем он увлекается. На данный момент новая функция «Ваш алгоритм» в Reels доступна только для пользователей в США, но в дальнейшем к ней получат доступ пользователи из других регионов. Аналогичная функция под названием «Управление темами» есть в TikTok. С её помощью они могут лучше контролировать то, что видят в ленте «Для вас». IBM заставила алгоритм коррекции ошибок квантовых компьютеров работать на обычных чипах AMD

24.10.2025 [19:57],

Сергей Сурабекянц

Сегодня компания IBM сообщила о реальной возможности запуска ключевого алгоритма коррекции ошибок квантовых вычислений на общедоступных чипах производства компании Advanced Micro Devices. Это открытие может существенно приблизить начало коммерческого использования квантовых вычислений.

Источник изображения: IBM Квантовые компьютеры используют так называемые кубиты для решения специфических задач, например, расчёта взаимодействия триллионов атомов на протяжении больших временных промежутков. На поиск ответа обычным компьютерам потребовались бы тысячи лет. Однако квантовые вычисления подвержены ошибкам и влиянию шума, которые могут быстро свести на нет вычислительную мощность квантового чипа. В июне IBM заявила, что разработала алгоритм для работы с квантовыми чипами, способный устранять подобные ошибки. В исследовательской работе, которая должна быть опубликована 27 октября, компания продемонстрирует его запуск в реальном времени на чипе AMD типа Valve Array («программируемая вентильная матрица»).

Источник изображения: AMD По словам директора по исследованиям IBM Джей Гамбетта (Jay Gambetta), исследование доказало, что новый алгоритм IBM для коррекции ошибок квантовых вычислений не только работает в реальном мире, но и запускается на существующем чипе AMD, который «смехотворно дёшев». Он также подчеркнул, что «внедрение алгоритма и демонстрация того, что он действительно в 10 раз быстрее, чем требуется, — это большая задача», которая была завершена на год раньше запланированного. IBM стремится завершить работы по созданию полноценного квантового компьютера Starling к 2029 году. Российские учёные усовершенствовали MP3

12.07.2025 [12:58],

Павел Котов

Российские учёные из Московского технического университета связи и информатики (МТУСИ) усовершенствовали алгоритм сжатия звука MP3 — его новый вариант позволяет уменьшить размер файлов на 20 % при сохранении того же качества звука, что и в классическом варианте формата, пишут «Известия».

Источник изображения: Ciocan Ciprian / unsplash.com «Формат MP3, несмотря на популярность, имеет недостатки. Например, при оцифровке аналогового сигнала (импульсно-кодовой модуляции, ИКМ) в цифровой на скорости 250–270 Кбит/с теряются нюансы, так называемые атаки, которые определяют насыщенность звука и его разборчивость», — цитирует издание заявление пресс-службы МТУСИ. Улучшение качества звука по сравнению с обычным сжатием MP3 у нового формата заметно уже при 56 кбит/с, что подтверждается опросами людей и объективными измерениями. Эксперты также запатентовали алгоритм «не искажающего компандирования» — эффективного сжатия, которое не сопровождается искажениями и шумами. «Метод сжимает динамический диапазон до 10–15 дБ, но звук передаётся без искажений. А качество даже при использовании 16-битного формата сравнимо с 32-битным входным сигналом, то есть негативные стороны 16 бит снижены», — отметили также в пресс-службе вуза. Проблема традиционных форматов сжатия звука состоит в том, что они исключают из аудиокартины некоторые нюансы, и в первую очередь тихие звуки; доходит до потери половины данных, указывают опрошенные «Известиями» эксперты. Искажения проявляются в появлении шумов, «металлического» оттенка и смазанности; в диапазоне от 56 до 128 Кбит/с пропадают детали, и звук становится плоским. Разработка российских учёных окажется полезной при работе в студиях звукозаписи, на потоковых платформах и для устройств с ограниченным объёмом памяти, считают эксперты. Для успешного внедрения технологии потребуется её применение на стриминговых сервисах, хорошем подспорьем станет и общее повышение качества звуковой аппаратуры, хотя и современные смартфоны уже в среднем сегменте способны обеспечить качественное звучание. На практике оптимизированный формат MP3 окажется наиболее полезным при низких битрейтах — это пригодится в онлайн-вещании, подкастинге и киберспорте, где важен чёткий звук при минимальном потреблении трафика. При работе в студии алгоритм будет полезным в сжатии «многодорожных фонограмм без потери субъективного качества». Проект особенно актуален с учётом роста потребления медиаконтента и потребности оптимизировать инфраструктуру хранения данных. Британский стартап объявил о разработке революционного алгоритма сжатия данных

04.07.2025 [17:46],

Павел Котов

Британский стартап утверждает, что добился прорыва в задаче сжатия данных без потерь — алгоритм CompressionX, по словам создателей, помогает уменьшить занимаемое файлом дисковое пространство на величину до 65 %.

Источник изображения: compressionx.co.uk Технология CompressionX рекламируется как альтернатива лучшим средствам сжатия данных на рынке, как экологически дружественный и удобный для бизнеса инструмент. Он работает иначе по сравнению с традиционными средствами, потому что в его основе лежит «умный, адаптивный алгоритм», а не общая процедура сжатия — он более разумно анализирует структуру файлов. К 2030 году центры обработки данных, если верить прогнозам, могут стать источниками 8 % мировых углеродных выбросов, и задуматься об оптимизации следует уже сегодня. Создатели технологии перечисляют несколько функций, призванных выделить CompressionX, в том числе архивирование в соответствии с требованиями европейского «Общего регламента по защите данных» (GDPR), поддержка шифрования XChaCha20, а также совместимость с форматами ZIP и 7Z. Разработчики указывают, что алгоритм может оказаться полезным для тех, кто пользуется популярными облачными хранилищами — он помогает экономить место и облегчает перемещение больших файлов. Есть, впрочем, у CompressionX и недостаток. В бесплатном режиме доступны только основные функции алгоритма и сжатие до 25 Гбайт данных в месяц. Неограниченные возможности и доступ для бизнес-клиентов обойдутся в £3,99 ($5,43) в месяц на одного пользователя, причём плата вносится за год вперёд. ЕС потребовал от соцсети X раскрыть алгоритм рекомендаций и политику модерирования

17.01.2025 [18:52],

Сергей Сурабекянц

В рамках начатого сегодня расследования, Еврокомиссия потребовала от соцсети X предоставить внутренние документы, касающиеся алгоритма рекомендаций платформы. Комиссия также издала «приказ о хранении» всех относящихся к делу документов, для контроля за возможным изменением алгоритма в будущем. Действия Еврокомиссии стали ответом на многочисленные жалобы на платформу со стороны немецких политиков в преддверии выборов в следующем месяце  В поступивших в Еврокомиссию жалобах утверждается, что алгоритм рекомендаций социальной сети X активно продвигает контент немецких ультраправых партий в преддверии выборов, которые запланированы в Германии на 23 февраля. Оправданность этих обвинений косвенно подтверждается заявлением Илона Маска (Elon Musk) в поддержку националистической партии «Альтернатива для Германии», в котором он утверждает, что эта партия «спасёт Германию». На вопрос о том, не инициировано ли расширенное расследование Еврокомиссии спорным интервью Маска, представитель регулятора сообщил, что новый запрос помог «контролировать системы вокруг всех этих происходящих событий». Однако он подчеркнул, что расследование «полностью независимо от каких-либо политических соображений или каких-либо конкретных событий». «Мы стремимся к тому, чтобы каждая платформа, работающая в ЕС, уважала наше законодательство, которое направлено на то, чтобы сделать онлайн-среду справедливой, безопасной и демократичной для всех граждан Европы», — заявила руководитель цифрового направления Еврокомиссии Хенна Вирккунен (Henna Virkkunen). По сообщениям из осведомлённых источников, регулятор ЕС также запросил у соцсети X доступ к внутренним правилам модерации и алгоритмам продвижения контента. Instagram✴ тестирует полное обнуление ленты рекомендаций — для тех, кто хочет начать с чистого листа

19.11.2024 [17:15],

Анжелла Марина

Instagram✴✴ анонсировал тестирование функции сброса системы рекомендаций. Нововведение предназначено для тех, кто устал от старых рекомендаций и хочет начать всё с чистого листа, позволив алгоритму заново изучить предпочтения и сформировать для показа другой контент.

Источник изображения: Julio Lopez/Unsplash Как пишет TechCrunch, новая функция предназначена для пользователей, которые считают, что рекомендации контента больше не соответствуют их интересам. Например, возможно, раньше кому-то нравились видеоролики с кулинарными рецептами, но затем интересы изменились, однако алгоритм продолжает рекомендовать этот контент в Reels и ленте «Интересное». После сброса в Instagram✴✴ рекомендаций персонализация контента начнёт формироваться заново на основе взаимодействия с публикациями и аккаунтами. Также при сбросе будет предложена опция просмотра списка аккаунтов, на которые пользователь подписан, чтобы отписаться от блогеров, контент которых больше не интересен. Примечательно, что нововведение похоже на функцию, которую TikTok запустил в прошлом году, позволяющую пользователям сбрасывать ленту рекомендаций «Для вас». Глава Instagram✴✴ Адам Моссери (Adam Mosseri) в своём видеообращении отметил, что новую функцию не следует использовать слишком часто, поскольку она предназначена только для случаев, когда требуется действительно полное обновление. «Хочу прояснить этот серьёзный шаг, — сказал Моссери. — Сначала ваш Instagram✴✴ станет достаточно не интересным, потому что мы будем относиться к вам так, как будто ничего не знаем о ваших интересах, и нам потребуется некоторое время, чтобы снова их изучить. Поэтому я не рекомендую делать это постоянно, но если вы окажетесь в ситуации, когда вам действительно захочется начать всё с чистого листа, это даст вам реальный выход из положения». Стоит отметить, что новая функция дополняет уже существующие инструменты Instagram✴✴, позволяющие отслеживать и редактировать личные рекомендации, выбирать в публикациях «Интересно» или «Не интересно», чтобы «проинформировать» алгоритм о своих предпочтениях, а также скрывать контент с определёнными словами или фразами, используя функцию «Скрытые слова». По заявлению компании, функция будет развёрнута по всему миру в ближайшее время. Instagram✴ начнёт продвигать оригинальный контент и бороться с серийными репостерами

30.04.2024 [18:46],

Павел Котов

Instagram✴✴ внесёт существенные изменения в механизмы рекомендации контента, уделив особое внимание оригинальному контенту и расширению аудитории небольших аккаунтов. Об этом сообщила администрация платформы.

Источник изображения: Guilherme Stecanella / unsplash.com Самое большое изменение коснётся агрегаторов — аккаунтов, которые публикуют материалы других пользователей. Иногда агрегаторы указывают авторство такого контента, отмечая его в публикации или подписи, но часто материал копируется без какого-либо подтверждения. В Instagram✴✴ эта проблема назрела давно, и теперь повторно опубликованный контент будет удаляться из рекомендаций на платформе. В первую очередь это коснётся серийных репостеров — учётные записи, публикующие материалы, которые они «не создавали и существенным образом не улучшали» более 10 раз за 30 дней. Это значит, что учётные записи — агрегаторы больше не будут появляться на странице «Интересное». Пострадавшие от санкции аккаунты смогут вернуться на страницу рекомендаций через 30 дней после последней публикации «неоригинального» контента. Но этим в администрации Instagram✴✴ решили не ограничиваться: опубликованный агрегаторами контент платформа заменит в рекомендациях на оригинальный. Это будет сделано, если оригинальный материал «относительно новый», и если система уверена, что публикации идентичны, «основываясь на звуках и визуальных сигналах». Изменения коснутся только рекомендаций — пользователи, которые подписаны на агрегаторы, всё равно увидят репосты в их профиле или у себя в ленте. Система также начнёт добавлять метки с указанием первоначального создателя контента — и он, и публикатор репоста смогут эту метку удалить. Санкции, направленные против аккаунтов-агрегаторов могут иметь последствия не только для «фабрик контента», ворующих мемы и фотографии. К примеру, могут пострадать люди, публикующие инфографику, страницы поклонников знаменитостей или аккаунты, публикующие вдохновляющие фото из различных источников в Instagram✴✴. Повторная публикация материалов в Instagram✴✴ стала настолько распространённой практикой, что для этого были созданы специальные приложения — теперь же людям придётся подумать дважды перед публикацией репоста. Новый алгоритм системы рекомендаций также «даст всем авторам равные шансы на прорыв». Раньше страницы рекомендаций формировались в зависимости от взаимодействия пользователей с публикациями, то есть страницы с наибольшим числом подписчиков чаще имели наибольший охват. Теперь принцип работы системы будет напоминать механизм бета-тестирования: часть контента будет предложена небольшой аудитории, которой он может быть интересен вне зависимости от подписки на автора. Наиболее интересные публикации будут представлены группе побольше, и процесс повторится. Возможно, это запустит в Instagram✴✴ феномен «завируситься может каждый» — из-за него TikTok стал настолько привлекательным для желающих стать инфлюенсерами. Это изменение вступит в силу в ближайшие месяцы. ИИ показал, что отпечатки пальцев не так уникальны, как считалось прежде

16.01.2024 [20:43],

Геннадий Детинич

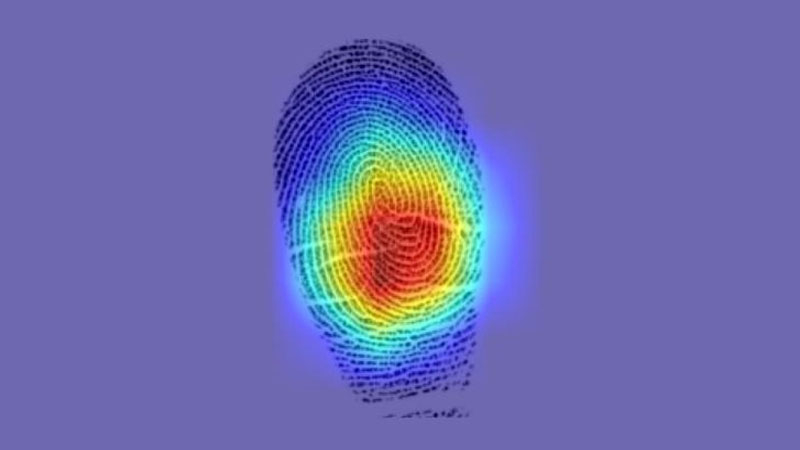

Считается, что рисунок линий на подушечках пальцев никогда не повторяется даже у одного человека, не говоря о других людях. На этом строится вся криминалистика и биометрические датчики. Группа исследователей решила проверить это утверждение с помощью обучаемой нейросети и с удивлением обнаружила, что отпечатки пальцев вовсе не так уникальны, как считалось.

Чем «горячее» область, тем больше сходства с отпечатками других пальцев одного человека. Источник: Gabe Guo/Columbia Engineering Это вряд ли заставит заново пересмотреть уголовные дела, где основными уликами были оставленные на месте преступления отпечатки пальцев. Но это может помочь с делами, где нет полного набора отпечатков, а новые всё всплывают и всплывают. Учёные из Колумбийского университета с помощью нейросетей, обычно используемых для распознавания лиц, проанализировали отпечатки пальцев 60 тыс. граждан США из открытой правительственной базы. После обучения нейросеть с вероятностью 77 % смогла идентифицировать другие отпечатки пальцев человека по одному из известных ей отпечатков. Сети достаточно было увидеть один отпечаток пальца, чтобы она сразу же представила все остальные. Новый анализ отпечатков пальцев по открытой базе с усовершенствованным алгоритмом позволил найти общие моменты, присущие всем отпечаткам пальцев одного человека. Эти особенности рисунка папиллярных линий сосредоточены в центре подушечек. На каждом пальце одного человека они имеют много одинаковых особенностей — изгибов и поворотов — сообщили учёные, что раньше никем не анализировалось. Со временем нейросеть стала лучше определять, когда два разных отпечатка принадлежат одному и тому же человеку. Хотя каждый отпечаток на одной руке по-прежнему уникален, между ними было достаточно сходства, чтобы искусственный интеллект смог сопоставить и находить общее. Алгоритм и методика, предложенные учёными, пока не подходят для уверенной идентификации человека лишь по одному отпечатку пальцев с помощью сканирования любого другого. Настоящее чудо может произойти, если нейросети скормить данные о миллионах и миллиардах людей. Но у скромного коллектива учёных нет доступа к таким базам. Разве что их методикой воспользуются заинтересованные государственные структуры. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |