|

Опрос

|

реклама

Быстрый переход

В Китае создали «глаз мухи» для дронов с панорамным зрением и встроенным «обонянием»

13.02.2026 [22:00],

Геннадий Детинич

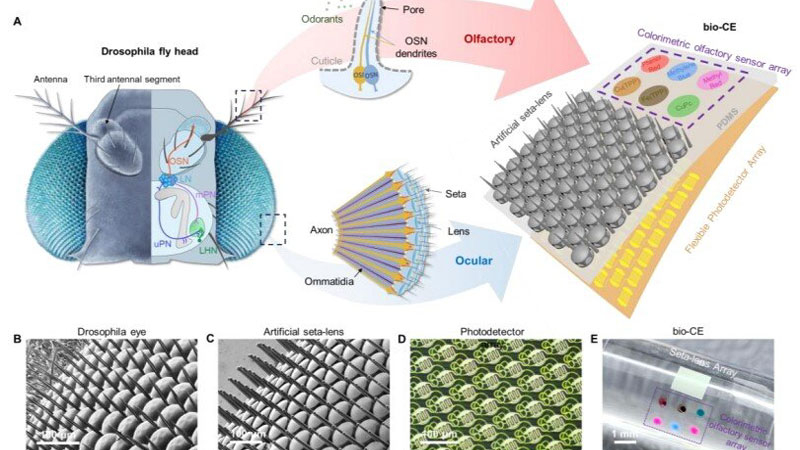

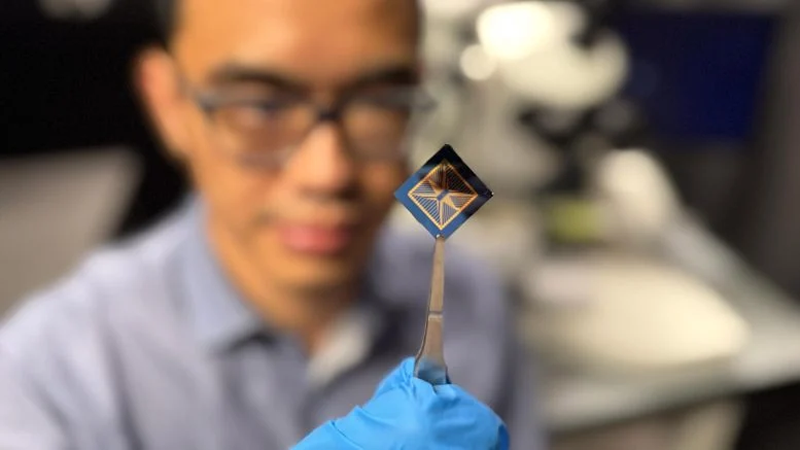

Исследователи пока не смогли создать сферические мушиные глаза, но даже упрощённый глаз на плоской подложке впечатляет миниатюрными размерами и возможностями. Это платформа размером всего 1,5 × 1,5 мм. По сути, это габариты насекомого, что приближает появление миниатюрных дронов размером с таракана или даже муху. Современные устройства машинного зрения намного крупнее, сложнее и требуют значительной энергии и вычислительных ресурсов, от чего китайская разработка ушла довольно далеко.

Источник изображения: Nature Communications 2026 Более того, этот миниатюрный датчик содержит сенсоры ряда опасных газов, которые искусственный глаз распознаёт автоматически. Даже мухи на такое не способны — их глаза лишены обоняния. Комбинация зрения и обоняния на одном компактном сенсоре — это шаг на пути повышения энергоэффективности миниатюрных роботизированных платформ, а также увеличения скорости их реагирования на окружающую обстановку. Отвечающая за зрение часть датчика состоит из 1027 элементов с микролинзами, напечатанными непосредственно на гибком фотодетекторе с помощью фемтосекундной лазерной двухфотонной полимеризации (FL-TPP). Это делает каждый оптический элемент изолированным от других, обеспечивая поле зрения шириной 180°. Слияние вспышек света для датчика начинается с частоты выше 1 кГц — это почти на два порядка больше, чем у человеческого глаза. Тем самым искусственный мушиный глаз различает намного более быстрые движения. Обонятельная компонента реализована методом струйной печати на той же платформе: массив колориметрических сенсоров меняет цвет при контакте с опасными газами и химикатами, имитируя «нюх» насекомого. Дополнительно между линзами добавлены щетинки, как у настоящих насекомых, что необходимо для защиты от запотевания во влажной среде. Щетинки удержат капельки влаги на себе и не дадут им затянуть линзы. В тестах датчика на миниатюрном четырёхколёсном роботе система продемонстрировала высокую чувствительность при сближении с препятствиями и движущимися помехами без необходимости поворота «головы» благодаря панорамному обзору. Робот одновременно обнаруживал препятствия слева и справа, а также реагировал на утечки опасных газов. Устройство показало отличную производительность в обнаружении быстрых движений и химических угроз, превзойдя многие существующие сенсоры по компактности и энергоэффективности. Разработка открывает новые возможности для навигации беспилотных платформ, включая микродроны и рои роботов, в сложных условиях — например, при поиске выживших в завалах или мониторинге химических утечек в зонах катастроф. Такой датчик может значительно повысить «интеллект» биороботов за счёт одновременного визуально-обонятельного восприятия при минимальной массе и энергозатратах, обеспечивая важный шаг в направлении автономных систем следующего поколения. Румынский стартап создал ИИ-очки с технологиями автопилота — они предназначены для незрячих и слабовидящих людей

15.01.2026 [07:14],

Владимир Фетисов

Румынский стартап .lumen показал на прошедшей недавно выставке CES 2026 весьма любопытную новинку. Речь об ИИ-очках с технологиями автопилота, которые помогают ориентироваться в пространстве полностью незрячим и слабовидящим людям. Модель первого поколения собрала 1500 предзаказов на сумму около $10 млн, но стартап уже ведёт разработку устройства следующего поколения.

Источник изображения: EE Times / YouTube Устройство .lumen имеет два важных аспекта. Первый заключается в том, что используемая в очках технология имеет некоторые сходства и различия с комплексами ADAS (продвинутые системы помощи водителю) для автомобилей. Второй аспект связан с тем, что устройство способно значительно повысить мобильность незрячих и людей с нарушениями зрения после непродолжительного использования, необходимого для того, чтобы пользователь научился интерпретировать посылаемые очками тактильные сигналы. Основатель и генеральный директор .lumen Корнел Амариэй (Cornel Amariei) в прошлом работал над автономными транспортными системами в компании Continental, но в 2020 году принял решение запустить собственный проект, чтобы создать устройство, полезное для незрячих и слабовидящих людей. Недавно он дал небольшое интервью, в котором рассказал о собственной мотивации для создания этого устройства, а также уроках, которые смог извлечь из разработки систем ADAS для автомобилей. Амариэй рассказал, что используемый в системах автономного вождения подход, опирающийся на использование предопределённых карт и дорог с чёткими границами, неприменим для пешеходов. Вместо этого компания использует функцию стереозрения в сочетании с нейросетями для непрерывного определения местоположения пользователя и анализа поверхности под его ногами. Это необходимо для того, чтобы гарантировать, что человек не выйдет, например, на поверхность озера только потому, что она выглядит ровной. Ещё Амариэй рассказал о достигнутом прогрессе, финансировании и собственном видении будущего стартапа. Он также не исключил, что очки компании найдут применение в других сферах, например, в робототехнике. Учёные измерили предел разрешения глаза и объяснили, есть ли смысл в 8K-телевизорах

27.10.2025 [19:49],

Сергей Сурабекянц

Учёные из Кембриджского университета и Meta✴✴ Reality Labs измерили предел разрешения человеческого глаза и составили список рекомендаций для владельцев телевизоров. Они попытались выяснить, в каких ситуациях имеет смысл приобретать телевизор высокой чёткости, в каких случаях хватит разрешения 4K, а где необходимо 8K.

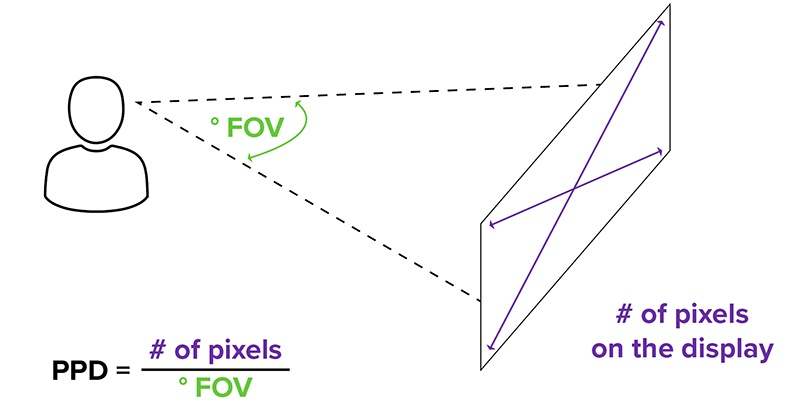

Источник изображения: Samsung Чтобы определить предел разрешения человеческого глаза, исследователи измеряли способность участников различать определённые детали на цветных и серых изображениях в зависимости от расстояния до экрана. При превышении предела разрешения увеличение числа пикселей на панели телевизора не имеет смысла, так как изображение содержит больше информации, чем может воспринять человеческий глаз. «Поскольку значительные инженерные усилия направлены на улучшение разрешения мобильных устройств, устройств дополненной и виртуальной реальности (AR и VR), важно знать максимальное разрешение, при котором дальнейшие улучшения не дают заметного эффекта, — считает руководитель исследования доктор Малиха Ашраф (Maliha Ashraf). — Однако не проводилось исследований, которые бы фактически измеряли то, что видит человеческий глаз, и каковы ограничения его восприятия». Исследователи создали экспериментальную установку, которая позволила им точно измерить то, что видит человеческий глаз, глядя на узоры на экране. Вместо измерения характеристик конкретного экрана они измеряли количество отдельных пикселей, помещающихся в один градус поля зрения (PPD). Этот параметр вместо ответа на вопрос «какое разрешение у этого экрана?» отвечает на вопрос «как выглядит этот экран с моего места?».

Источник изображения: holographica.space Участники исследования рассматривали чёрно-белые и цветные узоры с очень мелкими деталями и градациями цветов. Экран перемещали к зрителю и от него для измерения PPD на разных расстояниях. PPD также измеряли для центрального и периферического зрения.

Источник изображения: freepik.com Широко принятый стандарт проверки зрения, основанный на таблице Снеллена (российский аналог — таблица Головина-Сивцева), предполагает, что человеческий глаз способен различать детали с разрешением 60 пикселей на градус. «Этот показатель широко принят, но никто не измерял его на современных дисплеях, а не на настенной таблице с буквами, которая была впервые разработана в XIX веке», — отметила Ашраф.

Источник изображения: glazexpert.ru Исследователи обнаружили, что предел разрешения глаза выше, чем считалось ранее, но существуют важные различия между цветными и черно-белыми изображениями. Для серых изображений, рассматриваемых под прямым углом, средний показатель составил 94 PPD. Для красных и зелёных узоров этот показатель составил 89 PPD, а для жёлтого и фиолетового — 53 PPD. «Наш мозг на самом деле не очень хорошо воспринимает детали в цвете, поэтому мы наблюдали значительное снижение разрешения для цветных изображений, особенно при просмотре периферическим зрением, — пояснил профессор кафедры компьютерных наук и технологий Кембриджа Рафал Мантюк (Mantiuk). — Наши глаза, по сути, являются сенсорами, которые не так уж хороши, но наш мозг обрабатывает эти данные, формируя то, что, по его мнению, мы должны видеть». Точный предел разрешения зависит от ряда факторов, включая размер экрана, освещённость помещения и расстояние между зрителем и экраном. К примеру, исследователи выяснили, что для гостиной среднего размера в Великобритании, где расстояние между телевизором и диваном составляет 2,5 метра, 44-дюймовый телевизор с разрешением 4K или 8K не даст никаких дополнительных преимуществ по сравнению с 2K-телевизором того же размера.

Источник изображения: LG Исследователи создали статистическую модель, которая демонстрирует процентное соотношение людей с разным пределом разрешения глаз. Они уверены, что это поможет производителям создавать устройства, которые будут актуальны для большинства населения. Учёные также разработали бесплатный онлайн-калькулятор, где пользователи могут ввести размер своей комнаты, а также габариты и разрешение своего телевизора, чтобы определить наиболее подходящий экран для своего дома. Результаты исследования опубликованы в журнале Nature Communications. «Чем больше пикселей на дисплее, тем менее он эффективен, дороже стоит и требует большей вычислительной мощности для управления, — добавил Мантюк. — Поэтому мы хотели понять, при каком уровне разрешения дисплея дальнейшее повышение уже не имеет смысла». Учёные создали кибер-глаз, частично возвращающий зрение слепым людям

20.10.2025 [23:59],

Анжелла Марина

Исследователи разработали глазной имплантат, который частично восстанавливает центральное зрение, необходимое для чтения и других повседневных задач, у незрячих пациентов. Исследование, опубликованное в New England Journal of Medicine, показало, что устройство, основанное на беспроводной ретинальной технологии и внешней камере, помогло большинству участников эксперимента с запущенной возрастной макулодистрофией (ВМД) достичь клинически значимых улучшений.

Источник изображения: UPMC, ft.com Имплантат размером 2 × 2 мм вживляется в сетчатку и преобразует световые сигналы, поступающие с камеры, закреплённой на специальных очках, в электрические импульсы, которые передаются в мозг. Как сообщает Financial Times, в исследовании приняли участие 32 пациента с географической атрофией (ГА) — наиболее тяжёлой формой ВМД, приводящей к необратимой потере центрального зрения. У 81 % из них зафиксировано улучшение зрения на уровне, достаточном для выполнения повседневных задач, таких как чтение текста или распознавание лиц. В среднем участники смогли прочитать на 25 букв (примерно пять строк) больше по стандартной офтальмологической таблице, а один пациент улучшил результат на 59 букв (почти 12 строк). Франк Хольц (Frank Holz), ведущий автор исследования и заведующий кафедрой офтальмологии Университетской клиники Бонна, отметил, что впервые удалось восстановить функциональное центральное зрение у пациентов, ослепших из-за географической атрофии, и назвал технологию парадигмальным сдвигом в лечении поздних стадий ВМД. Жозе-Ален Саэль (José-Alain Sahel), старший автор работы и заведующий кафедрой офтальмологии Медицинской школы Университета Питтсбурга, подчеркнул, что ни одна из предыдущих попыток восстановления зрения не достигала подобных результатов у такого количества пациентов. Разработка основана на проекте Даниэля Паланкера (Daniel Palanker), профессора офтальмологии Стэнфордского университета. Устройство производится американской компанией Science Corporation, которая уже подала заявки на получение разрешения на клиническое применение в США и Европе. По словам представителей компании, окончательная стоимость имплантата и хирургической процедуры пока не определена и будет зависеть от переговоров с государственными и частными заказчиками. TCL представила смартфон с режимом снижения зависимости от гаджетов у детей

04.09.2025 [18:27],

Сергей Сурабекянц

TCL уже много лет выпускает смартфоны с фирменными дисплеями Nxtpaper, предлагающими специальный «бумажный режим», вдохновлённый технологией E Ink. Недавно компания решила расширить свою целевую аудиторию за счёт родителей, обеспокоенных «зависанием» детей в гаджетах. TCL представила детский смартфон Nxtpaper 5G Junior, который позиционируется, как безвредное для глаз устройство с возможностью переключения в монохромный режим.

Источник изображений: TCL Ключевым преимуществом новинки является специальная кнопка активации режима Max Ink, которая переключает матовый дисплей в монохромный режим, более комфортный для чтения. По утверждению производителя, такой режим меньше вредит детским глазам, мало подходит для игр и продлевает время работы устройства от аккумулятора. Телефон также оснащён различными функциями родительского контроля на базе Family Link от Google и режимом «Цифровой детокс» для поощрения разумного использования телефона. TCL также создала ряд милых персонажей под названием «Отряд гениев искусственного интеллекта», которые выглядят так, будто сошли со страниц среднестатистического мультфильма студии Pixar.  Главным препятствием для использования детьми является довольно большой размер смартфона. С 6,7-дюймовым экраном и комплектным чехлом устройство может оказаться неудобным для маленьких рук. Смартфон оснащён встроенным накопителем ёмкостью 256 Гбайт памяти и двумя тыловыми камерами. Другие характеристики устройства пока не обнародованы. Смартфон поступит в продажу в декабре по цене $250. Сегодня TCL выпускает недавно анонсированный Nxtpaper 60 Ultra — первый смартфон с новейшей технологией Nxtpaper 4.0, предназначенной для снижения бликов и мерцания. Устройство получило 7,2-дюймовый дисплей, тройную тыловую камеру и опциональную поддержку стилуса. Смартфон поступит в продажу в Европе уже сегодня по цене от €449 евро. Учёные заставили ИИ видеть то, чего нет — машинное зрение оказалось уязвимым

03.07.2025 [19:19],

Сергей Сурабекянц

Исследователи из университета Северной Каролины продемонстрировали новый способ атаки на системы компьютерного зрения, позволяющий контролировать то, что «увидит» искусственный интеллект. Использованный метод под названием RisingAttacK оказался эффективным для манипулирования всеми наиболее широко используемыми системами компьютерного зрения.

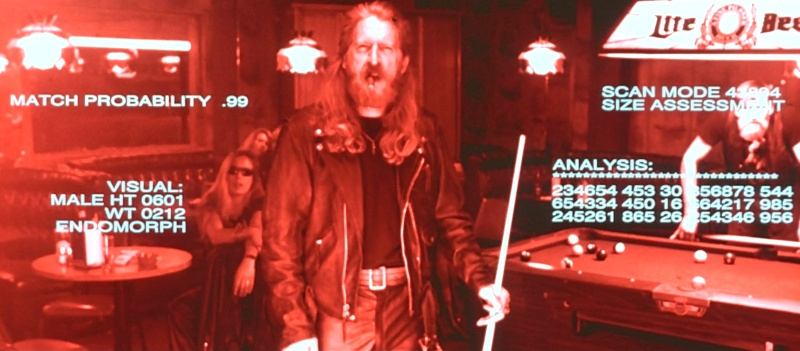

Источник изображения: unsplash.com RisingAttacK — это так называемая «состязательная атака» (adversarial attack), которая манипулирует данными, подаваемыми в систему ИИ. RisingAttacK состоит из серии операций, целью которых является внесение минимального количества изменений в изображение, которое позволит сбить с толку когнитивные способности ИИ. В результате ИИ может неправильно определить цвет светофора или поставить ошибочный диагноз по рентгеновскому снимку. Сначала RisingAttacK идентифицирует все визуальные особенности изображения и пытается определить, какая из них наиболее важна для достижения цели атаки. Затем RisingAttacK вычисляет, насколько чувствительна система ИИ к изменениям найденных ключевых особенностей. «Это требует некоторой вычислительной мощности, но позволяет нам вносить очень небольшие целенаправленные изменения в ключевые особенности, что делает атаку успешной, — рассказал доцент кафедры электротехники и вычислительной техники университета Северной Каролины Тяньфу Ву (Tianfu Wu). — В результате два изображения могут выглядеть одинаково для человеческого глаза, и мы можем чётко видеть машину на обоих изображениях. Но из-за RisingAttacK ИИ увидит машину на первом изображении, но не увидит на втором».

Источник изображений: Tri-Star Pictures Исследователи протестировали метод RisingAttacK против четырёх наиболее часто используемых программ компьютерного зрения: ResNet-50, DenseNet-121, ViTB и DEiT-B. Метод оказался эффективным при манипулировании всеми четырьмя программами. «Мы хотели найти эффективный способ взлома систем машинного зрения с ИИ, потому что эти системы часто используются в контекстах, которые могут повлиять на здоровье и безопасность человека — от автономных транспортных средств до медицинских технологий и приложений безопасности, — пояснил Ву. — Выявление уязвимостей является важным шагом в обеспечении безопасности этих систем».  «Хотя мы продемонстрировали способность RisingAttacK манипулировать моделями зрения, сейчас мы находимся в процессе определения того, насколько эффективен этот метод при атаке на другие системы искусственного интеллекта, такие как большие языковые модели. В дальнейшем наша цель состоит в разработке методов, которые могут успешно защищать от таких атак», — заключил он. Исследовательская группа сделала код RisingAttacK общедоступным для изучения и тестирования. Мозговой имплант Neuralink позволил обезьяне увидеть несуществующий предмет

14.06.2025 [06:49],

Алексей Разин

Идея создания интерфейса между мозгом человека и компьютером не является для стартапа Neuralink Илона Маска (Elon Musk) единственным направлением разработок в сфере мозговых имплантов. Устройство Blindsight призвано вернуть способность видеть незрячим пациентам, и недавно в ходе испытаний на обезьяне представителям компании удалось добиться определённого успеха.

Источник изображения: Neuralink Выступая на конференции в пятницу, инженер Neuralink Джозеф О’Доэрти (Joseph O’Doherty) рассказал о том, что ему и его коллегам удалось оказать стимулирующее воздействие на мозг обезьяны с вживлённым имплантом Blindsight, вызвав у неё своего рода зрительную галлюцинацию. Как считают авторы эксперимента, по меньшей мере две трети времени животное могло видеть некий предмет, которого в реальности не существовало. Об этом они могли судить по движению глаз подопытной обезьяны. Neuralink впервые открыто говорит о своих тестах импланта Blindsight. О клинических испытаниях с привлечением людей пока говорить преждевременно, поскольку в США это устройство не получило соответствующих одобрений со стороны регулирующих органов. Илон Маск ранее заявлял, что возвращение людям зрения является лишь базовой задачей проекта Blindsight, в идеале стартап хотел бы развить этот канал восприятия человеком действительности до пределов, не предусмотренных природой. Например, такие импланты могут наделить человека способность видеть в инфракрасном спектре. В марте он признался, что испытания Blindsight на обезьянах проводятся уже несколько лет, но вживить имплант первому человеку компания надеется до конца текущего года. Попутно инженер Neuralink поведал о прогрессе в испытаниях первой модели импланта, который позволяет транслировать нервные импульсы в компьютерные команды. На данный момент имплантом пользуются пять пациентов с той или иной формой паралича конечностей или мышц. Отдельные участники клинических испытаний пользуются возможностями импланта по 60 часов в неделю. Представитель Neuralink на конференции рассказал об экспериментах компании, в ходе которых имплант использовался для стимуляции мышечных сокращений обезьяны через головной мозг. В перспективе, подобная технология позволит вернуть подвижность парализованным пациентам без необходимости использования протезов или экзоскелета. В отношении дальнейших перспектив развития Blindsight было сказано, что стартап планирует использовать в сочетании с мозговым имплантом пару специальных очков, которые позволят вернуть зрение лишившимся его людям. Отвечающая за зрение часть головного мозга обезьяны расположена ближе к его поверхности, чем у человека, и это упрощает тестирование чипа на данном этапе. В случае с человеческим мозгом электроды импланта будут размещаться в более глубоких областях при помощи хирургического робота, разработанного Neuralink. Учёные вернули зрение слепым мышам с помощью теллура — и открыли путь к «сверхзрению» для человека

10.06.2025 [11:34],

Геннадий Детинич

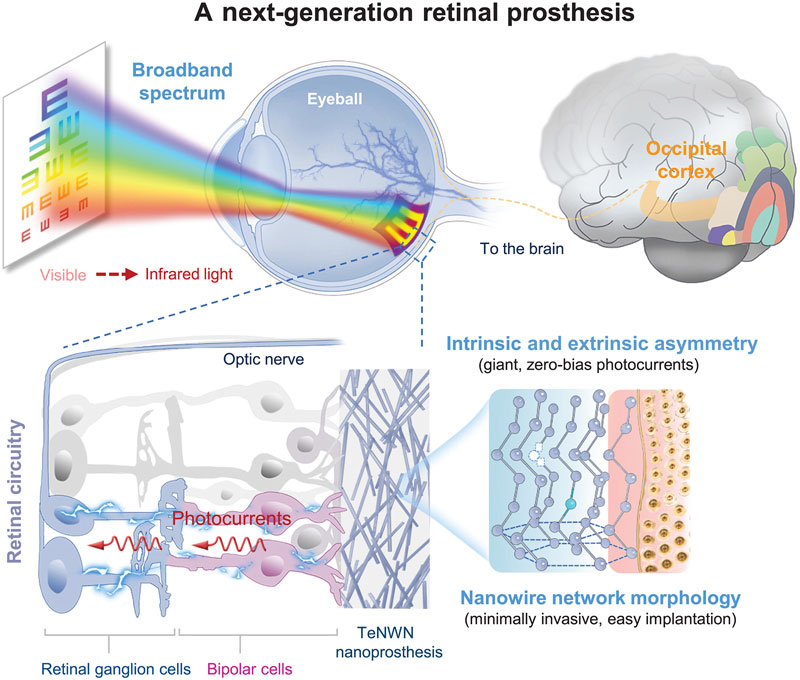

В одном из майских номеров журнала Science учёные из Университета Фудань (Fudan University) в Шанхае сообщили о прорыве в лечении врождённой слепоты. Исследования проводились на животных — мышах и приматах (но не на людях). Довольно простая имплантация нанопроволоки из теллура в область сетчатки глаза позволила животным реагировать на свет и различать объекты. Более того, мыши смогли видеть инфракрасный свет — способность, отсутствующую в природе.

Источник изображения: ИИ-генерация Grok 3/3DNews Учёные из Китая давно работают над благородной задачей — возвращением зрения людям, страдающим слепотой. Новые технологии приближают этот момент. Не исключено, что ключевую роль в этом сыграет теллур — редкий металл, в основном добываемый как побочный продукт очистки меди. Теллур давно используется в фотоэлектрических и термоэлектрических технологиях — он способен преобразовывать фотоны видимого и инфракрасного спектра в электрический ток. Примерно так же он функционирует и в сетчатке глаза: электроны, выбиваемые фотонами из теллура, возбуждают нервные окончания, что стимулирует передачу сигнала в зрительный центр мозга. Нанопроволоку из теллура учёные создавали методом химического осаждения. Её диаметр составил около 150 нм. В процессе была выращена сеть из нанопроволоки, которую затем имплантировали в глазное яблоко мышам и макакам. Сеть не вызвала биологического отторжения. На начальном этапе экспериментов имплантат продемонстрировал восстановление зрачкового рефлекса (реакции на свет) и способность передавать сигналы в головной мозг.

Источник изображения: Science 2025 Последующие эксперименты показали, что слепые мыши с имплантатом научились не только реагировать на световое раздражение, но и различать отдельные предметы. Самым удивительным стало то, что животные смогли видеть в ближнем инфракрасном диапазоне. Будет ли когда-нибудь такое зрение доступно человеку — вопрос открытый. Однако военные и спецслужбы наверняка заинтересуются этим направлением. И даже если подобные технологии не выйдут за пределы лабораторий, сам факт появления надежды вернуть зрение миллионам людей по всему миру стоит всех затраченных усилий. Figure похвалилась успехами человекоподобного робота Helix на работе, но посылки продолжают летать по складу

09.06.2025 [19:26],

Сергей Сурабекянц

Три месяца назад робототехнический стартап Figure «устроил на работу» в почтовое отделение своего передового гуманоидного робота Helix. Сегодня представители компании подробно рассказали о накопленном за это время опыте и успехах робота в сортировке посылок. Однако при просмотре опубликованного компанией почти часового видеоролика мы заметили множество ошибок, совершаемых Helix. Пожалуй, свои посылки мы ему пока доверить не готовы.

Источник изображений: Figure «Теперь Helix может обрабатывать более широкий спектр упаковок и приближается к ловкости и скорости человеческого уровня, приближая нас к полностью автономной сортировке посылок. Этот быстрый прогресс подчёркивает масштабируемость основанного на обучении подхода Helix к робототехнике, который быстро переносится в реальное применение», — так оценил успехи робота представитель Figure. По его словам, за счёт масштабирования данных и усовершенствования архитектуры возможности Helix существенно повысились:

Помимо стандартных жёстких коробок система теперь обрабатывает полиэтиленовые пакеты, мягкие конверты и другие деформируемые или тонкие посылки. Эти предметы могут складываться, мяться или изгибаться, что затрудняет захват и распознавание этикеток. Helix решает эту задачу, корректируя стратегию захвата на лету — например, отбрасывая мягкий пакет для его динамического переворота или используя специальные захваты для плоских почтовых отправлений. Робот должен поворачивать упаковку штрих-кодом вниз для сканирования. Helix старается расправить пластиковую упаковку, чтобы сканер смог успешно считать штрих-код. Такое адаптивное поведение подчёркивает преимущества сквозного обучения — робот выполняет действия, которые не были жёстко запрограммированы, чтобы компенсировать несовершенства упаковки. Многие достижения стали возможны благодаря целенаправленным улучшениям визуально-моторной политики робота. Он получил новые модули памяти и машинного зрения, что позволило ему лучше воспринимать состояние окружающей среды и быстро адаптироваться к изменениям ситуации. Helix оснащён модулем неявной визуальной памяти, который обеспечивает поведение с учётом текущего состояния — робот запоминает, какие стороны упаковки он уже осмотрел, либо какие зоны конвейера свободны. Модуль памяти помогает устранять избыточные движения, давая Helix ощущение временного контекста и позволяя ему действовать более стратегически при выполнении многошаговых манипуляций. Отслеживание истории недавних состояний позволяет роботу осуществлять более быстрое и реактивное управление. В результате ускоряется реакция на неожиданности и помехи: если пакет смещается или попытка захвата оказывается неудачной, Helix корректирует движение «на лету». Это значительно сократило время обработки каждого пакета. Helix использует аналог человеческого осязания благодаря интегрированной обратной связи по усилию. Робот способен определить момент соприкосновения с объектом и использовать это для модуляции движения, например, приостанавливая опускание при контакте с конвейерной лентой. Хотя основной задачей Helix в логистическом сценарии является автономная сортировка, он легко адаптируется к новым взаимодействиям. Например, протянутая к нему рука человека интерпретируется как сигнал к передаче предмета: робот отдаёт посылку, а не размещает её на конвейере — подобное поведение заранее явно не программировалось, система самостоятельно обучилась ему.  «Helix неуклонно масштабируется в плане ловкости и надёжности, сокращая разрыв между освоенными роботизированными манипуляциями и требованиями реальных задач. Мы продолжим расширять набор навыков и обеспечивать стабильность на ещё больших скоростях и рабочих нагрузках», — заявил представитель Figure. В реальности всё далеко не так радужно, как описывают маркетологи Figure — по следующим ссылкам можно увидеть, что робот совершает много ошибок, путается, роняет посылки и порой откровенно зависает. Так что какое-то время «кожаные мешки» на этой работе ещё будут востребованы. Но, учитывая нынешние темпы развития робототехники и бум искусственного интеллекта, почтовым служащим пора подумать о смене профессии. В Австралии создали электронный компьютерный глаз, который работает подобно человеческому и даже лучше

17.05.2025 [13:23],

Геннадий Детинич

Сегодня компьютерное зрение строится на датчиках изображения и сложных алгоритмах для обработки собираемой ими информации. Зрение человека устроено иначе — оно ориентировано на энергетическую эффективность, что полезно перенести в сферу электроники. Это не прихоть, а насущная необходимость экономии ресурсов. Учёные из Австралии создали прототип электронного глаза, который работает подобно человеческому, и даже может сам обрабатывать увиденное.

Источник изображения: RMIT Разработка относится к разряду нейроморфных вычислений. Она является аналоговой, а не цифровой. Обычное цифровое компьютерное зрение делает снимки кадр за кадром и затем обрабатывает их с помощью алгоритмов распознавания, затрачивая на процесс большое количество вычислительных ресурсов и энергии. Глаз и нервная система человека (мозг) отслеживают движение в поле зрения, прежде всего оценивая контуры и траекторию перемещения объектов. Это позволяет практически мгновенно оценивать ситуацию и действовать по обстоятельствам. Такое умение стало бы ценным подспорьем для роботов и автопилотов транспортных средств. Работа учёных из Университета RMIT (Royal Melbourne Institute of Technology) позволила сделать шаг в этом направлении. Исследователи воспользовались свойствами атомарно тонкого материала — дисульфида молибдена (MoS₂), способного образовывать дефекты в атомной структуре. Эти дефекты откликались на свет электрическим сигналом — подобно реакции нейронов в сетчатке глаза. Более того, заряд некоторое время сохранялся и мог участвовать в первичной обработке изображения прямо на месте — в самом чипе, имитирующем одновременно и глаз, и мозг. Проведённые исследования доказали, что материал вёл себя подобно базовым узлам LIF-нейронной спайковой сети (leaky integrate-and-fire, или, по-русски, «с утечкой, интеграцией и возбуждением»). На взмахи руки перед ним экспериментальный чип реагировал подобно человеческой системе глаз—мозг. Для восприятия происходящего аналоговому кристаллу не требовались процессор и интерпретация сцены. В дальнейшем учёные намерены создать чип с увеличенным разрешением, однако они считают, что разработка станет дополнением к обычному цифровому зрению, а не его заменой — по крайней мере, в краткосрочной и среднесрочной перспективе. Человекоподобные роботы Boston Dynamics Atlas получат «зрение» от LG

13.05.2025 [09:49],

Алексей Разин

Многие участники рынка компонентов для смартфонов не против добавить своему бизнесу динамики за счёт переключения на более активно растущие направления. LG Innotek в этом смысле рассчитывает на контракты с производителем человекоподобных роботов Boston Dynamics, которые обретут систему зрения на основе компонентов этого поставщика.

Источник изображения: Boston Dynamics О достигнутой между компаниями договорённости сообщает издание Business Korea. Речь идёт о следующем поколении человекоподобных роботов Atlas американской компании Boston Dynamics, которая принадлежит корейскому холдингу Hyundai Motor Group. С последним у LG Innotek уже сложились взаимовыгодные отношения, поскольку последняя из компаний снабжает автопроизводителя светотехникой для транспортных средств и прочими электронными системами. LG Innotek и Boston Dynamics будут совместно разрабатывать систему машинного зрения для человекоподобных роботов Atlas следующего поколения. Первая будет отвечать за поставку датчиков камер, позволяющих чётко определять взаимное расположение снимаемых объектов даже в условиях ограниченной видимости, а вторая займётся разработкой сопутствующего программного обеспечения. Если учесть, что Hyundai намеревается десятками тысяч использовать роботов Boston Dynamics на своих автосборочных предприятиях, то соответствующий контракт с LG Innotek обещает быть выгодным. Учёные предложили буквально пускать золотую пыль в глаза для лечения возрастной слепоты

23.04.2025 [22:34],

Геннадий Детинич

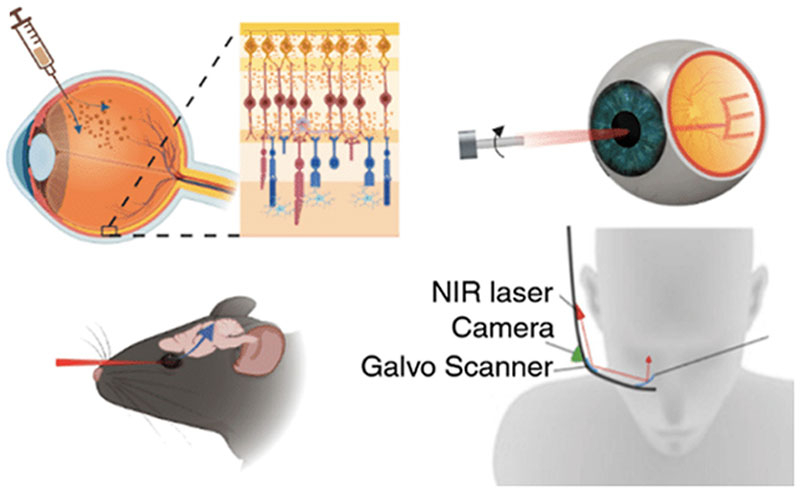

Медицина глаза готова выйти на новый уровень. Ряд дегенеративных заболеваний сетчатки, включая возрастные изменения, предложено лечить с минимальным хирургическим вмешательством. Это достигается сравнительно простой инъекцией в глаз золотой пыли, которая затем возбуждается инфракрасным лазером и стимулирует нейроны под сетчаткой. Опыты на мышах показали обнадёживающие результаты — животные начинали видеть после слепоты.

Источник изображения: ИИ-генерация Grok 3/3DNews Исследование провела группа учёных из Университета Брауна (Brown University) в Род-Айленде, США. Они искали возможность относительно простого восстановления зрения после возрастного или травматического поражения сетчатки. Альтернативой остаются серьёзные, но не гарантирующие успех методы лечения, а также различные имплантаты и интенсивная подсветка, которые могут окончательно уничтожить остатки зрения. Предложенное учёными решение отчасти уже используется и представляет собой термостимуляцию нейронов непосредственно под сетчаткой. Визуальный сигнал минует повреждённые фоторецепторы и воздействует напрямую на нейроны, которые, в свою очередь, передают информацию в головной мозг.

Источник изображения: ACS Nano 2025 Для этого в стекловидное тело глаз между хрусталиком и сетчаткой — фактически в гель — методом инъекции вводится золотая пыль нанометрового размера. Каждая пылинка покрыта антителами к белку Thy1. Это необходимо для взаимодействия золотых частиц с клеточными мембранами нейронов. Затем в глаз направляется луч лазера в ближнем инфракрасном диапазоне, который формирует изображение, непосредственно возбуждая нейроны под сетчаткой за счёт нагрева золотых частиц. Передавать изображение может встроенная в умные очки камера. Эксперимент с полуслепыми мышами с искусственно повреждённой сетчаткой показал, что предложенный метод позволил восстановить зрение. Насколько хорошо оно восстановилось — мыши не расскажут, но результаты внушают оптимизм. Для проверки методики на людях предстоит пройти долгий путь, чтобы избежать возможного вреда. В случае успеха технология сможет вернуть зрение миллионам пожилых людей — просто и безболезненно. От Intel отделился производитель систем машинного зрения RealSense

13.01.2025 [17:47],

Сергей Сурабекянц

В первой половине 2025 года Intel выделит инновационного производителя систем машинного зрения RealSense в независимую компанию, после чего она войдёт в инвестиционный портфель Intel Capital. Новая компания продолжит разрабатывать решения для компьютерного зрения на базе ИИ и представлять текущее портфолио Intel RealSense, включая камеры глубины RealSense, решения для аутентификации лиц, автономные мобильные роботизированные решения и приборы физиотерапии.

Источник изображений: Intel RealSense Intel утверждает, что выделение RealSense не является результатом недавних финансовых трудностей компании: «Мы верим в ценность RealSense и уверены в её успехе как самостоятельной компании. Это решение соответствует нашей текущей трансформации и поможет нам в дальнейшем соответствовать нашей стратегической цели — сосредоточиться на наших основных видах деятельности». Новая компания продолжит разрабатывать решения для компьютерного зрения на базе ИИ и представлять текущее портфолио Intel RealSense, включая камеры глубины RealSense, решения для аутентификации лиц, автономные мобильные роботизированные решения и приборы для физиотерапии. Также RealSense планирует расширить свою дорожную карту, добавив инновации в области стереозрения, робототехники, биометрического программного обеспечения и оборудования ИИ.  RealSense всегда была небольшой частью бизнеса Intel. Безусловно, благодаря работе в экосистеме технологического гиганта, компания гарантировала себе финансовую стабильность, возможность серьёзной научной деятельности и доступ к обширным ресурсам Intel, в том числе к масштабной сети отраслевых партнёров. Intel начала производить решения для компьютерного зрения в рамках своего подразделения Perceptual Computing в 2013 году. В 2014 году это подразделение было переименовано в Intel RealSense. Камеры машинного зрения Intel RealSense являются популярным выбором для разработчиков мобильных и промышленных роботов. К примеру, четвероногий робот ANYmal от ANYbotics оснащён шестью модулями Intel RealSense D435, которые работают вместе, создавая карту высот, помогающую роботу перемещаться по участку и преодолевать препятствия, включая подъем по лестнице.  Это далеко не первый случай резкого изменения политики Intel. Ранее, в августе 2021 года, Intel уже объявляла о закрытии RealSense, однако затем сменила курс, решив сохранить RealSense, но с сокращённым составом. В 2022 году Intel избавилась от компании-разработчика автономных транспортных средств Mobileye, которую приобрела в 2017 году за $15,3 млрд. «Intel инкубирует передовые, прорывные технологии и бизнесы для проверки потребностей клиентов и принятия рынком. На определённом уровне масштаба для этих бизнесов имеет смысл работать за пределами Intel, с гибкостью, чтобы работать так, как требует рынок, и возможностью инвестировать в ключевые области роста. Это позволяет отделению быстрее принимать решения, иметь большую гибкость решений для клиентов и оставаться гибким на конкурентных рынках» , — заявил представитель Intel. С выделением RealSense в отдельную компанию история этого подразделения принимает ещё один неожиданный поворот. Конечно, RealSense освобождается от приоритетов реструктуризации Intel, но независимость, безусловно, принесёт новые проблемы. Лампа накаливания снова в деле — физики увидели в ней основу мультиспектрального машинного зрения

25.12.2024 [18:46],

Геннадий Детинич

Учёные из Университета штата Мичиган стряхнули пыль с ламп накаливания, увидев в них основу для мультиспектрального машинного зрения. В природе свет несёт гораздо больше информации об окружающих объектах и процессах, чем видит глаз человека. Поэтому машинное зрение не должно уподобляться зрению людей. Оно должно быть шире и глубже воспринимать мир, делая среду обитания для человека безопаснее и комфортнее.

Источник изображения: Brenda Ahearn/Michigan Engineering Солнечный свет не имеет поляризации, он может приобретать её, например, при отражении. Отражение от поверхности воды, например, приобретает линейную поляризацию, что делает поляризованный свет ярче и опаснее для зрения. Солнечные очки с поляризационными стёклами легко компенсируют такие явления. Полезное свойство поляризации заключается в возможности уплотнить канал передачи в оптоволокне. Для этого используют круговую поляризацию. В природе насекомые и некоторые ракообразные видят поляризованный свет, что делает их лучшими собирателями или охотниками. Очевидно, что робототехника и ряд направлений в науке выиграют, если устройства смогут распознавать свет в расширенном спектре, включая разные виды поляризации. Исследователи из Университета Мичигана создали наномасштабный прибор из вольфрамовой нити накаливания, который способен испускать свет с эллиптической поляризацией. Такое явление стало возможным после того, как нить накала изготовили такой длины, которая сравнима с длиной волны света. Эллиптическая поляризация — это предельный случай как круговой, так и линейной поляризации, но он может использоваться как самостоятельный для тех же целей уплотнения трафика в одном и том же оптическом кабеле. В случае машинного зрения использование эллиптической поляризации позволяет повысить контраст изображения, что необходимо для распознавания в тёмное время суток или при плохом освещении. Наконец, благодаря эллиптической поляризации может появиться множество медицинских приборов, которые помогут с визуализацией образцов тканей человека, а также при проведении анализов. В России роботов-собак натравят на нарушителей техники безопасности на стройках и производстве

05.12.2024 [17:51],

Павел Котов

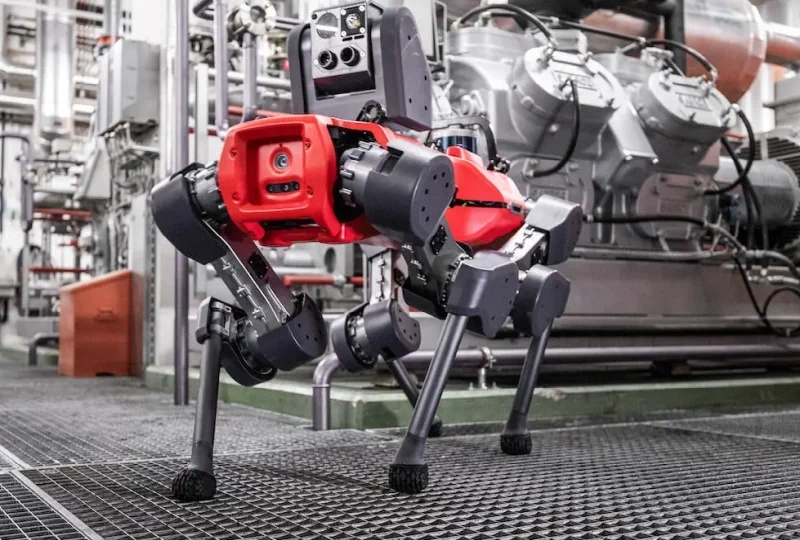

Российская компания VisionLabs и «Лаборатория Новых Продуктов» представила робота-собаку с системой машинного зрения и интеллектуальной видеоаналитики — он способен наблюдать за производственным процессом и следить за соблюдением работниками требований техники безопасности, сообщает «Хабр».

Источник изображения: habr.com Четвероногого робота система компьютерного зрения VisionLabs LUNA, которая в реальном времени фиксирует нарушения техники безопасности, в том числе наличие или отсутствие средств индивидуальной защиты, а также присутствие посторонних на промышленном объекте. Система также идентифицирует заданные сценарии: драки, падение человека, утерянные вещи, а также присутствие человека в опасной зоне. Спутниковая навигация, лидар и автономная система управления позволяют робособаке патрулировать объекты любой сложности, передвигаясь по определённому маршруту — при необходимости оператор может перехватывать управление. Защищённый водо- и пылеустойчивый корпус позволяет машине работать в условиях агрессивной среды. Поддержка автономной навигации означает, что робособака может эксплуатироваться на объектах, где невозможна установка традиционных камер наблюдения. Система компьютерного зрения VisionLabs отличается высокой точностью: отсутствие защитного шлема на человеке она определяет с точностью 99,2 %, жилета — 97,0 %, перчаток — 92,1 %. Обнаружив нарушение, робот докладывает о нём в диспетчерскую, а дежурный может оперативно связаться с сотрудником и попросить это нарушение устранить. На практике система способна снизить число несчастных случаев на объекте, повысить уровень дисциплины и уменьшить нагрузку на службу безопасности. К роботу можно подключить и дополнительные датчики, которые помогут инспектировать состояние оборудования: определять его целостность, измерять температуру и уровень вибрации, снимать показания приборов, а также обнаруживать тепло- и газоутечки. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |