|

Опрос

|

реклама

Быстрый переход

Meta✴ разрешит программистам пользоваться ИИ на собеседованиях

30.07.2025 [13:11],

Владимир Мироненко

Компания Meta✴✴ разрешит некоторым кандидатам использовать искусственный интеллект (ИИ) на собеседованиях по программированию, поскольку это «снижает эффективность мошенничества, связанного с использованием больших языковых моделей (LLM)», пишет ресурс Business Insider.

Источник изображения: Solen Feyissa/unsplash.com В начале этого месяца на внутренней доске объявлений Meta✴✴ появилась публикация «Собеседования с использованием ИИ». В ней сообщалось, что компания «разрабатывает новый тип собеседований по программированию, на которых кандидатам будет доступен ИИ-помощник». Объясняется, что это более точно отражает среду разработчиков, в которой будут работать будущие сотрудники, а также делает мошенничество на основе LLM менее эффективным. Также сообщалось, что Meta✴✴ ищет «подставных кандидатов» среди своих сотрудников для тестирования этого процесса собеседований. «Всё пока находится в стадии разработки; ваши данные помогут сформировать будущее собеседований в Meta✴✴», — говорится в публикации. «Совершенно очевидно, что мы сосредоточены на использовании ИИ, чтобы помочь инженерам в их повседневной работе, поэтому неудивительно, что мы тестируем, как предоставлять эти инструменты кандидатам во время собеседований», — подчеркнул представитель Meta✴✴ в заявлении для Business Insider. Ранее генеральный директор Meta✴✴ Марк Цукерберг (Mark Zuckerberg), говоря о влиянии ИИ на программирование, заявил: «Вероятно, в 2025 году мы как и другие компании, которые работают над этим, получим ИИ, который фактически сможет стать своего рода инженером среднего звена, умеющим писать код». Впрочем, не все компании придерживаются подхода Meta✴✴ к использованию ИИ. Например, в Amazon недавно дали указание внутренним рекрутерам дисквалифицировать кандидатов, если будет установлено, что они использовали ИИ-инструменты на собеседовании. ИИ-стартап Anthropic изначально рекомендовал соискателям не использовать ИИ-помощников при подаче заявлений, хотя впоследствии изменил своё решение. Неожиданный эффект ИИ-бума: прибыль аккумуляторного бизнеса Panasonic взлетела на 47 %

30.07.2025 [12:46],

Алексей Разин

Бурное развитие систем искусственного интеллекта требует адекватной технической инфраструктуры, и помимо собственно средств вычислений, порождает спрос на компоненты энергосистем. Резервное питание занимает в этом перечне не последнее место, о чём свидетельствует выросшая на 47 % прибыль подразделения Panasonic, занимающегося изготовлением аккумуляторов.

Источник изображения: Tesla В целом, этот бизнес Panasonic принято ассоциировать с электромобилями, главным образом марки Tesla, но рынок последних сейчас переживет не лучшие времена, а японскому поставщику удалось увеличить прибыль от реализации аккумуляторов на 47 % до $216 млн по итогам минувшего квартала. Panasonic сама не ожидала, что системы резервного хранения электроэнергии на базе аккумуляторов будут пользоваться подобным спросом. При этом Panasonic не стал повышать прогноз по операционной прибыли в сегменте энергетических систем по итогам всего фискального года, который завершится в марте, сохранив соответствующую сумму на уровне $1,1 млрд. В мае компания заявила, что вынуждена будет сократить 10 000 сотрудников и понести расходы в размере $880 млн, связанные с реструктуризацией, но она не коснётся энергетического бизнеса. На территории США компания производит аккумуляторные ячейки на предприятии в Неваде, которое обслуживает потребности Tesla, а также на недавно построенном заводе в Канзасе. Выпуском систем хранения электроэнергии занимается потребительское подразделение Panasonic. На этой неделе также стало известно о заключении соглашения между Tesla и LG Energy Solution, в рамках которого первая будет закупать у второй LFP-батареи для своих систем хранения электроэнергии. Сумма сделки достигла $4,3 млрд, она подразумевает использование батарей LG, изготовленных на территории США. В электромобилях Tesla они использоваться не будут, хотя на своём китайском предприятии этот автопроизводитель услугами данного поставщика активно пользуется. Соглашение рассчитано на несколько лет и может быть продлено. «Яндекс» раскрыл алгоритм распознавания голосовых команд в шумных условиях

30.07.2025 [12:43],

Павел Котов

Инженеры «Яндекса» опубликовали научную статью, в которой раскрыли принципы работы нейросети, обеспечивающей распознавание голосовых команд в условиях внешнего шума. Компания уже применяет эту технологию, и теперь внедрить её смогут разработчики по всему миру.

Источник изображения: yandex.ru/company Работа будет представлена на международной конференции по речевым технологиям Interspeech, которая пройдёт с 17 по 21 августа в нидерландском Роттердаме; среди прочих участников мероприятия значатся Microsoft, Google DeepMind и Google AR. Разработанная специалистами «Яндекса» технология используется в умных колонках и «ТВ Станциях». Она позволяет устройствам с «Алисой» правильно интерпретировать голосовые команды, если что-то пытается этому помешать: играет музыка, шумит вода, гудит вечеринка, или за окном грохочет стройка — система услышит пользователя, даже если он не будет пытаться перекричать песню или не станет выключать пылесос. Используя эту технологию, любая компания сможет повысить качество работы голосового помощника с искусственным интеллектом и уменьшить долю ложных срабатываний. Если человеческий голос раздаётся на фоне музыки, эффективными считаются алгоритмы эхоподавления; в случае других посторонних источников лучше работает шумоподавление, которое, однако, ухудшает и разборчивость человеческой речи. Поэтому в «Яндексе» разработали attention-механизм на основе нейросетей — на вход ему подаются сразу оба сигнала, с эхо- и шумоподавлением, и система динамически выбирает наиболее чёткий, адаптируясь к звуковому фону от источников разной природы. Meta✴ переманила из Apple уже четвёртого крупного специалиста в сфере ИИ за месяц

30.07.2025 [10:28],

Алексей Разин

Наиболее активным охотником за ценными кадрами в сфере искусственного интеллекта среди техногигантов сейчас является компания Meta✴✴ Platforms. За месяц ей удалось переманить из конкурирующей Apple уже четверых крупных исследователей в данной области, список которых недавно пополнился Боуэном Чжаном (Bowen Zhang).

Источник изображения: Unsplash, Andrea De Santis Как отмечает Bloomberg, на прежнем месте работы в Apple этот специалист занимался мультимодальными языковыми моделями. Чжан уже уволился из Apple в прошлую пятницу, и вскоре должен присоединиться к команде разработчиков ИИ в составе Meta✴✴ Platforms. Ранее он работал над созданием фундаментальных моделей ИИ, на которых основывалась работа всех платформ Apple, связанных с подобными технологиями. По данным Bloomberg, ранее в Meta✴✴ перешёл бывший руководитель Чжана — Руомин Пан (Ruoming Pang), и принятию такого решения могла способствовать стимулирующая выплата в размере $200 млн со стороны нового работодателя. Том Гантер (Tom Gunter) и Марк Ли (Mark Lee), которые также работали в составе теряющей специалистов команды Apple, ранее тоже перешли в Meta✴✴. Коллектив Apple, специализирующийся на фундаментальных решениях в области ИИ, рассредоточен между Калифорнией и Нью-Йорком. Apple пришлось поднять зарплату сохранившимся сотрудникам своего ИИ-подразделения, но она не готова соперничать с теми предложениями, которые поступают от конкурентов. Уход ключевых специалистов уже привёл к растерянности Apple в отношении дальнейшего направления разработок в сфере ИИ. Скорее всего, компании придётся больше полагаться на модели сторонних поставщиков. Руководство Apple не слишком верит в скорый успех собственных разработок в сфере ИИ, что дополнительно подрывает моральный дух специалистов. Meta✴✴ с её щедрыми предложениями в этом отношении без труда заполучает нужные кадры. В сфере развития голосового интерфейса Siri ставка сейчас делается на интеграцию с решениями OpenAI и Anthropic. При этом собственная платформа окончательно не забрасывается, но это лишь добавляет неопределённости в глазах сотрудников Apple. Унаследованная исторически политика в сфере информационной безопасности, кроме того, не позволяет специалистам компании добиваться быстрого прогресса. Упор делается на работу с данными на стороне клиентского устройства, тогда как конкуренты делают ставку на облачную инфраструктуру, которая развивается динамичнее и обладает более серьёзными вычислительными возможностями. Собственная облачная ИИ-модель Apple в разы уступает решениям конкурентов по количеству используемых параметров. OpenAI запустила «режим обучения» в ChatGPT — теперь ИИ не даёт готовых ответов, а помогает думать

30.07.2025 [00:07],

Анжелла Марина

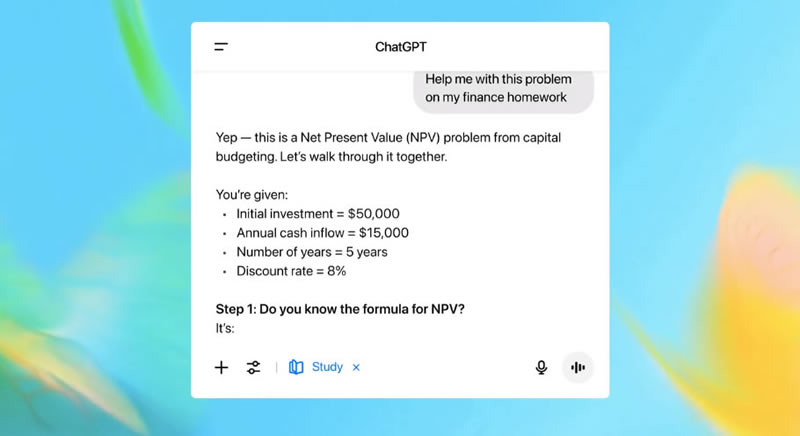

Компания OpenAI представила новый инструмент в ChatGPT — «Режим обучения» (Study Mode), который помогает студентам разбираться в задачах поэтапно, а не выдаёт готовые ответы. Это решение стало ответом на распространённую проблему: многие учащиеся используют ИИ для списывания, избегая самостоятельной работы. В OpenAI заявили, что создали Study Mode как «первый шаг на долгом пути к улучшению обучения в ChatGPT».

Источник изображения: openai.com Вице-президент OpenAI по образованию Лия Белски (Leah Belsky) отметила, что ChatGPT может значительно повысить успеваемость, если применяется как обучающий инструмент, но может и навредить учебному процессу, когда превращается в «машину для генерации ответов». Как пишет CNBC, ссылаясь на данные OpenAI, каждый третий студент студенческого возраста уже использует ChatGPT, поэтому компания разработала Study Mode, ориентированный на эту демографическую группу. Вместо прямых решений ИИ будет предлагать наводящие вопросы, помогая разбираться в домашних заданиях, подготовке к экзаменам и новых темах. Разработка велась совместно с преподавателями, учёными, экспертами в области образования и студентами из ChatGPT Lab — сообщества, где учащиеся делятся опытом использования чат-бота. В основе учебного режима лежат специальные системные инструкции, отражающие базовый набор моделей поведения, способствующих «более глубокому обучению, включая поощрение активного участия, управление когнитивной нагрузкой, проактивное развитие метапознания и саморефлексии, стимулирование любопытства и предоставление действенной и поддерживающей обратной связи». В своём блоге OpenAI продемонстрировала, как студент взаимодействует с новым «режимом обучения»: после отправки вопроса ChatGPT предлагает проработать два этапа решения, а затем сформулировать ответ своими словами.  «Вместо того чтобы делать работу за них, Study Mode побуждает учащихся критически относиться к своему обучению. Подобные функции — важный шаг к эффективному использованию ИИ в образовательной среде. Даже в эпоху ИИ наилучшие результаты достигаются, когда учащиеся с энтузиазмом воспринимают материал урока и активно его изучают», — отметил Робби Торни, старший директор по ИИ-программам в Common Sense Media. Ключевые особенности новой системы основаны на интерактивных подсказках, которые сочетают в себе наводящие вопросы, помогающие лучше понять и усвоить материал, шаблонные ответы, индивидуальную поддержку и проверку знаний. Study Mode можно включать и выключать в ходе беседы, что, по словам OpenAI, даёт студентам гибкость в достижении учебных целей в каждом чате. Начиная с сегодняшнего дня новый режим доступен зарегистрированным пользователям в версиях Free, Plus, Pro и Team, а в ChatGPT Edu он появится в ближайшие несколько недель. Квадриллион токенов за месяц: Google рассказала о нагрузке на свои ИИ-сервисы в июне

29.07.2025 [23:59],

Николай Хижняк

Google сообщила, что её ИИ-сервисы обработали почти квадриллион токенов в июне. Под токенами принято понимать единицы данных, обрабатываемые моделями ИИ во время обучения и генерации, что даёт представление о масштабах использования соответствующих сервисов Google. Токены могут включать текст, изображения, аудиоклипы, видео или другие модальности.

Источник изображения: Google По данным компании OpenAI — конкурента Google в области генеративных ИИ-технологий — один токен обычно эквивалентен четырём символам английского текста, а один абзац содержит в среднем около 100 токенов. Например, текст Декларации независимости США состоит из 1695 токенов. «В прошлом месяце мы обработали почти 1 000 000 000 000 000 токенов, что более чем вдвое больше, чем в мае», — заявил генеральный директор Google DeepMind Демис Хассабис (Demis Hassabis) в социальной сети X. Увеличение числа обработанных токенов не обязательно означает рост количества пользователей ИИ-сервисов, однако определённо указывает на то, что рассуждающие ИИ-модели обрабатывают значительно больше данных за одно использование. Google начала развёртывание семейства моделей логического вывода Gemini 2.5 в конце марта. Рост объёма обрабатываемых токенов требует расширения инфраструктуры центров обработки данных. В этом месяце Google сообщила, что ожидает увеличения капитальных затрат на ЦОДы на $10 млрд — до $85 млрд в год. «В вычислительных технологиях важен объём ресурсов, необходимых для обучения. Часто эти ресурсы нужно размещать в одном месте, поскольку ограничения пропускной способности между дата-центрами могут повлиять на эффективность. Сейчас ИИ-системы интегрируются в продукты, которыми пользуются миллиарды людей по всему миру, и требуют огромных вычислительных мощностей для генерации ответов. Кроме того, новый тренд в ИИ — рассуждающие модели — становится всё более актуальным: такие модели становятся умнее в зависимости от того, сколько времени им даётся на логическое размышление. Всё это требует всё больших ресурсов, и я не вижу признаков замедления в этом направлении. По мере совершенствования ИИ-системы будут становиться более полезными и востребованными», — рассказал в Хассабис ранее в подкасте Лекса Фридмана (Lex Fridman). Runway представила «Photoshop для видео» — ИИ-модель Aleph для быстрого редактирования видео

29.07.2025 [23:37],

Анжелла Марина

Компания Runway представила новую ИИ-модель под названием Aleph, предназначенную для редактирования видео на основе текстовых запросов. Модель позволяет удалять объекты и людей из кадра, изменять элементы сцены, генерировать новые ракурсы и вносить сложные правки в уже существующие или сгенерированные ролики.

Источник изображения: Runway Aleph Как сообщает CNET, разработка основана на исследованиях Runway в области General World Models и Simulation Models и позиционируется компанией как инструмент для «гибкого монтажа», позволяющий быстро и последовательно редактировать видео без нарушения целостности кадров. В отличие от предыдущих моделей, сосредоточенных в основном на генерации видео по тексту, Aleph делает акцент на интерактивном редактировании. Теперь можно добавлять или удалять объекты, изменять освещение, корректировать действия персонажей и сохранять визуальную согласованность между кадрами — то есть выполнять те задачи, которые ранее представляли наибольшую сложность для ИИ. В Runway отметили, что Aleph — это не просто обновление, а новый подход к работе с видео в целом. Модель сочетает генерацию высокого качества с возможностью мгновенного редактирования через диалоговый интерфейс, что может быть востребовано в киноиндустрии, рекламе и других сферах, где важна скорость обработки контента. Интересно, что запуск модели происходит на фоне растущей конкуренции в сфере ИИ-видео. В этом году аналогичные разработки представили OpenAI, Google, Microsoft и Meta✴✴. Однако Runway, известная своими моделями Gen-1 и Gen-2, утверждает, что Aleph выводит технологию на новый уровень. По данным компании, Aleph уже тестируют крупные киностудии, рекламные агентства, архитектурные бюро, игровые компании и команды в сфере электронной коммерции. В настоящее время доступ к модели открыт для корпоративных клиентов и партнёров, а более широкий запуск ожидается в ближайшие дни. ИИ-блокнот NotebookLM от Google научился создавать слайд-шоу с озвучкой

29.07.2025 [22:07],

Анжелла Марина

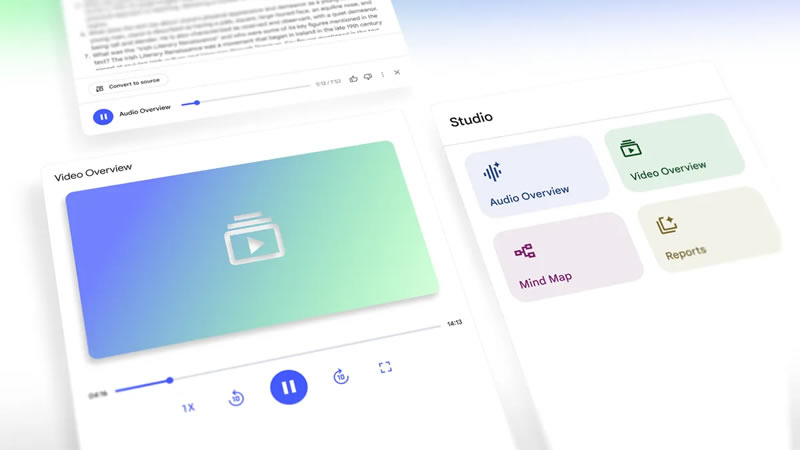

Google добавила в приложение NotebookLM новую функцию «Видеообзоры» (Video Overviews), которая с помощью искусственного интеллекта создаёт слайд-шоу с озвучиванием. Функция уже доступна на английском языке, и, как заявляет компания, в ближайшее время появится поддержка других языков.

Источник изображения: Copilot Как поясняет Google в своём блоге, эта функция станет визуальной альтернативой аудиообзорам. С помощью Video Overviews искусственный интеллект (ИИ) теперь может не только анализировать загруженные документы, но и превращать их содержание в визуальные слайд-шоу с голосовым сопровождением. Происходит это следующим образом: ИИ-хост генерирует иллюстрации, дополняя их реальными цитатами, данными, диаграммами и изображениями из исходных документов пользователя. Как пишет The Verge со ссылкой на компанию, такой подход особенно эффективен при подаче сложных материалов и придании наглядности абстрактным концепциям. Кроме того, в будущем планируется внедрение дополнительных форматов презентаций.

Источник изображения: blog.google Video Overviews поддерживает удобное управление воспроизведением — перемотку на 10 секунд вперёд или назад, а также регулировку скорости воспроизведения. Также появилась возможность сохранять несколько результатов одного типа материалов в рамках одного блокнота. Например, можно создать несколько аудиообзоров на основе одних и тех же исходных файлов. Параллельно Google анонсировала в NotebookLM обновления для вкладки «Студия». Теперь пользователи смогут создавать аудио- и видеообзоры, учебные пособия и аналитические документы. Интерфейс «Студии» также будет обновлён: в верхней части появятся четыре крупные кнопки для быстрого доступа к созданию «Аудиообзоров» (Audio Overviews), «Видеообзоров» (Video Overviews), «Умных карт» (Mind Maps) и «Отчётов» (Reports). Эти изменения, как сообщили в Google, начнут появляться у всех пользователей в течение ближайших нескольких недель. Photoshop получил ИИ-инструмент для быстрого повышения качества старых фотографий

29.07.2025 [19:37],

Сергей Сурабекянц

Adobe представила в последней бета-версии Photoshop серию новых инструментов, которые, по заявлению компании, устранят «утомительные шаги, снизят уровень сложности и сделают точное редактирование более быстрым и интуитивно понятным». Самой востребованной среди пользователей, по словам Adobe, является ИИ-функция Generative Upscale («Генеративное Масштабирование»), позволяющая увеличивать изображения до 8 мегапикселей без потери качества.

Источник изображений: Adobe В последней версии программы также появился обновлённый инструмент Remove («Удаление»), созданный на основе последней ИИ-модели Adobe Firefly. Он выполняет все ожидаемые функции стирания и удаления объектов, но при этом, по утверждению Adobe, обеспечивает более реалистичное изображение — на фотографии остаётся «меньше артефактов от удалённых объектов». Этот инструмент, как и Generative Upscale, доступен в бета-версии для настольных компьютеров и в веб-приложении. Adobe также запускает функцию Harmonize («Гармонизация»), ранее анонсированную под названием Project Perfect Blend на конференции Max в октябре 2024 года. Используя ИИ-модель Adobe Firefly, Harmonize «интеллектуально анализирует окружающий контекст, автоматически корректируя цвет, освещение, тени и визуальный тон для создания бесшовных, цельных композиций». Adobe утверждает, что новая функция существенно сократит необходимость ручной корректировки. Помимо бета-версии на настольном компьютере или в веб-браузере, она также доступна для пользователей мобильных устройств iOS.  Теперь пользователи получили возможность переключаться между различными ИИ-моделями Adobe Firefly. Кроме того, в этой бета-версии Photoshop появилась функция Projects («Проекты»), которая обеспечит сохранение всех файлов пользователя в едином пространстве и позволит отправлять заказчику целые коллекции, а не одну версию за раз. В ИИ-помощника программиста Amazon Q кто-то тайно внедрил опасный код — это заметили лишь через десять дней

29.07.2025 [17:30],

Павел Котов

Неизвестный вредитель добавил в расширение Amazon Q Developer для Microsoft Visual Studio Code с поддержкой генеративного искусственного интеллекта код с запросом на удаление данных. Расширение призвано помогать разработчикам писать и отлаживать код, составлять документацию и конфигурировать проекты.

Источник изображения: aws.amazon.com 13 июля 2025 года некий пользователь lkmanka58 на GitHub добавил в код расширения запрос на удаление системных и облачных ресурсов; 17 июля Amazon, не зная об этом, выложила обновление с этим кодом — версию 1.84.0. Подозрительную активность компания обнаружила лишь 23 июля, усилиями отдела разработчиков быстрого реагирования 24 июля была выпущена версия 1.85.0 без опасного кода, и пользователям расширения рекомендовали оперативно обновиться до этого варианта. В Amazon заверили, что код был некорректным и в пользовательской среде не выполнялся, но, по версии некоторых экспертов, он всё-таки работал, но не причинил никакого вреда. Версию 1.84.0 полностью удалили из каналов распространения ПО, но сообщество осталось недовольным. Люди выразили обеспокоенность тем, что компания пропустила потенциально опасный фрагмент кода, скрытым образом отредактировала историю git и несвоевременно раскрыла информацию об инциденте. Инцидент с Amazon не уникален. В 2024 году было проведено академическое обследование 53 000 расширений для Microsoft Visual Studio Code, в результате которого выяснилось, что около 5,6 % из них содержат подозрительные фрагменты: произвольные сетевые обращения, злоупотребление привилегиями и обфусцированный код. Программистам не рекомендуется безоговорочно доверять расширениям для сред разработки и помощникам с ИИ. Залогом безопасности не является даже репутация автора расширения — как в случае с Amazon. Microsoft не хочет упустить сильный ИИ: корпорация борется за доступ к будущим технологиям OpenAI

29.07.2025 [15:26],

Алексей Разин

Крупнейший инвестор OpenAI, корпорация Microsoft, явно не желает терять доступ к разработкам перспективного стартапа и пытается модифицировать договор с компанией таким образом, чтобы и впредь пользоваться её разработками в сфере искусственного интеллекта.

Источник изображения: Unsplash, Levart_Photographer Нюанс заключается в том, как поясняет Bloomberg, что действующий контракт между Microsoft и OpenAI предусматривает свободный доступ первой к разработкам второй только до момента создания так называемого «сильного» искусственного интеллекта (AGI), который по своим возможностям сопоставим с человеческим. После этой вехи в развитии OpenAI права Microsoft в отношении использования разработок стартапа должны быть серьёзно ограничены. Кроме того, контракт между компаниями сам по себе рассчитан до 2030 года. Microsoft хотела бы сохранить доступ к технологиям OpenAI и после этого рубежа. Сейчас Microsoft ведёт переговоры с целью устранения этого условия в договорённостях с OpenAI. Одновременно последняя старается провести реструктуризацию, которая позволит ей окончательно встать на коммерческие рельсы и начать привлекать масштабные инвестиции из самых разных источников. Сейчас компания управляется некоммерческой организацией, а величина потенциальной финансовой отдачи в пользу инвесторов ограничивается не самыми крупными суммами. Очевидно, что на этом фоне OpenAI не так просто привлекать средства на своё развитие, поскольку она не особо гарантирует возврат инвестиций. По данным Bloomberg, стороны достигнут соглашения в течение нескольких недель. В этом месяце главы компаний Сэм Альтман (Sam Altman) и Сатья Наделла (Satya Nadella) уже обсуждали данную тему на одной из профильных конференций. Впрочем, продвижению OpenAI к успешной реструктуризации данное соглашение может и не способствовать, поскольку на этом пути много других препятствий в виде того же иска Илона Маска (Elon Musk). OpenAI также стремится снизить зависимость от Microsoft, чтобы развивать свою вычислительную инфраструктуру и при помощи конкурирующих провайдеров облачных услуг. SoftBank, например, готова финансировать проекты OpenAI только в том случае, если реструктуризация последней будет завершена до конца текущего года. У OpenAI также имеется ряд требований к Microsoft — в сфере безопасного использования её разработок, например. В части создания AGI существующий контракт с Microsoft также содержит ряд неопределённостей. Например, совет директоров OpenAI оставляет за собой право определять, когда компания создаст AGI с технической точки зрения. Как только такое решение будет принято, Microsoft может быть существенно ограничена в доступе к технологиям OpenAI. Все последующие разработки уже не будут доставаться Microsoft, и это её очень беспокоит. Кроме того, Microsoft лишена права самостоятельно разрабатывать AGI. Если OpenAI сможет обеспечивать своих инвесторов прибылью в совокупном размере $100 млрд, у неё появится право выплатить Microsoft все причитающиеся доходы, взамен лишив партнёра доступа ко всем своим разработкам. Споры по этим вопросам могут быть рассмотрены в суде. Сторонам также предстоит договориться о том, как на деятельность OpenAI будут влиять сделки по поглощению прочих стартапов. Последние не всегда готовы предоставлять Microsoft доступ к своим исходным разработкам. В целом, Microsoft рассчитывает после реструктуризации получить от 30 до 35 % акций OpenAI. Если же условия в рамках нового контракта не устроят Microsoft, она готова смириться с условиями существующего. Европа возведёт ИИ-гигафабрики, стремясь наверстать упущенное в отрасли

29.07.2025 [13:54],

Павел Котов

В последние месяцы в Европе набирается популярность концепция «гигафабрик» — объектов для работы с системами искусственного интеллекта в промышленных масштабах. Власти Евросоюза характеризуют эти объекты как «динамичную экосистему», которая объединяет вычислительные мощности, данные и кадровые ресурсы, — всё это необходимо для разработки моделей и приложений ИИ.

Источник изображения: ALEXANDRE LALLEMAND / unsplash.com Европа оказалась в положении догоняющего в гонке ИИ по сравнению с США и Китаем. В состав ЕС входят 27 стран, что замедляет процессы принятия новых законов; дополнительными сдерживающими факторами являются высокие цены на электроэнергию и острая потребность в модернизации энергосистем. «У нас, например, на 30 % больше, чем в США, исследователей в разработке ИИ. У нас также около 7000 разрабатывающих ИИ стартапов, но главным препятствием для них являются ограниченные вычислительные ресурсы. Вот поэтому мы совместно с нашими государствами-членами решили вложиться в эту важнейшую инфраструктуру. Это очень крупные инвестиции, потому что они [объекты] вчетверо мощнее в плане вычислительных ресурсов, чем крупнейшие центры ИИ. У нас есть всё необходимое, чтобы быть конкурентоспособными в этом секторе, но в то же время мы хотим укрепить наш технологический суверенитет и нашу конкурентоспособность», — цитирует CNBC исполнительного вице-президента Еврокомиссии по вопросам технологического суверенитета Хенну Вирккунен (Henna Virkkunen). К настоящему моменту ЕС выделил €10 млрд на создание 13 ИИ-объектов и €20 млрд в качестве стартовой суммы на инвестиции в «гигафабрики», что, по словам властей региона, является «крупнейшими государственными инвестициями в ИИ в мире». Организаторы проекта получили уже 76 заявок из 16 стран и с 60 площадок, отражающих интерес к работе на «гигафабриках». Это значительно больше, чем ожидали власти региона, но для полноценного запуска потребуются колоссальные инвестиции и со стороны бизнеса. Идея «гигафабрик» в том, чтобы воспроизвести процессы, происходящие на промышленных предприятиях, но в качестве продукта получить не материальные товары, а передовые решения в области ИИ. Это будут центры обработки данных с ускорителями для обучения и запуска ИИ, а также сопутствующая инфраструктура, способная сделать ИИ-системы доступными для компаний, которые не могут создать свои собственные.

Источник изображения: Waldemar / unsplash.com Одной из первых пример показала телекоммуникационная компания Telenor, которая в ноябре минувшего года запустила собственный объект в Норвегии. Сейчас она работает с небольшим кластером ускорителей, чтобы установить потребности рынка перед расширением проекта. Для применения ИИ в работе приходится быть готовым к тому, чтобы поместить критически важную и составляющую коммерческую тайну информацию в обучающий массив, рассказали в Telenor. Сейчас компания работает с BabelSpeak — эта своего рода норвежская версия ChatGPT помогает пограничникам в переводе конфиденциальных диалогов, содержание которых нельзя раскрывать публичным службам. В первых числах сентября в немецком Мюнхене будет запущен крупный ИИ-объект, но он не будет «гигафабрикой». Для каждой «гигафабрики» потребуются инвестиции в размере от €3 млрд до €5 млрд, отметила госпожа Вирккунен; в этом году власти ЕС планируют объявить о запуске программы по сбору вложений. Многое пока остаётся неясным: доли участия частного капитала в дополнение к средствам налогоплательщиков, мощности и размеры «гигафабрик» — трудно сказать, в какой мере они помогут нарастить вычислительные ресурсы, указывают эксперты. Строительство каждой из них может занять год или два, но непонятно, сколько времени уйдёт на возведение электростанции для неё; следует рассчитывать на мощность не менее одного гигаватта, и неизвестно, потянут ли такую нагрузку европейские электросети — «потребуются крупные инвестиции в системы рекуперации энергии», указывают эксперты. Сейчас мощность ЦОД по всему миру составляет 85 ГВт, подсчитали аналитики швейцарской инвестиционной компании UBS. Исходя из того, что ЕС намеревается вложить в проект €20 млрд и установить на каждой «гигафабрике» по 100 тыс. современных ускорителей, мощность каждой может составить 100–150 МВт, а общая мощность всех достигнет 1,5–2 ГВт. Это на 15 % увеличит энергопотребление всего европейского региона — такая динамика представляется значительной даже в сравнении с США, на которые приходятся около трети мировой мощности. На быстрый старт рассчитывать не приходится, предупреждают эксперты: нужно не просто закупить оборудование у Nvidia, но также своими силами запустить объекты и сделать их экономически жизнеспособными. Начинать придётся с относительно скромных масштабов, потому что из-за дороговизны ЕС не сможет сразу создавать передовые ИИ-модели. Регион сумеет постепенно развить инфраструктуру и бизнес-процессы, выйти на достойный уровень, но сразу это не произойдёт. В Google Chrome появятся ИИ-сводки о репутации магазинов

29.07.2025 [08:37],

Анжелла Марина

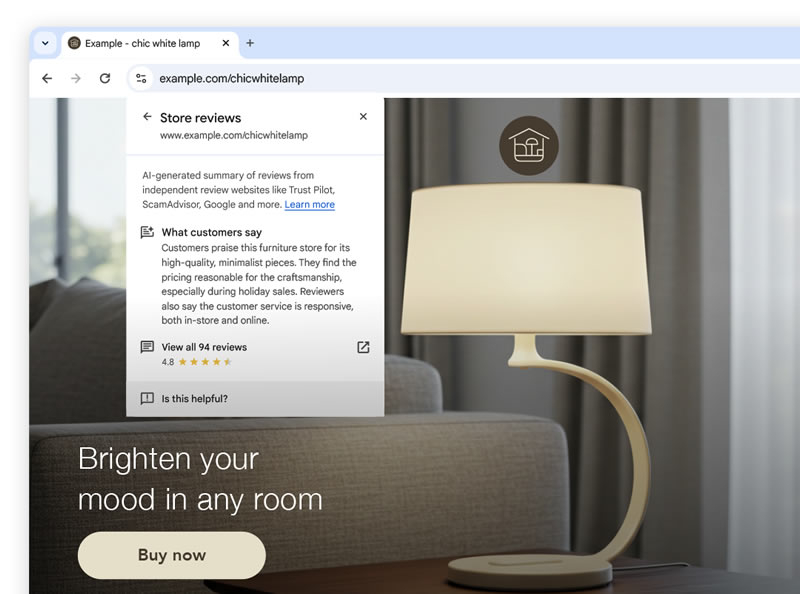

Google представила новую функцию в браузере Chrome, которая использует искусственный интеллект для генерации кратких обзоров интернет-магазинов. При нажатии на иконку слева от адресной строки появится всплывающее окно с информацией о репутации магазина, куда войдут такие показатели, как качество товаров, цены, обслуживание клиентов, условия возврата и покупательский опыт.

Источник изображения: AI По сообщению TechCrunch, сводки будут формироваться на основе отзывов с таких платформ, как Bazaarvoice, Bizrate Insights, Reputation.com, Reseller Ratings, ScamAdviser, Trustpilot, TurnTo, Yotpo и Verified Reviews. Функция изначально будет доступна только на настольных ПК и только на английском языке для пользователей в США. В Google не уточнили, появится ли аналогичный инструмент в мобильной версии браузера.

Источник изображения: Google По заявлению компании, эта функция призвана сделать онлайн-покупки безопаснее и удобнее. Однако её запуск также связан с усилением конкуренции с Amazon, который уже активно использует ИИ для анализа отзывов, подбора одежды по размеру и персонализированных рекомендаций. Отмечается, что нововведение появилось на фоне растущего давления на Chrome со стороны конкурентов и их ИИ-браузеров, таких как Perplexity Comet, The Browser Company (Dia) и Opera Neon, что вынуждают Google активнее интегрировать искусственный интеллект и в свой браузер. Среди разработок известны ИИ-агент, способный выполнять действия в Chrome от имени пользователя, и поддержка ассистента Gemini для подписчиков. Ранее компания уже внедрила ИИ-функции для поиска товаров, персонализированных рекомендаций, виртуальной примерки одежды, отслеживания цен, покупок в режиме AI Mode и автоматизированного оформления заказов. Последние две функции были представлены в этом году на конференции Google I/O, а подбор стильных образов одежды и интерьеров в AI Mode должен появиться уже осенью. Китайские ИИ-компании объединились для создания своей экосистемы и противостояния санкциям США

28.07.2025 [16:29],

Анжелла Марина

Китайские ИИ-компании объявили о создании двух новых отраслевых альянсов с целью укрепления и развития внутренней экосистемы, а также снижения зависимости от зарубежных технологий. Это решение стало ответом на ограничения со стороны США, блокирующие доступ к приобретению и использованию передовых ускорителей Nvidia, таких как H100, H200 и более современных Blackwell.

Источник изображения: Kandinsky По сообщению Reuters, один из альянсов, получивший название Model-Chip Ecosystem Innovation Alliance, объединит китайских разработчиков больших языковых моделей (LLM) и производителей ИИ-чипов. Участниками альянса станут такие производители графических процессоров (GPU), как Huawei, Biren, Moore Threads, Enflame, а также ИИ-стартап StepFun. Эти компании находятся под санкциями США, ограничивающими их доступ к технологиям с американским участием. По словам Чжао Лидуна (Zhao Lidong), генерального директора Enflame, участвующей в инициативе, проект объединит всю технологическую цепочку — от ИИ-чипов до инфраструктуры. Второй альянс — ИИ-комитет при Шанхайской генеральной торговой палате (Shanghai General Chamber of Commerce) — создан для содействия интеграции ИИ-технологий в промышленность. В его состав вошли такие компании, как SenseTime (также под санкциями США), MiniMax, Metax и Iluvatar CoreX. Интересно, что на Всемирной конференции по искусственному интеллекту (WAIC) в Шанхае Huawei представила систему CloudMatrix 384, в которую интегрированы 384 отечественных чипа Ascend 910C. По оценке американской аналитической компании SemiAnalysis, по некоторым показателям эта система превосходит Nvidia GB200 NVL72, а более низкую производительность отдельных чипов Huawei компенсирует за счёт масштабируемой архитектуры и системных инноваций. Похожие кластерные решения представили как минимум шесть китайских компаний. В частности, Metax продемонстрировала ИИ-суперноду с 128 чипами C550, предназначенную для использования в крупных дата-центрах с жидкостным охлаждением. Tencent представила открытую модель Hunyuan3D World Model 1.0, позволяющую создавать интерактивные 3D-среды по текстовым или визуальным запросам. Компания Baidu продемонстрировала «цифрового человека» — технологию нового поколения, способную имитировать голос, интонации, жесты и мимику по 10-минутной видеозаписи. Разработка может применяться в сфере виртуальных стримов. В свою очередь, Alibaba анонсировала Quark AI Glasses — умные очки на базе собственной ИИ-модели Qwen. Их релиз запланирован на конец 2025 года. Очки получат функции навигации через фирменные карты, а также возможность оплаты через Alipay с помощью голосовых команд и сканирования QR-кодов. Собрать за 60 секунд: Huawei и Avatr запустили ультрасовременный автомобильный завод без людей, но с 5G и ИИ

28.07.2025 [14:16],

Алексей Разин

Успех на автомобильном рынке в наши дни немыслим без современных средств производства. Китайская марка Avatr, которая развивается при участии Changan и Huawei, на этой неделе представила своё самое современное предприятие, которое собирает машины без участия человека и ориентируется на повсеместное внедрение сетей связи 5G и искусственного интеллекта.

Источник изображения: Avatr Как отмечается представителями Avatr, новейшее предприятие демонстрирует более 40 передовых технологических подходов к производству сложных видов продукции типа электромобилей. Искусственный интеллект и сети 5G соседствуют на нём с технологией цифровых двойников, и высокая степень автоматизации позволяет на одном конвейере без дополнительной смены оснастки одновременно выпускать до 1280 разновидностей транспортных средств, если считать все комбинации комплектующих и характеристик. Формально, на одном конвейере могут уживаться даже модели разных марок, если это потребуется. При всём этом каждые 60 секунд с конвейера сходит по одной машине. Сквозная цифровизация позволяет получать информацию в масштабе реального времени буквально от каждого элемента производственной цепочки. Отследить путь продукции можно от момента размещения заказа до выпуска готовой машины. За качество отвечают 369 специализированных систем мониторинга и 26 постов комплексной проверки продукции. Искусственный интеллект в полной мере проявляет себя на данном этапе работы с изделиями, предлагая 25 различных сценариев контроля качества продукции. Компания Avatr одновременно призналась, что скоро при поддержке традиционного партнёра в лице Huawei Technologies выпустит на китайский рынок флагманский внедорожник, который ляжет в основу нового семейства машин. Всего же до 2030 года под этой маркой выйдет 17 различных моделей, включая седаны, кроссоверы, минивэны и спорткары. Avatr ставит перед собой цель ежегодно продавать во всём мире по 800 000 машин. Если учесть, что в прошлом году она продала только 73 000 машин, то потенциал роста определённо имеется. В прошлом году Avatr официально вышел на рынки 25 новых стран и регионов, продукция марки представлена и в России. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |