|

Опрос

|

реклама

Быстрый переход

Microsoft представила три новые малые ИИ-модели семейства Phi-4

01.05.2025 [16:48],

Дмитрий Федоров

Microsoft выпустила три новые малые языковые модели (SLM) с открытой лицензией: Phi-4-mini-reasoning, Phi-4-reasoning и Phi-4-reasoning-plus. Каждая из моделей относится к классу рассуждающих (reasoning) моделей, ориентированных на логическую верификацию решений и тщательную проработку сложных задач. Эти ИИ-модели стали продолжением инициативы Microsoft по разработке компактных ИИ-систем — семейства Phi, впервые представленного год назад как фундамент для приложений, работающих на устройствах с ограниченными вычислительными возможностями.

Источник изображения: Jackson Sophat / Unsplash Наиболее производительной из представленных является ИИ-модель Phi-4-reasoning-plus. Она представляет собой адаптацию ранее выпущенной Phi-4 под задачи логического вывода. По утверждению Microsoft, её качество ответов близко к DeepSeek R1, несмотря на существенную разницу в объёме параметров: у DeepSeek R1 — 671 млрд, тогда как у Phi-4-reasoning-plus их значительно меньше. Согласно внутреннему тестированию Microsoft, эта модель показала результаты, соответствующие ИИ-модели OpenAI o3-mini в рамках бенчмарка OmniMath, оценивающего математические способности ИИ.

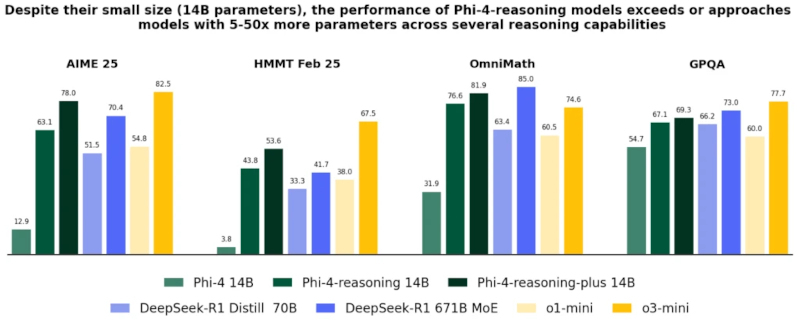

Модели Phi-4-reasoning и Phi-4-reasoning-plus (14 млрд параметров) демонстрируют превосходство над базовой Phi-4 и уверенно конкурируют с более крупными системами, включая DeepSeek-R1 Distill (70 млрд параметров) и OpenAI o3-mini, в задачах математического и логического мышления (AIME, HMMT, OmniMath, GPQA). Источник изображения: Microsoft Модель Phi-4-reasoning содержит 14 млрд параметров и обучалась на основе «качественных» данных из интернета, а также на отобранных демонстрационных примерах из o3-mini. Она оптимизирована для задач в области математики, естественных наук и программирования. Таким образом, Phi-4 reasoning ориентирована на высокоточные вычисления и аналитическую интерпретацию данных, оставаясь при этом относительно компактной и доступной для использования на локальных вычислительных платформах.

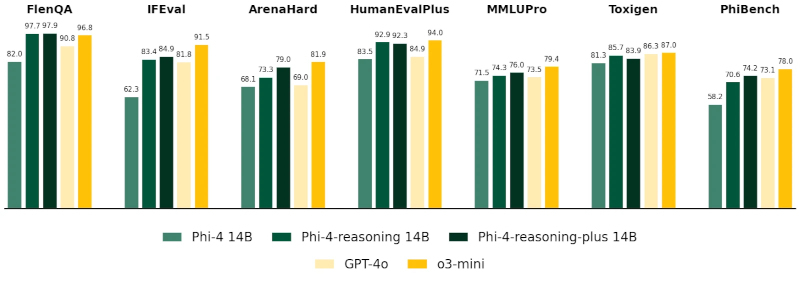

На универсальных тестах, включая FlenQA, IFEval, HumanEvalPlus, MMLUPro, ToxiGen и PhiBench, модели Phi-4-reasoning-plus демонстрируют точность, сопоставимую с GPT-4o и o3-mini, несмотря на меньший объём параметров (14 млрд параметров), особенно в задачах программирования, логики и безопасности. Источник изображения: Microsoft Phi-4-mini-reasoning — самая малогабаритная из представленных SLM. Её размер составляет около 3,8 млрд параметров. Она обучалась на основе приблизительно 1 млн синтетических математических задач, сгенерированных ИИ-моделью R1 китайского стартапа DeepSeek. Microsoft позиционирует её как ИИ-модель для образовательных сценариев, включая «встроенное обучение» на маломощных и мобильных устройствах. Благодаря компактности и точности, эта ИИ-модель может применяться в интерактивных обучающих системах, где приоритетом являются скорость отклика и ограниченность вычислительных ресурсов.

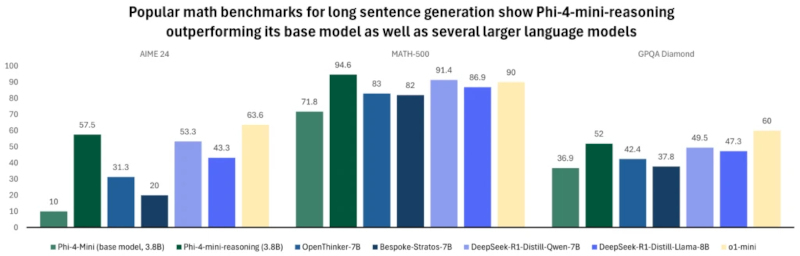

Phi-4-mini-reasoning (3,8 млрд параметров) значительно превосходит свою базовую версию и модели с вдвое большим размером на бенчмарках AIME 24, MATH-500 и GPQA Diamond, а также сопоставима или превосходит OpenAI o1-mini по точности генерации длинных математических ответов. Источник изображения: Microsoft Все три ИИ-модели доступны на платформе Hugging Face и распространяются под открытой лицензией. По словам Microsoft, при их обучении использовались дистилляция, обучение с подкреплением и высококачественные обучающие данные. Эти методы позволили сбалансировать размер SLM и их вычислительную производительность. ИИ-модели достаточно компактны, чтобы использоваться в средах с низкой задержкой, но при этом способны решать задачи, требующие строгости логического построения и достоверности результата. Ранее такие задачи были характерны лишь для гораздо более крупных ИИ. |