|

Опрос

|

реклама

Быстрый переход

Google заплатила этичным хакерам $10 млн за выявленные уязвимости в 2023 году

13.03.2024 [15:47],

Владимир Фетисов

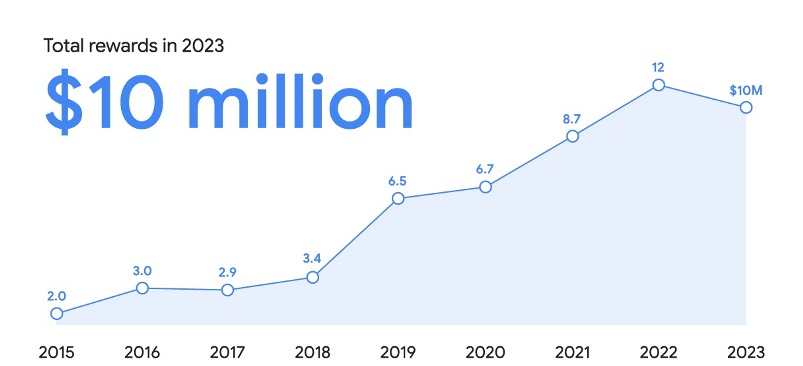

По итогам 2023 года Google выплатила этичным хакерам, которые участвовали в программе по поиску уязвимостей в разных продуктах IT-гиганта, $10 млн. Информация об этом появилась в блоге компании.

Источник изображения: Lumapoche / Pixabay В общей сложности вознаграждение от Google в прошлом году получили 632 исследователя в сфере информационной безопасности из 68 стран мира. Они занимались поиском уязвимостей в разных продуктах компании, таких как операционные системы Android и Wear OS. Размер самой большой единичной выплаты за отчёт об обнаруженной уязвимости составил $113 337, а всего с момента запуска программы в 2010 году Google выплатила исследователям $59 млн.

Источник изображения: Google В прошлом году Google расширила свою программу по поиску уязвимостей, добавив в неё сервисы на основе генеративных нейросетей, таких как Gemini. В течение всего года в этом сегменте было выявлено 35 ошибок, а общая сумма вознаграждения составила $87 тыс. За обнаруженные уязвимости в Android и аппаратных продуктах Google сумма выплат составила $3,4 млн.

Источник изображения: Google Ошибки, которые были обнаружены в Wear OS и Android Automotive, принесли исследователям $70 тыс. В браузере Chrome за год было выявлено 359 уязвимостей, которые принесли исследователям около $2,1 млн. Ознакомиться с более детальной информацией по данному вопросу можно в блоге Google. Microsoft исправила серьёзную уязвимость Windows, о которой стало известно полгода назад

11.03.2024 [18:34],

Владимир Фетисов

В прошлом месяце компания Microsoft выпустила исправления для уязвимости CVE-2024-21338, которая позволяла повышать привилегии пользователя в Windows. Примечательно, что о проблеме стало известно около полугода назад и, по данным компании Avast, последние несколько месяцев эту уязвимость активно использовали северокорейские хакеры из группировки Lazarus.

Источник изображения: Pete Linforth / pixabay.com Упомянутая уязвимость была выявлена специалистами Avast в драйвере appid.sys утилиты AppLocker. Эксплуатация бага позволяет злоумышленникам, имеющим доступ к атакуемой системе, повысить уровень прав до уровня SYSTEM, не взаимодействуя с жертвой. Проблема затрагивает устройства с Windows 11 и Windows 10, а также Windows Server 2022 и Windows Server 2019. В сообщении Avast говорилось, что для эксплуатации уязвимости CVE-2024-21338 злоумышленник должен авторизоваться в системе, а затем запустить особым образом сконфигурированное приложение, которое использует уязвимость, чтобы взять под контроль устройство. Несмотря на то, что патч для исправления уязвимости вышел в середине прошлого месяца, Microsoft лишь несколько дней назад обновила информацию на странице поддержки, подтвердив, что уязвимость CVE-2024-21338 использовалась хакерами. По данным Avast, группировка Lazarus эксплуатировала баг как минимум с августа прошлого года. Злоумышленники использовали уязвимость для получения привилегий уровня ядра и отключения защитных механизмов на атакуемых системах. В конечном счёте им удавалось скрытно внедрять в атакуемые системы руткит FudModule для выполнения разных манипуляций с объектами ядра. Вирус-вымогатель LockBit стали распространять через уязвимость в ПО для удалённого доступа ConnectWise

23.02.2024 [18:31],

Павел Котов

Киберпреступники эксплуатируют две опасные уязвимости программы удалённого доступа ConnectWise ScreenConnect для развёртывания вируса-вымогателя LockBit. Это свидетельствует, что ресурсы одноимённой хакерской группировки продолжают работать, хотя бы и частично.

Источник изображения: kalhh / pixabay.com Эксперты по кибербезопасности в компаниях Huntress и Sophos накануне доложили, что зафиксировали атаки LockBit, производимые через уязвимости популярной программы удалённого доступа ConnectWise ScreenConnect. Атаки осуществляются через две уязвимости. Ошибка CVE-2024-1709 относится к уязвимостям обхода аутентификации и считается «неприлично простой» в эксплуатации — она активно используется с минувшего вторника, то есть с того момента, как ConnectWise выпустила закрывающее её обновление программы и призвала клиентов установить его. Вторая ошибка за номером CVE-2024-1708 позволяет удалённо передать вредоносный код на уязвимую систему. Эксперты подчёркивают, что, во-первых, уязвимости ScreenConnect активно эксплуатируются киберпреступниками на практике; во-вторых, несмотря на проведённую правоохранительными органами нескольких стран операцию, часть ресурсов группировки LockBit продолжает работать. В начале недели правоохранительные органы нескольких стран доложили о проведении крупномасштабной операции, в результате которой были отключены 34 сервера в Европе, Великобритании и США, конфискованы более 200 криптовалютных кошельков, а также арестованы двое предполагаемых участников LockBit в Польше и на Украине. Обнаружившие новую волну атак эксперты заявили, что не могут отнести её к деятельности непосредственно LockBit, но группировка имеет большой охват и разветвлённую партнёрскую сеть, которую невозможно быстро уничтожить даже в рамках крупномасштабной международной операции. В компании ConnectWise заявили, что сейчас массовое внедрение вируса-вымогателя через программу не наблюдается. Но, по данным некоммерческой организации Shadowserver Foundation, занимающейся анализом вредоносной интернет-активности, уязвимости программы продолжают эксплуатироваться — накануне угроза исходила от 643 IP-адресов, а уязвимыми оставались более 8200 серверов. В приложении Apple Shortcuts нашли уязвимость, позволяющую похищать данные без участия пользователя

23.02.2024 [14:12],

Павел Котов

В популярном приложении Apple «Быстрые команды» (Apple Shortcuts) обнаружена уязвимость CVE-2024-23204, которая может открыть злоумышленникам доступ к конфиденциальным данным на устройствах под управлением macOS и iOS без запроса разрешения у пользователя.  Приложение «Быстрые команды» для macOS и iOS предназначается для автоматизации задач: оно позволяет создавать макросы с последовательностями различных действий, включая экспорт данных в iCloud и на другие платформы. Компания Bitdefender опубликовала информацию об уязвимости CVE-2024-23204, позволяющей создавать вредоносные файлы сценариев «Быстрых команд» в обход системы безопасности Apple Transparency, Consent and Control (TCC), предназначенной, чтобы следить, что приложения в явном виде запрашивают у пользователей разрешения для доступа к определённым данным или функциям. Добавив такой файл в библиотеку жертвы, злоумышленник получает возможность незаметно похищать конфиденциальные данные и системную информацию без запроса разрешения. Уязвимость присутствует в платформах версий до macOS Sonoma 14.3, iOS 17.3 и iPadOS 17.3, и ей присвоен рейтинг 7,5 из 10 («высокий»), поскольку её можно эксплуатировать удалённо без каких-либо привилегий. В актуальных версиях ОС Apple уже исправила ошибку, и эксперты по кибербезопасности рекомендуют обновить приложение «Быстрые команды» до последней версии. |