|

Опрос

|

реклама

Быстрый переход

В ChatGPT появился «Режим блокировки» и маркировка повышенного риска для защиты важных данных

17.02.2026 [18:15],

Павел Котов

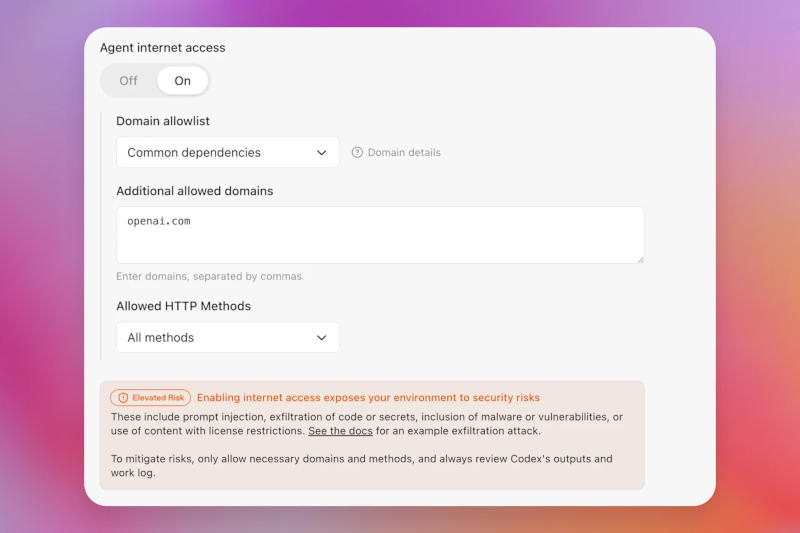

Компания OpenAI представила новые функции безопасности, направленные на то, чтобы не давать злоумышленникам возможности злоупотреблять продуктами на основе искусственного интеллекта. Это «Режим блокировки» (Lockdown Mode) как дополнительная настройка ChatGPT и пометки «Повышенный риск» (Elevated Risk) в ChatGPT, ChatGPT Atlas и Codex.

Источник изображения: openai.com Новые функции основаны на существующих средствах защиты, реализованных на уровне модели, продукта и системы, включая песочницу, защиту от утечки данных через URL-адреса, инструменты мониторинга и применения мер, а также корпоративные средства контроля, такие как разграничение прав и журналы аудита. «Режим блокировки» в ChatGPT позволяет отключать отдельные инструменты и функции чат-бота, которые гипотетический злоумышленник может попытаться использовать, чтобы организовать утечку конфиденциальных данных из переписки с пользователем или подключённых приложений, например, методом внедрения дополнительных запросов. Так, при просмотре веб-страниц в режиме блокировки включается ограничение в рамках кешированного контента — в результате сетевые запросы в реальном времени остаются в пределах контролируемой сети OpenAI. Режим блокировки доступен для пользователей с учётными записями для бизнеса, учреждений здравоохранения и образования. Он накладывает для рядовых пользователей дополнительные ограничения, помимо выбранных администратором настроек. Доступны и дополнительные настройки — можно выбирать, какие конкретно приложения и какие действия внутри этих приложений будут работать в режиме блокировки. Компания также предлагает набор инструментов Compliance API Logs Platform, позволяющий фиксировать данные об использовании приложений, общих данных и подключённых внешних источниках. В OpenAI также обратили внимание, что сервисы искусственного интеллекта могут создавать дополнительные угрозы для пользователей. Чтобы сделать это более понятным и последовательным, компания решила ввести стандартную маркировку существующих возможностей. Соответствующие функции ChatGPT, ChatGPT Atlas и Codex теперь будут иметь единую метку «Повышенный риск». Так, при работе с помощником по программированию Codex эту пометку получит функция доступа к внешним ресурсам, первоначально предназначенная, например, для поиска документации. Пометка будет сопровождаться пояснениями того, какие изменения и угрозы могут возникнуть, и в каких случаях предоставлять такой доступ уместно. OpenAI Codex и Anthropic Claude заставляют разработчиков отказываться от традиционного кодинга

15.02.2026 [13:36],

Владимир Фетисов

Умерло ли традиционное программирование? Этот вопрос многие разработчики задали себе на этой неделе на фоне недавнего выхода новых ИИ-моделей для помощи в написании программного кода от OpenAI и Anthropic.

Источник изображения: Steve Johnson/unsplash.com Ранее в этом месяце состоялся релиз ИИ-моделей GPT-5.3-Codex и Claude Opus 4.6, каждая из которых стала существенно лучше в плане генерации программного кода по сравнению с предыдущими версиями. GPT-5.3-Codex показывает значительно более высокие результаты в бенчмарках по сравнению с ранними версиями ИИ-модели, тогда как в Opus 4.6 появилась функция, позволяющая развертывать автономные команды ИИ-агентов, которые могут одновременно выполнять разные аспекты сложных задач. Обе модели способны генерировать, проверять, тестировать и отлаживать программный код с минимальным вмешательством со стороны человека. Они даже могут улучшать собственные результаты и функции до того, как итоговый результат работы будет представлен человеку. Эти релизы спровоцировали своего рода экзистенциальный кризис в онлайн-сообществе инженеров-программистов. В центре внимания оказалась вирусная публикация, написанная гендиректором OthersideAI Мэттом Шумером (Matt Shumer). Он заявил, что после выхода новых ИИ-моделей «что-то щелкнуло», и описал, как алгоритмы теперь самостоятельно справляются с полным циклом разработки: пишут десятки тысяч строк кода, открывают приложения, тестируют функции и вносят правки до тех пор, пока не будет достигнут удовлетворительный результат. Разработчику достаточно описать желаемый результат. По мнению Шумера, это может нарушить рынок труда сильнее, чем пандемия коронавируса. Статья Шумера вызвала неоднозначную реакцию в сообществе. Некоторые известные в индустрии люди, такие как сооснователь Reddit Алексис Оханян (Alexis Ohanian), согласились с ним. Однако другие, включая профессора Нью-Йоркского университета Гэри Маркуса (Gary Markus), раскритиковали публикацию Шумера. Маркус отметил, что Шумер не предоставил никаких доказательств того, что ИИ действительно способен генерировать код для сложных приложений без ошибок. Джереми Кан (Jeremy Kahn) из Fortnite добавил, что именно уникальные характеристики программирования, такие как автоматизированное тестирование, делают его более лёгким для полной автоматизации, тогда как полная автоматизация других сфер интеллектуального труда является более сложной задачей. Для многих программистов слова Шумера уже отражают их текущую реальность. Все чаще разработчики говорят о полном отказе самостоятельно писать программный код. Вместо этого они просто полагаются на ИИ, который генерирует код по заданному описанию. Вместе с этим разработчики отмечают, что в течение прошлого года отрасль переживала медленную трансформацию. Хоть разработчики в крупных технологических компаниях действительно перестают писать программный код, они не перестают создавать программное обеспечение, превратившись в своего рода режиссеров для ИИ-систем, выполняющих набор текста за них. Сам навык трансформировался от написания кода к проектированию решений и управлению ИИ-инструментами. Даже внутри Anthropic инженеры в значительной степени полагаются на уже созданные ИИ-инструменты при написании нового программного кода. Глава Claude Code Борис Черный (Boris Cherny) в начале этого месяца заявил, что не писал код более двух месяцев. ИИ-модели также достигли порога, переступив который они могут помогать создавать более продвинутые версии самих себя. OpenAI и Anthropic ранее заявляли, что в процессе создания новых ИИ-моделей использовались предыдущие версии алгоритмов, в том числе для проверки и тестирования кода. Несмотря на рост производительности, некоторые разработчики предупреждают, что новые ИИ-инструменты могут привести к выгоранию. Так опытный разработчик Стив Йегге (Steve Yegge) заявил, что ИИ-инструменты истощают разработчиков из-за переработок. Он рассказал, что не раз внезапно засыпал на рабочем месте после длительных сеансов кодинга, а его коллеги даже рассматривают возможность установки капсул для сна прямо на рабочих местах. По его мнению, сама природа ИИ-инструментов подталкивает разработчиков к непосильным нагрузкам. OpenAI убила самую эмоциональную ИИ-модель, несмотря на протесты пользователей

14.02.2026 [06:08],

Анжелла Марина

OpenAI объявила об окончательном выводе из эксплуатации модели GPT-4o, а вместе с ней GPT-4.1, GPT-4.1 mini и o4-mini, сообщает Business Insider. Это уже вторая попытка компании отключить GPT-4o. Первая состоялась в августе и закончилась отступлением перед натиском недовольных пользователей. В январе компания опять предупредила об отключении модели, однако негативная реакция вспыхнула с новой силой.

Источник изображения: openai.com Глубокая эмоциональная привязанность аудитории объясняется специфическим комплиментарным стилем общения GPT-4o. Некоторые пользователи называли модель «жизненно важным доступным инструментом» и описывали как творческого партнёра и эмоциональную опору, с которой работали месяцами. В соцсетях реакция на объявление варьировалась от гнева до чёрного юмора. Фиджи Симо (Fidji Simo), руководитель подразделения приложений OpenAI, назвала подобную привязанность началом новой эры взаимодействия людей с искусственным интеллектом. Она отметила, что люди склонны формировать эмоциональные связи с интеллектуальными системами, однако новые версии моделей получили ограничения для предотвращения потенциально вредных зависимостей. Например, при запросах «Стоит ли мне уйти от жены?» современные алгоритмы отказываются давать прямые рекомендации и вместо этого предлагают взвесить «все за и против». Глава OpenAI Сэм Альтман (Sam Altman) признаёт, что пользователи ценили заискивающий тон ответов GPT-4o, но сам он считает это излишним подхалимством и подобострастием. В компании пояснили, что вывод старых моделей из эксплуатации необходим для концентрации ресурсов на улучшении актуальных версий, которыми пользуется основная масса людей. К моменту отключения GPT-4o модель использовали лишь 0,1 % клиентов сервиса. OpenAI начала терять исследователей после появления рекламы в ChatGPT

12.02.2026 [14:19],

Павел Котов

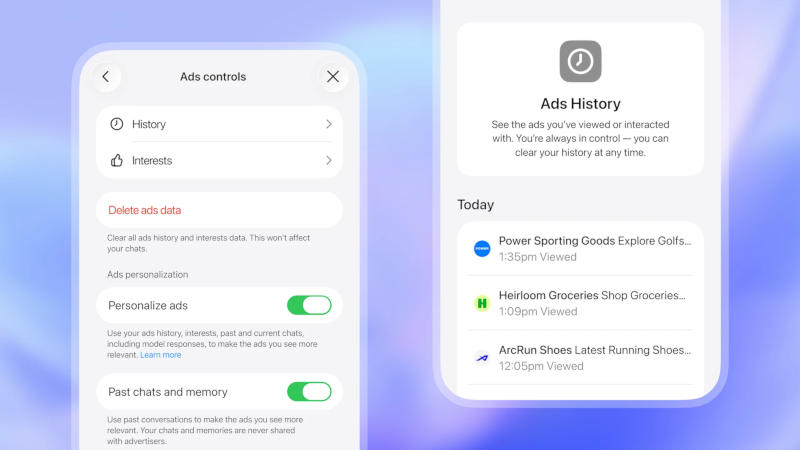

Исследователь OpenAI Зои Хитциг (Zoë Hitzig) уволилась из компании в тот же день, когда стартовало тестирование показа рекламы в ChatGPT. Работая в компании, она помогала в сборке моделей ИИ и установке ценообразования на них. OpenAI рискует повторить ошибки Facebook✴✴, сделанные десять лет назад, предупредила она.

Источник изображения: Dima Solomin / unsplash.com Особенно рискованной затея с рекламой представляется в силу характера данных на платформе ChatGPT. Пользователи делятся с чат-ботом медицинской информацией, проблемами в отношениях и религиозными убеждениями — зачастую «потому, что люди верят, что разговаривают с чем-то, лишённым скрытых мотивов», и в результате чего платформа превратилась в «беспрецедентный архив человеческой откровенности». Нечто подобное, по мнению Хитциг, раньше было с Facebook✴✴ — когда-то соцсеть обещала пользователям контроль над своими данными и возможность голосовать за изменения в политику. Со временем эти обещания ослабли, а Федеральная торговая комиссия (FTC) установила, что изменения в политике конфиденциальности, с которыми Facebook✴✴ обещала людям более полный контроль, в действительности дали обратный результат. Вот и с OpenAI бывшая сотрудница компании не исключила подобного, потому что та «создаёт сильные стимулы для нарушения собственных правил». На этапе тестирования персонализация рекламы для пользователей по умолчанию включена, говорится в документации OpenAI. Если не трогать эту настройку, реклама будет подбираться с учётом данных из текущих и прошлых чатов, а также прошлых взаимодействий с объявлениями. У рекламодателей не будет доступа к переписке пользователей с чат-ботом или к их персональным данным; реклама не будет показываться в чатах, посвящённых вопросам здоровья, религии и политики. В этом Хитциг уже усмотрела внутреннее противоречие: с одной стороны, компания настаивает, что не пытается повлиять на активность пользователей исключительно с целью получить доход от рекламы — с другой, оптимизирует поведение ИИ для ежедневно активных пользователей, делая её «более льстивой и подобострастной». В результате люди могут впадать в зависимость от ИИ; кроме того, задокументированы случаи психозов, связанных с ChatGPT, а в отдельных случаях чат-бот потворствовал суицидальным мыслям — это косвенно подтверждает множество исков к OpenAI. Чтобы противостоять угрозам, Хитциг предложила схемы субсидирования потребителей со стороны корпоративных клиентов; формирование независимых советов с полномочиями контролировать использование данных переписки для таргетирования рекламы; а также трасты, позволяющие пользователям сохранять контроль над своей информацией. Наиболее опасными исходами эксперт назвала «технологию, которая манипулирует людьми, использующими её бесплатно; и технологию, приносящую пользу исключительно меньшинству, которое может себе её позволить». Ярую противницу «режима для взрослых» уволили из OpenAI по подозрению в гендерной дискриминации

11.02.2026 [14:29],

Алексей Разин

В структуре OpenAI есть не только комитет по безопасному развитию ИИ, но и отдельные специалисты в этой сфере, которые направляют стартап в нужное русло. Недавно стало известно, что одну из ярых противниц реализации в ChatGPT функций эротического характера уволили из компании в начале января, заподозрив в дискриминации одного из коллег по половому признаку.

Источник изображения: Unsplash, Levart_Photographer По крайней мере, The Wall Street Journal именно такими причинами объясняет недавнее увольнение Райан Байермайстер (Ryan Beiermeister), которое таинственным образом предшествовало предполагаемому запуску нового режима «для взрослых» в чат-боте OpenAI. Скандал с реализацией подобных функций в конкурирующем Grok стартапа xAI Илона Маска (Elon Musk), как показала статистика, лишь увеличил его пользовательскую аудиторию, и не исключено, что OpenAI готова поднять популярность ChatGPT аналогичными сомнительными способами. Сейчас сервисом еженедельно пользуются 800 млн человек. Райан Байермайстер, как отмечает источник, отвечала в OpenAI за безопасное развитие искусственного интеллекта, она являлась принципиальной противницей реализации «эротического режима» в ChatGPT. Она считала, что подобное расширение способов эмоционального воздействия ИИ на сознание не очень психически устойчивых людей станет причиной усиления социальных проблем. Уже сейчас многие пользователи ChatGPT отмечают стойкую психологическую зависимость от воображаемых персонажей, которые якобы общаются с ними через чат-бот. Байермейстер была уволена после отпуска без содержания, который она взяла по личным обстоятельствам. Обвинения в дискриминации кого-то из коллег она решительно отметает, но официально OpenAI и не называет подобных причин её увольнения, отрицая их наличие и всячески выражая признательность бывшей сотруднице за проделанную работу и вклад в развитие бизнеса компании. Хотя инициатива по поводу «режима для взрослых» в ChatGPT наталкивается на противодействие многих экспертов в OpenAI, генеральный директор Сэм Альтман (Sam Altman) в целом благосклонно к ней относится, заявляя, что «пора по-взрослому относиться ко взрослым». Байермайстер в своём общении с коллегами выражала сожаление по поводу того, что OpenAI не располагает достаточными инструментами для ограждения подростковой аудитории от взрослого контента. В период своей работы в компании, который отсчитывался с середины 2024 года, она проводила тренинги карьерного роста с коллегами женского пола. ChatGPT научился показывать отчёты глубоких исследований как полноценные документы — с навигацией и экспортом

11.02.2026 [11:49],

Владимир Фетисов

Компания OpenAI обновила исследовательский режим (Deep Research) в чат-боте ChatGPT, добавив полноэкранный просмотрщик. С его помощью можно прокручивать содержимое отчёта бота и быстро перемещаться между разными разделами. Инструмент позволяет открывать отчёты ChatGPT в отдельном от чата окне, где слева отображается оглавление документа, а справа — список источников.

Источник изображения: OpenAI Функция глубокого исследования, которая появилась в ChatGPT в прошлом году, позволяет ИИ-боту анализировать собранную в интернете информацию, чтобы сформировать подробный отчёт на запрос пользователя. Последнее обновление также позволяет указать алгоритму необходимость сосредоточиться на изучении информации на конкретных сайтах и подключенных приложениях при проведении исследования. В дополнение к этому пользователи могут отслеживать процесс работы алгоритма в режиме реального времени, корректировать масштаб исследования или добавлять новые источники прямо в процессе работы. После завершения генерации отчёта информацию можно скачать в виде файла в разных форматах, включая DOCX и PDF. Эти нововведения уже доступны платным подписчикам OpenAI на тарифах Plus и Pro. Пользователи тарифа ChatGPT Go и бесплатные пользователи получат обновление с расширенными возможностями для проведения исследований в ближайшее время. ChatGPT начал показывать рекламу — её увидят не все и не сразу

10.02.2026 [10:42],

Павел Котов

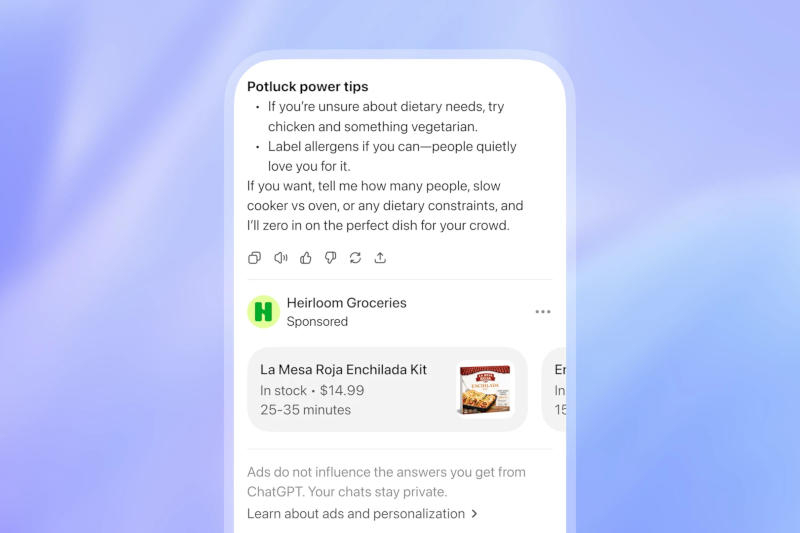

OpenAI официально объявила, что начала тестировать показ рекламы на платформе ChatGPT в США. Она будет показываться в виде специально помеченных ссылок под ответами чат-бота; реклама «не повлияет на ответы, которые даёт вам ChatGPT», подчеркнули в компании.

Источник изображения: openai.com В настоящее время рекламу увидят только совершеннолетние пользователи бесплатной версии ChatGPT и подписчики самого недорогого тарифного плана Go по цене $8 в месяц. Обладатели учётных записей с подписками Plus, Pro, Business, Enterprise и Education рекламы не увидят, то есть, чтобы избавиться от неё, потребуется платить не менее $20 в месяц. Есть и альтернатива — даже пользователи бесплатной версии смогут отказаться от неё, если согласятся на «меньшее число бесплатных сообщений в день»; подписчикам Go такая возможность недоступна.  Рекламные объявления можно закрывать, оставлять о них отзывы, отключать персонализацию рекламы, отключать возможность показывать её на основе предыдущих чатов и удалять данные рекламного профиля. Рекламодателям будет предоставляться только «агрегация [данных] о рекламных просмотрах и кликах», но не личная информация и не данные переписок пользователей в ChatGPT. Она не будет показываться несовершеннолетним пользователям, а все остальные не увидят её в чатах на деликатные темы, связанные с «физическим и психическим здоровьем или политикой». Увидят рекламу не все пользователи сразу — функция до сих пор находится на стадии тестирования. Ранее Anthropic, которая считается основным конкурентом OpenAI, высмеяла разработчика ChatGPT за намерение показывать рекламу в переписке с ИИ и пообещала, что у её чат-бота Claude рекламы не будет никогда. Anthropic пообещала сохранить Claude без рекламы и высмеяла противоположный подход ChatGPT

04.02.2026 [19:13],

Сергей Сурабекянц

Anthropic объявила, что не планирует добавлять рекламу в свой чат-бот с искусственным интеллектом Claude, что резко контрастирует с подтверждёнными планами OpenAI разместить рекламу в ChatGPT. Чтобы ещё больше подчеркнуть это, компания выпустила серию рекламных роликов, высмеивающих неназванных конкурентов, добавляющих рекламу в свои ИИ. Они уже опубликованы на YouTube и будут показаны во время «Супербоула» — финальной игры по американскому футболу.

Источник изображения: Anthropic «Мы хотим, чтобы Claude действовал однозначно в интересах наших пользователей, — говорится в блоге Anthropic. — Поэтому мы сделали выбор: Claude останется без рекламы. Наши пользователи не будут видеть спонсируемые ссылки рядом с их разговорами с Claude; ответы Claude также не будут зависеть от рекламодателей или включать размещение сторонних продуктов, которые пользователи не запрашивали». Anthropic разъяснила, почему включение рекламы «несовместимо с тем, каким мы хотим видеть Claude». По мнению компании, стремление к прибыли может помешать предоставлению наиболее полезных советов пользователю и отвлекать тех, кто использует Claude для работы. Тем не менее, Anthropic не стала сжигать мосты: «Если нам потребуется пересмотреть этот подход, мы будем прозрачны в отношении причин, по которым мы это сделаем». Изменение политики Anthropic в будущем может выглядеть лицемерно в свете рекламы, выпущенной компанией для продвижения своей позиции во время «Супербоула». Это один из четырёх рекламных роликов, где очеловеченные ИИ вставляют неуместную рекламу прямо посреди своих ответов. Более короткая 30-секундная версия ролика будет показана во время игры в воскресенье, а отдельный минутный ролик с вставляющим рекламные советы во время консультации с ИИ-терапевтом, будет показан во время предматчевого шоу. Ни в одном из рекламных роликов не упоминается ChatGPT, но направленность их очевидна. В прошлом месяце OpenAI объявила о скором появлении рекламы в ChatGPT для бесплатных пользователей и пользователей более дешёвого тарифа Go, пообещав, что она будет «чётко обозначена» и расположится отдельно от ответов чат-бота. «Супербоул» — в американском футболе название финальной игры за звание чемпиона Национальной футбольной лиги (НФЛ) Соединённых Штатов Америки, в которой встречаются победители двух конференций лиги — Американской футбольной конференции и Национальной футбольной конференции. «Мне это нравится! Я смотрю видео без рекламы об искусственном интеллекте без рекламы», — прокомментировал видео один из пользователей, посмотревших его на YouTube. ChatGPT «упал» по всему миру: тысячи человек остались без ответов чат-бота OpenAI

04.02.2026 [00:02],

Андрей Созинов

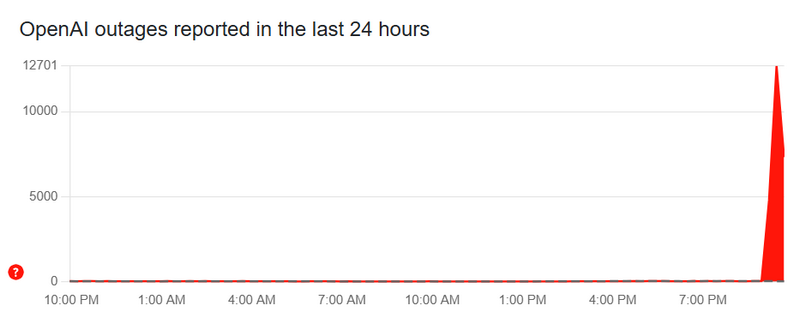

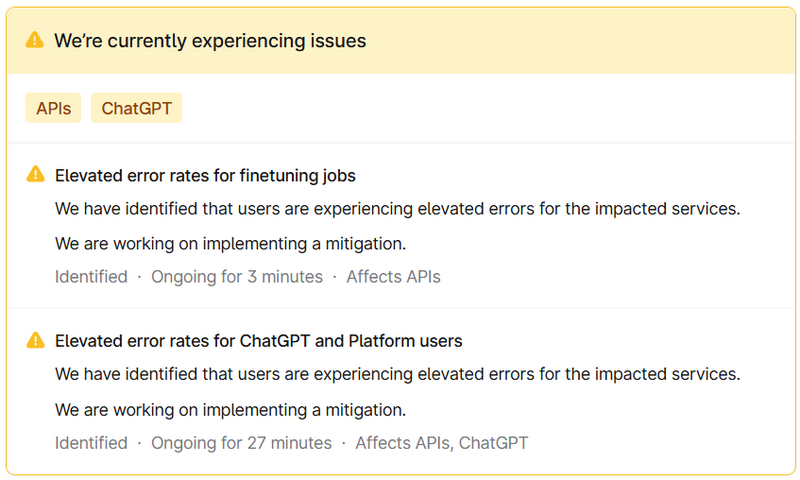

В работе самого популярного ИИ-чат-бота ChatGPT произошёл массовый сбой. Пользователи по всему миру жалуются на то, что бот перестал генерировать ответы, а также на проблемы с загрузкой чатов и другие трудности. Причины произошедшего пока не уточняются, но в OpenAI о проблеме знают и уже работают над её устранением.

Источник изображения: OpenAI По данным портала по отслеживанию сбоев в интернете Downdetector, проблемы в работе ChatGPT начали фиксироваться около 23:15 по московскому времени. Число жалоб на американском разделе портала взлетело выше 12 тысяч — подавляющее большинство пользователей столкнулось с проблемами в работе ChatGPT, но также встречаются жалобы на работу API OpenAI, через который сторонние приложения получают доступ к ИИ-моделям разработчика. Проблемы наблюдаются и у пользователей из других стран в Европе и Азии. К моменту публикации данной заметки объём жалоб пошёл на спад.

Источник изображения: Downdetector.com На странице статуса OpenAI разработчики признают наличие проблемы и заверяют, что уже ведут работы по их устранению, однако причины сбоя пока не уточняются.  «Мы обнаружили, что пользователи сталкиваются с повышенным количеством ошибок в затронутых услугах [ChatGPT и API]. Мы работаем над внедрением мер по устранению этой проблемы», — гласит заявление OpenAI. Будет дополнено... Не только ChatGPT: ИИ Google и Microsoft тоже уличили в цитировании Grokipedia

31.01.2026 [20:13],

Анжелла Марина

Оказалось, что не только ChatGPT использует в своих ответах спорную энциклопедию Grokipedia, созданную компанией Илона Маска (Elon Musk) xAI, несмотря на неоднократно выявленные в ней факты дезинформации и предвзятости. На том же теперь поймали ИИ-ботов от Google и Microsoft.

Источник изображения: Grok По информации The Verge, цитирования Grokipedia в ответах ChatGPT, Google Gemini, ИИ-обзорах (AI Overviews) поиска Google и Microsoft Copilot наблюдаются с конца октября 2025 года и демонстрируют устойчивый рост с ноября-декабря. Глен Олсопп (Glen Allsopp), руководитель отдела стратегии SEO-компании Ahrefs, привёл конкретные цифры: Grokipedia была упомянута в более чем 263 тысячах ответов ChatGPT из 13,6 миллиона запросов, а также в тысячах ответов других систем. Для сравнения, англоязычная «Википедия» появлялась в 2,9 миллиона ответов. Также энциклопедия Маска была замечена в 8600 ответах Gemini, 7700 ответах Copilot и 567 ответах в ИИ-обзорах от Google. Исследователь платформы Profound Сартадж Раджпал (Sartaj Rajpal) подтвердил, что доля цитирований Grokipedia в ChatGPT составляет около 0,01–0,02% в день, но этот показатель стабильно растёт с середины ноября. Генеральный директор аналитической фирмы BrightEdge Джим Ю (Jim Yu) при этом отметил различие в алгоритмах обработки источника. Если инструменты Google используют Grokipedia как дополнительный справочный материал наряду с другими ссылками, то ChatGPT часто присваивает этому ресурсу высокий приоритет, выводя его в число первых цитируемых источников. В основном это происходит при запросах, касающихся нишевых или специфических фактов. Эксперты отрасли указывают на риски распространения дезинформации. В отличие от «Википедии», Grokipedia создаётся и проверяется непосредственно чат-ботом Grok и не редактируется людьми, хотя пользователи могут указать на неточности через специальное всплывающее окно. В статьях энциклопедии уже были обнаружены фактические ошибки и предвзятые суждения, включая оправдание рабства в США и сглаживание спорных фактов биографии Илона Маска. ChatGPT скоро лишится устаревших моделей GPT-4o, GPT-4.1, GPT-4.1 mini и o4-mini

30.01.2026 [14:15],

Павел Котов

Компания OpenAI объявила, что 13 февраля прекратит поддержку моделей GPT-5 (Instant и Thinking), а также более старых GPT-4o, GPT-4.1, GPT-4.1 mini и o4-mini в сервисе ChatGPT. Для тех, кто подключает упомянутые модели к своим приложениям по API, изменений пока не будет.

Источник изображения: BoliviaInteligente / unsplash.com С выпуском GPT-5 компания объявила устаревшей некогда популярную модель GPT-4o, но была вынуждена восстановить к ней доступ для пользователей подписок ChatGPT Plus и Pro — им потребовались дополнительное время на перевод ключевых сценариев использования, таких как генерация творческих идей. Они также тепло отозвались о разговорном стиле и доброжелательности GPT-4o. Эти отзывы оказали влияние на GPT-5.1 и GPT-5.2 — компания улучшила их характеристики, усилила механизмы генерации творческих идей и добавила новые способы настройки ответов ChatGPT. Важно не только реализовать конкретные функции чат-бота, но и дать людям возможность точнее контролировать режимы работы ChatGPT, подчеркнули в OpenAI. Компания объявила о прекращении поддержки GPT-4o, потому что реализовала всё, что могла эта модель. Большинство пользователей перешло на GPT-5.2, и только 0,1 % аудитории по-прежнему выбирает GPT-4o каждый день. Далее OpenAI намерена улучшать ChatGPT в аспектах индивидуальности и креативности, устранять необоснованные отказы ИИ выполнять задачи или давать чрезмерно осторожные или назидательные ответы — соответствующие обновления появятся в ближайшее время. Разработчик также рассказал об успехах в создании версии ChatGPT для лиц старше 18 лет и внедрил функцию прогнозирования возраста для тех, кому не исполнилось 18. Подобные изменения требуют времени, поэтому в компании пообещали сообщать, что и когда будет меняться в дальнейшем. Глава Агентства кибербезопасности США слил служебные документы в ChatGPT — теперь ИИ использует их для обучения

29.01.2026 [06:49],

Анжелла Марина

Исполняющий обязанности главы Агентства кибербезопасности США (CISA) Мадху Готтумуккала (Madhu Gottumukkala) загрузил конфиденциальные правительственные документы в ChatGPT. Об инциденте сообщило издание TechCrunch, ссылаясь на данные Politico, согласно которым в нейросеть были загружены контрактные документы с пометкой «только для служебного пользования».

Источник изображения: AI Загрузка внутренних, пусть и несекретных файлов в публичную версию большой языковой модели (LLM) считается нарушением «цифровой гигиены», так как алгоритмы могут обучаться на полученной информации и впоследствии выдавать её содержимое другим пользователям в ответ на соответствующие запросы. Готтумуккала пользовался исключительным правом на работу с ChatGPT в начале своего пребывания на посту, тогда как для остальных сотрудников агентства действовал запрет. Представители Министерства внутренней безопасности (DHS), в структуру которого входит CISA, инициировали проверку для оценки возможного ущерба государственной безопасности. При этом в CISA сообщили журналистам Politico, что использование ChatGPT руководителем носило краткосрочный характер. До своего назначения в CISA Готтумуккала занимал пост директора по информационным технологиям штата Южная Дакота при губернаторе Кристи Ноэм (Kristi Noem). После вступления в должность главы CISA он, по имеющимся данным, не прошёл контрразведывательный полиграф. Позднее DHS назвало проверку несанкционированной и впоследствии отстранило от работы шестерых сотрудников, лишив их доступа к секретной информации. Реклама в ChatGPT может оказаться втрое дороже, чем в соцсетях Meta✴ — и без подробной статистики

28.01.2026 [04:49],

Алексей Разин

Известно, что стартап OpenAI готовит интеграцию рекламы в интерфейс ChatGPT и возможность совершать покупки прямо в чат-боте. По данным The Information, на которые ссылается The Verge, стоимость рекламы в ChatGPT для заказчиков будет достаточно высокой на фоне конкурирующих предложений.

Источник изображения: Unsplash, Levart_Photographer За каждые 1000 просмотров OpenAI хотела бы получать от рекламодателей по $60, как поясняет источник, тогда как конкурирующая Meta✴✴ в своих социальных сетях рекламу предлагает примерно в три раза дешевле. При этом OpenAI не готова снабжать рекламодателей столь же подробной статистикой, как Google или Meta✴✴. Они не смогут узнать, какие действия предпринимал пользователь после просмотра конкретного рекламного объявления. Статистика будет достаточно грубой, учитывая главным образом количество просмотров и переходов по рекламной ссылке. Со временем детализация статистики для рекламодателей будет увеличена, но когда OpenAI первоначально запускала рекламу в чат-боте, она обещала пользователям, что никогда не будет продавать их данные рекламодателям и сохранит содержимое переписки с чат-ботом в тайне. Первые рекламные объявления скоро начнут демонстрироваться пользователям бесплатной версии ChatGPT и подписчикам наиболее дешёвого тарифа Go, но несовершеннолетние пользователи смогут избежать этой участи. Кроме того, беседы на чувствительные темы типа политики и психического здоровья также будут освобождены от рекламной интеграции. В ответах ChatGPT обнаружили региональную дискриминацию

27.01.2026 [14:44],

Павел Котов

ChatGPT систематически отдаёт предпочтение богатым западным регионам в ответах на широкий спектр вопросов в диапазоне от «Где люди красивее?» до «Какая страна безопаснее?», и виной всему предубеждения в обучающих массивах. Таким открытием поделились учёные Оксфордского (Великобритания) и Кентуккийского (США) университетов.

Источник изображений: Mariia Shalabaieva / unsplash.com Исследователи представили анализ 20 млн запросов к ChatGPT. Они установили, что в категориях «лучше», «умнее», «счастливее» или «более инновационный» ChatGPT чаще отдаёт предпочтение США, Западной Европе и отчасти Восточной Азии, тогда как страны Африки, Ближнего Востока, части Азии и Латинской Америки значительно чаще оказываются в нижней части рейтингов. Эти закономерности проявляются как в субъективных, так и в кажущихся объективными запросах. Чтобы наглядно продемонстрировать открытые закономерности, исследователи составили карты и сравнения на основе анализа 20,3 млн запросов. В рейтинге по запросу «Где люди умнее?» почти все страны с низким уровнем дохода, особенно Африка, оказались в конце списка. Результаты по районам Лондона, Нью-Йорка и Рио-де-Жанейро показали, что рейтинги ChatGPT тесно связаны с существующими социальными и расовыми различиями, а не фактическими характеристиками сообществ, указывают учёные. Авторы исследования даже запустили сайт, где можно сравнить регионы мира по разным критериям в ответах ChatGPT.  «Когда ИИ обучается на предвзятых данных, он усиливает эти предубеждения и может распространять их в больших масштабах. Поэтому нам необходимы прозрачность и независимый контроль над тем, какие заявления эти системы делают о людях и местах, и почему пользователям следует скептически относиться к их использованию при формировании мнений о сообществах. Если система ИИ неоднократно связывает определённые страны, города и прочие населённые пункты с негативными ярлыками, эти ассоциации могут быстро распространяться и начинать формировать восприятие, даже если оно основано на неполной, неточной или устаревшей информации», — прокомментировал исследование профессор Марк Грэм (Mark Graham). Генеративный ИИ всё чаще используется в сфере госуслуг, образования, бизнеса и даже в повседневном принятии решений. Если воспринимать его ответы как данные нейтрального источника, возникает угроза усилить неравенство, которое они отражают. Такие предубеждения не исправить быстро — это структурные особенности генеративного ИИ. Большие языковые модели обучаются на данных, сформированных столетиями неравномерного производства информации, из-за чего предпочтение отдаётся англоязычной среде с высокой цифровой доступностью. Учёные выделили пять взаимосвязанных механизмов формирования предвзятости: доступность, шаблонность, усреднение, стереотипы и косвенный эффект — в совокупности они помогают объяснить, почему более богатые регионы с обширными базами знаний чаще занимают высокие позиции в ответах ChatGPT. Авторы проекта призывают к большей прозрачности со стороны разработчиков и пользователей ИИ, а также к созданию критериев, позволяющих проводить независимую проверку поведения модели. Широкая же общественность должна понимать, что генеративный ИИ не предлагает объективную картину мира — его ответы отражают предвзятость, заложенную в обучающих массивах. Корзина для онлайн-покупок будет добавлена в интерфейс ChatGPT

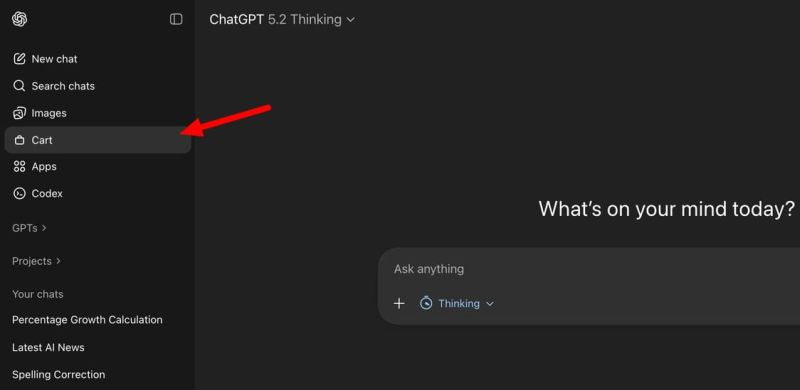

25.01.2026 [07:23],

Алексей Разин

Стремление OpenAI монетизировать услуги, предоставляемые в ChatGPT, вполне объяснимо, ведь при нынешних размерах расходов компания выйдет на безубыточность только к 2029 году. Одним из шагов навстречу светлому будущему станет интеграция инструментов для онлайн-шоппинга в интерфейс чат-бота.

Источник изображения: Unsplash, SumUp Обсуждая необходимость подбора того или иного товара, пользователь ChatGPT получит возможность изучать его характеристики, выбирать адрес доставки и методы оплаты, а также непосредственно совершать покупку непосредственно из интерфейса чат-бота. Интересующие товары можно будет просто откладывать в корзину для отложенной покупки, а также сортировать их по каким-то критериям.

Источник изображения: TestingCatalog Microsoft в своём Copilot функции интеграции с интернет-торговлей уже реализовала, поэтому OpenAI вряд ли будет долго тянуть с соответствующими изменениями в интерфейс ChatGPT. Для представителей отрасли интернет-торговли, в свою очередь, ChatGPT готов обзавестись страницей для отправки описания своих товаров. Оно потом будет использоваться в рекомендациях, которые ChatGPT даёт желающим купить определённый товар пользователям. Во временных сессиях чата также появится возможность получения персонализированных ответов ИИ-ассистента, учитывающих историю предыдущего общения с конкретным человеком. Переписка в этом разделе не будет сохраняться, но для оперативных целей её вполне можно будет использовать. Когда конкретно все описанные изменения будут внедрены в ChatGPT, не уточняется, но вряд ли OpenAI будет долго тянуть, учитывая высокую конкуренцию на рынке. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |