|

Опрос

|

реклама

Быстрый переход

Microsoft представила три новые малые ИИ-модели семейства Phi-4

01.05.2025 [16:48],

Дмитрий Федоров

Microsoft выпустила три новые малые языковые модели (SLM) с открытой лицензией: Phi-4-mini-reasoning, Phi-4-reasoning и Phi-4-reasoning-plus. Каждая из моделей относится к классу рассуждающих (reasoning) моделей, ориентированных на логическую верификацию решений и тщательную проработку сложных задач. Эти ИИ-модели стали продолжением инициативы Microsoft по разработке компактных ИИ-систем — семейства Phi, впервые представленного год назад как фундамент для приложений, работающих на устройствах с ограниченными вычислительными возможностями.

Источник изображения: Jackson Sophat / Unsplash Наиболее производительной из представленных является ИИ-модель Phi-4-reasoning-plus. Она представляет собой адаптацию ранее выпущенной Phi-4 под задачи логического вывода. По утверждению Microsoft, её качество ответов близко к DeepSeek R1, несмотря на существенную разницу в объёме параметров: у DeepSeek R1 — 671 млрд, тогда как у Phi-4-reasoning-plus их значительно меньше. Согласно внутреннему тестированию Microsoft, эта модель показала результаты, соответствующие ИИ-модели OpenAI o3-mini в рамках бенчмарка OmniMath, оценивающего математические способности ИИ.

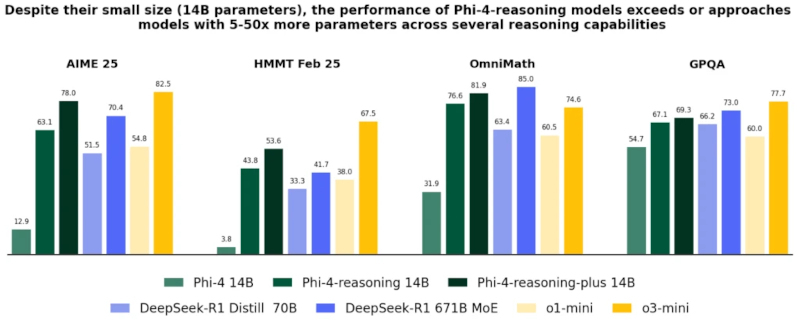

Модели Phi-4-reasoning и Phi-4-reasoning-plus (14 млрд параметров) демонстрируют превосходство над базовой Phi-4 и уверенно конкурируют с более крупными системами, включая DeepSeek-R1 Distill (70 млрд параметров) и OpenAI o3-mini, в задачах математического и логического мышления (AIME, HMMT, OmniMath, GPQA). Источник изображения: Microsoft Модель Phi-4-reasoning содержит 14 млрд параметров и обучалась на основе «качественных» данных из интернета, а также на отобранных демонстрационных примерах из o3-mini. Она оптимизирована для задач в области математики, естественных наук и программирования. Таким образом, Phi-4 reasoning ориентирована на высокоточные вычисления и аналитическую интерпретацию данных, оставаясь при этом относительно компактной и доступной для использования на локальных вычислительных платформах.

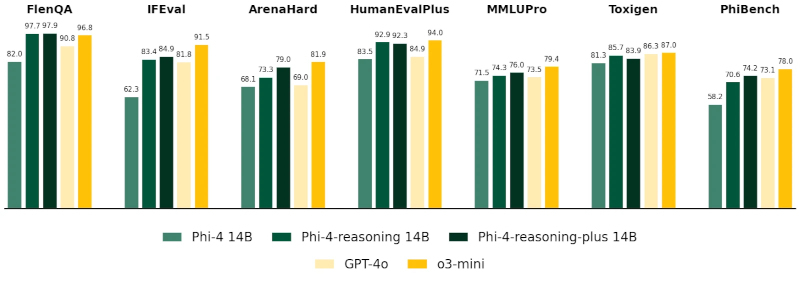

На универсальных тестах, включая FlenQA, IFEval, HumanEvalPlus, MMLUPro, ToxiGen и PhiBench, модели Phi-4-reasoning-plus демонстрируют точность, сопоставимую с GPT-4o и o3-mini, несмотря на меньший объём параметров (14 млрд параметров), особенно в задачах программирования, логики и безопасности. Источник изображения: Microsoft Phi-4-mini-reasoning — самая малогабаритная из представленных SLM. Её размер составляет около 3,8 млрд параметров. Она обучалась на основе приблизительно 1 млн синтетических математических задач, сгенерированных ИИ-моделью R1 китайского стартапа DeepSeek. Microsoft позиционирует её как ИИ-модель для образовательных сценариев, включая «встроенное обучение» на маломощных и мобильных устройствах. Благодаря компактности и точности, эта ИИ-модель может применяться в интерактивных обучающих системах, где приоритетом являются скорость отклика и ограниченность вычислительных ресурсов.

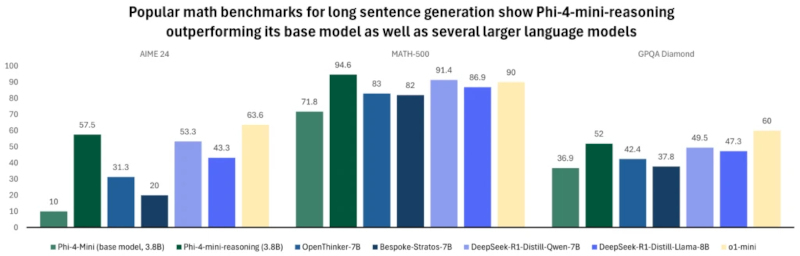

Phi-4-mini-reasoning (3,8 млрд параметров) значительно превосходит свою базовую версию и модели с вдвое большим размером на бенчмарках AIME 24, MATH-500 и GPQA Diamond, а также сопоставима или превосходит OpenAI o1-mini по точности генерации длинных математических ответов. Источник изображения: Microsoft Все три ИИ-модели доступны на платформе Hugging Face и распространяются под открытой лицензией. По словам Microsoft, при их обучении использовались дистилляция, обучение с подкреплением и высококачественные обучающие данные. Эти методы позволили сбалансировать размер SLM и их вычислительную производительность. ИИ-модели достаточно компактны, чтобы использоваться в средах с низкой задержкой, но при этом способны решать задачи, требующие строгости логического построения и достоверности результата. Ранее такие задачи были характерны лишь для гораздо более крупных ИИ. Microsoft выпустила три новые ИИ-модели ИИ Phi-3.5 — они превосходят аналоги от Google и OpenAI

23.08.2024 [11:03],

Павел Котов

Компания Microsoft не стала почивать на лаврах своего партнёрства с OpenAI и выпустила три новые системы искусственного интеллекта, относящиеся к семейству Phi — языковые и мультимодальные модели.

Источник изображения: VentureBeat / Midjourney Три новых проекта линейки Phi 3.5 включают большую языковую модель базового варианта Phi-3.5-mini-instruct на 3,82 млрд параметров, мощную Phi-3.5-MoE-instruct на 41,9 млрд параметров, а также Phi-3.5-vision-instruct на 4,15 млрд параметров — она предназначена для анализа изображений и видео. Все три модели доступны под брендом Microsoft на платформе Hugging Face по лицензии MIT — их можно загружать, производить тонкую настройку, модифицировать и использовать в коммерческих целях без ограничений. В тестах они не уступают, а иногда и превосходят такие конкурирующие продукты как Google Gemini 1.5 Flash, Meta✴✴ Llama 3.1 и даже OpenAI GPT-4o.

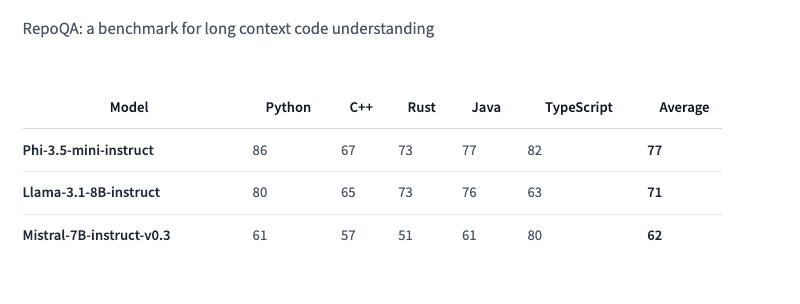

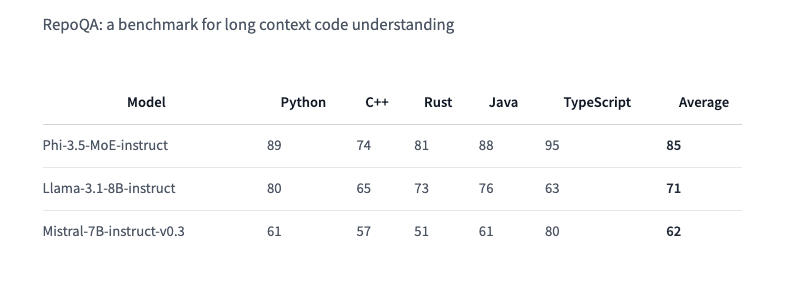

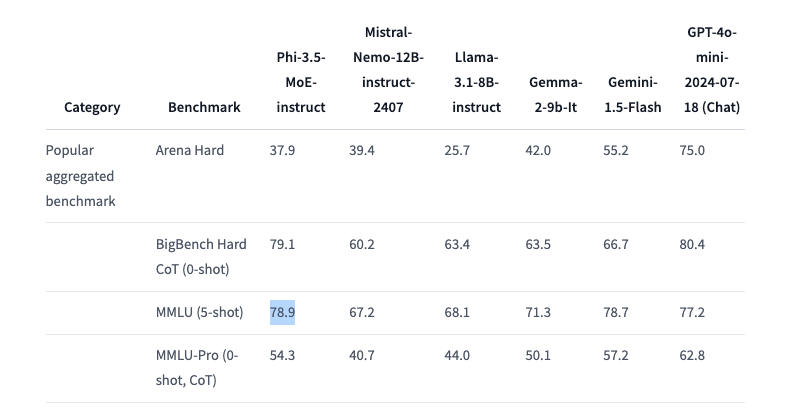

Здесь и далее источник изображения: VentureBeat / Midjourney Phi-3.5 Mini Instruct оптимизирована для окружений с ограниченными вычислительными ресурсами. Это облегчённая модель с 3,8 млрд параметров. Она предназначается для выполнения инструкций и поддерживает контекст длиной 128 тыс. токенов. Модель справляется с такими задачами как генерация кода, решение математических задач и логические рассуждения. Несмотря на свой компактный размер, Phi-3.5 Mini Instruct вполне конкурентоспособна в многоязычных и многооборотных языковых задачах. В тесте RepoQA, который используется для оценки «понимания длинного контекстного кода» она опережает, в частности, Llama-3.1-8B-instruct и Mistral-7B-instruct.  Phi-3.5 MoE (Mixture of Experts) объединяет несколько моделей различного типа, каждая из которых специализируется на собственной задаче. Архитектура модели характеризуется 42 млрд активных параметров и поддержкой контекста в 128 тыс., что позволяет применять её в требовательных приложениях — примечательно, что в документации Hugging Face говорится лишь о 6,6 млрд активных параметров. Phi-3.5 MoE демонстрирует достойные результаты в математике, генерации кода и понимании многоязычных запросов, зачастую превосходя более крупные модели в некоторых тестах, включая RepoQA; она также обошла GPT-4o mini в тесте MMLU (Massive Multitask Language Understanding) в области естественных и технических наук, а также гуманитарных и социальных дисциплин на разных уровнях знаний.  Phi-3.5 Vision Instruct объединяет возможности обработки текста и изображений. Она подходит для распознавания картинок и символов, анализа диаграмм и таблиц, а также составления сводок по видео. Vision Instruct, как и другие модели Phi-3.5, поддерживает длину контекста 128 тыс. токенов, что позволяет ей работать со сложными многокадровыми визуальными задачами. Система была обучена на синтетических и отфильтрованных общедоступных наборах данных с упором на высококачественные массивы информации с высокой плотностью рассуждений. Phi-3.5 Mini Instruct обучалась на 3,4 трлн токенов с использованием 512 ускорителей Nvidia H100-80G в течение 10 дней; модель смешанной архитектуры Phi-3.5 MoE была обучена на 4,9 трлн токенов с использованием 512 единиц Nvidia H100-80G за 23 дня; для обучения Vision Instruct на 500 млрд токенов с использованием 256 ИИ-ускорителей Nvidia A100-80G потребовались 6 дней. Всё трио Phi-3 доступно по лицензии MIT — она позволяет разработчикам свободно использовать, изменять, объединять, публиковать, распространять, сублицензировать или продавать копии продуктов. Лицензия содержит отказ от ответственности: модели предоставляются «как есть» без каких-либо гарантий — Microsoft и другие обладатели авторских прав не несут ответственности за любые претензии, убытки и прочие обязательства, которые могут возникнуть при использовании моделей. Intel ставит крест на Xeon Phi — поддержка Knights Mill и Knights Landing удалена из LLVM

27.05.2024 [20:29],

Анжелла Марина

После многих лет ожиданий и разочарований компания Intel удалила поддержку своих ускорителей Xeon Phi Knights Mill и Knights Landing из последней версии компилятора LLVM/Clang 19. Это фактически означает прекращение поддержки архитектуры MIC (Many Integrated Core), которая изначально разрабатывалась для суперкомпьютера Aurora экзафлопсного класса.

Источник изображения: Intel Процессоры Knights Mill должны были значительно увеличить производительность Aurora, но проект столкнулся с многочисленными задержками и не достиг ожидаемых показателей. Это в конечном итоге привело к отмене первой версии Aurora. Позже Министерство энергетики США изменило архитектуру Aurora, добавив в нее процессоры Intel Sapphire Rapids и графические процессоры Intel Ponte Vecchio. Однако и эта версия столкнулась с проблемами производительности и задержками срока реализации, сообщает Tom's Hardware и Phoronix. Cейчас эксафлопсный суперкомпьютер Aurora находится на пути к своему запуску и, возможно, даже в этом году. Но проблемы программного и аппаратного обеспечения, в том числе с системой охлаждения, не позволяют ему полностью раскрыть свой потенциал. Решение Intel прекратить поддержку Xeon Phi в LLVM/Clang отражает общий тренд среди основных компиляторов. Ранее в этом году поддержка была помечена устаревшей в LLVM/Clang 18, а в GCC она была объявлена устаревшей в версии 14 и полностью удалена в версии 15. Как заявила сама Intel, «удаление поддержки позволит сократить усилия по обслуживанию компилятора и упростит его дальнейшую разработку». Компания намерена сосредоточиться на специализированных решениях для искусственного интеллекта и высокопроизводительных вычислений, что, видимо, знаменует собой окончание долгого пути для продуктов линейки Xeon Phi, вдохновленных Larrabee, производство которых Intel официально прекратила еще в 2019 году. Microsoft представила Phi-3 Mini — самую маленькую ИИ-модель, которую учили на «детских книгах»

23.04.2024 [12:22],

Владимир Фетисов

Компания Microsoft представила следующую версию своей модели искусственного интеллекта Phi-3 Mini. Она стала первой из трёх небольших ИИ-моделей, которые софтверный гигант планирует выпустить в свет.

Источник изображения: geralt/Pixabay Phi-3 Mini с 3,8 млрд параметров обучается на наборе данных, который меньше по сравнению с массивом, используемым для обучения больших языковых моделей (LLM), таких как GPT-4. В настоящее время Phi-3 Mini доступна на облачной платформе Azure, а также в Hugging Face и Ollama. В дополнение к этому Microsoft планирует выпустить ИИ-модели Phi-3 Small с 7 млрд параметров и Phi-3 Medium с 14 млрд параметров. В декабре прошлого года Microsoft выпустила модель Phi-2, которая работала так же хорошо, как и более крупные модели, такие как Llama 2. По словам разработчиков, Phi-3 работает лучше предыдущей версии и может давать ответы, близкие к тем, что дают модели в 10 раз больше. Корпоративный вице-президент Microsoft Azure AI Platform Эрик Бойд (Eric Boyd) заявил, что Phi-3 Mini по своим возможностям не уступает таким LLM, как GPT-3.5, и выполнена «в меньшем форм-факторе». По сравнению с более крупными аналогами, небольшие ИИ-модели обычно дешевле в эксплуатации и лучше работают на персональных устройствах, таких как смартфоны и ноутбуки. В начале этого года СМИ писали, что Microsoft создала отдельную команду для разработки именно небольших ИИ-моделей. Наряду с Phi компания также создала модель Orca-Math, которая ориентирована на решение математических задач. Конкуренты Microsoft занимаются разработкой небольших ИИ-моделей, многие из которых нацелены на решение более простых задач, таких как обобщение документов или помощь в написании программного кода. К примеру, модели Gemma 2B и 7B от Anthropic могут обрабатывать большие научные статьи с графиками и быстро обобщать их, а недавно выпущенная модель Llama 3 от Meta✴✴ может использоваться для создания чат-ботов и помощи в написании кода. По словам Бойда, разработчики обучали Phi-3 по «учебному плану». Они вдохновлялись тем, как дети учатся на сказках, читаемых перед сном. Это книги с более простыми словами и структурами предложений, но в то же время зачастую в них поднимаются важные темы. Поскольку существующей литературы для детей при тренировке Phi-3 не хватало, разработчики взяли список из более чем 3000 тем и попросили большие языковые модели написать дополнительные «детские книги» специально для обучения Phi-3. Бойд добавил, что Phi-3 просто развивает дальше то, чему обучились предыдущие итерации ИИ-модели. Если Phi-1 была ориентирована на кодирование, а Phi-2 начала учиться рассуждать, то Phi-3 ещё лучше справляется с кодированием и рассуждениями. Хотя модели семейства Phi-3 обладают некоторыми общими знаниями, они не могут превзойти GPT-4 или другие LLM по широте охвата. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |