Компания Google представила Gemma 2 2B — компактную, но мощную языковую модель искусственного интеллекта (LLM), которая может составить конкуренцию лидерам отрасли, несмотря на свой значительно меньший размер. Новая языковая модель, содержащая всего 2,6 миллиарда параметров, демонстрирует производительность не хуже гораздо более крупных аналогов, включая OpenAI GPT-3.5 и Mistral AI Mixtral 8x7B.

Источник изображений: Google

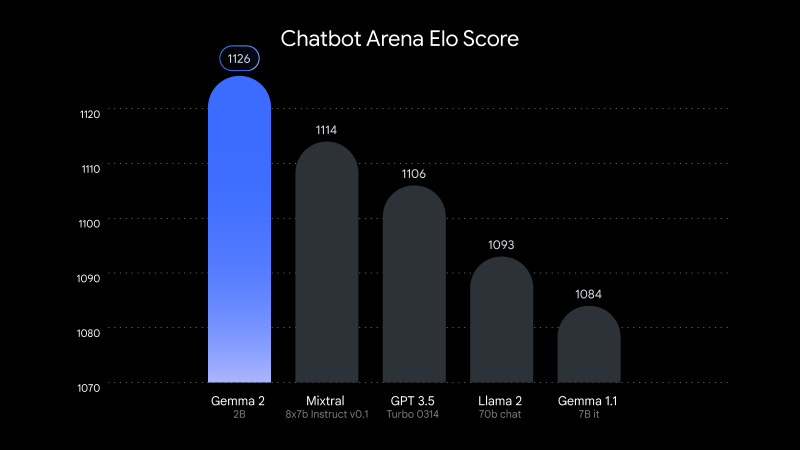

В тесте LMSYS Chatbot Arena, популярной онлайн-платформы для сравнительного тестирования и оценки качества моделей искусственного интеллекта, Gemma 2 2B набрала 1130 баллов. Этот результат немного опережает результаты GPT-3.5-Turbo-0613 (1117 баллов) и Mixtral-8x7B (1114 баллов) — моделей, обладающих в десять раз большим количеством параметров.

Google сообщает, что Gemma 2 2B также набрала 56,1 балла в тесте MMLU (Massive Multitask Language Understanding) и 36,6 балла в тесте MBPP (Mostly Basic Python Programming), что является значительным улучшением по сравнению с предыдущей версией.

Gemma 2 2B бросает вызов общепринятому мнению, что более крупные языковые модели изначально работают лучше компактных. Производительность Gemma 2 2B показывает, что сложные методы обучения, эффективность архитектуры и высококачественные наборы данных могут компенсировать недостаток в числе параметров. Разработка Gemma 2 2B также подчеркивает растущую важность методов сжатия и дистилляции моделей ИИ. Возможность эффективно компилировать информацию из более крупных моделей в более мелкие открывает возможности к созданию более доступных инструментов ИИ, при этом не жертвуя их производительностью.

Google обучила Gemma 2 2B на огромном наборе данных из 2 триллионов токенов, используя системы на базе своих фирменных ИИ-ускорителей TPU v5e. Поддержка нескольких языков расширяют её потенциал для применения в глобальных приложениях. Модель Gemma 2 2B имеет открытый исходный код. Исследователи и разработчики могут получить доступ к модели через платформу Hugging Face. Она также поддерживает различные фреймворки, включая PyTorch и TensorFlow.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018