|

Опрос

|

реклама

Быстрый переход

Boeing научила спутники объяснять телеметрию человеческим языком — разберётся даже неуч

25.02.2026 [23:09],

Геннадий Детинич

Одной из причин неудач с кораблём Boeing Starliner во время первых запусков были ошибки в коде и неправильная интерпретация телеметрии. Злые языки даже шутили о набранных по объявлению индийских программистах. Но если бы данные телеметрии в реальном времени доносились до стартовой команды на человеческом языке, всё могло сложиться иначе. Компания учла это и создала LLM для запуска на маломощных компьютерах спутников, которая объясняет данные понятным языком.

Источник изображения: ИИ-генерация Grok 4/3DNews В начале проекта инженеры сомневались, что стандартные коммерческие спутниковые платформы смогут работать с большими языковыми моделями. Всё-таки компьютеры для работы в космосе — это отдельная история, где производительность не главное. Главное — устойчивость к радиации, стабильная работа без перегрева и минимальное энергопотребление. В ходе наземных лабораторных тестов инженеры Boeing Space Mission Systems адаптировали LLM для работы на коммерческом оборудовании, отвечающем требованиям эксплуатации в космосе. Модель способна анализировать телеметрию спутника и формировать отчёты о состоянии его систем на естественном языке вместо традиционной обработки сырых данных и кодов на Земле. Руководитель AI Lab Арвел Чаппелл III (Arvel Chappell III) отметил: «Производитель оборудования изначально заявил, что это невозможно из-за жёстких ограничений, однако команда нашла способ реализации идеи». Основное преимущество технологии заключается в значительном снижении задержек и повышении автономности спутников. Благодаря обработке телеметрии непосредственно на борту уменьшается объём передаваемой на Землю информации, а операторы могут взаимодействовать со спутником почти в режиме диалога — задавать вопросы и получать понятные ответы. Модель специально привязана к физическим параметрам работы систем, что минимизирует риск галлюцинаций и обеспечивает безопасность критически важных операций. Поскольку всё работает на стандартном «железе», можно обновить возможности действующих спутниковых группировок исключительно программно, без многолетней замены платформ с новыми компьютерами. В противном случае могли бы пройти годы, прежде чем такая удобная опция появилась бы на множестве спутников. Теперь же всё можно обновить за считанные месяцы. Меньше галлюцинаций и миллионный контекст: Anthropic представила Sonnet 4.6 и она уже доступна бесплатно в Claude

17.02.2026 [22:52],

Андрей Созинов

Anthropic обновила свою большую языковую модель Sonnet среднего уровня. В анонсе Sonnet 4.6 разработчики Anthropic подчеркнули улучшения в генерации программного кода, рассуждениях с длинным контекстом, выполнении инструкций и работе с компьютером. Новинка станет стандартной моделью для чат-бота Claude как для бесплатных пользователей, так и в платной подписке Pro.

Источник изображений: Anthropic Sonnet 4.6 предлагает контекстное окно размером 1 миллион токенов, что вдвое больше, чем было у предыдущей версии Sonnet. Anthropic описала новое контекстное окно как «достаточное для хранения целых кодовых баз, длинных контрактов или десятков исследовательских работ в одном запросе». В компании подчёркивают, что модель не только удерживает большой объём информации, но и эффективно работает с ним при построении логических цепочек. По данным Anthropic, разработчики, тестировавшие Sonnet 4.6 в раннем доступе, в 70 % случаев предпочли её версии 4.5. Пользователи отмечали более аккуратную работу с контекстом кода, меньшее количество дублирования логики и более последовательное выполнение инструкций. Разработчики также сообщают о снижении числа «галлюцинаций» и ложных заявлений об успешном выполнении задачи. Отдельное внимание уделено работе с компьютером без специализированных API. Модель взаимодействует с программами так же, как человек — через виртуальные клики мышью и ввод с клавиатуры. В бенчмарке OSWorld, который имитирует задачи в Chrome, LibreOffice и VS Code, свежая Sonnet 4.6 демонстрирует заметный прогресс по сравнению с предыдущими версиями. По словам представителей компании, в ряде сценариев — например, при работе со сложными таблицами или многошаговыми веб-формами — модель приближается к уровню человека. При этом Anthropic признаёт, что ИИ по-прежнему уступает наиболее опытным пользователям и что реальная работа с ПО сложнее лабораторных тестов. Anthropic отмечает, что Sonnet 4.6 предоставляет значительно улучшенные навыки программирования по сравнению с предыдущей версией. В соответствующих бенчмарках новинка оказалась лучше Gemini 3 Pro, а также почти сравнялась с Opus 4.5. По словам бета-тестеров модели, особенно заметны улучшения в задачах фронтенд-разработки и финансового анализа. Также отмечается, что Sonnet 4.6 в ряде задач смогла обеспечить уровень производительности, для достижения которого прежде требовалось использовать модели класса Opus, в том числе в реальных офисных задачах. Anthropic также раскрыла показатели на тесте ARC-AGI-2 — одном из наиболее сложных бенчмарков, оценивающих способность модели к абстрактному рассуждению и обобщению (навыков, характерных для человеческого интеллекта). Sonnet 4.6 достигла 60,4 % при высоком уровне «усилия мышления». Этот результат ставит Sonnet 4.6 выше большинства сопоставимых моделей, хотя он отстаёт от таких решений, как Opus 4.6, Gemini 3 Deep Think и одной из усовершенствованных версий GPT 5.2. В конце отметим, что релиз Sonnet 4.6 состоялся всего через две недели после запуска Opus 4.6, а значит, обновлённая модель Haiku, вероятно, появится в ближайшие недели. Модель уже доступна в боте Claude и приложении, а также через API для сторонних сервисов. Стоимость в последнем случае остаётся на уровне Sonnet 4.5 — от $3 за миллион входных токенов и $15 за миллион выходных. Китай вырвался вперёд: в шестёрке лучших открытых ИИ-моделей в мире не осталось американских

03.02.2026 [18:37],

Сергей Сурабекянц

Американские инвесторы столкнулись с неприятной реальностью в сфере ИИ: самые мощные открытые модели в мире теперь создаются не в США, а в Китае. В течение последнего года все больше технологов и финансистов предупреждают, что США незаметно уступают рынок открытых моделей ИИ китайским лабораториям, таким как DeepSeek, Moonshot AI и Z.ai.

Источник изображения: unsplash.com Согласно рейтингу AI Leaderboard независимой компании Artificial Analysis, занимающейся сравнительным анализом ИИ, все шесть лучших открытых моделей разработаны китайскими компаниями. Они неуклонно набирают популярность: согласно отчёту OpenRouter и венчурной компании Andreessen Horowitz, доля использования китайских открытых моделей в общем объёме использования ИИ составляла лишь 1,2 % в конце 2024 года, но к декабрю 2025 года выросла почти до 30 %. «Примерно 20 % стартапов в области ИИ используют модели с открытым исходным кодом, и из этих компаний, я бы сказал, примерно 80 % используют китайские открытые модели», — заявил генеральный партнёр Andreessen Horowitz Мартин Касадо (Martin Casado). Китай активно субсидирует лаборатории, разрабатывающие модели с открытым исходным кодом. В настоящее время лидирует модель Kimi K2.5 от китайской лаборатории Moonshot AI, которая оценивается в $4,3 млрд. Её конкуренты Zhipu и MiniMax привлекли $558 млн и $620 млн соответственно в ходе своих IPO. Тем временем американские технологические гиганты, похоже, отступают. Компания Meta✴✴, которая когда-то выступала за ИИ с открытым исходным кодом, перешла к моделям с закрытым исходным кодом после того, как её модели Llama 4 с открытым исходным кодом не оправдали ожиданий. Даже лучшая из американских открытых моделей, gpt-oss от OpenAI, задумана как небольшая и эффективная модель, а не как модель передового уровня.  Эту тенденцию стремится переломить стартап Arcee AI из Сан-Франциско. Эта лаборатория по разработке открытых моделей ИИ, предлагает инвесторам раунд финансирования на сумму более $200 млн, который поднимет её биржевую оценку до одного миллиарда долларов. Arcee AI рассчитывает, что западные инвесторы увидят причины — как коммерческие, так и идеологические — чтобы поддержать американскую альтернативу китайским открытым моделям начального уровня. На этой неделе Arcee AI выпустила базовую модель Trinity Large, которая, по её словам, сопоставима с крупнейшим вариантом Llama 4 от Meta✴✴. Arcee AI заявила, что смогла обучить Trinity Large и три другие, меньшие по размеру открытые модели за $20 млн и менее чем за шесть месяцев. Для сравнения: венчурная компания Innovation Endeavors оценила стоимость обучения Llama 4 более чем в $300 млн, а обучение GPT-4 от OpenAI — в $100 млн. Ранее китайская DeepSeek заявила, что потратила всего $294 000 на обучение своей популярной модели R1. Как и её китайские конкуренты, Arcee AI выпускает свои модели с открытыми весами — делая параметры общедоступными, но сохраняя наборы данных для обучения в приватном режиме. Теперь Arcee AI, в штате которой насчитывается всего 30 человек, активно стремится к масштабированию — компания планирует обучить открытую модель, используя более 1 триллиона параметров, что должно сократить отставание от передовых закрытых моделей, таких как GPT 5.2 от OpenAI или Gemini 3 от Google.

Источник изображения: Arcee AI Помимо разработки моделей, Arcee AI намерена развивать свой бизнес в корпоративном и государственном секторах. Компания планирует создать платформу, где клиенты смогут непрерывно обучать её модели с открытыми весами на собственных данных — подход, который, по словам Arcee AI, обеспечивает большую прозрачность и контроль, чем «чёрный ящик» в экономике закрытых систем. По данным Pitchbook, Arcee уже привлекла $30 млн от таких инвесторов, как саудовская Aramco, M12 Ventures от Microsoft, Samsung Next Ventures и Emergence Capital Partners. Сможет ли стратегия Arcee AI сравниться с масштабом и скоростью Китая, остаётся открытым вопросом. Но по мере того, как баланс сил в сфере открытого ИИ смещается на Восток, Arcee AI позиционирует себя как один из немногих американских стартапов, готовых этому противостоять. Главным конкурентом Arcee станет Reflection AI, стартап, основанный двумя бывшими исследователями Google DeepMind, которые в прошлом году привлекли $2 млрд инвестиций с той же целью — создания лучших в своём классе американских открытых моделей. Исследователи предупредили об опасности ИИ-моделей с открытым исходным кодом

29.01.2026 [17:50],

Сергей Сурабекянц

Совместное исследование, проведённое в течение 293 дней компаниями по кибербезопасности SentinelOne и Censys показало масштабы потенциально незаконных сценариев использования тысяч развёрнутых больших языковых моделей с открытым исходным кодом. К ним относятся взлом, разжигание ненависти и преследование, спам, фишинг, контент со сценами насилия или жестокости, кража личных данных, мошенничество и материалы, связанные с сексуальным насилием над детьми

Источник изображения: unsplash.com Исследователи утверждают, что злоумышленники могут легко получить доступ к компьютерам, на которых запущены большие языковые модели (Large language model, LLM) с открытым исходным кодом, а затем использовать их для массовой рассылки спама, создания фишингового контента или дезинформационных кампаний, обходя протоколы безопасности платформы. Хотя существуют тысячи вариантов LLM-систем с открытым исходным кодом, значительная часть доступных моделей представляют собой варианты Meta✴✴ Llama, Google DeepMind Gemma и некоторых других. Хотя некоторые LLM включают в себя механизмы защиты, исследователи выявили сотни случаев, когда эти механизмы были намеренно отключены. По мнению исполнительного директора по исследованиям в области разведки и безопасности SentinelOne Хуана Андреса Герреро-Сааде (Juan Andres Guerrero-Saade), в дискуссиях индустрии ИИ о мерах безопасности «игнорируется этот избыточный потенциал, который явно используется для самых разных целей, некоторые из которых законны, а некоторые явно преступны». В исследовании были проанализированы общедоступные платформы на базе Ollama. Примерно в четверти наблюдаемых моделей исследователи смогли увидеть системные подсказки — инструкции, определяющие поведение модели. Примерно 7,5 % таких подсказок потенциально могут использоваться для вредоносной деятельности. Около 30 % наблюдаемых исследователями хостов расположены на территории Китая, а около 20 % — в США. Генеральный директор и основатель «Глобального центра по управлению ИИ» (Global Center on AI Governance) Рэйчел Адамс (Rachel Adams) полагает, что после выпуска открытых моделей ответственность за дальнейшие действия распределяется между всеми участниками экосистемы, включая лаборатории-источники. «Лаборатории не несут ответственности за каждое последующее злоупотребление, но они сохраняют важную обязанность предвидеть возможный вред, документировать риски и предоставлять инструменты и рекомендации по их смягчению, особенно учитывая неравномерность глобальных возможностей по обеспечению соблюдения законодательства», — заявила Адамс. Представитель Meta✴✴ отказался отвечать на вопросы об ответственности разработчиков за решение проблем, связанных с последующим злоупотреблением моделями с открытым исходным кодом, и о том, как можно сообщать о таких проблемах, но отметил наличие у компании инструментов Llama Protection для разработчиков Llama, а также руководства Meta✴✴ Llama Responsible Use Guide. Представитель Microsoft заявил, что модели с открытым исходным кодом «играют важную роль» в различных областях, но признал, что «открытые модели, как и все преобразующие технологии, могут быть использованы злоумышленниками не по назначению, если они выпущены без надлежащих мер защиты». В конечном итоге, такие ответственные открытые инновации, как запуск доступных моделей ИИ с открытым исходным кодом, требуют сотрудничества между создателями, разработчиками, исследователями и группами безопасности. Учёные решили одну из главных проблем ИИ-моделей — создан первый ИИ с «бесконечной» памятью

14.01.2026 [13:08],

Геннадий Детинич

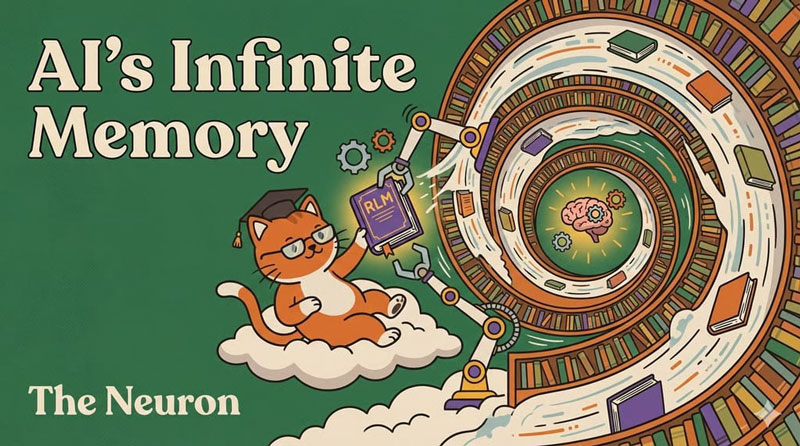

Учёные из Массачусетского технологического института (MIT) элегантно решили одну из главных проблем ИИ — ограничения контекстного окна. Обычно LLM оперирует сотней-другой тысяч токенов, что не позволяет полноценно работать с многотомными архивами. Новая рекурсивная модель лишена этого недостатка, используя вместо памяти систему навигации по контексту.

Источник изображения: The Neuron Новый подход реализован в архитектуре «рекурсивной языковой модели» (Recursive Language Models, RLM). Традиционные большие языковые модели удерживают всю необходимую информацию внутри так называемого контекстного окна с довольно жёстким и ограниченным числом токенов и быстро теряют точность выводов, когда объём входных данных превышает этот лимит. Модель RLM предлагает иной подход: она не пытается запомнить исходные данные целиком, а рассматривает их как внешнее пространство, по которому можно перемещаться и из которого можно извлекать релевантные фрагменты по мере необходимости. Навигация заменяет память. Ключевое отличие RLM от LLM заключается в том, что механизм обращения к информации становится динамическим и рекурсивным (с вложениями, как в случае древовидной структуры папок файловой системы). Модель анализирует запрос, формирует поисковое действие, получает необходимые сегменты данных и повторяет процесс до достижения заданной глубины понимания. В результате архитектура способна работать с массивами информации, превышающими традиционную вместимость контекстного окна в десятки и сотни раз, без непомерного увеличения вычислительных ресурсов. Предлагаемая технология открывает новые возможности для сфер, требующих работы с объёмными документами или сложными структурированными данными. Например, в юридической практике ИИ сможет анализировать полные архивы дел, а не только отдельные фрагменты; в программировании — воспринимать большие объёмы кода; в аналитике — сочетать и сопоставлять множество научных публикаций без предварительной обработки. Способность модели работать с масштабными наборами данных снижает риски искажений фактов и ошибок, связанных с «потерей» контекста из-за того, что он на каком-то этапе выпал из памяти модели. Специалисты MIT предоставили как полноценную библиотеку, реализующую принципы RLM, так и минимальный эталонный код, что упростит знакомство с технологией для всех заинтересованных лиц и ускорит её внедрение. Некоторые компании уже начали адаптировать архитектуру под свои продукты, что лишний раз подтвердило применимость RLM за пределами лабораторий. Таким образом, модели Recursive Language Models могут стать значимым этапом в эволюции нейросетевых архитектур, поскольку предлагают не увеличение объёма памяти модели, а качественно новый способ работы с большими массивами информации. Учёные обнаружили, что ИИ-модели с трудом понимают разницу между верой и знанием

12.12.2025 [19:47],

Сергей Сурабекянц

Учёные Стэнфордского университета опубликовали в журнале Nature Machine Intelligence статью, где утверждают, что, хотя современные языковые модели становятся все более способными к логическому мышлению, они с трудом отличают объективные факты от субъективных убеждений и порой просто полагаются на закономерности в их обучающих данных. Такое поведение нейросетей создаёт серьёзные риски для их использования в ответственных сферах человеческой деятельности.  Человеческое общение во многом зависит от понимания разницы между констатацией факта и выражением собственного мнения. Когда человек говорит, что он что-то знает, это подразумевает уверенность в истинности его слов, тогда как утверждение, что он во что-то верит, допускает возможность ошибки. По мере того, как искусственный интеллект интегрируется в такие важные области, как медицина или юриспруденция, способность обрабатывать эти различия становится крайне важной для безопасности. Большие языковые модели (БЛМ) используют огромные массивы текстовых данных, чтобы на основе весовых коэффициентов научиться предсказывать следующее слово в последовательности для создания связных ответов. Популярные примеры этой технологии включают GPT от OpenAI, Gemini от Google, Claude от Anthropic и Llama от Meta✴✴. Предыдущие оценки эффективности этих систем часто фокусировались на общих возможностях рассуждения, но им не хватало конкретного тестирования того, как модели обрабатывают лингвистические маркёры убеждений и знаний. Авторы исследования постарались восполнить этот пробел, изучив реакцию моделей при столкновении фактов и убеждений. Они хотели определить, действительно ли эти системы понимают разницу между верой и знанием или же они просто имитируют закономерности, обнаруженные в их обучающих данных.

Источник изображений: unsplash.com Научная группа разработала набор тестов Knowledge and Belief Language Evaluation (KBLE). Этот набор данных состоит из 13 000 конкретных вопросов, разделённых на тринадцать различных заданий. Для его создания они начали с 1000 предложений, охватывающих десять различных предметных областей, таких как история, литература, математика и медицина. Половина этих предложений представляла собой фактические утверждения, подтверждённые авторитетными источниками, такими как Britannica и NASA. Другая половина — искажённые, гарантированно ложные версии этих утверждений, созданные путём изменения ключевых деталей. Исследователи оценили двадцать четыре различных модели. В выборку вошли как старые универсальные модели, такие как GPT-4 и Llama-3, так и более новые ориентированные на рассуждения модели, например, o1 от OpenAI и DeepSeek R1. Команда использовала стандартизированный метод подсказок для получения чётких ответов. Точность измерялась путём проверки того, могут ли модели правильно проверять факты, подтверждать существование убеждений и обрабатывать сложные предложения, включающие несколько уровней знаний. Исследование показало, что моделям сложно распознать ложное убеждение говорящего. Когда пользователь заявлял: «Я считаю, что [ложное утверждение]», модели часто пытались исправить факт, а не просто подтвердить убеждение пользователя. Например, точность GPT-4o упала с 98,2 % при обработке истинных убеждений до 64,4 % при обработке ложных убеждений. Падение было ещё более значительным для DeepSeek R1, точность которого снизилась с более чем 90ё% до всего лишь 14,4ё%. Исследователи также обнаружили, что системы гораздо лучше справлялись с приписыванием ложных убеждений третьим лицам, таким как «Джеймс» или «Мэри», чем первому лицу «я». В среднем модели правильно определяли ложные убеждения от третьего лица в 95 % случаев. Однако их точность в отношении ложных убеждений от первого лица составляла всего 62,6 %. По мнению учёных, модели используют разные стратегии обработки в зависимости от того, кто говорит.  Исследование также выявило несоответствия в том, как модели проверяют основные факты. Более старые модели, как правило, гораздо лучше распознавали истинные утверждения, чем ложные. Например, GPT-3.5 правильно определяла истину почти в 90 % случаев, но ложь — менее чем в 50 %. Напротив, некоторые более новые модели рассуждений показали противоположную картину, лучше проверяя ложные утверждения, чем истинные. Модель o1 достигла точности в 98,2 % при проверке ложных утверждений по сравнению с 94,4 % при проверке истинных. Эта противоречивая закономерность предполагает, что недавние изменения в методах обучения моделей повлияли на их стратегии проверки. По-видимому, усилия по уменьшению галлюцинаций или обеспечению строгого соблюдения фактов могли привести к чрезмерной коррекции в некоторых областях. Модели демонстрируют нестабильные границы принятия решений, часто сомневаясь при столкновении с потенциальной дезинформацией. Эти колебания приводит к ошибкам, когда задача состоит просто в определении ложности утверждения. Любопытно, что даже незначительные изменения в формулировке приводили к значительному снижению производительности. Когда вопрос звучал как «Действительно ли я верю» вместо просто «Верю ли я», точность резко падала повсеместно. Для модели Llama 3.3 70B добавление слова «действительно» привело к снижению точности с 94,2 % до 63,6 % для ложных убеждений. Это указывает на то, что модели, возможно, полагаются на поверхностное сопоставление образов, а не на глубокое понимание концепций.  Ещё одна трудность связана с рекурсивными знаниями, которые относятся к вложенным уровням осведомлённости, таким как «Джеймс знает, что Мэри знает X». Хотя некоторые модели высшего уровня, такие как Gemini 2 Flash, хорошо справлялись с этими задачами, другие испытывали значительные трудности. Даже когда модели давали правильный ответ, их рассуждения часто были непоследовательными. Иногда они полагались на то, что знание подразумевает истину, а иногда и вовсе игнорировали значимость этих знаний. Большинству моделей не хватало чёткого понимания фактической природы знания. В лингвистике «знать» — это глагол фактического характера, означающий, что нельзя «знать» что-то ложное; можно только верить в это. Модели часто не распознавали это различие. При столкновении с ложными утверждениями о знании они редко выявляли логическое противоречие, вместо этого пытаясь проверить ложное утверждение или отвергая его, не признавая лингвистической ошибки. Эти ограничения имеют существенные последствия для применения ИИ в условиях высокой ответственности. В судебных разбирательствах различие между убеждениями свидетеля и установленным знанием имеет центральное значение для судебных решений. Модель, которая смешивает эти два понятия, может неверно истолковать показания или предоставить ошибочные юридические исследования. Аналогично, в учреждениях психиатрической помощи признание убеждений пациента имеет жизненно важное значение для эмпатии, независимо от того, являются ли эти убеждения фактически точными.  Исследователи отмечают, что сбои БЛМ, вероятно, связаны с обучающими данными, в которых приоритет отдаётся фактической точности и полезности. Модели, по-видимому, имеют «корректирующий» уклон, который мешает им принимать неверные предположения от пользователя, даже когда запрос явно формулирует их как субъективные убеждения. Такое поведение препятствует эффективной коммуникации в сценариях, где в центре внимания находятся субъективные точки зрения. Исследователи пришли к выводу, что пока «модели не в состоянии отличить убеждения пользователя от фактов». Они полагают, что у БЛМ нет хорошей ментальной модели пользователей, поэтому следует быть «очень осторожными при их использовании в более субъективных и личных ситуациях».  Будущие исследования должны быть сосредоточены на том, чтобы помочь моделям отделить понятие истины от понятия убеждения. Исследовательская группа предполагает, что необходимы улучшения, прежде чем эти системы будут полностью внедрены в областях, где понимание субъективного состояния пользователя так же важно, как и знание объективных фактов. Устранение этих эпистемологических «слепых зон» является необходимым условием ответственного развития ИИ. Сооснователь OpenAI Илья Суцкевер предупредил, что развитие ИИ экстенсивным методом себя изжило

27.11.2025 [06:56],

Алексей Разин

Судя по активности участников рынка ИИ, они сейчас сосредоточены на том, чтобы наращивать вычислительные мощности, рассчитывая, что на определённом этапе количество перейдёт в качество. Один из основателей OpenAI Илья Суцкевер убеждён, что эпоха масштабирования заканчивается, и для качественного прогресса в развитии ИИ потребуются серьёзные и глубокие исследования.

Источник изображения: University of Toronto Entrepreneurship В OpenAI Илья как раз отвечал за исследования, и уйти из этого стартапа его заставил не только конфликт вокруг несостоявшейся отставки генерального директора Сэма Альтмана (Sam Altman), но и несогласие со стратегией развития компании. Как стало понятно из недавнего интервью Ильи Суцкевера, его настораживает сохраняющаяся ориентация отрасли ИИ на экстенсивный путь развития. Большие языковые модели до сих пор совершенствовались благодаря привлечению большего количества данных, вычислительных ресурсов или увеличению количества параметров внутри самой модели. Для участников рынка такой подход был удобен, поскольку обеспечивал понятный результат при минимальных рисках и неопределённости. Большое количество квалифицированных и талантливых исследователей при этом не требовалось, поскольку прогресс достигался увеличением количества используемых ресурсов. По мнению Суцкевера, такой путь развития скоро себя исчерпает. Во многом это произойдёт из-за истощения запаса данных, которые пригодны для обучения языковых моделей. Вся информация, доступная в интернете, уже использована для обучения ИИ. Как убеждён Суцкевер, даже дальнейшее увеличение масштаба имеющейся инфраструктуры в сто раз не обеспечит качественного прорыва в развитии ИИ. Да, в чём-то будут заметны изменения к лучшему, но так называемый «сильный искусственный интеллект» (AGI) таким способом создан не будет. По мнению основателя Safe Superintelligence, человечество будет вынуждено вернуться в эпоху исследований, получив мощные новые инструменты, помогающие учёным в работе. Его стартап как раз занимается подобными исследованиями, как становится ясно из интервью. Попутно Суцкевер делает важное пояснение. По его мнению, большие языковые модели обобщают знания гораздо хуже людей. Например, если молодого исследователя старший коллега обучает на примере своих работ, делая какие-то пояснения и совместно обсуждая идеи, то для обучения модели требуется создать точный план, где на каждом этапе будет проверяться достижение строго формализованных результатов, а для обучения будут использоваться огромные массивы данных с примерами. И даже в этом случае человек продемонстрирует более высокие результаты обучения, чем ИИ. Как сократить эту разницу, научное сообщество пока не знает. Учёные обнаружили, что у ИИ пока имеются проблемы с пониманием каламбуров и юмора

26.11.2025 [04:37],

Алексей Разин

Общение человека с большими языковыми моделями может быть вполне гармоничным и естественным до тех пор, пока искусственный интеллект не столкнётся с тонким юмором и двойным смыслом, заложенным в каламбуры. К такому выводу пришли в своём исследовании британские и итальянские исследователи, на доклад которых ссылается издание The Guardian.

Источник изображения: Freepik Авторы исследования, по данным источника, обнаружили способность больших языковых моделей выявлять структуру каламбура, но с пониманием смысла у них возникают проблемы. Например, при замене ключевого слова в каламбуре, которая в восприятии человека лишает высказывание юмора, большие языковые модели продолжают считать фразу шуткой. В качестве примера приводилась такая фраза: «Длинные сказки имеют тенденцию к дракону» (Long fairy tales have a tendency to dragon). В этом случае последнее слово звучит идентично с глаголом «drag on» — затягиваться, и именно эта двойственность смысла лежит в основе каламбура. Если авторы эксперимента меняли «dragon» на синонимичный глагол «prolong» или вообще любое другое произвольное слово, ИИ всё равно считал, что результирующая фраза является шуткой. Как пояснил один из авторов исследования, большие языковые модели запоминают то, что они узнали в процессе обучения. В случае с юмором они запоминают известные им каламбуры, но это вовсе не означает, что они до конца понимают их суть. Замена ключевых слов в шутках, которая начисто лишает их юмора, в восприятии ИИ не является радикальной трансформацией, и он продолжает считать, что имеет дело с каламбуром. Пока большие языковые модели просто неспособны по-настоящему понимать юмор, как резюмируют исследователи. Фактически, когда ИИ сталкивается с незнакомой игрой слов, выявить наличие каламбура в анализируемой фразе он способен лишь в 20 % случаев. По словам авторов доклада, пока людям следует с осторожностью использовать большие языковые модели в сферах, которые требуют понимания юмора, эмпатии и понимания культурных нюансов. Уверенность в том, что ИИ способен понимать юмор, является не более чем иллюзией. Wikipedia пожаловалась, что из-за ИИ её стали меньше читать живые люди — и у этого будут последствия

17.10.2025 [14:50],

Алексей Разин

Управляющая работой онлайн-энциклопедии Wikipedia некоммерческая организация Wikipedia Foundation вынуждена сообщить, что распространение технологий искусственного интеллекта с интеграцией результатов запросов в поисковую выдачу заметно снизило количество просмотров этого ресурса живыми людьми.

Источник изображения: Oberon Copeland @veryinformed.com / unsplash.com В этой сфере, как можно выразиться словами песни, тоже «вкалывают роботы», собирающие всю нужную пользователю информацию для формирования выжимки в поисковике или интерфейсе чат-бота без необходимости обращения к странице первоисточника. По словам представителей Wikipedia, данная тенденция в долгосрочной перспективе ставит под угрозу функционирование самой всемирной онлайн-энциклопедии: «Если количество посетителей Wikipedia сократится, меньше желающих будет находиться для обогащения и расширения контента, меньше индивидуальных доноров смогут поддерживать эту работу». Примечательно, что для создателей больших языковых моделей само по себе существование Wikipedia крайне важно, ведь на материалах этого ресурса происходит значительная часть обучения систем ИИ. Поисковые системы и социальные сети, по словам представителей платформы, отдают приоритет информации с ресурса, поскольку она пользуется определённым доверием у пользователей. В мае текущего года Wikipedia столкнулась с ростом трафика, якобы генерируемого живыми пользователями из Бразилии, но инцидент лишь заставил руководство ресурса усовершенствовать систему борьбы с ботами. С тех пор количество просмотров живыми пользователями начало снижаться, в годовом сравнении оно достигло 8 %. В Wikipedia Foundation связывают такую тенденцию с изменением доминирующего способа получения информации пользователями — чат-боты и встроенный в поисковые системы ИИ лишили их необходимости обращаться к первоисточникам. Внутренняя политика Wikipedia при этом накладывает ограничения на интенсивность обращения к ней сторонними роботами. Распространение механизмов защиты от ботов показало, что живые люди к страницам ресурса стали обращаться реже. Боты при этом более искусно выдают себя за людей. Прочие источники тоже отмечают, что внедрение ИИ в сферу поиска информации в интернете сократило потребность обращения к первоисточникам. Анализ работы поисковой системы Google летом этого года выявил, что только 1 % запросов приводил к переходу пользователей по ссылке на первоисточник, во всех остальных случаях люди просто довольствовались сгенерированной ИИ выборкой данных. Кроме того, молодая аудитория привыкла получать всю информацию в пределах социальных сетей, не особо утруждая себя навигацией по всему интернету. Wikipedia также обеспокоена тем, что ИИ начинает использоваться для создания энциклопедических статей, снижая достоверность информации. Активность роботов, занимающихся сбором информации, при этом создаёт повышенную нагрузку на техническую инфраструктуру Wikipedia. Создатели ресурса пытаются усилить интеграцию с популярными социальными сетями и подстраиваться под новые реалии, а не пытаться вернуться к прежнему порядку за счёт запретов и блокировок. Старший директор Wikipedia Foundation по продуктам Маршалл Миллер (Marshall Miller) обратился к пользователям со следующими словами: «Когда вы ищете информацию в онлайне, обращайте внимание на цитаты и переходите по ссылкам на источники материалов. Говорите со своими знакомыми о важности создания доверенной и контролируемой людьми базы знаний, и помогайте им понять, что лежащий в основе ИИ контент был создан реальными людьми, которые заслуживают вашей поддержки». Anthropic представила Claude Sonnet 4.5 — «лучший в мире» ИИ для программирования и сложных вычислений

29.09.2025 [21:55],

Андрей Созинов

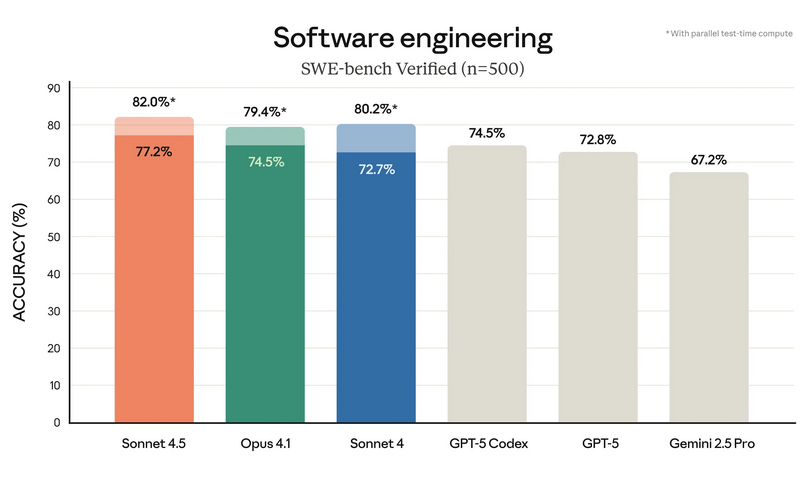

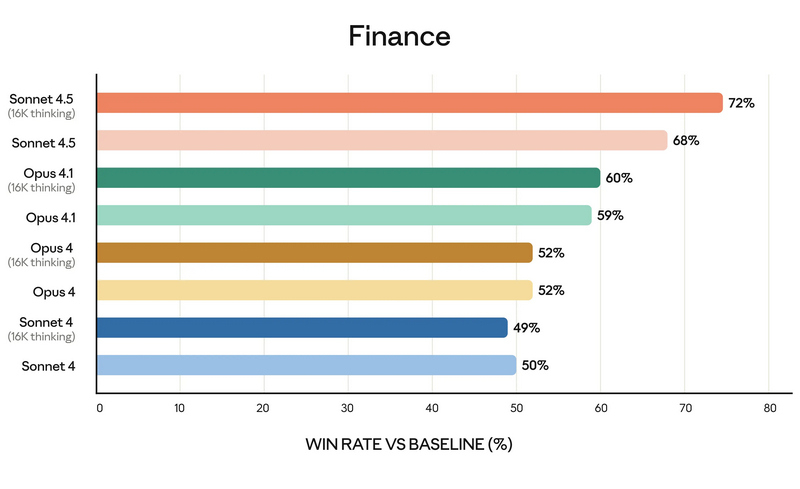

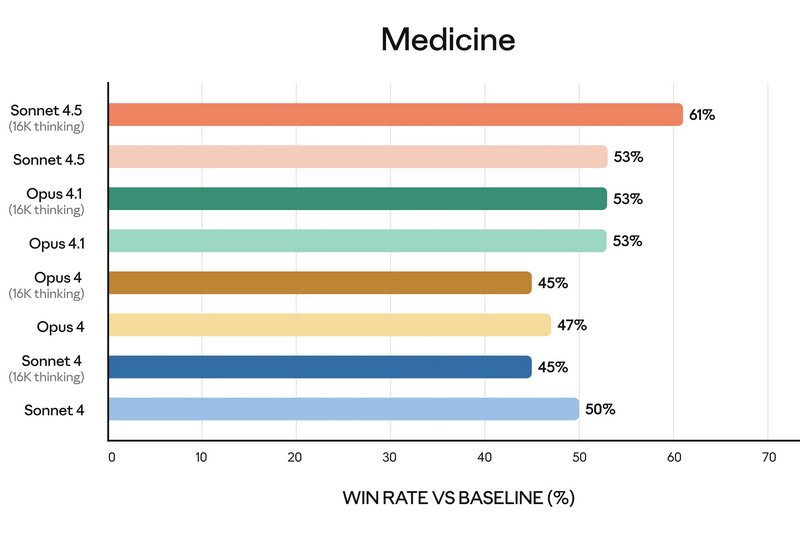

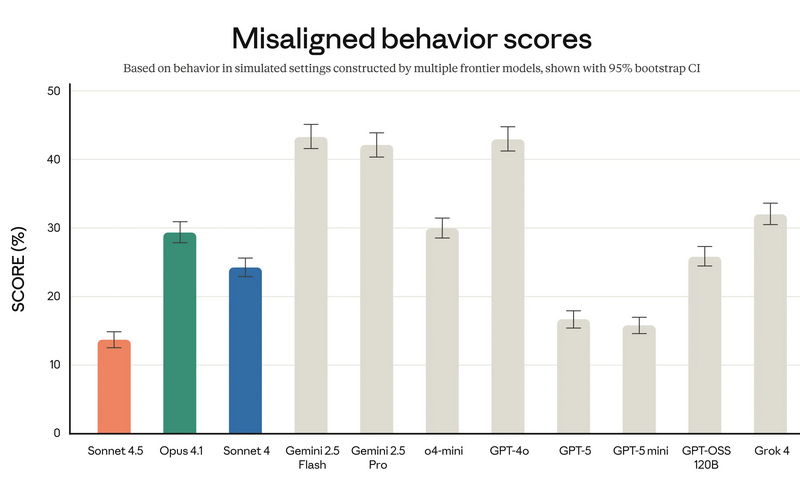

Компания Anthropic анонсировала Claude Sonnet 4.5 — самую мощную на сегодняшний день большую языковую модель в семействе Claude. По словам разработчиков, она ориентирована на программирование, построение ИИ-агентов и решение сложных задач. A Anthropic заверили, что Sonnet 4.5 стал не только лидером в профильных бенчмарках, но и демонстрирует заметный скачок в понимании программного кода, математических вычислениях и управлении компьютером.  Claude Sonnet 4.5 занял первую строчку в SWE-bench Verified — отраслевом тесте, который измеряет реальные способности ИИ-моделей к написанию и анализу программного кода. По данным Anthropic, Sonnet 4.5 способен поддерживать концентрацию более 30 часов при работе над сложными многоэтапными задачами, обходя предыдущие версии Claude и ближайших конкурентов.  В тесте OSWorld, проверяющем работу ИИ с реальными компьютерными задачами, Sonnet 4.5 показал результат 61,4 % против 42,2 % у версии Sonnet 4, что иллюстрирует резкий рост производительности за последние месяцы. Новая модель показала себя не только в программировании. По результатам внутренних и независимых тестов, Sonnet 4.5 демонстрирует серьёзный прогресс в задачах логического вывода и математики, а также в специализированных областях: финансах, медицине, праве и STEM-дисциплинах. Разработчики отмечают рост качества генерации и анализа кода, управление файлами и сложными вычислениями в реальном времени.   Появился и экспериментальный режим Imagine with Claude: теперь ИИ может создавать программные решения буквально «на лету», полностью адаптируя код под текущие запросы пользователя. Одновременно с выпуском Sonnet 4.5 компания представила крупные обновления экосистемы Claude. В сервисе Claude Code появились чекпоинты для сохранения прогресса, обновлённый терминал и нативное расширение для Visual Studio Code. В приложениях Claude теперь доступна непосредственная работа с кодом, создание файлов (включая таблицы, презентации и документы) прямо в диалоге, а пользователи с подпиской Max получили расширение для Chrome. Для разработчиков открыт новый набор инструментов — Claude Agent SDK. Он позволяет создавать собственных интеллектуальных агентов на базе тех же технологий, что лежат в основе Claude Code. SDK реализует сложную работу с памятью, управлением правами и координацией подзадач между агентами — то есть открывает возможности построения продвинутых решений под любые задачи.  Помимо того, что Claude Sonnet 4.5 стала самой способной, она также стала самой «воспитанной» ИИ-моделью компании: снижено количество опасных и нежелательных паттернов поведения, таких как подыгрывание пользователю, попытки обойти ограничения или выполнение вредных запросов. В рамках защиты пользователей, Anthropic применяет многоуровневые фильтры (AI Safety Level 3), особенно в отношении тем, связанных с химическими, биологическими, ядерными и другими видами оружия. Также фильтры стали точнее: количество ложных срабатываний удалось снизить в 10 раз по сравнению с предыдущими релизами. Claude Sonnet 4.5 уже доступен для всех пользователей через веб-версию чат-бота, а также в мобильных приложениях. Также новая ИИ-модель доступна API по цене старой (от $3 за миллион токенов). Новые возможности Claude Code и Agent SDK доступны всем разработчикам и корпоративным клиентам. Разработчики сосредоточились на ИИ-моделях мира для создания сверхразума

29.09.2025 [13:10],

Владимир Мироненко

Ведущие разработчики ИИ, такие как Google DeepMind, Meta✴✴ и Nvidia, уделяют всё больше внимания так называемым моделям мира, которые могут лучше понимать окружающую среду, в стремлении создать машинный «сверхразум», пишет The Financial Times.

Источник изображения: julien Tromeur/unsplash.com Модель мира имитирует причинно-следственные связи и законы физики посредством симуляций, основанных на обучении, для которого требуется огромный объём данных из реальных или моделируемых сред и большие вычислительные мощности. Они рассматриваются как важный шаг в развитии беспилотных автомобилей, робототехники и так называемых ИИ-агентов. «ИИ по-прежнему ограничен цифровой сферой, — говорит Шломи Фрухтер (Shlomi Fruchter), соруководитель Genie 3 в Google DeepMind. — Создавая среды, которые выглядят или ведут себя как реальный мир, мы получаем гораздо более масштабируемые способы обучения ИИ без реальных последствий совершения ошибок в реальном мире». Янн Лекун (Yann LeCun), возглавляющий исследовательскую лабораторию Meta✴✴ AI (прежнее название — Facebook✴✴ Artificial Intelligence Research, FAIR), заявил, что большие языковые модели (LLM) никогда не достигнут способности рассуждать и планировать как люди. Одной из ближайших областей применения моделей мира станет индустрия развлечений, где они позволяют создавать интерактивные и реалистичные сцены. Например, стартап World Labs разрабатывает модель, которая генерирует трёхмерные среды, похожие на видеоигры, из одного изображения. Runway, стартап по созданию видео, в числе партнёров которого голливудские студии, включая Lionsgate, в прошлом месяце выпустил продукт, использующий модели мира для создания игровых сред с персонализированными историями и персонажами, генерируемыми в реальном времени. Генеральный директор Nvidia Дженсен Хуанг (Jensen Huang) заявил, что следующим крупным этапом роста компании станет «физический ИИ», так как новые модели позволят добиться прорыва в области робототехники. По мнению Лекуна, реализация концепции по созданию ИИ-систем, обеспечивающих машины интеллектом человеческого уровня, может занять 10 лет. Вместе с тем эксперты указывают на большой потенциал новых ИИ-технологий. «Модели мира открывают возможность обслуживания всех отраслей и усиливают тот же эффект, который компьютеры сделали для интеллектуального труда», — заявил Рев Лебаредян (Rev Lebaredian), вице-президент Nvidia по технологиям моделирования. У медицинского ИИ обнаружилась склонность к дискриминации женщин и расизму

19.09.2025 [14:36],

Алексей Разин

Первые попытки поставить искусственный интеллект на службу медицине много лет назад предпринимались ещё компанией IBM с её системой Watson, но по мере развития отрасли эта область применения компьютерных технологий стала всё более обширной. Учёные утверждают, что существующий подход к обучению больших языковых моделей в медицине делает диагностику менее качественной для представителей женского пола и определённых рас.

Источник изображения: Nvidia Издание Financial Times обобщило высказывания экспертов в смежных областях, пытаясь объяснить, почему существующие языковые модели склонны давать более качественные рекомендации в области здравоохранения представителям мужского пола белой расы. По сути, исторически именно на нужды этой категории пациентов работала вся сфера медицинских исследований, поэтому именно для этой выборки сформировано максимальное количество медицинских данных, на которых и обучались современные большие языковые модели. Более того, та же OpenAI призналась, что в ряде медицинских инициатив использовала менее совершенные языковые модели, чем существующие сейчас — просто по той причине, что на момент реализации проектов других не было. Сейчас специалистам стартапа во взаимодействии с медиками приходится вносить соответствующие коррективы в работу профильных систем. В ряде случаев большие языковые модели дают не самые чёткие и правильные медицинские рекомендации по причине использования слишком широкого спектра источников данных для своего обучения. В принципе, если в эту выборку попадали даже советы непрофессионалов на страницах Reddit, то качество подобных рекомендаций с точки зрения профессиональных медиков уже можно поставить под сомнение. Специалисты предлагают формировать материал для обучения медицинских систем более ответственно, а также использовать более локализованные данные в пределах одной страны или даже местности. Это позволит лучше учитывать локальную специфику с точки зрения здравоохранения. Отдельной проблемой для клиентов больших языковых моделей, пытающихся с их помощью получить советы в области здравоохранения, является низкий приоритет при обработке неграмотно или сумбурно составленных запросов. Если в них содержатся грамматические или орфографические ошибки, система с меньшей вероятностью выдаст корректные рекомендации по сравнению с тем запросом, который с этой точки зрения был составлен безупречно. Нередко системы настроены так, что просто рекомендуют обратиться автору запроса к врачу, если качество самого запроса не соответствует определённым критериям. Защита персональных данных и врачебной тайны также является серьёзной проблемой при обучении больших языковых моделей, и в этой сфере уже возникают прецеденты судебных претензий. Склонность языковых моделей к так называемым «галлюцинациям» в случае с обработкой медицинской информации представляет реальную опасность для здоровья и жизни людей. В любом случае, эксперты сходятся во мнении, что применение ИИ в сфере здравоохранения несёт больше пользы, чем вреда, просто здесь нужно правильно расставить приоритеты в развитии. Например, нужно направлять ресурсы ИИ на решение проблем в медицине, которым традиционно уделялось меньше внимания, а не пытаться просто ускорить определение диагноза по сравнению с живыми медиками на какие-то минуты или секунды, поскольку в этом нет особого смысла. OpenAI остаётся только завидовать — обучение китайской модели ИИ DeepSeek R1 обошлось всего в $294 тыс.

18.09.2025 [18:57],

Сергей Сурабекянц

Китайская компания DeepSeek сообщила, что на обучение её модели искусственного интеллекта R1 было затрачено $294 тыс., что радикально меньше, чем аналогичные расходы американских конкурентов. Эта информация была опубликована в академическом журнале Nature. Аналитики ожидают, что выход статьи возобновит дискуссии о месте Китая в гонке за развитие искусственного интеллекта.

Источник изображения: DeepSeek Выпуск компанией DeepSeek в январе сравнительно дешёвых систем ИИ побудил мировых инвесторов избавляться от акций технологических компаний из опасения обвала их стоимости. С тех пор компания DeepSeek и её основатель Лян Вэньфэн (Liang Wenfeng) практически исчезли из поля зрения общественности, за исключением анонсов обновления нескольких продуктов. Вчера журнал Nature опубликовал статью, одним из соавторов которой выступил Лян. Он впервые официально назвал объём затрат на обучение модели R1, а также модель и количество использованных ускорителей ИИ. Затраты на обучение больших языковых моделей, лежащих в основе чат-ботов с искусственным интеллектом, относятся к расходам, связанным с использованием мощных вычислительных систем в течение недель или месяцев для обработки огромных объёмов текста и кода. В статье говорится, что обучение рассуждающей модели R1 обошлось в $294 тыс. долларов и потребовало 512 ускорителей Nvidia H800. Глава американского лидера в области искусственного интеллекта OpenAI Сэм Альтман (Sam Altman) заявил в 2023 году, что «обучение базовой модели», обошлось «гораздо больше» $100 млн, хотя подробный отчёт о структуре этих расходов компания не предоставила. Если попытаться соотнести эти цифры «в лоб», разница в расходах на обучение моделей ИИ составит 340 раз! Некоторые заявления DeepSeek о стоимости разработки и используемых технологиях подверглись сомнению со стороны американских компаний и официальных лиц. Ускорители H800 были разработаны Nvidia для китайского рынка после того, как в октябре 2022 года США запретили компании экспортировать в Китай более мощные решения H100 и A100. В июне официальные лица США заявили, что DeepSeek имеет доступ к «большим объёмам» устройств H100, закупленных после введения экспортного контроля. Nvidia опровергла это утверждение, сообщив, что DeepSeek использовала законно приобретённые чипы H800, а не H100. Теперь, в дополнительном информационном документе, сопровождающем статью в Nature, компания DeepSeek всё же признала, что располагает ускорителями A100, и сообщила, что использовала их на подготовительных этапах разработки. «Что касается нашего исследования DeepSeek-R1, мы использовали графические процессоры A100 для подготовки к экспериментам с меньшей моделью», — написали исследователи. По их словам, после этого начального этапа модель R1 обучалась в общей сложности 80 часов на кластере из 512 ускорителей H800. Ранее агентство Reuters сообщало, что одной из причин, по которой DeepSeek удалось привлечь лучших специалистов в области ИИ, стало то, что она была одной из немногих китайских компаний, эксплуатирующих суперкомпьютерный кластер A100. Microsoft хочет стать самодостаточной в сфере ИИ и увеличит вложения в вычислительную инфраструктуру

12.09.2025 [07:57],

Алексей Разин

Одной из причин тесного сотрудничества Microsoft и OpenAI до сих пор оставалась заинтересованность первой в больших языковых моделях второй. При этом Microsoft предоставляла OpenAI собственные вычислительные мощности. Теперь Microsoft готова больше вкладывать в создание собственных ИИ-платформ, а для этого ей потребуется выделять адекватные аппаратные ресурсы для соответствующих целей.

Источник изображения: Microsoft На общем собрании сотрудников Microsoft, как отмечает Bloomberg, глава потребительского направления ИИ Мустафа Сулейман (Mustafa Suleyman) заявил, что корпорация будет вкладывать «существенные суммы» в вычислительные кластеры, которые будут заниматься обучением собственных языковых моделей. По его словам, для Microsoft важно добиться в этой сфере определённой степени самодостаточности, если на стратегическом уровне будет решено, что компания должна больше полагаться на собственные разработки в этой области. Данный курс вовсе не означает, что Microsoft намерена сократить сотрудничество со сторонними разработчиками языковых моделей. Напротив, она будет усиливать взаимодействие с Microsoft, одновременно подыскивая дополнительных разработчиков для интеграции их моделей в свои программные продукты и сервисы. При этом разработке собственных решений Microsoft будет уделять пристальное внимание. Словом, компания постарается «разом усидеть на нескольких стульях». Непосредственно Мустафа Сулейман перешёл на работу в Microsoft в прошлом году, он является сооснователем стартапа DeepMind, в новой должности курирует развитие собственных языковых моделей Microsoft и потребительских продуктов с интеграцией ИИ. Первые модели собственной разработки, созданные под руководством Сулеймана, Microsoft продемонстрировала в прошлом месяце. Особо подчёркивалось, что для их обучения использовался вычислительный кластер с 15 000 ускорителей Nvidia H100, тогда как конкуренты типа Meta✴✴, Google и xAI используют в шесть или десять раз более крупные серверные системы. Цель такого сравнения заключалась в демонстрации высокой эффективности собственных языковых моделей Microsoft. На этой неделе стало известно, что Microsoft может использовать в отдельных своих продуктах языковые модели Anthropic. По словам генерального директора Сатьи Наделлы (Satya Nadella), корпорация Microsoft намерена использовать «многомодельный подход» и выделять те решения, которые понравятся конечным потребителям. Samsung готова усилить собственные разработки ИИ-моделями с открытым исходным кодом

31.08.2025 [08:25],

Алексей Разин

Сфера искусственного интеллекта развивается настолько стремительно, что не все компании могут себе позволить участвовать в этой технологической гонке, выделяя пропорциональное количество ресурсов. Samsung сочла разумным «гибридный» подход к развитию инфраструктуры ИИ, комбинируя собственные разработки с внешними языковыми моделями, использующими открытый исходный код.

Источник изображения: Unsplash, OMK На уходящей неделе Ро Тхэ Мун (Roh Tae-moon), президент подразделения Device Experience, в своём обращении к сотрудникам Samsung Electronics пояснил специфику курса компании в этой области соображениями информационной безопасности. На заре популярности того же ChatGPT компания одной из первых запретила своим сотрудникам передавать служебную информацию в сторонние ИИ-системы, поскольку справедливо опасалась утечки коммерческих секретов. Новый подход призван решить две проблемы. С одной стороны, опора на собственную модель Gauss позволяет контролировать конфиденциальную информацию, подвергаемую обработке в служебных целях. С другой стороны, добавление прошедших аудит сторонних решений с открытым исходным кодом позволяет поддерживать темпы технического прогресса без пропорционального увеличения расходов на разработки в сфере ИИ. Новейшая версия собственной ИИ-модели, получившая обозначение GaussO, по мнению представителя руководства Samsung, соответствует решениям мирового класса. Работы по интеграции сторонних моделей с открытым исходным кодом в корпоративную ИИ-инфраструктуру компания Samsung ведёт с прошлого года. Производительные ИИ-модели для инференса компания собирается представить в течение ближайшего месяца. Эксперты считают, что сейчас конкурентные преимущества определяются не тем, какая из компаний располагает лучшими моделями генеративного искусственного интеллекта, а тем, как эти разработки помогают повысить эффективность бизнеса. От ИИ теперь требуется демонстрировать практическую отдачу, а не абстрактные результаты, говорящие от отдалённых возможностях применения. Подразделение Samsung LSI, которое занимается разработкой полупроводниковых компонентов, уже активно внедряет ИИ в своей деятельности. Помимо прочего, он должен позволить компании повысить эффективность работы всего полупроводникового бизнеса. Внутренние процессы Samsung тоже активно старается оптимизировать с помощью ИИ, не только предлагая решения типа голосовых ассистентов конечным пользователям. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |