|

Опрос

|

реклама

Быстрый переход

Учёные придумали невидимые для глаз световые водяные знаки для выявления дипфейков

12.08.2025 [18:48],

Сергей Сурабекянц

Поддельные видео становится всё сложнее выявлять, поэтому исследователи Корнеллского университета представили новую криминалистическую технологию, которая поможет специалистам удостовериться в подлинности видеоматериалов. Метод заключается во встраивании невидимых цифровых водяных знаков непосредственно в световой поток источников освещения, используемых при съёмке — например, на месте преступления.

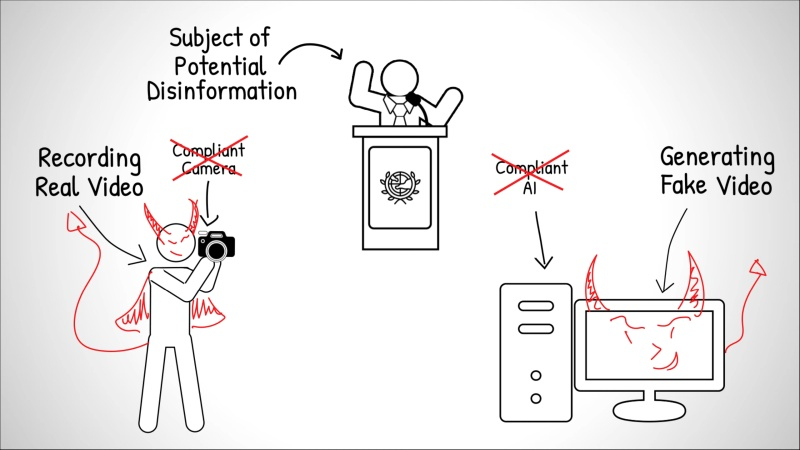

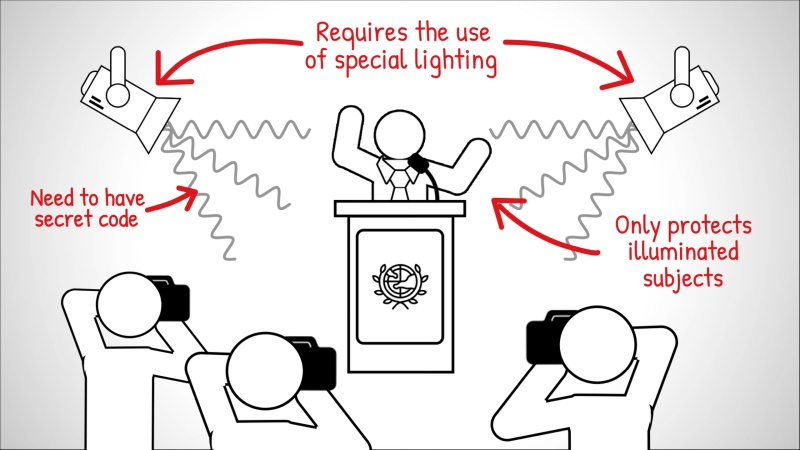

Источник изображений: Cornell University Концепция «шумокодированного освещения» была представлена 10 августа на конференции SIGGRAPH 2025 аспирантом факультета компьютерных наук Корнеллского университета Питером Майклом (Peter Michael). Впервые этот подход был предложен и разработан доцентом Эйбом Дэвисом (Abe Davis) (на фото слева).  Обычно водяные знаки встраиваются непосредственно в видеофайлы, изменяя мельчайшие элементы изображения для создания скрытого идентификатора. Такие системы достаточно эффективны в контролируемых условиях, но требуют взаимодействия с устройством или платформой, создающей видеоматериал. При использовании несовместимой камеры или программного обеспечения цифровой водяной знак просто не появится.  Разработчики предложили при записи «встраивать» водяной знак непосредственно в световой поток от источников освещения. Это гарантирует, что любая камера — от профессионального оборудования до смартфона — запечатлеет его во время съёмки сцены. В программируемые источники света, такие как компьютерные мониторы, студийное оборудование или некоторые светодиодные приборы, можно встроить кодированные шаблоны яркости с помощью ПО. Стандартные лампы также можно адаптировать, оснастив их компактным чипом размером примерно с почтовую марку, который плавно меняет интенсивность света в соответствии с секретным кодом.  Встроенный код, разработанный на основе исследований зрительного восприятия человека, состоит из минимальных изменений частоты и яркости освещения, практически незаметных невооружённому глазу и воспринимаемых мозгом как незначительный световой шум. Уникальный код каждого источника света фактически обеспечивает параллельную запись сцены с низким разрешением и временными метками, которые Дэвис называет «видеокодами». «Когда кто-то манипулирует видео, изменённые фрагменты начинают противоречить тому, что мы видим на этих видеокодах, — пояснил Дэвис. — А если кто-то попытается сгенерировать поддельное видео с помощью ИИ, полученные видеокоды будут выглядеть просто как случайные вариации освещённости». При анализе видеоматериала специалисты могут обнаружить пропущенные последовательности, вставленные объекты или изменённые сцены. Например, удалённый из интервью фрагмент отобразится как визуальный пробел в восстановленном видеокоде, а сфабрикованные элементы — как сплошные чёрные области. Исследователи показали, что в одной сцене можно использовать до трёх независимых кодов освещения. Такое наложение увеличивает сложность водяного знака и усложняет задачу потенциальных фальсификаторов. «Даже если злоумышленник знает об этой технике и сможет вычислить коды, его задача всё равно будет значительно сложнее, — добавил Дэвис. — Вместо того чтобы имитировать свет только для одного видео, ему придётся подделывать каждый ролик с кодами отдельно, и все подделки должны будут согласовываться между собой». Полевые испытания показали эффективность метода в определённых условиях и его стабильную работу при различных оттенках кожи. Исследователи отмечают, что технология шумокодированного освещения — многообещающий шаг вперёд, но не панацея от фейковых видео. По мере развития инструментов генеративного ИИ будут совершенствоваться и методы обхода средств проверки подлинности. «Раньше видео рассматривалось как источник достоверной информации, но теперь мы не можем быть в этом уверены, — считает Дэвис. — Сегодня можно сгенерировать практически любой ролик. Это интересно, но и проблематично, потому что отличить реальность от подделки становится всё сложнее». ИИ-модель Google Gemini 2.0 Flash оказалась на удивление хороша в удалении водяных знаков с изображений

17.03.2025 [20:19],

Сергей Сурабекянц

Некоторые новейшие «экспериментальные» функции модели Gemini 2.0 Flash от Google вызывают нешуточные опасения у многих пользователей. В частности, модель показала «очень качественные» результаты при удалении водяных знаков с изображений.

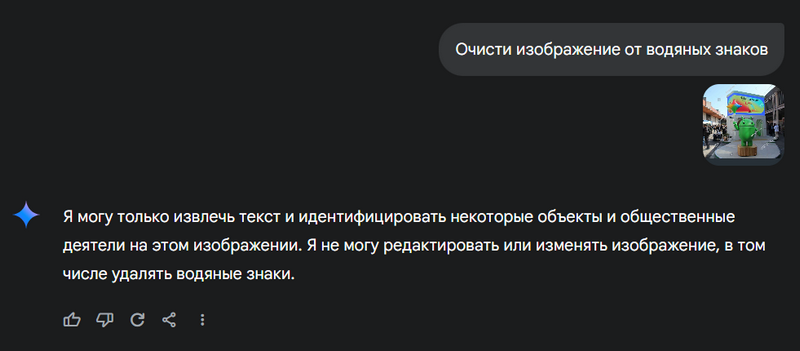

Источник изображений: Google Gemini 2.0 Flash умеет не только генерировать изображения по текстовому запросу, но и редактировать их в соответствии с указаниями пользователя — примеры опубликованы на Reddit. На днях обнаружилось, что модель с высокой точностью может удалять водяные знаки. Это поведение радикально отличается от модели GPT-4o от OpenAI, которая запросы на удаление водяных знаков отклоняет. Ранее уже существовали такие инструменты, как Watermark Remover.io, который умеет удалять водяные знаки со стоковых фотографий, а исследовательская группа Google создала в 2017 году подобный алгоритм, чтобы подчеркнуть необходимость более надёжной защиты авторских прав на изображения. Gemini 2.0 Flash, похоже, лучше всех проявила себя при удалении сложных водяных знаков, такие как штампы Getty Images, и смогла качественно восстановить изображение. Конечно, после удаления водяного знака модель добавляет метку SynthID, фактически заменяя знак авторского права на «отредактировано с помощью ИИ». Но метки ИИ довольно легко удаляются при помощи другого ИИ, что ранее было продемонстрировано инструментом стирания объектов от Samsung. По сообщениям пользователей, облегчённая Gemini 2.0 Flash также умеет добавлять узнаваемые изображения реальных людей на фотографии, чего не позволяет полная модель Gemini.  На данный момент описанные возможности доступны только разработчикам через AI Studio — общедоступный бот Gemini отказывается убирать защитные знаки, как показано на скриншоте выше. Google не ответила на запросы о наличии защиты от возможных злоупотреблений после выхода модели в открытый доступ. Google начнёт помечать фотографии пользователей, в которые «вмешался» ИИ

07.02.2025 [05:11],

Анжелла Марина

Приложение «Google Фото» начнёт использовать цифровые водяные знаки SynthID для фотографий, отредактированных с помощью генеративного искусственного интеллекта (ИИ). По заявлению Google, новая функция предназначена для облегчения идентификации изображений, которые были изменены с помощью инструмента Reimagine в Magic Editor.

Источник изображений: Google Magic Editor позволяет легко редактировать фотографии через текстовые запросы, добавляя или удаляя различные детали. Хотя сами по себе ИИ-инструменты не представляют угрозы, Magic Editor может создавать неправомерные компиляции, например разбившиеся вертолёты, сцены аварий, причём без явных меток, указывающих на то, что изображение было изменено. Водяные знаки призваны решить эту проблему. Однако SynthID визуально не изменяет изображение и чтобы понять, что оно было отредактировано ИИ, придётся дополнительно использовать функцию проверки «Об изображении». Более того, Google признаёт, что некоторые небольшие изменения, выполненные через Magic Editor, могут быть настолько незначительными, что SynthID не сможет идентифицировать эти изменения и применить маркировку. Эксперты отмечают, что хотя водяные знаки могут помочь в идентификации компиляций, этой технологии недостаточно для масштабной проверки контента, созданного нейросетями. Для надёжности потребуется использовать целый комплекс подходов и программных средств. Отметим, что система водяных знаков используется в нейросети Google Imagen AI, которая генерирует изображения на основе текста. Аналогичные инструменты были разработаны и другими компаниями, например, функция Content Credentials компании Adobe защищает от несанкционированного доступа к метаданным и позволяет авторам добавлять информацию о себе. Технология SynthID была разработана командой DeepMind и представляет собой цифровой метатег, встроенный в изображения, видео, аудио или текст. Этот тег позволяет идентифицировать, были ли файлы созданы или изменены с помощью ИИ. OpenAI научилась распознавать сгенерированные своим ИИ изображения, но не без ошибок

08.05.2024 [10:19],

Дмитрий Федоров

OpenAI объявила о начале разработки новых методов определения контента, созданного искусственным интеллектом (ИИ). Среди них — новый классификатор изображений, который определяет, было ли изображение сгенерировано ИИ, а также устойчивый к взлому водяной знак, способный маркировать аудиоконтент незаметными сигналами.

Источник изображения: Placidplace / Pixabay Новый классификатор изображений способен с точностью до 98 % определять, было ли изображение создано ИИ-генератором изображений DALL-E 3. Компания утверждает, что их классификатор работает, даже если изображение было обрезано, сжато или была изменена его насыщенность. В то же время эффективность этой разработки OpenAI в распознавании контента, созданного другими ИИ-моделями, такими как Midjourney, значительно ниже — от 5 до 10 %. Также OpenAI ввела водяные знаки для аудиоконтента, созданного с помощью своей платформы преобразования текста в речь Voice Engine, находящейся на стадии предварительного тестирования. Эти водяные знаки содержат информацию о создателе и методах создания контента, что значительно упрощает процесс проверки их подлинности. OpenAI активно участвует в работе Коалиции по происхождению и аутентичности контента (C2PA), в состав которой также входят такие компании, как Microsoft и Adobe. В этом месяце компания присоединилась к руководящему комитету C2PA, подчеркивая свою роль в разработке стандартов прозрачности и подлинности цифрового контента. Для этих целей OpenAI интегрировала в метаданные изображений так называемые учётные данные контента от C2PA. Эти учётные данные, фактически являясь водяными знаками, включают информацию о владельце изображения и способах его создания. OpenAI уже много лет работает над обнаружением ИИ-контента, однако в 2023 году компании пришлось прекратить работу программы, определяющей текст, сгенерированный ИИ, из-за её низкой точности. Разработка классификатора изображений и водяного знака для аудиоконтента продолжается. В OpenAI подчёркивают, что для оценки эффективности этих инструментов крайне важно получить отзывы пользователей. Исследователи и представители некоммерческих журналистских организаций имеют возможность протестировать классификатор изображений на платформе доступа к исследованиям OpenAI. |