|

Опрос

|

реклама

Быстрый переход

Huawei предложила в руках переносить файлы между гаджетами

27.11.2024 [16:49],

Павел Котов

Сегодня существует множество способов передавать файлы с одного мобильного устройства на другое: технология Quick Share и сторонние приложения для обмена данными, электронная почта и мессенджеры, облачные хранилища и многое другое. Huawei представила ещё один невероятный способ провести эту операцию: захватить файл рукой на одном устройстве и выбросить его на другое.

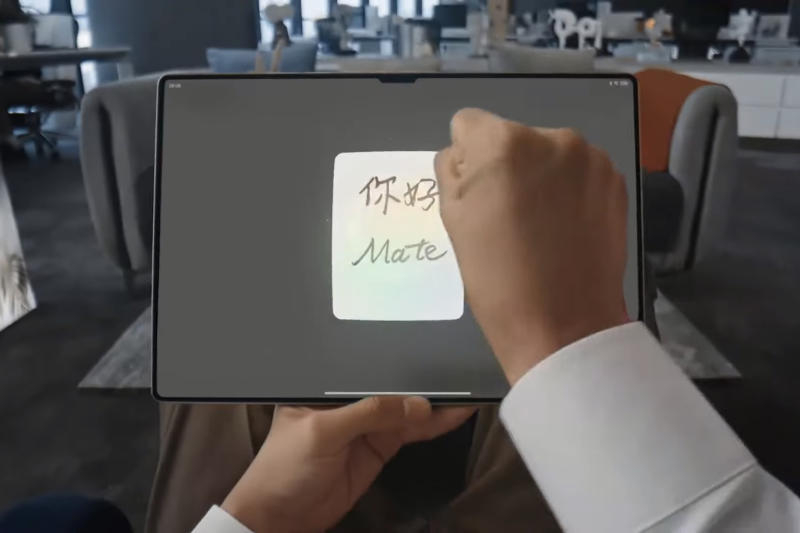

Источник изображений: Huawei Накануне Huawei представила серию смартфонов Mate 70, складной Mate X6 и планшет MatePad Pro 12.3 — все они получили поддержку новой функции «ИИ-телепортация». Она позволяет совершить над экраном устройства жест захвата рукой, чтобы «взять» контент, и отпустить руку над другим, чтобы передать данные на него. Простое и интуитивно понятное движение, не требующее настроек и нажатия кнопок.  Пока функция работает только с изображениями и снимками экранов, говорится на сайте Huawei. Не исключено, что в перспективе это затронет и другие типы файлов, например, офисные документы; а с файлами большого размера она настолько изящно работать уже не будет. Производитель также уточнил, что «ИИ-телепортация» пока работает только на устройствах последнего поколения: на смартфонах серии Mate 70, на раскладном Mate X6 и на планшете MatePad Pro 12.3. Возможно, в перспективе интересную функцию захотят перенять и другие производители. |