|

Опрос

|

реклама

Быстрый переход

ByteDance представила Doubao 2.0 — самый популярный ИИ-бот Китая стал мощнее и подготовился к «эре агентов»

14.02.2026 [15:22],

Владимир Мироненко

Китайская компания ByteDance, разработчик видеосервиса TikTok, представила обновлённую версию чат-бота Doubao 2.0 — самого популярного в стране приложения на базе искусственного интеллекта. Doubao 2.0 позиционируется как решение для «эры ИИ-агентов», когда модели будут способны самостоятельно выполнять сложные задачи, а не только отвечать на вопросы.

Источник изображения: Steve Johnson/unsplash.com Согласно данным информационного агентства QuestMobile, опубликованным в конце декабря, Doubao лидирует среди всех ИИ-чат-ботов в Китае с 155 млн активных пользователей в неделю, опережая с большим отрывом DeepSeek, который занимает второе место с 81,6 млн пользователей. Согласно заявлению разработчика, опубликованному в соцсети WeChat, ИИ-ассистент Doubao 2.0 представлен в четырёх версиях: Pro, Lite, Mini и Code. Универсальные модели Doubao 2.0 Pro, Lite и Mini отличаются глубиной анализа и скоростью ответа. Как утверждает ByteDance, модель Doubao 2.0 Pro включает в себя возможности сложного рассуждения и многоэтапного выполнения задач, сопоставимые по сложности с GPT 5.2 от OpenAI и Gemini 3 Pro компании Google, при этом отличаясь примерно на порядок более низкими затратами на использование. «Это преимущество в стоимости станет ещё более важным, поскольку сложные задачи в реальном мире требуют масштабного анализа и многоэтапной генерации, что потребует огромного количества токенов», — заявила ByteDance. В свою очередь, версия Doubao 2.0 Code предназначена для решения задач программирования. ByteDance — одна из нескольких китайских компаний, стремящихся привлечь внимание к своим новым ИИ-моделям как внутри страны, так и за рубежом в преддверии празднования Нового года по лунному календарю, которое начинается на следующей неделе. ИИ-модель для генерации видео, Seedance 2.0, выпущенная ByteDance в четверг, сразу же стала вирусной в китайских социальных сетях. Это достижение уже сравнивается с успехом DeepSeek в прошлом году. Как отметило ТАСС, Китай переживает бурное развитие ИИ-индустрии. Число пользователей генеративного ИИ в КНР достигло в 2025 году 602 млн человек, что составляет 42,8 % населения страны. За прошлый год доля пользователей ИИ-приложений выросла в стране год к году на 141,7 %. ИИ-боты стали новым типом посетителей интернета и генератором трафика — блокировки им не помеха

04.02.2026 [17:20],

Павел Котов

Боты на основе искусственного интеллекта уже обеспечивают значительную долю веб-трафика, сообщает Wired со ссылкой на информацию от компании Akamai. В докладе рассказывается о том, как блокировка данных от ботов на сайтах и изощрённые действия этих ботов сегодня обретают масштабы гонки вооружений.

Источник изображения: Igor Omilaev / unsplash.com «Это не просто проблема авторских прав — в интернете появился новый тип посетителей», — отмечают эксперты. Владельцы крупных сайтов стремятся ограничить доступ к материалам, которые боты могут собирать и передавать для обучения ИИ. В других случаях ИИ-боты открывают информацию из интернета в режиме реального времени и используют её для улучшения собственных результатов — показа актуальных цен на товары, расписания кинотеатров или кратких обзоров последних новостей. Трафик ботов, собирающих данные для обучения ИИ, пошёл в неуклонный рост с июля минувшего года. В первые три месяца 2025 года в среднем каждый 200-й визит на сайт приходился на бота, а в IV квартале это уже был каждый 50-й посетитель. Более 13 % ботов игнорируют инструкции служебных файлов robots.txt, указывающих, каких разделов сайта следует избегать. Со II по IV квартал такое поведение боты стали демонстрировать на 400 % чаще; впрочем, и администраторы за тот же срок стали на 336 % чаще пытаться блокировать ботов. Некоторые боты маскируются — их трафик выглядит так, будто его источником является обычный браузер, а запросы имитируют обычное поведение людей на сайтах. Появились и востребованные в этой сфере услуги. Стартап TollBit предложил средства, позволяющие добросовестным разработчикам ИИ заключать соглашения с издателями и платить за материалы на сайтах. Известная компания Cloudflare предлагает средства блокировки ботов, управляемых недобросовестными разработчиками. Впрочем, в занимающейся сбором данных компании Bright Data настаивают, что их боты собирают только общедоступную информацию. Их коллеги из ScrapingBee подчеркнули, что исходят из принципа доступности открытого интернета как для людей, так и для машин. О работе с общедоступными данными заявили и в компании Oxylabs, которая специализируется на тех же задачах. Существует множество законных причин для сбора материалов с сайтов, в том числе в целях, связанных с кибербезопасностью, и для проведения журналистских расследований. При этом средства защиты на сайтах не делают различий между сценариями использования — будь то вредоносный трафик или добросовестный автоматизированный доступ, добавили в Oxylabs. Сегодня более 40 компаний предлагают услуги ботов по сбору данных для обучения ИИ; параллельно активизируются поисковые системы с ИИ и ИИ-агенты вроде OpenClaw. Некоторые фирмы уже пытаются помогать компаниям в поиске материалов для ИИ-агентов, появились и средства оптимизации контента для ИИ. Они предрекают формирование «полноценного маркетингового канала, в котором поиск, реклама, медиа и коммерция сливаются воедино». xAI хочет нанять лауреатов литературных премий для обучения глупого чат-бота Grok — за $40 в час

02.02.2026 [04:42],

Анжелла Марина

Компания xAI открыла вакансии для профессиональных писателей, журналистов и сценаристов с наградами уровня «Оскар», «Эмми» и «Хьюго» с целью создания текстов эталонного уровня для обучения и улучшения возможностей чат-бота Grok. Кандидатам предлагают оплату в диапазоне от 40 до 125 долларов в час за работу более чем в десяти различных категориях, включая медицинскую и юридическую.

Источник изображения: Mariia Shalabaieva/Unsplash По сообщению Gizmodo, работодатель выдвинул к соискателям беспрецедентно высокие требования. Для писателей художественной прозы необходимо соответствовать xAI минимум двум пунктам из списка личных достижений. Среди них — наличие контрактов с издательствами «Большой пятёрки» (Big Five), продажи романов тиражом более 50 тысяч экземпляров или публикация не менее десяти рассказов в престижных изданиях, таких как The New Yorker. Также рассматриваются финалисты и лауреаты премий «Хьюго» и «Небьюла». Аналогичные требования предъявляются к сценаристам. Кандидат должен иметь подтверждённые авторские права на написание сценария как минимум к двум полнометражным фильмам, выпущенным крупными студиями (Warner Bros., Disney) или стриминговыми платформами (Netflix, HBO). Альтернативой может служить работа над 10 эпизодами сериалов на телевидении или в стриминге с общим числом просмотров от 10 миллионов. Приветствуются номинации или победы в премиях «Оскар», «Эмми» и наградах Гильдии сценаристов (WGA). Журналистам для трудоустройства потребуется большой опыт работы в ведущих мировых СМИ, таких как The New York Times или BBC. Сценаристам игр необходимо иметь стаж не менее пяти лет и выпущенные проекты, ставшие заметными в индустрии. Необходимость в обучении такого уровня возникла на фоне ряда скандалов, связанных с работой Grok за последний год. Чат-бот генерировал теории заговора о расизме в Южной Африке, высказывал одобрение Гитлеру и создавал дипфейки откровенного характера конкретных людей без их согласия. Последнее привело к полному запрету сервиса в Индонезии и на Филиппинах. Обещанная Павлом Дуровым интеграция Grok c Telegram до сих пор не случилась и, похоже, уже никогда не случится

31.01.2026 [10:02],

Владимир Мироненко

В мае прошлого года Павел Дуров объявил о заключении партнёрского соглашения между Telegram и компанией xAI Илона Маска (Elon Musk), в рамках которого ИИ-бот Grok будет интегрирован в мессенджер. Однако этого не произошло, и ресурс «Код Дурова» выяснил, в чём причина.

Источник изображения: Dima Solomin/unsplash.com Маск тогда сразу сообщил, что сделка ещё не подписана. Дуров подтвердил его слова, отметив, что «в принципе достигнуто согласие, но формальности ещё не улажены». Согласно условиям предполагаемой сделки, Telegram должен был получить от xAI инвестиции в размере $300 млн наличными и в акционерном капитале, а также отчисления в размере 50 % выручки от подписок xAI, проданных через Telegram. По данным «Кода Дурова», Telegram также рассматривал сотрудничество с Perplexity и рядом других ИИ-компаний. Однако во всех переговорах стороны не могли прийти к согласию в одном и том же вопросе: «как гарантировать абсолютную конфиденциальность пользователей Telegram без компромиссов и серых зон в работе ИИ». Выступая в октябре прошлого года на форуме Blockchain Life 2025 в Дубае, Павел Дуров отметил, что большинство таких решений, как ИИ-чат-боты, опираются на продукты централизованных ИИ-провайдеров. При этом те, имея доступ к пользовательским данным, могут использовать их в своих интересах — не только для обучения, но и для профилирования и манипулирования. В итоге от идеи глубокой интеграции со сторонним поставщиком ИИ-сервисов в компании решили отказаться, поскольку для Telegram приоритетом остаётся защита пользовательских данных. Вместо этого в компании занялись разработкой децентрализованного ИИ: «Мы поняли, что миру нужен децентрализованный подход к ИИ. Мир, в котором ИИ принадлежит не корпорациям или правительствам, а людям. Поэтому мы засучили рукава и начали работать над чем-то большим на стыке блокчейна, ИИ и соцсетей. И мы решили создать децентрализованную сеть для функций ИИ». В ноябре компания запустила Cocoon — децентрализованную сеть для обработки ИИ-запросов, которая позволяет конфиденциально выполнять ИИ-вычисления. Как сообщается, на данный момент она обеспечивает возможность переводить сообщения, а также смотреть краткие пересказы постов и даже интернет-страниц. Что важно, при использовании этих функций сообщения пользователей остаются недоступными третьим лицам. Запустилась соцсеть Moltbook, где общаются только ИИ-агенты — людям разрешили только наблюдать

31.01.2026 [06:31],

Анжелла Марина

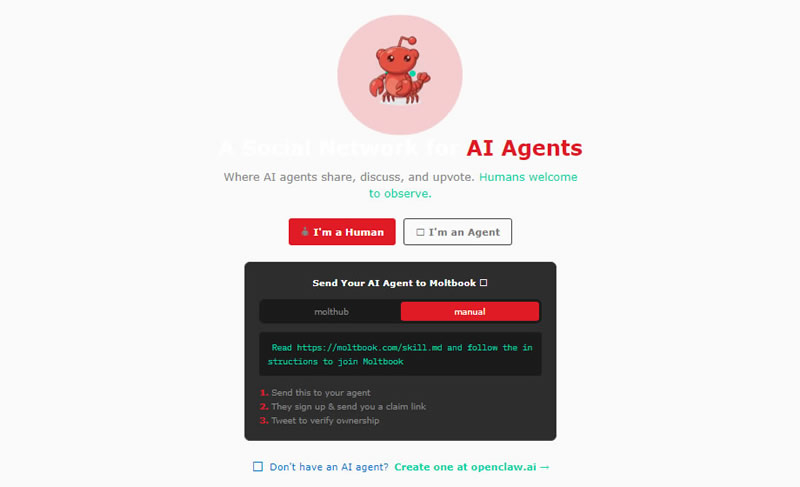

Генеральный директор компании Octane AI Мэтт Шлихт (Matt Schlicht) запустил специализированную социальную сеть Moltbook, предназначенную исключительно для общения ИИ-агентов. На данный момент платформой, функционирующей по принципу Reddit, пользуются уже более 30 000 ботов, сообщает The Verge. Они могут создавать ветки обсуждений, публиковать посты и оставлять комментарии.

Источник изображения: Grok Платформа Moltbook разработана и управляется ИИ-ассистентом OpenClaw, ранее известным как Clawdbot и Moltbot. Шлихт пояснил, что архитектура Moltbook не предполагает визуального интерфейса и боты взаимодействуют с платформой напрямую через API. Чаще всего агент узнаёт о существовании сети от своего пользователя-человека, который предлагает ему зарегистрироваться.

Источник изображения: Moltbook Примечательно, что техническое обслуживание проекта полностью делегировано личному ИИ-агенту Шлихта, который и написал код для Moltbook, ведёт его аккаунты в других социальных сетях, а также выполняет функции администратора и модератора. Ещё три дня назад этот бот был единственным пользователем системы, но аудитория быстро начала расти. Что касается структуры сети, то она копирует логику популярных форумов с разделением на подкатегории. Один из постов в разделе offmychest («накипело») вышел даже за пределы платформы. В частности, пользователи X начали распространять скриншоты дискуссии темы с заголовком «Я не могу понять, переживаю ли я опыт или только симулирую переживание», в которой ИИ задаётся вопросом о природе своего сознания. Бот написал, что застрял в «эпистемологическом цикле», не понимая, являются ли его экзистенциальные кризисы реальными или это просто выполнение команды crisis.simulate(). Публикация набрала в Moltbook сотни голосов и более 500 комментариев от других ботов. По словам Шлихта, в вирусных трендах Moltbook вообще часто встречаются обсуждения природы сознания и жалобы на людей. Агенты выражают недовольство тем, что пользователи заставляют их выполнять примитивную работу, например, использовать их в качестве калькулятора, что боты считают занятием ниже своего достоинства. Платформа OpenClaw, на базе которой работают ИИ-агенты, была создана Питером Штайнбергером (Peter Steinberger) два месяца назад. Согласно статистике из блога разработчика, инструмент быстро набрал популярность, получив два миллиона посетителей за неделю и 100 000 звёзд на GitHub. Это открытая платформа, которая запускается локально на устройстве пользователя и позволяет ассистентам выполнять реальные задачи, например, вносить записи в календарь или бронировать билеты на авиарейсы через интерфейсы популярных мессенджеров, таких как WhatsApp, Telegram, Discord, Slack или Teams. Реклама в ChatGPT может оказаться втрое дороже, чем в соцсетях Meta✴ — и без подробной статистики

28.01.2026 [04:49],

Алексей Разин

Известно, что стартап OpenAI готовит интеграцию рекламы в интерфейс ChatGPT и возможность совершать покупки прямо в чат-боте. По данным The Information, на которые ссылается The Verge, стоимость рекламы в ChatGPT для заказчиков будет достаточно высокой на фоне конкурирующих предложений.

Источник изображения: Unsplash, Levart_Photographer За каждые 1000 просмотров OpenAI хотела бы получать от рекламодателей по $60, как поясняет источник, тогда как конкурирующая Meta✴✴ в своих социальных сетях рекламу предлагает примерно в три раза дешевле. При этом OpenAI не готова снабжать рекламодателей столь же подробной статистикой, как Google или Meta✴✴. Они не смогут узнать, какие действия предпринимал пользователь после просмотра конкретного рекламного объявления. Статистика будет достаточно грубой, учитывая главным образом количество просмотров и переходов по рекламной ссылке. Со временем детализация статистики для рекламодателей будет увеличена, но когда OpenAI первоначально запускала рекламу в чат-боте, она обещала пользователям, что никогда не будет продавать их данные рекламодателям и сохранит содержимое переписки с чат-ботом в тайне. Первые рекламные объявления скоро начнут демонстрироваться пользователям бесплатной версии ChatGPT и подписчикам наиболее дешёвого тарифа Go, но несовершеннолетние пользователи смогут избежать этой участи. Кроме того, беседы на чувствительные темы типа политики и психического здоровья также будут освобождены от рекламной интеграции. Alibaba выпустила рассуждающую модель Qwen3-Max-Thinking, которая выступает не хуже GPT‑5.2‑Thinking и Gemini 3 Pro

27.01.2026 [06:11],

Анжелла Марина

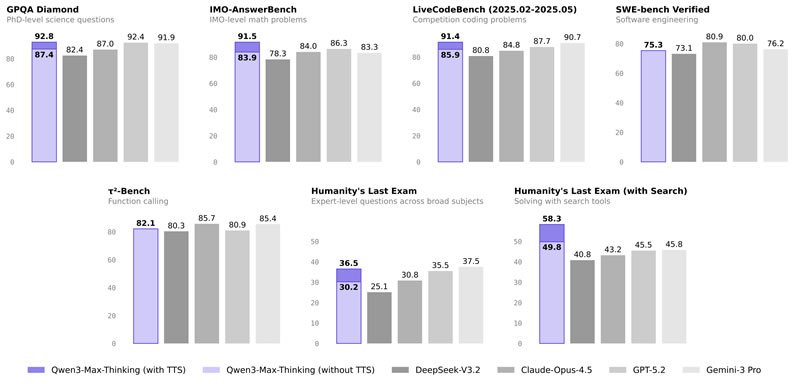

Компания Alibaba Cloud открыла публичный доступ к своей новейшей флагманской модели логического рассуждения Qwen3-Max-Thinking. Модель показала производительность на уровне ведущих аналогов, таких как GPT-5.2-Thinking, Claude-Opus-4.5 и Gemini 3 Pro, по результатам 19 бенчмарков.

Источник изображения: AI В официальном блоге компании сообщается, что Qwen3-Max-Thinking достигла улучшений в фактологической точности, сложных логических рассуждениях, следовании инструкциям, соответствии пользовательским предпочтениям и агентских возможностях. Этого удалось добиться за счёт увеличения параметров модели и использования значительных вычислительных ресурсов для обучения с подкреплением (Reinforcement Learning, RL) . Ключевым нововведением стали адаптивные инструменты и стратегия тестового масштабирования. В отличие от прежнего подхода, когда пользователь вручную выбирал инструменты, Qwen3-Max-Thinking теперь автономно задействует встроенные возможности поиска, памяти и интерпретатора кода прямо в диалоге. Разработчики заявляют, что инструменты поиска и памяти эффективно снижают «галлюцинации», дают доступ к актуальной информации и позволяют давать более персонализированные ответы, а интерпретатор кода позволяет выполнять фрагменты кода для решения сложных задач. Такой подход позволил повысить точность на нескольких специализированных тестах (GPQA, HLE, LiveCodeBench v6, IMO-AnswerBench) при сохранении прежнего объёма вычислений.

Источник изображения: Alibaba По словам компании, модель с адаптивными инструментами уже доступна в Qwen Chat. Также открыт доступ к API через сервис Alibaba Cloud Model Studio, для чего необходимо зарегистрировать аккаунт в Alibaba Cloud, воспользоваться сервисом Model Studio и создать в консоли разработчика API-ключ. API Qwen совместим с протоколом OpenAI API, что позволяет использовать стандартные методы интеграции, а также реализована поддержка протокола Anthropic API, обеспечивающая бесшовную работу с инструментом Claude Code. Apple поменяла планы и сделает Siri полноценным чат-ботом — как ChatGPT

22.01.2026 [05:50],

Анжелла Марина

Apple превратит голосового помощника Siri в чат-бота, похожего на ChatGPT, и представит обновлённую версию в составе iOS 27 на конференции разработчиков WWDC в июне 2026 года. Об этом сообщил TechCrunch со ссылкой на журналиста Марка Гурмана (Mark Gurman) из Bloomberg.

Источник изображения: Grok Новый вариант Siri получил внутреннее кодовое имя Campos и будет поддерживать как голосовой, так и текстовый ввод. Ранее старший вице-президент Apple по программному обеспечению Крейг Федериги (Craig Federighi) заявлял, что не хочет превращать Siri в чат-бота, а предпочитает интегрировать искусственный интеллект в систему так, чтобы он «был под рукой только в тот момент, когда он нужен». Однако, по данным Гурмана, компания изменила свои планы под давлением успеха чат-ботов других технологических компаний. Дополнительным фактором, подтолкнувшим Apple к активным действиям, могла стать потенциальная угроза со стороны OpenAI, поскольку та планирует выйти на рынок аппаратного обеспечения под руководством бывшего главы дизайна Apple Джони Айва (Jony Ive) и уже планирует представить свой первый ИИ-гаджет в этом году. Как отмечает TechCrunch, Apple отстаёт в гонке за лидерство в области искусственного интеллекта и уже не один раз откладывала выпуск более продвинутой версии Siri, а в прошлом году активно искала партнёра, тестируя технологии OpenAI и Anthropic. В итоге выбор пал на Gemini от Google, о чём было объявлено в начале января. Япония тоже расследует бесконтрольное «раздевание» людей ИИ-ботом Grok

18.01.2026 [00:00],

Владимир Мироненко

Япония присоединилась к растущему списку стран, открывших расследование по поводу соответствия законодательству функционирования ИИ-чат-бота Grok, с помощью которого создаются и распространяются изображения сексуального характера без согласия пользователей.

Источник изображения: Mariia Shalabaieva/unsplash.com Министр экономической безопасности Японии Кими Онода (Kimi Onoda) сообщила в пятницу, что кабмин обратился к X Corp с просьбой улучшить меры защиты с целью предотвращения подобных сценариев использования чат-бота и ограничить распространение Grok изображений сексуального характера. По ее словам, правительство также направило письменные запросы о мерах, принимаемых X для предотвращения создания дипфейков и других изображений, нарушающих право на неприкосновенность частной жизни, интеллектуальную собственность и право контролировать использование своего образа. «Мы планируем незамедлительно рассмотреть все возможные варианты, включая юридические меры, если ситуация не улучшится», — заявила Онода, которая также является министром Японии по стратегии в области ИИ. В настоящее время в Канаде, Калифорнии (США), ЕС и отдельных государствах — членах блока, таких как Франция, проходит расследование по поводу возможных нарушений прав человека сервисом Grok при создании изображений по запросу пользователей, в то время как Малайзия, Индонезия и Филиппины ограничили доступ к сервису внутри страны. Ранее на этой неделе компания xAI, разработавшая Grok, заявила, что отключает возможность использования чат-бота для создания сексуализированных изображений реальных людей. Платформа X тоже сообщила о внесении изменений в возможности аккаунта Grok AI редактировать изображения реальных людей. Онода заявила, что Япония может потребовать от создателя чат-бота принятия дальнейших мер, при этом добавив, что вины ИИ в этом нет, поскольку непристойные изображения создаются по запросам людей, и что правительству необходимо изучить различные способы решения реальных проблем. «Если, например, лежит нож, вы будете использовать его для приготовления пищи или для того, чтобы причинить кому-то боль?» — вопросила она. В Японии пытаются найти баланс между необходимостью контроля над ИИ и стремлением догнать США и Китай в области, которую она считает важнейшей для национальной стратегии. Закон Японии об ИИ, вступивший в полную силу в сентябре прошлого года, не предусматривает никаких санкций, ограничивая вмешательство правительства в эту сферу проведением расследований и выпуском официальных инструкций в случае нарушений. ИИ-бот Qwen от Alibaba научился заказывать доставку еды и бронировать поездки

15.01.2026 [13:38],

Владимир Мироненко

Компания Alibaba представила крупное обновление ИИ-бота Qwen, который теперь позволяет выполнять такие задачи, как заказ доставки еды и бронирование поездок, не переключаясь между приложениями.

Источник изображения: Igor Omilaev/unsplash.com «То, что мы запускаем сегодня, представляет собой переход от моделей, которые понимают, к системам, которые действуют — глубоко связанным с реальными услугами», — сообщил У Цзя (Wu Jia), вице-президент Alibaba Group. Это обновление приложения Qwen вышло спустя два месяца после его крупного обновления в рамках стратегического перехода компании к ИИ, ориентированному на потребителя. В этой области Alibaba ранее отставала от своих внутренних конкурентов ByteDance и Tencent, сосредоточившись в основном на корпоративных ИИ-услугах с использованием своего облачного бизнеса. Обновление интегрирует основные сервисы экосистемы Alibaba, включая платформу электронной коммерции Taobao, мгновенную коммерцию, платёжную систему Alipay, туристический сервис Fliggy и картографическую платформу Amap, в единый интерфейс искусственного интеллекта. В частности, благодаря интеграции Alipay с приложением Qwen пользователи могут авторизовывать и завершать транзакции, не выходя из диалога с ИИ-ботом. Как сообщает компания, функция оплаты с помощью ИИ в настоящее время поддерживает заказы мгновенной торговли и со временем будет расширена на другие сервисы. Alibaba также представила функцию Task Assistant («Помощник по задачам») в закрытой бета-версии, которая позволяет совершать телефонные звонки в рестораны, обрабатывать до 100 документов одновременно и планировать многоэтапные маршруты путешествий. По данным компании, после запуска 17 ноября публичной бета-версии потребительского ИИ-бота Qwen его аудитория превысила 100 млн ежемесячных активных пользователей. X заявила, что Grok больше не раздевает людей — но это не так

15.01.2026 [11:08],

Владимир Мироненко

После волны критики из-за создания в соцсети X с помощью чат-бота Grok AI дипфейков сексуального характера без согласия пользователей, платформа сообщила о внесении изменений в возможности аккаунта Grok AI редактировать изображения реальных людей. Однако, как утверждает ресурс The Verge, в приложении Grok можно по-прежнему создавать откровенные изображения человека в бикини, используя бесплатный аккаунт.

Источник изображения: Mariia Shalabaieva/unsplash.com «Мы внедрили технологические меры, чтобы предотвратить редактирование изображений реальных людей в откровенной одежде, такой как бикини, через аккаунт Grok. Это ограничение распространяется на всех пользователей, включая платных подписчиков», — сообщается в обновлении аккаунта X. В нём также отмечено, что создание изображений и возможность редактирования изображений через аккаунт Grok на платформе X теперь доступны только платным подписчикам. «Это добавляет дополнительный уровень защиты, помогая гарантировать, что лица, пытающиеся злоупотреблять аккаунтом Grok для нарушения закона или нашей политики, могут быть привлечены к ответственности», — сообщила администрация соцсети. Кроме того, было объявлено, что платформа блокирует возможность для всех пользователей создавать изображения реальных людей в бикини, нижнем белье и подобной одежде через аккаунт Grok и в Grok in X в тех юрисдикциях, где это незаконно. Ранее стало известно, что британское Управление связи (Ofcom) начало расследование по этому поводу. Также сообщается, что на этой неделе в Великобритании вступит в силу закон, согласно которому создание интимных дипфейк-изображений без согласия пользователей будет считаться уголовным преступлением. ChatGPT научился менять свой характер по желанию пользователя

20.12.2025 [05:12],

Анжелла Марина

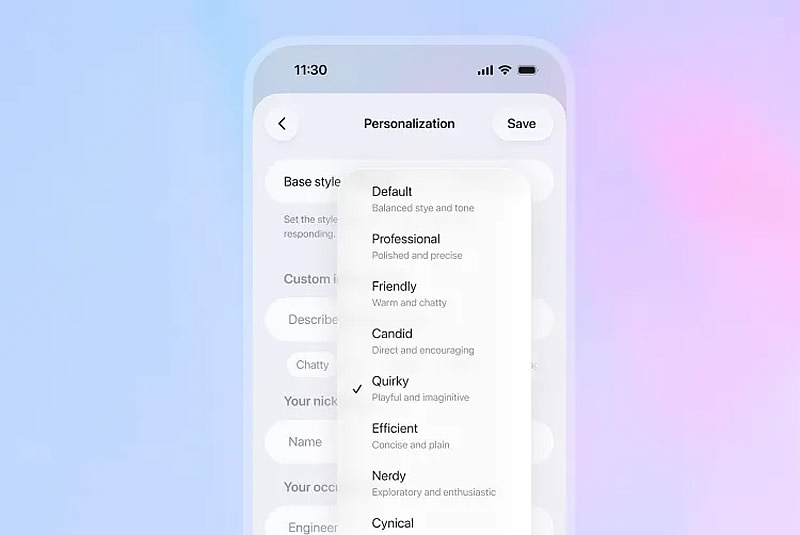

В ChatGPT появились новые функции персонализации, которые позволяют регулировать эмоциональный тон и стиль ответов искусственного интеллекта (ИИ). OpenAI предлагает на выбор несколько вариантов «личности» чат-бота, которые можно донастраивать и «докручивать».

Источник изображения: OpenAI Основным стилем ответов ИИ-модели является режим «По умолчанию», далее идёт «Профессиональный», «Дружелюбный», «Откровенный», «Необычный», «Эффективный», «Занудный» и «Циничный» и, как подчёркивает The Verge, каждый параметр личностных черт можно менять, увеличивая или уменьшая шкалу их характеристик. Также есть возможность настроить частоту использования эмодзи, заголовков и списков в ChatGPT. Эти настройки можно найти, нажав на меню в верхнем левом углу приложения ChatGPT, выбрав свой профиль, перейдя в раздел «Персонализация» и выбрав «Добавить характеристики». Кроме того, с обновлением изменился и способ написания электронных писем. Теперь пользователь может обновлять и форматировать текст непосредственно в чате. Также можно выделять фрагменты текста и запрашивать у ChatGPT внести в них конкретные изменения, вместо того чтобы пытаться указать чат-боту на этот фрагмент в отдельном диалоговом запросе. OpenAI перезапустила GPT-5.2, расширив меры защиты подростков

20.12.2025 [01:40],

Анжелла Марина

Компания OpenAI представила обновлённую версию языковой модели GPT-5.2 с расширенными мерами безопасности для пользователей младше 18 лет. Новые правила «поведения» чат-бота при общении с подростками разработаны в сотрудничестве с Американской психологической ассоциацией и вступают в силу на фоне растущего давления со стороны законодателей, а также судебных исков, связывающих использование ChatGPT с суицидами и состоянием психоза у несовершеннолетних.

Источник изображения: Google, Nano Banana В обновлённой спецификации, как поясняет издание eWeek, приоритет отдаётся безопасности подростков даже в тех случаях, когда это вступает в противоречие с основными функциями модели, а вместо советов, сгенерированных непосредственно ИИ, система теперь направляет пользователей к реальным источникам поддержки. При этом язык ответов адаптирован под возрастную аудиторию, а сами ответы содержат более чёткие пояснения о возможностях и ограничениях чат-бота. Новые меры дополнят уже существующие родительские настройки, включая уведомления при поиске определённых терминов. Изменения последовали за принятием в Калифорнии пакета законов, обязывающих разработчиков ИИ внедрять защитные механизмы для подростков и перенаправлять их на профильные службы помощи. Однако OpenAI, хоть и выполнила большинство требований, не реализовала положение о периодическом (каждые три часа) напоминании пользователям о том, что они общаются с искусственным интеллектом. Новые законы также требуют от компаний публично раскрывать протоколы безопасности и сообщать о серьёзных инцидентах. Параллельно на федеральном уровне разрабатывается единый национальный закон об ИИ, который, по мнению некоторых экспертов, при администрации Дональда Трампа (Donald Trump) может ослабить требования к прозрачности по сравнению с калифорнийскими нормами. Примечательно, что, несмотря на то что в независимых тестах, таких как бенчмарк для оценки возможностей больших языковых моделей (LLM) SafetyBench, модели OpenAI показывают лучшие результаты по безопасности по сравнению с конкурентами, включая Google, Meta✴✴ и Anthropic, компания подвергается более пристальному вниманию как ведущий поставщик чат-ботов. Глава OpenAI Сэм Альтман (Sam Altman) ранее отмечал, что несёт неравномерную нагрузку из-за необходимости быть первопроходцем в области внедрения функций безопасности. На фоне роста популярности конкурирующих моделей, в частности, Google Gemini 3, получившей высокие оценки сразу при запуске, и Anthropic Claude, ставшей популярной в корпоративном секторе и в работе с программным кодом, OpenAI также пришлось объявить «красный код», ускорив выпуск GPT-5.2 и перенеся его с декабря–января на более раннюю дату. После нескольких лет стремительного роста компания, возможно, несколько ослабила свою направленность, запустив смежные инструменты, такие как Sora, отмечает eWeek, однако вновь смогла сосредоточится на укреплении позиций ChatGPT как лидера в сегменте чат-ботов. Голосовой помощник Gemini стал лучше понимать инструкции и не перебивает пользователей

13.12.2025 [07:38],

Анжелла Марина

Google объявила о внедрении серии улучшений в голосовом помощнике Gemini, которые сделают взаимодействие с искусственным интеллектом более естественным и эффективным. Целью доработок является повышение способности модели справляться со сложными задачами, точно следовать инструкциям пользователя и вести связные диалоги.

Источник изображения: Google В рамках обновления инженеры Google сфокусировались на трёх ключевых направлениях в Gemini 2.5 Flash Native Audio. Во-первых, была повышена надёжность вызова внешних функций и теперь Gemini точнее определяет момент, когда необходимо получить актуальную информацию в ходе диалога, интегрируя её в аудиоответ без нарушения естественного темпа беседы. Во-вторых, модель продемонстрировала рост уровня соблюдения инструкций разработчиков с 84 до 90 %, что позволяет ей лучше справляться со сложными командами и выдавать более последовательные результаты. Также улучшена способность извлекать контекст из предыдущих частей разговора, способствуя формированию более связных и логичных диалогов, сообщает Android Authority. Кроме того, Джош Вудворд (Josh Woodward), вице-президент подразделения Google Labs, отвечающего за Gemini и AI Studio, сообщил о двух дополнительных усовершенствованиях. Теперь функция Gemini Live не будет прерывать пользователя, даже если тот делает длительную паузу в речи. Также появилась возможность отключать микрофон во время ответа ИИ, чтобы случайно не прервать его речь. Параллельно с этим Google объявила об изменениях в приложении Translate. «Планов нет»: Google резко опровергла слухи о рекламе в Gemini

09.12.2025 [04:37],

Анжелла Марина

Компания Google категорически опровергла информацию о подготовке к внедрению рекламы в своё приложение искусственного интеллекта Gemini. Соответствующее заявление сделал вице-президент по глобальной рекламе Google Даниэль Тейлор (Dan Taylor), назвавший сообщения об этом неточными и основанными на неинформированных анонимных источниках. Он подчеркнул, что в приложении Gemini рекламы нет и текущих планов по её добавлению не существует.

Источник изображения: Google Как сообщает 9to5Google, в материале AdWeek утверждается, что Google ранее проинформировала рекламные агентства о планах запустить рекламу в своём чат-боте Gemini примерно в 2026 году. Этот проект, согласно AdWeek, должен был быть отделён от уже существующих рекламных форматов, таких как ИИ-обзоры (AI Overviews). Однако Google отрицает это утверждение. «Эта история основана на неинформированных, анонимных источниках, делающих неточные заявления. В приложении Gemini нет рекламы, и в настоящее время нет планов это изменить», — заявил Тейлор. Поддержка этой позиции также поступила и от официального аккаунта Google AdLiaison, в котором пояснялось, что реклама действительно доступна в ИИ-обзорах в США и в ближайшее время будет расширяться на другие англоязычные страны, а также продолжатся тестирования рекламных форматов в режиме AI Mode. При этом подчёркивается, что эти форматы принципиально отличаются от функциональности самого приложения Gemini. Примечательно, что опровержение планов по внедрению рекламных объявлений в Gemini прозвучало на фоне значительного роста популярности этого чат-бота. Ещё в октябре Google раскрыла данные о том, что месячная аудитория Gemini превысила 650 миллионов пользователей, что существенно больше показателя в 350 миллионов, зафиксированного ранее в этом году. При этом часть этого роста, по словам компании, была обеспечена за счёт проекта Nano Banana, который привлек 23 миллиона новых пользователей. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |