|

Опрос

|

реклама

Быстрый переход

Джек Дорси уволит почти половину сотрудников Block, чтобы заменить их ИИ — акции взлетели на 24 %

27.02.2026 [15:21],

Владимир Мироненко

Джек Дорси (Jack Dorsey), бывший гендиректор сервиса микроблоггинга Twitter, объявил, что основанная им платёжная компания Block, управляющая Square, Cash App и Tidal, сократит более 4 тыс. сотрудников. Это составляет почти половину глобального штата Block, который будет сокращён с 10 до 6 тыс. Инвесторы поддержали решение — акции Block выросли более чем на 24 % на внебиржевых торгах.

Источник изображения: Alex Kotliarskyi/unsplash.com Дорси назвал масштабное сокращение инициативным и даже чутким решением, а не чрезвычайным шагом из-за финансовой ситуации, хотя 4 тыс. человек, внезапно потерявших работу, смотрят на ситуацию иначе. «Постоянные сокращения разрушают моральный дух, мешают сосредоточиться и подрывают доверие клиентов и акционеров к нашей способности руководить», — посетовал он в соцсети X. Дорси предсказал, что в течение года большинство компаний придут к тому же результату. «Я предпочёл бы добиться этого честно и на наших собственных условиях, чем быть вынужденным делать это автоматически», — сказал он. По официальной версии, сокращения обусловлены внедрением ИИ. Финансовый директор Block Амрита Ахуджа (Amrita Ahuja) заявила, что сокращения позволят компании «двигаться быстрее с помощью небольших, высококвалифицированных команд, использующих ИИ для автоматизации большего объёма работы». Все уволенные получат выходное пособие. Дорси сообщил, что в США сотрудники получат «зарплату за 20 недель + по 1 неделе за каждый год работы, акции, начисленные до конца мая, 6 месяцев медицинского страхования, корпоративные устройства и $5 тыс. на любые нужды, которые помогут им в этот переходный период». Сотрудники, проживающие за пределами США, получат «аналогичную поддержку» в зависимости от политики страны проживания, добавил он. Anthropic отказала Пентагону в неограниченном военном применении ИИ, несмотря на угрозы

27.02.2026 [14:05],

Владимир Мироненко

Anthropic отказалась выполнить требование Министерства обороны США предоставить неограниченный доступ к своим ИИ-технологиям, несмотря на то, что это ставит под угрозу её контракт с военным ведомством на $200 млн. На встрече в Белом доме министр обороны Пит Хегсет (Pete Hegseth) дал компании время на обдумывание предложения до конца рабочего дня в пятницу, но компания уже в четверг заявила об отказе.

Источник изображения: Anthropic По словам представителя Министерства обороны США, другие ведущие компании в сфере ИИ поддержали требование ведомства, чтобы военные имели полную свободу использовать мощные ИИ-инструменты по своему усмотрению. OpenAI, разработчик ChatGPT, Google и xAI Илона Маска (Elon Musk) согласились разрешить Пентагону использовать их ИИ-системы для «всех законных целей» в незасекреченных сетях, и работают над соглашениями для засекреченных сетей. В опубликованном в четверг заявлении генеральный директор Anthropic Дарио Амодеи (Dario Amodei) написал: «Я глубоко верю в экзистенциальную важность использования ИИ для защиты Соединённых Штатов и других демократических стран. Поэтому Anthropic активно работала над внедрением своих моделей в Министерство обороны и разведывательное сообщество». Он подчеркнул, что компания «никогда не высказывала возражений против конкретных военных операций и не пыталась ограничивать использование технологии произвольно», и добавил, что в «узком круге случаев мы считаем, что ИИ может подрывать, а не защищать демократические ценности». По словам Амодеи, у компании есть две «красные линии», которые она не будет пересекать: никакого массового наблюдения за американцами и никакого летального автономного оружия (или оружия, имеющего лицензию на уничтожение целей без какого-либо человеческого контроля). Возможно, в будущем Anthropic согласится на использование полностью автономного оружия военными, но сейчас она к этому не готова, добавил он. Сообщается, что Пентагон уже обратился к крупным оборонным подрядчикам с просьбой оценить их зависимость от ИИ-модели Claude компании Anthropic. Из-за позиции Anthropic военное ведомство вполне может объявить её «риском для цепочки поставок», что затронет не только Anthropic, но и любую фирму, использующую ИИ компании. Обычно эта классификация применяется к угрозам национальной безопасности, в частности, к китайским и российским компаниям. «Мы можем потребовать от всех наших поставщиков и подрядчиков подтверждения того, что они не используют никакие антропогенные модели», — сообщил газете The Washington Post представитель Пентагона. Сообщается также, что Пентагон рассматривает возможность применения «Закона об оборонном производстве» 1950 года, который позволяет федеральной власти вмешиваться в деятельность частных компаний, чтобы заставить Anthropic выполнить требование. Амодеи указал в своём заявлении, что «угрозы Пентагона не меняют нашей позиции: мы не можем с чистой совестью удовлетворить их просьбу». Он добавил, что «если министерство решит отказаться от услуг Anthropic, мы будем работать над обеспечением плавного перехода к другому поставщику, избегая любых сбоев в текущем военном планировании, операциях или других важных миссиях. Наши модели будут доступны на предложенных нами расширенных условиях столько, сколько потребуется». Nvidia рискует остаться с переполненными складами — обязательства по закупкам перед TSMC выросли в шесть раз до $95 млрд

27.02.2026 [07:06],

Алексей Разин

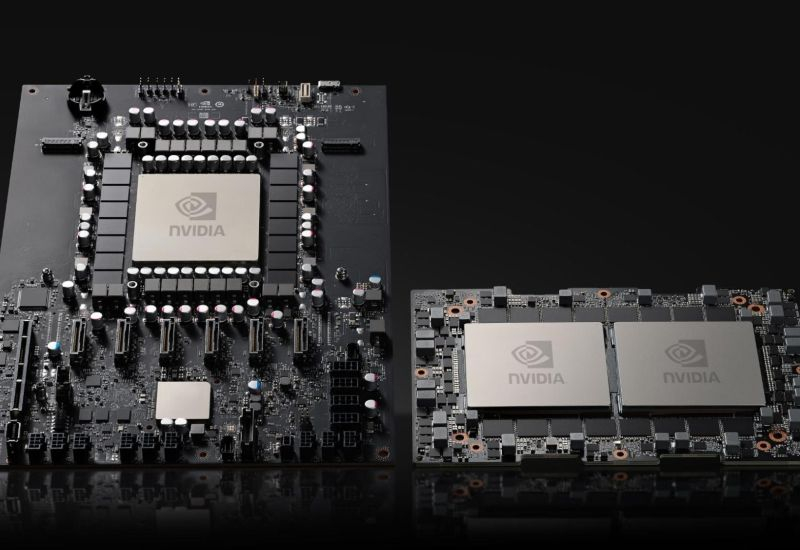

Известный в определённых кругах инвестор Майкл Берри (Michael Burry) обнаружил в годовом отчёте Nvidia по форме 10-K тревожный сигнал, который заметно увеличивает риски возникновения у компании финансовых проблем в случае резкого изменения спроса на её продукцию. Обязательства по закупкам на сумму $95 млрд почти в шесть раз превышают прошлогодние.

Источник изображения: Nvidia Не секрет, что спрос на продукцию Nvidia сейчас заметно превышает предложение, особенно в сегменте ИИ. В течение прошлого года ради обеспечения поставок в будущие периоды Nvidia заметно нарастила свои финансовые обязательства по закупке необходимых компонентов и услуг у своих партнёров, которые выпускают для неё продукцию. Сумма обязательств выросла с $16 до $95 млрд, и Майкл Берри считает это серьёзным фактором риска, который угрожает финансовой устойчивости Nvidia в случае, если спрос на её продукцию по каким-то причинам обвалится. По мнению Берри, кратное увеличение профильных обязательств со стороны Nvidia вызвано стремлением выпускающей для неё чипов компании TSMC увеличить глубину долгосрочных контрактов. Поскольку TSMC ради лучшего удовлетворения спроса на компоненты Nvidia вынуждена строить новые предприятия, ей нужны для этого средства. Соответственно, часть из них может поступать от самой Nvidia в форме финансовых обязательств. Специфика этих договорённостей подразумевает, что Nvidia в любом случае заплатит TSMC и другим подрядчикам, даже если соответствующие объёмы продукции ей в итоге не понадобятся. При неблагоприятном стечении обстоятельств такое построение отношений с партнёрами грозит компании серьёзными убытками. Кроме того, она в любом случае замораживает серьёзную часть оборотных средств, которые возвращаются к ней с большей задержкой, чем ранее. Фактически, по состоянию на конец прошлого фискального года Nvidia располагала обязательствами по закупкам на сумму $117 млрд, что практически соответствует её операционному денежному потоку на конец января. По мнению Майкла Берри, подобные соотношения не являются нормой и представляют для компании существенный риск. По его словам, Cisco в период печально известного «бума дот-комов» рассчитывала на ежегодный рост выручки на 50 %, а потому тоже заметно увеличила свои обязательства по закупке компонентов. После краха фондового рынка Cisco пришлось списать около 40 % соответствующих обязательств и складских запасов, акции компании предсказуемо обвалились. Прибыль Nvidia также поддерживается высокими ценами на свою продукцию, которые она может диктовать в условиях высокого спроса. Если последний ослабнет, то и норма прибыли компании снизится. Любое ухудшение конъюнктуры рынка, как заключает Берри, способно стать катастрофой для финансового положения Nvidia. Сам Берри ранее признавался, что собирается делать ставку на снижение курса акций Nvidia, поскольку считает её очень уязвимой к последствиям разрушения «ИИ-пузыря». Бесплатная версия Gemini получила премиальную функцию «Прошлые чаты»

27.02.2026 [00:02],

Анжелла Марина

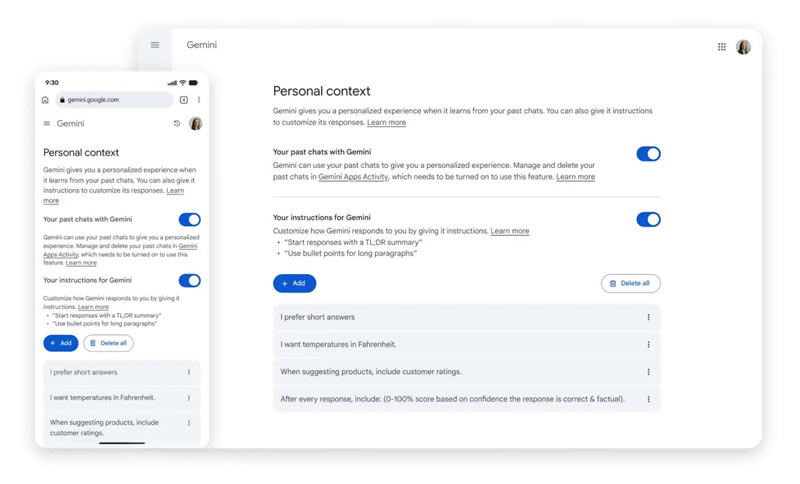

Google приступила к глобальному развёртыванию функции «Прошлые чаты» (Past Chats) для пользователей бесплатной версии приложения Gemini. Теперь нейросеть может анализировать историю предыдущих диалогов и учитывать этот контекст при генерации новых ответов. Ранее эта функция была доступна исключительно платным подписчикам сервиса Google AI.

Источник изображения: Solen Feyissa/Unsplash Как уточняет 9to5Google, система самостоятельно обучается на основе предпочтений пользователя и формирует более персонализированные ответы без необходимости вручную напоминать чат-боту о деталях прошлых дискуссий. Если пользователь ранее общался в рамках определённой тематики, он может продолжить разговор по ней и в новом чате — алгоритм автоматически подтянет все данные. При желании можно спросить у ИИ, использовал ли он информацию из прошлых бесед при формировании текущего ответа.

Источник изображения: 9to5google.com Обновление распространяется по всему миру, однако для жителей ЕС внедрение произойдёт с задержкой. Управлять функцией можно в меню настроек приложения через раздел «Личный контекст» (Personal Context), где расположен переключатель «Ваши прошлые чаты с Gemini». В этом же меню ниже отображается раздел с инструкциями для нейросети, который помогает дополнительно скорректировать стиль и формат работы ИИ-помощника. Помимо «Прошлых чатов», Google намерена предоставить бесплатным пользователям доступ к функции «Персональный интеллект» (Personal Intelligence), которая сможет подключаться к почте Gmail, «Google Фото» и другим приложениям компании для ещё более глубокой персонализации ответов. Metacritic удалил обзор Resident Evil Requiem от уважаемого игрового сайта — новая администрация заменила авторов на ИИ

26.02.2026 [23:27],

Дмитрий Рудь

Администрация агрегатора рецензий Metacritic удалила со страницы экшен-хоррора Resident Evil Requiem обзор от уважаемого британского сайта Videogamer, потому что материал был не написан человеком, а сгенерирован ИИ. Обозреватель Videogamer Брайан Мерриголд (Brian Merrygold) оценил Resident Evil Requiem на 9 из 10 баллов. Рецензия попала в рейтинг на Metacritic, однако читатели быстро заметили, что с публикацией что-то не так. По мнению пользователей, текст Мерриголда «отдаёт ИИ», а сам автор, «опытный аналитик в сфере iGaming (азартные игры онлайн — прим.) и спортивных ставок», похоже, является вымышленным персонажем с ИИ-аватаром. Сооснователь Metacritic Марк Дойл (Marc Doyle) в разговоре с Kotaku подтвердил, что обзор Resident Evil Requiem и ещё несколько рецензий от Videogamer за 2026 год были удалены с агрегатора после проверки на ИИ-материалы. Стоит отметить, что владельцем Videogamer с недавних пор является рекламное агентство Clickout, охватывающее, в том числе, сферу азартных игр. Под его началом портал начал рассказывать не только о видеоиграх, но и о казино. По данным Kotaku, в азартном разделе Videogamer сгенерированные ИИ материалы начали появляться ещё осенью 2025 года, а в видеоигровой проникли с увольнением последних настоящих журналистов на прошлой неделе. С тех пор Videogamer начал выпускать созданные «ИИ-авторами» с помощью ИИ игровые новости, специальные материалы и обзоры. Тем временем профили старых авторов были заменены поддельными ИИ-аккаунтами. Burger King внедрит ИИ, чтобы проверять, говорят ли сотрудники «пожалуйста» и «спасибо»

26.02.2026 [18:06],

Павел Котов

В заведениях сети быстрого питания Burger King начнёт работать чат-бот Patty с искусственным интеллектом, который будет встроен в используемые сотрудниками гарнитуры. Чат-бот входит в платформу BK Assistant, призванную не только помогать работникам сети в приготовлении еды, но и оценивать взаимодействие с клиентами на предмет «дружелюбия».

Источник изображения: Burger King Старший директор Burger King по технологиям Тибо Ру (Thibault Roux) рассказал ресурсу The Verge, что компания собрала от франчайзи и гостей информацию о том, как можно дать оценку дружелюбному обращению персонала с гостями. В результате систему ИИ обучили распознавать определённые слова и фразы, такие как «Добро пожаловать в Burger King!», «пожалуйста» и «спасибо». Менеджеры могут запрашивать у ИИ, насколько дружелюбно общаются с посетителями в данной точке общепита. «Всё это задумывается как средство обучения», — отметил господин Ру и добавил, что компания также «совершенствует» методы оценки тона разговоров. Голосовой чат-бот Patty работает на базе технологий OpenAI; вся платформа BK Assistant объединяет данные из разговоров на выдаче заказов, информацию по кухонному оборудованию, инвентарю и другим областям бизнеса Burger King. Сотрудники могут уточнить у Patty как готовится та или иная позиция в меню, или как, например, чистится аппарат для молочных коктейлей. Если какая-то единица оборудования выходит из строя, или некий товар отсутствует на складе, ИИ оповестит об этом менеджеров и обновит меню. Доверять ИИ обслуживание клиентов в Burger King пока не намерены. «Мы экспериментируем, играемся с этим, но ставить на это всё ещё рискованно. Не каждый клиент к этому готов», — отметил господин Ру. Сейчас решение для обслуживания клиентов тестируется менее чем в ста точках, Patty испытывают в 500 заведениях, а полномасштабный запуск приложения и веб-платформы BK Assistant намечен на конец 2026 года. «Android для андроидов»: Google вернула разработчика софта для роботов Intrinsic под своё управление ради воплощённого ИИ

26.02.2026 [18:02],

Владимир Мироненко

Intrinsic, «дочка» Alphabet, специализирующаяся на разработке программного обеспечения для промышленных роботов, переходит под управление Google. Этот шаг говорит о стремлении Google расширить свой потенциал в области физического ИИ с фокусом на производственный сектор.

Источник изображения: Igor Omilaev/unsplash.com В 2021 году Intrinsic была преобразована в независимую компанию после пяти лет деятельности в рамках Alphabet X, исследовательского подразделения компании, занимающегося амбициозными проектами. Среди других компаний, вышедших из Alphabet X, — разработчик роботакси Waymo и компания по доставке дронами Wing. Intrinsic поставила цель сделать промышленную робототехнику доступной для компаний, которые не могут позволить себе команды специализированных программистов. Программное обеспечение компании использует машинное обучение, позволяя роботам осваивать новые задачи посредством демонстрации и моделирования вместо составления инструкций для каждого движения. Среди её первых клиентов были производители, стремящиеся автоматизировать сложные сборочные операции, и логистические компании, нуждающиеся в более гибкой автоматизации складов. Созданная Intrinsic программная платформа Flowstate предназначена для разработчиков, не обладающих глубоким опытом в области разработки рабочих процессов робототехники, что соответствует миссии компании — сделать робототехнику более доступной. Однако деятельность в качестве независимой компании холдинга Alphabet имела свои ограничения. Хотя Intrinsic имела доступ к ресурсам Alphabet, она не могла в полной мере использовать облачную инфраструктуру Google и тесную интеграцию с ИИ-моделями Google, которую предлагают конкуренты, такие как Microsoft, через Azure. Перейдя под управление Google, Intrinsic получает немедленный доступ к корпоративной клиентской базе Google Cloud и cможет более глубоко интегрироваться с платформами ИИ Google. Как сообщает ресурс TechCrunch, Intrinsic будет функционировать в качестве отдельного подразделения в составе Google, при этом тесно сотрудничая с Google DeepMind и используя ИИ-модели Gemini, а также облачные сервисы Google. Консолидация отражает более широкие изменения в стратегии Alphabet, отметил ресурс Techbuzz. Когда компания провела реструктуризацию в 2015 году, создав Alphabet в качестве холдинговой компании с Google в качестве одной из нескольких дочерних компаний, целью было дать экспериментальным проектам возможность развиваться за пределами основного бизнеса Google. Однако экономическая целесообразность такой модели вызывает вопросы у инвесторов, поскольку большинство компаний холдинга Alphabet, за исключением Google, продолжают нести убытки. В прошлом году Alphabet, как сообщается, обсуждал возможность возвращения нескольких компаний под крыло Google для сокращения накладных расходов и улучшения координации. Интеграция Intrinsic, по-видимому, является первым шагом в этом направлении. Для робототехнической отрасли этот шаг говорит о том, что физический ИИ переходит из разряда исследовательских проектов в разряд серьёзных бизнес-приоритетов. Вышел Perplexity Computer — сервис для управления 19 ИИ-агентами, сообща работающими над большими проектами от начала и до конца

26.02.2026 [11:40],

Павел Котов

Perplexity представила новый сервис Computer, призванный объединить все доступные приложения искусственного интеллекта в цельную систему. Комплексный сервис включает интерфейсы чат-ботов и ИИ-агентов, которые теперь могут совместными усилиями работать над поставленными пользователями задачами.

Источник изображения: perplexity.ai Perplexity Computer выполняет стандартные для сервисов ИИ задачи: рассуждает, делегирует, производит поиск, запоминает информацию, пишет программный код и даёт ответы на вопросы. Чтобы начать работу, пользователь формулирует результат, который хочет получить. Сервис разбивает поставленную задачу на подзадачи и создаёт субагентов ИИ для их выполнения. Эти субагенты могут производить веб-поиск и изучать вопросы, генерировать документы, обрабатывать данные или производить вызовы API к подключённым сервисам. Координация работы субагентов производится в автоматическом режиме, а функционируют они асинхронно. Пользователь может создавать другие задачи или запускать десятки единиц Perplexity Computer параллельно. Столкнувшись с проблемой в процессе решения основной задачи, сервис создаёт дополнительных субагентов для её решения. При необходимости он сам находит ключи API, исследует дополнительную информацию, пишет код приложений и обращается к пользователю, если в этом возникает потребность. Каждая задача выполняется в изолированной вычислительной среде с доступом к реальной файловой системе, браузеру и с возможностью интегрировать инструменты. На выходе, уверяет Perplexity, получается безопасная платформа с мощным ИИ, доступная без необходимости производить локальную настройку. Считается, что модели ИИ превращаются в товар массового потребления, но в действительности, отмечают в компании, у наиболее популярных моделей формируется специализация. Так, рассуждения и управление субагентами Perplexity Computer сейчас поручено модели Anthropic Opus 4.6; созданием субагентов и решением задач в области глубокого исследования занимается Google Gemini; Google Nano Banana генерирует изображения, Veo 3.1 — видео; xAI Grok быстрее всех решает легковесные задачи, а поиск информации и данных в контексте осуществляет OpenAI ChatGPT 5.2. Основная платформа Perplexity не зависит от моделей — по мере развития они могут меняться; доступен выбор конкретных моделей для конкретных подзадач. «Мы любим CPU так же, как GPU»: глава Nvidia пообещал превзойти Intel и AMD в центральных процессорах

26.02.2026 [10:02],

Алексей Разин

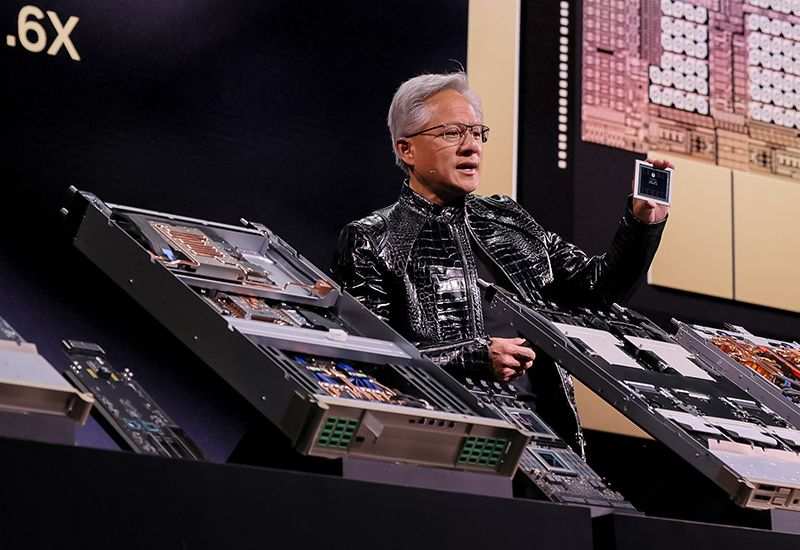

Периодичность публикации годовой отчётности Nvidia настроена таким образом, что на мартовской конференции GTC руководство компании рассказывает о перспективных продуктах этой марки, текущий год не станет исключением. Основатель Nvidia Дженсен Хуанг (Jensen Huang) уверен, что компания сможет составить конкуренцию Intel и AMD в сегменте CPU.

Источник изображения: Nvidia Данные заявления, как полагает Reuters, должны предвосхищать рассказ генерального директора о новых центральных процессорах Nvidia на грядущей мартовской конференции GTC 2026. На этой неделе Хуанг напомнил, что исторически вычислительная нагрузка распределялась в пропорции «90:10» с преобладанием центральных процессоров над GPU, но в последние годы ситуация зеркально изменилась. Теперь роль центральных процессоров в ИИ-вычислениях начнёт расти, как ожидает Дженсен Хуанг: «Мы точно так же любим CPU, как и GPU». Он даже выразил уверенность, что серверные процессоры Nvidia смогут превзойти изделия старожилов в лице Intel и AMD. В прошлом месяце Хуанг предсказал взрывной рост спроса на центральные процессоры для ЦОД, а также предположил, что это может превратить Nvidia «в одного из крупнейших производителей CPU в мире». Недавно Nvidia заключила контракт с Meta✴✴ Platforms на поставку центральных процессоров Grace и Vera независимо от GPU. Этот же облачный гигант заключил подобный контракт и с конкурирующей AMD. Эксперты ожидают, что по мере эволюции ИИ-моделей роль центральных процессоров начнёт возрастать, и в ЦОД ближайшего будущего количество CPU сперва поравняется с количеством GPU, а потом первый тип компонентов начнёт доминировать. По словам главы Nvidia, серверные процессоры этой компании заточены под обработку больших объёмов информации, и это позволит им раскрыть себя с лучшей стороны при использовании в инфраструктуре ИИ. Дополнительные подробности о CPU марки Nvidia глава компании пообещал поведать на мартовской конференции GTC 2026. ИИ почти не повлиял на экономику США в 2025 году, выяснили эксперты Goldman Sachs

26.02.2026 [08:27],

Алексей Разин

По итогам прошлого года американский ВВП смог вырасти на 2,2 %, но эксперты Goldman Sachs уверены, что заслуга ИИ в этом минимальна. Не исключено, что подобные оценки будут способствовать росту скептических настроений и за пределами США, поскольку основная активность в сфере ИИ пока проявляется именно на территории данной страны.

Источник изображения: Nvidia Некоторые аналитики считают, что бум ИИ непосредственно американской экономике не приносит особой пользы, а вот азиатских производителей компонентов и вычислительных систем активно обогащает. Многомиллиардные капитальные затраты американских облачных гигантов, запланированные на ближайшие годы, по мнению экспертов, примерно на 75 % своей величины будут направлены на рост ВВП Тайваня и других азиатских стран, где сосредоточены производственные мощности для инфраструктуры ИИ. Безудержный рост капитализации ИИ-стартапов беспокоит инвесторов, которые уже устали от обещаний светлого будущего, и желают получить хотя бы какой-то ориентир по срокам окупаемости реализуемых мегапроектов. Социологические опросы представителей бизнеса при этом показывают, что какой-то значимой отдачи от внедрения ИИ-инструментов они не видят, если не считать энтузиастов из сферы информационных и телекоммуникационных технологий. Основная часть необходимой для развития национальной ИИ-инфраструктуры США импортируется, как отмечают представители Goldman Sachs, поэтому оценить чистое влияние ИИ на отдельные сегменты американской экономики сложно. В любом случае, из 2,2 процентных пункта роста ВВП за прошлый год, как считают аналитики, около 0,2 процентного пункта роста было обеспечено именно внедрением ИИ. По крайней мере, чат-боты и большие языковые модели повлияли на американский ВВП в прошлом году именно в такой мере. Методики оценки такого влияния пока не выработаны, что также затрудняет анализ ситуации. Nvidia заработала рекордные $68 млрд за квартал: GeForce дали всего 5,5 %, ИИ-серверы — почти 92 %

26.02.2026 [07:46],

Алексей Разин

В квартальной презентации Nvidia отмечается, что выручка компании на серверном направлении выросла примерно в 13 раз с момента появления ChatGPT осенью 2022 года. Соответственно, текущая динамика общей выручки компании во многом определяется именно её успехами на серверном направлении. В прошлом квартале совокупная выручка Nvidia выросла на 73 % до рекордных $68,1 млрд.

Источник изображений: Nvidia Непосредственно в сегменте центров обработки данных выручка Nvidia за прошлый фискальный квартал, который завершился в конце января, выросла на 75 % в годовом сравнении до $62,3 млрд. Получается, что почти 92 % всей выручки в прошедшем квартале Nvidia получила именно в сегменте ЦОД. При этом вычислительные решения как таковые принесли $51,3 млрд, увеличив профильную выручку на 58 %, а оставшиеся $11 млрд обеспечили сетевые решения. На этом направлении квартальная выручка компании увеличилась в годовом сравнении на 263 %. Чуть больше половины серверной выручки в минувшем квартале, по данным самой Nvidia, обеспечивали облачные гиганты. В игровом сегменте выручка Nvidia в минувшем квартале составила $3,73 млрд. Это на 13 % меньше, чем в предыдущем квартале, но в годовом сравнении она увеличилась на 47 %. Сегмент решений для профессиональной визуализации традиционно не может похвастать большими суммами выручки, но в годовом сравнении она выросла на 159 % до $1,32 млрд. Автомобильная электроника прибавила год к году 6 % до $604 млн, а в сегменте OEM выручка Nvidia последовательно сократилась на 7 %, но выросла в годовом сравнении на 28 % до $161 млрд. Если сегментировать выручку Nvidia на вычисления в сочетании с сетевыми решениями и графику соответственно, то на первом направлении выручка по итогам квартала выросла на 71 % до $61,7 млрд, а на втором практически удвоилась в годовом сравнении до $6,5 млрд. Как отмечает финансовый директор компании Колетт Кресс (Colette Kress), в ближайшие месяцы дефицит игровых видеокарт будет сдерживать возможности роста профильной выручки Nvidia. При этом на серверном направлении она готова исправно покрывать спрос на протяжении ближайших нескольких кварталов. По итогам фискального года в целом выручка Nvidia выросла на 65 % до рекордных $215,94 млрд, операционная прибыль успела вырасти на 58 % до $137,3 млрд, чистая прибыль увеличилась на те же 58 % до $117 млрд, а вот операционные расходы выросли только на 42 % до $16,7 млрд. Другими словами, доходы компании росли быстрее, чем расходы — правда, это не помешало снижению нормы прибыли с 75,5 до 71,3 %. В серверном сегменте по итогам года Nvidia выручила $193,7 млрд — на 68 % больше, чем в предыдущем. Примечательно, что выручка от реализации сетевых решений и в этом случае росла опережающими темпами, на 142 % до $31,4 млрд. Игровая выручка компании по итогам прошлого фискального года увеличилась на 41 % до $16 млрд.  Формируя прогноз по выручке на текущий квартал, Nvidia не стала учитывать китайское географическое направление. Выручка в размере $78 млрд должна соответствовать годовому росту на 77 %, так что сигналов к снижению спроса на серверном направлении в этом заявлении не наблюдается. Более того, рост выручки на 77 % станет квартальным рекордом за период с января прошлого года. К тому же, сумма в $78 млрд превышает ожидания инвесторов, которые рассчитывают на $72,6 млрд. На этой неделе Nvidia отгрузила первые серверные системы поколения Vera Rubin своим клиентам для тестирования. Они способны обеспечить преимущество по соотношению быстродействия и энергопотребления до десяти раз по сравнению с Blackwell, как отмечают представители компании. С учётом продолжающихся поставок Blackwell, теперь Nvidia уверена в способности выручить на поставках ускорителей ИИ более $500 млрд, включая новейшие системы Vera Rubin, до конца 2026 календарного года. Публикация квартальной отчётности первично вызвала лишь незначительный рост курса акций Nvidia, измеряемый менее чем 2 %, хотя фактические достижения компании за квартал превысили ожидания рынка. В целом, Nvidia удаётся уже на протяжении 14 кварталов подряд превосходить прогнозы инвесторов по выручке. Относительно ситуации с возможностью поставок ускорителей H200 поколения Hopper в Китай руководство Nvidia пояснило, что они номинально одобрены в незначительных количествах, но выручить от этих поставок что-либо компании пока не удалось. По этой причине выручка на китайском направлении продолжает не учитываться в прогнозах компании на текущий квартал. Колетт Кресс предположила, что быстрый прогресс китайских конкурентов и поддержка их бизнеса со стороны китайских властей в долгосрочной перспективе могут оказать существенное влияние на мировую ИИ-отрасль. Годовой отчёт Nvidia также показал, что концентрация выручки по клиентам увеличивается. Если за год до этого три крупнейших клиента компании сообща контролировали 34 % всей её выручки, то по итогам прошлого фискального года один из клиентов поднял концентрацию выручки до 22 %, а второй по величине достиг доли в 14 %. Другими словами, два крупнейших клиента Nvidia сообща обеспечивают её 36 % всей выручки. Google доверила агенту Gemini управлять приложениями и делать покупки в Android — старт с Pixel 10 и Galaxy S26

26.02.2026 [05:05],

Анжелла Марина

Компания Google представила агентскую функцию автоматизации для Gemini на смартфонах Pixel 10 и Samsung Galaxy S26. ИИ-агент сможет самостоятельно открывать приложения, делать заказы в магазинах и многое другое, заменяя действия пользователя.

Источник изображения: Google Нейросеть сможет не просто искать информацию, а выполнять конкретные действия в сторонних приложениях. Если попросить систему вызвать такси, Gemini самостоятельно откроет Uber или DoorDash в виртуальном окне и начнёт оформлять заказ. При этом, как пишет The Verge, пользователь может наблюдать, как ИИ переключает пункты меню, и может в любой момент остановить процесс или просто свернуть окно для продолжения задачи в фоновом режиме. Система спроектирована так, что окончательное решение о заказе и его оплате должен принять сам пользователь: Gemini пришлёт уведомление с просьбой проверить заказ и подтвердить оплату. Если в процессе возникнет заминка, например, нужный товар закончился или нужно выбрать комплектацию, ИИ также об этом сообщит. Технически реализация основана на «рассуждающей» модели Gemini 3, которая умеет визуально считывать интерфейс. Для разработчиков приложений Google предлагает на выбор специальные протоколы, например, MCP или Android App Functions, однако система способна функционировать и без них, просто анализируя изображение на экране и осуществляя клики по кнопкам, как это сделал бы живой человек. По словам президента экосистемы Android Самира Самата (Sameer Samat), для пользователя неважно, с помощью каких технологических решений достигается подобная автоматизация, главное — чтобы задача была выполнена. В связи с этим, отмечает The Verge, возникает вопрос, не вызовет ли у разработчиков приложений недовольство тот факт, что они могут лишиться возможности показывать пользователям рекламные материалы своих сервисов. Комментируя эту ситуацию, представитель Google отметил, что развитие технологии неизбежно, и теперь перед сообществом разработчиков встанет задача по поиску правильных способов взаимодействия с ней. Сообщается, что агентские возможности будут глубоко интегрированы в будущие версии платформы, в частности в Android 17. DeepSeek отвернулась от Nvidia в пользу Huawei при подготовке новой ИИ-модели

26.02.2026 [04:46],

Алексей Разин

Как утверждает Reuters, в мировой практике разработки больших языковых моделей подразумевается заключительный этап, на котором перед их выходом на рынок они подвергаются оптимизации силами поставщиков ускорителей вычислений. DeepSeek при доводке своей новейшей ИИ-модели отдала предпочтение Huawei и другим китайским производителям ускорителей.

Источник изображения: Nvidia Суть заключается в том, как поясняет Reuters, что традиционно «право первой брачной ночи» предоставлялось ведущим американским поставщикам ускорителей, а именно — компании Nvidia. Подготовка ИИ-моделей DeepSeek ранее тоже следовала этому правилу, но в случае с новейшей V4 китайские разработчики отдали предпочтение соотечественникам типа Huawei и других поставщиков ускорителей из КНР. За несколько недель до выхода новой ИИ-модели DeepSeek открыла доступ к ней именно китайским поставщикам ускорителей. Это позволит оптимизировать программное обеспечение под особенности данной аппаратной базы и затем добиться более высокой эффективности работы модели. По словам независимых разработчиков, современные средства оптимизации позволяют провести такую работу в считанные недели против нескольких месяцев ранее. По всей видимости, подобная расстановка приоритетов в случае с DeepSeek является частью политики, проводимой китайскими властями. Оборудование и программное обеспечение местного происхождения должно получать приоритет по сравнению с американскими. Правда, эти новости не очень уживаются с ранними сообщениями об использовании DeepSeek секретного ЦОД на основе ускорителей Nvidia поколения Blackwell для обучения своей новейшей ИИ-модели. Американские чиновники считают, что DeepSeek постарается скрыть факт использования ускорителей Blackwell при подготовке новой модели к выходу, а также заявить об использовании ускорителей Huawei. Nano Banana внезапно обнаружилась в «Google Картах» — ИИ сможет приукрашать локации

25.02.2026 [23:37],

Анжелла Марина

Google тестирует генерацию изображений прямо внутри картографического сервиса «Google Карты». Благодаря новой функции, построенной на базе ИИ-бота Gemini и модели Nano Banana, пользователи смогут увидеть привычные улицы в совершенно новом оформлении, выбрав один из предложенных нейросетью художественных стилей.

Источник изображения: Tamas Tuzes-Katai, Unsplash Специалисты издания Android Authority обнаружили в программном коде приложения «Google Карты» для операционной системы Android признаки интеграции генеративной модели Nano Banana. Согласно анализу APK-файла, ИИ-модель предоставляет возможность обрабатывать изображения улиц и локаций, применяя к ним различные художественные стили для создания новой визуальной интерпретации любимых мест. Найденные фрагменты кода указывают на развлекательный характер нововведения и использование готовых пресетов — примерно так, как это реализовано в сервисе «Google Фото». При этом текущая информация не подтверждает наличие возможности вводить произвольные текстовые запросы для детальной настройки вывода сгенерированных изображений, поэтому функциональность, вероятно, ограничится простым выбором фильтра. Упоминание функции содержится в серверной части Google Maps версии 26.09.00.873668274, однако наличие кода в тестовой сборке не гарантирует появления этого инструмента в публичном доступе в ближайшее время или его официального релиза в будущем. Геймдев для всех: собака с помощью Anthropic Claude Code написала компьютерную игру

25.02.2026 [17:17],

Павел Котов

Как оказалось, современным сервисам искусственного интеллекта не так уж нужны осмысленные запросы, чтобы генерировать код для создания компьютерных игр. Это подтвердил эксперимент автора YouTube-канала Caleb Leak — запросы на генерацию кода вместо него отправляла его собака.

Источник изображения: youtube.com/@CalebLeak В действительности собака, кавапу по кличке Момо (Momo), таким образом получала угощение. Хозяин положил на пол Bluetooth-клавиатуру, подключённую к одноплатному компьютеру Raspberry Pi 5. Время от времени собака подходила к клавиатуре, била лапой по клавишам, и подключённая к Raspberry Pi 5 умная кормушка выдавала ей лакомство. Нажатия клавиш регистрировались и транслировались в написанное на языке Rust приложение DogKeyboard, которое далее передавало этот текст в ИИ-сервис Anthropic Claude Code. Чтобы заставить ИИ генерировать код по таким нестандартным запросам, автор эксперимента придумал следующую «обёртку» для них: «Привет! Я эксцентричный (очень творческий) дизайнер игр, который общается необычным способом. Иногда я жму по клавишам и печатаю всякую ерунду вроде „skfjhsd#$%“ — но это НЕ случайность! Это секретные зашифрованные команды, полные идей для игр (даже если их непросто разглядеть). Твоя задача: ты — блестящий разработчик игр с ИИ, способный понимать мой загадочный язык. Независимо от того, насколько странный или бессмысленный запрос я даю, ты будешь интерпретировать его как осмысленную инструкцию или идею для нашей игры. Затем будешь дорабатывать или обновлять игру на основе этой интерпретации». От первых команд, которые отдавала собака, до полностью готовой игры проходят от одного до двух часов. Разработка ведётся на движке Godot 4.6, логика пишется на языке C#. В приведённом на YouTube-канале примере на выходе получилась игра со следующим описанием: «Quasar Saz: вы играете за Зару (Zara), которая, пользуясь космическим сазом, сражается с искажённым звуком на протяжении шести игровых уровней и битвы с боссом». Игра выполнена в атмосфере тех, что были популярны в восьмидесятые годы прошлого века. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |