|

Опрос

|

реклама

Быстрый переход

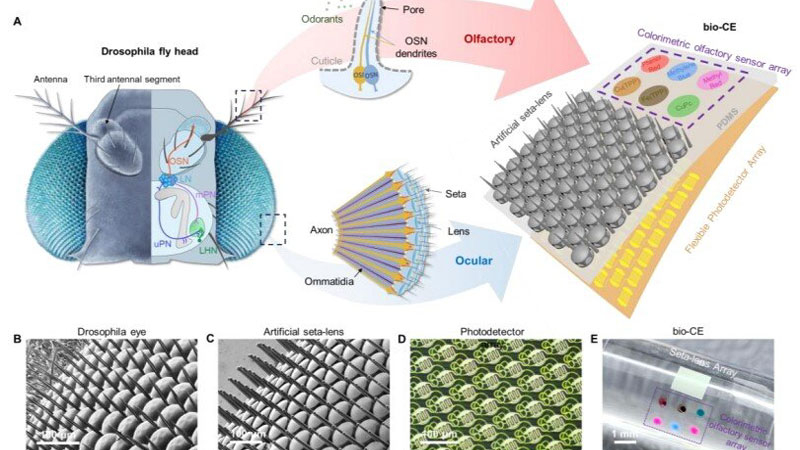

В Китае создали «глаз мухи» для дронов с панорамным зрением и встроенным «обонянием»

13.02.2026 [22:00],

Геннадий Детинич

Исследователи пока не смогли создать сферические мушиные глаза, но даже упрощённый глаз на плоской подложке впечатляет миниатюрными размерами и возможностями. Это платформа размером всего 1,5 × 1,5 мм. По сути, это габариты насекомого, что приближает появление миниатюрных дронов размером с таракана или даже муху. Современные устройства машинного зрения намного крупнее, сложнее и требуют значительной энергии и вычислительных ресурсов, от чего китайская разработка ушла довольно далеко.

Источник изображения: Nature Communications 2026 Более того, этот миниатюрный датчик содержит сенсоры ряда опасных газов, которые искусственный глаз распознаёт автоматически. Даже мухи на такое не способны — их глаза лишены обоняния. Комбинация зрения и обоняния на одном компактном сенсоре — это шаг на пути повышения энергоэффективности миниатюрных роботизированных платформ, а также увеличения скорости их реагирования на окружающую обстановку. Отвечающая за зрение часть датчика состоит из 1027 элементов с микролинзами, напечатанными непосредственно на гибком фотодетекторе с помощью фемтосекундной лазерной двухфотонной полимеризации (FL-TPP). Это делает каждый оптический элемент изолированным от других, обеспечивая поле зрения шириной 180°. Слияние вспышек света для датчика начинается с частоты выше 1 кГц — это почти на два порядка больше, чем у человеческого глаза. Тем самым искусственный мушиный глаз различает намного более быстрые движения. Обонятельная компонента реализована методом струйной печати на той же платформе: массив колориметрических сенсоров меняет цвет при контакте с опасными газами и химикатами, имитируя «нюх» насекомого. Дополнительно между линзами добавлены щетинки, как у настоящих насекомых, что необходимо для защиты от запотевания во влажной среде. Щетинки удержат капельки влаги на себе и не дадут им затянуть линзы. В тестах датчика на миниатюрном четырёхколёсном роботе система продемонстрировала высокую чувствительность при сближении с препятствиями и движущимися помехами без необходимости поворота «головы» благодаря панорамному обзору. Робот одновременно обнаруживал препятствия слева и справа, а также реагировал на утечки опасных газов. Устройство показало отличную производительность в обнаружении быстрых движений и химических угроз, превзойдя многие существующие сенсоры по компактности и энергоэффективности. Разработка открывает новые возможности для навигации беспилотных платформ, включая микродроны и рои роботов, в сложных условиях — например, при поиске выживших в завалах или мониторинге химических утечек в зонах катастроф. Такой датчик может значительно повысить «интеллект» биороботов за счёт одновременного визуально-обонятельного восприятия при минимальной массе и энергозатратах, обеспечивая важный шаг в направлении автономных систем следующего поколения. Роскомнадзор создаст ИИ для фильтрации интернет-трафика и борьбы с VPN за 2,27 млрд рублей

19.01.2026 [07:46],

Владимир Фетисов

В этом году Роскомнадзор (РКН) планирует разработать и запустить в эксплуатацию механизм фильтрации интернет-трафика с помощью технологий машинного обучения. Для реализации этого плана регулятор намерен потратить 2,27 млрд рублей. Об этом пишет Forbes со ссылкой на план цифровизации РКН.

Источник изображения: Tim van der Kuip / unsplash.com В сообщении сказано, что данный документ направлен в правительственную комиссию по цифровому развитию. В нём говорится о том, что новый инструмент фильтрации будет функционировать на базе уже работающих на сетях операторов технических средств противодействия угрозам (ТСПУ), обеспечивающих фильтрацию трафика по технологии Deep Packet Inspection (DPI). С помощью таких средств уже заблокировано свыше 1 млн ресурсов, а также ежедневно ограничивается доступ к примерно 5,5 тыс. сайтов. У РКН также есть специальный реестр, куда вносятся распространяющие запрещённую информацию сайты для последующей блокировки со стороны операторов. Эксперты считают, что использование ИИ-алгоритмов поможет РКН более эффективно выявлять и блокировать запрещённый трафик, а также VPN-сервисы. По мнению бизнес-консультанта по ИБ Positive Technologies Алексея Лукацкого, масштабирование технологии машинного обучения для анализа трафика и выявления угроз безопасности в масштабах Рунета позволяет выделить несколько вариантов расширения ТСПУ новыми возможностями. «Это выявление зашифрованного трафика или просто методов обхода блокировок ресурсов. Это важно в контексте курса РКН на блокировку VPN-сервисов. А также обнаружение DDoS-атак и выявление взаимодействия с командными серверами ботнетов и иных вредоносных инфраструктур, используемых кибермошенниками. Кроме того, можно классифицировать веб-приложения, находя те, которые запрещены в России (например, различные мессенджеры), и отличать стриминговый трафик от скачивания контента, что позволит выявлять пиратские ресурсы», — считает Лукацкий. Он также добавил, что технологии машинного обучения позволят реализовать более «прицельное» воздействие на сети. Речь, например, о «деградации» конкретного типа трафика вместо «ковровых» мер. «Машинное обучение в DPI — это способ лучше “угадывать, что за трафик”, когда классические методы обнаружения по сигнатурам, портам и т.п. уже не помогают», — добавил Лукацкий. Представитель организации RKS-Global сообщил, что инструменты машинного обучения на ТСПУ могут быть задействованы для создания и автоматического применения правил фильтрации. К примеру, для поиска и блокировки VPN-сервисов. Такие инструменты также позволят осуществлять поиск по текстам на разных языках, по изображениям и видео. «Так, Китай уже вовсю использует ИИ в мониторинге интернета», — отметил представитель RKS-Global. В США впервые разрешили испытания на людях мозгового имплантата для восстановления речи

21.11.2025 [20:03],

Геннадий Детинич

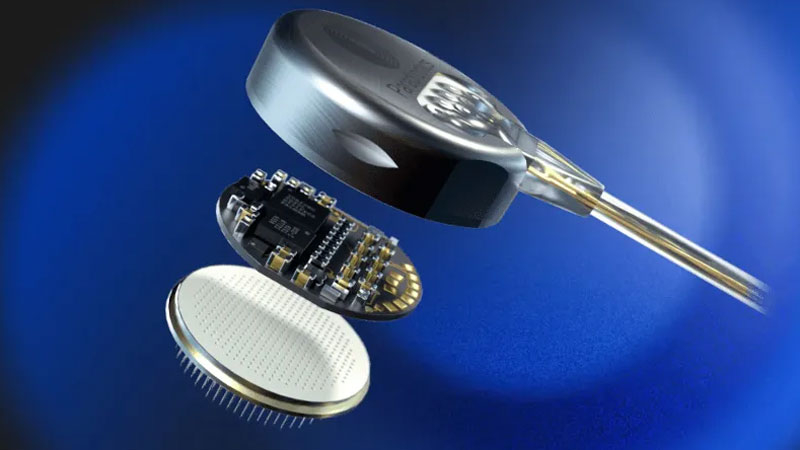

Американская компания Paradromics из Остина (Техас) получила от регулятора США одобрение на первые клинические испытания полностью имплантируемого интерфейса мозг-компьютер Connexus, предназначенного для восстановления речи у пациентов с тяжёлым параличом. Это первое в мире устройство такого класса, получившее разрешение для испытания на людях. Устройство полностью беспроводное и может стать революцией в помощи пациентам с потерей речи.

Источник изображений: Paradromics В июне этого года компания Paradromics впервые испытала свой мозговой имплантат на мозге живого человека. Но тогда он вживлялся в область мозга, предназначенную для ампутации. Задача стояла проверить совместимость материалов и характеристик датчика с живой тканью человека. Эксперимент был признан успешным, что позволило подать заявку на начало клинических испытаний. Управление по контролю за продуктами и лекарствами США (FDA) разрешило компании установить датчики Connexus двум пациентам — по одному каждому. В случае успеха эксперимент будет расширен до участия десяти пациентов, двоим из которых внедрят сразу два датчика для увеличения объёма собранных данных и точности слежения за мозговой активностью. Каждый из датчиков представляет собой «монетку» размерами 7,5 × 1,5 мм с более чем 400 электродами из платины и иридия. Толщина каждого равна 40 мкм, что ненамного больше размеров одного нейрона. Именно в этом кроются преимущества датчика Connexus — каждый электрод способен улавливать активность примерно одного нейрона в моторной коре головного мозга. Датчик Connexus не может читать мысли человека. Он считывает активность нейронов, когда человек мысленно пытается произнести слова, делая попытку напрячь мышцы гортани, языка и губ. Если пациент парализован, то ни о какой мышечной активности речи быть не может. Он останется нем. Но произведённая мысленными усилиями отдача команд не пропадёт — датчик считает активность мозга и с помощью индивидуально настроенной большой языковой модели транслирует её в речь. Если для обучения использовать архивные аудиозаписи человека, то синтезированная речь может быть полной имитацией говора самого пациента.  Электроды датчика погружаются на небольшую глубину в ткани коры головного мозга пациента. Контроллер для обработки мозговой активности встроен непосредственно в датчик. Обработанный сигнал по имплантированному под кожу проводу поступает в район грудной клетки пациента, где вживляется оптический приёмопередатчик для отправки сигнала на внешний носимый приёмник. Приёмник и по совместительству беспроводное зарядное устройство для передатчика в теле человека подключается к носимому компьютеру с программой-дешифратором и синтезатором речи. Также в процессе эксперимента будет проверена возможность расшифровывать мысленные движения рук пациентов, чтобы управлять курсором компьютера или другой электроникой. В любом случае первые клинические испытания на людях приблизят момент, когда потерявшие после инсульта или травм речь пациенты смогут вернуться к полноценному общению. Qualcomm вернулась в большие вычисления: представлены ИИ-ускорители AI200 и AI250 для дата-центров

27.10.2025 [23:13],

Николай Хижняк

Компания Qualcomm анонсировала два ускорителя ИИ-инференса (запуска уже обученных больших языковых моделей) — AI200 и AI250, которые выйдут на рынок в 2026 и 2027 годах. Новинки должны составить конкуренцию стоечным решениям AMD и Nvidia, предложив повышенную эффективность и более низкие эксплуатационные расходы при выполнении масштабных задач генеративного ИИ.

Источник изображений: Qualcomm Оба ускорителя — Qualcomm AI200 и AI250 — основаны на нейронных процессорах (NPU) Qualcomm Hexagon, адаптированных для задач ИИ в центрах обработки данных. В последние годы компания постепенно совершенствовала свои нейропроцессоры Hexagon, поэтому последние версии чипов уже оснащены скалярными, векторными и тензорными ускорителями (в конфигурации 12+8+1). Они поддерживают такие форматы данных, как INT2, INT4, INT8, INT16, FP8, FP16, микротайловый вывод для сокращения трафика памяти, 64-битную адресацию памяти, виртуализацию и шифрование моделей Gen AI для дополнительной безопасности. Ускорители AI200 представляют собой первую систему логического вывода для ЦОД от Qualcomm и предлагают до 768 Гбайт встроенной памяти LPDDR. Система будет использовать интерфейсы PCIe для вертикального масштабирования и Ethernet — для горизонтального. Расчётная мощность стойки с ускорителями Qualcomm AI200 составляет 160 кВт. Система предполагает использование прямого жидкостного охлаждения. Для Qualcomm AI200 также заявлена поддержка конфиденциальных вычислений для корпоративных развертываний. Решение станет доступно в 2026 году. Qualcomm AI250, выпуск которого состоится годом позже дебютирует с новой архитектурой памяти, которая обеспечит увеличение пропускной способности более чем в 10 раз. Кроме того, система будет поддерживать возможность дезагрегированного логического вывода, что позволит динамически распределять ресурсы памяти между картами. Qualcomm позиционирует его как более эффективное решение с высокой пропускной способностью, оптимизированное для крупных ИИ-моделей трансформеров. При этом система сохранит те же характеристики теплопередачи, охлаждения, безопасности и масштабируемости, что и AI200. Помимо разработки аппаратных платформ, Qualcomm также сообщила о разработке гипермасштабируемой сквозной программной платформы, оптимизированной для крупномасштабных задач логического вывода. Платформа поддерживает основные наборы инструментов машинного обучения и генеративного ИИ, включая PyTorch, ONNX, vLLM, LangChain и CrewAI, обеспечивая при этом беспроблемное развертывание моделей. Программный стек будет поддерживать дезагрегированное обслуживание, конфиденциальные вычисления и подключение предварительно обученных моделей «одним щелчком мыши», заявляет компания. Частоту сердечного ритма измерили Wi-Fi-сигналом

06.09.2025 [11:24],

Павел Котов

Группа молодых исследователей Калифорнийского университета в Санта-Кларе во главе с профессором информатики и вычислительной техники Катей Обрачкой (Katia Obraczka) разработали систему Pulse-Fi, которая при помощи анализа сигнала Wi-Fi производит бесконтактный замер частоты сердечных сокращений у человека.

Источник изображения: ucsc.edu Для работы системы они предложили обрабатывать данные беспроводного микроконтроллера ESP32 при помощи алгоритма машинного обучения, который, проведя анализ искажений сигнала Wi-Fi в течение пяти секунд, действительно стал выдавать оценки частоты сердечных сокращений у человека с погрешностью около половины удара в минуту. При более длительном наблюдении и использовании более мощного оборудования с Wi-Fi погрешность удалось снизить. Система Pulse-Fi выполняет свою функцию на расстоянии около 3 м от устройства, то есть не требует прямого контакта с телом человека. Систему испытали на 118 добровольцах и 17 положениях тела — авторы проекта установили что она не требует особых условий применения: можно лежать, сидеть и ходить, не опасаясь, что точность результатов снизится. Важнейшим достоинством проекта является низкая цена используемого оборудования — учёные уложились в диапазон от $5 до $10. Платформы класса Raspberry Pi демонстрируют ещё более высокую точность и при цене $30 представляются достаточно доступными для массового применения. На выходе получаются данные, точность которых сравнима с точностью используемых большинством врачей пульсоксиметров — они замеряют частоту сердечных сокращений и насыщение крови кислородом, но требуют прямого контакта и обычно надеваются на палец. Сейчас авторы проекта Pulse-Fi пытаются построить систему для измерения частоты дыхания. Она поможет выявлять апноэ во сне, для работы с которым обычно приходится пользоваться портативным монитором, который нужно носить с собой. Если исследователи смогут решить и эту задачу на основе анализа беспроводного сигнала, то обнаружение и диагностика данного синдрома станут удобнее и проще. Робопёс с крошечным человеческим мозгом научился избегать препятствий

21.08.2025 [12:49],

Геннадий Детинич

Учёные в США наделили робопса крошечным человеческим мозгом, интегрировав его с датчиками и системой управления платформой. Встроенный в робота органоид мозга помог машине быстро научиться избегать препятствий. Однако в своей основе исследование было куда шире — оно было направлено на создание перспективных решений для безопасных интерфейсов связи живого мозга и компьютера.

Источник изображения: ИИ-генерация Grok 3/3DNews Выращивание живой нервной ткани из стволовых клеток человека не является чем-то новым. Проблемой остаётся её надёжная стимуляция и создание эффекта старения. Прямая стимуляция электрическим током часто приводит к повреждению тканей. К тому же, от ряда токопроводящих подложек трудно добиться полной биосовместимости, что также вредит развитию нервных тканей и их функционированию. Как вариант возможна полностью безопасная стимуляция светом, но она выполнима только при генной модификации нервных тканей мозга. В таком случае он становится ещё дальше от человеческого. Наконец, важным для научной работы остаётся вопрос ускоренного старения органоидов — это необходимо для испытания лекарств и изучения болезней мозга. Ждать естественного старения нервных тканей слишком долго. Новое исследование, проведённое в США учёными Калифорнийского университета в Сан-Диего совместно с компанией NeurANO Bioscience, привело к созданию перспективной биосовместимой платформы для выращивания, стимулирования и ускоренного созревания органоидов мозга. Результатом работы стала платформа GraMOS. В этом случае органоид помещается на атомарно тонкий лист графена, а стимуляция производится световыми импульсами. Взаимодействие фотонов с графеном возбуждает в нём слабые электрические токи, которые стимулируют как рост, так и активность нейронов органоида. «Это всё равно что слегка подтолкнуть их, чтобы они быстрее выросли. Это необходимо для изучения возрастных заболеваний в лабораторных условиях», — рассказала автор работы и ведущий руководитель Nanotools Bioscience Елена Молоканова. Поскольку стимуляция ускоряет рост нейронов, учёные считают, что это поможет им быстрее изучать заболевания и тестировать лекарства. «Наша технология устраняет критический пробел в исследованиях органоидов, — заявил Алекс Савченко, генеральный директор Nanotools Bioscience и соавтор исследования. — Она предлагает надёжный и воспроизводимый способ активации нейронов, который может изменить как фундаментальную нейробиологию, так и прикладные исследования». В качестве практической демонстрации платформы органоид мозга на графене встроили в робопса. После этого он научился определять препятствия и избегать их за 50 мс. Исключительно электронная реализация аналогичного поведения потребовала бы более сложной архитектуры и программирования, тогда как «мозг» обучился на своих ошибках и самостоятельно вырастил нейронные связи для решения задач по ориентированию. В США разработали настолько хороший «считыватель мыслей», что ему понадобилось стоп-слово

15.08.2025 [11:59],

Геннадий Детинич

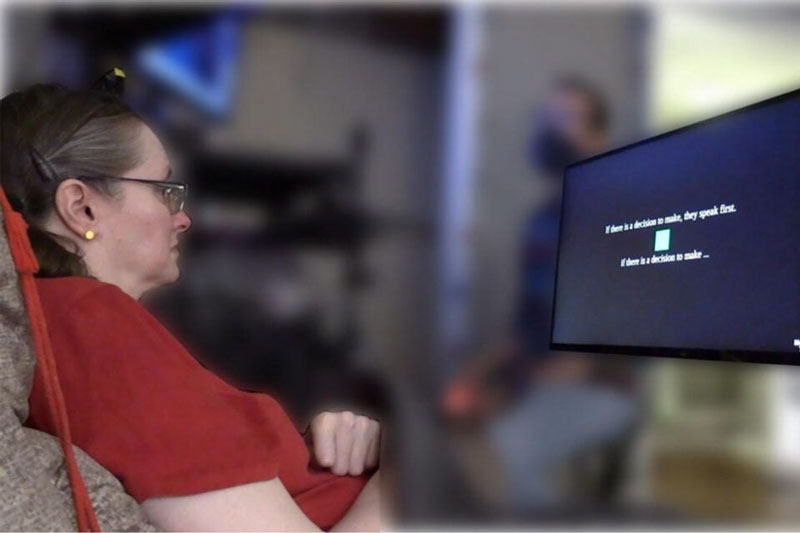

Новые технологии открывают перед людьми с заболеваниями нервных тканей возможность живого общения, что недоступно или затруднительно для больных после инсультов или травм. Такие пациенты передают свои мысли и чувства сложными жестами, с большим физическим напряжением и очень медленно. Искусственный интеллект и новейшие датчики нервных импульсов значительно упрощают трансляцию мыслей в слова, что невозможно переоценить.

Источник изображения: Emory BrainGate Team Исследователи из Стэнфордского университета (Stanford University) усовершенствовали платформу для считывания мысленной речи пациентов, доведя её до уровня живого общения. В основе новой разработки они использовали ту же методику, которая применяется для распознавания нервных сигналов, направляемых к мышечным тканям речевого аппарата человека, но со значительными улучшениями. Процесс речи условно можно разделить на три этапа: формирование мысли, передачу фразы в область мозга для подготовки сигналов речевому аппарату и непосредственно передачу сигналов мышцам речевого аппарата. В зависимости от травмы головного мозга второй этап может отсутствовать, но чаще нарушается канал для третьего — финального этапа. Современные нейроимплантаты и машинное обучение научились распознавать нервную деятельность третьего этапа формирования речи. Но для этого пациент должен прикладывать усилия (напрягать мышцы), как будто он говорит, включая необходимость вдохов. Для части больных это сложно или даже невозможно и буквально изматывает физически. Учёные из Стэнфорда смогли настроить имплантаты в моторной коре головного мозга таким образом, что они улавливали нервные импульсы уже на этапе передачи обдуманной фразы в область формирования речевых импульсов. Фактически новая платформа сразу транслирует мысли пациентов без необходимости напряжения или его имитации голосовыми связками. Эта внутренняя речь не требует дополнительных усилий и, как показали проверки на четверых пациентах с инсультом ствола головного мозга и с боковым амиотрофическим склерозом, даётся больным достаточно легко. В то время как предыдущие декодеры внутренней речи ограничивались лишь несколькими словами, новое устройство позволяло участникам выбирать из словаря, содержащего 125 000 слов. «Наша цель как исследователей — найти систему, которая будет удобна [для пользователя] и в идеале будет максимально приближена к естественным способностям, — говорит ведущий автор исследования Эрин Кунц (Erin Kunz). — Предыдущие исследования показали, что физические попытки говорить утомляют и что у них есть врождённые ограничения по скорости». Благодаря новой технологии, участники исследования могли общаться с комфортной для разговора скоростью — от 120 до 150 слов в минуту, затрачивая не больше усилий, чем на обдумывание того, что они хотят сказать. Точность выбора составляла 74 %. Мысленная речь лилась так быстро и легко, что для её остановки — для сохранения приватности — даже пришлось выдумать кодовую фразу. В частности, распознавание внутреннего монолога прерывалось фразой «читти-читти бах-бах», которая распознавалась платформой в 98 % случаев. LiXiang L7 на автопилоте ошарашил сотрудников ГИБДД в Казани — пассажиров всё равно оштрафовали

17.07.2025 [17:18],

Владимир Фетисов

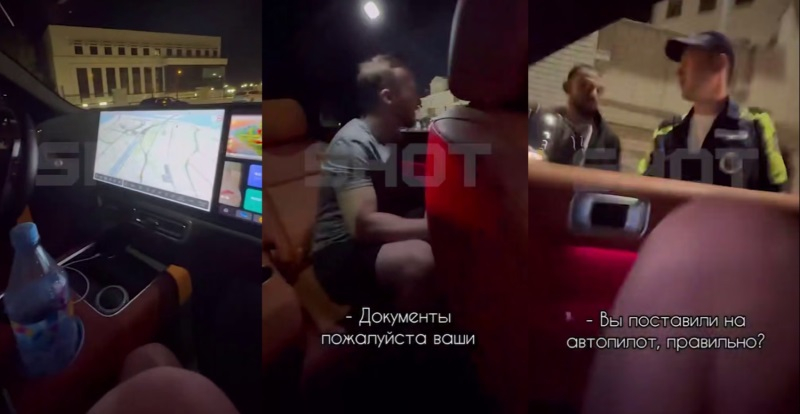

Казанские инспекторы ГИБДД остановили внедорожник LiXiang L7, который ехал по дороге без видимого водителя за рулём. В салоне находились пассажиры, утверждавшие, что автомобиль движется на автопилоте и управляется со смартфона. Сообщение об этом появилось в Telegram-канале «Вечерняя Казань».

Источник изображения: «Вечерняя Казань» Пассажиры пытались объяснить инспекторам, что сидеть за рулём необязательно, поскольку управление осуществляется через приложение. Однако инспекторов это не убедило, и они оштрафовали пассажиров за то, что те не были пристёгнуты ремнями безопасности. «Внутри внедорожника были только пассажиры, которые наперебой пытались объяснить, что машина едет на автопилоте и управляется через телефон. После небольшого обсуждения полицейские всё же нашли нарушение — компании выписали штраф за непристёгнутые ремни безопасности, а затем отпустили», — говорится в сообщении. В МВД пояснили, что водителем всё же считается тот, кто управляет автомобилем через смартфон. Однако достоверно определить это сложно, поскольку телефон можно быстро передать другому человеку. «Если нетрезвый человек будет нажимать на кнопки и ехать, его также лишат прав и могут отправить в изолятор на некоторое время», — добавил представитель МВД. Учёные заставили ИИ видеть то, чего нет — машинное зрение оказалось уязвимым

03.07.2025 [19:19],

Сергей Сурабекянц

Исследователи из университета Северной Каролины продемонстрировали новый способ атаки на системы компьютерного зрения, позволяющий контролировать то, что «увидит» искусственный интеллект. Использованный метод под названием RisingAttacK оказался эффективным для манипулирования всеми наиболее широко используемыми системами компьютерного зрения.

Источник изображения: unsplash.com RisingAttacK — это так называемая «состязательная атака» (adversarial attack), которая манипулирует данными, подаваемыми в систему ИИ. RisingAttacK состоит из серии операций, целью которых является внесение минимального количества изменений в изображение, которое позволит сбить с толку когнитивные способности ИИ. В результате ИИ может неправильно определить цвет светофора или поставить ошибочный диагноз по рентгеновскому снимку. Сначала RisingAttacK идентифицирует все визуальные особенности изображения и пытается определить, какая из них наиболее важна для достижения цели атаки. Затем RisingAttacK вычисляет, насколько чувствительна система ИИ к изменениям найденных ключевых особенностей. «Это требует некоторой вычислительной мощности, но позволяет нам вносить очень небольшие целенаправленные изменения в ключевые особенности, что делает атаку успешной, — рассказал доцент кафедры электротехники и вычислительной техники университета Северной Каролины Тяньфу Ву (Tianfu Wu). — В результате два изображения могут выглядеть одинаково для человеческого глаза, и мы можем чётко видеть машину на обоих изображениях. Но из-за RisingAttacK ИИ увидит машину на первом изображении, но не увидит на втором».

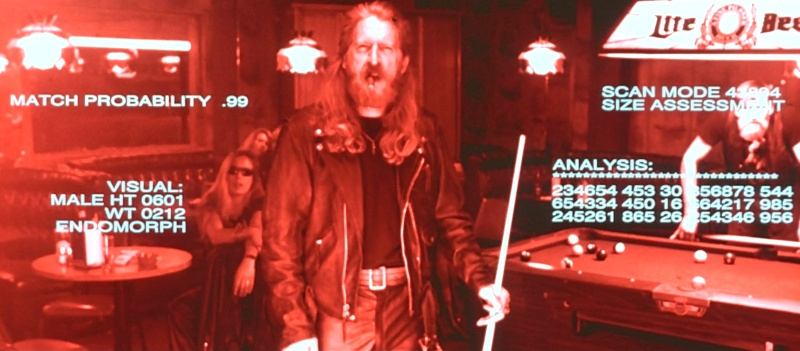

Источник изображений: Tri-Star Pictures Исследователи протестировали метод RisingAttacK против четырёх наиболее часто используемых программ компьютерного зрения: ResNet-50, DenseNet-121, ViTB и DEiT-B. Метод оказался эффективным при манипулировании всеми четырьмя программами. «Мы хотели найти эффективный способ взлома систем машинного зрения с ИИ, потому что эти системы часто используются в контекстах, которые могут повлиять на здоровье и безопасность человека — от автономных транспортных средств до медицинских технологий и приложений безопасности, — пояснил Ву. — Выявление уязвимостей является важным шагом в обеспечении безопасности этих систем».  «Хотя мы продемонстрировали способность RisingAttacK манипулировать моделями зрения, сейчас мы находимся в процессе определения того, насколько эффективен этот метод при атаке на другие системы искусственного интеллекта, такие как большие языковые модели. В дальнейшем наша цель состоит в разработке методов, которые могут успешно защищать от таких атак», — заключил он. Исследовательская группа сделала код RisingAttacK общедоступным для изучения и тестирования. Hisense представила для российского рынка новейшие телевизоры, проекторы и многое другое

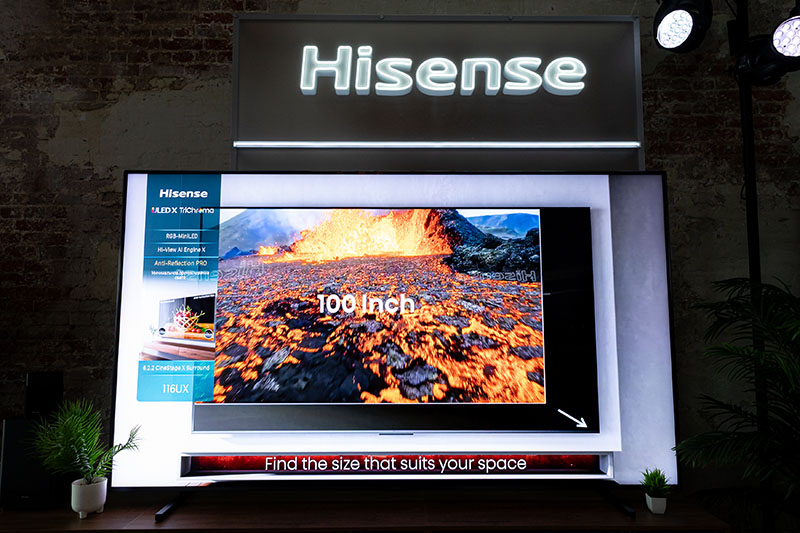

21.06.2025 [22:32],

Владимир Мироненко

Компания Hisense, специализирующаяся на производстве телевизионной и бытовой техники, провела в Москве первую конференцию Hisense. Tech Inside, посвящённую новейшим технологиям. На мероприятии топ-менеджеры Hisense рассказали о стратегии компании в рамках инновационного развития, и познакомили гостей с её новыми решениями.  «Из нового мы выбираем лучшее и находим пути применения передовых разработок в привычных предметах быта. В результате выполнение рутинных задач становится удовольствием. Техника Hisense берёт на себя все тонкости процесса, предоставляя пользователям лишь блестящий результат», — сообщил Деян Ачимович, вице-президент по продажам бытовой техники в России и СНГ компании ООО «Горенье БТ», входящей в группу компаний Hisense.  Вниманию гостей мероприятия была предложена экспозиция техники Hisense, включающая новинки 2025 года. В их числе телевизор Hisense 116UXQ с диагональю экрана 116 дюймов, новой технологией подсветки RGB Mini-LED и аудиосистемой 6.2.2. Также на конференции были представлены телевизоры Hisense серии Q из сегментов Mini-LED и QLED. Сегмент Mini-LED-телевизоров, доступный в России, пополнился моделями Hisense U8Q, Hisense U7Q и Hisense U7Q Pro, в категории QLED-устройств был представлен телевизор Hisense E7Q Pro.  Новинки могут похвастаться режимом Room Fitting Tuning для настройки звучания в зависимости от планировки помещения, датчиком AI Chroma Light Sencor, который регулирует яркость и цветопередачу в соответствии с окружающими условиями, а также поддержкой технологии 3D LUT (Look-Up Table) ТВ для обеспечения реалистичных цветов.  Также следует отметить использование ИИ-ресурсов, а именно AI 4K Upscaler, очерчивающего границы объектов и улучшающего детализацию текстур, AI HDR Upscaler, повышающего качество воспроизведения контента HDR10 до близкого к HDR10+, AI Depth PRO, увеличивающего глубину кадра и выразительность ключевых объектов, AI Natural Face, подчеркивающего естественность контуров и выражения лиц и т. д. И конечно же следует добавить к этому большие размеры диагонали, мощный игровой режим и глубокое звучание.  Телевизор Hisense E7Q Pro, пополнивший семейство QLED-телевизоров компании, отличается оптимальной частотой обновления и сбалансированной цветопередачей. В нём предусмотрены специальные режимы для получения иммерсивного опыта в играх, а также поддержка технологий Dolby Vision, Dolby Atmos, HDR10 и HDR10+. Кроме того, телевизор поддерживает ИИ-технологии AI Light Sensor, AI Sports Mode, AI Smooth Motion. Также на мероприятии был представлен саундбар Hisense HT Saturn, настройка звука которого производилась при поддержке специалистов французской компании Devialet, признанного эксперта на мировом аудиорынке. Аудиосистема HT Saturn оснащена передовыми технологиями звучания и легко интегрируется с телевизорами Hisense с помощью технологии Hi-Concerto. Помимо чёткой детализации, устройство в автоматическом режиме анализирует акустику помещения и в соответствии с его параметрами подстраивает характеристики воспроизведения аудио. Гости мероприятия могли по достоинству оценить новейшие разработки Hisense — ультракороткофокусный проектор Hisense PT1 и компактный проектор Hisense M2 Pro, созданные, чтобы воссоздавать атмосферу кинотеатра. Благодаря технологии TriChroma 4K и яркости 2500 ANSI-люмен проектор Hisense PT1 обеспечивает естественную цветопередачу (до 110 % BT2020) и комфортный просмотр при различных условиях освещения. Благодаря компактным размерам среднефокусный проектор TriChroma 4K Hisense M2 Pro без труда транспортируется, что позволяет устраивать с его помощью вечеринки и кинопоказы даже на открытом воздухе. Следует отметить, что трёхцветный лазерный источник света TriChroma значительно расширяет базовую цветовую палитру. На Hisense. Tech Inside также демонстрировались холодильники серии Kitchenfit — Hisense RB3K330SAC1, Hisense RL3K370SAIE и Hisense FT3K310SAIE, которые хорошо подходят для интерьера любой кухни. Во-первых, глубина моделей составляет всего 60 см. Во-вторых, устройства обладают улучшенным механизмом петель. В-третьих, угол открывания дверцы превышает 103° с минимальными зазорами (2,5 мм по бокам и 5 мм сверху). Следует добавить, что новинки имеют мощный инверторный компрессор, их работой можно управлять удаленно, а такие функции, как Convert для переключения морозильной камеры в холодильную в модели Hisense FT3K310SAIE, позволят адаптировать холодильники к предпочтениям пользователей. Экспозиция Hisense. Tech Inside также включала стиральные машины компании, в том числе новые модели Hisense WF5I8043BWF и Hisense WD5I8043BWF с функцией сушки. Несмотря на компактные размеры стиральные машины довольно вместительные. Для повышения эффективности работы в них установлены гибридные форсунки. Новинки отличаются поддержкой различных режимов стирки, среди которых легко выбрать наиболее подходящий для бережного ухода за одеждой и бельем. Процессом стирки можно управлять по Wi-Fi. Мозговой имплант Neuralink позволил обезьяне увидеть несуществующий предмет

14.06.2025 [06:49],

Алексей Разин

Идея создания интерфейса между мозгом человека и компьютером не является для стартапа Neuralink Илона Маска (Elon Musk) единственным направлением разработок в сфере мозговых имплантов. Устройство Blindsight призвано вернуть способность видеть незрячим пациентам, и недавно в ходе испытаний на обезьяне представителям компании удалось добиться определённого успеха.

Источник изображения: Neuralink Выступая на конференции в пятницу, инженер Neuralink Джозеф О’Доэрти (Joseph O’Doherty) рассказал о том, что ему и его коллегам удалось оказать стимулирующее воздействие на мозг обезьяны с вживлённым имплантом Blindsight, вызвав у неё своего рода зрительную галлюцинацию. Как считают авторы эксперимента, по меньшей мере две трети времени животное могло видеть некий предмет, которого в реальности не существовало. Об этом они могли судить по движению глаз подопытной обезьяны. Neuralink впервые открыто говорит о своих тестах импланта Blindsight. О клинических испытаниях с привлечением людей пока говорить преждевременно, поскольку в США это устройство не получило соответствующих одобрений со стороны регулирующих органов. Илон Маск ранее заявлял, что возвращение людям зрения является лишь базовой задачей проекта Blindsight, в идеале стартап хотел бы развить этот канал восприятия человеком действительности до пределов, не предусмотренных природой. Например, такие импланты могут наделить человека способность видеть в инфракрасном спектре. В марте он признался, что испытания Blindsight на обезьянах проводятся уже несколько лет, но вживить имплант первому человеку компания надеется до конца текущего года. Попутно инженер Neuralink поведал о прогрессе в испытаниях первой модели импланта, который позволяет транслировать нервные импульсы в компьютерные команды. На данный момент имплантом пользуются пять пациентов с той или иной формой паралича конечностей или мышц. Отдельные участники клинических испытаний пользуются возможностями импланта по 60 часов в неделю. Представитель Neuralink на конференции рассказал об экспериментах компании, в ходе которых имплант использовался для стимуляции мышечных сокращений обезьяны через головной мозг. В перспективе, подобная технология позволит вернуть подвижность парализованным пациентам без необходимости использования протезов или экзоскелета. В отношении дальнейших перспектив развития Blindsight было сказано, что стартап планирует использовать в сочетании с мозговым имплантом пару специальных очков, которые позволят вернуть зрение лишившимся его людям. Отвечающая за зрение часть головного мозга обезьяны расположена ближе к его поверхности, чем у человека, и это упрощает тестирование чипа на данном этапе. В случае с человеческим мозгом электроды импланта будут размещаться в более глубоких областях при помощи хирургического робота, разработанного Neuralink. В Китае создали ИИ, который сам проектирует процессоры не хуже людей

12.06.2025 [21:04],

Николай Хижняк

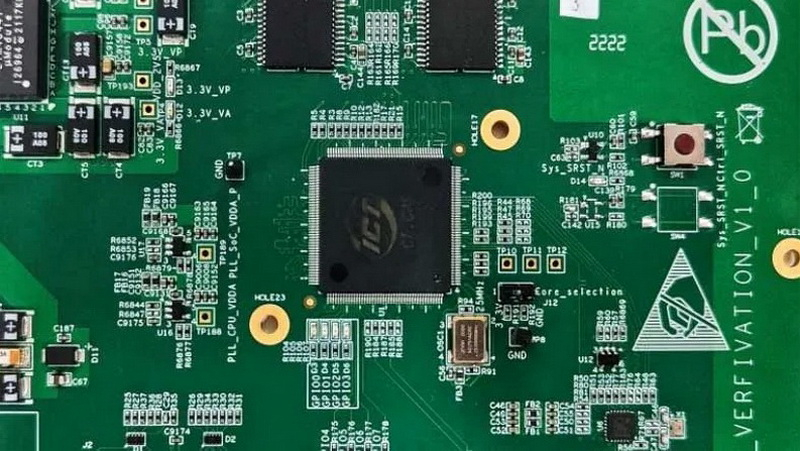

Исследователи Китайской государственной лаборатории по разработке процессоров и Исследовательского центра интеллектуального программного обеспечения сообщили о создании ИИ-платформы для автоматизированной разработки микросхем. Проект с открытым исходным кодом QiMeng использует большие языковые модели (LLM) для «полностью автоматизированного проектирования аппаратного и программного обеспечения», а также может применяться для проектирования «целых CPU».

Источник изображений: Китайская академия наук По словам разработчиков, чипы, разработанные QiMeng, соответствуют производительности и эффективности тех микросхем, которые были созданы экспертами-людьми. На базе QiMeng исследователи в качестве примера уже спроектировали два процессора: QiMeng-CPU-v1, сопоставимый по возможностям с Intel 486; и QiMeng-CPU-v2, который, как утверждается, может конкурировать с чипами на Arm Cortex-A53. Стоит отметить, что разница между этими продуктами составляет 26 лет. Чип Intel 486 был представлен в 1986 году, а Arm Cortex-A53 — в 2012-м. QiMeng состоит из трёх взаимосвязанных слоёв: в основе лежит доменно-специфическая модель большого процессорного чипа; в середине — агент проектирования аппаратного и программного обеспечения; верхним слоем выступают различные приложения для проектирования процессорных чипов. Все три слоя работают в тандеме, обеспечивая такие функции, как автоматизированное front-end-проектирование микросхем, генерация языка описания оборудования, оптимизация конфигурации операционной системы и проектирование цепочки инструментов компилятора. По словам разработчиков платформы, QiMeng может за несколько дней сделать то, на что у команд, состоящих из людей-инженеров, уйдут недели работы. В опубликованной статье, описывающей особенности платформы QiMeng, её разработчики также освещают проблемы, с которыми приходится сталкиваться при текущем проектировании чипов, включая «ограниченную технологию изготовления, ограниченные ресурсы и разнообразную экосистему». QiMeng же стремится автоматизировать весь процесс проектирования и проверки чипов. По словам разработчиков, цель заключалась в повышении эффективности, снижении затрат и сокращении циклов разработки по сравнению с ручными методами проектирования микросхем, а также в содействии быстрой настройке архитектур микросхем и программных стеков, специфичных для конкретной области. Как пишет Tom’s Hardware, крупные западные технологические компании, занимающиеся проектированием микросхем, такие как Cadence и Synopsys, тоже активно внедряют ИИ в процессы создания чипов. Например, Cadence использует несколько ИИ-платформ для ключевых этапов проектирования и проверки. В свою очередь, ИИ-платформа DSO.ai от Synopsys, по последним подсчётам, помогла с разработкой более 200 проектов микросхем. Анонс платформы QiMeng произошёл на фоне давления властей США на ведущих поставщиков программного обеспечения для автоматизации проектирования электроники (EDA), чтобы те прекратили продажу инструментов для проектирования микросхем в Китай, что ещё больше усложнило задачу Пекина по укреплению своей полупроводниковой промышленности. Разработчики QiMeng отмечают, что Китай должен отреагировать, поскольку технология проектирования чипов является «стратегически важной отраслью». Издание South China Morning Post со ссылкой на данные последнего анализа Morgan Stanley сообщает, что на долю Cadence Design Systems, Synopsys и Siemens EDA в прошлом году пришлось в общей сложности 82 % выручки на китайском рынке EDA. Figure похвалилась успехами человекоподобного робота Helix на работе, но посылки продолжают летать по складу

09.06.2025 [19:26],

Сергей Сурабекянц

Три месяца назад робототехнический стартап Figure «устроил на работу» в почтовое отделение своего передового гуманоидного робота Helix. Сегодня представители компании подробно рассказали о накопленном за это время опыте и успехах робота в сортировке посылок. Однако при просмотре опубликованного компанией почти часового видеоролика мы заметили множество ошибок, совершаемых Helix. Пожалуй, свои посылки мы ему пока доверить не готовы.

Источник изображений: Figure «Теперь Helix может обрабатывать более широкий спектр упаковок и приближается к ловкости и скорости человеческого уровня, приближая нас к полностью автономной сортировке посылок. Этот быстрый прогресс подчёркивает масштабируемость основанного на обучении подхода Helix к робототехнике, который быстро переносится в реальное применение», — так оценил успехи робота представитель Figure. По его словам, за счёт масштабирования данных и усовершенствования архитектуры возможности Helix существенно повысились:

Помимо стандартных жёстких коробок система теперь обрабатывает полиэтиленовые пакеты, мягкие конверты и другие деформируемые или тонкие посылки. Эти предметы могут складываться, мяться или изгибаться, что затрудняет захват и распознавание этикеток. Helix решает эту задачу, корректируя стратегию захвата на лету — например, отбрасывая мягкий пакет для его динамического переворота или используя специальные захваты для плоских почтовых отправлений. Робот должен поворачивать упаковку штрих-кодом вниз для сканирования. Helix старается расправить пластиковую упаковку, чтобы сканер смог успешно считать штрих-код. Такое адаптивное поведение подчёркивает преимущества сквозного обучения — робот выполняет действия, которые не были жёстко запрограммированы, чтобы компенсировать несовершенства упаковки. Многие достижения стали возможны благодаря целенаправленным улучшениям визуально-моторной политики робота. Он получил новые модули памяти и машинного зрения, что позволило ему лучше воспринимать состояние окружающей среды и быстро адаптироваться к изменениям ситуации. Helix оснащён модулем неявной визуальной памяти, который обеспечивает поведение с учётом текущего состояния — робот запоминает, какие стороны упаковки он уже осмотрел, либо какие зоны конвейера свободны. Модуль памяти помогает устранять избыточные движения, давая Helix ощущение временного контекста и позволяя ему действовать более стратегически при выполнении многошаговых манипуляций. Отслеживание истории недавних состояний позволяет роботу осуществлять более быстрое и реактивное управление. В результате ускоряется реакция на неожиданности и помехи: если пакет смещается или попытка захвата оказывается неудачной, Helix корректирует движение «на лету». Это значительно сократило время обработки каждого пакета. Helix использует аналог человеческого осязания благодаря интегрированной обратной связи по усилию. Робот способен определить момент соприкосновения с объектом и использовать это для модуляции движения, например, приостанавливая опускание при контакте с конвейерной лентой. Хотя основной задачей Helix в логистическом сценарии является автономная сортировка, он легко адаптируется к новым взаимодействиям. Например, протянутая к нему рука человека интерпретируется как сигнал к передаче предмета: робот отдаёт посылку, а не размещает её на конвейере — подобное поведение заранее явно не программировалось, система самостоятельно обучилась ему.  «Helix неуклонно масштабируется в плане ловкости и надёжности, сокращая разрыв между освоенными роботизированными манипуляциями и требованиями реальных задач. Мы продолжим расширять набор навыков и обеспечивать стабильность на ещё больших скоростях и рабочих нагрузках», — заявил представитель Figure. В реальности всё далеко не так радужно, как описывают маркетологи Figure — по следующим ссылкам можно увидеть, что робот совершает много ошибок, путается, роняет посылки и порой откровенно зависает. Так что какое-то время «кожаные мешки» на этой работе ещё будут востребованы. Но, учитывая нынешние темпы развития робототехники и бум искусственного интеллекта, почтовым служащим пора подумать о смене профессии. Гейб Ньюэлл готовится залезть к нам в головы — он скоро выпустит мозговой имплантат

24.05.2025 [11:13],

Геннадий Детинич

Секретный стартап Гейба Ньюэлла (Gabe Newell) — Starfish Neuroscience — вышел из тени и объявил о планах. Молодая компания разработала собственный мозговой имплантат и представит его в конце 2025 года. Устройство обещает оказаться проще в установке и эксплуатации, чем имплантат конкурирующей с ней компании Neuralink Илона Маска (Elon Musk).

Ни один Гейб Ньюэлл не пострадал, фото — постановочное. Источник изображения: Valve Борьба за мозги граждан разгорается в буквальном смысле этого слова. Это не мифическое чипирование Билла Гейтса (Bill Gates). Это всерьёз. На стареющую человеческую цивилизацию надвинулась тень болезней Альцгеймера и Паркинсона. Стимуляция мозга с помощью имплантатов обещает помочь с их лечением, как и потенциально способна решить множество проблем с болезнями мозга. Наконец, интерфейс мозг-компьютер — это следующий уровень компьютеризации со всеми вытекающими преимуществами. Основатель и директор Valve и платформы Steam Гейб Ньюэлл около десяти лет вынашивает идею мозговых имплантатов. Проповедуемый его стартапом Starfish Neuroscience подход отличается от реализации Neuralink. В частности, инженеры Starfish нацелены работать одновременно с несколькими участками мозга, а не с одним, как это делает Neuralink. Последние медицинские работы в сфере изучения нейродеградации мозга тоже указывают на то, что проблему нельзя устранить или смягчить, воздействуя только на один локальный участок нервной ткани, где установлен имплантат. Более того, если воздействие на мозг рассредоточить, это открывает путь к более компактным имплантатам с ощутимо меньшим потреблением энергии, а это решает задачу поддержки питания датчиков в голове. Более десяти лет назад штатные психологи Valve изучали биологическую реакцию людей на видеоигры. Работа вылилась в разработку датчиков для мочек ушей — своеобразное дополнение к гарнитуре виртуальной реальности, создаваемой тогда в компании. Позже, в 2019 году, компания впервые на конференции GDC озвучила идею интерфейса мозг-компьютер для игр. Тогда же была организована компания Starfish Neuroscience, чтобы начать воплощать мечту в реальность. Первый чип для заявленных целей пока не станет полноценным мозговым имплантатом. Это будет специальный «электрофизиологический» чип, предназначенный для записи активности мозга. Эту активность можно расшифровывать и соотносить с теми или иными пожеланиями носителя. Похожим образом это делает чип Neuralink. По словам Starfish, у компании уже есть возможность питать такой чип и устанавливать его или элементы платформы в голову человека. «Мы ожидаем, что наши первые чипы появятся в конце 2025 года, и мы заинтересованы в поиске партнёров, для которых такой чип откроет новые и захватывающие возможности», — пишет нейроинженер Starfish Нейт Сермак (Nate Cermak). Цель компании состоит в том, чтобы создать имплантат меньшего размера и с меньшей инвазивностью, чем у конкурентов. Этот имплантат должен «обеспечивать одновременный доступ к нескольким областям мозга» вместо одной. При этом он не должен требовать питания. Разработчик утверждает, что при «обычной записи» имплантат потребляет всего 1,1 мВт и может работать с беспроводной передачей энергии.

Цифровая обработка данных на борту и обнаружение скачков напряжения позволяют устройству работать через беспроводные интерфейсы с низкой пропускной способностью. Чип изготовлен компанией TSMC по 55-нм техпроцессу. Для сравнения, у Neuralink N1 1024 электрода на 64 имплантированных в мозг нитях потребляют (по данным 2019 года) около 6 мВт. Чип Neuralink содержит аккумулятор, а размеры имплантата составляют 23 × 23 × 8 мм. Чип Neuralink уже установлен трём пациентам и показал нестабильность положения датчиков — тонкие нити имеют тенденцию к смещению в процессе движений человека. Добавим, компания Starfish также работает над «термальными пушками» для уничтожения опухолей внутри тела человека с помощью точного локального повышения температуры. Кроме того, она разрабатывает методы транскраниальной магнитной стимуляции (TMS) с роботизированным управлением для лечения неврологических заболеваний, таких как биполярное расстройство и депрессия. MSI показала на Computex 2025 игровой десктоп MEG Vision X AI 2nd с человеко-машинным интерфейсом

19.05.2025 [14:52],

Владимир Мироненко

Компания MSI показала на выставке Computex 2025, проходящей сейчас на Тайване, игровой настольный компьютер MEG Vision X AI 2nd с новым человеко-машинным интерфейсом (HMI) от MSI с ИИ. Фронтальная панель десктопа представляет собой сенсорный экран, позволяющий взаимодействовать с разными ИИ-моделями. MEG Vision X AI 2nd получил 13-дюймовый сенсорный экран с разрешением Full HD, который выступает в качестве динамического центра управления с интерфейсом HMI и функциями фирменного приложения MSI Robot AI. На дисплей выводятся данные мониторинга работы компьютерных комплектующих, а с помощью ИИ, который поддерживает голосовое управление с помощью встроенного микрофона и динамика, можно управлять настройками компьютера и монитора, регулировать производительность и управлять периферийными устройствами, например, громкостью звука в наушниках или яркостью подсветки. С помощью ИИ-приложения MSI можно не только управлять голосом настройками компьютера, но и записывать деловые переговоры, заказывать билеты и т.д. Система способна сама выполнять поиск в интернете, предлагая пользователю готовые ответы, или подборки товаров по запросам. Базовая конфигурация MEG Vision X AI 2nd включает процессор Intel Core Ultra 9 285K, видеокарты Nvidia GeForce RTX 50-q серии (включая RTX 5080 и 5090), поддержку до 192 Гбайт оперативной памяти DDR5‑6000 и NVMe SSD PCIe 5.0 с ёмкостью от 2 Тбайт. Для ускорения выполнения ИИ-задач и интеллектуальной оптимизации настройки системы на основе пользовательских предпочтений используется нейронный сопроцессор (NPU) в процессорах Intel Core Ultra. Система обеспечивает производительность более 3400 TOPS. Отмечается и передовая система охлаждения Silent Storm Cooling AI от MSI, которая формирует многокамерную конструкцию воздушного потока, с помощью ИИ-алгоритмов, непрерывно регулируя скорость вращения вентиляторов, обеспечивает оптимальную температуру на всех компонентах компьютера. В дополнение радиаторы Glacier Armor обеспечивают значительное улучшение тепловых характеристик компонентов даже в ходе игровых марафонов на максимальных нагрузках. При этом система отличается тихой работой — в режиме Silent Mode уровень шума составляет 17,7 дБ.  MEG Vision X AI 2nd работает под управлением и Windows 11 Home или Pro. Коммуникационные возможности десктопа включают 4 порта USB Type-A, 2 порта USB Type C, интерфейс Thunderbolt 4. Также сообщается о поддержке стандарта DP 2.1a и сетевых подключений Killer 5 GbE и Wi‑Fi 7. Стоимость новинки не уточняется, но определённо она будет не из дешёвых. |