|

Опрос

|

реклама

Быстрый переход

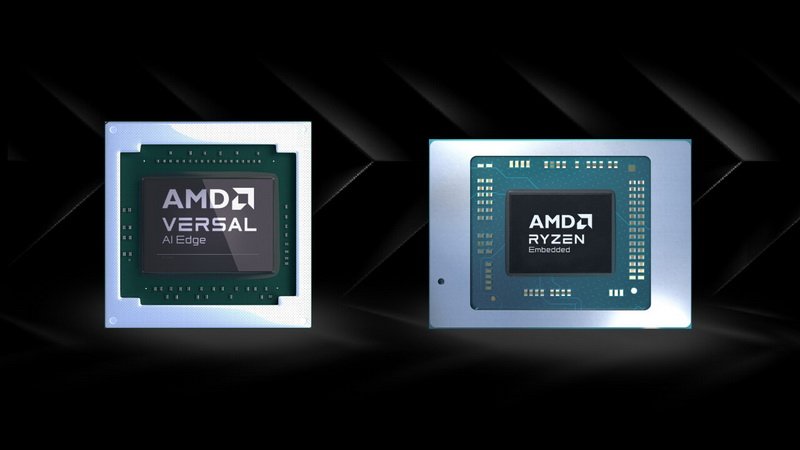

AMD представила чипы XA Versal AI Edge и Ryzen Embedded V2000A для расширения ИИ-функций автомобилей

05.01.2024 [21:40],

Николай Хижняк

Компания AMD представила продукты, предназначенные для расширения ИИ-возможностей автомобилей. Первым является серия однокристальных платформ XA Versal AI Edge, который оснащены ИИ-движками и массивом векторных процессоров. Их основное предназначение — повышение безопасности и эффективности работы датчиков LiDAR, радаров, камер и прочих сенсоров на базе ИИ. Также была представлена серия процессоров Ryzen Embedded V2000A для расширения возможностей мультимедийных систем авто.

Источник изображений: AMD Примечательная особенность серии SoC AMD XA Versal AI Edge и процессоров Ryzen Embedded V2000A заключается в том, что это первые 7-нм чипы, сертифицированные для использования в автомобильной отрасли. В целом же XA Versal AI Edge и Ryzen Embedded V2000A призваны улучшить водительский и пассажирский опыт использования различных систем автомобиля, позволяя реализовать в них поддержку различных ИИ-функций. XA Versal AI Edge — это адаптивная платформа, отвечающая за поддержку искусственного интеллекта и предназначенная для управления различными датчиками авто. XA Versal AI Edge отвечает за повышение точности и отзывчивости автомобильных датчиков LiDAR, радаров и камер, что является критически важным для принятия быстрых и точных решений ИИ-системами. Одним из преимуществ платформы XA Versal AI Edge является её масштабируемость. Например, в составе флагманского SoC XAVE2602 используются 152 ИИ-движка с 820 тыс. логическими ячейками, а также 984 цифровых сигнальных процессоров (DSP). AMD заявляет для этого чипа производительность до 89 TOPS (триллионов операций в секунду) в вычислениях INT8. Компания также сможет предложить платформы XA Versal AI Edge с показателями производительности от 5 до 171 TOPS, предназначенные для разных сегментов и задач. Основой XA Versal AI Edge служит APU в парой ядер Arm Cortex-A72, а также двуядерный модуль Arm Cortex-R5F RPT. Показатель энергопотребления чипов XA Versal AI Edge варьируется от 6–9 Вт (платформа XAVE2002) до внушительных 75 Вт (платформа XAVE2802). Серия процессоров Ryzen Embedded V2000A предназначена для расширения ИИ-возможностей мультимедийных систем авто как для водителя, так и для пассажиров. Эти процессоры могут использоваться для управления цифровым салоном автомобилей — от информационно-развлекательной консоли до пассажирских дисплеев. В составе этих процессоров, производящихся с применением 7-нм техпроцесса, используются ядра на архитектуре Zen 2. Новые чипы пришли на смену четырёхъядерному и восьмипоточному APU Ryzen Embedded V1000 на архитектуре Zen первого поколения. Ryzen Embedded V2000A предлагают до шести ядер Zen 2 с поддержкой до 12 виртуальных потоков и оснащены встроенной графикой Radeon Vega 7 с семью исполнительными блоками. Согласно AMD, новые процессоры до 88 % производительнее предшественников. Чипы Ryzen Embedded V2000A поддерживают подключение до четырёх 4K-дисплеев, работу двух гигабитных сетевых интерфейсов и сертифицированы по стандартам AEC-Q100 со строгими требованиями к качеству и надёжности. Компания обещает 10-летнюю поддержку этих процессоров. Ряд партнёров AMD, включая Tesla, Ecarx, Luxoft, BlackBerry/QNX, Xylon, Cognata и других, уже заинтересовались новыми платформами XA Versal AI Edge и Ryzen Embedded V2000A. По словам AMD, первый SoC XAVE1752 в рамках серии XA Versal AI Edge станет доступен в начале 2024 года. Остальные чипы серии будут выпущены до конца этого года. Компания также отмечает, что подготовила для потенциальных клиентов тестовый комплект AXVEK 280 для оценки возможностей новых SoC. Intel наняла выходца из HPE, чтобы он помог ей конкурировать с NVIDIA в сфере ИИ-ускорителей

04.01.2024 [22:58],

Николай Хижняк

Компания Intel назначила исполнительного директора Hewlett Packard Enterprise Джастина Хотарда (Justin Hotard) главой своей группы, занимающейся разработкой технологий для центров обработки данных и искусственного интеллекта. Тем самым она привлекла для управления одним из своих ключевых подразделений стороннего специалиста.

Джастин Хотард. Источник изображения: Intel В Hewlett Packard Enterprise Хотард отвечал за высокопроизводительные вычисления, искусственный интеллект и управление лабораториями HPE. В Intel он будет курировать разработку и поддержку некоторых наиболее важных продуктов компании, включая серверные процессоры Xeon, которые ранее доминировали в сегменте ЦОД, но уступили значительную долю рынка конкурирующим предложениям. До HPE Хотард также возглавлял компании NCR и Motorola Inc. В Intel он возглавит направление ИИ, специализированных графических процессоров и ускорителей и постарается вывести компанию на достойный уровень конкуренции с NVIDIA, которая в настоящий момент безоговорочно доминирует в этом направлении. Восстановление своего лидирующего положения на рынке продуктов для центров обработки данных имеет решающее значение для планов генерального директора Пэта Гелсингера (Pat Gelsinger) по восстановлению превосходства Intel в индустрии производства микросхем. Хотя чипы для ЦОД составляют относительно небольшую часть отрасли, сами по себе специализированные процессоры и ускорители на их основе могут продаваться за десятки тысяч долларов каждый, что делает их чрезвычайно прибыльными. Хотард, который приступит к своей работе в Intel с 1 февраля, сменит ветерана компании Сандру Риверу (Sandra Rivera). Ривера с понедельника перешла на должность главы подразделения программируемых решений Intel (Programmable Solutions Group, PSG), которое компания выделила в отдельный бизнес и планирует вывести на биржу в течение двух-трёх лет. Intel отдельно объявила, что ещё один топ-менеджер её подразделения ЦОД и ИИ Арун Субраманьян (Arun Subramaniyan) возглавил новую софтверную компанию Articul8, специализирующуюся на внедрении машинного обучения и больших языковых моделей (LLM). Она была создана Intel совместно с инвестиционными компаниями DigitalBridge Group и Mindset Ventures. |