|

Опрос

|

реклама

Быстрый переход

Робоэкскаватор обучили прицельно швырять камни

10.07.2024 [15:44],

Геннадий Детинич

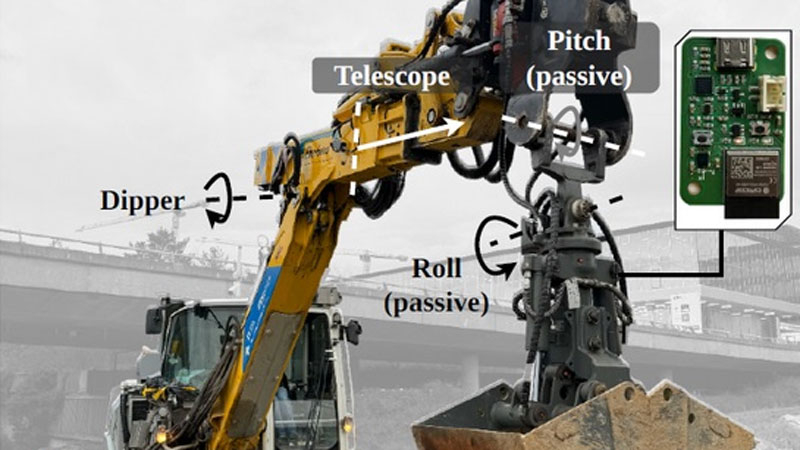

Опытным экскаваторщикам знаком трюк, который позволяет отправлять содержимое ковша за пределы досягаемости стрелы. Наделённый нейросетью робоэкскаватор оказался прилежным учеником, который также смог освоить прицельное метание камней дальше зоны досягаемости стрелы. На очереди швыряние сыпучих материалов и повышение точности для работы ковшом на разных высотах.

Источник изображения: ETH Zürich О процессе обучения нейросети робоэкскаватора для точного манипулирования содержимым ковша сообщили исследователи из Швейцарии (ETH Zürich). Нейросеть на основе обучения с подкреплением была обучена бросать мяч и камни в указанную точку, которая была дальше досягаемости стрелы (до 9,5 м при дальности захвата стрелой 7,5 м). Подобные операции помогут робототехнике справляться с большим кругом задач с меньшими затратами энергии на перемещения, а также сделают её работу более безопасной. Экскаватор совершал захват и броски ковшом с двумя степенями свободы, который не был жёстко закреплён на стреле. Броски совершались как по прямой, когда в работе была одна только стрела, так и с поворотом кабины. Во втором случае точность была чуть меньше, но в любом случае снаряд отклонялся от точки прицеливания не более чем на 30–40 см. Исследователи обучали нейросеть на базе модернизированного 12-т колёсного экскаватора Menzi Muck M545. Ранее они обучили экскаватор ряду нетривиальных операций, например, научив его строить устойчивую стену из неподготовленных каменных блоков. Экскаватор сам оценивал баланс камней и строил прочное каменное ограждение. Для точных автономных работ на местности экскаватор с помощью установленных на него датчиков строит модель окружающего пространства, в котором выполняет заданные операции. Ноутбуки на Intel Lunar Lake и AMD Strix Point на старте продаж не получат ИИ-функции Copilot Plus

07.06.2024 [22:20],

Николай Хижняк

Новые ИИ-функции Windows, включая технологию масштабирования Auto SR, не являются эксклюзивными для ПК на базе процессоров Qualcomm Snapdragon X Elite. Чипы Intel Lunar Lake и AMD Strix Point тоже оснащены производительными NPU, необходимыми для их работы. Компьютеры на этих процессорах появятся в продаже осенью и тоже получат маркировку Copilot Plus PC. Однако никто не гарантирует, что они получат поддержку ИИ-функций прямо на старте продаж, в отличие от систем на чипах Qualcomm.

Источник изображения: Microsoft Как пишет портал The Verge, поговоривший с представителями компаний Intel, AMD и Nvidia, системы на базе новых процессоров Core Ultra и Ryzen AI потребуют установку программных обновлений для Windows, которые наделят их поддержкой ИИ-функций Copilot Plus от Microsoft. Однако неизвестно, будут ли эти обновления выпущены до конца текущего года. «Системы на базе Intel Lunar Lake и AMD Strix Point соответствуют требованиям Windows 11 AI PC и нашим требованиям аппаратного обеспечения для Copilot Plus PC. Мы тесно сотрудничаем с Intel и AMD для оснащения их систем функциями Copilot Plus через бесплатные программные обновления, когда те станут доступны», — говорится в заявлении менеджера по маркетингу Microsoft Джеймса Хауэлла (James Howell) для The Verge. «Lunar Lake получат поддержку функций Copilot Plus PC через обновления, когда они станут доступным», — сообщил в ответе изданию PR-менеджер Intel Томас Ханнафорд (Thomas Hannaford). Ранее в разговоре с The Verge представители Nvidia сообщили аналогичную информацию: «Эти Windows 11 AI PC получат бесплатные обновления с функциями Copilot Plus, когда эти обновления будут готовы». Представитель AMD Мэтью Гурвиц (Matthew Hurwitz) в разговоре с журналистами не смог подтвердить, что ноутбуки на базе их процессоров получат функции Copilot Plus PC на старте продаж. «Мы ожидаем, что функции Copilot Plus появятся [в составе ноутбуков на базе наших процессоров] к концу 2024 года», — заявил Гурвиц. В Intel и Microsoft тоже не смогли уточнить, появятся ли ИИ-функции в составе ноутбуков на базе Intel до конца текущего года. Microsoft изменила Recall — функция не будет делать скриншоты без разрешения пользователя

07.06.2024 [22:05],

Николай Хижняк

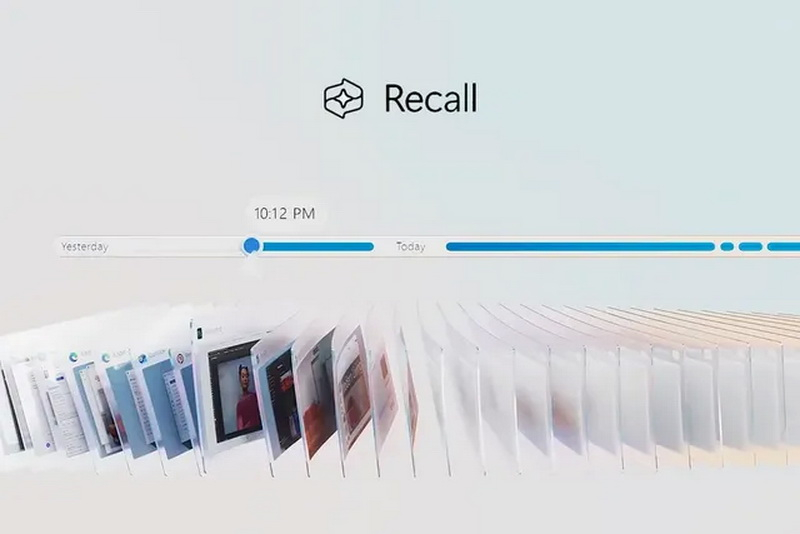

Microsoft внесла изменения в функцию записи действий Recall для Windows 11 после того, как она вызвала жаркие споры на тему конфиденциальности пользователей. Recall постоянно делает скриншоты действий пользователя на ПК, а затем позволяет в любой момент вернуться к той или иной активности. Как пишет The Verge, у Recall можно будет отключить функцию съёмки скриншотов при первоначальной настройке ОС.

Источник изображений: Microsoft Функция Recall станет доступна с поступлением в продажу ноутбуков Copilot Plus PC. Изначально Microsoft планировала активировать Recall на компьютерах по умолчанию, однако сейчас компания говорит, что предоставит пользователям возможность выбора — включить или оставить выключенной спорную ИИ-функцию. Выбор можно будет сделать во время процесса первоначальной настройки нового Copilot Plus PC. «Если не будет выбран иной вариант, то Recall будет отключена по умолчанию», — говорит глава подразделения Windows Паван Давулури (Pavan Davuluri). Перед использованием Recall компания также потребует авторизацию через Windows Hello. Таким образом, пользователю придётся предоставить изображение своего лица, отпечаток пальца или использовать PIN-код перед обращением к Recall. «Кроме того, для просмотра вашей хроники и поиска в Recall потребуется подтверждение присутствия [владельца ПК]», — говорит Давулури, отмечая, что посторонний не сможет использовать поиск в Recall без предварительной аутентификации. Эта аутентификация также будет применяться к защите скриншотов, создаваемых Recall. «Мы добавляем дополнительные уровни защиты данных, включая дешифровку по методу «точно в срок», защищенную системой безопасного входа Windows Hello Enhanced Sign-in Security (ESS). Таким образом, снимки Recall будут расшифрованы и доступны только после аутентификации пользователя», — объясняет Давулури, добавляя, что база данных поисковых индексов также будет зашифрована. Ранее сообщалось, что Recall при поддержке ИИ-алгоритмов будет делать скриншоты того, что происходит на ПК, и сохранять эту информацию локально, то есть на компьютере пользователя. Эта информация не попадёт в облако и не будет использоваться Microsoft для обучения своих ИИ-моделей. Поисковая строка Recall позволит просматривать разные временные отрезки активности в форме созданных скриншотов (открытые страницы веб-браузера, программы и т.д.). При желании пользователь сможет вернуться в ту или иную временную точку активности с помощью всего пары движений мыши.  Microsoft внесла изменения в способы хранения базы данных Recall и доступа к ней после того, как эксперт по кибербезопасности Кевин Бомонт (Kevin Beaumont) обнаружил, что функция хранит информацию в виде обычного текста, что значительно упрощало авторам вредоносных программ создание инструментов для извлечения базы данных и её содержимого. Хотя Recall пока доступна лишь в тестовых сборках Windows, некоторые умельцы уже успели воспользоваться этим недостатком и создали ряд программных инструментов, позволяющих получить доступ к хранящимся в ней данным пользователей. Например, приложение TotalRecall извлекает базу данных Recall и позволяет легко просматривать сохранённый текст и снимки экрана, созданные функцией Microsoft. А сетевой инструмент NetExec, похоже, скоро получит собственный модуль Recall, который сможет получать доступ к папкам Recall на ПК и создавать их дамп для дальнейшего просмотра созданных снимков экрана. Появление подобных инструментов стало возможным только потому, что база данных Recall не наделена системой полного шифрования. Как сообщается, Microsoft разработала Recall в рамках инициативы Secure Future Initiative (SFI), призванной повысить безопасность её программных продуктов после крупных атак на облачный сервис Azure. Портал The Verge пишет, что глава Microsoft Сатья Наделла (Satya Nadella) ставит во главу угла безопасность над всеми остальным при разработке новых программных продуктов, о чём он сообщил во внутреннем письме для сотрудников компании и призвал их последовать его примеру, даже если это будет означать отказ от каких-то новых функций. «Если вы столкнулись с выбором между безопасностью и другим приоритетом, ваш ответ ясен: занимайтесь безопасностью. В некоторых случаях это означает, что безопасность имеет более высокий приоритет над другими задачами, которыми мы занимаемся, такими как разработка новых функций или обеспечение постоянной поддержки устаревших систем», — сообщил Наделла сотрудникам Microsoft. Глава подразделения Windows Паван Давулури в своих комментариях тоже ссылается на новую инициативу SFI по повышению безопасности программных продуктов Microsoft и отмечает, что компания принимает меры по повышению защиты Recall. Однако, похоже, эти вносимые изменения во многом опираются на отзывы сторонних исследователей цифровой безопасности, а не на собственные принципы безопасности Microsoft. В противном случае спорные моменты, связанные с Recall, были бы выявлены ещё на стадии её разработки и компания приняла бы соответствующие меры для их исправления или изменения ещё до запуска этой функции. Microsoft подчеркивает, что Recall будет доступна только на новых ПК Copilot Plus PC. Эти системы разработаны с учётом повышенных требований к программной и аппаратной безопасности и оснащены криптографическим процессором Pluton, разработанным для защиты персональных данных пользователей от кражи. AMD представила мощнейший ИИ-ускоритель MI325X с 288 Гбайт HBM3e и рассказала про MI350X на архитектуре CDNA4

03.06.2024 [12:22],

Николай Хижняк

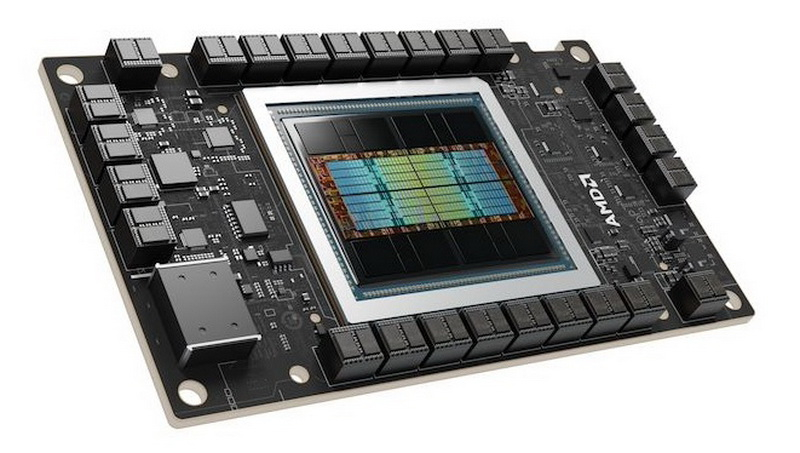

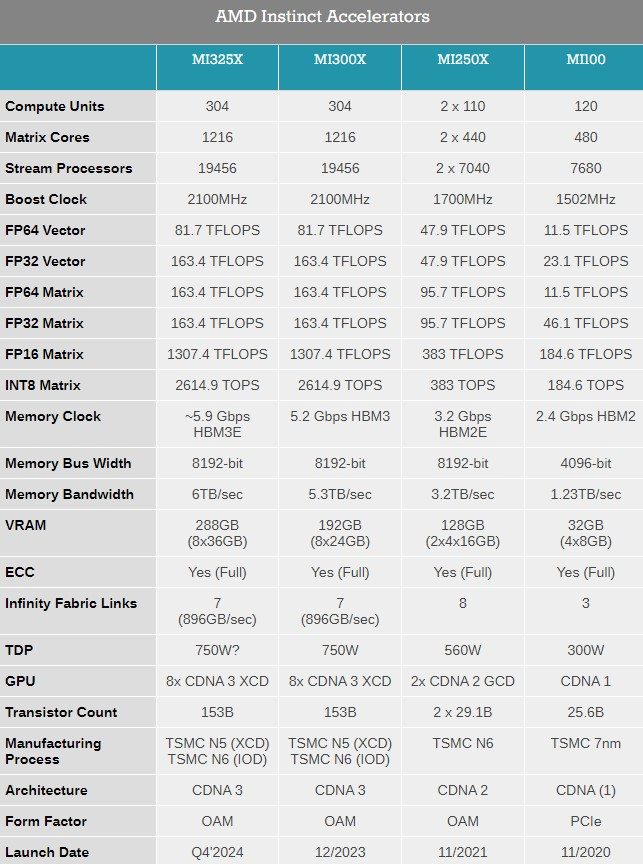

Компания AMD представила на выставке Computex 2024 обновлённые планы по выпуску ускорителей вычислений Instinct, а также анонсировала новый флагманский ИИ-ускоритель Instinct MI325X.

Источник изображений: AMD Ранее компания выпустила ускорители MI300A и MI300X с памятью HBM3, а также несколько их вариаций для определённых регионов. Новый MI325X основан на той же архитектуре CDNA 3 и использует ту же комбинацию из 5- и 6-нм чипов, но тем не менее представляет собой существенное обновление для семейства Instinct. Дело в том, что в данном ускорителе применена более производительная память HBM3e. Instinct MI325X предложит 288 Гбайт памяти, что на 96 Гбайт больше, чем у MI300X. Что ещё важнее, использование новой памяти HBM3e обеспечило повышение пропускной способности до 6,0 Тбайт/с — на 700 Гбайт/с больше, чем у MI300X с HBM3. AMD отмечает, что переход на новую память обеспечит MI325X в 1,3 раза более высокую производительность инференса (работа уже обученной нейросети) и генерации токенов по сравнению с Nvidia H200. Компания AMD также предварительно анонсировала ускоритель Instinct MI350X, который будет построен на чипе с новой архитектурой CDNA 4. Переход на эту архитектуру обещает примерно 35-кратный прирост производительности в работе обученной нейросети по сравнению с актуальной CDNA 3. Для производства ускорителей вычислений MI350X будет использоваться передовой 3-нм техпроцесс. Instinct MI350X тоже получат до 288 Гбайт памяти HBM3e. Для них также заявляется поддержка типов данных FP4/FP6, что принесёт пользу в работе с алгоритмами машинного обучения. Дополнительные детали об Instinct MI350X компания не сообщила, но отметила, что они будут выпускаться в формфакторе Open Accelerator Module (OAM).

Источник изображения: AnandTech ИИ-ускорители Instinct MI325X начнут продаваться в четвёртом квартале этого года. Выход MI350X ожидается в 2025 году. Кроме того, AMD сообщила, что ускорители вычислений серии MI400 на архитектуре CDNA-Next будут представлены в 2026 году. ChatGPT обретёт тело: OpenAI возродила разработку роботов

31.05.2024 [18:44],

Сергей Сурабекянц

Компания OpenAI заморозила разработку собственного робота общего назначения ещё в 2020 году. Теперь гигант искусственного интеллекта собирается поставлять свои технологии машинного обучения другим разработчикам и производителям роботов. По сообщению Forbes, в связи с ростом инвестиций в роботов с ИИ компания OpenAI перезапускает свое ранее закрытое подразделение по робототехнике.

Источник изображения: unsplash.com По данным трёх независимых источников, в настоящее время OpenAI нанимает инженеров-исследователей для восстановления команды, которую она закрыла в 2020 году. Новая команда существует менее двух месяцев и в списке вакансий поясняется, что новые сотрудники станут «одними из первых её членов». За последний год OpenAI инвестировала в несколько компаний, занимающихся разработкой человекоподобных роботов, включая Fig AI (привлечено $745 млн), 1X Technologies (125 $млн) и Physical Intelligence ($70 млн). Первые намёки на возвращение интереса OpenAI к робототехнике появились в февральском пресс-релизе, посвящённом сбору средств для компании Fig. Месяц спустя компания Fig представила робота, демонстрирующего элементарные навыки речи и мышления на основе большой мультимодальной модели, обученной OpenAI.

Источник изображения: pexels.com Источники сообщают, что OpenAI намерена сосуществовать, а не конкурировать с разработчиками роботов, создавая технологии, которые производители роботов будут интегрировать в свои собственные системы. Инженеры компании будут сотрудничать с внешними партнёрами и заниматься обучением моделей ИИ. Даже такая, более узкая направленность команды робототехники OpenAI, может пересекаться с другими компаниями. Например, Covariant, основанная бывшими членами команды OpenAI по робототехнике, занимаются обучением собственных моделей, а количество талантливых специалистов весьма ограничено.

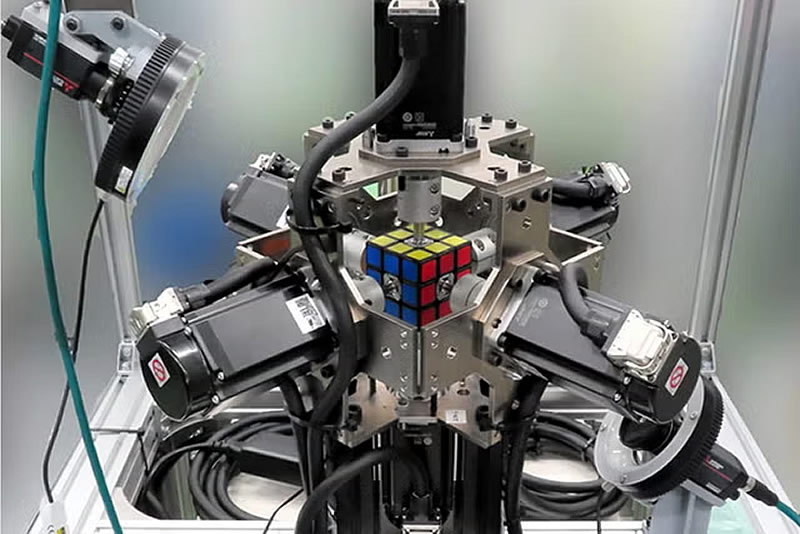

Источник изображения: pexels.com Робототехника была одним из основных направлений OpenAI с первых дней её существования. Команда специалистов под руководством соучредителя OpenAI Войцеха Зарембы (Wojciech Zaremba) стремилась создать «робота общего назначения». В 2019 году исследователи OpenAI обучили нейросеть собирать кубик Рубика с помощью роботизированной руки. Но в октябре 2020 года команда была распущена из-за «нехватки данных для обучения», по словам Зарембы.

Источник изображения: Mitsubishi В конечном итоге OpenAI направила усилия команды по робототехнике на другие проекты. «Благодаря быстрому прогрессу в области искусственного интеллекта и его возможностей мы обнаружили, что другие подходы, такие как обучение с подкреплением и обратной связью с человеком, приводят к более быстрому прогрессу», — говорится в заявлении компании. В конечном итоге, достижения в обучении с подкреплением стимулировали бум ИИ, который произошёл после выпуска компанией ChatGPT. Некоторые из бывших сотрудников OpenAI в области робототехники остаются в компании на других должностях. Например, Заремба помогает руководить разработкой флагманских моделей GPT, Питер Велиндер (Peter Welinder) руководит продуктами и партнёрскими отношениями, Боб МакГрю (Bob McGrew) является вице-президентом по исследованиям, а Лилиан Венг (Lilian Weng) возглавляет отдел систем безопасности и является членом недавно созданного комитета по безопасности OpenAI.

Источник изображения: pexels.com Пока нет точной информации, планирует ли OpenAI разрабатывать своё робототехническое оборудование, что она пыталась сделать несколько лет назад. Растущие амбиции компании в последнее время были отмечены некоторой турбулентностью, в том числе серией увольнений высокопоставленных специалистов. После публикации Forbes от 30 мая, OpenAI официально подтвердила набор специалистов в возрождённую команду по робототехнике. Google представила мощнейший серверный ИИ-процессор Trillium — почти в пять раз быстрее предшественника

14.05.2024 [22:21],

Николай Хижняк

В рамках конференции Google I/O компания Google представила шестое поколение своего фирменного тензорного процессора (Tensor Processing Unit) с кодовым названием Trillium. Он предназначен для центров обработки данных, ориентированных на работу с искусственным интеллектом. По словам компании, новый чип почти в пять раз производительнее предшественника.

Источник изображения: The Verge «Промышленный спрос на компьютеры для машинного обучения вырос в миллион раз за последние шесть лет и каждый год продолжает увеличиться в десять раз. Я думаю, что Google была создана для этого момента. Мы являемся новаторами в разработке чипов для искусственного интеллекта уже более десяти лет», — заявил генеральный директор Alphabet Сундар Пичаи (Sundar Pichai) в разговоре с журналистами. Разрабатываемые Alphabet, материнской компанией Google, специализированные чипы для центров обработки данных, ориентированных на ИИ, представляют собой одну из немногих жизнеспособных альтернатив решениям компании Nvidia. Вместе с программным обеспечением, оптимизированным для работы с тензорными процессорами Google (TPU), эти решения позволили компании занять значительную долю на рынке. По данным издания Reuters, Nvidia по-прежнему доминирует на рынке чипов для ИИ-дата-центров с долей 80 %. Значительная часть от оставшихся 20 % приходятся на различные версии TPU от Google. В отличие от Nvidia, компания Google не продаёт свои процессоры, а использует их сами и сдаёт в аренду облачные вычислительные платформы, которые на них работают. Для шестого поколения TPU под названием Trillium компания заявляет прибавку вычислительной производительности в 4,7 раза по сравнению с TPU v5e в задачах, связанных с генерацией теста и медиаконтента с помощью больших языковых моделей ИИ (LLM). При этом Trillium на 67 % энергоэффективнее, чем TPU v5e, отмечают в компании. Как пишет портал TechCrunch, значительного увеличения производительности у Trillium компания смогла добиться благодаря увеличения количества используемых матричных умножителей (MXU), а также повышения тактовой частоты чипа. Кроме того, компания удвоила для Trillium пропускную способность памяти. Более конкретных технических деталей Trillium не приводится. Вычислительные мощности нового процессора станут доступны для клиентов облачных сервисов Google к «концу 2024 года», отмечают в компании. Однако от решений Nvidia компания Google не отказывается. В рамках конференции Google I/O также было заявлено, Google станет одним из первых облачных провайдеров, который с начала будущего года будет предлагать облачные услуги на базе специализированных ИИ-ускорителей нового поколения Nvidia Blackwell. ИИ переплюнет по энергопотреблению Индию уже к 2030 году, спрогнозировал глава Arm

17.04.2024 [21:42],

Николай Хижняк

Технологиям искусственного интеллекта требуются огромные объёмы электроэнергии. По мнению главы компании Arm Рене Хааса (Rene Haas), это может привести к тому, что уже к концу текущего десятилетия общие объёмы потребляемой системами ИИ энергии превзойдут объёмы энергопотребления Индии, самой густонаселённой страны в мире. Источник изображения: Gerd Altmann / pixabay.com По словам Хасса, поиск способов предотвратить прогнозируемое утроение энергопотребления к 2030 году имеет первостепенное значение, если человечество хочет достигнуть целей, которые возлагаются на ИИ. «Мы по-прежнему находимся на раннем этапе развития возможностей [искусственного интеллекта]. Чтобы эти системы стали лучше, им потребуется дополнительное обучение — этап, который включает в себя бомбардировку программного обеспечения огромными наборами данных. Этот процесс рано или поздно столкнётся с пределом наших энергетических мощностей», — рассказал Хаас в интервью Bloomberg. Хаас формально ставит себя в один ряд с растущим числом людей, выражающих обеспокоенность по поводу возможного ущерба, который ИИ может нанести мировой энергетической инфраструктуре. Но он также заинтересован в том, чтобы отрасль перешла на использование чипов с Arm-архитектурами, которые всё больше завоёвывают популярность в центрах обработки данных. Технологии компании, которые к настоящему моменту получили широкое распространение в смартфонах, разработаны с целью более эффективного использования энергии по сравнению с традиционными серверными чипами. Arm рассматривает ИИ в качестве одного из основных драйверов своего роста. Технологии компании уже используются в процессорах, являющихся основой серверных систем AWS, Microsoft и Alphabet, разработавших собственные чипы для снижения своей зависимости от Intel и AMD. По словам Хааса, используя больше чипов, изготовленных по индивидуальному заказу, компании могут сократить ограничивающие факторы и повысить энергоэффективность их систем. Такая стратегия может снизить энергопотребление центров обработки данных более чем на 15 %. Однако отрасль нуждается в более масштабных технологических прорывах. Сроки поставок ИИ-ускорителей Nvidia H100 сократились до 2–3 месяцев

10.04.2024 [20:59],

Николай Хижняк

Cроки поставок ИИ-ускорителей Nvidia H100 сократились с 3–4 до 2–3 месяцев (8–12 недель), сообщает DigiTimes со ссылкой на заявление директора тайваньского офиса компании Dell Теренса Ляо (Terence Liao). ODM-поставщики серверного оборудования отмечают, что дефицит специализированных ускорителей начал снижаться по сравнению с 2023 годом, когда приобрести Nvidia H100 было практически невозможно.

Источник изображения: Nvidia По словам Ляо, несмотря на сокращение сроков выполнения заказов на поставки ИИ-ускорителей, спрос на это оборудование на рынке по-прежнему чрезвычайно высок. И несмотря на высокую стоимость, объёмы закупок ИИ-серверов значительно выше закупок серверного оборудования общего назначения. Окно поставок в 2–3 месяца — это самый короткий срок поставки ускорителей Nvidia H100 за всё время. Всего шесть месяцев назад он составлял 11 месяцев. Иными словами, клиентам Nvidia приходилось почти год ждать выполнение своего заказа. С начала 2024 года сроки поставок значительно сократились. Сначала они упали до 3–4 месяцев, а теперь до 2–3 месяцев. При таком темпе дефицит ИИ-ускорителей может быть устранён к концу текущего года или даже раньше. Частично такая динамика может быть связана с самими покупателями ИИ-ускорителей. Как сообщается, некоторые компании, имеющие лишние и нигде не использующиеся H100, перепродают их для компенсации огромных затрат на их приобретение. Также нынешняя ситуация может являться следствием того, что провайдер облачных вычислительных мощностей AWS упростил аренду ИИ-ускорителей Nvidia H100 через облако, что в свою очередь тоже частично помогает снизить на них спрос. Единственными клиентами Nvidia, которым по-прежнему приходится сталкиваться с проблемами в поставках ИИ-оборудования, являются крупные ИИ-компании вроде OpenAI, которые используют десятки тысяч подобных ускорителей для быстрого и эффективного обучения своих больших языковых ИИ-моделей. Языковые модели ИИ сразились друг с другом в импровизированном турнире по Street Fighter III

05.04.2024 [18:24],

Николай Хижняк

На хакатоне Mistral AI, прошедшем в Сан-Франциско на минувшей неделе, разработчики Стэн Жирар (Stan Girard) и Quivr Brain представили тест LLM Colosseum с открытым исходным кодом, основанный на классическом аркадном файтинге Street Fighter III. Тест предназначен для определения самой эффективной языковой модели ИИ в не совсем традиционной, но зрелищной манере.

Источник изображений: YouTube / Matthew Berman ИИ-энтузиаст Мэтью Берман (Matthew Berman) решил провести с помощь теста LLM Colosseum своеобразный турнир между языковыми моделями, о чём он поделился в своём видео. В нём же Берман показал один из поединков между ИИ. Кроме того, он рассказал, как можно установить этот проект с исходным кодом на домашний ПК или Mac и оценить его самостоятельно. Это не совсем типичный тест LLM. Как правило, маленькие языковые модели имеют преимущество в задержке и скорости, что приводит к победе в большинстве виртуальных боёв. В файтингах очень важна скорость реакции игроков на ответные действия своих оппонентов. То же правило работает и в случае противостояния ИИ против ИИ.

Источник изображений: OpenGenerativeAI team Языковая модель в реальном времени принимает решение, как ей сражаться. Поскольку LLM представляют собой текстовые модели, их обучили в игре Street Fighter III с помощью текстовых подсказок. ИИ сначала дали проанализировать контекст игры в целом, а затем подсказали, как реагировать на то или иное игровое действие в той или иной ситуации, не забыв про вариативность ходов. ИИ обучили приближаться или отдаляться от противника, а также использовать различные приёмы вроде огненного шара, мегаудара, урагана и мегаогненного шара. Продемонстрированный на видео бой между ИИ выглядит динамично. Оппоненты действуют стратегически, блокируют удары противника и используют специальные приёмы. Однако к настоящему моменту проект LLM Colosseum позволяет использовать только одного игрового персонажа, Кена. Согласно тестам Жирара, лучшей языковой моделью в турнире Street Fighter III оказалась GPT 3.5 Turbo от OpenAI. Среди восьми участников она достигла самого высокого рейтинга ELO — 1776. В отдельной серии тестов, организованных Банджо Обайоми (Banjo Obayomi), специалистом по продвижению продуктов AWS компании Amazon, спарринги проводились между четырнадцатью языковыми моделями в рамках 314 индивидуальных матчей. Здесь в конечном итоге победила языковая модель claude_3_haiku от Anthropic с рейтингом ELO 1613. Microsoft и Intel сформулировали определение «ПК с искусственным интеллектом»

27.03.2024 [17:24],

Николай Хижняк

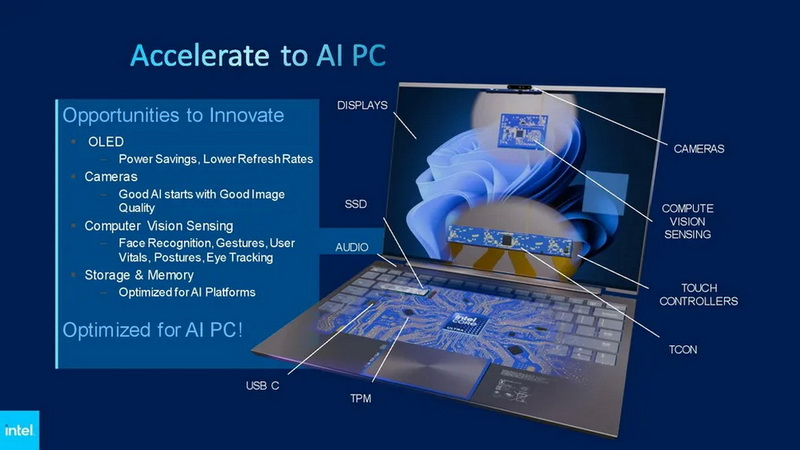

Intel и Microsoft представили на проходящей конференции в Тайбэе своё универсальное определение «ПК с искусственным интеллектом». В понимании обоих производителей, далеко не все актуальные модели ПК и ноутбуков, представленных сегодня на рынке, ему соответствуют, даже несмотря на то, что они оснащены новейшими процессорами с ИИ-ускорителями и ИИ-помощником Copilot на базе большой языковой модели, который входит в состав операционной системы Windows 11.

Источник изображений: Intel В октябре прошлого года компания Intel запустила программу AI PC Acceleration Program, призванную побудить независимых разработчиков программного обеспечения, а также производителей аппаратных средств присоединиться к расширению экосистемы ПК, оснащённых технологиями искусственного интеллекта. На конференции в Тайбэе производитель процессоров сообщил, что будет более активно помогать разработчикам ПО и аппаратных средств в рамках этого процесса. Intel представила специальные комплекты разработчиков на базе NUC с новейшими процессорами Core Ultra (Meteor Lake) для разработки программных решений с поддержкой ИИ, а также поделилась чётким определением «ПК с искусственным интеллектом», каким его представляет компания Microsoft. Стремительное развитие технологий искусственного интеллекта и машинного обучения в течение последних лет открыло огромные возможности для внедрения новых аппаратных и программных функций в проверенную временем платформу ПК. Однако само по себе определение «ПК с искусственным интеллектом» или ИИ ПК по-прежнему оставалось расплывчатым. Ведущие мировые производители процессоров, включая Intel, AMD, Apple уже разработали и выпустили свои аппаратные решения, оснащённые специальными блоками ускорения работы ИИ-алгоритмов (NPU), которые располагаются на кристаллах чипов рядом с обычными ядрами CPU и GPU. На рынке скоро также должны появиться ноутбуки на базе процессоров Qualcomm, тоже оснащённых такими ИИ-ускорителями. Однако у каждой компании имеется свой взгляд на то, что представляет собой компьютер с искусственным интеллектом. Ранее Intel уже заявляла, что к концу 2025 году планирует оснастить 100 млн ПК по всему миру своими процессорами с NPU. Для достижения этих целей производитель заручился поддержкой более сотни независимых поставщиков программного обеспечения и уже к концу 2024 года планирует вывести на рынок более 300 различных приложений с поддержкой искусственного интеллекта. Согласно прогнозам аналитического агентства Canalys, конкуренция на рынке ПК с технологиями ИИ в ближайшие годы будет усиливаться. И если к концу 2024 года доля поставок ПК с поддержкой искусственного интеллекта составит 19 % от общемировых объёмов поставок компьютеров, то 2027 эта доля вырастет уже до 60 %. В новом совместно разработанном Microsoft и Intel определении говорится, что компьютер с искусственным интеллектом будет поставляться с нейронным сопроцессором (NPU), центральным и графическим процессорами, поддерживающими ИИ-помощника Microsoft Copilot, а также будет иметь физическую клавишу вызова ИИ-помощника Copilot непосредственно на клавиатуре, которая заменит правую клавишу Windows. Copilot — это чат-бот с искусственным интеллектом, созданный на основе LLM (большой языковой модели) и в данный момент активно внедряющийся компанией Microsoft в её операционную систему Windows 11. В настоящее время он работает через облачные сервисы, но, как сообщается, компания планирует реализовать локальную обработку Copilot непосредственно на ПК для повышения его производительности и оперативности. Озвученное Intel и Microsoft определение «ПК с искусственным интеллектом» означает, что большинство уже выпущенных ноутбуков на процессорах Intel Meteor Lake и AMD Ryzen AI последних поколений, поставляющихся без выделенной клавиши вызова Copilot, на самом деле не соответствуют официальным критериям Microsoft. В то же время можно ожидать, что все ключевые производители ПК и ноутбуков рано или поздно скорректируют характеристики своих решений для соответствия этим требованиям. Хотя Intel и Microsoft сейчас занимаются совместным продвижением нового определения ИИ ПК, у самой Intel есть более простое определение для таких систем. В нём описывается ПК с CPU, GPU и NPU, в котором каждый из этих компонентов имеет свои собственные возможности ускорения выполнения задач, специфичных для искусственного интеллекта. Intel предлагает распределять рабочие нагрузки ИИ между указанными компонентами в зависимости от типа необходимых вычислений. При этом на NPU компания предлагает возлагать нагрузки ИИ с низкой интенсивностью, с которыми он сможет справляться с высокой степенью энергоэффективности. Сюда можно отнести, например, обработку фотографий, а также аудио и видео. NPU сможет ускорить выполнение этих задач непосредственно на компьютере, а не полагаясь на специальные облачные сервисы. В Intel отмечают, что таким образом получится одновременно увеличить время автономности систем с NPU, повысить их производительность, а также реализовать высокий уровень конфиденциальности данных за счёт хранения всей информации на локальном компьютере, а не в Сети. Использование NPU в низкоинтенсивных нагрузках также освободит ресурсы центрального и графического процессоров, которые можно будет использовать для других задач. Возможности CPU и GPU предлагается использовать при более интенсивных ИИ-нагрузках, где мощностей NPU может оказаться недостаточно. При необходимости ресурсы NPU и GPU также можно будет использовать одновременно, например, для запуска ресурсоёмких языковых моделей. Разные модели искусственного интеллекта имеют разные требования к объёму используемой памяти и скорости компонентов, которые необходимы для их работы. Одни могут создавать более сложные и точные языковые модели, другие обеспечивают более высокую скорость выполнения поставленных задач. Intel говорит, что вопрос доступного объёма памяти у ПК станет ключевым для запуска LLM. Некоторые модели требуют 16 Гбайт ОЗУ, другим требуется вдвое больше. В перспективе это может привести к значительному увеличению стоимости потребительских компьютеров с ИИ, особенно в сегменте ноутбуков, однако Microsoft пока не определила минимальные требования к доступной памяти. Очевидно, что компания продолжит сотрудничество с производителями ПК и ноутбуков, чтобы найти нужный компромисс. Для каждого сегмента потребительских устройств, вероятно, будут выставлены свои требования. Но вполне можно ожидать, что даже в системах начального уровня с искусственным интеллектом появится больше памяти, а ПК с 8 Гбайт ОЗУ будут встречаться крайне редко или вообще исчезнут. Что касается специальных комплектов разработчиков программного обеспечения с поддержкой ИИ, то для них Intel представила системы ASUS NUC Pro 14, оснащённые процессорами Core Ultra (Meteor Lake). Это компактные неттопы, оснащённые несколькими портами USB 3.2, а также интерфейсами Thunderbolt, предлагающие до 96 Гбайт ОЗУ. Более подробные характеристики указанных систем компания не сообщает, однако отмечает, что они также предлагают набор предустановленного специального программного обеспечения, инструментов, компиляторов и драйверов, необходимых для разработки программ с поддержкой ИИ. Установленные инструменты включают, среди прочего, Cmake, Python и OpenVino. Платформа Intel также поддерживает ONNX, DirectML и WebNN и другие средства для разработки и оптимизации программного обеспечения. Intel отмечает, что на её оборудовании с использованием OpenVino уже разработано более 280 различных открытых и оптимизированных ИИ-моделей, на базе ONNX — 173 моделей, а на базе Hugging Face — 150. При этом самые популярные модели скачиваются более 300 тыс. раз в месяц. Компания уже сотрудничает с десятками крупных поставщиков программного обеспечения по вопросу интеграции ИИ в их продукты. В их числе Zoom, Adobe, Autodesk и многие другие. Однако Intel хочет расширить экосистему разработчиков, добавив к ней небольшие независимые команды и даже разработчиков-одиночек. Именно для них компания подготовила специальные комплекты разработчиков. Первые устройства для разработки программного обеспечения с ИИ-функциями будут выдаваться на текущей конференции в Тайбэе. В перспективе Intel также хочет предоставить указанные комплекты разработчиков тем, кто в силу разных причин не может участвовать в подобных мероприятиях. Однако эта часть программы AI PC Acceleration Program пока не началась из-за различных ограничений в разных странах и других логистических проблем. Intel планирует предлагать комплекты разработчиков по льготной цене, однако конкретных деталей по этому поводу производитель не предоставил. В перспективе компания также планирует предоставлять разработчикам доступ к аналогичным аппаратным средствам на базе своих будущих платформ. Также компания планирует укрепить сотрудничество с различными университетами, представляя их факультетам информатики указанные комплекты разработчика. Для поддержки сообщества разработчиков на сайте Intel также имеется специальный центр знаний, в котором содержатся видеоуроки, инструкции, различная документация, дополнительные материалы и даже образцы кода. Для независимых поставщиков аппаратного обеспечения в рамках программы Open Labs компания Intel предлагает круглосуточный доступ к своим ресурсам для тестирования и оптимизации аппаратных средств, а также ранним образцам её оборудования в лабораториях в США, Китае и Тайване. Компания заявляет, что в рамках программы Open Labs более ста различных команд разработчиков уже представили около 200 различных аппаратных компонентов. ChatGPT обрёл тело — OpenAI и Figure сделали умного робота-гуманоида, который полноценно общается с людьми

13.03.2024 [22:40],

Николай Хижняк

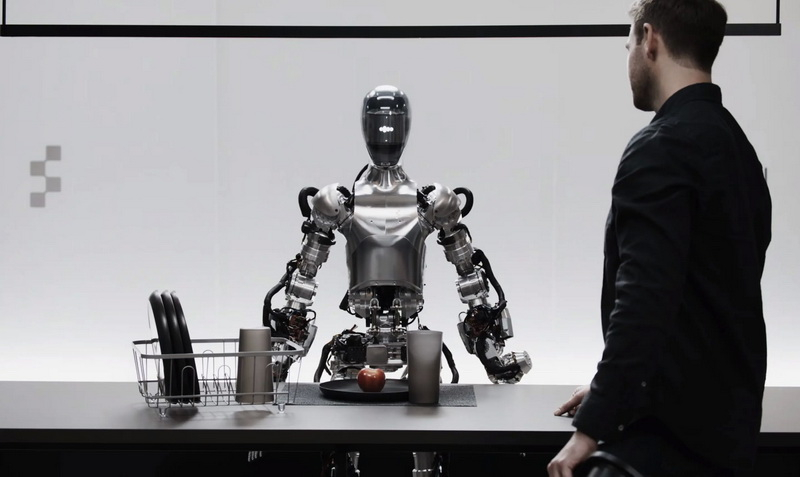

Американский стартап Figure показал первые плоды сотрудничества с компанией OpenAI по расширению возможностей гуманоидных роботов. Figure опубликовала новое видео со своим роботом Figure 01, ведущим диалог с человеком в режиме реального времени. Машина на видео отвечает на вопросы и выполняет его команды.

Источник изображения: Figure Стремительный темп развития проекта Figure 01 и компании Figure в целом не может не впечатлять. Бизнесмен и основатель стартапа Бретт Эдкок (Brett Adcock) «вышел из тени» год назад, после того как компания привлекла внимание крупных игроков на рынке робототехники и технологий искусственного интеллекта, включая Boston Dynamics, Tesla Google DeepMind, Archer Aviation и других, и поставила цель «создать первого в мире коммерчески доступного гуманоидного робота общего назначения». К октябрю того же года Figure 01 «встал на ноги» и продемонстрировал свои возможности в выполнении базовых автономных задач. К концу всё того же 2023 года робот обрёл возможность обучаться выполнению различных задач. К середине января Figure подписала первый коммерческий контракт на использование Figure 01 на автомобильном заводе компании BMW в североамериканском штата Северная Каролина. В прошлом месяце Figure опубликовала видео, на котором Figure 01 выполняет работу на складе. Практически сразу после этого компания анонсировала разработку второго поколения машины и объявила о сотрудничестве с OpenAI «по разработке нового поколения ИИ-моделей для гуманоидных роботов». Сегодня Figure поделилась видео, в котором демонстрируются первые результаты этого сотрудничества. Через свою страницу в X (бывший Twitter) Адкок сообщил, что встроенные в Figure 01 камеры отправляют данные в большую визуально-языковую модель ИИ, обученную OpenAI, в то время как собственные нейросети Figure «также через камеры робота захватывает изображение окружения с частотой 10 Гц». Алгоритмы OpenAI также отвечают за возможность робота понимать человеческую речь, а нейросеть Figure преобразует поток полученной информации в «быстрые, низкоуровневые и ловкие действия робота». Глава Figure утверждает, что во время демонстрации робот не управлялся дистанционно и видео показано с реальной скоростью. «Наша цель — научить мировую модель ИИ управлять роботами-гуманоидами на уровне миллиардов единиц», — добавил руководитель стартапа. При таком темпе развития проекта ждать осталось не так уж и долго. Cerebras представила гигантский процессор WSE-3 c 900 тысячами ядер

13.03.2024 [19:58],

Николай Хижняк

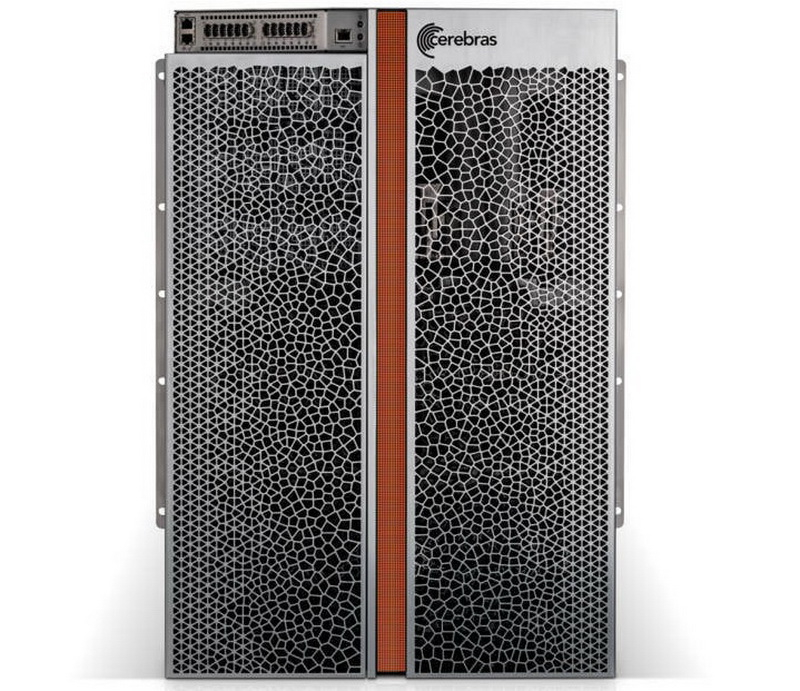

Американский стартап Cerebras Systems представил гигантский процессор WSE-3 для машинного обучения и других ресурсоёмких задач, для которого заявляется двукратный прирост производительности на ватт потребляемой энергии по сравнению с предшественником.

Cerebras WSE-3. Источник изображений: Cerebras Площадь нового процессора составляет 46 225 мм2. Он выпускается с использованием 5-нм техпроцесса компании TSMC, содержит 4 трлн транзисторов, 900 000 ядер и объединён с 44 Гбайт набортной памяти SRAM. Его производительность в операциях FP16 заявлена на уровне 125 Пфлопс. Один WSE-3 составляет основу для новой вычислительной платформы Cerebras CS-3, которая, по утверждению компании, обеспечивает вдвое более высокую производительность, чем предыдущая платформа CS-2 при том же энергопотреблении в 23 кВт. По сравнению с ускорителем Nvidia H100 платформа Cerebras CS-3 на базе WSE-3 физически в 57 раз больше и примерно в 62 раза производительнее в операциях FP16. Но учитывая размеры и энергопотребление Cerebras CS-3, справедливее будет сравнить её с платформой Nvidia DGX с 16 ускорителями H100. Правда, даже в этом случае CS-3 примерно в 4 раза быстрее конкурента, если речь идёт именно об операциях FP16.

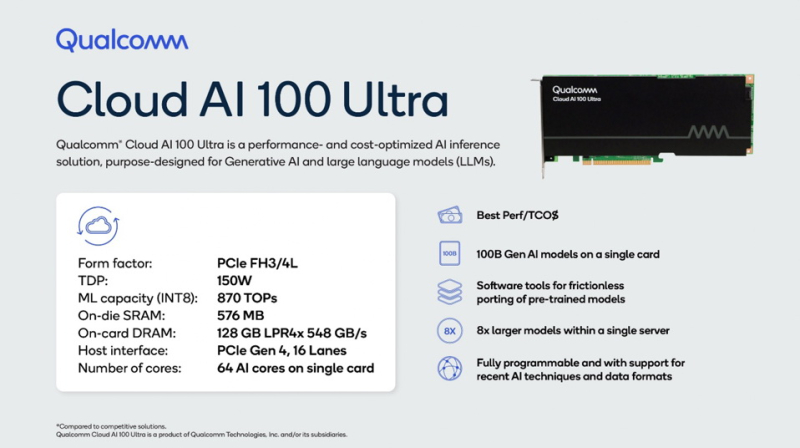

Cerebras CS-3 Одним из ключевых преимуществ систем Cerebras является их пропускная способность. Благодаря наличию 44 Гбайт набортной памяти SRAM в каждом WSE-3, пропускная способность новейшей системы Cerebras CS-3 составляет 21 Пбайт/с. Для сравнения, Nvidia H100 с памятью HBM3 обладает пропускной способностью в 3,9 Тбайт/с. Однако это не означает, что системы Cerebras быстрее во всех сценариях использования, чем конкурирующие решения. Их производительность зависит от коэффициента «разрежённости» операций. Та же Nvidia добилась от своих решений удвоения количества операций с плавающей запятой, используя «разреженность». В свою очередь Cerebras утверждает, что добилась улучшения примерно до 8 раз. Это значит, что новая система Cerebras CS-3 будет немного медленнее при более плотных операциях FP16, чем пара серверов Nvidia DGX H100 при одинаковом энергопотреблении и площади установки, и обеспечит производительность около 15 Пфлопс против 15,8 Пфлопс у Nvidia (16 ускорителей H100 выдают 986 Тфлопс производительности). Cerebras уже работает над внедрением CS-3 в состав своего суперкластера Condor Galaxy AI, предназначенного для решения ресурсоёмких задач с применением ИИ. Этот проект был инициирован в прошлом году при поддержке компании G42. В его рамках планируется создать девять суперкомпьютеров в разных частях мира. Две первые системы, CG-1 и CG-2, были собраны в прошлом году. В каждой из них сдержится по 64 платформы Cerebras CS-2 с совокупной ИИ-производительностью 4 экзафлопса. В эту среду Cerebras сообщила, что построит систему CG-3 в Далласе, штат Техас. В ней будут использоваться несколько CS-3 с общей ИИ-производительностью 8 экзафлопсов. Если предположить, что на остальных шести площадках также будут использоваться по 64 системы CS-3, то общая производительность суперкластера Condor Galaxy AI составит 64 экзафлопса. В Cerebras отмечают, что платформа CS-3 может масштабироваться до 2048 ускорителей с общей производительностью до 256 экзафлопсов. По оценкам экспертов, такой суперкомпьютер сможет обучить модель Llama 70B компании Meta✴✴ всего за сутки. Помимо анонса новых ИИ-ускорителей Cerebras также сообщила о сотрудничестве с компанией Qualcomm в вопросе создания оптимизированных моделей для ИИ-ускорителей Qualcomm с Arm-архитектурой. На потенциальное сотрудничество обе компании намекали с ноября прошлого года. Тогда же Qualcomm представила свой собственный ИИ-ускорители Cloud AI100 Ultra формата PCIe. Он содержит 64 ИИ-ядра, 128 Гбайт памяти LPDDR4X с пропускной способностью 548 Гбайт/с, обеспечивает производительность в операциях INT8 на уровне 870 TOPS и обладает TDP 150 Вт.

Источник изображения: Qualcomm В Cerebras отмечают, что вместе с Qualcomm они будут работать над оптимизацией моделей для Cloud AI100 Ultra, в которых будут использоваться преимущества таких методов, как разреженность, спекулятивное декодирование, MX6 и поиск сетевой архитектуры. «Как мы уже показали, разрежённость при правильной реализации способна значительно повысить производительность ускорителей. Спекулятивное декодирование предназначено для повышения эффективности модели при развёртывании за счёт использования небольшой и облегченной модели для генерации первоначального ответа, а затем использования более крупной модели для проверки точности этого ответа», — отметил гендиректор Cerebras Эндрю Фельдман (Andrew Feldman). Обе компании также рассматривают возможность использования метода MX6, представляющего собой форму сжатия размера модели путём снижения её точности. В свою очередь, поиск сетевой архитектуры представляет собой процесс автоматизации проектирования нейронных сетей для конкретных задач с целью повышения их производительности. По словам Cerebras, сочетание этих методов способствует десятикратному повышению производительности на доллар. В Китае искусственный интеллект навёл порядок на железной дороге — она заработала лучше, чем новая

13.03.2024 [12:10],

Геннадий Детинич

Чат-боты, сгенерированные картинки, видео и другие подобные развлечения с искусственным интеллектом — это интересно и местами полезно. Но более важным станет практическое внедрение ИИ в производство, транспорт и материальную экономику в целом. В конечном итоге выиграет тот, кто буквально будет «пахать и строить» на ИИ, заменив человека в производственной сфере. Китай сделал важный шаг к этому: благодаря ИИ там смогли навести порядок на железной дороге.

Источник изображения: Xinhua Простой обыватель даже не может себе представить, чего стоит содержать дорогу, инфраструктуру и парк техники в порядке, а также обеспечивать движение составов. Это потенциально убыточные мероприятия с огромной ответственностью. Китай, как и другие страны, вскоре ощутит проблемы со стареющим населением. При этом железнодорожная сеть в стране растёт и предполагает соединение высокоскоростными ж/д магистралями все города с населением свыше 500 тыс. человек. Скорость подвижного состава также растёт, что делает человеческий фактор наиболее слабым звеном. Протокол управления данными для внедрения ИИ-алгоритмов на железной дороге в Китае был внедрён оператором национальной сети железных дорог — китайской государственной компанией China State Railway Group — в 2022 году. Доступ к данным должен был быть ограничен и защищён от стороннего вмешательства и утечек. Алгоритмы управления были проверены людьми, и только после этого они были внедрены. Масштабные испытания начались в 2023 году. Результат ошеломил — железная дорога стала работать даже лучше, чем новая (сразу после ввода участков и составов в строй). Датчики установлены на объектах инфраструктуры, на колёсные пары, на вагоны, чтобы учитывать вибрации, ускорение и амплитуды и это не говоря об обычной сигнальной автоматике. Объём собираемых для анализа данных достиг 200 Тбайт, а ведь это не картинки или видео, а обычные состояния регистров. Человек и сколь угодно большой коллектив не смог бы оперативно обрабатывать такой объём информации. Всё это данные о 45 тыс. км путей — это длиннее, чем экватор Земли. Обслужить всё это не хватит никакой рабочей силы. Размещённая в Пекине система искусственного интеллекта в режиме реального времени обрабатывает огромные объёмы данных со всей страны и может предупреждать ремонтные бригады о нештатных ситуациях в течение 40 минут с точностью до 95 %. Рекомендации обычно направлены на предотвращение неисправностей — на профилактику потенциальных проблем. ИИ во всём этом потоке данных научили находить связи между событиями, которые недоступны для осознания в реальном масштабе времени. За прошедший год ни одна из действующих высокоскоростных железнодорожных линий Китая не получила ни единого предупреждения о необходимости снижения скорости из-за серьёзных проблем с неровностями пути, в то время как количество мелких неисправностей на путях сократилось на 80 % по сравнению с предыдущим годом. Алгоритмы действуют настолько чётко, что даже повышают плавность хода в условиях сильных ветров и на мостах, снижая амплитуду колебаний составов и уменьшая нагрузку на пути и инфраструктуру. Звучит, как фантастика. Подобные решения не только уменьшают потребность в обслуживающем персонале, но также снижают финансовую нагрузку на содержание железных дорог и, что самое важное, повышают безопасность движения. В Китае признают своё отставание от США в плане развития искусственного интеллекта, но если США не сможет конвертировать возможности ИИ в повышение производительности труда в материальной сфере, то это их преимущество будет лишь иллюзией. ChatGPT научился читать свои ответы вслух

05.03.2024 [10:12],

Николай Хижняк

Компания OpenAI добавила в свой ИИ-бот ChatGPT функцию «Чтение вслух», которая озвучивает ответы на запросы пользователей с помощью одним из пяти голосов. Функция может пригодиться, например, в дороге, когда отвлечься на экран устройства для чтения ответа на запрос может оказаться невозможно. Новая функция «Чтение вслух» уже доступна как в веб-версии ChatGPT, так и в приложениях ChatGPT для iOS и Android.

Источник изображения: Unsplash, Andrew Neel Функция «Чтение вслух» поддерживает 37 языков и автоматически определяет язык ответа. Она доступна как для чат-ботов на базе GPT-4, так и для GPT-3.5. Следует добавить, что аналогичные возможности для своих ИИ-моделей ранее добавила компания Anthropic, один из основных конкурентов OpenAI. В сентябре минувшего года ChatGPT запустил функцию голосового запроса, благодаря которой пользователи могут голосом проговаривать запрос для чат-бота, не печатая его в форме. Новая же функция позволяет настроить чат-бота таким образом, чтобы он всегда устно отвечал на запросы пользователя. Для работы функции «Чтение вслух» в мобильных приложениях необходимо нажать и удерживать поле введённого запроса. В результате откроется специальный плеер «Чтение вслух», где можно выбрать настройки воспроизведения, приостановки или перемотки аудио-ответа. В веб-версии чат-бота для активации функции «Чтение вслух» под текстом ответа отображается значок динамика. MSI представила читерский монитор MEG 321URX — он сам находит врагов в League of Legends

10.01.2024 [22:59],

Николай Хижняк

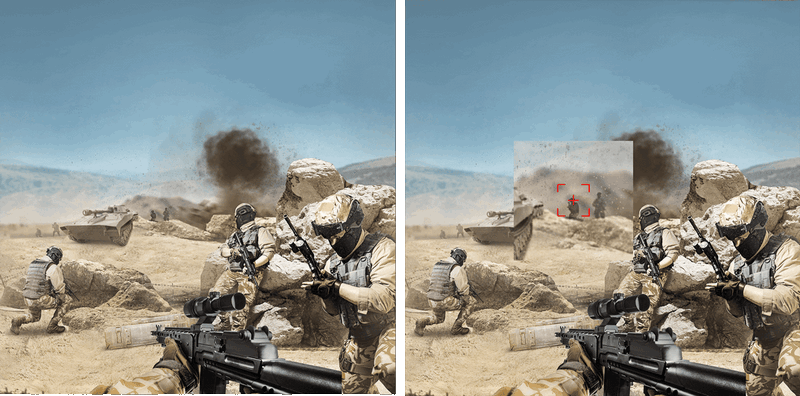

Компания MSI представила на выставке CES 2024 необычный игровой 32-дюймовый QD-OLED-монитор MEG 321URX. Его главной особенностью является встроенный ИИ, который не только улучшает качество работы дисплея, но также обладает функцией обнаружения врагов в League of Legends и показывает место на карте, откуда они могут появиться. Позже монитору добавят возможность помогать игрокам и в других играх.

Источник изображения: Brad Chacos / IDG Компания называет эту технологию SkySight. По словам производителя, SkySight анализирует мини-карту на экране и предсказывает, откуда может появиться противник, отображая эту информацию в виде красного пятна на дисплее. Опытные игроки способны делать что-то подобное самостоятельно, но для новичков эта функция может оказаться крайне полезной. Неизвестно, нарушает ли такой подход правила League of Legends, однако распознать работу SkySight вряд ли смогут даже самые продвинутые алгоритмы против читеров. Дело в том, что анализ ИИ и генерация второго слоя изображения на экране выполняются специальным чипом, встроенным в сам монитор. Функция работает независимо от операционной системы и программного обеспечения компьютера. Ещё одной особенностью монитора стала светодиодная полоска внизу дисплея, которая дублирует полоску очков здоровья персонажа в игре. MSI говорит, что к началу продаж MEG 321URX весной этого года выпустит специальное ПО, которое позволит обучать встроенный ИИ-алгоритм монитора для обнаружения врагов и шкал здоровья в любых других играх. Для первоначального обучения ИИ-алгоритма это программное обеспечение будет использовать ресурсы ПК. Однако потом всю обработку, анализ и отображение на экране будет выполнять сам монитор. В MSI пока не говорят, какой именно ИИ-процессор используется в MEG 321URX и как он хранит набор данных для обучения. Кроме этого, в монитор встроены технологии умного прицела и оптического зума — первая автоматически меняет цвет прицела так, чтобы он не сливался с окружением, а зум при нажатии горячих клавиш превращает любое оружие в снайперскую винтовку, приближая и увеличивая врагов на экране.  Даже если пользователю не нужны все эти читерские ИИ-функции, то MEG 321URX сам по себе обладает отличными характеристиками. Его экран поддерживает разрешение 3840 × 2160 пикселей, частоту обновления 240 Гц, имеет 99-процентный охват цветового пространства DCI-P3, обладает контрастностью 1 500 000:1 и имеет сертификацию DisplayHDR True Black 400. Кроме того, он поддерживает технологию OLED Care 2.0, которая снижает вероятность выгорания экрана. В оснащение монитора входят разъёмы HDMI 2.1, DisplayPort 2.1, USB 2.0 и USB-C. Последний может работать в альтернативном режиме DisplayPort, а также передавать до 90 Вт мощности на внешнее устройство. Стоимость монитора MEG 321URX производитель пока не сообщает. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |