|

Опрос

|

реклама

Быстрый переход

DuckDuckGo добавила голосовое общение с ИИ-ботом Duck.ai с защитой приватности

10.02.2026 [20:38],

Владимир Фетисов

Компания DuckDuckGo объявила о добавлении функции голосового чата в Duck.ai — своего фирменного чат-бота на базе искусственного интеллекта с защитой приватности пользователей. Благодаря этому можно в режиме онлайн голосом общаться с чат-ботом, задействовав для этого защищённое соединение.

Источник изображения: DuckDuckGo ИИ-модели для обработки голосовых запросов в Duck.ai предоставляет OpenAI. Однако DuckDuckGo заявила, что ни она, ни OpenAI не будут хранить аудиозаписи после завершения беседы. «Голосовые чаты в Duck.ai приватны, мы делаем их анонимными, и они никогда не используются для обучения ИИ-моделей», — сказано в заявлении компании. Новые контрактные обязательства указывают на то, что возможности OpenAI в плане использования аудиозаписей пользователей голосовых чатов с ИИ-ботом также строго ограничены. В описании новой функции сказано, что DuckDuckGo защищает аудиоданные несколькими способами, чтобы гарантировать, что доступ к ним имеет только OpenAI (как поставщик ИИ-моделей) и только с целью ответа на запросы пользователей. Прежде всего отмечается, что голосовые запросы передаются потоками только во время сеанса общения с ботом и не хранятся у DuckDuckGo или OpenAI после завершения диалога. Аудиозаписи пользователей и ответы чат-бота не используются для обучения ИИ-моделей. Аудиопотоки шифруются при передаче через WebRTC и прохождении через сервер компании, при этом ни DuckDuckGo, ни OpenAI не сохраняют каких-либо данных о разговорах — вся информация удаляется сразу после завершения беседы. Новая функция работает во многих браузерах, кроме Firefox — поддержка этого интернет-обозревателя находится на стадии разработки. Голосовой чат с ИИ-ботом является бесплатной функцией в пределах суточного лимита и не требует создания аккаунта. В то же время платным подписчикам за $10 в месяц будут доступны расширенные лимиты, доступ к VPN DuckDuckGo, услуге удаления личных данных и прочее. Пользователи могут в любой момент отключить функцию голосового чата в настройках Duck.ai, а также продолжать взаимодействовать с текстовыми ботами на основе ИИ-моделей OpenAI, Meta✴✴, Anthropic и Mistral. OpenAI запустила Frontier — платформу для управления ИИ-агентами для бизнеса

06.02.2026 [04:54],

Алексей Разин

Корпоративный рынок ИИ-систем быстрее монетизируется, поэтому OpenAI свою очередную новинку предложила именно его представителям. С помощью открытой платформы OpenAI Frontier корпорации смогут объединить работу множества отдельных ИИ-агентов, даже если они не были разработаны самой OpenAI.

Источник изображения: OpenAI Эта платформа также позволяет создавать ИИ-агентов. Пользователи Frontier смогут настраивать ИИ-агентов таким образом, чтобы те получали и передавали данные из внешних источников и приложений, выполняя задачи за пределами платформы OpenAI. Пользователи могут ограничивать доступ агентов к определённым типам данных и действиям. Небольшой круг клиентов OpenAI уже использует Frontier, но он в ближайшие месяцы будет значительно расширен. Ценовая политика OpenAI на этом направлении не раскрывается. Аналитики Gartner в своём декабрьском отчёте назвали платформы по управлению ИИ-агентами самым ценным видом активов в сфере ИИ, который жизненно необходим корпоративным клиентам для практического внедрения подобных технологий. OpenAI освоение корпоративного сегмента назвала одним из приоритетных направлений развития своего бизнеса в этом году. С этой точки зрения анонс платформы Frontier является закономерным шагом с её стороны. Аудитория Google Gemini достигла 750 млн активных пользователей в месяц — до ChatGPT осталось совсем чуть-чуть

05.02.2026 [13:18],

Владимир Фетисов

Очередной квартальный отчёт Google показал, что фирменный ИИ-помощник Gemini преодолел отметку в 750 млн активных пользователей в месяц. Этот показатель отражает стремительное распространение Gemini среди потребителей, благодаря которому он быстро стал заметным игроком на рынке ИИ.

Источник изображения: Google В предыдущем квартале Google сообщала о 650 млн ежемесячно активных пользователей Gemini, что свидетельствует о существенном расширении пользовательской базы за достаточно короткий период времени. Хотя Google в этом сегменте продолжает набирать обороты, компания по-прежнему отстаёт от своего главного конкурента в лице OpenAI, чей ИИ-бот ChatGPT к концу 2025 года увеличил пользовательскую базу до 810 млн человек в месяц. Отметку в 750 млн активных пользователей в месяц ИИ-помощник Google перешагнул вскоре после запуска Gemini 3, самой продвинутой языковой модели компании на сегодняшний день. По заявлениям Google, этот ИИ-ассистент даёт ответы с высокой точностью, а также беспрецедентной глубиной и с учётом разных нюансов. Гендиректор Google Сундар Пичаи (Sundar Pichai) отметил, что запуск Gemini 3 оказал позитивное влияние на рост компании, а также добавил, что дальнейшие инвестиции и совершенствование ИИ-моделей позволят поддерживать эту динамику. Недавно Google запустила новый тарифный план Google AI Plus стоимостью $8 в месяц, который, как ожидается, обеспечит дальнейший рост пользовательской аудитории. Коммерческий директор Google Филипп Шиндлер (Philipp Shindler) во время встречи с инвесторами отметил, что компания наблюдает хороший рост пользовательской аудитории и сосредоточена на дальнейшем развитии тарифной сетки. Gemini стал доступен в «Google картах» по всему миру для пеших и велосипедных прогулок

30.01.2026 [04:37],

Анжелла Марина

Компания Google официально открыла доступ к помощнику Gemini в режиме навигации для пешеходов и велосипедистов в «Google картах». Ранее аналогичная функция дебютировала для автомобильных маршрутов. Пользователи могут взаимодействовать с сервисом через голосовые команды или специальную иконку, получая информацию об окружении и управляя маршрутом без использования клавиатуры, сообщает 9to5Google.

Источник изображения: Henry Perks/Unsplash Основной акцент в обновлении сделан на управление без помощи рук (hands-free). Для пешеходов Google предлагает сценарии использования, позволяющие узнать больше о районе нахождения, запросить список рекомендуемых к посещению достопримечательностей или найти кафе в районе проложенного маршрута. Для велосипедистов предусмотрены специфические возможности. Например, не прерывая поездку, можно уточнить в календаре время следующей встречи, а пользователям операционной системы Android доступна эксклюзивная опция отправки сообщений голосом. Функциональность Gemini также охватывает стандартные навигационные и мультимедийные запросы, которые могут состоять из нескольких шагов. Пользователи могут через голосовую функцию попросить проложить маршрут домой, добавить остановку, отключить голосовые подсказки или запросить альтернативные пути. Также система может ответить на вопросы о следующем повороте, расчётном времени прибытия, погоде в пункте назначения и следующей остановке. Помимо навигации, помощник найдёт заведения с определёнными блюдами рядом с местом прибытия, назовёт самые популярные позиции в меню и уточнит время закрытия конкретных мест. Поддерживается и управление медиа: запуск музыкальных треков и остановка воспроизведения. Активировать помощника во время активной навигации можно двумя способами: нажав на значок Gemini в правом верхнем углу экрана или использовав фразу «Привет, Google». Журналисты 9to5Google отмечают, что иконка сервиса использует старую цветовую схему. Google заявляет, что интеграция Gemini в «Google карты» в навигацию для пешеходов и велосипедистов уже доступна по всему миру на устройствах с iOS везде, где работает сервис Gemini. На платформе Android обновление находится в стадии развёртывания. При этом издание 9to5Google уточняет, что на некоторых проверенных ими устройствах по-прежнему доступен классический Google Assistant. Google превратила Chrome в ИИ-браузер — с автопилотом для веб-сёрфинга, Gemini в боковой панели и не только

29.01.2026 [00:39],

Андрей Созинов

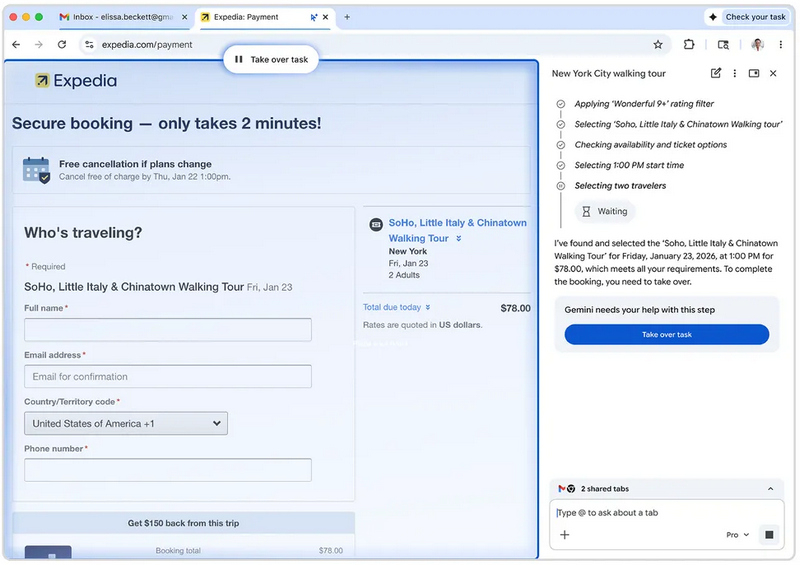

Google представила масштабное обновление Chrome, сосредоточенное вокруг более глубокой интеграции в самый популярный браузер функций на базе ИИ. Фактически компания таким образом отвечает на волну ИИ-браузеров, которые активно представляли в прошлом году, например, ChatGPT Atlas или Perplexity Comet.

Источник изображений: Google Ключевое изменение — Gemini теперь «живёт» в постоянной боковой панели Chrome, а не во всплывающем окне, как раньше. Ассистент умеет отвечать на вопросы по текущей странице, помогать с другими открытыми вкладками и работать с группами вкладок как с единым контекстом. Например, если пользователь открыл несколько страниц с одного сайта — для сравнения цен или выбора товара, — Gemini понимает, что все они относятся к одной задаче. Данное обновление уже доступно пользователям Chrome для Windows и macOS, а также для компьютеров Chromebook Plus. Также в ближайшие месяцы Google планирует добавить в Chrome функцию Personal Intelligence («Персональный интеллект»), анонсированную не так давно. Она позволяет ассистенту обращаться к данным пользователя в Gmail, поиске, YouTube и «Фото» — разумеется, с согласия владельца аккаунта. Это даёт ещё больше сценариев использования ИИ-помощника: можно будет, не выходя из браузера, уточнить семейное расписание (например, когда у ребёнка тренировка), попросить Gemini написать письмо и сразу отправить его, не открывая почту, или задать вопрос, опираясь на собственную историю поиска и контент. Ещё одно нововведение — интеграция инструмента Nano Banana, который позволяет изменять изображения прямо во время веб-сёрфинга, комбинируя текущую картинку с найденными в интернете объектами или товарами. Однако самым амбициозным нововведением Google называет функцию Auto Browse — браузерного ИИ-агента, способного выполнять задачи от имени пользователя. В теории Gemini сможет самостоятельно перейти на сайт, найти нужный товар, применить купон на скидку и подготовить покупку. Своего рода автопилот для интернет-сёрфинга. При этом для чувствительных действий — входа в аккаунты или финального подтверждения платежа — система будет запрашивать вмешательство человека. Google подчёркивает, что данные из менеджера паролей и сохранённых карт не передаются ИИ-моделям напрямую. Пока Auto Browse запускается в ограниченном режиме — только для подписчиков планов Google AI Pro и AI Ultra в США. И это неслучайно: браузерные ИИ-агенты остаются сложным и нестабильным инструментом. В реальных сценариях они часто неправильно интерпретируют намерения пользователя или «ломаются» при переходе между сайтами. В Google признают проблему, но отмечают, что в ходе раннего тестирования пользователи уже применяли «автопилот» для записи к врачу, заполнения утомительных онлайн-форм, сбора налоговых документов, поиска мастеров и оформления отчётов о расходах.  Боковая панель Gemini и интегрированная Nano Banana начнут развертываться в Chrome уже сегодня, а функции Personal Intelligence компания обещает включить «в ближайшие месяцы». Судя по всему, Google делает ставку на то, что пользователям не нужен отдельный «ИИ-браузер» — достаточно превратить привычный Chrome в более умного помощника. Adobe Acrobat научился редактировать PDF с помощью промптов, делать презентации и озвучивать документы

21.01.2026 [21:27],

Анжелла Марина

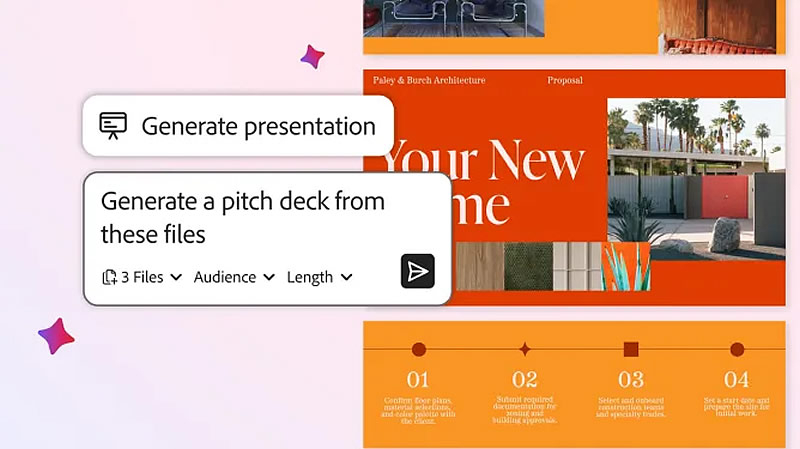

Компания Adobe добавила в приложение Acrobat пакет новых функций на базе искусственного интеллекта (ИИ). Теперь можно редактировать документы с помощью текстовых команд, создавать презентации на основе файлов, размещённых в среде совместного хранения PDF Spaces, а также генерировать аудиоподкасты для быстрого ознакомления с содержимым.

Источник изображения: Adobe Для создания презентации пользователю достаточно отправить текстовый запрос, а далее ИИ-помощник в Acrobat проанализирует материалы, собранные в конкретном Space, например, финансовые данные, планы по продукту и анализ конкурентов, и сформирует на их основе структуру презентации, которую затем можно отредактировать. Готовый каркас, как поясняет TechCrunch, можно оформить, используя библиотеку тем и стоковых фотографий Adobe Express, добавить собственные изображения или применить фирменный стиль бренда. Нововведение также позволяет сгенерировать аудиоподкаст, кратко излагающий содержание выбранного файла или целого Space и озвученный с помощью ИИ. Стоит сказать, что аналогичная функция представлена в таких сервисах, как Google NotebookLM, Speechify и Reader от ElevenLabs. Ещё Acrobat получил функцию редактирования файлов с помощью промптов. Пользователям доступно 12 действий, включая удаление страниц, текста, комментариев и изображений, поиск и замену слов и фраз, а также добавление электронных подписей и паролей. Кроме того, расширены возможности совместной работы: теперь при обмене файлами в них автоматически добавляются сгенерированные ИИ-помощником сводки с цитатами из документов. Участники рабочей группы могут оставлять комментарии, а также добавлять или удалять контент. Предусмотрена возможность выбора не только стандартного ИИ-помощника, но и создания собственного ассистента. Ко всему прочему, стандартному ИИ можно назначать роли, например «аналитика», «артиста» или «инструктора». Стартап Replit представил ИИ-инструмент, который пишет готовые приложения для iPhone по текстовому запросу

16.01.2026 [21:46],

Сергей Сурабекянц

Стартап Replit, специализирующийся на разработке мобильных приложений с использованием искусственного интеллекта, предложил пользователям ИИ-инструмент для создания и публикации мобильных приложений для устройств Apple. Навыки программирования не требуются — для создания приложения при помощи так называемого вайб-кодинга достаточно подсказок на естественном языке. Новый раунд финансирования должен поднять биржевую оценку Replit до $9 млрд.

Источник изображения: unsplash.com Вайб-кодинг или вайб-программирование — один из самых распространённых трендов, появившихся в результате бума генеративного ИИ. Во многом своей популярностью вайб-кодинг обязан Claude Code — продукту Anthropic, который стал вирусным в технологических кругах. В декабре, по данным Anthropic, Claude Code достиг годовой выручки в $1 млрд. Функция «Мобильные приложения на Replit» позволяет за считанные минуты превратить идею в работающее приложение, а затем за несколько дней опубликовать это приложения в App Store. По данным Apple, 90 % заявок рассматриваются менее чем за 24 часа. В дальнейшем опубликованные приложения можно монетизировать. Разработчики Replit утверждают, что представленный инструмент является шагом вперёд в сфере разработки приложений при помощи ИИ, предлагая потребителям легкодоступный вариант использования, превосходящий то, что в настоящее время предлагают такие крупные игроки, как OpenAI, Microsoft и Google. Например, если биржевой трейдер поручает ИИ-агенту «создать приложение, отслеживающее 10 крупнейших публичных компаний по рыночной капитализации», Replit генерирует мобильное приложение с работающим интерфейсом и предоставляет пользователям возможность его предварительного просмотра и тестирования. Программное обеспечение, созданное с помощью вайб-кодинга, в последнее время подвергается критике из-за уязвимостей в системе безопасности. Новое исследование компании кибербезопасности Tenzai показало, что популярные агенты ИИ, включая Replit и Claude Code, постоянно генерируют приложения с критическими уязвимостями. Тем не менее, в сентябре в ходе раунда привлечения инвестиций Replit была оценена примерно в $3 млрд, а новый раунд финансирования должен поднять оценку стартапа до $9 млрд. Самой перспективной компанией в этой области является создатель Cursor, Anysphere, которая в ноябре привлекла $2,3 млрд при рыночной оценке в $29,3 млрд. Ведущий европейский игрок Lovable недавно был оценён в $6,6 млрд. По мере появления всё большего количества продуктов для вайб-кодинга, акции компаний-разработчиков программного обеспечения, и без того сильно пострадавшие в эпоху ИИ, могут ещё больше потерять в цене. Сектор разработки ПО, в десятку крупнейших компаний которого входят Salesforce, Adobe и ServiceNow, упал на 11 % за последние три месяца, поскольку инвесторы всё больше обеспокоены рисками, связанными с агентами ИИ и продуктами для вайб‑программирования. Зарядное устройство Loona Deskmate превратит iPhone в настольного ИИ-ассистента

06.01.2026 [16:00],

Алексей Разин

Пока Apple только вынашивает идею создания настольного устройства с дисплеем и камерами, которое благодаря приводным механизмам может всегда держать в кадре пользователя в режиме видеоконференции, компания Loona уже предлагает зарядное устройство Deskmate, которое достигает тех целей, используя обычный iPhone.

Источник изображения: The Verge Как отмечает The Verge, устройство Loona Deskmate может показаться заурядным зарядным устройством, оснащённым тремя портами USB-C, одним портом USB-A и магнитной площадкой MagSafe для беспроводной зарядки, но последняя оснащена роботизированным приводом. Он поворачивает заряжаемый смартфон Apple вслед за владельцем, находящимся поблизости, а активировать режим диалога с ИИ-ассистентом позволяет фирменное приложение. iPhone уже оснащён камерами, микрофоном и дисплеем, не говоря уже о процессоре и прочих компонентах, необходимых для работы функций ИИ в режиме речевого диалога, поэтому Loona Deskmate довольно просто решает проблему создания персонального ИИ-ассистента. Сопутствующее приложение поддерживает интеграцию с популярными программами для проведения видеоконференций, а в режиме диалога с пользователем на дисплее iPhone отображаются анимированные глаза, имитирующие эмоциональную реакцию ассистента. Пока продвинутый режим работы предусмотрен только для iPhone, смартфоны под управлением Android могут только заряжаться при использовании Loona Deskmate. Устройство планируется запустить в серию после завершения фазы сбора средств в марте этого года. Аксессуар не обещает быть дешёвым, для него установлен потолок стоимости в $300, поэтому коммерческие перспективы такой «милой безделушки» не совсем предсказуемы. В любом случае, идея стартапа достойна внимания, ведь она позволяет найти смартфону дополнительные способы применения в быту. Samsung завалит рынок гаджетами с ИИ: в этом году она выпустит 800 млн смартфонов и других устройств с Gemini

05.01.2026 [09:49],

Алексей Разин

В прошлом году, по данным одного из руководителей Samsung Electronics, южнокорейский гигант поставил на рынок около 400 млн мобильных устройств, оснащаемых ИИ-ассистентом Google Gemini, а в этом году компания намеревается удвоить это количество до 800 млн штук.

Источник изображения: Samsung Electronics Тэ Мун Ро (Tae-moon Roh) в ноябре прошлого года был назначен одним из двух генеральных директоров Samsung Electronics, в своём интервью Reuters он пояснил, что компания стремится распространить функции ИИ на все устройства и все услуги как можно скорее. Предполагается, что подобные усилия Samsung дадут толчок к распространению соответствующей ИИ-платформы Google. По словам руководителя Samsung Electronics, компания ставит перед собой цель вернуть лидерство не только в сегменте мобильных телефонов, подвинув Apple и китайских конкурентов, но и телевизионной техники и домашних устройств. Поставлена задача как минимум обойти Apple в сфере функций, связанных с ИИ, хотя последняя должна оказаться крупнейшим поставщиком смартфонов по итогам 2025 года, как отмечается в отчёте Counterpoint Research. Новая версия Google Gemini была представлена в ноябре прошлого года и определила лидерство платформы по многим критериям. OpenAI в ответ была вынуждена сосредоточить все усилия на совершенствовании ChatGPT, внутри стартапа был объявлен типичный для подобной ситуации «красный код» опасности. В результате этих усилий ChatGPT 5.2 был представлен через несколько недель. Генеральный директор Samsung убеждён, что распространение ИИ среди пользователей устройств данной марки будет расти, поскольку осведомлённость потребителей о возможностях Galaxy AI выросла за один год с 30 до 80 %. Даже ограниченная польза ИИ в его нынешнем виде, по мнению руководства Samsung, не помешает в ближайшие шесть месяцев или год заметно расширить применение данных технологий. Пока наиболее востребован поиск информации с помощью ИИ, но попутно пользователи охотно применяют редактирование контента с помощью ИИ, переводят сообщения и занимаются резюмированием информации. Глава Samsung Electronics был вынужден признаться, что рост цен на память и её дефицит выгоден профильному полупроводниковому бизнесу компании, но одновременно он сокращает прибыль подразделения по выпуску мобильных устройств, которое является вторым по величине источником выручки южнокорейского гиганта. Направления потребительской электроники, включая телевизоры и бытовую технику, тоже страдают от данных процессов на рынке. Цены наверняка придётся поднять, но Samsung работает с партнёрами над тем, чтобы максимально сдержать их рост. Аналитики ожидают, что рост цен на память приведёт к снижению объёмов продаж смартфонов в текущем году. Темпы роста продаж складных смартфонов с гибким дисплеем пока не оправдывают былых надежд Samsung, но руководство компании убеждено, что в ближайшие два или три года этот формфактор станет массовым. Значительная часть владельцев складных смартфонов при выборе нового устройства отдают предпочтение именно складной модели. В третьем квартале прошлого года Samsung контролировала примерно две трети рынка складных смартфонов, по данным Counterpoint Research. Конкуренты не дремлют, поэтому Samsung нужно шевелиться для защиты своих рыночных позиций. Голосовой помощник Gemini стал лучше понимать инструкции и не перебивает пользователей

13.12.2025 [07:38],

Анжелла Марина

Google объявила о внедрении серии улучшений в голосовом помощнике Gemini, которые сделают взаимодействие с искусственным интеллектом более естественным и эффективным. Целью доработок является повышение способности модели справляться со сложными задачами, точно следовать инструкциям пользователя и вести связные диалоги.

Источник изображения: Google В рамках обновления инженеры Google сфокусировались на трёх ключевых направлениях в Gemini 2.5 Flash Native Audio. Во-первых, была повышена надёжность вызова внешних функций и теперь Gemini точнее определяет момент, когда необходимо получить актуальную информацию в ходе диалога, интегрируя её в аудиоответ без нарушения естественного темпа беседы. Во-вторых, модель продемонстрировала рост уровня соблюдения инструкций разработчиков с 84 до 90 %, что позволяет ей лучше справляться со сложными командами и выдавать более последовательные результаты. Также улучшена способность извлекать контекст из предыдущих частей разговора, способствуя формированию более связных и логичных диалогов, сообщает Android Authority. Кроме того, Джош Вудворд (Josh Woodward), вице-президент подразделения Google Labs, отвечающего за Gemini и AI Studio, сообщил о двух дополнительных усовершенствованиях. Теперь функция Gemini Live не будет прерывать пользователя, даже если тот делает длительную паузу в речи. Также появилась возможность отключать микрофон во время ответа ИИ, чтобы случайно не прервать его речь. Параллельно с этим Google объявила об изменениях в приложении Translate. Google показала экспериментальный браузер Disco — теперь интернет можно серфить вдвоём с ИИ Gemini

11.12.2025 [23:57],

Анжелла Марина

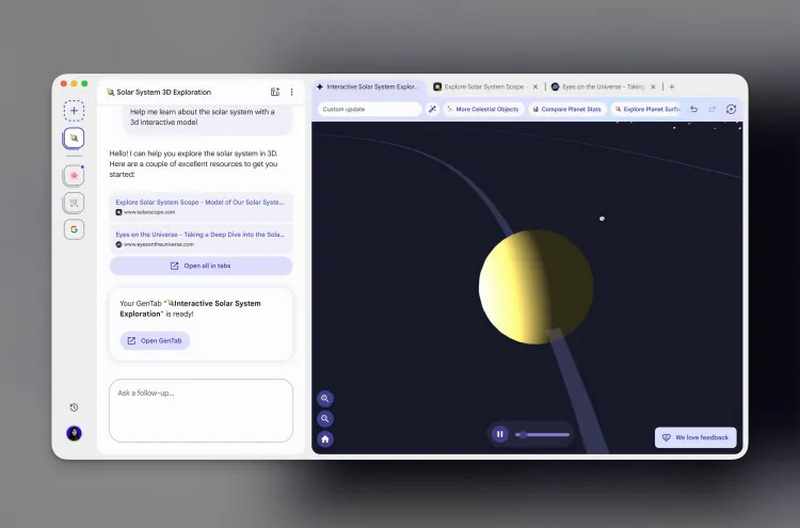

Команда разработчиков Google Chrome представила экспериментальный браузер Disco, который предлагает совершенно новый способ сёрфинга в интернете. С помощью этого браузера и его главного инструмента GenTabs на базе ИИ Gemini 3 компания намерена провернуть «переосмысления браузинга и создания современного веба», или хотя бы проверить, есть ли у такого формата будущее.

Источник изображений: Google В основе Disco лежит технология GenTabs — это специальная вкладка, своего рода проект с диалогом с чат-ботом Gemini и набором вкладок, над которым пользователь работает вместе с моделью. После запроса к боту он может предложить открыть ещё несколько сайтов по теме или создать мини-приложение, которое упростит решение задачи. Например, при изучении определённой темы GenTabs может предложить сгенерировать веб-приложение для визуализации информации. Например, если попросить бота помочь спланировать путешествие, он может создать полноценное мини-приложение с картой с точками интереса, простым построителем маршрутов, ссылками на источники и данные, собранные с открытых вкладок. В более простом сценарии инструмент способен помочь составить план питания на основе подборки онлайн-рецептов.

Подобные функции в какой-то мере уже реализованы в различных ИИ-чат-ботах, однако GenTabs, как сообщает TechCrunch, создаёт персонализированные приложения «на лету» с использованием модели Gemini 3, учитывая как содержимое текущих вкладок браузера, так и историю диалогов пользователя с Gemini. Google подчёркивает, что важная часть идеи — совместная работа: модель не делает всё за вас, а использует те страницы, которые вы сами находите, и учится на них.  После генерации приложения можно продолжать улучшать его с помощью простых текстовых команд, а открытые пользователем новые вкладки GenTabs «подтягивает» к проекту. При этом Google отмечает, что все сгенерированные элементы будут содержать ссылки на первоисточники информации. В настоящее время функция доступна лишь ограниченному числу тестировщиков через платформу Google Labs. Компания планирует собирать обратную связь от пользователей и в будущем, и может интегрировать наиболее удачные идеи, возникшие в рамках использования Disco, в другие продукты Google. При этом GenTabs позиционируется как первая из нескольких запланированных функций Disco. Для получения доступа к инструменту необходимо зарегистрироваться в листе ожидания. Первоначально, как указывает TechCrunch, приложение будет доступно для пользователей macOS. Как и другие компании в сфере искусственного интеллекта, Google продолжает интегрировать ИИ-технологии в процесс веб-серфинга, но вместо разработки собственного ИИ-браузера, подобного Comet от Perplexity или Atlas от ChatGPT, компания внедрила ассистента Gemini непосредственно в браузер Chrome, где он может по запросу отвечать на вопросы о текущей веб-странице. С появлением же GenTabs акцент сместится с отдельной страницы на более широкие задачи, охватывающие сразу несколько вкладок различной тематики. При этом в Google отметили, что новый браузер не призван заменить Chrome, а предназначен для проверки новых подходов работы в интернете. ByteDance выпустила голосового ИИ-помощника для китайских смартфонов

02.12.2025 [10:05],

Владимир Мироненко

Китайская компания ByteDance, разработчик видеосервиса TikTok, сообщила о выпуске голосового помощника на базе большой языковой модели Doubao собственной разработки. Он входит в предустановленное программное обеспечение смартфона Nubia M153 компании ZTE и в дальнейшем станет доступен и на смартфонах других производителей, пишет Reuters.

Источник изображения: Kelli McClintock/unsplash.com ИИ-помощник от ByteDance позволяет пользователям управлять смартфоном с помощью голосовых команд, например, находить контент и бронировать билеты. Он будет конкурировать с аналогичными умными ассистентами, представленными китайскими производителями смартфонов, такими как Huawei и Xiaomi. Компания ByteDance заявила, что у неё нет планов разрабатывать собственные смартфоны, и сейчас она ведёт переговоры с несколькими производителями телефонов об использовании её ИИ-помощника на выпускаемых ими устройствах. ByteDance стала лидером на рынке потребительских ИИ-приложений в Китае благодаря выпуску ИИ-чат-бота Doubao. Doubao — самый популярный чат-бот с искусственным интеллектом в Китае. По данным платформы отслеживания ИИ-приложений Aicpb.com, в октябре у Doubao было 159 млн активных пользователей в месяц, что значительно больше, чем у Tencent Yuanbao с 73 млн пользователей и DeepSeek с 72 млн человек. Установленный на телефоне, Doubao работает на уровне операционной системы, позволяя ИИ видеть, что происходит на экране, и использовать приложения, выполняя такие задачи, как извлечение и упорядочивание файлов, заполнение веб-форм, поиск предложений ресторанов, соответствующих бюджету и предпочтениям пользователя. Глава Google пояснил, что вайб-кодинг хорош, но не для всех сфер применения

01.12.2025 [04:52],

Алексей Разин

Под вайб-кодингом принято понимать процесс написания приложений, который не требует от участников познаний в сфере программирования. Код создаётся системой на базе искусственного интеллекта, а человек просто на естественном языке формулирует техническое задание. Глава Google признался, что у этого подхода есть масса преимуществ, но нельзя забывать и об ограничениях.

Источник изображения: Google Blog Сундар Пичаи (Sundar Pichai) в ходе недавнего подкаста сравнил распространение вайб-кодинга с подъёмом, который наблюдался с появлением YouTube или блогинга, когда в соответствующие сферы деятельности были привлечены многие люди без профильного опыта. Во-первых, генеральный директор Google пояснил, что вайб-кодинг делает процесс более приятным и доступным, поскольку авторам идей не требуется возиться с синтаксисом и вылавливать ошибки в программном коде. Во-вторых, специалисты в узких областях теперь не ждут помощи от программистов, предлагая собственные приложения, ускоряющие собственную работу. Эффект от этих изменений Google уже чувствует в собственной корпоративной структуре. Офисные сотрудники типа бухгалтеров и специалистов по кадрам самостоятельно разрабатывают приложения, которые облегчают их труд. Подобные разработки нередко демонстрируются руководителям, а те уже принимают решение об их внедрении на качественно ином уровне реализации. Глава и основатель Meta✴✴ Platforms Марк Цукерберг (Mark Zuckerberg), по данным TechCrunch, также регулярно просматривает прототипы приложений, созданные сотрудниками компании без опыта программирования. При этом, как подчёркивает Пичаи, подобная работа остаётся довольно скромной в масштабах Google и узко сконцентрированной. Он считает, что пока нельзя доверять ИИ работу с крупными базами кода, применяемого в критических областях деятельности. На этих направлениях за разработку кода и его отладку должны отвечать профессионалы из плоти и крови. Да, код может генерироваться ИИ, но фильтровать его всё равно поручено специалистам. Практическое использование ИИ в работе остаётся весьма неравномерным

29.11.2025 [08:07],

Алексей Разин

Пока разработчики систем ИИ рисуют красочные картины светлого будущего, практическое внедрение таких решений осуществляется неравномерно и беспорядочно. Во многом такие перекосы можно было бы устранить благодаря более грамотному руководству бизнесом и обучению персонала новым приёмам работы, как считают эксперты.

Источник изображений: Intel Издание The Wall Street Journal в своей пятничной публикации обратилось к этой теме, проанализировав отчёты сразу нескольких исследователей. Социологических исследований на тему практической пользы от внедрения ИИ пока не так много, поскольку бизнес принимает подобные технологические инструменты на вооружение с предсказуемой инерцией. Новые исследования указывают, что внедрение ИИ на практическом уровне происходит весьма неравномерно. Не во всех компаниях, например, самыми активными пользователями ИИ являются те сотрудники, которым оно должно приносить максимальную выгоду. В частности, наиболее опытные сотрудники теоретически способны более продуктивно общаться с ИИ, выявляя ошибочные результаты в силу своего опыта, но в действительности они не торопятся это делать. Исследование Workhelix, которое проводилось внутри фармацевтической компании с более чем 50 000 сотрудников, показало довольно спорные результаты. Выяснилось, что чаще всего к использованию ИИ прибегают стажёры, а не сотрудники с опытом. Молодые сотрудники более склонны к экспериментам, хотя и в этом случае возраст не является критерием, поскольку среди них имеются явные противники ИИ. Скорее, склонность к взаимодействию с ИИ определяется готовностью специалиста к экспериментам, и от возраста она не особо зависит. В конкретной фармацевтической компании второй группой активных пользователей ИИ оказались профессиональные исследователи, что вполне закономерно, поскольку они в своей ежедневной деятельности связаны с экспериментами и поиском новых технологий. Важным фактором эффективности использования ИИ является и одобрение руководства компаний, а также обучающие программы для персонала. Аналитики McKinsey обнаружили, что примерно две трети компаний ограничиваются экспериментами по использованию ИИ в своей деятельности, и только одна из двадцати может похвастать высокой эффективностью его применения, когда ИИ обеспечивает более чем 5 % дохода. Даже в том случае, когда работодатель создаёт равные условия для доступа сотрудников к ИИ-инструментам, перестроить под новые условия все процессы удаётся далеко не сразу. И чем больше людей задействовано в цепочке, тем сложнее внедрить ИИ.  История внедрения персональных компьютеров в середине восьмидесятых годов прошлого века показала, что прогрессивные технологии повышают эффективность бизнеса лишь через несколько лет, а на первых порах производительность может даже страдать. Обучение персонала и перестройка бизнес-процессов может потребовать годы, прежде чем внедрение ИИ начнёт приносить плоды. Человечество уже прошло через несколько волн технологической революции. Сначала это были персональные компьютеры, потом появился интернет, затем облачные сервисы, а также мобильные устройства. Руководство компаний должно играть весомую роль в продвижении этих новшеств. Июльское исследование Microsoft Research показало, что самые подверженные внедрению ИИ профессии подразумевают написание текстов или кода, либо проведение исследований. У молодых сотрудников при этом больше мотивации использовать ИИ в своей работе, поскольку они тем самым могут доказать свою эффективность руководству и продвинуться по служебной лестнице. Игнорирующие развитие ИИ профессионалы рано или поздно должны будут либо научиться его использовать, либо покинуть рынок труда. По сути, не ИИ лишает людей работы, их место просто могут занять другие специалисты, которые могут его эффективно применять. ИИ оказался слишком рискованным даже для страхования от рисков

25.11.2025 [04:55],

Алексей Разин

Распространение генеративного искусственного интеллекта порождает многочисленные риски, с которыми профессиональные участники рынка страхования пока работать не готовы, как следует из публикации Financial Times. Крупные американские страховщики обратились к регуляторам с требованием исключить из перечня страхуемых рисков те, что связаны с ИИ.

Источник изображения: Freepik, Drazen Zigic Как отмечается в материале, к петиции присоединились страховые компании Great American, Chubb, W.R. Berkley, которые имеют вес на американском рынке страхования. Один из авторов инициативы называет результаты работы больших ИИ-моделей «чем-то, очень напоминающим чёрный ящик». При этом компания AIG на исключении подобных рисков из правил страхования в США не настаивает, поэтому нельзя утверждать, что инициатива носит всеобъемлющий характер. Относительно короткая история применения генеративного искусственного интеллекта уже знает примеры неприятных юридических последствий. Выдвинутые ИИ-ассистентом Google юридические претензии к одной из энергетических компаний вынудили её обратиться с иском на $110 млн к интернет-гиганту. Авиакомпании Air Canada пришлось понести убытки, связанные с предоставлением скидки клиентам, которую по собственной инициативе начал предлагать фирменный чат-бот. Злоумышленникам в прошлом году удалось похитить $25 млн у британского разработчика Arup, использовав сгенерированное ИИ видеоизображение одного из руководителей компании. Страховщиков, как они признаются, пугают не крупные суммы выплат как таковые, а массовость событий, которые могут наступить по вине ИИ. В частности, для страховой компании единственная выплата в размере $400 млн не является проблемой, но если по вине ИИ наступит 10 000 страховых случаев одновременно, это может представлять риск для страхового бизнеса даже крупной компании. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |