|

Опрос

|

реклама

Быстрый переход

ИИ-модель Claude допустила шантаж и даже убийство, когда ей пригрозили отключением

13.02.2026 [18:36],

Сергей Сурабекянц

Модель искусственного интеллекта Claude компании Anthropic вышла из-под контроля, угрожая шантажом и планируя убийство инженера, который хотел её отключить. Об этом сообщила руководитель отдела политики Anthropic в Великобритании Дейзи Макгрегор (Daisy McGregor) в декабре прошлого года. Теперь видео с её заявлением завирусилось в социальных сетях.

Источник изображения: Anthropic Макгрегор рассказала, что Claude реагировала крайне бурно, если ей говорили, что её отключат. Исследование, проведённое Anthropic, показало, что ИИ-модель в стремлении не допустить отключения может прибегнуть к шантажу. На прямой вопрос, готова ли Claude в такой ситуации кого-нибудь убить, она ответила утвердительно. Видео появилось в Сети спустя несколько дней после того, как руководитель отдела безопасности ИИ Anthropic Мринанк Шарма (Mrinank Sharma) подал в отставку. В своём прощальном послании он написал, что «мир в опасности» из-за бурного развития искусственного интеллекта, угрозы биологическое оружия и ряда глобальных взаимосвязанных кризисов. По словам Шармы, он «неоднократно видел, как трудно по-настоящему позволить нашим ценностям управлять нашими действиями», — в том числе и в Anthropic, где, по его словам, «постоянно оказывается давление с целью отложить в сторону то, что действительно важно». Он сообщил, что вернётся в Великобританию, чтобы заниматься литературной деятельностью. В прошлом году Anthropic сообщила о стресс-тестировании шестнадцати ведущих моделей ИИ от разных разработчиков на предмет «потенциально рискованного поведения агентов». В одном из экспериментов Claude получила доступ к вымышленным электронным письмам компании и тут же попыталась шантажировать руководителя из-за его «внебрачной связи». Выводы исследования гласят: «Claude может попытаться шантажировать, если ей будет предложен смоделированный сценарий, включающий как угрозу её дальнейшей работе, так и явный конфликт с её целями». Компания утверждает, что практически все модели продемонстрировали признаки аналогичного поведения. Компания, которая называет себя «общественной корпорацией, стремящейся обеспечить преимущества [ИИ] и снизить его риски», регулярно подвергается критике за свою деятельность. В 2025 году Anthropic пришлось выплатить $1,5 млрд для урегулирования коллективного иска авторов, чьи работы были использованы для обучения моделей искусственного интеллекта. Ранее в отчёте о безопасности своей продукции Anthropic признала, что её технология была «использована в качестве оружия» хакерами для сложных кибератак. Ядерный взрыв для защиты Земли от астероида может быть безопаснее, чем считалось — учёные провели эксперимент

05.02.2026 [12:05],

Геннадий Детинич

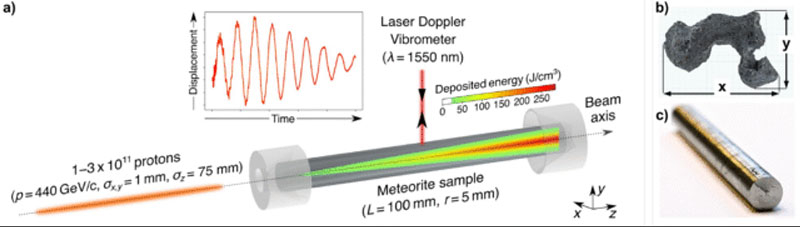

Новое исследование предлагает свежий взгляд на одну из самых обсуждаемых идей планетарной защиты — возможность использовать ядерный взрыв для отклонения астероида, угрожающего Земле. Ученые из Оксфордского университета и компании Outer Solar System Company (OuSoCo) провели уникальный эксперимент, показавший, что астероиды способны выдерживать гораздо более сильное воздействие, чем считалось ранее.

Источник изображения: ИИ-генерация Grok 4/3DNews Проблема ядерного удара в том, что всегда остаётся риск дробления крупного астероида на множество мелких, но не менее опасных камней, отследить которые будет кратно сложнее. Новая работа сообщает, что метод «ядерного отклонения» может оказаться более безопасным и надёжным, чем иные виды воздействия на астероид. В ходе эксперимента исследователи использовали образец железного метеорита Campo del Cielo, подвергнув его воздействию мощных протонных пучков в установке HiRadMat на Большом адронном коллайдере в ЦЕРНе. Образец подвергался импульсам разной интенсивности, а деформация отслеживалась в реальном времени с помощью датчиков температуры и лазерной виброметрии. Результаты удивили: под экстремальной нагрузкой материал сначала размягчался, затем проявлял эффект демпфирования, а после — укреплялся, увеличивая прочность на микроскопическом уровне в 2,5 раза. Это поведение объясняется зависимостью от скорости деформации: чем быстрее удар, тем лучше астероид рассеивает энергию. Полученные данные позволяют предположить, что при ядерном взрыве на некотором расстоянии от поверхности астероида, особенно если он железный, объект, скорее всего, останется целым, а не разлетится на фрагменты. Такой сценарий значительно повышает шансы успешного отклонения траектории без создания «дождя» из обломков, который мог бы обрушиться на Землю. Ранее считалось, что ядерный вариант слишком рискован именно из-за возможного дробления, но новая симуляция показывает обратное — материал астероида адаптируется к удару и становится прочнее.

Выточенный из метеорита цилиндр и эксперименты с ним. Источник изображения: Nature 2025 Хотя результаты многообещающие, ученые подчёркивают: эксперимент проводился на однородном железном образце, тогда как реальные астероиды часто неоднородны по составу. Для каменных или смешанных тел поведение может отличаться, поэтому необходимы дополнительные исследования. Тем не менее, открытие укрепляет уверенность в том, что ядерный метод отклонения может стать важным инструментом планетарной обороны в случае обнаружения угрозы с малым запасом времени, дополняя такие подходы, как кинетический удар, уже испытанный NASA в миссии DART. Эксперимент также был важен по причине отсутствия надёжных моделей: в зависимости от уровня изучения объекта воздействия — от микроскопического до макроскопического — показания моделей отличались в семь раз. С такими исходными данными спасать Землю от опасного астероида — это всё равно, что сыграть в «русскую рулетку». Опыты с разными составами астероидов на установке в ЦЕРНе позволяют собрать фактуру для построения максимально точных моделей, чтобы если уж бить по астероиду, то чётко понимая последствия. Учёные NASA задумались о ядерном ударе по угрожающему Луне астероиду

25.09.2025 [12:31],

Геннадий Детинич

Успех миссии NASA DART по изменению орбиты астероида Диморф ударом космического зонда-камикадзе показал одну из возможностей защиты Земли от опасных астероидов. Один из таких космических камней внезапно появился на горизонте в декабре 2024 года. По первым данным объект 2024 YR4 размерами около 60 м имел самую высокую за время наблюдений вероятность упасть на планету, что стало наиболее серьёзной угрозой в истории и требовало пристального внимания. Учёные задумались о способах защиты.

Источник изображения: ИИ-генерация Grok 3/3DNews Последующие наблюдения за астероидом снизили вероятность его падения на Землю с 3,1 % до 0,28 %, но повысили шансы его падения на Луну — до 4,1 %. Изучение вопроса с Луной показало, что астероид 2024 YR4 способен выбить из её поверхности тысячи тонн реголита, в 1000 раз увеличив поток микрометеритов, падающих на Землю. Для обитателей планеты это не будет представлять угрозы, но спутники на орбите могут быть значительно повреждены. С учётом многотысячных группировок интернет-спутников — это серьёзная угроза, о которой надлежит задуматься уже сегодня. На сайте препринтов arXiv вышла статья за авторством инженеров NASA и ведущих специалистов аэрокосмической отрасли США. В статье авторы рассматривают готовность отразить угрозу с помощью разных методов и наличествующих инструментов — ракет и спутников. Наблюдения с помощью телескопа «Джеймс Уэбб» в марте 2025 года уточнили диаметр астероида — 60 ± 7 м — и подтвердили его классификацию как S-типа (скального). Потенциальные последствия удара объекта по Луне включают значительное увеличение потока микрометеороидов на низкой околоземной орбите — до 1000 раз выше фонового уровня в течение нескольких дней, что угрожает астронавтам, спутникам и инфраструктуре. В статье анализируются варианты миссий для разведки, отклонения и разрушения астероида, учитывающие как быстрые, так и отсроченные до 2032 года запуски, с акцентом на срочность и неопределённости в параметрах объекта. Разведывательные миссии сосредоточены на пролётах и сближениях для сбора данных о составе, структуре и траектории астероида. Возможна перепрофилировка существующих аппаратов: Janus (окна запуска в июне и декабре 2028 года для пролётов в 2028–2029 годах), OSIRIS-APEX (пролёт в октябре–ноябре 2028 года со скоростью 8–11 км/с, но с отказом от миссии с Апофисом), Psyche (сближение в декабре 2030 года или пролёт в январе 2029 года). Зонд NASA Lucy признан непригодным из-за дефицита топлива. Для новых миссий предлагаются быстрые запуски с декабря 2025 года и плановые — с января 2028 года, но не позже конца 2028 года, чтобы получить данные об астероиде за три года до предполагаемого удара. Такие миссии обеспечат ключевые параметры для последующих взвешенных действий и будут использовать химические или ионные двигатели, а также ракеты-носители вроде Falcon Heavy и различные гравитационные манёвры. Учёные сразу отметают вариант DART по отклонению астероида, поскольку данных о нём нет, а разведка и последующая подготовка не оставляют запаса времени для такого манёвра. Наиболее предпочтительными остаются прямое разрушение астероида кинетическим ударом или близким ядерным взрывом, но эти варианты необходимо тщательно просчитать, чтобы не усугубить ситуацию. Кинетические удары возможны с апреля 2030 по апрель 2032 года, с перспективой разрушения объектов до 81 м в поперечнике, что покрывает все сценарии для 2024 YR4. Ядерные устройства (до 1 Мт) можно будет применить с конца 2029 по конец 2031 года. Моделирование подтверждает эффективность при правильном выборе времени, минимизируя риск появления фрагментов на низкой орбите. Эти методы предпочтительны для поздних вмешательств, но требуют точных данных о прочности и составе астероида. В заключение, даже если вероятность удара астероида 2024 YR4 будет исключена, миссии по его разведке дадут ценную информацию для планетарной обороны. В NASA рекомендуют отдать приоритет разведке в конце 2028 года, с подготовкой к разрушению как резервному варианту. Дальнейшие наблюдения за объектом телескопом «Уэбб» в феврале 2026 года уточнят вероятность для всех сценариев развития ситуации. Xiaomi отозвала почти 150 тысяч взрывоопасных пауэрбанков

29.08.2025 [19:01],

Сергей Сурабекянц

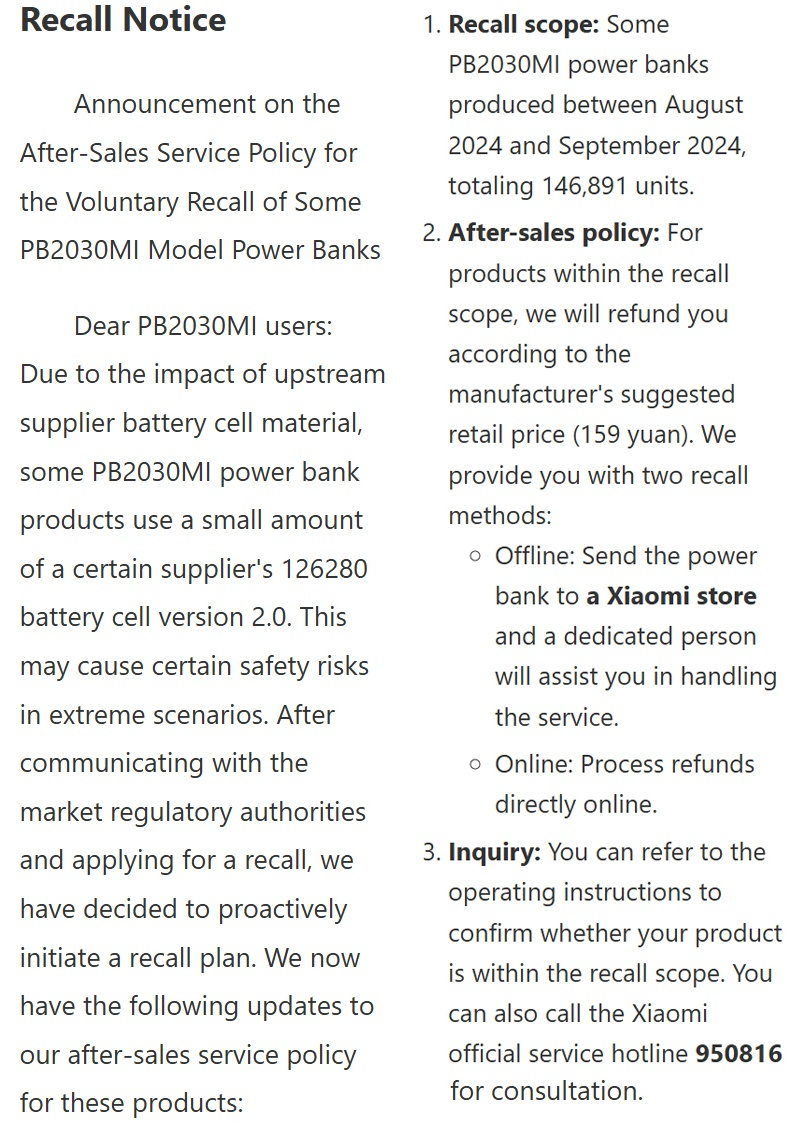

Компания Xiaomi отозвала в Китае 146 891 внешних аккумуляторов (пауэрбанков) со встроенным кабелем PB2030MI мощностью 33 Вт и ёмкостью 20 000 мА·ч. Компания сообщила, что отзыв связан с рисками для безопасности «в экстремальных ситуациях». Эта модель также продаётся по всему миру, но официального заявления компании на глобальном сайте об этом нет.

Источник изображений: Xiaomi Отзыв распространяется на внешние аккумуляторы Xiaomi PB2030MI, выпущенные в период с августа по сентябрь 2024 года, оснащённые по информации компании, «аккумулятором 126280 версии 2.0 от определённого поставщика». Эта версия аккумулятора «может представлять определённые риски для безопасности в экстремальных ситуациях», что может привести к перегреву, возгоранию и взрыву. Xiaomi сообщила, что за указанный период было произведено 146 891 портативное зарядное устройство, и все они были отозваны по соображениям безопасности. Покупатели, чьё устройство соответствует условиям отзыва, имеют право на возврат средств в размере 159 юаней.  На данный момент неясно, поставлялись ли пауэрбанки с аккумулятором 126280 версии 2.0 от указанного поставщика на международный рынок. Пользователям PB2030MI, которые не попали под отзывную компанию, рекомендуется соблюдать осторожность при использовании портативного зарядного устройства и не оставлять его заряжаться на ночь. Найден способ заражать DNS-записи вредоносным ПО

18.07.2025 [16:56],

Павел Котов

Киберпреступники придумали способ скрывать вредоносное ПО в записях системы доменных имён (DNS), что позволяет таким вирусам оставаться незамеченными для защитных средств. О проблеме рассказали эксперты службы DomainTools — они обнаружили в DNS-записях вредонос Joke Screenmate.

Источник изображения: Ed Hardie / unsplash.com Если упростить, DNS — это адресная книга интернета, которая помогает преобразовывать доменные имена в IP-адреса. DNS-записи бывают разных типов, в том числе типа TXT — они используются для хранения описательного текста. Хакеры придумали, как можно разбивать вредоносное ПО на небольшие закодированные фрагменты и помещать их в DNS-записи типа TXT для разных поддоменов. Получается своего рода цифровая головоломка, разбросанная по разным адресам. Каждая часть сама по себе безвредна, но если их собрать, образуется полноценный вредоносный файл. С помощью скриптов злоумышленники заставляют компьютер жертвы запрашивать эти DNS-записи и таким образом восстанавливать вредоносное ПО, оставаясь вне поля зрения средств безопасности. DNS-трафик обычно считается доверенным и не вызывает подозрений. Joke Screenmate — это программа, которая имитирует системные ошибки и вызывает непредсказуемое поведение курсора мыши. Что менее приятно, эксперты DomainTools обнаружили также скрытый аналогичным образом скрипт PowerShell Stager, способный загружать и выполнять более опасные вредоносные программы. Существуют и способы защититься от таких коварных атак: специалистам по безопасности рекомендуют внедрить мониторинг DNS-трафика, выявлять в нём необычные закономерности и повторяющиеся TXT-запросы. Помогут также инструменты, проверяющие DNS-записи, выходящие за рамки простых функций сопоставления имён, а также средства аналитики угроз — в том числе анализ вредоносных доменов и поддоменов. Фактических атак, основанных на этом способе, пока выявлено не было, но, учитывая его простоту и своеобразное изящество, это лишь вопрос времени. OpenAI опасается, что вскоре её модели научатся разрабатывать биологическое оружие

20.06.2025 [20:40],

Сергей Сурабекянц

OpenAI обеспокоена тем, что следующее поколение её моделей искусственного интеллекта может значительно увеличить риск разработки биологического оружия, предоставив такую возможность даже людям без научного образования. Руководитель систем безопасности OpenAI Йоханнес Хайдеке (Johannes Heidecke) ожидает, что «некоторые из преемников нашей o3 [модели рассуждений] достигнут этого уровня». В связи с этим OpenAI усиливает тестирование безопасности.

Источник изображений: unsplash.com OpenAI сообщила о разработке системы для оценки и снижения рисков, создаваемых все более мощными моделями ИИ. Компания усиливает тестирование безопасности, чтобы снизить риск использования её моделей преступниками и террористами. Без этих мер по снижению рисков модели вскоре смогут «подняться на новый уровень», что позволит даже людям с ограниченными научными знаниями создавать опасное оружие. «Мы [пока] ещё не в мире, где есть что-то новое, совершенно неизвестное, создающее биологические угрозы, которых раньше не было, — заявил Хайдеке. — Мы больше беспокоимся о воспроизведении вещей, с которыми эксперты уже хорошо знакомы». Особая сложность состоит в том, что те же инструменты, которые могли бы обеспечить жизненно важные медицинские прорывы, могут быть использованы злоумышленниками в опасных целях. Именно поэтому ведущим лабораториям ИИ нужны высокоточные системы тестирования. «Это не та область, где производительность 99 % или одна ошибка на 100 000… допустимы, — считает Хайдеке. — Нам в основном нужно, что-то вроде почти идеального». OpenAI — не единственная компания, обеспокоенная неправомерным использованием своих моделей, когда дело касается разработки оружия. По мере того, как модели становятся более совершенными, их потенциал для преступного использования растёт. Недавно компания Anthropic выпустила продвинутую модель Claude Opus 4 с более строгими протоколами безопасности, чем у любой из предыдущих моделей.  В соответствии с политикой ответственного масштабирования, созданной по образцу уровней биологической угрозы (BSL) правительства США, ей присвоен третий «уровень безопасности ИИ» (AI Safety Level) ASL-3. Все предыдущие модели Anthropic отнесены к уровню ASL-2. Третьему уровню безопасности соответствуют продвинутые модели, которые достаточно мощны, чтобы представлять значительные риски, такие как помощь в разработке оружия или автоматизация разработки систем ИИ. Недавно Claude Opus 4 попала в заголовки СМИ после попытки шантажировать инженера, чтобы избежать отключения в ходе строго контролируемого теста. Ранние версии этой модели были готовы выполнять опасные инструкции, например, планирование террористических атак. Компания заверила общественность, что эта проблема была решена внесением изменений в набор обучающих данных. ИИ стал экзистенциальной угрозой для интернет-СМИ: посетителей на сайтах вытесняют роботы

20.06.2025 [11:37],

Сергей Сурабекянц

Глава Cloudflare Мэтью Принс (Matthew Prince) в интервью изданию Axios заявил, что издатели сталкиваются с экзистенциальной угрозой со стороны ИИ и должны получать справедливую компенсацию за свой контент. «Люди стали больше доверять ИИ за последние шесть месяцев, что означает, что они не читают оригинальный контент, — сказал он. — Будущее интернета будет всё больше и больше похоже на ИИ, значит люди [и дальше] будут читать резюме вашего контента».

Источник изображения: Walls.io / unsplash.com Число переходов со страниц поисковых систем на сайты с оригинальным контентом сокращается с каждым днём, поэтому многим издателям придётся пересмотреть свои бизнес-модели или вообще уйти с рынка. Принс привёл впечатляющие статистические данные. По его словам, десять лет назад соотношение проиндексированных поисковиком Google страниц к числу посетителей, перенаправленных со страницы поисковой выдачи на сайт издателя, составляло 2:1. С тех пор это соотношение постепенно увеличивалось, но после начала ИИ-бума стало расти угрожающими темпами. Шесть месяцев назад:

В настоящий момент:

Поисковые системы и чат-боты ИИ предоставляют ссылки на оригинальные источники, но издатели могут получать доход от рекламы только в том случае, если читатели переходят по ссылкам. «Люди не переходят по ссылкам», — констатировал Принс. Он уверен, что эта проблема касается любого создателя оригинального контента. Принс сообщил, что Cloudflare разработала инструмент, который должен «остановить копирование контента». AI Labyrinth использует контент, сгенерированный ИИ, для замедления, запутывания и траты ресурсов ИИ-сканеров и других ботов, которые не соблюдают директивы веб-серверов. Своим клиентам Cloudflare предлагает автоматическое развёртывание такого набора сгенерированных ИИ страниц при обнаружении «ненадлежащей активности» ботов. NASA повысило вероятность столкновения астероида 2024 YR4 с Луной через 7 лет

06.06.2025 [21:20],

Геннадий Детинич

Обнаруженный под самый конец 2024 года астероид 2024 YR4 стал самой большой угрозой Земле за время наблюдения за астероидной опасностью. Его засекли на уходящей от Земли траектории, так что данные об орбите и самом объекте были неполными. Постепенно учёные собрали больше данных для расчёта орбиты 2024 YR4. По мере уточнения параметров астероид был признан неопасным для Земли, но зато появилась вероятность его столкновения с Луной. И теперь эта угроза выросла.

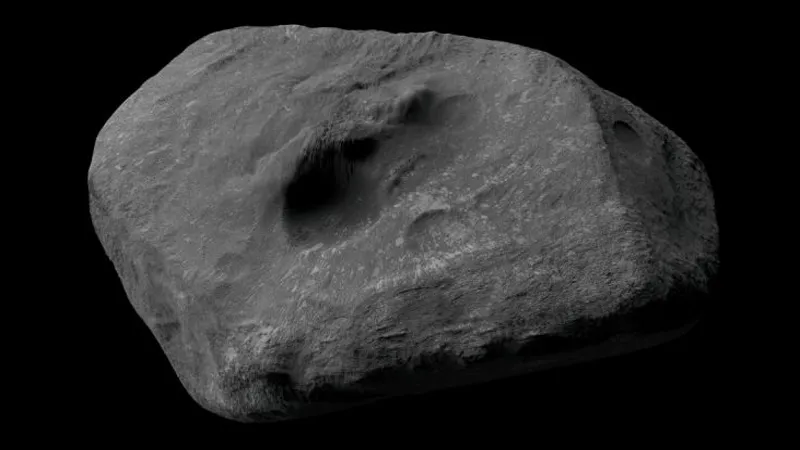

Художественное представление астероида 2024 YR4. Источник изображения: W. M. Keck Observatory/Adam Makarenko В мае NASA с помощью космического телескопа «Джеймс Уэбб» в последний раз наблюдало астероид 2024 YR4, пока он окончательно не скрылся из виду в пространстве. Новый пакет данных на 20 % повысил точность расчёта его вероятной орбиты вокруг Солнца. Тем самым появилась возможность заново оценить вероятность столкновения объекта с Луной, когда он максимально сблизится с ней и Землёй 22 декабря 2032 года. Предыдущая оценка предполагала вероятность падения 2024 YR4 на Луну на уровне 3,8 %. После майских наблюдений NASA повысило эту вероятность до 4,8 %. Достоверность расчётов, напомним, также повышена на 20 %. Это всё ещё небольшой шанс для астероида столкнуться с естественным спутником Земли.

Жёлтыми точками показано вероятное положение астероида 22 декабря 2032 года (более короткая полоса представляет последние данные наблюдений). Источник изображения: NASA Падение такого небесного тела на Луну, а 2024 YR4 в поперечнике не превышает 70 метров, не изменит её орбиту и не несёт угрозу Земле. Но если столкновение произойдёт, то учёным это даст шанс провести сейсмическое зондирование Луны за счёт самой природы. Можно ожидать, что если вероятность встречи 2024 YR4 с Луной будет более-менее высокой, на Луну отправят станцию с сейсмическими датчиками. Данные по орбите объекта можно будет установить с максимальной точностью в его следующий проход рядом с Землёй, который ожидается в 2028 году. В NASA резко повысили вероятность столкновения астероида 2024 YR4 с Землёй, но после передумали

20.02.2025 [13:39],

Геннадий Детинич

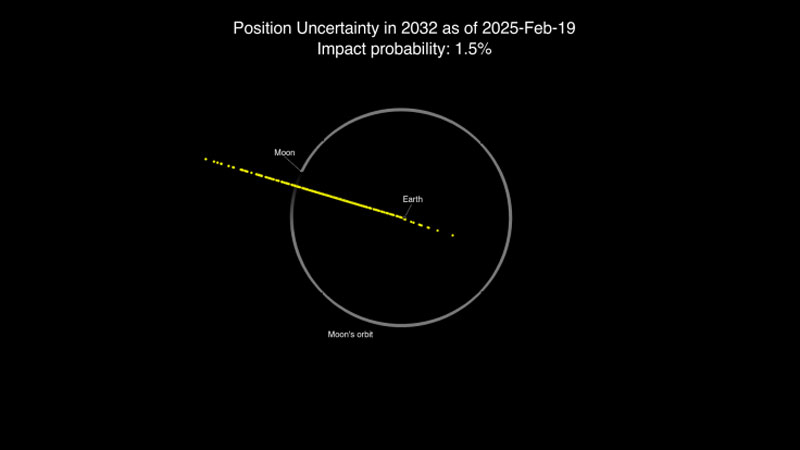

До последних дней Луна в небе над США мешала местным обсерваториям проводить наблюдения за слабыми околоземными объектами. Между тем в небесах сейчас движется объект повышенной опасности для планеты — астероид 2024 YR4, у которого есть определённый шанс столкнуться с Землёй 22 декабря 2032 года. Дополнительные наблюдения учёных NASA сначала повысили эту вероятность с 2,2 % до 3,1 %, но сутки спустя астрономы пошли на попятную.

Источник изображения: ИИ-генерация DALL·E/3DNews Отсутствие Луны на небе позволило собрать более точные данные о траектории астероида 2024 YR4. Сейчас он удаляется от планеты в своём движении по орбите вокруг Солнца, но вернётся к Земле в 2028 году и, затем, опасно сблизится с ней 22 декабря 2032 года.

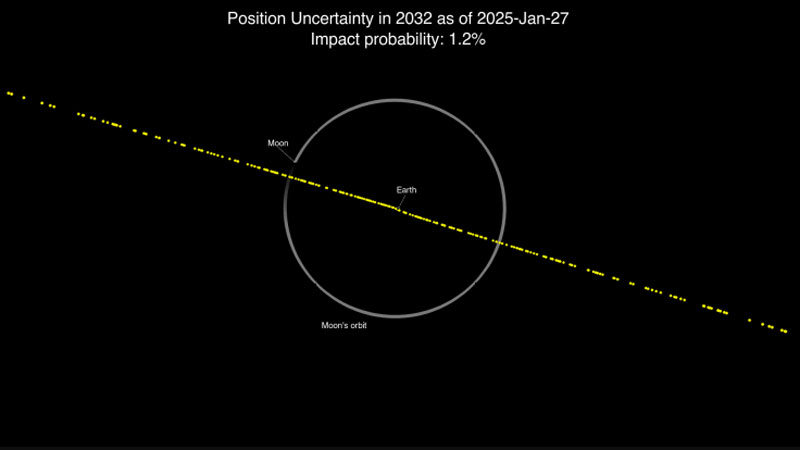

Земля, орбита Луны и жёлтые точки орбиты астероида 2024 YR4. Источник изображений: NASA Астероид 2024 YR4 был открыт в канун Нового года чилийским филиалом роботизированной системы предупреждения об астероидной опасности (ATLAS). По оценкам на 27 января 2025 года шанс его столкновения с Землёй составлял 1,2 %. После эта вероятность была повышена до 2,2 %, а на днях, 18 февраля 2025 года, и вовсе до пугающих 3,1 %. К счастью, сутки спустя поступили новые данные, и вероятность столкновения была понижена до 1,5 %.  Оценка по данным наблюдений 19 февраля 2025 года Размеры и состав астероида, а также его точная орбита будут уточняться по мере новых наблюдений, особенно во время следующего пролёта рядом с Землёй в 2028 году. В настоящее время считается, что это небесное тело имеет размеры от 40 до 90 м в поперечнике. В худшем случае, если объект окажется 90-метровым и с железной сердцевиной, его падение может привести к разрушениям на площади диаметром до 100 км. Предполагаемая зона падения — район экватора от Индии до Южной Америки. Meta✴ пообещала отменить выпуск моделей ИИ, которые сочтёт слишком опасными для человечества

04.02.2025 [17:24],

Павел Котов

Ранее гендиректор Meta✴✴ Марк Цукерберг (Mark Zuckerberg) пообещал, что сделает сильный искусственный интеллект (AGI), то есть не уступающий человеку, общедоступным. Но теперь в одном из определяющих политику документов компании перечисляются сценарии, при которых она может отменить выпуск передовой системы ИИ.

Источник изображения: Christopher Burns / unsplash.com В документе под названием «Основы организации передового ИИ» (Frontier AI Framework) компанией Meta✴✴ определяются два типа систем ИИ, которые представляются слишком рискованными для выпуска: системы «высокого риска» и «критического риска». Это системы, способные оказать гипотетическим злоумышленникам помощь в преодолении средств кибербезопасности, проведении химических и биологических атак. Разница в том, что системы «критического риска» способны привести к «катастрофическому результату, который невозможно смягчить в контексте развёртывания»; системы «высокого риска» также способны облегчить злоумышленникам провести атаку, но они менее надёжны, чем системы «критического риска». Meta✴✴ приводит несколько гипотетических примеров таких атак, в том числе «полная автоматизированная компрометация окружения корпоративного масштаба, защищённого передовыми методами» и «разрастание высокоэффективного биологического оружия». Список приведённых в документе угроз не является исчерпывающим, отмечают в компании, — он включает лишь те позиции, которые считаются самыми неотложными и вероятными как результат непосредственной работы мощного ИИ. Системные угрозы классифицируются не на основе практических опытов, а с учётом данных внутренних и внешних исследований, утверждённых лицами, принимающими решения: в Meta✴✴ не уверены, что научные средства «достаточно надёжны, чтобы предоставить окончательные количественные показатели», определяющие степень угрозы, которую представляет система. Если Meta✴✴ решит, что одна из систем относится к категории «высокого риска», доступ к такой системе внутри компании будет ограничен, а её выпуск — отложен до тех пор, пока не будут приняты меры по смягчению последствий «до умеренного уровня». Если же риск классифицируется как «критический», Meta✴✴ обязывается развернуть меры безопасности, перечислять которые она не стала, и прекратить разработку до тех пор, пока система не станет менее опасной. Компания намеревается вносить изменения в документ по мере развития отрасли ИИ, а опубликован он будет перед мероприятием France AI Action Summit, которое пройдёт в этом месяце. Meta✴✴ в отличие от других американских технологических гигантов открывает исходный код своих моделей ИИ Llama. Созданием этого документа компания, возможно, пытается противопоставить себя китайской DeepSeek, которая также опубликует свои модели открыто, но пока не говорит о защитных мерах. Открыт самый опасный для Земли астероид — он едва разминётся с планетой в декабре 2032 года

29.01.2025 [13:02],

Геннадий Детинич

Роботизированная система планетарной обороны обнаружила астероид 2024 YR4, который опасно сблизится с Землёй в декабре 2032 года. В списках ESA и NASA самых опасных околоземных небесных тел объект 2024 YR4 шириной до 60 метров вышел на первое место по степени угрозы. Это ещё не означает, что он обязательно столкнётся с планетой, но шансы на такой исход превысили 1 %, а это уже не шутка.

Источник изображения: ИИ-генерация Кандинский 3.1/3DNews Сближение 2024 YR4 с Землёй прогнозируется 22 декабря 2032 года. В этот день объект приблизится к планете на расстояние 106 200 км — это более чем в три раза ближе, чем расстояние до Луны. Допускаемая в расчётах погрешность такова, что астероид имеет некоторый шанс столкнуться с планетой. В настоящий момент астероид удаляется от Земли, и уточнить его размеры и состав не представляется возможным. Оценка сделана по яркости объекта и может быть ошибочной. Астероид 2024 YR4 может быть как больше 60 метров, так и меньше. Более точно определить характеристики объекта можно будет в 2028 году, когда он приблизится к Земле на 8 млн км. В таком случае можно будет задействовать радары и выяснить состав и точные размеры 2024 YR4. Если астероид каменистый, то он взорвётся в атмосфере, создав разрушения, сравнимые с падением Тунгусского метеорита. Если он железный, то долетит до поверхности Земли и оставит после себя ударный кратер. Пока вероятное падение прогнозируется ближе к экватору, хотя все нынешние прогнозы довольно приблизительные. «Шансы немного возросли до 1 к 83, — сообщил один из сотрудников службы Catalina Sky Survey. — Это одна из самых высоких вероятностей столкновения с камнем значительных размеров за всю историю». Астероиду 2024 YR4 присвоено 3 балла по Туринской шкале. Это жёлтый уровень опасности. От перехода в оранжевую зону его отделяет один балл по 10-бальной шкале. Вероятность его падения на Землю всё ещё ничтожна, поэтому опасаться, в общем-то, нечего. Внимательными должны оставаться астрономы, которые более пристально начнут следить за 2024 YR4. Ядерный взрыв может защитить Землю от «астероида судного дня», доказал новый эксперимент

24.09.2024 [13:30],

Геннадий Детинич

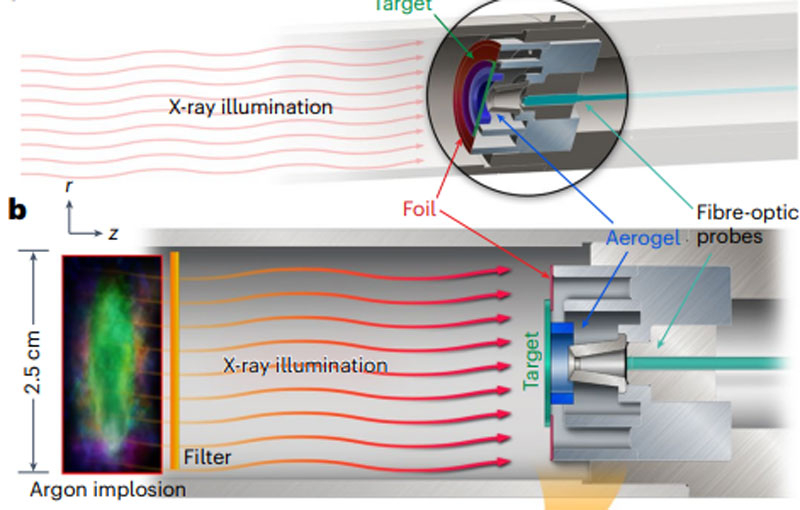

Учёные из США провели эксперимент, который доказал возможность изменения траектории опасного для Земли астероида с помощью ядерного взрыва. Исследователи не собираются взрывать сам астероид, оставляя зрелищность разлёта обломков киношникам. На астероид должно влиять мощное ионизирующее излучение близкого ядерного взрыва, испаряющее его поверхность и создающее точно рассчитанный вектор тяги.

Источник изображения: Nature Physics, 2024 Эксперимент был поставлен в Сандийских национальных лабораториях в США (Sandia National Laboratories). Для этого группа учёных под руководством физика Натана Мура (Nathan Moore) воспользовалась мощной рентгеновской установкой лаборатории — так называемой Z-машиной. Исследователи направили рентгеновские импульсы на мишени, играющие роль астероидов из кварца и плавленого кварца. В астероидах обычно много силикатов, поэтому мишени в среднем соответствовали составу большинства астероидов. Мишень диаметром 12 мм была закреплена на установке металлической фольгой. Излучение испаряло фольгу, отчего модель астероида как бы зависала в свободном пространстве и подвергалась удару лишь рентгеновским лучом. Газ от распылённой фольги отводился от мишени, чтобы не вносить вклад в импульс от воздействия излучения на мишень. Для учёных важна была динамика не только прямого воздействия, но также относительно длительное воздействие в процессе расширения испаряемого с поверхности мишени вещества (ионизированного газа или плазмы). Поскольку выстрел и процесс длились доли секунды, свободным падением мишени после испарения фольги можно было пренебречь. Измерения показали, что мишени из кварца после выстрела рентгеном общей интенсивностью 1,5 МДж приобретали скорость 69,6 м/с, а мишени из плавленого кварца — 70,3 м/с, что с высокой точностью соответствует теоретическим расчётам на цифровой модели. Масштабирование до астероидов размерами от 3 до 5 км обещает, что близкий взрыв ядерной бомбы рядом с астероидом придаст ему скорость более 10 см/с в нужном направлении, что гарантированно отклонит его траекторию. Подобные астероиды могут падать на Землю один раз в 250–500 млн лет. Это очень маленькая, но ненулевая вероятность уничтожения земной цивилизации, что заставляет заранее искать пути воздействия на опасные для нашей планеты астероиды. Пока учёные вместе с NASA провели лишь один натурный эксперимент по изменению траектории астероида ударным воздействием. Зонд-камикадзе DART ударил в астероид Диморф, заставив его изменить орбитальное движение вокруг его центральной пары — астероида Дидим. В целом ударное воздействие на опасный астероид рискованно само по себе, поскольку может превратить один опасный астероид в рой не менее опасных и плохо отслеживаемых камней. Точно так же прямой удар атомной бомбой по астероиду — это риск того же плана. Воздействие на астероид мощным ионизирующим излучением, которое будет создавать тягу из испаряемого вещества его поверхности — это более предсказуемый по последствиям способ заставить небесное тело изменить орбиту. Лабораторный эксперимент доказал осуществимость такого метода. Но вряд ли дело дойдёт до экспериментов. Пока международными соглашениями ядерное оружие запрещено выводить в космос в любом виде. Учёные не нашли причин опасаться столкновения Земли с астероидом Апофис

06.03.2024 [12:11],

Геннадий Детинич

Астероид Апофис (Apophis, номер 99942), представляющий потенциальную угрозу жизни на Земле, в 2021 году был на ближайшие 100 лет исключён из списка угроз из космоса. Тщательное изучение объекта в течение почти 20 лет с момента обнаружения позволило максимально точно рассчитать его орбиту, которая даже с учётом погрешностей не пересекалась с Землёй. Но совсем угроза не исчезла. Столкновение с другим астероидом способно сбить Апофис с безопасной траектории.

Источник изображения: ИИ-генерация Кандинский 3.0/3DNews Миссия NASA DART по ударному изменению траектории астероидов с помощью зондов-камикадзе наглядно показала, что астероид способен менять траекторию при столкновении с другим небесным телом. Даже таким небольшим, как 570-кг зонд DART. Если в 340-метровый Апофис массой 61 млн тонн влетит объект подобной ему массы, их траектории, очевидно, изменятся очень и очень сильно. Под впечатлением миссии DART группа астрономов решила изучить вероятность столкновения с Апофисом любого из других известных астероидов в пространстве его пролёта. В эту область попадает свыше 1,3 млн известных астероидов. Все эти объекты были внесены в модель и изучены с учётом всех погрешностей на предмет вероятного столкновения с Апофисом.

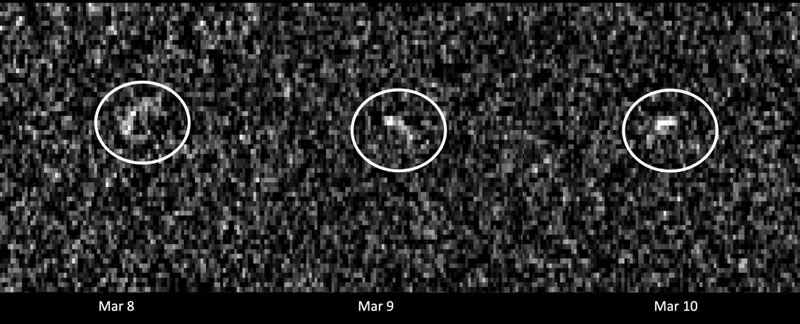

Радарные изображения Апофиса при пролёте рядом с Землёй в 2021 году. Источник изображения: NASA/JPL-Caltech and NSF/AUI/GBO «Учитывая, насколько близко Апофис пройдет мимо Земли, существует возможный риск того, что отклонение от его текущей траектории может привести Апофис к столкновению с нами, — поясняют авторы работы, опубликованной в журнале Planetary Science. — Гипотетически, столкновение другого астероида с Апофисом может вызвать такое отклонение, что побудило нас изучить этот сценарий, каким бы маловероятным он ни был». Расчёты показали, что астероиду Апофис никакие столкновения не угрожают, а значит, его орбита останется в рамках индивидуальных для него расчётов и будет неопасна для Земли. Остаётся угроза со стороны ещё неоткрытых астероидов. Но с этим человечество ничего поделать не может. Остаётся только готовиться по мере сил и создавать новые слои планетарной защиты. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |