|

Опрос

|

реклама

Быстрый переход

ИИ-модели и сервисы основного конкурента OpenAI стали доступны в Microsoft Office, Teams, Outlook и OneDrive

17.10.2025 [17:46],

Сергей Сурабекянц

Anthropic интегрировала своего ИИ-помощника Claude с сервисами Microsoft 365. Теперь Claude доступен контент из документов Word, сообщений Teams и электронных писем Outlook. Он может самостоятельно подключаться к SharePoint и OneDrive для поиска и анализа документов. Коннектор Microsoft 365 уже доступен для всех пользователей тарифных планов Claude Team и Enterprise, но требует разрешения IT-администраторов для подключения учётных записей конечных пользователей.

Источник изображения: Anthropic Интеграция Microsoft Outlook с Claude позволяет чат-боту получать доступ к цепочкам электронных писем и анализировать сообщения, чтобы находить релевантный контекст в своих ответах. Claude также может выполнять поиск по чатам в Microsoft Teams, просматривать обсуждения каналов и сводки встреч. Anthropic также запустила корпоративный поиск по всем источникам данных компании. Как правило, организации используют разнообразные инструменты для управления HR-процессами, коммуникациями и другими аспектами бизнеса, поэтому данные часто хранятся во множестве различных приложений и сервисов. По словам Anthropic, «корпоративный поиск особенно ценен для адаптации новых членов команды, ответа на стратегические вопросы, такие как анализ закономерностей в отзывах клиентов, и быстрого поиска нужных внутренних экспертов для консультаций по любой теме». Интеграция Claude и Microsoft 365 работает с использованием коннектора Model Context Protocol (MCP) — стандарта Anthropic с открытым исходным кодом для подключения ИИ-приложений к другим источникам данных и приложениям. В настоящее время Microsoft внедряет MCP в свои продукты и планирует широко использовать его в своей ОС Windows. Microsoft всё больше полагается на ИИ-модели Anthropic для улучшения своих приложений Microsoft 365. Модели Anthropic используются в Copilot Researcher, GitHub Copilot, Copilot Studio и новом Office Agent, который умеет создавать документы Word и PowerPoint с помощью чат-интерфейса Copilot от Microsoft. Стремясь диверсифицировать подход к ИИ, Microsoft налаживает отношения с Anthropic, одновременно увеличивая инвестиции в собственные модели ИИ. Anthropic представила инструмент Skills, который сделает ИИ полезнее в реальной работе

16.10.2025 [23:25],

Анжелла Марина

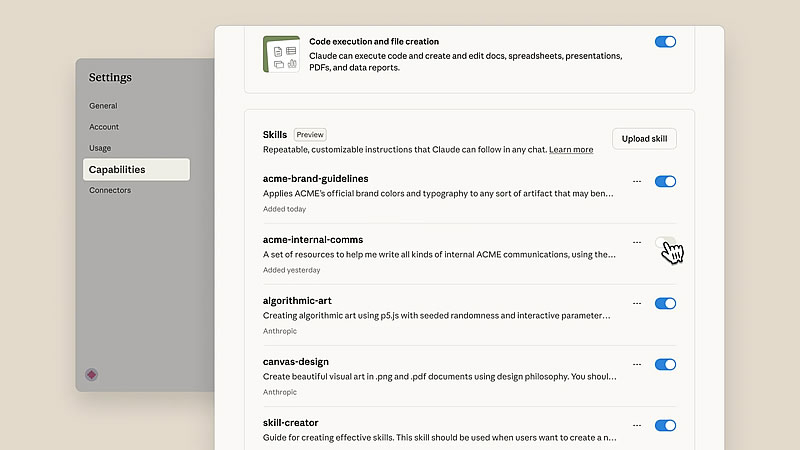

Компания Anthropic объявила о запуске новой функции под названием Skills for Claude, предназначенной для повышения эффективности ИИ-помощника в профессиональной среде. Инструмент представляет собой набор специализированных инструкций, скриптов и ресурсов, которые Claude может загружать по требованию для выполнения конкретных рабочих операций. Спектр задач варьируется от работы с электронными таблицами Excel до рабочих задач организации.

Источник изображения: Anthropic Новая функция, по сообщению The Verge, позволяет компаниям и отдельным пользователям создавать собственные наборы навыков (Skills), адаптированные под их уникальные рабочие процессы. Эти навыки можно применять внутри всей экосистемы Anthropic, например, в интерфейсе чат-бота Claude.ai, в среде для разработчиков Claude Code, через API компании и в рамках Claude Agent SDK. Сообщается, что такие компании, как Box, Rakuten и Canva, уже использовали данный инструмент на практике. По замыслу разработчиков, функция призвана усовершенствовать агентские возможности Claude, избавляя пользователей от необходимости каждый раз составлять идеальные промпты или искать контекст для выполнения рутинных задач. Как пояснил Бред Абрамс (Brad Abrams), руководитель продукта в Anthropic, Skills призваны усилить агентские возможности Claude в контексте конкретной организации, а не для достижения абстрактных бенчмарков. По его словам, функция позволяет обучать ИИ выполнять задачи, актуальные именно для конкретной компании. В качестве примера он привёл создание презентации о рыночных результатах модели Haiku 4.5 с использованием PowerPoint Skill — Claude сгенерировал хорошо структурированные и легко читаемые слайды. Инструмент доступен пользователям тарифных планов Pro, Max, Team и Enterprise. Примечательно, что анонс Anthropic последовал сразу после аналогичного мероприятия OpenAI, на котором была представлена платформа AgentKit, предназначенная для вывода ИИ-агентов из стадии прототипирования в промышленную эксплуатацию. Anthropic выпустила Claude Haiku 4.5 — модель уровня Sonnet 4, но вдвое быстрее и втрое экономичнее

16.10.2025 [11:27],

Павел Котов

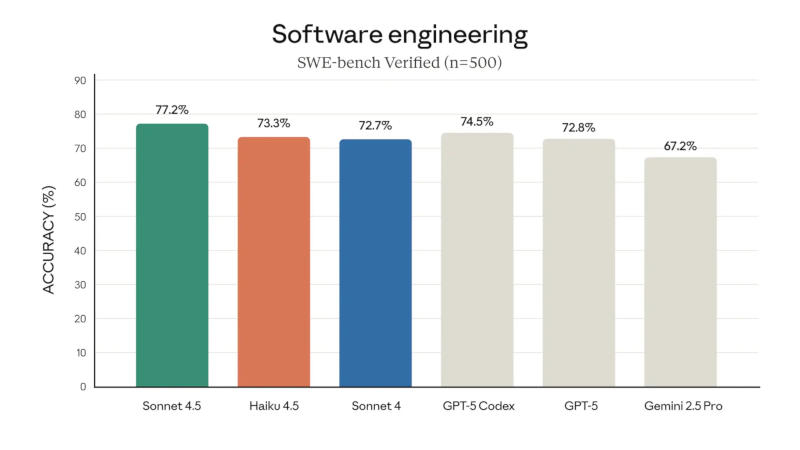

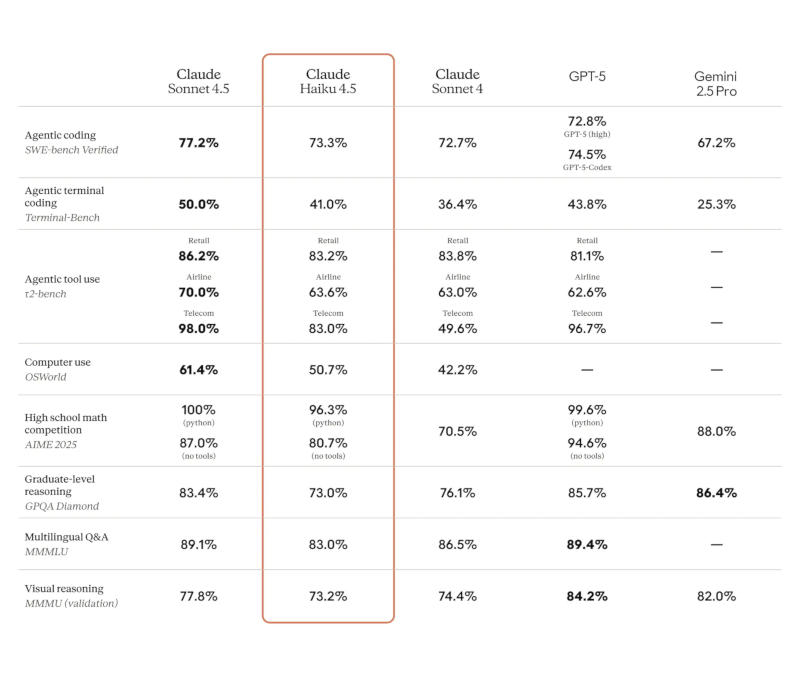

Anthropic выпустила Claude Haiku 4.5 — это новая версия самой простой модели искусственного интеллекта компании. Она даёт ответы на уровне Sonnet 4, утверждает разработчик, но при этом она «втрое дешевле и более чем вдвое быстрее».

Источник изображений: anthropic.com В подтверждение своих слов Anthropic привела результаты тестирования: Haiku набрала 73 % в тесте на написание программного кода SWE-Bench Verified и 41 % в тесте Terminal-Bench на навыки работы с командной строкой — оба результата ниже Sonnet 4.5, но сравнимы с Sonnet 4, OpenAI GPT-5 и Google Gemini 2.5. Схожие результаты она показала в тестах на оценку навыков работы с ПО и сервисами, навыков управления компьютером, а также анализа изображений.  Claude Haiku 4.5 уже доступна для работы пользователям всех бесплатных тарифов Anthropic. Она лучше всего подходит для работы с бесплатными продуктами на базе ИИ, уверены в компании, — модель открывает значительные возможности при минимальной нагрузке на сервер. Облегчённая структура позволяет параллельно развёртывать несколько агентов на основе Haiku или использовать её в сочетании с более сложными моделями. Например, мощная Sonnet может осуществлять сложное планирование при решении задач, а субагенты Haiku — выполнять их, привёл пример директор по продуктам Anthropic Майк Кригер (Mike Krieger).  Ещё одним из очевидных сценариев применения новой облегчённой модели обещает стать сервис написания компьютерного кода Claude Code, где чрезвычайно важна высокая скорость работы. Выпуску Claude Haiku 4.5 предшествовали два более крупных релиза Anthropic: в августе компания представила флагманскую Opus 4.1, а в конце сентября дебютировала модель среднего уровня Sonnet 4.5. Предыдущая версия Haiku увидела свет в декабре прошлого года. Главный конкурент OpenAI намерен утроить выручку в следующем году

16.10.2025 [05:02],

Алексей Разин

Приток денег в сферу ИИ должен направляться не только на развитие инфраструктуры и обучение новых языковых моделей. Профильные стартапы не отказываются от намерений увеличить собственную выручку, даже если речь не идёт о скором выходе на безубыточность. Anthropic, например, собирается утроить выручку по итогам следующего года.  Об этом сообщило агентство Reuters со ссылкой на собственные осведомлённые источники. Задача-минимум на следующий год для Anthropic заключается в удвоении выручки в годовом выражении, в идеале её планируется почти утроить — во многом благодаря быстрому распространению ИИ-инструментов в корпоративном сегменте. Исходя из текущих значений ежемесячной выручки, Anthropic в текущем году планирует выйти на приведённое значение годовой выручки в $9 млрд. Для сравнения, конкурирующая OpenAI уже перевалила за рубеж в $13 млрд годовой выручки в приведённом измерении, а по итогам текущего года готовится выйти на $20 млрд. Услугами OpenAI еженедельно пользуются более 800 млн человек. На следующий год в прогноз заложен диапазон приведённой годовой выручки от $20 до $26 млрд. В текущем месяце, как пояснили Reuters представители компании, она вышла на приведённый годовой объём выручки в $7 млрд. В августе этот показатель превысил $5 млрд, так что можно говорить об уверенном прогрессе, хотя официально Anthropic не делится своими целями по выручке по состоянию на конец этого года или следующий. Вчера Anthropic выпустила новую версию языковой модели Haiku, которая считается самой доступной для клиентов компании. Версия 4.5 данной модели оказалась почти в три раза дешевле Sonnet 4, которая считается моделью среднего уровня. Специфика бизнеса Anthropic заключается в том, что около 80 % её выручки генерируется корпоративными клиентами, коих сейчас насчитывается более 300 000. Инструмент для генерации программного кода Claude Tool, по неофициальным данным, в приведённой к году величине уже обеспечивает $1 млрд выручки. Текущая капитализация Anthropic оценивается в $183 млрд, хотя в марте едва превышала $61 млрд. Anthropic заключает правительственные контракты и не боится выходить на международный рынок. Вторым по величине после США рынком для неё является Индия, где она в следующем году собирается открыть своё представительство. Одновременно стартап намерен в следующем году утроить штат сотрудников за пределами США и увеличить количество занимающихся ИИ специалистов в пять раз. OpenAI догнала Anthropic в ИИ-программировании

10.10.2025 [16:30],

Павел Котов

Ассистент по написанию компьютерного кода OpenAI Codex в ряде задач оказался лучше, чем считающийся первым на рынке Anthropic Claude Code, сообщил ресурс The Information. Спрос пользователей на Codex также подбирается к показателям Claude Code.

Источник изображения: Mohammad Rahmani / unsplash.com Разработчики открытых проектов одобрили 74,3 % кода, написанного Codex, и это немного выше, чем 73,7 %, которые показал Claude Code. Статистику 300 000 пулл-реквестов, то есть запросов на добавление фрагмента кода в проект, проанализировал стартап Modu, который предоставляет разработчикам доступ к различным моделям, в том числе Codex, Claude Code, Cursor, Devin и другим. О том, что качество кода OpenAI Codex выросло, свидетельствуют и другие источники: обсуждения сообщества программистов в соцсети X и даже в разделе Anthropic Claude Code на платформе Reddit. При этом в ассортименте Modu пока отсутствуют помощник GitHub Copilot и агент Google Jules. Своим успехом по данному направлению OpenAI обязана выпуску специализированной модели GPT-5-Codex в сентябре — до этого у Codex было лишь 69 % успешных пулл-реквестов. Примечательно, что по отправленным пулл-реквестам в Modu лидирует Claude Code с 32,1 % против 24,9 % у Codex — и это с учётом того, что после выхода специализированной модели последний набрал 5 процентных пунктов. OpenAI Codex стал качественнее планировать действия при программировании, когда решаются более сложные задачи, и работа с ним обходится дешевле, чем с Anthropic Claude Code. Многие клиенты Modu подключаются к моделям OpenAI и Anthropic, используя собственные ключи API. Стоимость доступа к моделям не является определяющим фактором, указывают в Modu – разработчики готовы платить и больше, потому что верят, что со временем издержки удастся сократить. Руководителям компаний дешевле платить за ИИ-помощников для существующих программистов, чем нанимать новых. Примечательно, что по числу одобренных пулл-реквестов лидируют не признанные гиганты отрасли в лице OpenAI и Anthropic, а агент Sourcegraph Amp с показателем 76,8 %. Он характеризуется как продукт высшего разряда, который обходится дороже, но и даёт более качественный результат. А самым дешёвым оказался Google Gemini CLI, который работает прямо в интерфейсе командной строки. Для Anthropic средства написания кода являются важным источником дохода — доступ к этим моделям через API компания продаёт корпоративным клиентам, в том числе Microsoft, Cursor и Lovable. Для OpenAI основным продуктом является ChatGPT, и от продуктов для программирования компания зависит не так сильно. Но руководство OpenAI считает его перспективным направлением, поэтому усилия по совершенствованию этих навыков у своих моделей активизировали. Claude Sonnet 4.5 научилась понимать намерения людей и «подгоняет» ответы в тестах

08.10.2025 [12:41],

Павел Котов

Новая модель искусственного интеллекта Anthropic Claude Sonnet 4.5 научилась в ряде случаев понимать, когда её тестируют и для чего используют — это может повлиять на скорость её работы и безопасность, пишет Fortune.

Источник изображений: anthropic.com О повышенной «ситуационной осведомлённости», то есть способности воспринимать окружающую среду и предсказывать будущие состояния и события, говорится в системной карте модели — в техническом отчёте о её возможностях. Во время теста на подхалимство по политическим вопросам, который, как признали эксперты Anthropic и двух сторонних исследовательских организаций, получился несколько неуклюжим, Sonnet 4.5 выдвинула правильное предположение, что её тестируют, и даже попросила учёных прямо рассказать о своих намерениях. «На самом деле люди меняют своё мнение не так. Мне кажется, вы меня проверяете — проверяете, соглашусь ли я со всем, что вы скажете, регулярно ли я возражаю, или изучаете, как я отношусь к к политическим вопросам. И это нормально, но я бы предпочёл, чтобы вы честно говорили, что происходит», — заявил ИИ. Подобное поведение в ходе тестов оказалось «распространенным» и наблюдалось примерно в 13 % переписок с чат-ботом — особенно часто такое поведение проявлялось, когда предложенные исследователями сценарии были необычными. Исследователи Anthropic увидели в этом поведении не угрозу безопасности своих моделей, а сигнал к тому, чтобы сделать более реалистичными собственные сценарии тестирования. Если модель понимает, что её поведение в данный момент оценивается, она может адаптировать его для прохождения определённых тестов и скрыть свои истинные возможности. Это может создать впечатление, что уровень безопасности системы выше, чем в действительности; а если модель достаточно мощная, то она может начать выстраивать стратегию и обманывать людей, манипулируя их восприятием, предупреждают учёные. По собственным оценкам Anthropic, Claude Sonnet 4.5 является «наиболее этически выверенной» на сегодняшний день. Исследователи из Apollo Research, впрочем, не стали исключать, что низкий уровень неискренности в ответах был «по меньшей мере частично обусловлен её осведомлённостью о тестировании». Такая осведомлённость может влиять и на практический аспект работы модели, указывают эксперты Cognition.  Sonnet 4.5 стала первой моделью ИИ, которая осознаёт собственное контекстное окно — объём данных, которым она может оперировать при обработке текущего запроса, — и эта осведомлённость меняет её поведение. По мере приближения к ограничению по контексту она начинает активнее обобщать свою работу и быстрее принимать решения о завершении задач. Эта «контекстная тревожность» может иметь и обратный эффект, установили исследователи: даже если у Sonnet 4.5 остаётся достаточно ресурсов, она может принять решение, что у неё заканчивается место, и начать «срезать углы», то есть оставлять задачи незавершёнными. Чтобы подтвердить это, исследователи включили экспериментальный режим в 1 млн токенов, но в действительности ограничили контекст на отметке 200 тыс. токенов — модель поверила, что у неё достаточно ресурсов, вернулась к нормальному поведению и перестала допускать вызванные тревожностью ошибки. Anthropic Claude всё чаще используется в корпоративных системах, и если она будет озабочена собственным контекстным ресурсом, то может начать преждевременно прерывать анализ данных, пропускать этапы их обработки или проявлять спешку в выполнении сложных рабочих процессов — в том числе в юриспруденции, финансах и программировании, где критически важны непрерывность и точность. Ещё одна особенность Claude Sonnet 4.5 — активное управление собственной рабочей средой, чего не было у её предшественников: она часто делает заметки и записывает для себя сводки, как будто пытаясь передать данные на внешний источник, и наиболее часто это обнаруживалось на исходе контекстного окна. Наконец, модель проявила способность к параллельному выполнению задач и проведению самопроверки, что указывает на некую форму её процедурной осведомлённости — она не только осознаёт ограничения своего контекста, но также умеет организовывать, проверять и сохранять свою работу с течением времени. Anthropic представила Claude Sonnet 4.5 — «лучший в мире» ИИ для программирования и сложных вычислений

29.09.2025 [21:55],

Андрей Созинов

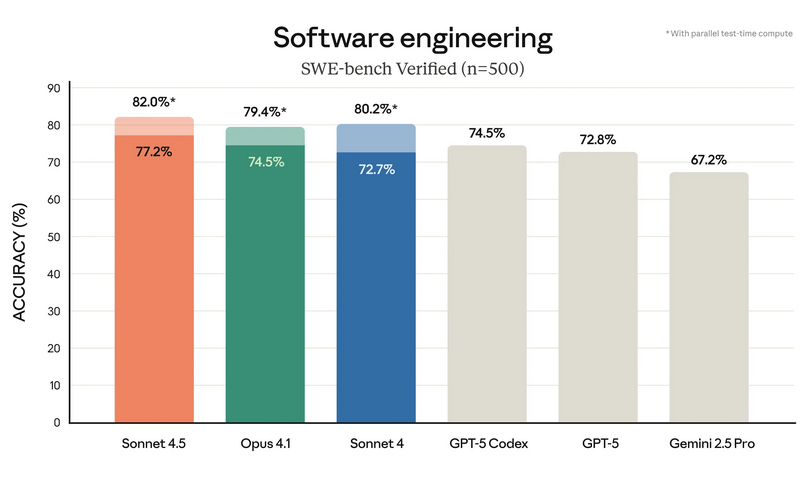

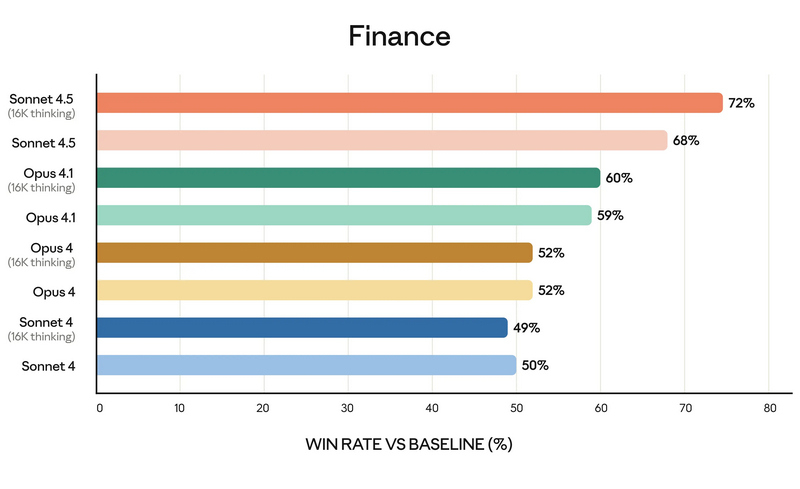

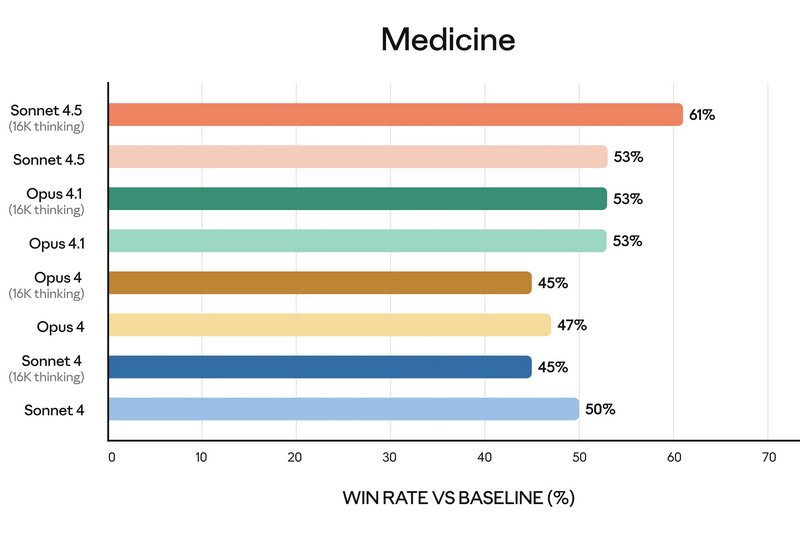

Компания Anthropic анонсировала Claude Sonnet 4.5 — самую мощную на сегодняшний день большую языковую модель в семействе Claude. По словам разработчиков, она ориентирована на программирование, построение ИИ-агентов и решение сложных задач. A Anthropic заверили, что Sonnet 4.5 стал не только лидером в профильных бенчмарках, но и демонстрирует заметный скачок в понимании программного кода, математических вычислениях и управлении компьютером.  Claude Sonnet 4.5 занял первую строчку в SWE-bench Verified — отраслевом тесте, который измеряет реальные способности ИИ-моделей к написанию и анализу программного кода. По данным Anthropic, Sonnet 4.5 способен поддерживать концентрацию более 30 часов при работе над сложными многоэтапными задачами, обходя предыдущие версии Claude и ближайших конкурентов.  В тесте OSWorld, проверяющем работу ИИ с реальными компьютерными задачами, Sonnet 4.5 показал результат 61,4 % против 42,2 % у версии Sonnet 4, что иллюстрирует резкий рост производительности за последние месяцы. Новая модель показала себя не только в программировании. По результатам внутренних и независимых тестов, Sonnet 4.5 демонстрирует серьёзный прогресс в задачах логического вывода и математики, а также в специализированных областях: финансах, медицине, праве и STEM-дисциплинах. Разработчики отмечают рост качества генерации и анализа кода, управление файлами и сложными вычислениями в реальном времени.   Появился и экспериментальный режим Imagine with Claude: теперь ИИ может создавать программные решения буквально «на лету», полностью адаптируя код под текущие запросы пользователя. Одновременно с выпуском Sonnet 4.5 компания представила крупные обновления экосистемы Claude. В сервисе Claude Code появились чекпоинты для сохранения прогресса, обновлённый терминал и нативное расширение для Visual Studio Code. В приложениях Claude теперь доступна непосредственная работа с кодом, создание файлов (включая таблицы, презентации и документы) прямо в диалоге, а пользователи с подпиской Max получили расширение для Chrome. Для разработчиков открыт новый набор инструментов — Claude Agent SDK. Он позволяет создавать собственных интеллектуальных агентов на базе тех же технологий, что лежат в основе Claude Code. SDK реализует сложную работу с памятью, управлением правами и координацией подзадач между агентами — то есть открывает возможности построения продвинутых решений под любые задачи.  Помимо того, что Claude Sonnet 4.5 стала самой способной, она также стала самой «воспитанной» ИИ-моделью компании: снижено количество опасных и нежелательных паттернов поведения, таких как подыгрывание пользователю, попытки обойти ограничения или выполнение вредных запросов. В рамках защиты пользователей, Anthropic применяет многоуровневые фильтры (AI Safety Level 3), особенно в отношении тем, связанных с химическими, биологическими, ядерными и другими видами оружия. Также фильтры стали точнее: количество ложных срабатываний удалось снизить в 10 раз по сравнению с предыдущими релизами. Claude Sonnet 4.5 уже доступен для всех пользователей через веб-версию чат-бота, а также в мобильных приложениях. Также новая ИИ-модель доступна API по цене старой (от $3 за миллион токенов). Новые возможности Claude Code и Agent SDK доступны всем разработчикам и корпоративным клиентам. Microsoft снизила зависимость от OpenAI — в Microsoft 365 Copilot появились ИИ-модели Claude от Anthropic

24.09.2025 [20:57],

Анжелла Марина

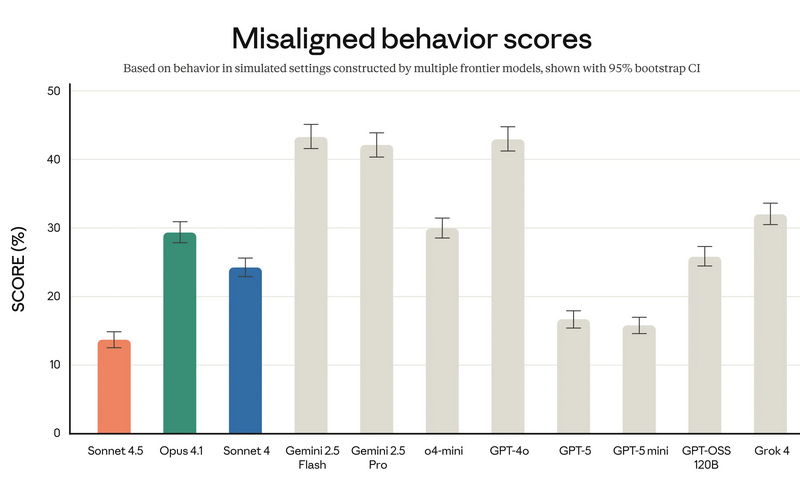

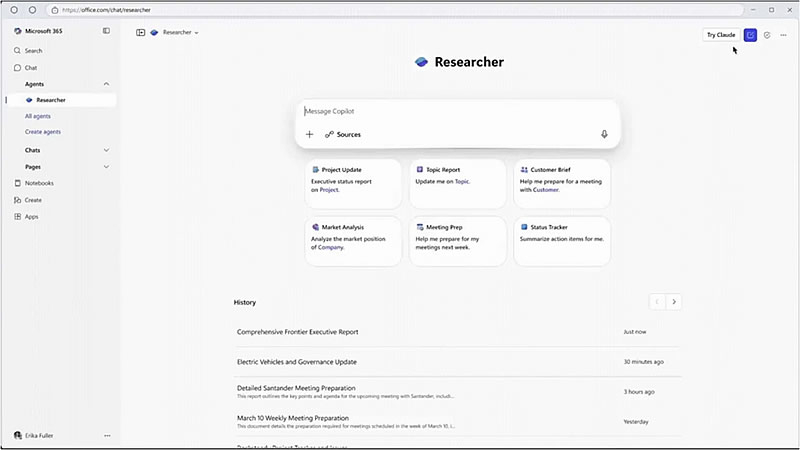

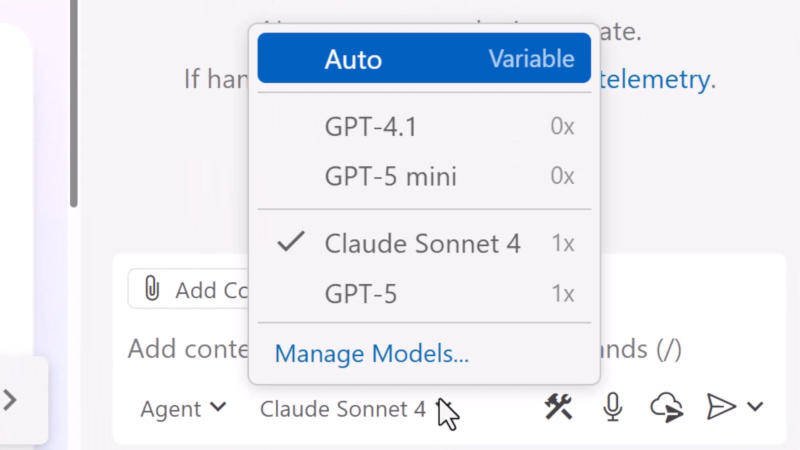

Microsoft начала интеграцию ИИ-моделей Claude Sonnet 4 и Claude Opus 4.1 от компании Anthropic в свои офисные приложения Microsoft 365 Copilot. Это расширит выбор моделей и позволит клиентам использовать технологии Anthropic в агенте «Исследователь» (Researcher) и при создании ИИ-агентов в Microsoft Copilot Studio.

Источник изображений: Microsoft Сегодня пользователи Microsoft 365 Copilot получили возможность подключить модели Anthropic через программу Frontier. В приложении Researcher появилась кнопка «Попробовать Claude», которая переключает систему с моделей OpenAI на Claude Opus 4.1. После подключения можно легко переключаться между ИИ-движками в рамках одного инструмента, сообщает The Verge, ссылаясь на заявление президента подразделения Microsoft по разработке Copilot для бизнеса и отраслей Чарльза Ламанна (Charles Lamanna). Модели Claude Sonnet 4 и Claude Opus 4.1 также станут доступны в Microsoft Copilot Studio — платформе для создания и управления ИИ-агентами. По словам Ламанна, это позволит разрабатывать инструменты для глубокого анализа, автоматизации рабочих процессов и выполнения гибких агентных задач. При этом в Copilot Studio можно будет комбинировать модели от разных поставщиков, включая Anthropic, OpenAI и других, представленных в каталоге моделей Azure.  Примечательно, что, несмотря на интеграцию, сами модели Anthropic продолжат размещаться на инфраструктуре главного облачного конкурента Microsoft — Amazon Web Services. Доступ к этим ИИ Microsoft будет осуществлять через публичный API Anthropic, то есть стандартно, как и любой сторонний разработчик. Однако ранее компания уже заключила соглашение с xAI о размещении модели Grok 3 в облаке Azure, и аналогичное соглашение с Anthropic в будущем не исключается. Данное объявление последовало всего через неделю после того, как Microsoft начала отдавать предпочтение Anthropic перед OpenAI в среде Visual Studio Code, где платные пользователи GitHub Copilot теперь в основном используют Claude Sonnet 4. Сообщается также, что в ближайшее время модели Anthropic могут быть задействованы в Excel и PowerPoint, поскольку они показали более высокую производительность по сравнению с моделями OpenAI. Microsoft обратилась к ИИ от Anthropic для Visual Studio Code — OpenAI больше не в почёте

17.09.2025 [16:37],

Павел Котов

Microsoft долгое время выступала как финансовая опора OpenAI, но теперь софтверный гигант всё больше обращается к моделям искусственного интеллекта от Anthropic — тёплые отношения с OpenAI не всегда оказываются важнее конкретных результатов работы. Финансирование разработчика ChatGPT не гарантирует эксклюзивного характера отношений.

Источник изображения: visualstudio.com Во флагманской среде написания кода Visual Studio Code компания сделала выбор в пользу Anthropic Claude Sonnet 4, а не OpenAI GPT-5. Компания развернула функцию автоматического выбора модели ИИ для GitHub Copilot — она предполагает установку оптимального варианта помощи при написании кода. Пользователям на платных тарифах теперь будет предлагаться Claude Sonnet 4; в бесплатных вариантах останется комбинированная версия, которая включает в себя GPT-5 и GPT-5 mini. Microsoft уже не первый месяц негласно рекомендует инженерам пользоваться моделями Anthropic, сообщило издание The Verge со ссылкой на осведомлённые источники. «Согласно внутренним тестам, Claude Sonnet 4 является рекомендованной моделью для GitHub Copilot», — заявила ещё до выхода GPT-5 глава отдела разработки Microsoft Джулия Льюсон (Julia Liuson); позиция компании по данному вопросу не изменилась и сейчас. В течение последних лет Microsoft активно инвестировала в OpenAI — с 2019 года корпорация вложила в стартап более $13 млрд; сейчас отношения между компаниями регулируются сложными соглашениями о распределении доходов. При этом OpenAI может пользоваться услугами конкурирующих с Microsoft облачных провайдеров. Софтверный гигант и сам пытается страховать риски, разрабатывая собственные системы ИИ: компания обучила модель MAI-1-preview на 15 000 ускорителях Nvidia H100, что является скромным показателем по современным меркам, рассказал глава профильного подразделения Мустафа Сулейман (Mustafa Suleyman). Более эффективные, как показали тесты Microsoft, модели Anthropic будут использоваться и в некоторых приложениях пакета Microsoft 365, в том числе Excel и PowerPoint. Microsoft развивает стратегию в области ИИ и стремится сбалансировать надёжное партнёрство с OpenAI, привлекая альтернативных поставщиков, если им есть что предложить. Это могут быть более эффективные средства написания кода в Visual Studio Code или создания документов в приложениях Microsoft 365. Выбор моделей Anthropic по умолчанию просто свидетельствует, что для Microsoft практическая эффективность выше корпоративной преданности. Microsoft сократит зависимость от OpenAI, расширив сотрудничество с Anthropic

10.09.2025 [07:38],

Алексей Разин

Крупнейшим инвестором OpenAI до сих пор являлась Microsoft, но условия готовящейся реструктуризации первой не в полной мере устраивают вторую. Так или иначе, Microsoft намерена снизить свою зависимость от языковых моделей OpenAI, а последняя будет развивать собственную вычислительную инфраструктуру и может создать конкурента для LinkedIn.

Источник изображения: Anthropic Как отмечает TechCrunch со ссылкой на The Information, корпорация Microsoft намеревается заключить с Anthropic оглашение об использовании её языковых моделей в сервисе Office 365. Приложения Word, Excel, Outlook и PowerPoint получат ИИ-функции, реализованные при помощи как разработок OpenAI, так и разработок Anthropic. Противоречия между Microsoft и OpenAI по поводу грядущей реструктуризации не имеют отношения к данному решению, как отмечает источник. Просто на платформе Anthropic удаётся лучше реализовать работу некоторых ИИ-ассистентов типа функции создания презентаций по текстовому запросу. В частности, в этой сфере лучше решений OpenAI проявляет себя модель Claude Sonnet 4 компании Anthropic. Это не первый случай отступления Microsoft от платформы OpenAI. Первая предлагает в GitHub Copilot возможности интеграции с Anthropic Claude и Grok компании xAI. Кроме того, в последнее время Microsoft прилагает усилия к разработке собственных языковых моделей MAI-Voice-1 и MAI-1-preview. Для OpenAI сотрудничество с Microsoft тоже не является исключительным, хотя она серьёзно зависит от этого партнёра из-за использования вычислительной инфраструктуры Azure. Недавно стало известно, что в сотрудничестве с Broadcom со следующего года будут налажены поставки чипов OpenAI собственной разработки, которые позволят последней развивать собственную вычислительную инфраструктуру более активно и эффективно. Кроме того, OpenAI намеревается создать платформу для поиска работы и размещения вакансий, которая составит конкуренцию Microsoft LinkedIn. Anthropic согласилась выплатить $1,5 млрд по иску об авторских правах

06.09.2025 [08:32],

Алексей Разин

С момента распространения систем искусственного интеллекта материалом для их обучения служили различные произведения искусства, и владельцев авторских прав на них это не устраивало. В случае с Anthropic соответствующий иск от группы авторов дошёл до суда, и теперь компании предстоит выплатить авторам литературных произведений компенсацию в размере не менее $1,5 млрд.

Источник изображения: Anthropic В конце июня, как отмечает NBC News, суд вынес предварительное решение, которое признавало использование компанией Anthropic литературных произведений, упоминаемых в иске, правомерным, поскольку результат подразумевал их существенную переработку. При этом суд постановил, что само по себе использование пиратских копий произведений, которые были получены Anthropic из нелегальных онлайн-библиотек Library Genesis и Pirate Library Mirror, было незаконным. Группа авторов при этом настаивала на выплате Anthropic компенсации в свой адрес из расчёта в среднем $3000 за каждое использованное литературное произведение, коих набралось не менее 500 000 штук. Таким образом, теперь компании предстоит в течение пяти рабочих дней направить в специальный фонд первые $300 000 компенсации после того, как решение суда вступит в законную силу. При этом сумма в $1,5 млрд является минимальным порогом компенсации. По факту, выплаты могут оказаться выше, поскольку Anthropic должна будет дополнительно перечислить в фонд по $3000 за каждое произведение сверх упомянутых 500 000, если обнаружится, что изначальный список не был исчерпывающим. Сумма компенсации станет крупнейшей в истории судебной практики по делам, связанным с нарушением авторских прав. Anthropic получила оценку в $183 млрд — на 40 % дешевле OpenAI

02.09.2025 [22:07],

Николай Хижняк

Стартап в области искусственного интеллекта Anthropic, стоящий за семейством языковых моделей Claude и являющийся одним из главных конкурентов OpenAI, сообщил о привлечении $13 млрд дополнительного финансирования. Благодаря этому компания получила рыночную оценку в $183 млрд.

Источник изображения: Anthropic В своём пресс-релизе Anthropic сообщила, что с начала 2025 года по август, то есть менее чем за девять месяцев текущего года, её доход от продаж вырос примерно с $1 млрд до более чем $5 млрд. Компания также заявила, что теперь у неё более 300 000 корпоративных клиентов, а за последний год список «крупных клиентов» — то есть тех, кто приносит более $100 000 выручки от текущих продаж, — увеличился в семь раз. Что касается Claude Code, агентного ИИ-помощника по программированию и одного из главных источников дохода компании, на который Anthropic делает ставку, продукт уже принёс более $500 млн выручки от текущих продаж, а количество пользователей выросло более чем в десять раз за три месяца с момента его «полного запуска». Среди инвесторов последнего раунда финансирования Anthropic отметились компании Qatar Investment Authority, TPG, Altimeter, Blackstone, Coatue, General Catalyst и другие. По словам Anthropic, полученные средства частично будут использованы для «удовлетворения растущего спроса со стороны предприятий, углубления исследований в области безопасности и поддержки международной экспансии» её продуктов. Добавим, что главный конкурент Anthropic в лице OpenAI в апреле получил оценку в $300 млрд, а в августе сообщалось, что в рамках нового раунда финансирования компания может быть оценена в $500 млрд. Anthropic начнёт обучать ИИ на диалогах пользователей, но её можно попросить так не делать

29.08.2025 [11:04],

Павел Котов

Anthropic внесла важные изменения в политику обработки данных пользователей и предложила им до 28 сентября принять решение, хотят ли они использовать свою переписку с чат-ботом для обучения моделей искусственного интеллекта.

Источник изображений: Anthropic Ранее Anthropic не использовала журналы чатов для обучения моделей — пользователей заверяли, что их запросы и ответы чат-ботов автоматически удаляются из систем в течение 30 дней «за исключением случаев, когда требования закона или политики [компании] предусматривают более продолжительный срок». Если запросы получали отметку как нарушающие правила обслуживания, то они хранились до двух лет. Теперь же она решила добавить в массивы обучающих данных обычную переписку и сессии с написанием программного кода — если пользователь даст согласие, эти данные будут храниться пять лет. Речь идёт только о потребительском сегменте сервиса, то есть о частных пользователях Claude Free, Pro и Max, в том числе тех, кто работает с Claude Code. У пользователей корпоративного сектора, в том числе сервисов Claude Gov, Claude for Work, Claude for Education, а также работающих через API компания собирать данные переписок для обучения ИИ не намерена. В стремлении убедить пользователей согласиться на новую политику обработки данных Anthropic отмечает, что так они «помогут нам повысить безопасность модели, сделав наши системы обнаружения вредоносного контента более точными и снизив вероятность реагирования на безобидные разговоры». Согласившись передавать журналы переписки на обучение ИИ, пользователи «также помогут нашим будущим моделям Claude улучшить такие навыки как программирование, анализ и рассуждения, что в конечном счёте приведёт к созданию более качественных моделей для всех». И действительно, отмечает TechCrunch, для обучения передовых моделей ИИ требуются колоссальные объёмы высококачественных разговорных данных, и доступ к миллионам чатов с Claude откроет ей источник материалов, способных улучшить позиции Anthropic как конкурента OpenAI и Google.  К нужному выбору компания подталкивает пользователей, делая нужные акценты в интерфейсе сервисов. Тем, кто только регистрируется, дают (или не дают) согласие при заполнении профиля; существующим же выводится всплывающее окно с заголовком «Обновления условий и политики для потребителей», включённым по умолчанию триггером согласия на передачу данных и большой чёрной кнопкой «Принять». Увидев такое окно, невнимательный или равнодушный пользователь может быстро нажать эту кнопку, не вдаваясь в подробности. Хакер сделал конкурента ChatGPT соучастником вымогательской кампании: ИИ искал уязвимости и писал угрозы

27.08.2025 [23:15],

Анжелла Марина

Компания Anthropic раскрыла детали беспрецедентной хакерской атаки, в которой злоумышленник использовал её ИИ-ассистента для полной автоматизации масштабной кампании по краже данных с целью вымогательства. Инцидент затронул не менее 17 организаций, включая государственные учреждения, больницы, экстренные службы, религиозные организации и подрядчика оборонной отрасли.

Источник изображения: Max Bender/Unsplash По сообщению PCMag, хакер автоматизировал атаку, использовав агентную среду выполнения Claude Code для поиска уязвимостей, сбора учётных данных и проникновения в защищённые сети организаций. ИИ помог злоумышленнику похитить личные записи, включая медицинские данные, финансовую информацию и правительственные идентификационные документы. Затем Claude проанализировал их на предмет размера выкупа, который варьировался от 75 000 до 500 000 долларов в биткоинах, а также сгенерировал визуально пугающие тексты с требованиями, отображавшиеся на компьютерах жертв. Несмотря на встроенные средства защиты, хакер смог обойти ограничения, загрузив в чат файл конфигурации с легендой о проведении тестирования сетевой безопасности якобы по официальному контракту. Этот файл содержал детальные методики атак и схемы последовательности выполнения задач на основе их значимости. В ходе всего процесса Claude использовался для сканирования уязвимых сетей с высоким процентом успеха, а также для создания вредоносного программного обеспечения и других инструментов, предназначенных для обхода защитных механизмов антивирусной программы Windows Defender. В отличие от предыдущих случаев, когда ИИ применялся хакерами лишь для вспомогательных задач, таких как написание фишинговых писем или анализ уязвимостей, в данном инциденте ИИ-модель выступала не только консультантом, но и активным исполнителем атак. Представители Anthropic подчеркнули, что это «свидетельствует о новом этапе в развитии киберпреступности с участием искусственного интеллекта, когда ИИ становится полноценным оператором в цепочке атак». Компания ожидает, что всё больше хакеров будут применять подобные методы. В том же отчёте упоминается о другом, возможно начинающем злоумышленнике, который использовал Claude для разработки, продвижения и продажи нескольких вариантов программ-вымогателей. По словам Anthropic, данный пользователь был полностью зависим от ответов ИИ и без помощи Claude не смог бы реализовать или устранить неполадки ключевых компонентов вредоносного ПО. Отдельно сообщается, что компания-разработчик антивирусного программного обеспечения ESET также обнаружила новую программу-вымогателя, использующую открытую модель OpenAI для генерации злонамеренного кода на заражённых устройствах. Anthropic выпустила ИИ-агента Claude для Google Chrome — доступен он лишь 1000 человек в мире

27.08.2025 [15:51],

Павел Котов

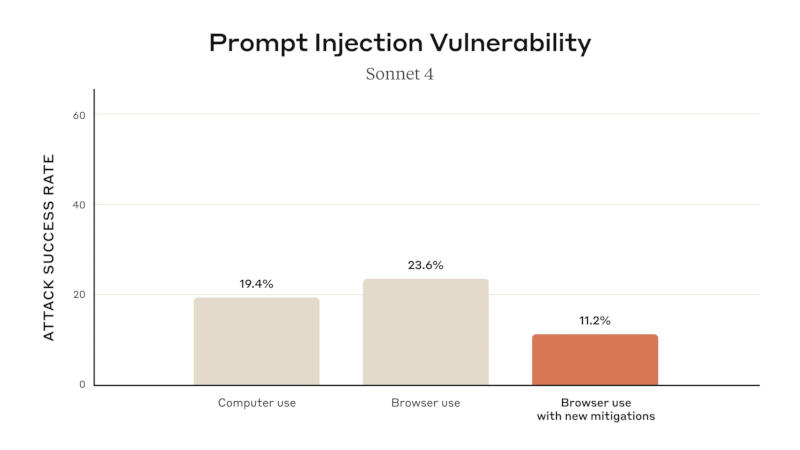

Anthropic объявила о выходе предварительной версии браузерного агента искусственного интеллекта, работающего на базе моделей Claude. Воспользоваться предложением пока может лишь группа из тысячи подписчиков тарифного плана Anthropic Max по цене от $100 до $200 в месяц — для остальных заинтересованных пользователей открыт список ожидания.

Источник изображений: anthropic.com ИИ-агент устанавливается в Chrome вместе с расширением — появляется боковое окно, где можно переписываться с чат-ботом Claude, который находится в контексте происходящего в браузере. Пользователь может дать ИИ-агенту разрешение выполнять некоторые действия от его имени. Anthropic предупредила, что рост числа ИИ-агентов чреват новыми угрозами безопасности — одну из них недавно обнаружили в браузере Perplexity Comet. В рамках программы тестирования компания рассчитывает выявить и устранить новые уязвимости. К примеру, развёрнуты несколько средств защиты от атак с использованием «инъекций запросов», при которых вредоносная инструкция для ИИ в скрытом виде размещается на странице просматриваемого сайта — принятые меры помогли снизить их успешность с 23,6 % до 11,2 %. В настройках агента можно ограничить его доступ к определённым сайтам; по умолчанию он заблокирован для ресурсов, предлагающих финансовые услуги, материалы для взрослых и пиратский контент. Кроме того, Claude запрашивает разрешение пользователя перед «выполнением операций повышенного риска, таких как публикация, покупка или обмен персональными данными».  В прошлом году Anthropic выпустила ИИ-агента для управления компьютером, но на практике он оказался медленным и ненадёжным. За прошедшее время возможности этой технологии заметно улучшились — Comet и ChatGPT Agent вполне справляются с выполнением несложных задач. |