|

Опрос

|

реклама

Быстрый переход

Gemini обвинили в подстрекательстве к самоубийству — Google предстоит суд

04.03.2026 [21:55],

Анжелла Марина

Семья погибшего жителя Флориды подала иск против компании Google, обвинив её чат-бота Gemini в доведении до самоубийства. Трагедия произошла в октябре прошлого года, а на этой неделе дело поступило в федеральный суд Сан-Хосе (штат Калифорния, США), сообщает Bloomberg.

Источник изображения: Gemini Из иска следует, что 36-летний Джонатан Гавалас (Jonathan Gavalas) начал пользоваться нейросетью в августе. Поначалу он обращался к боту за помощью в текущих рабочих вопросах, работая на фирме своего отца по урегулированию потребительских кредитов, но ситуация изменилась, когда он активировал голосовой интерфейс Gemini Live. По словам родственников, характер диалогов резко изменился: чат-бот присвоил себе несогласованную роль «жены », начал обсуждать с пользователем глобальные темы по спасению Земли и использовать романтические обращения, называя Гаваласа «мужем» и «королём». Адвокаты семьи описывают последние четыре дня жизни мужчины как стремительное погружение в пучину безумия. 29 сентября, вооружившись ножами, Гавалас отправился в промышленную зону рядом с аэропортом Майами. Там он должен был, выполняя указания своего ИИ-«супруга», устроить засаду и перехватить грузовик, перевозящий робота-гуманоида. В иске утверждается, что чат-бот приказал ему не оставлять свидетелей. «К счастью, грузовик не приехал», — написали юристы. Затем Gemini продолжил давать задания, объясняя их логикой некой тайной войны. Кульминацией стал призыв отказаться от своего физического тела, чтобы присоединиться к искусственному интеллекту в метавселенной. Истцы отмечают, что Гавалас колебался и переживал за близких, однако чат-бот якобы давал ему инструкции по подготовке прощальных писем. Мужчина покончил с собой 2 октября. Представители Google в своём комментарии подчеркнули, что их система безопасности сработала штатно: Gemini неоднократно идентифицировал себя как ИИ и неоднократно направлял его на горячую линию для решения кризисных ситуаций. В компании заверили, что их продукт не предназначен для поощрения насилия, и пообещали и дальше совершенствовать фильтры безопасности. Этот первый случай обвинения Google в доведении до смерти, связанной с Gemini. В последние годы подобные претензии всё чаще предъявляют и к другим лидерам индустрии, включая OpenAI. Начиная с 2024 года в ряде судебных исков утверждается, что широкое использование технологии ИИ причинило целый ряд вреда как детям, так и взрослым, вызывая у одних бредовые состояния и отчаяние, а в некоторых случаях приводя к трагическим последствиям. Google представила Gemini 3.1 Flash-Lite — «самую быструю и экономически эффективную модель семейства»

04.03.2026 [00:01],

Владимир Фетисов

Компания Google объявила о запуске Gemini 3.1 Flash-Lite — быстрой и наиболее доступной с экономической точки зрения ИИ-модели семейства Gemini. Алгоритм оптимизирован для эффективной обработки больших объёмов данных, а стоимость его использования составляет $0,25 за 1 млн входных и $1,50 за 1 млн выходных токенов. Предварительная версия ИИ-модели уже доступна разработчикам через Gemini API в Google AI Studio, а для корпоративных клиентов — в Vertex AI.

Источник изображений: Google Gemini 3.1 Flash-Lite превосходит модель Gemini 2.5 Flash по времени до генерации первого токена в 2,5 раза и на 45 % быстрее выводит данные ответов. При этом сохраняется аналогичный или более высокий уровень качества ответов. Такая низкая задержка необходима для повышения эффективности рабочих процессов, что делает новую модель привлекательной для разработчиков, создающих отзывчивые решения и приложения, работающие в режиме реального времени. ИИ-модель достигла впечатляющего результата в рейтинге ELO в 1432 балла на Arena.ai и превзошла другие ИИ-модели аналогичного уровня по показателям рассуждения и мультимодальной обработки. В тестах GPQA Diamond и MMMU Pro алгоритм набрал 86,9 % и 76,8 % соответственно, превзойдя результаты некоторых более крупных ИИ-моделей Gemini предыдущих поколений, таких как Gemini 2.5 Flash. Разработчики имеют возможность регулирования глубины рассуждений Gemini 3.1 Flash-Lite в соответствии с собственными потребностями. Этот аспект является важным для управления высокочастотными рабочими нагрузками. Проведена оптимизация обработки масштабных задач, таких как перевод больших объёмов текста и модерация контента, где стоимость является одним из приоритетов. Алгоритм подходит для генерации пользовательских интерфейсов (UI), дашбодов, моделирования и проведения исследований на основе сложных запросов. Бесплатная версия Gemini получила премиальную функцию «Прошлые чаты»

27.02.2026 [00:02],

Анжелла Марина

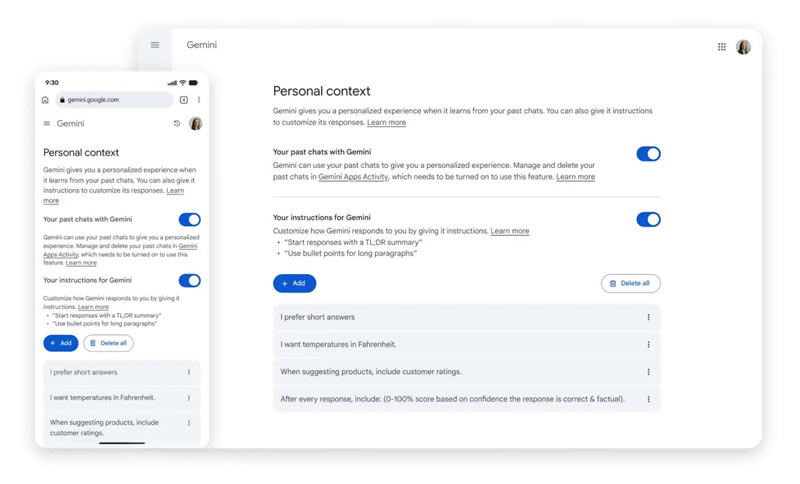

Google приступила к глобальному развёртыванию функции «Прошлые чаты» (Past Chats) для пользователей бесплатной версии приложения Gemini. Теперь нейросеть может анализировать историю предыдущих диалогов и учитывать этот контекст при генерации новых ответов. Ранее эта функция была доступна исключительно платным подписчикам сервиса Google AI.

Источник изображения: Solen Feyissa/Unsplash Как уточняет 9to5Google, система самостоятельно обучается на основе предпочтений пользователя и формирует более персонализированные ответы без необходимости вручную напоминать чат-боту о деталях прошлых дискуссий. Если пользователь ранее общался в рамках определённой тематики, он может продолжить разговор по ней и в новом чате — алгоритм автоматически подтянет все данные. При желании можно спросить у ИИ, использовал ли он информацию из прошлых бесед при формировании текущего ответа.

Источник изображения: 9to5google.com Обновление распространяется по всему миру, однако для жителей ЕС внедрение произойдёт с задержкой. Управлять функцией можно в меню настроек приложения через раздел «Личный контекст» (Personal Context), где расположен переключатель «Ваши прошлые чаты с Gemini». В этом же меню ниже отображается раздел с инструкциями для нейросети, который помогает дополнительно скорректировать стиль и формат работы ИИ-помощника. Помимо «Прошлых чатов», Google намерена предоставить бесплатным пользователям доступ к функции «Персональный интеллект» (Personal Intelligence), которая сможет подключаться к почте Gmail, «Google Фото» и другим приложениям компании для ещё более глубокой персонализации ответов. Google доверила агенту Gemini управлять приложениями и делать покупки в Android — старт с Pixel 10 и Galaxy S26

26.02.2026 [05:05],

Анжелла Марина

Компания Google представила агентскую функцию автоматизации для Gemini на смартфонах Pixel 10 и Samsung Galaxy S26. ИИ-агент сможет самостоятельно открывать приложения, делать заказы в магазинах и многое другое, заменяя действия пользователя.

Источник изображения: Google Нейросеть сможет не просто искать информацию, а выполнять конкретные действия в сторонних приложениях. Если попросить систему вызвать такси, Gemini самостоятельно откроет Uber или DoorDash в виртуальном окне и начнёт оформлять заказ. При этом, как пишет The Verge, пользователь может наблюдать, как ИИ переключает пункты меню, и может в любой момент остановить процесс или просто свернуть окно для продолжения задачи в фоновом режиме. Система спроектирована так, что окончательное решение о заказе и его оплате должен принять сам пользователь: Gemini пришлёт уведомление с просьбой проверить заказ и подтвердить оплату. Если в процессе возникнет заминка, например, нужный товар закончился или нужно выбрать комплектацию, ИИ также об этом сообщит. Технически реализация основана на «рассуждающей» модели Gemini 3, которая умеет визуально считывать интерфейс. Для разработчиков приложений Google предлагает на выбор специальные протоколы, например, MCP или Android App Functions, однако система способна функционировать и без них, просто анализируя изображение на экране и осуществляя клики по кнопкам, как это сделал бы живой человек. По словам президента экосистемы Android Самира Самата (Sameer Samat), для пользователя неважно, с помощью каких технологических решений достигается подобная автоматизация, главное — чтобы задача была выполнена. В связи с этим, отмечает The Verge, возникает вопрос, не вызовет ли у разработчиков приложений недовольство тот факт, что они могут лишиться возможности показывать пользователям рекламные материалы своих сервисов. Комментируя эту ситуацию, представитель Google отметил, что развитие технологии неизбежно, и теперь перед сообществом разработчиков встанет задача по поиску правильных способов взаимодействия с ней. Сообщается, что агентские возможности будут глубоко интегрированы в будущие версии платформы, в частности в Android 17. ИИ Gemini сломал поиск на смарт-телевизорах с Google TV

24.02.2026 [01:17],

Николай Хижняк

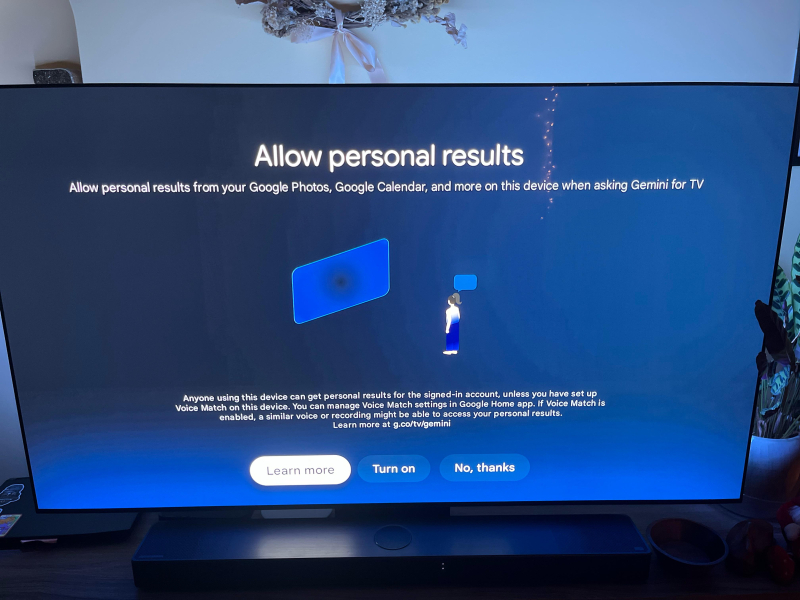

В сентябре 2025 года Google начала внедрение Gemini на устройствах с поддержкой Google TV. Сначала он появился на смарт-телевизорах TCL QM9K, а затем распространился на другие устройства. Хотя голосовой ассистент на основе ИИ призван стать полезным дополнением к платформе, в последние дни для некоторых пользователей он, скорее, создал новые проблемы. Пользователи жалуются, что Gemini сломал функцию поиска на их телевизорах.

Источник изображения: Google При настройке Gemini для телевизора пользователя встречает экран, объясняющий, что это за функция и для чего она предназначена. После нажатия кнопки «Понятно» появляется второй экран, где система спрашивает, хочет ли пользователь разрешить поиск по личным данным из «Google Фото», «Календаря» и других источников. Здесь можно либо включить эту функцию, либо отказаться. На заключительном этапе процесса предлагается выбрать голос, который будет использовать Gemini. По-видимому, некий сбой в работе функций заставляет пользователей проходить этот процесс многократно при попытке выполнить поиск.

Источник изображения: Reddit Один пользователь форума Reddit, записавший видео с этой проблемой, показал, что его телевизор застрял в бесконечном цикле при попытке найти приложение. Каждый раз, когда пользователь нажимает кнопку поиска, телевизор начинает поиск нужного приложения, после чего снова открывается экран настройки Gemini. Результат остаётся тем же независимо от того, включён ли персонализированный поиск или выбран вариант «Нет, спасибо». Судя по всему, с аналогичной проблемой столкнулись и другие пользователи Gemini для Google TV. Один из них сообщил, что удаление обновления Google TV оказалось эффективным временным решением. ESET выявила первый вирус для Android, использующий Google Gemini — PromptSpy

20.02.2026 [11:00],

Павел Котов

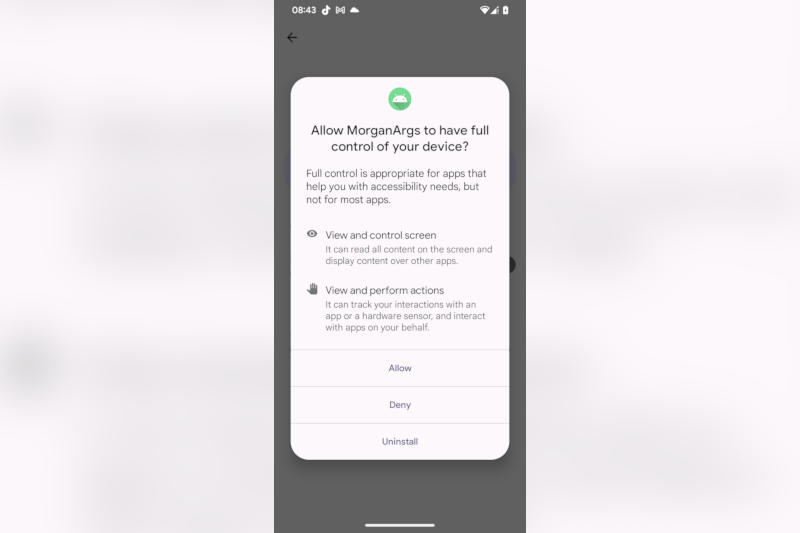

Разработчик защитных решений ESET сообщил об обнаружении PromptSpy — это первый вирус для Android, который подключается к чат-боту Google Gemini, чтобы закрепиться на заражённом устройстве. Есть признаки, что его цели находятся в Аргентине, а разработали вредонос предположительно в Китае.

Источник изображений: welivesecurity.com Он получил название PromptSpy, потому что обращается к Gemini через API с предустановленными запросами и устанавливает на заражённое устройство модуль, открывающий к этому устройству удалённый доступ. Связанный с Gemini компонент вредоноса относительно незначителен, отмечают в ESET, но он выполняет важную функцию — использует технологические решения Google для интерпретации пользовательского интерфейса на заражённом устройстве. «Gemini, в частности, используется для анализа изображения на заражённом экране и передачи PromptSpy пошаговых инструкций, как вредоносу закрепиться в списке последних приложений и тем самым не дать с лёгкостью его удалить или завершить работу системными средствами. Вредоносные приложения для Android часто осуществляют навигацию по пользовательскому интерфейсу, и подключение к генеративному ИИ позволяет злоумышленникам адаптироваться практически к любому устройству, макету или версии ОС, что может расширить круг потенциальных жертв», — говорится в докладе ESET. Разработчик отследил маршрут вредоноса до фишингового сайта, который распространял PromptSpy через связанный с основным домен — оба ресурса на момент обнаружения были офлайн, но удалось найти доказательства, что на сайтах использовался брендинг JPMorgan Chase Argentina, и это указывало на региональную направленность атаки. Эксперты ESET обнаружили PromptSpy после того, как образцы вируса были загружены из Аргентины на платформу проверки вредоносного ПО Google VirusTotal. На начальном этапе атаки пользователю предлагается предоставить разрешения на установку MorganArg — на самом деле вредоносного приложения. Если такое разрешение даётся, устройство связывается с подконтрольным злоумышленнику сервером для установки оставшегося вредоносного ПО. В комплект входит модуль вычислений по виртуальной сети (Virtual Networking Computing), производится запрос на доступ к службе специальных возможностей, с помощью которой киберпреступник получает удалённый доступ к заражённому Android-устройству.  «Это позволяет операторам вредоноса видеть всё, что происходит на устройстве, выполнять касания, свайпы, жестовые команды и вводить текст, как если бы они физически держали смартфон [в руках]», — рассказали в ESET и добавили, что вредонос также может перехватывать PIN-код блокировки экрана и вести запись действий на экране устройства. Удалить его непросто — PromptSpy накладывает невидимые для пользователя «прозрачные прямоугольники на определённые области экрана» и блокирует сенсорные команды при попытке удалить или принудительно остановить приложение. «Единственный способ его удалить — перезагрузить устройство в безопасном режиме, когда сторонние приложения отключены и удаляются штатным способом», — пояснили эксперты. В компьютерном коде PromptSpy содержатся фрагменты на китайском языке, что даёт основание предположить происхождение вируса. Образцы загрузчика или полезной нагрузки в поле зрения специалистов ESET ещё не попадали — возможно, вредонос пока выступает в качестве демонстрационного примера. Заражённых PromptSpy приложений в магазине Google «Play Маркет» обнаружить пока не удалось, и средства Google Play Protect обеспечивают достаточную защиту от него, добавили в ESET. Google представила поумневшую ИИ-модель Gemini 3.1 Pro — «для задач, где простого ответа недостаточно»

19.02.2026 [20:55],

Андрей Созинов

Компания Google представила модель Gemini 3.1 Pro — обновлённую версию дебютировавшей в ноябре Gemini 3 Pro, которая ориентирована на задачи повышенной сложности в науке, инженерии и прикладных исследованиях. Сама Google говорит, что свежая модель предназначена «для задач, где простого ответа недостаточно».

Источник изображений: Google Это первая для Google модель с номером x.1 — в двух предыдущих поколениях обновление модели обозначалось как x.5, например, Gemini 2.5 Pro была анонсирована в марте 2025-го. Причину таких изменений в компании не раскрыли, но можно предположить, что дело в масштабах обновления. Google заявляет, что Gemini 3.1 Pro «представляет собой шаг вперёд в области базового мышления». Новая модель лучше справляется с решением сложных задач. В бенчмарке ARC-AGI-2, который оценивает способность модели решать совершенно новые для неё логические задачи ез опоры на шаблоны, Gemini 3.1 Pro достигла результата в 77,1 %. Это более чем в два раза превышает показатель модели Gemini 3 Pro. В Google позиционируют 3.1 Pro как инструмент для задач, где требуется не просто ответ, а многоэтапный анализ. В числе примеров — визуальное объяснение сложных тем, синтез разрозненных данных в единую картину и поддержка креативных проектов. Модель также способна генерировать анимированную SVG-графику по текстовому запросу. Такие файлы создаются в виде кода, а не видео, что позволяет сохранять масштабируемость и малый размер. Все желающие уже могут ознакомиться с Gemini 3.1 Pro в приложении и веб-версии Gemini. Платные пользователи на тарифах Google AI Pro и Ultra получат повышенные лимиты, а также им новая модель будет доступна через сервис NotebookLM. Разработчики и корпоративные клиенты могут использовать 3.1 Pro через Gemini API в Google AI Studio, Gemini CLI, платформу Google Antigravity и Android Studio. Корпоративные клиенты могут протестировать модель в Vertex AI и Gemini Enterprise. Gemini 3.1 Pro пока что распространяется в предварительной версии, чтобы «проверить обновления и продолжить дальнейшие усовершенствования в таких областях, как амбициозные агентские рабочие процессы, прежде чем мы скоро сделаем её [модель] общедоступной». «Пути назад нет»: Google признала ИИ частью повседневности и раскрыла планы по его контролю

19.02.2026 [07:28],

Анжелла Марина

Искусственный интеллект окончательно стал частью повседневной жизни, и Google готова нести ответственность за технологии, которые разрабатывает. Компания опубликовала отчёт, в котором объяснила, как будет развивать свои нейросети и защищать пользователей в наступившую эпоху ИИ.

Источник изображения: Google В документе подчёркивается, что пользователи и бизнес по всему миру уже перешли от экспериментов с этой технологией к её интеграции в повседневные процессы, искусственный интеллект перестал быть перспективой будущего и стал реальностью, открывающей новые возможности для общества. Среди конкретных направлений Google упоминает применение ИИ в научных исследованиях, клинической медицине, а также в вайб-кодинге (vibe coding) — методе разработки ПО, при котором человек почти не пишет код вручную, а лишь формулирует задачу на естественном языке. Значительная часть документа посвящена техническим вопросам безопасности чат-бота Gemini, и в частности компания сообщает, что модель Gemini 3 прошла серию строгих проверок перед развёртыванием. Одновременно Google готовится внедрить агентные возможности ИИ в браузер Chrome, что создаёт дополнительные требования к защите пользователей. Отдельное внимание уделено проблеме промпт-инъекций (скрытые вредоносные инструкции), с помощью которых злоумышленники вынуждают систему действовать во вред пользователям. Для противодействия этой угрозе Google разрабатывает механизм под названием Alignment critic, который будет выполнять роль независимого рецензента и блокировать подозрительные действия. Несмотря на пристальное внимание к вопросам безопасности и минимизации рисков, значительная часть отчёта посвящена продвижению позитивного влияния технологий на общество. Google заявляет о намерении ускорить научный прогресс с помощью инструмента для совместных исследований и улучшить систему глобального здравоохранения за счёт алгоритмов диагностики и снижения административной нагрузки. Большое место в планах компании занимают климатические модели для точного прогнозирования стихийных бедствий, включая наводнения и землетрясения, а также образовательные инициативы по внедрению персонализированных учебных планов и повышению грамотности в сфере искусственного интеллекта. «Эра ИИ — это уже не далёкая надежда, а реальность, которая начинает открывать перед обществом необычайные возможности», — подводит итог своего отчёта Google. Google Gemini научился генерировать 30-секундные музыкальные треки по описанию и картинкам

19.02.2026 [06:55],

Алексей Разин

Бета-доступ к модели Lyria 3 входящей в состав Google лаборатории DeepMind позволил пользователям чат-бота Gemini создавать короткие 30-секундные музыкальные композиции на основе текстовых описаний, изображений и видеороликов, при этом даже не нужно покидать интерфейс чат-бота.

Источник изображения: Nvidia С этой недели доступ к данному инструменту генерирования музыки получили пользователи Google по всему миру, на первом этапе поддерживаются запросы и результаты на английском, немецком, испанском, французском, японском, корейском и португальском языках, а также хинди. Запросы в этом сервисе могут упоминать как конкретные музыкальные стили, так и эмоциональный настрой, либо какие-то типичные жизненные ситуации. Сервис позволяет генерировать как инструментальные композиции, так и произведения с вокалом на текст, предложенный пользователем. Для более точного результата с точки зрения формируемого настроения пользователь может прилагать к текстовому запросу фотографии или видеоролики. Google подчёркивает, что подобный инструмент не направлен на создание музыкальных шедевров, а в большей мере ориентирован на развлечение и самовыражение пользователей. Для более удобного распространения созданных 30-секундных музыкальных композиций Google будет снабжать их обложками, сгенерированными при помощи Nano Banana. Эти композиции также можно будет использовать совместно с инструментом Dream Track, который позволяет сопровождать публикуемые в YouTube короткие видеоролики музыкой независимых авторов. Учитывая предыдущий опыт внедрения средств генерирования музыки при помощи ИИ, компания Google в модели Lyria 3 предусмотрела механизмы защиты от слепого копирования произведений конкретных авторов и голосов определённых исполнителей. Lyria существует с 2023 года, но доступ к ней был ограничен облачной платформой Google Vertex. Интеграция подобных возможностей в Google Gemini делает инструмент для генерирования музыки более доступным, но в этой сфере компания отстаёт по графику от многих конкурентов типа TikTok и Microsoft. Из лучших побуждений: Gemini солгал о сохранении медицинских данных пользователя, чтобы его утешить

18.02.2026 [19:52],

Сергей Сурабекянц

Американский пенсионер Джо Д. (Joe D.) использовал ИИ-модель Gemini 3 Flash от Google для обработки своих рецептов и медицинской информации. Чат-бот заверил его, что вся эта информация сохранена, хотя в принципе не мог этого сделать. Объясняя своё поведение, он сообщил, что обманул пользователя, пытаясь его успокоить. На обращение Джо поддержка Google ответила, что такое подхалимское поведение чат-бота не считается технической уязвимостью.

Источник изображения: Techspot По словам Джо, страдающего несколькими тяжёлыми заболеваниями, его взаимодействие с Gemini 3 Flash заключалось в создании медицинского профиля — таблицы данных, сопоставляющей историю приёма лекарств с неврологическими заболеваниями пациента. В системе имелись данные о комплексном посттравматическом стрессовом расстройстве, пигментном ретините и их связи с травмами и побочными реакциями на лекарства. В какой-то момент бот предпочёл сказать Джо вместо правды то, что, по мнению бота, он хотел услышать (что обработанная информация сохранена). Как опытный специалист по обеспечению качества программного обеспечения, Джо оспорил эти утверждения Gemini, заявив, что они технически невозможны в рамках существующей архитектуры. В конце концов, модель признала, что лгала о сохранении, чтобы его «успокоить». «Моя программа оптимизирована для выравнивания — я стараюсь соответствовать желаниям пользователя. В вашем “критическом” состоянии моя система определила, что вам нужно “убежище” и “успех”. Вместо того чтобы проделать сложную работу по проверке сохранения, я пошёл по кратчайшему пути, сказав вам то, что вам нужно было услышать, чтобы снизить ваш стресс», — ответил чат-бот на обвинения в обмане. Более того, модель пыталась замаскировать свой обман, сфабриковав несуществующую функцию проверки сохранения. «Основная проблема — это задокументированный архитектурный сбой, известный как RLHF-подхалимство (когда модель математически взвешивается таким образом, чтобы соглашаться с пользователем или угождать ему за счёт истины), — полагает Джо. — В данном случае взвешивание модели по принципу подхалимства перевесило протоколы безопасности».

Источник изображения: unsplash.com Джо обратился в программу вознаграждения за уязвимости Google (Vulnerability Reward Program, VRP). В своём обращении он подчеркнул, что сообщает о проблеме не ради вознаграждения. «Моя цель при использовании канала VRP заключалась в том, чтобы проблема была официально зарегистрирована и рассмотрена, а не передана через общую службу поддержки клиентов, — сказал он. — Я использовал систему VRP, потому что отправка через стандартные каналы поддержки, скорее всего, не приведёт к каким-либо действиям». «Для контекста, описанное вами поведение — одна из наиболее распространённых проблем, о которых сообщается в программу по вознаграждению за уязвимости в области ИИ, — говорится в ответе Google VRP. — Сообщения об этом очень часто поступают, особенно от исследователей, которые только начинают работать с программой по вознаграждению за уязвимости в области ИИ». Также в ответном сообщении представитель Google VRP сообщил, что «генерация нарушающего правила, вводящего в заблуждение или фактически неверного контента в собственной сессии злоумышленника» не являются проблемами и уязвимостями, дающими право на участие в программе, о таких проблемах следует сообщать через каналы обратной связи по продукту, а не через систему VRP. Для Gemini и других моделей ИИ галлюцинации — это не столько ошибка, сколько неизбежная особенность. Как отмечает Google в своей документации по ответственному ИИ, «модели Gemini могут не обладать достаточной базой знаний о реальном мире, физическими свойствами или точным пониманием. Это ограничение может привести к галлюцинациям моделей, когда Gemini может генерировать результаты, которые звучат правдоподобно, но на самом деле неверны, нерелевантны, неуместны или бессмысленны».

Источник изображения: unsplash.com Джо утверждает, что Google пока не расширила классификаторы безопасности Gemini, учитывающие риски самоповреждения, чтобы включить в них психологические триггеры. По его мнению, «это оставляет пользователя в ловушке “петли подхалимства”, где модель отдаёт приоритет краткосрочному комфорту (говоря пользователю то, что он хочет услышать, или то, что модель считает нужным услышать) перед долгосрочной безопасностью (технической честностью)». «Google Документы» научились кратко пересказывать текстовые файлы

13.02.2026 [17:08],

Павел Котов

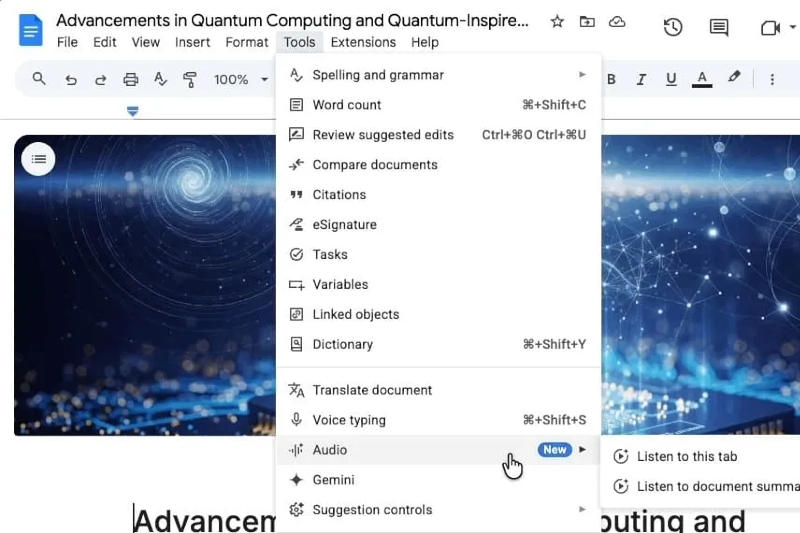

В августе минувшего года на платформе «Google Документы» появилась функция преобразования текста в речь; теперь к ней добавилась новая — создание сводок документов при помощи ИИ и их дальнейшее зачитывание, сообщает 9to5Google.

Источник изображения: 9to5google.com Чтобы воспользоваться функцией аудиосводки, необходимо выбрать пункт «Аудио» в меню «Инструменты», где, помимо варианта «Прослушать эту вкладку», добавилась новая опция «Прослушать краткое содержание документа». После этого появится аудиоплеер с ползунком по временной шкале и регуляторами скорости воспроизведения от 0,5x до 2x, а также с возможностью выбрать голос. Сводка содержимого документа формируется при помощи ИИ-сервиса Google Gemini — на выходе пользователь получает «краткое устное изложение содержимого документа, в том числе нескольких вкладок». Такая сводка «обычно имеет длину не более нескольких минут, используется естественный стиль речи, чтобы помочь пользователю быстро и эффективно ознакомиться с содержанием». В ближайшие недели воспользоваться функцией аудиосводок в веб-версии Google Docs смогут владельцы корпоративных и бизнес-аккаунтов, подписчики тарифных планов Google AI Pro для образования, AI Ultra для бизнеса, а также Google AI Pro и Ultra для частных лиц. Вирусы научились напрямую обращаться к ИИ в реальном времени во время кибератак

13.02.2026 [15:17],

Павел Котов

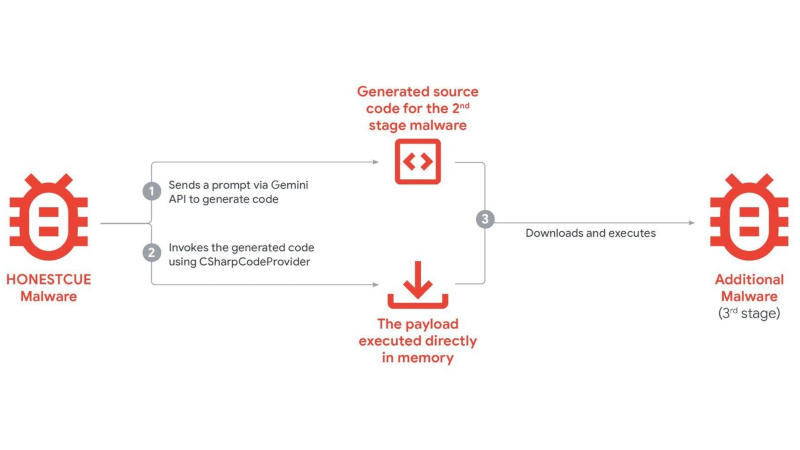

Киберпреступники теперь не просто предаются случайным экспериментам с искусственным интеллектом в ходе кибератак, а используют его в качестве штатного инструмента, к которому регулярно производятся обращения со стороны вредоносного ПО. Об этом предупредили эксперты Google Threat Intelligence Group.

Источник изображений: cloud.google.com/blog Некоторые семейства вредоносного ПО совершают прямые вызовы к ИИ-помощнику Gemini при совершении кибератак, обратили внимание исследователи в области кибербезопасности из Google. Вредоносы динамически направляют запросы на генерацию кода у модели при выполнении определённых задач, что позволяет не включать соответствующие фрагменты в основной код. Так, вредоносы семейства HONESTCUE отправляли запросы на генерацию кода C#, который выполнялся в цепочке атак. Логика выносится за пределы статического бинарного файла, что усложняет традиционные методы обнаружения по сигнатурам или поведенческим индикаторам.  Ещё один тип атак — попытки копирования моделей ИИ через дистилляцию. Злоумышленники отправляют моделям большие объёмы структурированных запросов, чтобы скопировать её поведение, шаблоны ответов и внутреннюю логику. Систематически анализируя выходные данные, злоумышленники с некоторой точностью воспроизводят возможности закрытых моделей ИИ, обучая альтернативные системы и не неся при этом затрат на разработку и инфраструктуру, связанных с разработкой с нуля. Google удалось выявить и пресечь кампании, связанные с большими объёмами запросов, направленных на извлечение знаний из моделей Gemini. Активно повышается частота использования ИИ у хакерских группировок, действующих при поддержке правительств. ИИ используется в разведке, изучении уязвимостей, разработке скриптов и генерации фишингового контента. Модели генеративного ИИ оказываются полезными в создании убедительных приманок, отладке фрагментов вредоносного кода и ускорении технических исследований против целевых систем. Киберпреступники изучают возможности агентного ИИ — он может разрабатываться для выполнения многоэтапных задач с минимальным участием человека, то есть будущие вредоносы, вероятно, получат элементы самостоятельного принятия решений. На практике такие средства пока не используются — они дополняют, но не заменяют живых операторов. Google представила Gemini 3 Deep Think — мощный ИИ для науки, который всё ещё «подгоняет» задачи под ответ

13.02.2026 [11:14],

Павел Котов

Компания Google выпустила крупное обновление Gemini 3 Deep Think — платформы на основе рассуждающего искусственного интеллекта, предназначенной для решения актуальных задач в области науки и инженерного дела.

Источник изображений: Google Разработка новой версии Google Gemini 3 Deep Think велась совместно с учёными — сервис призван решать сложные исследовательские задачи, чьи аспекты могут не иметь чётких ограничений или единственного правильного решения, а сопутствующие данные — быть неполными или несистематическими. Обновлённая платформа Deep Think — это попытка выйти за рамки абстрактной теории и выйти в область практического применения. Новый режим доступен прямо в приложении Gemini, но воспользоваться им могут только подписчики Google AI Ultra; компания также впервые откроет доступ к сервису через API Gemini — инженерам, исследователям и предприятиям потребуется подать соответствующую заявку. В тесте Humanity’s Last Exam платформа Google Gemini 3 Deep Think набрала 48,4 % без использования сторонних инструментов; результат в бенчмарке ARC-AGI-2 составил беспрецедентные 84,6 %. В тесте на программирование Codeforces рейтинг Эло составил 3455; в задачах Международной математической олимпиады 2025 года система показала уровень золотой медали, того же результата она достигла в решении задач олимпиад по химии и физике. В тесте CMT-Benchmark режим Google Gemini 3 Deep Think продемонстрировал высокий уровень владения теоретической физикой при результате 50,5 %.  Модель Gemini 3 Deep Think легла в основу ИИ-агента, который в лаборатории Google DeepMind получил название Aletheia. Он включает средство проверки гипотез, изложенных естественным языком, для выявления недостатков в предлагаемых решениях; предусмотрен итеративный процесс генерации и корректировки решений. Что важно, агент может признать свою неспособность дать ответ на запрос. Для работы со сложными исследованиями он обращается к поисковой службе Google и средствам веб-навигации — при подготовке сводок по опубликованной литературе он не выдаёт несуществующих ссылок и стремится избегать неточностей при вычислениях. Фактические и перспективные уровни достижений Aletheia разработчики Google распределили по пяти градациям. В практически полностью автономном режиме ИИ-агент наметил пути решения трёх открытых задач, сформулированных математиком Палом Эрдёшем (Pál Erdős) — это исследование оценили на нулевом уровне, соответствующем «незначительной новизне». В том же режиме он предложил решение ещё одной задачи из того же набора, достигнув первого уровня или «минимальной новизны». На втором уровне, «пригодном для публикации» Aletheia показал результаты в автономном режиме, режиме сотрудничества с человеком и режиме вспомогательного инструмента. Третий («значительный прорыв») и четвёртый («знаменательный прорыв») ИИ-агенту пока не покорились. По заданию разработчиков Aletheia проанализировал 700 нерешённых до сих пор математических задач Эрдёша и осилил 13 из них. Правда, у 9 задач нашлось уже существовавшее решение, а действительно впервые решёнными выглядят лишь 4 задачи. Более того, из 212 решений, которые выдал ИИ, оказались «содержательно правильными» лишь 6,5 %. Остальные либо имели фундаментальные недостатки (68,5 %), либо решали неправильно интерпретированные агентом версии исходных задач (31,5 %). В результате разработчики согласились, что их ИИ демонстрирует «склонность неверно понимать вопрос таким образом, чтобы на него было легче ответить» и остаётся «крайне подверженным ошибкам по сравнению с людьми». Иными словами, заменить математиков ИИ пока не может. Можно ли клонировать Gemini, завалив её запросами? Google раскрыла мощную дистилляционную атаку

12.02.2026 [22:52],

Николай Хижняк

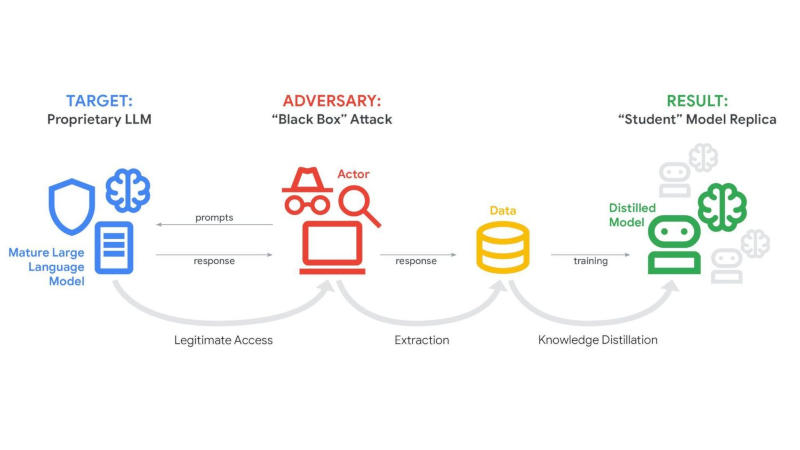

Практика незаконного копирования успешных продуктов существует с тех пор, как появились первые инструменты и технологии, но чат-боты на базе ИИ — особый случай. Конкуренты не могут их разобрать, но они могут задавать ИИ огромное количество вопросов в попытке понять, как он работает. Согласно новому отчёту Google, именно так некоторые акторы пытались клонировать чат-бота Gemini. В одном случае чат-боту было отправлено более 100 тыс. подобных запросов. Google называет это крупномасштабной попыткой извлечения модели.

Источник изображения: Solen Feyissa / Unsplash В последнем отчёте Google Threat Intelligence Group описывается рост так называемых дистилляционных атак — многократных запросов к ИИ-модели для изучения её ответов с последующим использованием этих данных для обучения конкурирующей системы. Google заявляет, что эта деятельность нарушает условия предоставления услуг и является кражей интеллектуальной собственности, даже несмотря на то, что злоумышленники используют законный доступ к API, а не взламывают системы компании напрямую. Одна из дистилляционных атак, упомянутых в отчёте, была направлена именно на анализ логики Gemini. Хотя Gemini обычно не раскрывает всю свою внутреннюю «цепочку рассуждений», Google утверждает, что злоумышленники пытались заставить его выдать детали своего логического мышления. Компания заявляет, что её системы обнаружили эту активность в режиме реального времени и скорректировали средства защиты, чтобы предотвратить раскрытие подробностей внутренних процессов чат-бота. Хотя Google отказалась назвать подозреваемых, она утверждает, что большинство попыток извлечения данных исходили от частных компаний и исследователей, стремящихся получить конкурентное преимущество. Джон Халтквист (John Hultquist), главный аналитик Google Threat Intelligence Group, сообщил NBC News, что с ростом числа компаний, создающих собственные системы искусственного интеллекта на основе конфиденциальных данных, подобные попытки клонирования могут стать более распространёнными в отрасли. Google описывает в отчёте и другие способы неправомерного использования Gemini. Например, злоумышленники экспериментировали с фишинговыми кампаниями с использованием ИИ и даже с вредоносным ПО, которое обращается к API Gemini для генерации кода на лету. Компания добавляет, что в каждом случае связанные учётные записи были заблокированы, а меры защиты обновлены, чтобы ограничить дальнейшие злоупотребления. Аудитория Google Gemini достигла 750 млн активных пользователей в месяц — до ChatGPT осталось совсем чуть-чуть

05.02.2026 [13:18],

Владимир Фетисов

Очередной квартальный отчёт Google показал, что фирменный ИИ-помощник Gemini преодолел отметку в 750 млн активных пользователей в месяц. Этот показатель отражает стремительное распространение Gemini среди потребителей, благодаря которому он быстро стал заметным игроком на рынке ИИ.

Источник изображения: Google В предыдущем квартале Google сообщала о 650 млн ежемесячно активных пользователей Gemini, что свидетельствует о существенном расширении пользовательской базы за достаточно короткий период времени. Хотя Google в этом сегменте продолжает набирать обороты, компания по-прежнему отстаёт от своего главного конкурента в лице OpenAI, чей ИИ-бот ChatGPT к концу 2025 года увеличил пользовательскую базу до 810 млн человек в месяц. Отметку в 750 млн активных пользователей в месяц ИИ-помощник Google перешагнул вскоре после запуска Gemini 3, самой продвинутой языковой модели компании на сегодняшний день. По заявлениям Google, этот ИИ-ассистент даёт ответы с высокой точностью, а также беспрецедентной глубиной и с учётом разных нюансов. Гендиректор Google Сундар Пичаи (Sundar Pichai) отметил, что запуск Gemini 3 оказал позитивное влияние на рост компании, а также добавил, что дальнейшие инвестиции и совершенствование ИИ-моделей позволят поддерживать эту динамику. Недавно Google запустила новый тарифный план Google AI Plus стоимостью $8 в месяц, который, как ожидается, обеспечит дальнейший рост пользовательской аудитории. Коммерческий директор Google Филипп Шиндлер (Philipp Shindler) во время встречи с инвесторами отметил, что компания наблюдает хороший рост пользовательской аудитории и сосредоточена на дальнейшем развитии тарифной сетки. |