|

Опрос

|

реклама

Быстрый переход

Google обновит аккаунты в Play Games — они станут похожими на профили в Steam

02.09.2025 [10:49],

Владимир Фетисов

Google готовит крупное обновление сервиса Play Games, в котором уже в этом месяце появятся общедоступные профили игроков, похожие на то, что можно увидеть в Steam. В новых профилях будут отображаться статистические и прочие сведения о времени, проведённом за играми на Android и Windows. Начиная с 23 сентября, профили Play Games начнут обновляться, и в них появятся «новые социальные функции».

Источник изображения: Greg Bulla / Unsplash Игровые профили Google Play существуют давно, но они не всегда доступны, и, безусловно, в них отсутствуют какие-либо социальные функции. В нынешнем виде в профилях попросту отображаются достижения пользователя. Детали того, как изменятся профили Play Games неясны, но, ожидается, они станут похожими на то, что можно увидеть в Steam. Общедоступные профили в Steam могут показывать, в какие игры играл пользователь, какие достижения он заработал и др. Как и в Steam, Google позволит пользователям изменять настройки профиля, чтобы при необходимости можно было скрыть отображение каких-либо данных. «Начиная с 23 сентября, мы будем обновлять профили Play Games. В вашем профиле будет отображаться статистика игр, которые вы установили из Google Play, а также появятся новые социальные функции. Ваш профиль и связанные с ним функции скоро появятся прямо в Google Play, за счёт чего вам будет проще получить доступ ко всем нашим игровым предложениям. Чтобы использовать функции и сервисы, связанные с вашим игровым профилем, Google будет собирать информацию об используемых вами играх, например, о том, в какие игры вы играли и когда делали это. Мы также будем использовать эти данные для улучшения игрового процесса в Google Play», — говорится в сообщении Google. В Google отметили, что разработчики приложений также смогут передавать в компанию данные об активности пользователей в играх. После обновления профиля к нему будут применены настройки видимости, аналогичные тем, что были выбраны пользователем ранее. Например, если пользователь выбрал вариант «Видимый для всех», то информация в обновлённом профиле также будет видна всем. Для обновления профиля пользователю не потребуется предпринимать каких-либо действий, это произойдёт автоматически. Мобильный Google Chrome получил новый пользовательский интерфейс в стиле Material 3 Expressive

01.09.2025 [19:55],

Сергей Сурабекянц

Google анонсировала новый язык дизайна Material 3 Expressive в мае текущего года. С тех пор компания последовательно внедряет его во все свои мобильные приложения. Ранее новым пользовательским интерфейсом обзавелись Gmail и Google Clock, а теперь пришло время и для браузера Chrome. По утверждению тестировщиков, новый дизайн «придаёт группе вкладок Chrome более красочный вид».

Источник изображения: Google В июне дизайн Material 3 Expressive стал доступен в предварительной версии Google Chrome Canary. C сегодняшнего дня новый интерфейс стал доступен в стабильной версии браузера. Таким образом, браузер Chrome присоединился к постоянно растущему списку приложений Google, получивших обновление в стиле Material 3 Expressive. В мобильном Chrome с новым дизайном индикатор загрузки страницы получил закруглённые углы. Значки, появляющиеся при нажатии на три горизонтальные точки в правом верхнем углу, также получили небольшое изменение дизайна. Все значки, включая «Перейти вперёд», «Закладка», «Загрузить», «Информация о сайте» и «Обновить», теперь помещены в круглые контейнеры. Кроме того, значки верхней панели больше не отделены от нижнего меню. Кнопка «Новая вкладка» на странице сетки вкладок теперь заключена в квадратный блок со скруглёнными углами. Изменён вид значка режима «Инкогнито», а все вкладки и группы вкладок помещены в прямоугольный блок. Интерфейс группы вкладок также обновлён. В отличие от предыдущей версии, когда выбранный цвет отображался только точкой на карточке группы вкладок, в новой версии Chrome выбранный цвет применяется ко всей группе вкладок. В целом, Google продолжает придерживаться традиционного дизайна Chrome, даже в интерфейсе Material Expressive 3. Обновление пользовательского интерфейса стартовало 31 августа и в течение ближайших дней должно стать доступно для пользователей по всему миру. Meta✴ может начать использовать ИИ-модели Google и OpenAI в своих приложениях

31.08.2025 [10:31],

Владимир Фетисов

Компания Meta✴✴ Platforms рассматривает возможность партнёрства с конкурентами, такими как Google и OpenAI, с целью расширения возможностей искусственного интеллекта в своих приложениях. Об этом пишет информационное агентство Reuters со ссылкой на собственные осведомлённые источники.

Источник изображения: Steve Johnson / Unsplash В сообщении сказано, что руководители ИИ-подразделения Meta✴✴ Superintelligence Labs изучают возможность интеграции ИИ-модели Google Gemini с целью предоставления текстовых ответов на пользовательские запросы, получаемые чат-ботом Meta✴✴ AI. Вместе с этим они рассмотрели возможность использования ИИ-моделей OpenAI для повышения качества работы Meta✴✴ AI и других ИИ-функций в приложениях компании. Любые сделки Meta✴✴ с конкурентами, такими как Google и OpenAI, следует рассматривать как временное явление, необходимое до тех пор, пока компания не завершит разработку собственных алгоритмов. Приоритетной задачей ИИ-подразделения Meta✴✴ является обеспечение того, чтобы собственная ИИ-модель Llama 5 могла успешно конкурировать с передовыми аналогами других компаний. По данным источника, Meta✴✴ уже интегрировала ИИ-модели сторонних разработчиков в некоторые внутренние инструменты, предназначенные для сотрудников компании. К примеру, это касается ИИ-помощника по написанию программного кода, которым пользуется персонал Meta✴✴. Официальные представители OpenAI и Google воздерживаются от комментариев по данному вопросу. ЕС всё же оштрафует Google за антиконкурентное поведение, но наказание будет скромным

30.08.2025 [10:43],

Владимир Мироненко

В ближайшие недели компании Google могут назначить в ЕС штраф за нарушение антимонопольного законодательства, выразившееся в антиконкурентном поведении в сфере рекламных технологий, однако его размер будет небольшим, сообщает агентство Reuters со ссылкой на источники, знакомые с ситуацией.

Источник изображения: Guillaume Périgois/unsplash.com Решение Европейской комиссии по поводу штрафа подводит итог четырёхлетнего расследования, начатого по иску Европейского совета издателей. В 2023 году Google обвинили в том, что компания якобы отдаёт предпочтение своим рекламным сервисам по сравнению с конкурентами. Хотя ранее говорилось о возможном крупном штрафе, его размер будет относительно небольшим. По словам источников, вице-президент ЕК по вопросам конкуренции Тереза Рибера (Teresa Ribera), в отличие от своей предшественницы Маргреты Вестагер (Margrethe Vestager), предпочитавшей накладывать значительные взыскания за нарушение законодательства ЕС, стремится не к карательным мерам, а к прекращению использования антиконкурентных практик. В ответ на просьбу прокомментировать публикацию Reuters Google сослалась на запись в блоге от 2023 года, где компания раскритиковала «ошибочную интерпретацию» Еврокомиссией работы сектора рекламных технологий и заявила, что и издатели, и рекламодатели располагают широким выбором. Как отмечает Reuters, новый штраф будет существенно меньше рекордного взыскания в €4,3 млрд, наложенного на Google антимонопольным органом ЕС в 2018 году за использование мобильной ОС Android для подавления конкурентов. Компания также была оштрафована на €2,42 млрд в 2017 году за использование собственного сервиса сравнения цен для получения несправедливого преимущества перед европейскими конкурентами, а также на €1,49 млрд в 2019 году за злоупотребление доминирующим положением при запрете использования веб-сайтами сторонних сервисов вместо её платформы AdSense. Лучшая защита — нападение: Google начнёт проводить кибератаки на хакеров

29.08.2025 [17:00],

Павел Котов

Компания Google собирается занять более активную позицию в защите себя и, возможно, других американских организаций от кибератак — в компании допустили, что она может взять на себя роль нападающей в цифровом поле, передаёт CyberScoop.

Источник изображения: Greta Schölderle Möller / unsplash.com В ближайшие месяцы Google планирует сформировать «группу активного противодействия» для борьбы с киберпреступниками, сообщила вице-президент подразделения Google Threat Intelligence Group Сандра Джойс (Sandra Joyce). «Мы в Google Threat Intelligence Group занимаемся проактивным выявлением возможностей по фактическому пресечению каких-либо кампаний или операций. Нам придётся перейти от реактивной к проактивной позиции, <..> если хотим изменить ситуацию прямо сейчас», — такое заявление она сделала на профильном мероприятии, по итогам которого был опубликован доклад «Взломать или не взломать в ответ? Вот в чём вопрос... или нет?». В документе обсуждаются идеи о том, следует ли властям США дать частным компаниям разрешение на проведение наступательных кибератак, поможет ли воздействие вне цифрового поля эффективно сдерживать противников, или, возможно, следует бросить ресурсы на совершенствование средств киберзащиты. В июле Конгресс США принял «Большой прекрасный законопроект», который, в частности, предусматривает выделение $1 млрд на наступательные кибероперации. Это не значит, что компании вроде Google в одночасье начнут взламывать какие-то ресурсы, но отражает дальнейшее направление политики США по данному вопросу — по меньшей мере, в лице администрации действующего президента. А 15 августа был внесён проект «Закона о разрешении на каперские свидетельства и репрессалии на мошеннические фермы 2025 года», который наделяет главу государства правом «выдавать каперские свидетельства и репрессалии в отношении актов агрессии против Соединённых Штатов, совершенных членом преступной организации или любым участвующим в сговоре лицом, связанным с замешанной в киберпреступлениях организацией». Каперскими свидетельствами во времена парусного флота назывались документы, от имени государства разрешавшие частным судам действовать пиратскими методами; под репрессалиями понимались принудительные меры политического или экономического характера, принимаемые одним государством в ответ на неправомерные действия другого — сейчас эти меры называются санкциями. Таким образом, власти США дают сигнал, что они готовы идти на крайние меры, чтобы отбить у киберпреступников других стран желание атаковать американские организации. Конкретных форм инициатива пока не обрела. В приложении «Телефон» на Android появились новые «визитные карточки» для контактов

28.08.2025 [11:21],

Владимир Фетисов

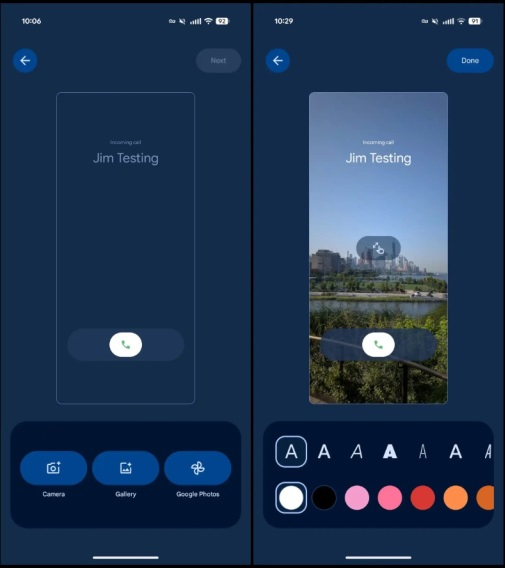

Ранее в этом месяце Google обновила дизайн Android-приложения «Телефон» в стиле Material 3 Expressive. Вместе с этим в нём появились новые «визитные карточки». Эти изображения можно добавлять к контактам из адресной книги, после чего они будут отображаться при входящих и исходящих звонках.

Источник изображений: 9to5google.com В верхней части вкладки «Главная» отображается сообщение: «Представляем визитную карточку: настройте, как вы будете видеть контакт, когда он позвонит вам». Установить визитные карточки также можно в меню контактов. Для этого необходимо перейти в раздел визитных карточек, в котором представлены все добавленные к контактам изображения.  После того, как пользователь выбрал нужный контакт, можно установить изображение визитной карточки, задействовав для этого фотоснимок, картинку из галереи или «Google Фото ». Здесь же можно обрезать изображение, добавить рамку и имя контакта с помощью карусели с разными шрифтами и цветами.  После настройки выбранное изображение будет демонстрироваться на экране устройства при звонках данному контакту. По данным источника, новые визитные карточки доступны в стабильной версии приложения «Телефон» версии 188, которое пока доступно на фирменных смартфонах Google Pixel 10. Google заявила о своей непричастности к сбоям Google Meet в России

28.08.2025 [10:59],

Павел Котов

Google заявила, что с её стороны сбоев в работе службы видеосвязи Google Meet не наблюдается, и к возникшим у россиян проблемам с этим сервисом компания отношения не имеет. Такой комментарий Google дала ресурсу РБК.

Источник изображения: Rubaitul Azad / unsplash.com «Нам известно о проблемах с доступом пользователей к Google Meet в России; это не связано с техническими проблемами на стороне Google», — заявили в американской компании. Накануне от россиян начали поступать жалобы на сбои в работе службы Google Meet — наибольшее число обращений отмечено в 12:15 мск. К 20:40 мск были зафиксированы более 1,5 тыс. жалоб. Чаще всего сообщалось, что не открываются приложение или сайт, отказывается работать функция звонков или отсутствует звук. Роскомнадзор также заявил о своей непричастности к происходящему. Ранее ведомство ограничило звонки в популярных мессенджерах Telegram и WhatsApp, и сервис Google Meet быстро вышел на второе место в списке самых скачиваемых приложений российского раздела Apple App Store. Частичную блокировку звонков в Telegram и WhatsApp власти объяснили стремлением оградить россиян от мошенников. Google открыла доступ к Vids для всех: ИИ-видеоредактор стал бесплатным, но не без ограничений

27.08.2025 [19:21],

Анжелла Марина

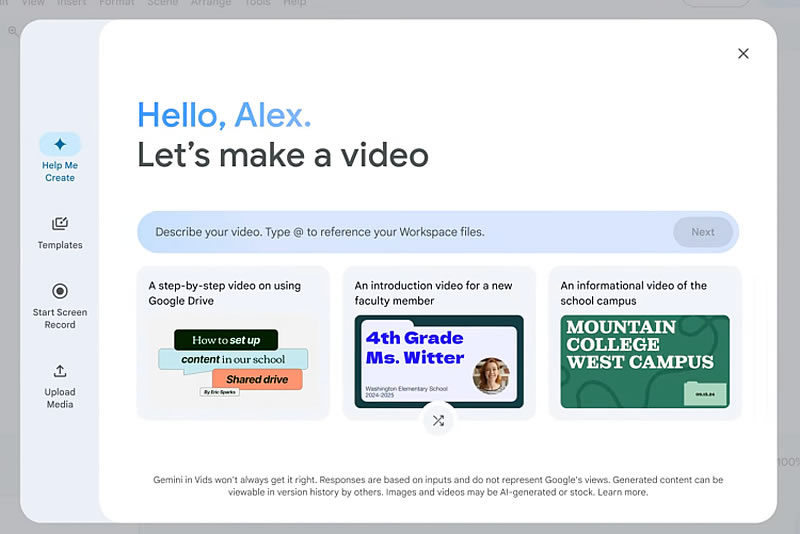

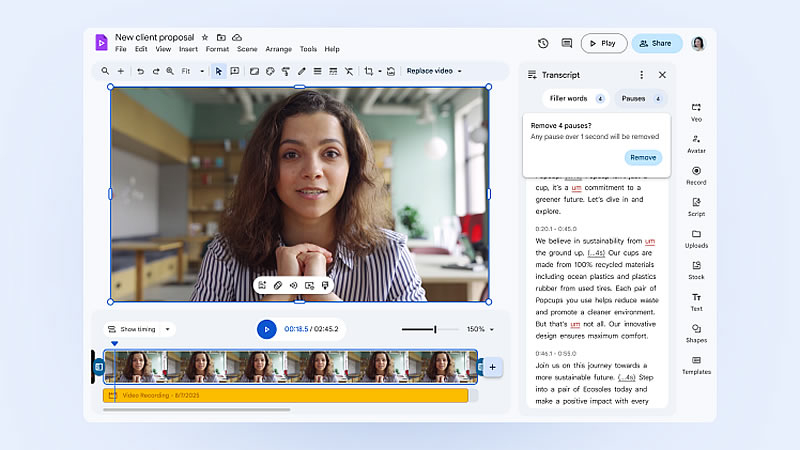

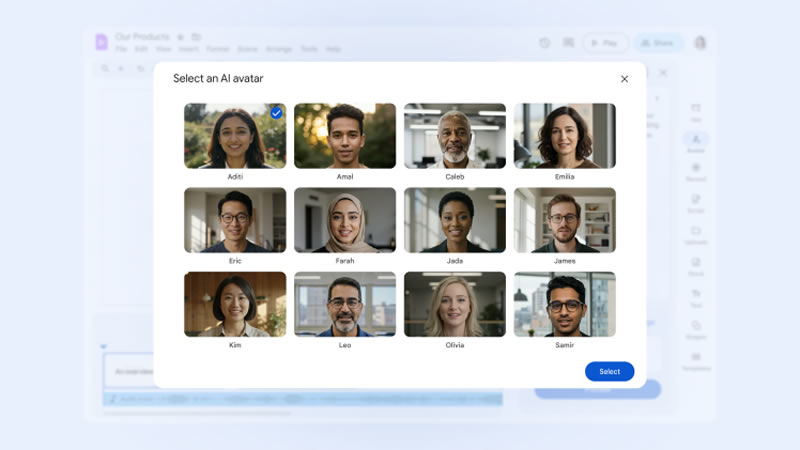

Google запустила бесплатную версию видеоредактора Vids, работающего на базе искусственного интеллекта (ИИ). Ранее этот инструмент был доступен исключительно подписчикам Google Workspace и специальных тарифов с ИИ, но теперь все пользователи смогут использовать его базовую версию, которая включает шаблоны, стоковый медиаконтент и ограниченный набор ИИ-возможностей.

Источник изображений: Google Vids, представленный в прошлом году как часть пакета Workspace, предназначен для быстрого создания видео-презентаций. Он помогает пользователям формировать раскадровки, предлагая сцены, подбирая стоковые изображения и фоновую музыку с помощью алгоритмов. Как сообщает The Verge, ссылаясь на слова директора по продукту Вишну Шиваджи (Vishnu Sivaji), упрощённая версия сохраняет значительную часть основных возможностей приложения, однако в ней отсутствуют некоторые новейшие ИИ-функции, анонсированные одновременно с открытием доступа. В частности, бесплатная версия не позволяет использовать ИИ-аватары для озвучивания текста от имени пользователя.  В рамках обновления платные подписчики получат доступ к выбору из 12 готовых аватаров с уникальной внешностью и голосом, в которые можно загружать собственный сценарий. При этом функция создания персонального ИИ-аватара, аналогичная реализованной в Zoom, в Vids пока недоступна. На вопрос о такой возможности Шиваджи ответил, что компания не готова делиться планами на этот счёт.  Также Google расширила возможности генерации видео: теперь можно создавать 8-секундные ролики на основе конкретного изображения, например фотографии нового продукта. Кроме того, появился инструмент, автоматически удаляющий из записи слова-паразиты и паузы, что полезно при подготовке собственных видео для презентаций. В компании считают, что новые функции помогут бизнесу сэкономить время и деньги при производстве видеоконтента различного назначения, в том числе обучающих роликов, так как, по словам Шиваджи, традиционное производство даже 10-минутного видео с живыми актёрами может занимать до полугода и обходиться в десятки тысяч долларов из-за затрат на написание сценария, его согласование, аренду студии, съёмку и монтаж. Миссия выполнима: ИИ-агент Google самостоятельно нашёл критическую уязвимость в браузере Chrome

27.08.2025 [19:07],

Сергей Сурабекянц

В очередном обновлении безопасности браузера Chrome Google исправила критическую уязвимость (CVE-2025-9478), обнаруженную автономным инструментом на основе ИИ под названием Google Big Sleep. Этот ИИ-агент разработан на базе нейросети Gemini и предназначен для обнаружения уязвимостей без участия человека. Обязательная проверка, произведённая специалистами-людьми, показала правоту Big Sleep.

Источник изображения: unsplash.com Google исправила критическую уязвимость в версиях Chrome 139.0.7258.154/155 для Windows и macOS, в версии 139.0.7258.154 для Linux и в Chrome для Android версии 139.0.7258.158. Ожидается, что производители других браузеров на базе Chromium последуют этому примеру в ближайшие дни. В блоге компании устранённая уязвимость описана, как обнаруженная внешними специалистами по безопасности, однако её первооткрывателем назван именно Google Big Sleep. Поскольку к результатам проверки безопасности, полученным с помощью подобных инструментов, следует относиться с осторожностью, они всегда перепроверяются экспертами. Google не раскрывает информации о проценте ошибочных диагнозов Big Sleep. Однако в описываемом случае ИИ-агент отработал в лучших традициях специальных агентов из фильмов-блокбастеров. Google классифицирует CVE-2025-9478 (уязвимость использования памяти после освобождения в графической библиотеке Angle) как критическую. По данным Google, она пока не эксплуатировалась для реальных атак. В предыдущем обновлении безопасности Chrome, выпущенном неделю назад, Google также закрыла уязвимость безопасности, обнаруженную Big Sleep. Пока неясно, насколько востребованными являются подобные инструменты искусственного интеллекта для поиска уязвимостей в программном коде. Есть вероятность, что компания специально привлекает внимание общественности к достижениям ИИ, так как кровно заинтересована в продолжении бума искусственного интеллекта и внедрении ИИ везде, где только возможно. Текущие версии браузеров Microsoft Edge, Brave и Vivaldi в настоящее время ещё не получили исправления уязвимости CVE-2025-9478. При этом Vivaldi основан не на Chromium 139, а на Chromium 138 из расширенного стабильного канала. Несмотря на обновление от 25 августа, Opera по-прежнему использует устаревший Chromium 135, для которого Google не выпускала обновления с конца апреля. Следующая версия Opera, которая будет работать на Chromium 137, всё ещё находится на стадии бета-тестирования. Google планирует выпустить Chrome 140 на следующей неделе, а некоторые пользователи уже получили доступ к пробной версии на этой неделе. Обычно Chrome обновляется автоматически при выходе новой версии. Для запуска обновлений вручную следует в меню «Справка» выбрать пункт «О Google Chrome». Google Meet опять «штормит» — россияне массово жалуются на сбои сервиса в России

27.08.2025 [15:52],

Владимир Мироненко

Российские пользователи сообщают о сбоях в работе сервиса видеоконференций Google Meet, о чём свидетельствуют данные портала Downdetector. В основном жалуются на то, что при подключении не слышно коллег на встрече, а также на то, что спустя короткое время после подключения сервис разрывает соединение.

Источник изображения: Rubaitul Azad/unsplash.com За сутки на работу сервиса поступили 1253 жалобы. 58 % пользователей сообщили о сбое сайта, 30 % — о сбое мобильного приложения, 6 % отметили общий сбой. Больше всего сообщений о сбое поступило из Санкт-Петербурга — около 10 % всех жалоб. Также со сбоями столкнулись пользователи из Москвы и Московской области (по 5 %), Архангельской и Калининградской областей — тоже по 5 %. Как отметили «Ведомости», первые сообщения о сбоях в работе Google Meet стали поступать 22 августа, через девять дней после объявления Роскомнадзора о частичной блокировке звонков в мессенджерах Telegram и Whatsapp. В РКН тогда заявили изданию, что ведомство не ограничивало звонки в сервисе Google Meet. Вместе с тем, 23 августа в МВД РФ сообщили, что мошенники начали тестировать альтернативные приложения для обхода блокировок, выбрав в качестве основного канала коммуникаций с потенциальными жертвами сервис Google Meet. Google выпустила «ИИ-фотошоп» — в Gemini встроили модель nano-banana, которая может точно редактировать картинки

27.08.2025 [11:06],

Павел Котов

Google обновила чат-бот Gemini, добавив в него основанную на алгоритмах искусственного интеллекта функцию для обработки изображений — она позволяет с высокой точностью контролировать процесс редактирования фотографий. Поисковый гигант стремится выйти на уровень средств обработки изображений от OpenAI и привлечь аудиторию ChatGPT.

Источник изображения: blog.google Обновление Gemini 2.5 Flash Image доступно всем пользователям приложения Gemini, а также разработчикам на платформах Gemini API, Google AI Studio и Vertex AI. Новый редактор обрабатывает изображения с высокой точностью на основе запросов простым естественным языком. Он сохраняет единообразие лиц, животных и другие детали, что не всегда под силу конкурирующим инструментам: например, если попросить ChatGPT или xAI Grok изменить на фотографии цвет чьей-то рубашки, на выходе можно получить искажённое лицо или изменения на фоне. Google Gemini 2.5 Flash Image уже завоевала признание пользователей — компания открыла доступ к ней на платформе LMArena под названием «nano-banana». Это не отдельная модель ИИ, а встроенная функциональность существующей Gemini 2.5 Flash AI. «Мы по-настоящему повысили качество работы с изображением, а также способность модели следовать инструкциям. Это обновление значительно улучшает процесс редактирования, делая его более органичным, а результаты работы модели — пригодными для любых целей», — рассказала ресурсу TechCrunch руководитель направления по генеративным визуальным моделям в Google DeepMind Николь Брихтова (Nicole Brichtova). Модель обладает глубокими знаниями о мире и позволяет задавать в запросе несколько образцов — например, изображение дивана, гостиной и цветовой палитры можно совместить в едином ответе. «Мы хотим дать пользователям свободу творчества, чтобы они могли получить от моделей то, что хотят. Но это не похоже на что-то другое», — добавила госпожа Брихтова. Google приняла некоторые меры для борьбы с ростом числа дипфейков: на сгенерированные ИИ изображения добавляются визуальные водяные знаки и идентификаторы в метаданных. Google кардинально обновила дизайн мобильного приложения Gmail в стиле Material 3 Expressive

27.08.2025 [07:02],

Владимир Фетисов

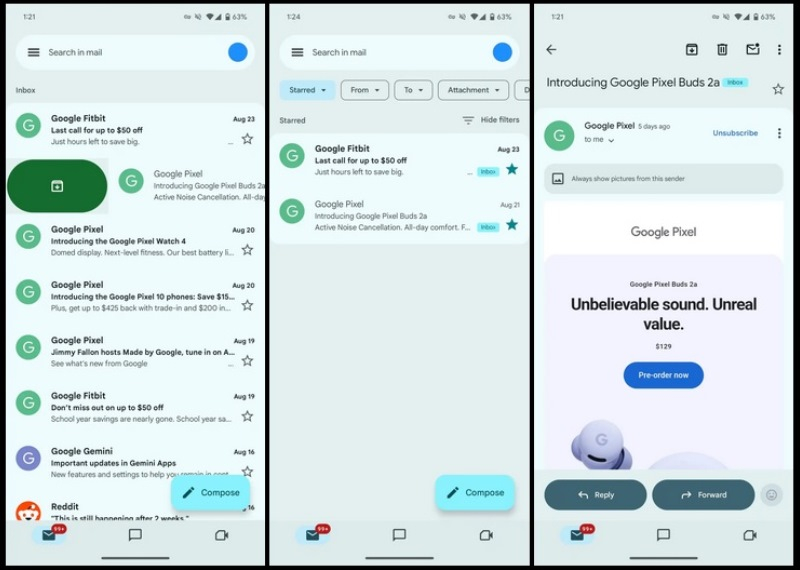

Приложение почтового сервиса Gmail стало одним из первых, где Google тестировала новый пользовательский интерфейс, соответствующий языку дизайна Material 3 Expressive. Теперь же началась масштабное распространение этого нововведения.

Источник изображений: 9to5google.com На главной странице и в некоторых других разделах список сообщений отображается внутри единого блока со скруглёнными углами в верхней и нижней областях. Действия, выполняемые с помощью свайпов (архивирование, удаление и др.), дополняются новой анимацией. В нынешнем виде поле в верхней части рабочего пространства не является панелью поиска, но Google тестировала такой вариант в бета-версиях приложения в последние несколько недель. При открытии какого-то письма стиль оформления сохраняется, а в верхней части окна отображается строка с темой сообщения. Одно из заметных изменений, внесённых в первоначальный дизайн Gmail, заключается в том, что контуры кнопок стали более объёмными. В режимах «Ответить» и «Переслать» разработчики задействовали более динамичный оттенок, значительно выделяющийся на фоне нижней панели.  Распространение обновлённого дизайна мобильного приложения началось на этой неделе. На данном этапе на изменения обратили внимание пользователи Android-версий Gmail 2025.08.11.x. Вероятно, потребуется некоторое время, прежде чем дизайн Gmail в стиле Material 3 Expressive станет доступен всем пользователям. Google оштрафовали на 7 млн рублей за работу в России без регистрации в Роскомнадзоре

26.08.2025 [21:12],

Владимир Мироненко

Таганский районный суд города Москвы признал компанию Google виновной в совершении административного правонарушения, выразившемся в осуществлении деятельности в России без регистрации в Роскомнадзоре, назначив штраф в размере более 7 млн руб., сообщает РБК со ссылкой на Telegram-канал объединённой пресс-службы судов общей юрисдикции Москвы.

Источник изображения: Firmbee.com/unsplash.com «Постановлением мирового судьи судебного участка Nº 422 Таганского района города Москвы «Гугл ЛЛС» (Google LLC) признано виновным в совершении административного правонарушения, предусмотренного ч. 2 ст. 13.49 КоАП России», — указано в сообщении. Статьёй предусматривается ответственность за осуществление деятельности иностранным юридическим лицом без регистрации в Роскомнадзоре или без открытия филиала на территории России в виде административного штрафа в размере не более 10 млн руб. До этого задолженность американской компании по штрафам составляла 27,2 млрд руб., не считая претензий российских телеканалов к ней за блокировку их аккаунтов на YouTube, начисливших неустойку, исчисляемую в дуодециллионах руб. В основном штрафы были назначены из-за отказа компании удалить с платформы YouTube фейки и экстремистские материалы, призывы к массовым беспорядкам, популяризацию VPN-сервисов и другие запрещённые материалы. XR-гарнитура Samsung Project Moohan будет представлена 29 сентября, если слухи верны

26.08.2025 [16:31],

Владимир Мироненко

Согласно данным южнокорейского издания NewsWorks, компания Samsung представит гарнитуру расширенной реальности (XR) Project Moohan на мероприятии Galaxy Unpacked 29 сентября 2025 года. Устройство сначала поступит в продажу в Южной Корее 13 октября, а затем постепенно появится на других рынках.  По словам источников NewsWorks, цена Project Moohan составит от 2,5 до 4 млн корейских вон (около $1800–2000), что дешевле, чем Apple Vision Pro за $3500, но к числу бюджетных продуктов устройство отнести нельзя. Ранее сообщалось, что Samsung не ждёт от гарнитуры огромного успеха на старте, планируя реализовать в этом году около 100 тыс. экземпляров. Для сравнения: Apple поставила в прошлом году на рынок 224 тыс. гарнитур Vision Pro, а продажи Meta✴✴ Quest 3 после выхода в октябре 2023 года достигли около 1 млн единиц к июню 2024-го. Гарнитура Project Moohan на программной платформе Android XR является плодом сотрудничества Samsung и Google. В разработке Google Android XR также участвовала Qualcomm. Инсайдеры не исключают, что в продажу новинка поступит под названием Galaxy XR. На данный момент известно, что гарнитура построена на чипсете Snapdragon XR2 Gen 2 и оснащена 16 Гбайт оперативной памяти. В комплект поставки будет входить внешний аккумулятор. ИИ-блокнот NotebookLM научился делать видеообзоры на русском и десятках других языков

26.08.2025 [01:04],

Анжелла Марина

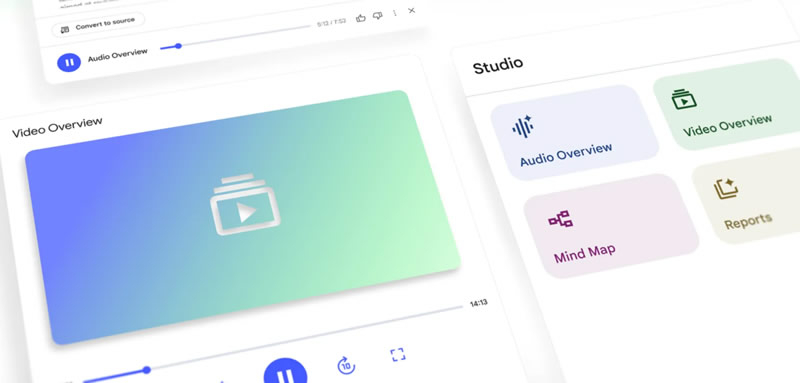

Google объявила о расширении функции видеобзоров (Video Overviews) в ИИ-помощнике NotebookLM. Теперь приложение поддерживает более 80 языков, включая русский, французский, немецкий, испанский и японский. Одновременно улучшены аудиообзоры (Audio Overviews) для неанглоязычных пользователей — они стали более подробными.

Источник изображения: Google Функция видеобзоров, позволяющая превращать заметки, PDF-документы и изображения в видеопрезентации, была запущена в прошлом месяце и изначально работала только на английском языке. Теперь пользователи могут получать визуальные сводки и на родном языке, сообщает издание TechCrunch. Ранее аудиообзоры на других языках ограничивались краткими версиями, а полные сводки были доступны исключительно на английском. После обновления расширенные аудиообзоры также стали доступны на более чем 80 языках, включая русский. При этом сохранена возможность выбора краткой версии для тех, кому нужны лишь ключевые моменты. По словам разработчиков, эти шаги направлены на то, чтобы глобальная аудитория NotebookLM могла использовать ИИ-ассистента максимально эффективно и комфортно, независимо от родного языка. Обновления начали поступать пользователям сегодня и будут развёрнуты по всему миру в течение ближайшей недели. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |