|

Опрос

|

реклама

Быстрый переход

Гендир Тан собрался возродить в Intel разработку GPU для дата-центров — для этого переманили топ-архитектора из Qualcomm

04.02.2026 [04:52],

Алексей Разин

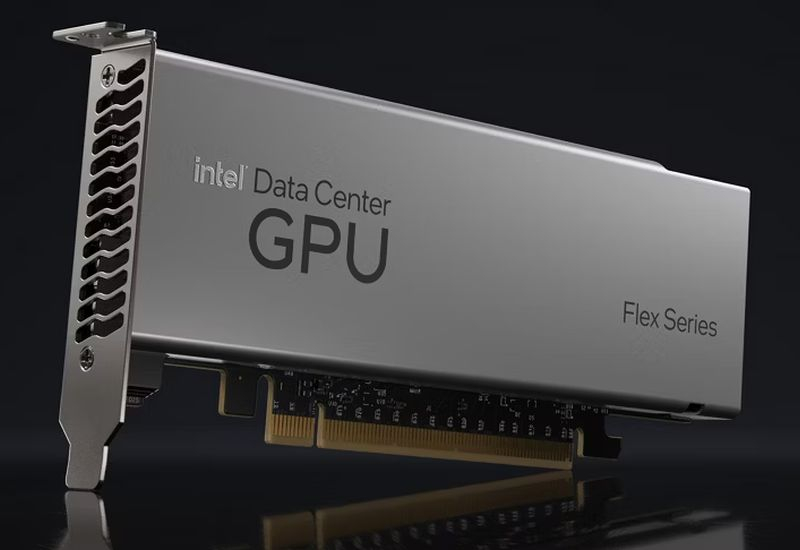

Попытки компании Intel вернуться на рынок дискретной графики предпринимаются с прошлого десятилетия, в 2017 году соответствующие усилия возглавил перешедший из конкурирующей AMD Раджа Кодури (Raja Koduri), но почти три года назад он покинул Intel. Нынешний глава компании объявил, что недавно назначил нового главного архитектора GPU.

Источник изображения: Intel Эти заявления прозвучали из уст Лип-Бу Тана (Lip-Bu Tan) на конференции Cisco AI Summit, как отмечает CNBC. Не называя имени нового руководителя этого направления, глава Intel дал понять, что на уговоры кандидата ушло немало усилий и времени. В любом случае, для реализации изменений в сфере разработки графических процессоров Intel придётся потратить несколько лет, поэтому эффект от нового назначения не будет сиюминутным. Скорее всего, усилия нового руководителя будут направлены на разработку линейки конкурентоспособных ускорителей Intel для сегмента искусственного интеллекта. Собственные разработки наверняка будут сочетаться с использованием ноу-хау поглощаемых Intel стартапов, как это было ранее. Одновременно Лип-Бу Тан назвал искусственный интеллект главным вызовом для рынка памяти, который переживает небывалый рост цен и сталкивается с дефицитом микросхем. По мнению главы Intel, улучшения ситуации нет смысла ждать ранее 2028 года. Ветеран Qualcomm перешёл в Intel, чтобы разрабатывать серверные GPU

17.01.2026 [07:43],

Алексей Разин

Попытки Intel разрабатывать высокопроизводительные графические процессоры тянутся уже несколько десятилетий, ради достижения таких целей компания то и дело привлекает специалистов с опытом работы у конкурентов. Свежим кадровым приобретением в этой сфере стал переход в Intel ветерана Qualcomm, который на прежнем месте руководил разработкой GPU.

Источник изображения: LinkedIn Речь идёт об Эрике Демерсе (Eric Demers), как поясняет издание CRN. Он около 14 лет проработал в Qualcomm, в последнее время он занимал в компании пост старшего вице-президента по разработкам. Со следующей недели Эрик Демерс займёт аналогичную должность в Intel, где также будет руководить разработкой GPU с уклоном на применение в сегменте искусственного интеллекта. По словам аналитиков Moor Insights and Strategy, Демерс является не только опытным руководителем, но и компетентным разработчиком архитектур GPU. Ему вполне по силам разработать графический процессор с нуля, как подчёркивают эксперты. В Qualcomm Демерс курировал разработку графических ядер семейства Adreno, которые применялись в мобильных устройствах и ПК, а также в сегменте Интернета вещей, устройствах дополненной и виртуальной реальности и автомобильной электронике. Поскольку семейство процессоров Snapdragon X2 предназначалось для использования в ПК, опыт их разработки должен помочь Демерсу на новом рабочем месте. До перехода в Qualcomm в 2012 году Эрик Демерс успел поработать техническим директором подразделения AMD, которое отвечало за разработку графических решений. Демерс успел поработать в ATI, прежде чем её поглотила в 2006 году компания AMD, а ранее он трудился в Silicon Graphics. Intel в последние годы не только теряет руководителей и занимается постоянной реструктуризацией, но и не может нащупать почву для развития линейки своих ИИ-ускорителей. Поглощая профильные стартапы, она не может добиться внятного успеха на этом рынке, где доминирует Nvidia. Органическое же развитие в сфере серверных GPU потребует нескольких лет, но приглашение профессионалов в сфере их разработки подчёркивает, что Intel готова двигаться этим путём. Китайский производитель Zephyr рассказал о поломках Radeon RX 6000 из-за трещин, вздутий и короткого замыкания в GPU

28.12.2025 [21:42],

Николай Хижняк

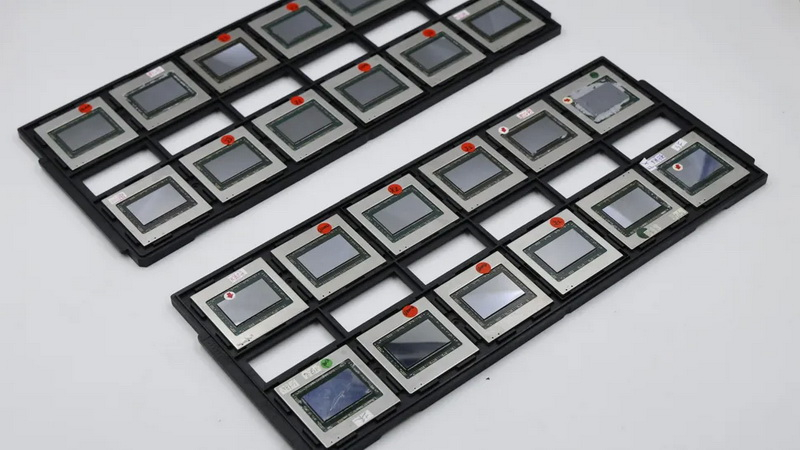

В 2023 году начали появляться сообщения о выходящих из строя видеокартах Radeon RX 6000 на базе графических процессоров Navi 21, что вызвало вопросы о причинах этих инцидентов. Хотя это было, по сути, локальное, изолированное событие, которое с тех пор было урегулировано, спустя два года появилась новая информации.

Источник изображений: Zephyr Китайский производитель видеокарт Zephyr вдруг сообщил, что на сегодняшний день заменил по гарантии множество высокопроизводительных видеокарт Radeon RX 6000 (в частности, RX6800/RX6900XT) на архитектуре RDNA 2, у которых были неисправными графические чипы. Компания также продемонстрировала сами чипы, вышедшие из строя из-за трещин, вздутий или короткого замыкания. По словам Zephyr, существует «вероятность в 1 % подобных инцидентов каждый год», имея в виду вероятность для пользователей встретится с такими повреждениями GPU. Компания опубликовала фотографии лотка с неисправными графическими чипами, которые были заменены в рамках гарантийных обязательств. Она заявила, что в то время как другие производители часто отказывают в гарантийном обслуживании в таких случаях, Zephyr всегда выполняла свои обязательства и будет продолжать это делать. В сообщении компания говорит о серьёзных ошибках бренда в обслуживании клиентов, но при этом подчеркивает и положительные моменты. На китайском видеохостинге Bilibili опубликовано видео, демонстрирующее эти GPU крупным планом, с различными деформациями. Большинство из них вышло из строя из-за короткого замыкания. На некоторых чипах заметно вздутие со стороны задней части подложки, у некоторых треснули кристаллы. Все эти вышедшие из строя графические процессоры хранятся в офисах Zephyr как напоминание о клиентах, которым они помогли. Как пишет портал Tom’s Hardware, на момент появления первых сообщений о подобных повреждениях графических процессоров серии RX 6000, один немецкий ритейлер объяснил их выход из строя сочетанием криптовалютного бума (многие карты с такими повреждениями активно использовались в майнинге), а также эксплуатацией GPU в условиях высокой влажности. Однако публичных жалоб пользователей на подобные инциденты не было, поскольку это не было масштабной проблемой. Энтузиаст использовал тепловые трубки процессорного кулера для жидкостного охлаждения GPU

07.12.2025 [07:24],

Анжелла Марина

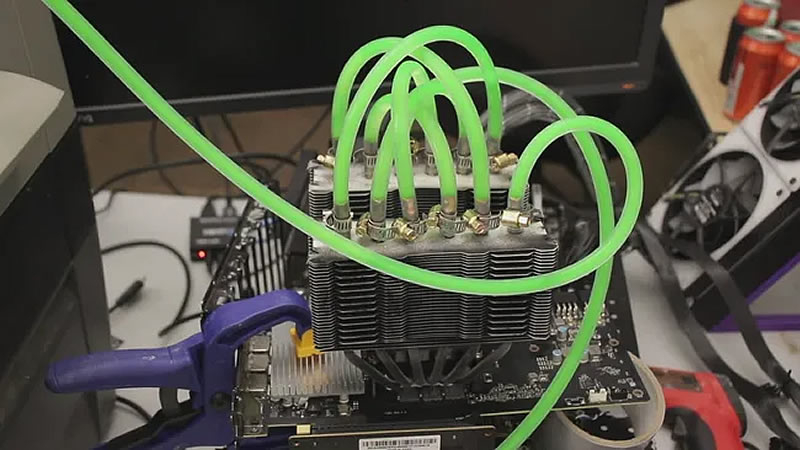

Энтузиаст TrashBench реализовал нестандартный моддинг-проект, в ходе которого переделал воздушный кулер Thermalright Peerless Assassin в гибридную систему охлаждения для видеокарты. В основе модификации лежит использование тепловых трубок кулера в качестве каналов для циркуляции охлаждающей жидкости.

Источник изображения: TrashBench/YouTube Тепловые трубки в стандартных воздушных кулерах представляют собой герметичные полости, частично заполненные рабочей жидкостью. При нагреве жидкость испаряется в зоне контакта с источником тепла (у медного основания), а пар перемещается к более холодной части — рёбрам радиатора, где конденсируется и возвращается к основанию под действием капиллярных сил, обеспечивая непрерывный фазовый перенос тепла. В данном случае моддер аккуратно удалил часть алюминиевых пластин радиатора, обнажив тепловые трубки, а затем срезал их верхние участки, чтобы получить доступ к внутренним каналам, ведущим непосредственно к медному основанию. К этим каналам, как пишет Tom's Hardware, были герметично подсоединены тонкие водонесущие трубки. В качестве охлаждающей жидкости использовалась вода, подкрашенная зелёным красителем, подаваемая 12-вольтовым диафрагменным насосом от портативного охладителя со льдом. Итоговая система была установлена на видеокарту MSI GeForce RTX 3070, у которой была демонтирована штатная система охлаждения, чтобы обеспечить прямой контакт медного основания кулера с кристаллом графического процессора (GPU). В ходе тестирования температура графического процессора стабилизировалась на уровне минус 14 градусов Цельсия. По словам TrashBench, такая эффективность охлаждения позволила разогнать GPU на дополнительные 320 МГц, что в совокупности обеспечило средний прирост производительности на уровне 10 % в играх и бенчмарках по сравнению с эталонными показателями видеокарты в штатной комплектации. Отмечается, что ранее этот же моддер экспериментировал с погружением видеокарт в трансмиссионное масло, однако новая реализация охлаждения представляется более практичной с точки зрения повторяемости и эксплуатационной устойчивости. Как построить 5000-ваттный GPU будущего — Intel расскажет на ISSCC 2026

28.11.2025 [01:39],

Николай Хижняк

Насыщенная программа конференции ISSCC 2026, которая пройдет в феврале будущего года, включает немало интересных тем. Среди них — «как реализовать 5000-ваттные графические процессоры». Идею хочет предложить не абы кто, а заслуженный исследователь Intel, проработавший в компании более 25 лет, пишет Computer Base.

Источник изображения: Intel Каладхар Радхакришнан (Kaladhar Radhakrishnan) давно и активно работает в области технологий питания микросхем и компонентов. Многочисленные публикации его работ доступны онлайн. На конференции ISSCC в феврале 2026 года он представит один из своих последних проектов, который в полной мере соответствует современным тенденциям: интегрированные решения по регулированию напряжения для графических процессоров мощностью 5 кВт. Презентация состоится 19 февраля в рамках панельной дискуссии, посвященной теме «Обеспечение будущего ИИ, высокопроизводительных вычислений и архитектуры чиплетов: от кристаллов до корпусов и стоек». Ключевая идея предложения — использование в составе GPU интегрированных регуляторов напряжения (IVR). Сама по себе технология IVR не является новинкой в отрасли. Однако её использование в составе графических процессоров для обеспечения значительно более высокой мощности всё ещё остаётся относительно новой областью. Следующее поколение больших GPU в ускорителях ИИ будет потреблять от 2300 до предположительно 2700 Вт. Nvidia Vera Rubin Ultra и её преемник Feynman Ultra, по слухам, будут потреблять более 4000 Вт. Таким образом, цель Intel в 5 кВт для GPU — это совсем не нереалистичная цифра на будущее. Предполагается, что применение IVR в составе GPU потребует использования технологии корпусирования чипов Foveros-B. Данная технология ожидается не ранее 2027 года. Внешних клиентов компания намерена привлекать через своё контрактное производство Foundry. Как пишет Computer Base, компания TSMC также работает над этим направлением со своими партнёрами. GUC, компания, входящая в экосистему TSMC, недавно объявила, что отправила IVR на отладку в составе CoWoS-L. CoWoS-L является самым передовым решением TSMC для корпусирования больших интерпозеров. Технология CoWoS-L ожидается в 2027 году и придёт на смену CoWoS-S, которая сейчас используется для упаковки большинства чипов таких компаний, как Nvidia, AMD и других. Китайская Lisuan Tech разослала партнёрам образцы своей видеокарты с производительностью как у RTX 4060

16.11.2025 [20:51],

Анжелла Марина

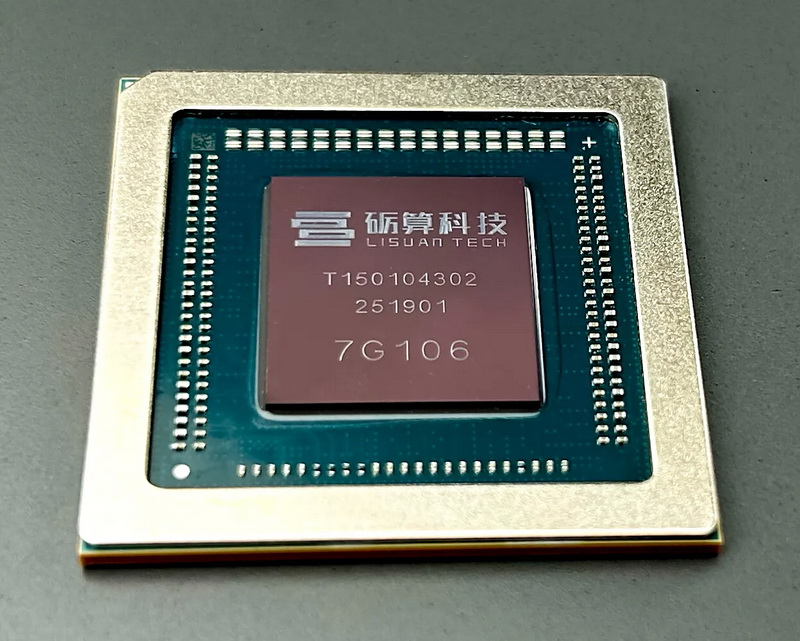

Китайская компания Lisuan Technology подтвердила, что её первый графический процессор для рендеринга графики 7G100, созданный по 6-нм техпроцессу, достиг стадии рассылки образцов и их тестирования клиентами. Согласно инвесторскому отчёту, инженеры компании сейчас занимаются тестированием чипа у партнёров, доработкой на основе обратной связи, подготовкой к производству и одновременно запуском маркетинговой кампании. «Работы идут в штатном режиме», — отмечается в документе.

Источник изображения: videocardz.com Однако эта новость пришла позже, чем ожидалось, отмечает VideoCardz. Ранее, после презентации 26 июля, на сайте компании фигурировал чёткий план относительно того, что испытания должны начаться в августе 2025 года, а массовое производство — в сентябре. Сейчас, в середине ноября, подтверждено лишь начало тестирования, что указывает на срыв первоначального графика. О старте серийного выпуска в официальном сообщении речь не идёт вообще.

Источник изображения: Lisuan Tech GPU 7G100 разработан по 6-нанометровому техпроцессу TSMC и ляжет в основу двух видеокарт: пользовательской 7G106 и профессиональной 7G105. Обе поддерживают современные графические интерфейсы API — DirectX 12 (без трассировки лучей), Vulkan 1.3, OpenGL 4.6 и OpenCL 3.0. Модель 7G106 оснащена 12 Гбайт памяти GDDR6 с 192-битной шиной и одним 8-контактным разъёмом питания с целевой мощностью платы до 225 Вт. Её старший собрат, 7G105, получил больший объём памяти до 24 Гбайт, поддержку ECC, усиленную защиту данных и ориентирован на задачи в сфере искусственного интеллекта и рабочих станций. По данным самой Lisuan, производительность 7G106 в ряде бенчмарков сопоставима с GeForce RTX 4060 и даже приближается к уровню RTX 5060. Например, в 3DMark Fire Strike чип набрал около 26 800 баллов, а в тесте OpenCL в Geekbench 6 — 111 290. Компания также показала, как современные игры, в том числе Black Myth: Wukong, работают в разрешении 4K с графикой на уровне High и сохраняют стабильный FPS. «Самый маленький» в мире графический процессор TinyGPU v2.0, содержащий 200 тыс. транзисторов, запущен в производство

10.11.2025 [07:21],

Владимир Фетисов

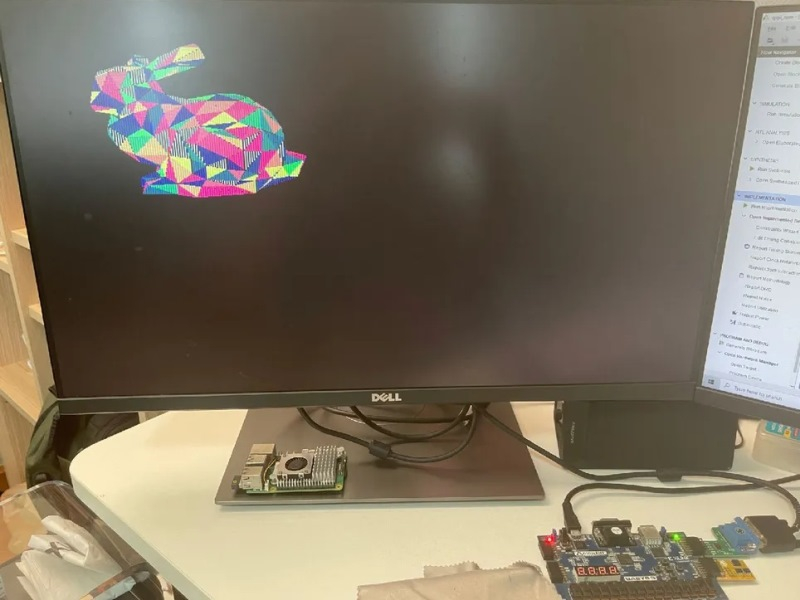

Разработчик-любитель Понсагон Вичит (Pongsagon Vichit) представил широкой публике графический процессор TinyGPU v2.0. Устройство представляет собой автономный GPU с тактовой частотой 25 МГц и возможностью вывода изображения 320 × 240 пикселей с 4-битным цветом, а также с аппаратной поддержкой обработки 3D-сцен в режиме реального времени.

Источник изображения: @MattDIYgraphics / X Возможности TinyGPU v2.0 сопоставимы с ускорителями Nvidia GeForce 256, которые были анонсированы в 1999 году. Тем не менее, TinyGPU v2.0 является самостоятельным графическим процессором с примерно 200 тыс. транзисторов. Для сравнения, флагманская видеокарта Nvidia GeForce RTX 5090 насчитывает 92,2 млрд транзисторов. Несмотря на это, основные этапы подготовки кадра у этих ускорителей происходят схожим образом, а колоссальная разница между ними заключается в масштабах и уровне производительности. Энтузиаст опубликовал в своём аккаунте в соцсети X небольшое видео, а котором показал, как происходит загрузка разных 3D-моделей из встроенной в TinyGPU v2.0 флеш-памяти. Любопытно, что для управления он задействовал геймпад от Super Nintendo. С его помощью энтузиаст преобразует модели, изменяя их размер и положение, а также изменяет местоположение источника освещения. Несмотря на то, что это существенное улучшение по сравнению с первой версией TinyGPU, которую разработчик представил примерно год назад, технические характеристики TinyGPU v2.0 не слишком впечатляют. Ускоритель работает с тактовой частотой 25 МГц и может выдавать от 7,5 до 15 кадров в секунду при рендеринге низкополигональных 3D-моделей. При этом выводится изображение с разрешением 320 × 240 пикселей с 4-битным цветом (до 16 оттенков). Хотя графика с таким разрешением и глубиной цвета прочно ассоциируется с эпохой домашних компьютеров прошлого века, в TinyGPU v2.0 задействованы значительно более современные процессы. Ускоритель выполняет интерактивное преобразование 3D-векторов в растровое изображение и использует технологию преобразования освещения, которая впервые появилась в GeForce 256. Среди других технических особенностей TinyGPU v2.0 отметим поддержку двойной буферизации с 4-битной глубиной цвета, хранение данных Z-буфера в QSPI RAM, поддержку до 1 тыс. треугольников и 1 направленного источника света в сценах с плоским затемнением. TinyGPU v2.0 стал участником проекта Tiny Tapeout для запуска производственного цикла. Проектировка дизайна видеокарты обойдётся энтузиасту примерно в $1500. Узнать больше о проекте можно на площадке Verilog, а исходные файлы и другие материалы доступны на GitHub. Samsung модернизирует ИИ-инфраструктуру разработки своих чипов с помощью 50 000 GPU компании Nvidia

02.11.2025 [06:55],

Анжелла Марина

Samsung Electronics объявила о намерении развернуть вычислительный кластер из 50 000 графических процессоров (GPU) компании Nvidia для автоматизации и оптимизации собственного производства полупроводников. Новый объект получил рабочее название AI Megafactory, сообщает CNBC.

Источник изображения: Samsung Electronics Это соглашение стало частью масштабного расширения партнёрской сети Nvidia, чьи чипы остаются ключевыми компонентами для разработки и внедрения передовых решений в области искусственного интеллекта (ИИ). Ранее, в начале недели, генеральный директор Nvidia Дженсен Хуанг (Jensen Huang) сообщил в Вашингтоне о сотрудничестве с такими компаниями, как Palantir, Eli Lilly, CrowdStrike и Uber, а вскоре после выступления он был замечен в Сеуле за неформальной встречей с председателем совета директоров Samsung Ли Чжэ Ёном (Lee Jae-yong), а также другими корейскими бизнес-лидерами. Представители Nvidia уточнили, что совместно с Samsung будет адаптирована литографическая платформа для работы с GPU Nvidia, что, по их оценкам, обеспечит двадцатикратный прирост производительности. Кроме того, Samsung намерена задействовать программное обеспечение Nvidia Omniverse и использовать GPU для запуска собственных ИИ-моделей в мобильных устройствах. Важно отметить, что Samsung выступает не только клиентом и партнёром Nvidia, но и одним из ключевых поставщиков. Компания производит высокопроизводительную память типа HBM (High Bandwidth Memory), широко применяемую в ИИ-чипах Nvidia. В рамках нового этапа сотрудничества стороны договорились совместно доработать память следующего поколения HBM4 для использования в будущих ИИ-процессорах. Партнёрство с Samsung подкрепляет заявление Хуанга о том, что текущий портфель заказов Nvidia на GPU архитектуры Blackwell и следующего поколения Rubin достиг 500 млрд долларов. Эта перспектива способствовала росту рыночной капитализации Nvidia до исторического уровня в $5 трлн. Помимо Samsung, аналогичные GPU-кластеры развёртывают южнокорейские конгломераты SK Group и Hyundai. Рэймонд Тэ (Raymond Teh), старший вице-президент Nvidia по Азиатско-Тихоокеанскому региону, заявил, что компания тесно взаимодействует с правительством Республики Корея в поддержку его амбициозных планов по лидерству в сфере ИИ. Китайская Innosilicon представила видеокарту Fenghua 3 — CUDA, DX12, трассировка лучей и более 112 Гбайт HBM

24.09.2025 [15:31],

Николай Хижняк

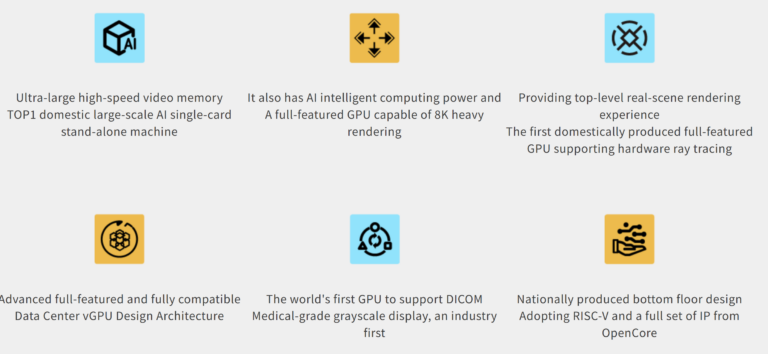

Компания Innosilicon представила свой графический процессор третьего поколения — Fenghua 3. Компания обещает, что третья версия графического процессора будет значительно превосходить своих предшественников. Компания называет его первым полнофункциональным GPU собственной разработки, которые построен на открытой архитектуре RISC-V и совместим с CUDA.

Источник изображений: Innosilicon В отличие от предыдущих поколений ускорителей Fenghua, основанных на архитектуре PowerVR от Imagination Technologies, Fenghua 3 использует в качестве основы проект OpenCore RISC-V Nanhu V3. Innosilicon утверждает, что новый GPU способен справиться с широким спектром рабочих нагрузок: от обучения ИИ и масштабных научных вычислений до САПР, медицинской визуализации и облачного гейминга. Для Fenghua 3 заявляется поддержка DirectX 12, Vulkan 1.2 и OpenGL 4.6 с аппаратной трассировкой лучей. Компания продемонстрировала работу GPU в таких играх, как Tomb Raider, Delta Force и Valorant, хотя данные о частоте кадров и настройках не были предоставлены. Fenghua 3 также поддерживает подключение до шести 8K-мониторов с частотой обновления 30 Гц.  Для задач искусственного интеллекта ускоритель на базе Fenghua 3 предлагает более 112 Гбайт высокоскоростной памяти HBM — это самый большой объём памяти среди китайских видеокарт. Один ускоритель может обрабатывать модели с 32 и 72 млрд параметров, а кластер из восьми — поддерживать огромные модели DeepSeek 671B и 685B. Innosilicon также подтвердила совместимость своей новинки с Qwen 2.5, Qwen 3 и семейством ИИ-моделей DeepSeek V3, V3.1 и R1. Innosilicon также похвасталась тем, что Fenghua 3 — первая в Китае видеокарта, поддерживающая формат YUV444, который обеспечивает наилучшую детализацию и точность цветопередачи. Это будет особенно полезно для тех, кто работает с САПР или занимается видеомонтажом. Кроме того, Fenghua 3 — первая в мире видеокарта, которая предлагает встроенную поддержку технологии DICOM (Digital Imaging and Communication in Medicine). Она позволяет точно визуализировать рентгеновские снимки, МРТ, КТ и УЗИ на стандартных мониторах, устраняя необходимость в дорогостоящих специализированных медицинских дисплеях с градациями серого. Ускоритель работает с системами Windows, Android, Tongxin и Kylin Linux. Сделка c Nvidia не повлияет на собственные планы Intel по выпуску процессоров и видеокарт

20.09.2025 [13:34],

Андрей Созинов

Intel чётко заявила — сотрудничество с Nvidia не повлияет на уже свёрстанные её собственные планы выпуска новых процессоров и видеокарт. Компания пояснила, что все новые продукты, которые будут разрабатываться в союзе с Nvidia, должны будут усилить и дополнить линейку продукции, а не перекраивать её. Отдельно Intel подчёркивает, что видеокарты Arc тоже продолжат развиваться.

Источник изображения: X, Lip-Bu Tan «Хотя на данный момент мы не раскрываем конкретные планы, всё, о чём мы говорим, соответствует существующей стратегии Intel и дополняет её. Сотрудничество с NVIDIA позволит предложить дополнительные решения для ИИ и расширит присутствие в сегментах высокопроизводительных вычислений как в клиентских системах, так и в ЦОД. Мы продолжим придерживаться нашего плана развития GPU. С NVIDIA мы работаем над обслуживанием отдельных сегментов рынка, но также будем следовать собственному курсу», — пояснил представитель Intel в комментарии сайту Tom's Hardware. Напомним, Nvidia инвестировала в Intel $5 млрд и договорилась о поставке чиплетов RTX для интеграции их в процессоры Intel. Это породило два ключевых вопроса. Первый: изменится ли судьба графики Arc — в том числе дискретной и встроенной. И второй: повлияет ли это на планы Intel по мобильным CPU. После того, как в прессе поднялась волна спекуляций, Intel дала развёрнутый официальный комментарий. Из него следует: оснований для беспокойства нет, компания продолжит придерживаться своего плана по GPU, что позволяет рассчитывать на сохранение линейки Arc как минимум в обозримом будущем. Что касается процессоров, здесь Intel ещё более категорична: текущая мобильная дорожная карта остаётся без изменений. Сейчас в процессорных планах значится процессор Panther Lake, который должен дебютировать этой осенью с началом массовых поставок в 2026 году. Следом идёт Nova Lake, запланированный на конец 2026-го с фактическим выходом в 2027 году. Согласно утечкам, в том же году может появиться и Wildcat Lake. Всё, что родится в результате партнёрства с Nvidia, будет дополнением к этом списку. По сути, это могут быть премиальные версии уже существующих CPU, ориентированные на игровые или творческие сценарии. Технически у Intel уже есть опыт работы с GPU-тайлами в имеющихся процессорах. Поэтому логично предположить, что в будущем компания сможет выпускать процессоры либо с графикой Arc, либо с чиплетами Nvidia RTX на выбор. По словам Дженсена Хуанга, Intel и Nvidia работают над партнёрством около года. Но деталей о конкретных продуктах ждать в ближайшее время не стоит. Для того, чтобы обширные планы компаний воплотились в жизнь, может потребоваться ещё 2-3 года. AMD готовит ответ ИИ-серверам Nvidia — система MegaPod объединит 256 ускорителей Instinct MI500 и 64 процессора EPYC Verano

05.09.2025 [01:17],

Анжелла Марина

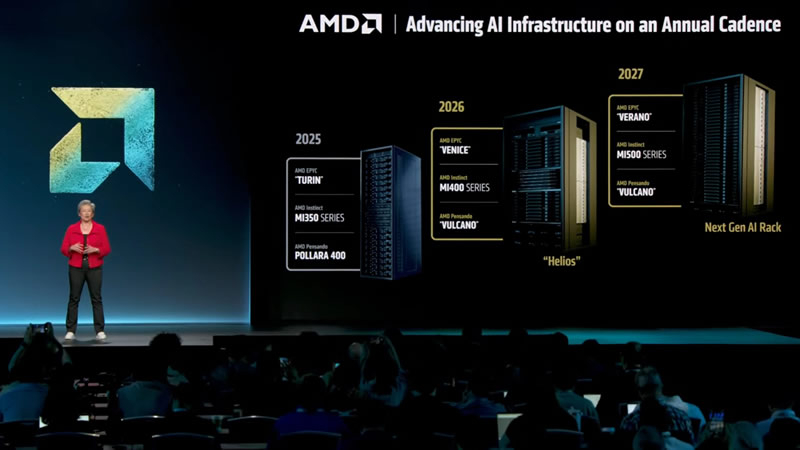

AMD намерена представить в 2027 году масштабную вычислительную платформу для искусственного интеллекта под кодовым названием MI500 Scale Up MegaPod, которая будет включать 256 ускорителей серии Instinct MI500 и 64 центральных процессора EPYC Verano. Данная система сможет предложить лучшую масштабируемость по сравнению с Nvidia NVL576 и станет развитием анонсированной ранее платформы Helios 2026 года, которая будет содержать более 72 GPU.

Источник изображения: AMD По сообщению Tom's Hardware, информация о деталях проекта, получившего предварительное название MI500 UAL256, была опубликована аналитическим изданием SemiAnalysis в официальном аккаунте X. В конфигурации задействованы три связанные стойки: в двух боковых разместят по 32 вычислительных модуля, каждый из которых включает один процессор EPYC Verano и четыре ускорителя Instinct MI500, а центральная стойка будет отведена под 18 модулей с коммутаторами UALink. Всего в системе используется 64 вычислительных модуля и 256 GPU-ускорителей. По сравнению с NVL576 от Nvidia, в котором используется 144 ускорителя Rubin Ultra (каждый содержит четыре вычислительных чиплета), платформа AMD предлагает примерно на 78 % больше GPU-ускорителей на одну систему. Однако аналитики отмечают, что прямое сравнение производительности затруднено, так как у NVL576 будет 147 Тбайт памяти HBM4 и суммарная производительность 14 400 PFLOPS в формате FP4, что делает её крайне производительной и конкурентной системой. Учитывая растущее энергопотребление и тепловыделение графических процессоров для искусственного интеллекта, платформа MI500 UAL256 будет использовать единую систему жидкостного охлаждения как для вычислительных модулей, так и для сетевых коммутаторов. Ожидается, что AMD представит свою разработку в конце 2027 года, примерно в тот же период, когда Nvidia планирует дебют своих машин на архитектуре Kyber. Если это произойдёт, то обе компании в 2028 году увеличат производство стоечных решений на базе Instinct MI500 и Rubin Ultra. Nvidia захватила почти четверть рынка GPU для ПК — лидирует Intel, а доля AMD сжалась до 14 %

30.08.2025 [16:18],

Николай Хижняк

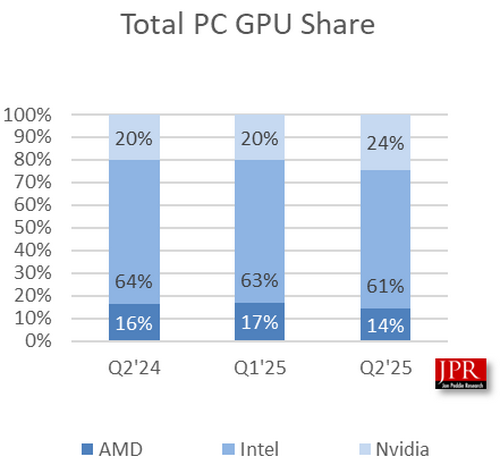

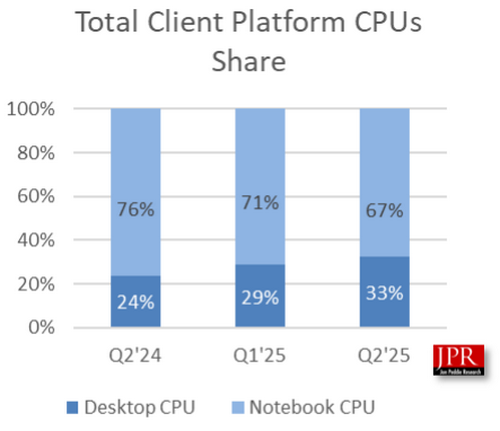

Nvidia продолжила стремительно наращивать свою долю на рынке видеокарт во втором квартале 2025 года. По данным исследовательской компании Jon Peddie Research, мировые поставки графических процессоров для ПК, куда входят как дискретные GPU, так и встроенные, достигли 74,7 млн единиц, а поставки центральных процессоров для ПК — 66,9 млн единиц.

Источник изображения: Wccftech Согласно прогнозу JPR, с 2025-го по 2028-й год среднегодовой темп сокращения рынка графических процессоров для ПК составит 2,9 %, а к концу обозначенного периода количество использующихся по всему миру графических процессоров для ПК достигнет почти 3 млрд единиц. Доля дискретных видеокарт на рынке в течение следующих пяти лет достигнет 23 % — большинство систем по-прежнему будут ограничиваться встроенной графикой.

Источник изображения здесь и ниже: Jon Peddie Research Во втором квартале поставки GPU для ПК выросли на 4,9 % по сравнению с тем же периодом прошлого года. Поставки видеокарт для настольных ПК увеличились на 11 %, а мобильных GPU для ноутбуков — на 2,5 %. В этом году Nvidia и AMD выпустили новые серии видеокарт — GeForce RTX 5000 и Radeon RX 9000. Благодаря этому поставки видеокарт начали расти по сравнению с предыдущими месяцами. Цены на новые модели графических ускорителей всё ещё находятся на высоком уровне, но они постепенно нормализуются, и многие модели уже доступны по ценам, близким к рекомендованным. Общая доля GPU компаний AMD и Intel на рынке снизилась: у AMD падение составило 2,4 % по сравнению с предыдущим кварталом, а у Intel — 1,9 %. В то же время доля Nvidia увеличилась до 24 %, что на 4,3 % больше, чем кварталом ранее. Благодаря тому, что встроенная графика присутствует в большинстве процессоров Intel, компания занимает большую часть рынка. Учитывая, что дискретные видеокарты продемонстрировали наибольший рост во II квартале 2025 года, можно ожидать, что доля Nvidia на рынке дискретной графики поднимется на новый уровень. Согласно отчёту за I квартал 2025 года, доля Nvidia на рынке дискретной графики составляла 92 %. AMD же сократила свою долю с 15 % до 8 %. Доля Intel, по данным Jon Peddie Research, упала с одного процента до нуля.  Отчёт по поставкам процессоров для ПК показывает, что AMD удалось увеличить отгрузки в штучном выражении на 27 %. У Intel прирост составил всего 2 %. Совокупно поставки процессоров во II квартале этого года выросли на 8 %. Сегмент процессоров для ПК увеличился на 12,9 % по сравнению с прошлым годом и на 7,9 % по сравнению с предыдущим кварталом. По состоянию на I квартал 2025 года доля настольных процессоров на рынке составила 33 %. В IV квартале 2024 года этот показатель составлял 29 %, а по итогам второго квартала прошлого года — 24 %. Доля процессоров для ноутбуков в I квартале 2025 года составила 67 %, что ниже 71 % кварталом ранее и 76 % годом ранее. AMD призналась, что готова быстро создавать дискретные нейронные процессоры для ИИ

02.08.2025 [07:05],

Алексей Разин

Очевидно, что Intel и AMD сложно смириться с тем, как Nvidia практически единолично пожинает плоды своих многолетних усилий по продвижению так называемых GPU в сфере ускорения вычислений. В свою очередь, AMD готова не только создавать конкурентоспособные GPU, но и присматривается к сегменту более специализированных нейронных процессоров (NPU), которые также могут быть востребованы в эпоху ИИ.

Источник изображения: AMD Руководитель направления клиентских центральных процессоров AMD Рахул Тику (Rahul Tikoo) подтвердил изданию CRN, что эта компания ведёт переговоры с клиентами на тему возможного применения специализированных чипов, ускоряющих работу инфраструктуры ИИ, при этом не являющихся GPU. Подчёркивается, что крупные производители ПК типа Lenovo, Dell и HP Inc. интересуются возможностью использования различных ускорителей для работы с искусственным интеллектом. В частности, Dell уже выразила готовность использовать дискретный ускоритель Qualcomm для соответствующих нужд. Как пояснил представитель AMD, компания внимательно присматривается к этой сфере применения, и у неё есть решения, которые она может предложить при наличии спроса. Когда такие продукты появятся на рынке, Рахул Тику пояснить отказался, сославшись на необходимость сохранения коммерческой тайны. При этом он подчеркнул, что AMD подобные предложения может вывести на рынок достаточно быстро. Ранее технический директор одного из системных интеграторов заявил CRN, что AMD, на его взгляд, может предложить NPU, созданные с использованием разработок Xilinx. Соответствующий блок уже появился в составе процессоров Ryzen, в дальнейшем он может трансформироваться в обособленное дискретное решение с более высокой производительностью. Ценность подобных компонентов должна заключаться в том, что при адекватном уровне быстродействия они будут потреблять существенно меньше электроэнергии, чем GPU. Китайская Lisuan Technology представила видеокарту на собственном GPU, и она тянет Black Myth: Wukong в 4K

26.07.2025 [15:14],

Николай Хижняк

Китайский стартап Lisuan Technology представил на мероприятии в Шанхае свой первый графический процессор 7G106 собственной разработки, изготовленный с применением 6-нм техпроцесса TSMC N6. Работу чипа показали в составе референсной видеокарты. GPU предназначен для игровых видеокарт массового сегмента.

Источник изображений: Lisuan Technology / TechPowerUp Графический процессор 7G106 от компании Lisuan Technology использует проприетарную архитектуру TrueGPU с поддержкой различных API, включая DirectX 12 (без поддержки трассировки лучей), Vulkan 1.3, OpenGL 4.6 и OpenCL 3.0. Несмотря на отсутствие поддержки трассировки лучей, 7G106 позиционируется как решение для широкого круга пользователей, ищущих достойную игровую производительность без наценки, характерной для продукции топовых мировых брендов. В составе графического процессора 7G106 присутствуют 192 текстурных блока (TMU) и 96 блоков растеризации (ROP). Чип поддерживает до 12 Гбайт памяти GDDR6 с 192-битной шиной. Для GPU заявляется поддержка вычислений FP32 и INT8 с теоретической производительностью FP32 на уровне 24 Тфлопс. Графический чип также поддерживает аппаратное ускорение декодирования AV1 и HEVC до 8K60FPS, а также кодирование AV1 с разрешением 4K30FPS и HEVC с разрешением 8K30FPS. Он поддерживает интерфейс PCIe 4.0 x16 и предлагает поддержку четырёх видеовыходов DisplayPort 1.4 с компрессией DSC 1.2b. Поддержка HDMI не заявлена, вероятно, ввиду высокой стоимости лицензии. Характеристики энергопотребления представленного решения пока неокончательные. Референсная видеокарта на базе 7G106 оснащена одним 8-контактным разъёмом PCIe, что подразумевает максимальную потребляемую мощность 225 Вт. Карта также предлагает функцию виртуального GPU (vGPU), поддерживающую до 16 контейнеров через SR-IOV, что говорит о её направленности не только на игровой сегмент, но и на корпоративные решения и виртуализацию. Компания подчеркнула эту универсальность во время анонса, выделив варианты использования ускорителя для рабочих станций, создания контента и даже метавселенной. Lisuan Technology также анонсировала профессиональный вариант ускорителя, оснащённый 24 Гбайт памяти. Характеристики в целом аналогичные игровой карте, но все данные производитель не привёл. Сравнить обе карты можно в таблице ниже. На мероприятии также было продемонстрировано, что видеокарта на базе графического процессора 7G106 способна обеспечить приемлемый уровень производительности в игре Black Myth: Wukong в разрешении 4K и при высоких настройках графики. Согласно данным портала ITHome, карта показала более 70 кадров в секунду в этой игре. В синтетических бенчмарках 7G106 показал результат 26 800 в 3DMark Fire Strike и 111 290 баллов в тесте Geekbench 6.4.0 OpenCL. Во втором случае китайское решение оказалось примерно на 10 % быстрее GeForce RTX 4060. Однако в тесте Fire Strike китайский GPU оказался заметно медленнее моделей Nvidia GeForce RTX 5060, RTX 5050, а также AMD Radeon RX 9060, все из которых показали результат около 29 000 баллов. Согласно имеющейся информации, образцы графического процессора 7G106 начнут рассылать заинтересованным сторонам в августе. А начало массового производства 7G106 запланировано на сентябрь этого года. Однако информации о тактовых частотах графического процессора, а также данных о том, когда видеокарты на его основе появятся в продаже, пока нет. Lisuan Tech 7G106

Смотреть все изображения (16)

Смотреть все изображения (16) Представители портала TechPowerUp побывали на презентации Lisuan Technology. С фотографиями этого мероприятия можно ознакомиться в галерее выше. Китайцы выпустили первую видеокарту на суверенном 6-нм GPU — Lisuan G100, которую сравнивают с RTX 4060

30.05.2025 [16:29],

Николай Хижняк

Китайская компания Lisuan Technology заявила, что успешно запустила первый образец будущей видеокарты G100, в основе которой используется первый для Китая полностью суверенный графический процессор, произведённый с использованием 6-нм техпроцесса.

Источник изображения: Lisuan Technology Китай стремится к технологической независимости от западных компаний. На этом фоне к китайским компаниям присоединилось множество опытных разработчиков и инженеров. Lisuan Technology, основанная в 2021 году, является одним из самых молодых стартапов в сегменте разработки и производства видеокарт. Другими аналогичными стартапами являются Moore Threads (основана в 2020 году) и Biren (создана в 2019 году). В числе основателей Lisuan Technology — ветераны индустрии, проработавшие в Кремниевой долине более 25 лет. То же самое можно сказать и о Moore Threads, которая была основана Чжан Цзяньчжуном (Zhang Jianzhong), бывшим вице-президентом и директором китайского подразделения Nvidia. О видеокарте G100 пока мало информации. Известно, что в её основе используется проприетарная архитектура TrueGPU, разработанная Lisuan Technology. В отличие от некоторых других китайских производителей, которые нередко лицензируют технологии таких компаний, как Imagination, для разработки на их основе собственных продуктов, TrueGPU является действительно суверенной архитектурой, разработанной с нуля. Lisuan Technology не сообщает, на мощностях какого производителя выпущен 6-нм графический процессор, используемый в основе G100. Из-за американских санкций Китай не имеет доступа к иностранным 6-нм техпроцессам, что исключает Samsung и TSMC в качестве возможных производителей этого чипа. Весьма вероятно, что за выпуск GPU отвечает китайский производитель полупроводников SMIC, который также занимается выпуском графических процессоров Ascend 920 AI для компании Huawei. Слухи приписывают G100 производительность на уровне GeForce RTX 4060, хотя сама компания Lisuan Technology эту информацию не подтверждала. Также ускорителю приписывают поддержку графических API DirectX 12, Vulkan 1.3, OpenGL 4.6 и OpenGL 3.0. Это может говорить о том, что G100 можно будет использовать не только для профессиональных задач, но и для игр. Разработка G100 началась в 2021 году. Изначально компания планировала выпустить этот ускоритель в 2023 году, однако финансовые трудности (дело чуть не дошло до банкротства), с которыми столкнулся разработчик, сдвинули срок выпуска на 2024 год. В конечном итоге родительская компания Dongxin Semiconductor поддержала стартап и выделила ему финансирование в размере $27,7 млн, что позволило продолжить разработку G100. Lisuan Technology успешно произвела первые чипы G100, они работают и, судя по всему, результаты соответствуют ожиданиям разработчика. Сейчас компания занимается разработкой программного обеспечения, проверками аппаратной части, а также оптимизацией графического драйвера. Lisuan Technology рассчитывает выпустить небольшое количество видеокарт G100 в третьем квартале этого года, однако массовое производство ускорителя, вероятно, стартует не раньше 2026 года. Разработка видеокарты с нуля требует больших усилий и времени. Опыт той же Moore Threads показал, что разработка программного обеспечения так же важна, как и разработка «железа», поскольку правильно оптимизированные драйверы способны значительно повысить производительность GPU. |